多目視覺定位協同引導自動運輸車研究

曾群生,蘇成悅,程天明,張洪釗,黃佩鐸

ZENG Qunsheng1,SU Chengyue2,CHENG Tianming2,ZHANG Hongzhao2,HUANG Peiduo2

1.廣東工業大學 計算機學院,廣州 510006

2.廣東工業大學 物理與光電工程學院,廣州 510006

1.School of Computer,Guangdong University of Technology,Guangzhou 510006,China

2.School of Physics&Optoelectronic Engineering,Guangdong University of Technology,Guangzhou 510006,China

1 引言

室內定位技術在自動化生產活動中越來越重要[1]。目前自動運輸車AGV(Automated Guided Vehicle)的室內定位導航方式有慣性定位導航、循線定位導航、衛星定位導航、超聲波定位導航、紅外定位導航、激光測距、WiFi局域網、藍牙技術、RFID技術、ZigBee技術、UWB技術、特殊光定位技術以及視覺定位技術等[2-6]。但上述的定位技術存在不足,如靈活性差、適用性差、不穩定等問題。

基于視覺定位技術具有靈活性高、精度高,無需場景輔助設施的優勢。其中全局視覺定位技術具有柔性大、靈活性高,用戶可隨時用軟件定義自動運輸車的運輸路徑[7-8]。文獻[9]提出一種基于全局視覺定位導引自動運輸車方案,采用半徑定比例的雙紅球作為自動運輸車的特定標志物。上位機通過識別雙球位置計算出自動運輸車的物理空間位置以及姿態方向角。但是并未解決問題:(1)雙球標志物被遮擋無法計算出自動運輸車的位置問題;(2)在大范圍的作業區域,需要多個攝像頭擴展物理空間視場協同引導AGV問題。

針對上述存在的兩個問題,提出一種多目攝像頭全局視覺協同定位引導自動運輸進行路徑規劃導航方案。采用紅色單球半徑15.0 cm作為車體標志以及MPU6050陀螺儀實現慣性導航,多個攝像頭協同可以實現物理視場空間的擴展,適用于工廠大范圍的定位。球體標志物的好處是無論在視場中的任意角度看都是一個圓,具有不變性。使用紅色單球做為標志物替代雙球具有快速識別、抗干擾性強以及實時性高的優勢。PC機識別出紅色單球的位置并發送給下位機自動運輸車,AGV根據當前的坐標位置和運輸終點位置運輸。同時安裝在自動運輸車上的陀螺儀傳感器可以感知車的二維方向和加速度姿態,當標志物被遮擋的時候,自動運輸車利用陀螺儀慣性導航,走出遮擋區域。方案具有適用性強、定位范圍大、靈活性高、穩定性好的優勢,切合實際工廠自動運輸車的定位作業需求。

2 多目視覺定位協同系統結構

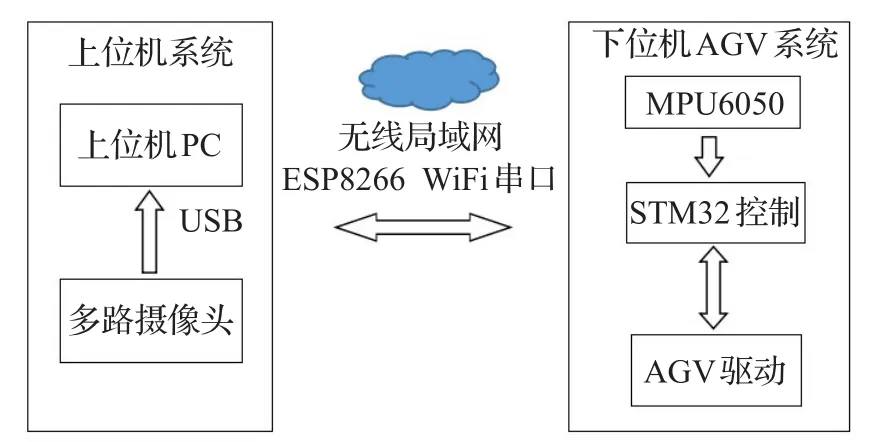

定位系統總設計結構如圖1所示,在室內安裝多個攝像頭,各路視頻流通過USB傳輸給上位機PC。上位機系統識別出AGV物理位置坐標后,通過無線WiFi發送給下位機ESP8266串口WiFi模塊。自動運輸車通過自身當前的坐標以及要求運輸終點目的位置信息計算出路徑。

圖1 定位系統總設計結構

3 上位機系統設計

上位機系統由OpenCV和QT平臺進行聯合開發設計。可以實時感知運輸車的位置信息并發送運輸車位置坐標,支持多點路徑規劃導航且用戶可以靈活地更改導航路徑。系統由以下三部分組成:紅色球體標志物識別、空間視場幾何投影映射關系的建模以及多攝像頭協同視場擴展計算。

3.1 標志物識別

在上位機的程序設計中,紅色球體標志物的識別是整個過程最基本的一步[10]。識別算法設計如下:

步驟1標定測得每個鏡頭的畸變參數,然后對輸入的圖像進行仿射變換得到矯正圖像[11]。

步驟2將采集的RGB圖像轉換為HSV顏色空間,由于HSV顏色空間色度和亮度通道是單獨分開的,因而對光照的敏感度低于RGB圖像[12]。

步驟3分割經矯正圖像的紅色區域。HSV紅色約束域為:色度H∈[0 ,10]?[1 56,180],飽和度S∈[4 6,255],亮度V∈[4 3,255]。

步驟4對分割后的圖像做數學形態學濾波。采用數學形態學的腐蝕和膨脹操作來濾波,以增加邊沿圓滑性,同時消除圖像上孤立點。

步驟5采用Canny算子提取出邊沿輪廓圖像,該方法在抗噪聲和精確邊沿提取上有出色的表現[13]。

步驟6濾波之后創建面積大小以及圓形度約束條件。通過球體大小,確定面積約束范圍S'∈[500,10 000],圓形度C∈[0.8,1.0],識別率最高。

上述公式(1),其中P表示物體的周長,S′表示面積。圓形度的值越接近1.0表示該圖形越接近圓,可用于消除非圓輪廓。

步驟7篩選出滿足條件的輪廓并輸出目標小球的位置。

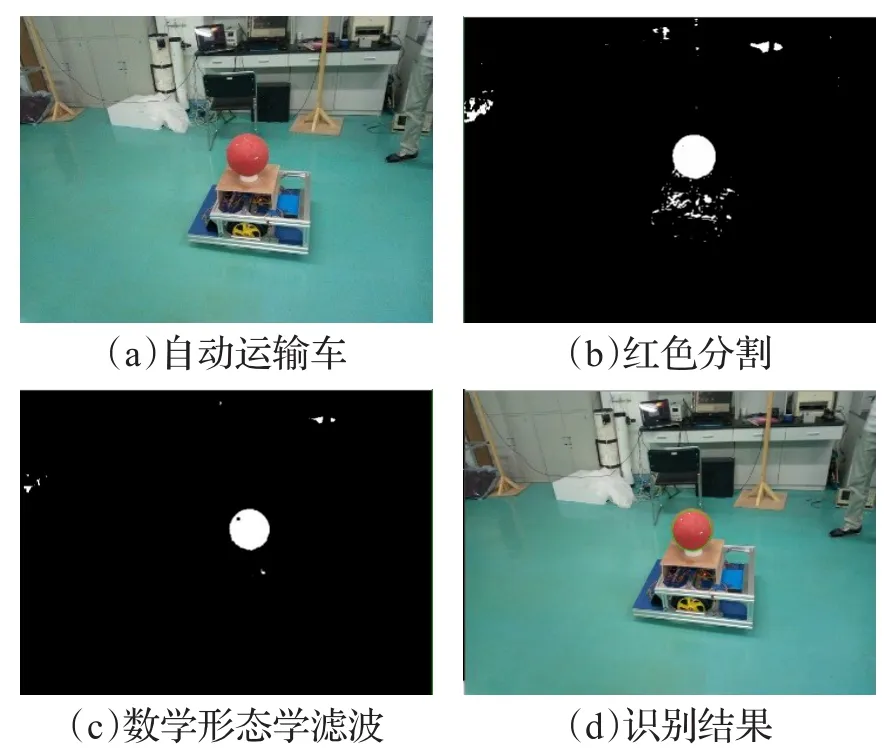

球體標志物識別情況如圖2識別過程。

圖2 識別算法過程

3.2 空間視場建模

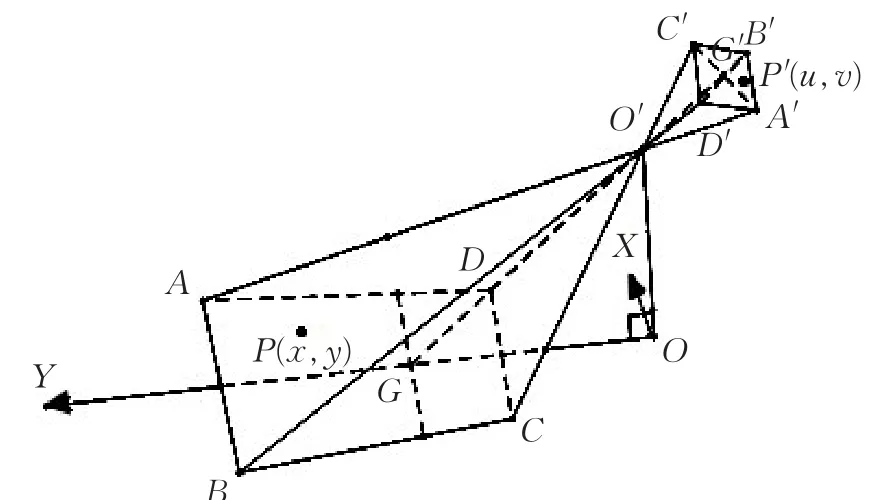

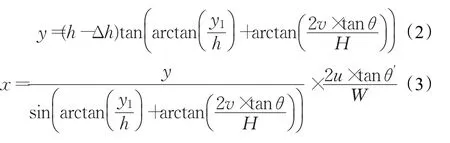

視場建模是建立起圖像平面和物理空間坐標之間的映射關系[14],根據小孔成像的原理建立幾何投影關系,數學模型如圖3所示。

如圖3所示區域ABCD為物理空間視場,A′B′C′D′為圖像區域,O′為攝像頭光心,O作為物理空間坐標系原點,O′G為光軸。H和W分別為圖像的高和寬,G′為圖像坐標系的原點,取P′(u,v)為圖像上坐標,則映射到物理空間為P(x,y)坐標。由映射模型可得關系式:

圖3 視場映射模型

θ′、h、?h、y1、θ 分別表示為水平視場角的半角、攝像頭距離地面高度、目標物中心距離地面高度、光軸與地面交點G到O點的距離、垂直視場角的半角,這些參數是可測量的。

3.3 多目攝像頭協同導引AGV

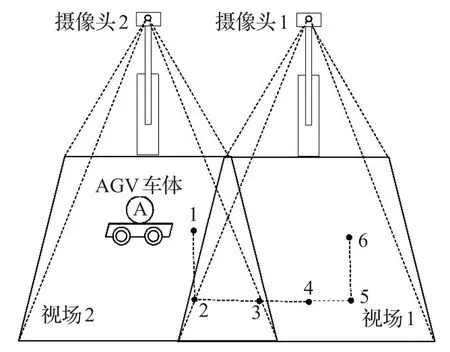

3.3.1 兩目視場擴展結構及步驟

圖4是以兩個攝像頭物理視場擴建為例的模型,規劃運輸路徑如圖中1-2-3-4-5-6。在室內安裝兩個攝像頭,并讓它們之間存在一定的視場交叉域。通過3步實現視場擴建:

步驟1計算出2號攝像頭的坐標系和1號基準攝像頭坐標系的夾角θ;

步驟22號攝像頭坐標系通過θ校正為跟基準坐標的方向一致的坐標系,再計算出2號攝像頭相對基準攝像頭的位置偏移量(△x,△y);

步驟3后面2號攝像頭的坐標位置同樣經過θ校正再加上偏移量就是擴展的坐標位置。

圖4 兩目視場擴建模型

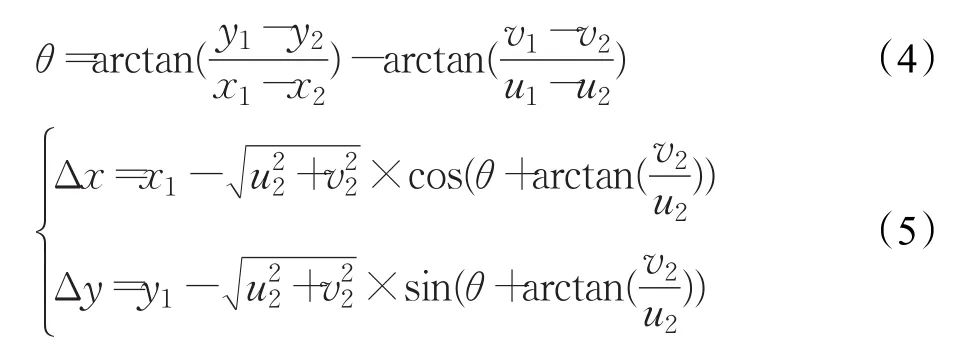

3.3.2 兩目視場擴展原理

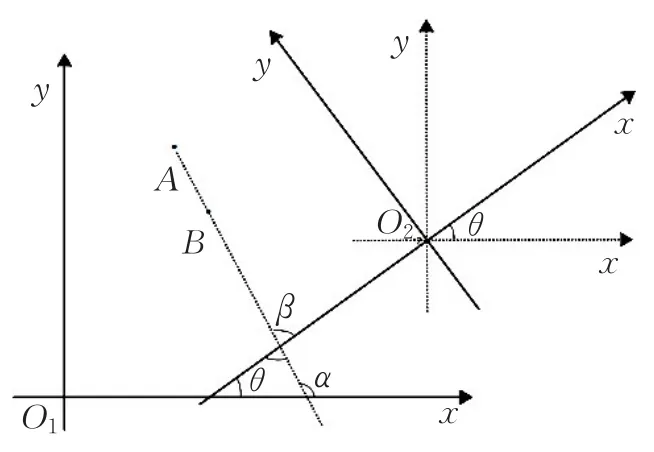

設1號基準攝像頭坐標原點為O1,2號攝像頭坐標原點為O2,在視場交叉域中任取兩個點A和B,視場1攝像頭計算出的物理空間坐標為A(x1,y1),B(x2,y2),視場2攝像頭計算出的物理空間坐標為A(u1,v1),B(u2,v2)。其中α、β分別為AB線與1號和2號攝像頭坐標軸的正切角,有θ=β-α,幾何關系如圖5所示。

圖5 視場擴展數學建模

通過圖5的幾何關系,計算得到兩坐標軸夾角θ,以及2號攝像頭偏移量(△x,△y)。

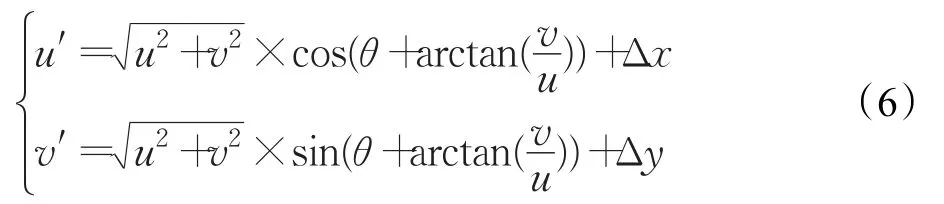

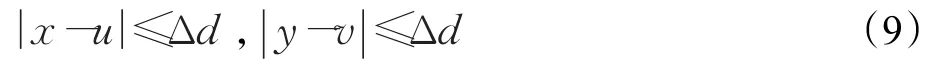

取2號攝像頭中任一點坐標為C(u,v),故其擴展后坐標為 C′(u′,v′),其中有:

3.3.3 多目視場擴展

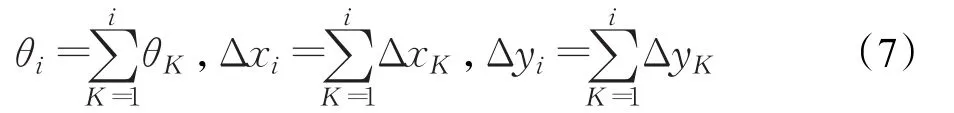

多目視場擴建是在兩目視場擴展理論基礎上,進行兩兩視場擴展進而實現多目視場引導自動運輸車。設1號攝像頭為基準攝像頭,2號攝像頭相對1號測得擴展參數,用向量 P1(θ1,Δx1,Δy1)表示;K∈1,2,…,Z ,第K號攝像頭相對K-1號攝像頭的擴展參數向量為PK-1(θK-1,ΔxK-1,ΔyK-1),則第 i號攝像頭相對1號基準攝像頭測得的擴展參數為向量 Qi(θi,Δxi,Δyi),i∈1,2,…,K ,其中

故第i號攝像頭中任取一點Ji(x,y)經參數向量Qi(θi,Δxi,Δyi)計算得擴展坐標 J′i(x′,y′)。

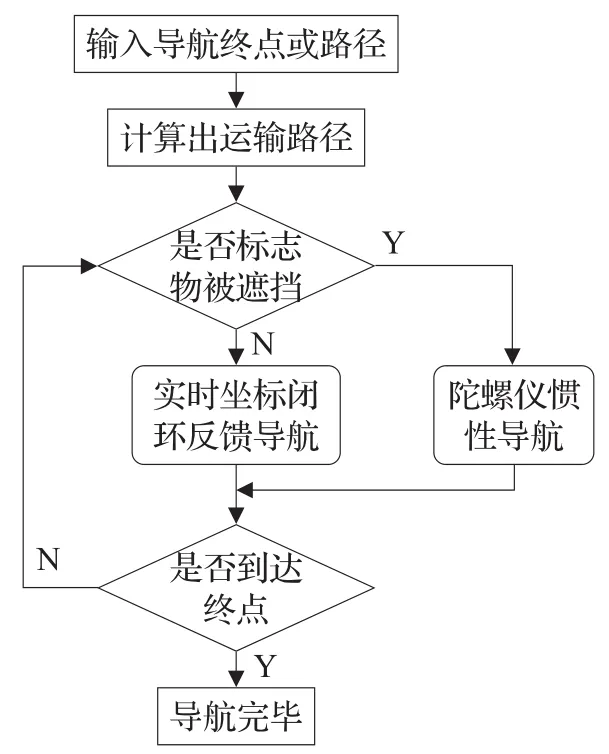

4 下位機AGV導航控制

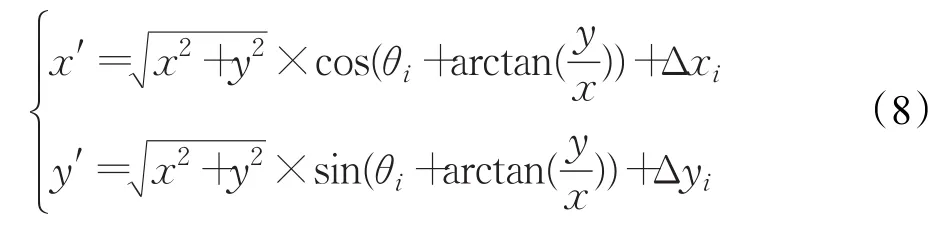

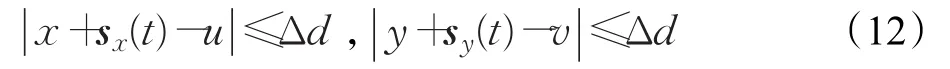

下位機采用一套分時雙閉環反饋機制對運輸車進行控制。設運輸車當前位置坐標為E(x,y),到達點位置坐標F(u,v),控制停止誤差為△d。

(1)當球體標志物沒被遮擋時,通過比較車當前位置和目標點位置的X方向和Y的反饋差量是否同時在設定的△d范圍內,如果是則表示到達目的地,判斷條件如下:

(2)當標志物被遮擋時,運輸車將失去上位機實時的位置坐標,此時利用MPU6050的加速度傳感器計算自身當前位置,從而實現慣性導航[15]。設遮擋t=0時刻,到解除遮擋t=T整個過程X方向和Y方向瞬時加速度分別為ax(t)和ay(t),速度為vx(t)和vy(t),位移為sx(t)和 sy(t)。

X方向和Y方向瞬時速度為:

X方向和Y方向位移為:

故判斷到達目標點條件如下:

根據差量利用PID技術控制小車的運動狀態[16],算法控制如圖6導航控制流程圖。

圖6 下位機導航控制

5 引導實驗

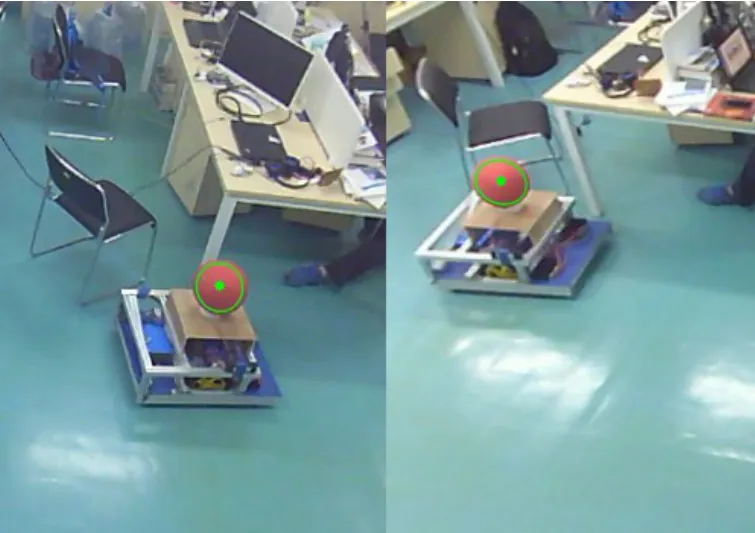

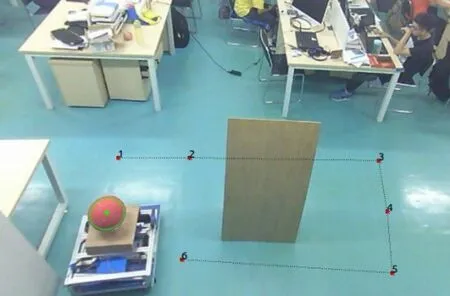

本次實驗環境在范圍比較大的工作室環境,單目定位視場范圍大致為5.0 m×5.0 m。實驗環境如圖7所示。

實驗前參數:

(1)攝像頭垂直視角 2 θ=70°,水平視角 2 θ′=70°;

(2)攝像頭分辨率為1 280×720,采集速度30 f/s;

(3)攝像頭高度h=285.5 cm,標志物質心距離地面的高度?h=51.5 cm,攝像頭光軸與地面交點G到O點的距離y1=134.6 cm。

圖7 實驗環境

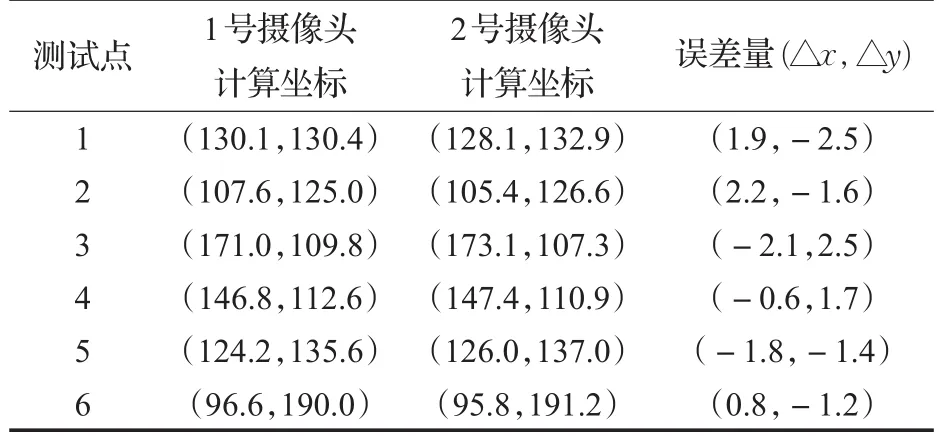

5.1 單目路徑規劃導航實驗

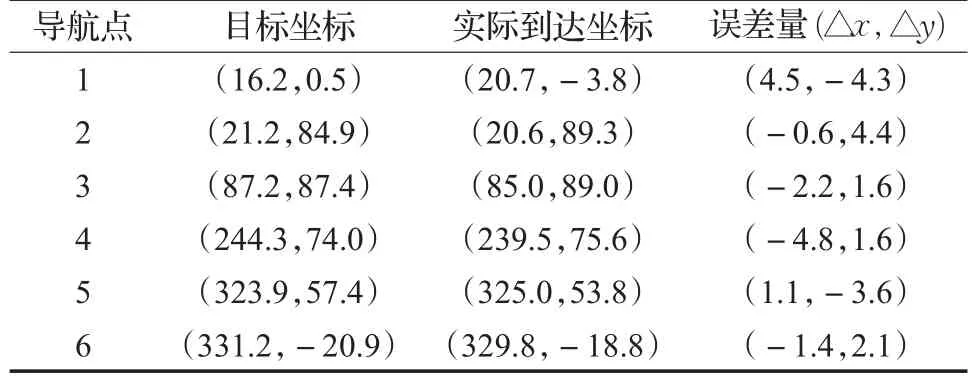

自動運輸車單個攝像頭規劃路徑導航場景,如圖8所示。為了模擬標志物被遮擋的情況,在場地中人為地加入了一塊比較高的擋板,當AGV從2點運輸到3點的時候,過程中車的紅色球標志物會被擋住,失去實時坐標靠MPU6050陀螺儀慣性導航行走。并記錄運輸車到達每一個目標點的坐標情況制表1。

圖8 單目路徑規劃導航

表1 單目路徑規劃導航 cm

表1表明AGV實際到達坐標跟設定目標點存在有±2.2 cm左右誤差,這是因為AGV自身程序設定允許±5.0 cm左右誤差,因此該誤差屬于合理值,也是滿足自動運輸車定位作業的精度要求。設定±5.0 cm左右誤差是為了解決實際運輸中超過了目標坐標需要運輸車不斷調整問題。實驗表明設定合理的誤差閾值,可以使定位系統更加高效、快速。

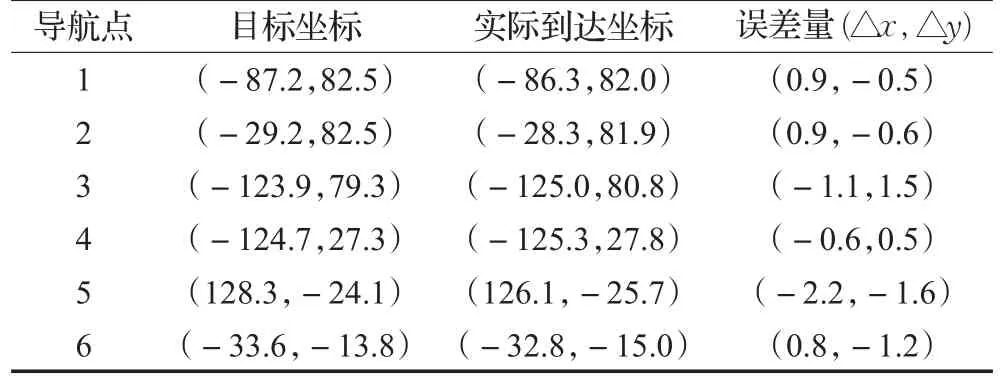

5.2 雙目協同擴展空間誤差分析

將自動運輸車以不定距無規律地擺放在兩個攝像頭交叉視場域中6個不同的位置,兩個攝像頭分別計算出小車的實際物理空間坐標,制得表2視場擴展誤差分析。

表2兩目誤差分析結果為兩個攝像頭計算物理空間坐標誤差是±3.0 cm,理論上AGV擺放一個位置兩個攝像頭計算出來的物理空間坐標應該是一致的,但是由于設備的誤差、實驗參數測量的誤差導致視場擴展也存在一定的誤差,因而兩個視場計算出的坐標就存在一定的誤差值。在定位視場寬高5.0 m×5.0 m視場范圍內,±3.0 cm的擴展誤差是可接受的,可實現正常的規劃導航。

表2 雙目視場擴展誤差分析 cm

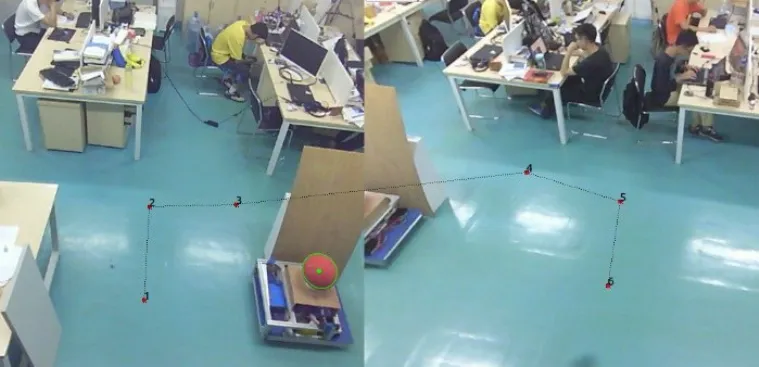

5.3 多目協同路徑規劃導航實驗

以兩目擴展導航為實驗,測試場景如圖9所示。擺放好兩個攝像頭位置,讓兩個視場有一定的交叉域,開啟上位機的視場校正模式。將AGV車擺放在交叉域中兩個不同位置,軟件自動計算出擴展參數完成兩個視場的物理空間擴展。記錄運輸車到達每一個目標點的坐標情況制表3。

圖9 多目路徑規劃導航場景

表3 多目路徑規劃導航cm

AGV成功地依次經過6個目標導航點,最終抵達終點。表3顯示導航誤差為±5.0 cm,屬于設定的誤差范圍內。兩目協同導航的成功驗證了視場擴展算法的正確性。如果擴展算法錯誤,則當運輸車從一個視場到達另外一個視場的時候坐標會不一致,這個時候自動車就會重新計算出一條新路徑,而這條路徑是不可預知的,將會帶來一些不可預料問題最終無法實現多目視覺多點規劃導航。同時兩目視場物理空間的擴建推導理論是可以應用于多目攝像頭視場的擴建,且擴展靈活性高,只需要讓攝像頭之間有一定交叉域就可以實現多目協同導引AGV運輸作業,從而實現大范圍導航。

6 結束語

針對目前視覺定位存在的未解決問題,文中提出一種以紅色單球為車體標志物的多目視覺協同導引AGV運輸車的方案并實驗驗證。具有以下三方面的特點:(1)采用單球代替雙球標志物,具有識別速度快、穩定性高的優勢。選擇球體標志物的好處是任意視角下看到的都是圓,具有不變性。(2)自動運輸車主控導航控制算法采用分時雙閉環反饋設計,通過安裝MPU6050利用慣性導航解決球體被遮擋情況。(3)多目攝像頭視場協同引導自動運輸車,攝像頭之間通過視場交叉域建立起統一的坐標關系,解決了在寬廣的室內環境中需要大范圍的定位導航作業。

定位系統支持單點和多點路徑規劃導航,可靈活更改自動運輸車的規劃路徑,同時通過軟件擴展算法可靈活地實現多目視覺定位協同導引自動運輸車。最終實驗結果表明:單目定位視場范圍在5.0 m×5.0 m大小內,計算出的雙目物理視場擴展誤差為±3.0 cm。無論是單目還是多目視覺的多點路徑導航誤差都達到±5.0 cm預期內,具有可擴展性好、定位范圍大、靈活性高的優勢,可應用于工業上復雜的室內環境以及運輸作業范圍要求大的物理空間場合。接下來繼續研究:(1)多車在多目視場中的調度運輸導航;(2)自動運輸車避障功能。

參考文獻:

[1]趙銳,鐘榜,朱祖禮,等.室內定位技術及應用綜述[J].電子科技,2014(3):154-157.

[2]Ye X,Wang Y,Hu W,et al.WarpMap:Accurate and efficient indoor location by dynamic warping in sequencetype radio-map[C]//2016 13th Annual IEEE Int Conf on Sensing,Communication,and Networking,2016:1-9.

[3]Xu D,Han L,Tan M,et al.Ceiling-based visual positioning for an indoor mobile robot with monocular vision[J].IEEE Transactions on Industrial Electronics,2009,56(5):1617-1628.

[4]Takahashi Y.Mobile robot self localization based on multiantenna-RFID reader and IC tag textile[C]//IEEE Workshop on Advanced Robotics and Its Social Impacts,Tokyo,2013:106-112.

[5]Huang H,Yang A,Feng L,et al.Indoor positioning method based on metameric white light sources and subpixels on a color image sensor[J].IEEE Photonics Journal,2016,8(6):1-10.

[6]李金超.基于視覺的自動尋跡AGV控制系統研究[D].河北秦皇島:燕山大學,2014.

[7]李君.全局視覺導航AGV控制原理與技術的研究[D].武漢:武漢理工大學,2007.

[8]易弘.AGV視覺導航研究[J].國外電子測量技術,2010(2):44-46.

[9]林劍冰,蘇成悅,鄭俊波,等.機器視覺導引的室內自動運輸車定位系統[J].機械科學與技術,2015(11):1675-1681.

[10]Vaishnavi D,Subashini T S.Recognizing image splicing forgeries using histogram features[C]//Mec Int Conf on Big Data&Smart City,2016:1-4.

[11]涂波,劉璐,劉一會,等.一種擴展小孔成像模型的魚眼相機矯正與標定方法[J].自動化學報,2014(4):653-659.

[12]趙紅雨,吳樂華,史燕軍,等.基于HSV顏色空間的運動目標檢測方法[J].現代電子技術,2013(12):45-48.

[13]趙同剛,陳迅.基于監督學習的Canny圖像邊緣檢測改進算法研究[J].半導體光電,2016(5):731-734.

[14]王文波.基于單目視覺的實時測距方法研究[D].遼寧大連:大連理工大學,2014.

[15]王旭鳳.基于慣性導航的室內定位系統的研究[D].長春:吉林大學,2015.

[16]張奎,雷勇.無刷直流電機智能PID控制系統建模與仿真[J].測控技術,2015(4):81-84.