基于卷積網絡特征的逆向稀疏建模的目標跟蹤

孫文靜 朱文球 王業祥 劉少林

(湖南工業大學計算機學院 湖南 株洲 412007)

0 引 言

目標跟蹤是計算機視覺領域的一個非常重要的突破,也是許多研究學者現在的主要研究方向。目前,目標跟蹤已經在智能監控、智能交通、人機交互、醫學圖像等方面得到廣泛應用。目標跟蹤問題可以被理解為在一個場景中估計目標的運動軌跡,然而在跟蹤過程中,目標可能會發生遮擋、尺度、形狀等變化,對于場景環境,如光照變化、噪聲、復雜背景等也會影響目標跟蹤的魯棒性和準確性。

在傳統的目標跟蹤方法中,大多采用顏色、紋理、HOG、Harr、SIFT、SURF等單一特征進行目標建模,或者使用多種特征融合進行目標建模,從而使提取的目標特征更具有表達能力、抗變性和可區分性。針對目標表觀變化和遮擋問題,在文獻[1-2]中又引入了分塊思想。雖然基于傳統特征的目標跟蹤方法已取得一定的成績,但是以上特征都是人工設計,有時只能適用某一特定目標的跟蹤,如Harr特征適用于人臉檢測,HOG特征適用于行人檢測;其次,只提取目標的一種或幾種低層特征,并不能較全面地表示目標的特性;再次,如提取SIFT特征、多種融合特征,計算比較復雜,在一定程度上會降低目標跟蹤的實時性。2006年,Hinton等[3]的突破性進展表明:多層神經網絡模型有很強的特征學習能力,深度學習模型學習到的特征數據對原始數據有更本質的代表性。近年來深度學習已被廣泛地應用到語音識別、圖像識別和自然語言處理領域,通過神經網絡能夠從數據中自動學習更抽象、更豐富、表達能力更強的高層特征。2013年,Wang等[4]把深度學習成功應用到了目標跟蹤中,并取得較好的成績。其后,Wang等[5]通過分析低層網絡特征包含更多目標細節,高層網絡特征偏向目標整體語義信息的特點,利用全卷積網絡(VGG-16)提取的高低層特征實現了目標跟蹤 ,在一定程度上解決了目標漂移問題,同時對目標本身的形變具有更加魯棒的效果。針對目標與背景出現角色轉換的問題,Nam等[6]提出了MDNet。Cui等[7]利用多向神經網絡來建模和挖掘對整體跟蹤有用的可靠目標部分,最終解決預測誤差累計和傳播導致的跟蹤漂移問題。因此,本文也將采用卷積網絡實現特征提取。同時受到簽名認證連體網絡[8]的啟發,并且在文獻[9-10]中,也都采用了類似的網絡結構,在人臉檢測與圖片相似度判別方面有一定的優勢。基于這種思想,本文的網絡結構也將使用連體網絡,一個用于正樣本的特征提取,另一個用于視頻幀的特征提取。在文獻[11-13]中,采用正向稀疏約束選取候選目標,雖然提高了性能,大量的正負模板增加了計算量。本文加入逆向稀疏建模思想,對候選樣本進行選擇,減少了模板數量,從而實現了較為魯棒的目標跟蹤。

1 相關內容

1.1 粒子濾波理論

在視覺目標跟蹤中,最常采用例子濾波跟蹤框架預測下一幀目標和更新目標位置。設xt表示t時刻的目標狀態,yt表示t時刻的視頻幀,y1:t表示初始1~t時刻所有的視頻幀。目標跟蹤的含義是利用直到當前時刻所有視頻幀估計出當前時刻目標狀態的后驗分布,即p(xt|y1:t)。粒子濾波框架主要包含預測和更新兩步:

1) 預測階段:利用上一時刻視頻幀的狀態對當前時刻目標狀態進行估計:

(1)

式中:p(xt|xt-1)描述了目標狀態在相鄰時刻之間的轉移,稱為轉移分布。

2) 更新階段:利用yt對后驗分布p(xt|y1:t)進行更新:

(2)

式中:p(yt|xt)代表當前給定目標狀態時的概率,成為似然分布。

(3)

1.2 稀疏表示理論

設模板集合T={ti∈Rd×1},i=1,2,…,m,d表示模板圖像的特征維數,m表示模板個數(包含正負模板)。在目標跟蹤過程中,粒子濾波算法會產生許多粒子,也就是候選樣本集Y={yj∈Rd×1},j=1,2,…,n,n表示粒子個數。正向稀疏表示思想就是用模板集合T中的幾個模板來線性表示每一個候選樣本yj,即yj=Tα。為了保證α的稀疏性,通過添加稀疏約束條件進行限制,即求解如下表達式:

(4)

式中:‖·‖2、‖·‖1分別表示L2范數和L1范數,μ是正則化參數,α是稀疏相關系數,表示所有模板與候選樣本yj的相關性,系數值越大,相關性越大。

2 基于卷積網絡特征的逆向稀疏建模

2.1 卷積網絡與特征提取

本文采用五層卷積神經網絡,在每一層卷積操作后通過非飽和的ReLU激活函數進行激活,在第一、第二層的激活后又添加了池化操作,具體網絡結構如圖1所示。網絡輸入圖片可以是灰度圖片,也可以是彩色圖片,最終網絡輸出大小為6×6的256維的特征集。

圖1 卷積網絡結構

2.2 逆向稀疏建模

在粒子濾波跟蹤算法[11-13]中,經常通過求解如下的L1范式最小化問題,對粒子進行非負稀疏約束表示,從而評估每個粒子的重要性。但是對于模板集除了需要包含正模板,還需要引入負模板,以此來避免跟蹤目標漂移,并且大量的L1范式計算將會降低目標跟蹤的時效性。

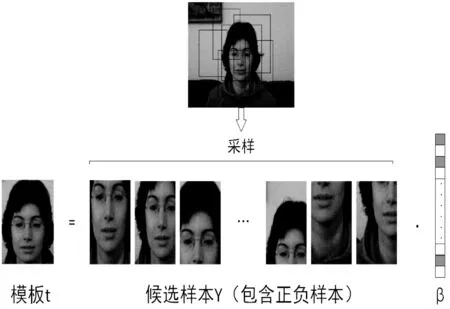

受到正向稀疏理論的啟發,本文算法采用逆向稀疏思想判斷候選樣本與模板的相關性,即用候選樣本稀疏表示模板,具體表示過程如圖2所示。目標模板為要跟蹤的目標(正模板),在候選樣本集中也只有與目標相近的候選樣本才和正模板有較大的相關性。因此上述逆向稀疏理論可轉化為如式(5)的求解問題。相比正向稀疏表示,逆向稀疏表示每一幀也只需對一個模板進行求解,減少了大量計算。

(5)

圖2 逆向稀疏建模示意圖

經過卷積網絡處理后輸出的特征是高維的,為了簡化計算,將模板和候選樣本集平鋪成矩陣再進行稀疏約束優化求解。

2.3 最佳粒子選擇

上述逆向稀疏求解將得到每種特征對應的稀疏系數,那么模板的重建殘差為:

(6)

(7)

2.4 目標模板更新

在跟蹤過程中,目標會出現姿態、尺寸、遮擋等變化,如果模板保持不變,會出現目標漂移或者丟失的現象,所以很有必要采用某種模板更新策略。對于模板更新太過頻繁而導致累積誤差造成的跟蹤漂移,Mei等[14]根據候選樣本與模板的相似性更新模板;Wei等[15]在此基礎上,對負模板更新加以距離限制,即遠離目標區域8像素距離;Zhuang等[11]利用歐式距離來判別是否更新正模板。

本文算法采用模板重建殘差來判斷是否更新模板。在上一節中得到每一維特征的重建殘差,對應特征重建殘差向量為E=[e1,e2,…,e256],如果誤差小于一定閾值θ,則用最佳候選粒子對應的特征進行替換;否則保持不變。由于模板特征維數高,在不斷更新的過程中,既可能保留了之前視頻幀的目標特征,也可包含最近視頻幀的特征,對目標的本身變化具有一定的魯棒性。

2.5 算法流程

1) 輸入:當前幀:Ft

2) 初始化,將第一幀的粒子集和手動標注的目標調整為127×127大小圖片后送入卷積網絡,進行特征提取,其中目標特征集直接作為正模板。

4) 利用式(5)進行對特征平鋪矩陣求解稀疏系數矩陣β。

5) 利用殘差式(6)評估目標重建誤差。

6) 通過最大后驗概率和式(7)估計出最佳粒子。

7) 模板更新:如果模板每一維特征重建誤差小于一定閾值θ,則用最佳粒子對應維數的特征進行替換;否則,保持不變。

8) 保留當前幀的目標位置和更新后的目標模板。

9) 循環3~8操作,直到視頻結束。

10) 輸出整個視頻的目標跟蹤結果。

3 實驗結果與分析

實驗中以MATLAB 2014b為編程工具,在Ubunhtu 16.04操作系統環境下進行實驗,為了加速計算,本機配置了獨立顯卡(Quadro K1200,顯存256 MB)。本文算法中的參數λ值為0.25,θ為0.6。測試視頻數據集來源于http://cvlab.hanyang.ac.kr/tracker_benchmark/datasets.html,主要選取了包含復雜背景、遮擋、快速運動和光線變化環境因素的數據集:Skating1、Freeman4、Faceocc1、MotorRolling、Car4、Shaking。實驗分析部分采用其他5種跟蹤算法與本文算法在定性和定量兩個標準上評估。對比方法包括基于核的在線結構輸出預測的Struck[16]算法、基于增強分類器的OAB[17]算法、基于區域積分直方圖的Frag[18]算法、采用加速梯度方法的最小化L1范數的L1APG[19]跟蹤算法,以及跟蹤學習檢測的TLD[20]算法。

3.1 定性分析

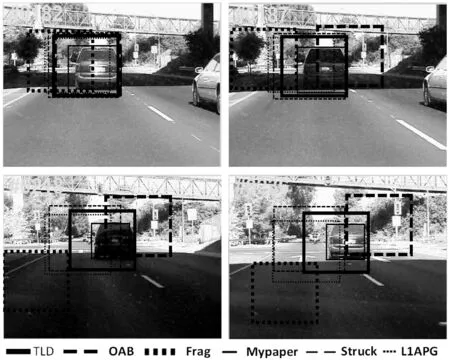

圖3、圖4、圖5分別展示了5種跟蹤算法與本文算法在復雜背景、遮擋、快速運動和光線變化環境下的跟蹤對比。

圖3 光線變化因素

圖4 速度變化因素

圖5 復雜背景和遮擋因素

1) 光線變化。圖3主要展示了車輛經過鐵橋時光線從亮到暗再從暗到亮的跟蹤效果。下圖182幀和187幀是亮度從量到暗的跟蹤效果,Frag算法發生了漂移,后續幀直接丟失目標。218幀和236幀展現了從暗到亮的跟蹤效果,OAB、Struck、L1APG均出現漂移。雖然TLD算法也能夠跟蹤到目標,但相較于本文算法,精確度不高。

2) 目標快速運動。如圖4所示,開始跟蹤效果都比較好,在28幀目標開始下降,在接下來經過35幀、39幀時,OAB算法一直都能捕捉到目標,相對于另外5種方法,本文算法的性能較好。接下來隨著目標的快速前進和上升,本文算法也能夠取得較好的跟蹤效果。在88幀目標到達最高點時,只有OAB和本文算法依然可跟蹤到目標。

3) 目標在復雜背景情況下被遮擋。如圖5所示,在第53幀時,由于復雜背景的干擾,OAB和Frag算法已丟失跟蹤目標,TLD算法發生了目標漂移,Struck、L1APG和本文算法表現良好。在第82幀目標發生部分遮擋時,Struck和TLD算法也出現了丟失目標的現象,本文算法依然能夠捕捉到跟蹤目標。不過在240幀時,本文算法也出現了跟蹤位置輕微偏離,但當目標完全顯露時,跟蹤位置就很快回歸到了目標位置。

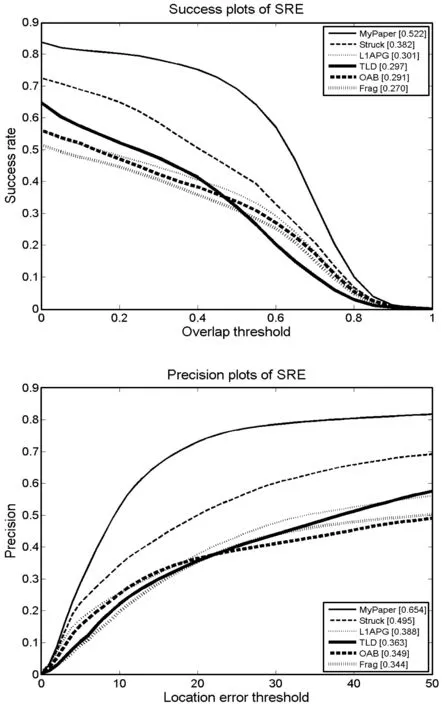

3.2 定量分析

為了更具體地衡量跟蹤算法的性能,本節既采用中心位置誤差和重疊率對6種跟蹤方法進行定量分析,又采用在時間魯棒性評估(TRE)和空間魯棒性評估(SRE)測試跟蹤器的魯棒性。

1) 中心誤差為各跟蹤算法估計的中心位置與手工標注的真實目標中心的歐氏距離,距離越小,表明跟蹤效果越好。重疊率為跟蹤框區域和真實目標區域的交集比上它們的并集,其值越大,則說明跟蹤結果與目標真實位置越接近。表1和表2分別描述了平均中心誤差和平均中心率。從結果對比發現,本文算法在以上兩種衡量標準下整體優于其他5種跟蹤算法,進一步表明本文算法的跟蹤性能較好。

表1 6種跟蹤算法的平均重疊率

表2 6種跟蹤算法的平均中心定位誤差(像素個數)

2) 時間魯棒性評估是從不同視頻幀開始跟蹤,統計其跟蹤結果的重疊率和中心誤差率。空間魯棒性評估是通過偏移或縮放目標真實位置邊框來抽取初始化的邊界框,然后對跟蹤結果進行評估。從圖6和圖7的曲線可以看出,本文算法在不同情況下均表現出較好的跟蹤效果。

圖6 時間魯棒性評估曲線圖

圖7 空間魯棒性評估曲線

4 結 語

在目標跟蹤過程中,抗變性的目標表示對跟蹤效果有很大的影響,本文采用卷積神經網絡代替傳統的特征提取方法,利用高層特征的語義性、抽象性來提高目標表示的抗變性。同時,引入逆向稀疏思想,只用一個正模板進行L1范式稀疏約束求解,直接選取最佳候選樣本。實驗結果表明,在光線變化、目標快速運動、復雜背景以及遮擋情況下,相比于其他算法,本文算法的跟蹤效果較好。

[1] 劉振興,范新南,李敏.融合SURF特征的改進自適應分塊目標跟蹤算法[J].計算機工程與設計,2016,37(2):454-459.

[2] 鮑華,趙宇宙,張陳斌,等.基于自適應分塊表觀模型的視覺目標跟蹤[J].控制與決策,2015,31(3):448-452.

[3] Hinton G E,Salakhutdinov R R. Reducing the dimensionality of data with neural networks[J].Science,2006,313(5786):504-507.

[4] Wang N, Yeung D Y. Learning a deep compact image representation for visual tracking[C]//International Conference on Neural Information Processing Systems. Curran Associates Inc. 2013:809-817.

[5] Wang L, Ouyang W, Wang X, et al. Visual Tracking with Fully Convolutional Networks[C]//IEEE International Conference on Computer Vision. IEEE, 2016:3119-3127.

[6] Nam H, Han B. Learning Multi-domain Convolutional Neural Networks for Visual Tracking[C]//Computer Vision and Pattern Recognition. IEEE, 2016:4293-4302.

[7] Cui Z,Xiao S,Feng J,et al.Recurrently target-attending tracking[C]//IEEE Conference on Computer Vision and Pattern Recognition.IEEE Computer Society,2016:1449-1458.

[8] Bromley J, Guyon I, Lecun Y, et al. Signature verification using a siamese time delay neural network[C]//Advances in Neural Information Processing Systems.DBLP,1993:737-744.

[9] Taigman Y, Yang M, Ranzato M, et al. DeepFace: Closing the gap to human-level performance in face verification[C]//IEEE Conference on Computer Vision and Pattern Recognition. IEEE, 2014:1701-1708.

[10] Zagoruyko S, Komodakis N. Learning to compare image patches via convolutional neural networks[C]//Computer Vision and Pattern Recognition. IEEE, 2015:4353-4361.

[11] Zhuang B, Lu H, Xiao Z, et al. Visual tracking via discriminative sparse similarity map[J]. IEEE Transactions on Image Processing, 2014, 23(4):1872-1881.

[12] Wang D, Lu H, Bo C. Online visual tracking via two view sparse representation[J]. IEEE Signal Processing Letters, 2014, 21(9):1031-1034.

[13] Wang D, Lu H, Xiao Z, et al. Inverse sparse tracker with a locally weighted distance metric[J]. IEEE Transactions on Image Processing A Publication of the IEEE Signal Processing Society, 2015, 24(9):2646-2657.

[14] Mei X, Ling H. Robust visual tracking using l(1) minimization[C]//IEEE, International Conference on Computer Vision. DBLP, 2009:1436-1443.

[15] Zhong W, Lu H C, Yang M H. Robust object tracking via sparsity-based collaborative model[C]//IEEE Conference on Computer Vision and Pattern Recognition. IEEE Computer Society, 2012:1838-1845.

[16] Hare S, Saffari A, Torr P H S. Struck: Structured output tracking with kernels[C]//IEEE International Conference on Computer Vision. IEEE, 2011:263-270.

[17] Grabner H, Grabner M, Bischof H. Real-time tracking via on-line boosting[C]//British Machine Vision Conference 2006, Edinburgh, Uk, September. DBLP, 2006:47-56.

[18] Adam A, Rivlin E, Shimshoni I. Robust fragments-based tracking using the integral histogram[C]//IEEE Computer Society Conference on Computer Vision and Pattern Recognition. IEEE Computer Society, 2006:798-805.

[19] Bao C, Wu Y, Ling H, et al. Real time robust L1 tracker using accelerated proximal gradient approach[C]//Computer Vision and Pattern Recognition. IEEE, 2012:1830-1837.

[20] Kalal Z, Matas J, Mikolajczyk K. P-N learning: Bootstrapping binary classifiers by structural constraints[C]//Computer Vision and Pattern Recognition. IEEE, 2010:49-56.