基于PReLUs-Softplus非線性激勵函數的卷積神經網絡*

郜麗鵬,鄭 輝

(哈爾濱工程大學 信息與通信工程學院,哈爾濱 150001)

基于PReLUs-Softplus非線性激勵函數的卷積神經網絡*

郜麗鵬,鄭 輝

(哈爾濱工程大學 信息與通信工程學院,哈爾濱 150001)

針對卷積神經網絡表達能力和識別效果受卷積層激勵函數影響的問題,提出了一種新型非線性激勵函數PReLUs-Softplus,并將其應用于神經網絡卷積層.對新型神經網絡和采用傳統激勵函數的神經網絡在MNIST和CIFAR-10標準數據庫上進行了圖像識別對比實驗,結果表明,相比于采用傳統激勵函數的神經網絡,使用PReLUs-Softplus激勵函數的卷積神經網絡在不同的池化方式下圖像識別計算收斂速度更快,顯著降低了識別的錯誤率.

深度學習;卷積神經網絡;激勵函數;模式識別;非線性映射;池化;網絡結構;圖像識別

與傳統的神經網絡不同,卷積神經網絡作為深度學習中一種常見的模型,輸入是原始圖像,而非提取出來的圖像特征,免去了復雜的特征提取過程.卷積神經網絡模型作為新興的分類器在多個領域得到了廣泛應用,如字符識別[1]、語音識別[2]、人臉識別[3]、人體行為理解[4]、交通信號識別[5]、情感識別[6]和手勢識別[7-8]等.在卷積神經網絡結構中,卷積的操作過程是線性的,表達能力較弱.通過使用非線性映射的激勵函數可以顯著提高神經網絡的表達能力,激勵函數的選取直接決定著網絡性能的優劣.飽和非線性激勵函數如雙曲正切函數(Tanh)和S形生長曲線(Sigmoid)在神經網絡領域取得了良好成果,但存在收斂速度慢和梯度彌散導致的不收斂等問題.近年來,生物學家建立了能夠更加精確地模擬腦神經元接受信號過程的激勵模型ReLUs(Rectified Linear Units).ReLUs模型具有計算簡單、收斂速度快和識別精度高等優點,較好地解決了使用Tanh函數和Sigmoid函數的神經網絡存在的問題,但是ReLUs函數網絡可能導致神經元壞死的現象[9].隨后有學者提出了ReLUs函數的變形函數形式ReLUs-Leaky和PReLUs(Parametric ReLUs),這兩種函數繼承了ReLUs函數的優點,具備一定的稀疏能力,解決了神經元壞死的問題.但是以上三種ReLUs族激勵函數在x軸的正半軸沒有本質變化,對神經網絡進行了線性修正,因此欠缺對模型的表達能力.Softplus函數是對ReLUs函數的一種非線性表達,Softplus函數是一個近似光滑的非線性函數,從曲線形式上看更加契合生物神經元的激活特征,但欠缺稀疏表達能力.本文綜合PReLUs和Softplus函數優點,提出了一種新的不飽和非線性函數PReLUs-Softplus,其具備稀疏表達能力,收斂速率快,識別精度高.

1 卷積神經網絡

卷積神經網絡有別于其他形式的神經網絡,通過對輸入的原始圖像進行直接卷積運算實現對旋轉、平移和放縮圖像的自適應識別,其網絡結構如圖1所示.

圖1 卷積神經網絡結構Fig.1 Convolutional neural network structure

(1)

(2)

式中,f(·)為神經元的激勵函數.

采樣層是通過降采樣和池化手段獲得特征圖像的子模塊集合,子模塊之間不能互相重疊.CNNs采樣層的池化方式分為均值池化、最大池化和隨機池化三種形式[10].

卷積神經網絡與其他神經網絡的相同之處是均采用前向傳播學習進行圖像分類,采用反向傳播更新權重和偏置的方式進行學習.不同之處在于卷積神經網絡的權值和偏置以卷積核的形式存在,前向傳播通過多層卷積層和采樣層的交替作用直接學習原始圖像[11].反向傳播算法更新權值的公式為

W(t+1)=W(t)-ηδ(t)x(t)

(3)

式中:x(t)為該神經元的響應輸出;δ(t)為該神經元的誤差項;η為學習率.

CNNs的輸入層和采樣層均不含激活函數,通常使用CNNs模型進行分類時,輸出層一般采用Sigmoid函數.因此,本文僅對卷積層使用不同激活函數的神經網絡模型的性能進行研究.

2 常用激活函數及其特性

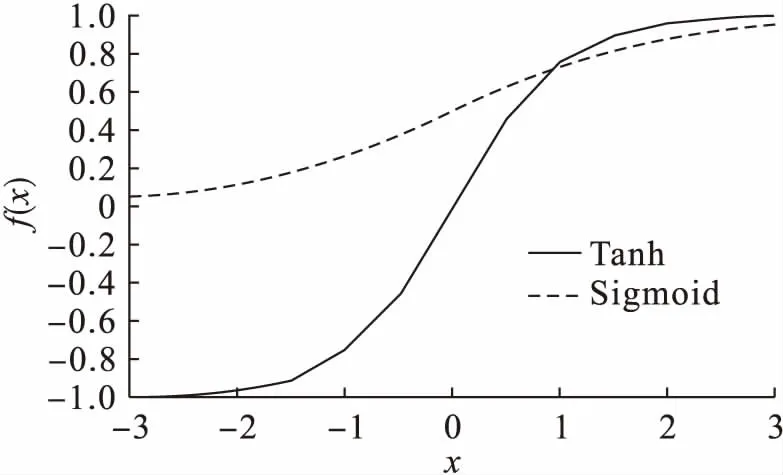

卷積神經網絡提出后,激勵函數的選擇一直是學者們研究的熱點.Tanh、Sigmoid激勵函數和Softplus、ReLUs激勵函數以及ReLUs族函數的圖形如圖2~4所示,其表達式分別如下所示.

1) 飽和非線性函數

Tanh函數的表達式為

圖1給出了從故障開始到重合閘的設備操作順序,如保護繼電器、斷路器、重合閘繼電器等。在繼電保護動作和斷路器跳閘后,斷路器重合閘之前還需要電去離子時間。在此期間,次級電弧應滅弧。根據斷路器的斷開與斷路器重合閘以恢復電力傳輸之間的間隔定義重合閘間歇時間:

圖2 飽和非線性函數曲線Fig.2 Saturated nonlinear function curves

圖3 不飽和非線性函數曲線Fig.3 Non-saturated nonlinear function curves

圖4 ReLUs族函數曲線Fig.4 ReLUs family function curves f(x)=(ex-e-x)/(ex+e-x)

(4)

Sigmoid函數的表達式為

f(x)=(1+e-x)-1

(5)

2) 不飽和非線性函數

ReLUs函數的表達式為

f(x)=max(0,x)

(6)

Softplus函數的表達式為

f(x)=ln(ex+1)

(7)

3) ReLUs族函數

ReLUs族函數的表達式為

(8)

由圖2可知,飽和非線性激勵函數Tanh的曲線與Sigmoid函數的曲線具有相同的趨勢,只是函數值域不同.由于激勵函數的輸出中心為零,不會出現權重“Z”字下降情況,但是激勵函數關于零點奇對稱的特性與生物神經元的基本特征并不相符.Sigmoid函數具有連續可微分性的特征,一度成為激活函數的最優選擇,但是后續研究表明其不具有稀疏特性,而且收斂速度較慢.由圖3可知,ReLUs激勵函數曲線自變量小于0時的輸出為0,從而獲得稀疏表達能力;Softplus函數是對ReLUs函數的非線性平滑表示,具有非線性映射糾正的能力,但其欠缺稀疏表達能力.在ReLUs族函數的Leaky-ReLUs函數表達式中,a通常取一個較小的數,如0.01、0.05等固定值,不再是直接壓縮至0,而是將x<0部分的輸出值壓縮1/a倍,這樣既起到修正數據分布的稀疏作用,又不會造成神經元壞死,在后面幾層需要負軸信息時不至于完全無法恢復.PReLUs表達式中的a是在高斯分布中抽取的一個隨機數,在測試過程中可對a進行修正.研究人員通過實驗論證指出,相比Leaky-ReLUs函數,PReLUs函數的圖像識別準確率提高了1.03%.PReLUs函數繼承了Leaky-ReLUs函數的一切優點,但是由于ReLUs族激勵函數對x>0部分的數據只進行了線性修正,所以對樣本模型的表達能力仍有所欠缺.

3 PReLUs-Softplus激活函數及其特征

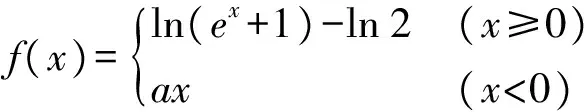

綜合PReLUs和Softplus等非線性修正激活函數的特點,本文提出了一種新型非線性飽和激勵函數.該激勵函數繼承了PReLUs激活函數的稀疏特性和Softplus函數的光滑特性,既實現了稀疏表達,又不會造成神經元壞死,同時還實現了激勵函數的光滑非線性映射,更貼近于人腦神經元的激勵模型.分別對Softplus函數和PReLUs函數進行變換,就可得到PReLUs-Softplus激勵函數,即首先將Softplus函數曲線下移ln 2個基本單位,然后把x<0部分的輸出數據設為ax,修正后函數記為PReLUs-Softplus,函數曲線如圖5所示,其表達式為

(9)

由圖5可以看出,a為一個被訓練的常數,PReLUs-Softplus激勵函數的負半軸斜率將根據實時訓練發生變化,最終收斂為適宜的常數.PReLUs-Softplus具有靈活的稀疏表達能力,為了增強對樣本模型的表達能力,該激勵函數對x>0部分的數據進行了連續光滑的非線性修正,此外該激活函數一階導數曲線在x>0的部分是連續光滑的增函數,在卷積層應用該激勵函數的神經網絡更容易收斂并獲得最優解.

圖5 PReLUs-Softplus函數曲線Fig.5 PReLUs-Softplus function curves

4 實驗結果及分析

為了驗證采用PReLUs-Softplus激勵函數卷積神經網絡在圖像識別中應用的效果,分別在MNIST和CIFAR-10數據庫上進行了實驗研究.全輸出層的激勵函數均為Sigmoid函數,卷積層的激勵函數分別選取本文提出的PReLUs-Softplus和傳統的激勵函數,對比兩種網絡的識別效果.實驗設置如下:Matlab版本為2016a,操作系統為Windows 7專業版,CPU為INTEL i7-6700,主頻為3.4 GHz,內存為8 GB.

4.1 MNIST實驗

MNIST庫為手寫羅馬數字(0~9)數據庫,其中包含訓練圖片60 000張,測試圖片10 000張,圖片規格為28×28大小的灰度圖像.樣本庫中部分訓練圖片如圖6所示,部分測試圖片如圖7所示.

圖6 部分訓練圖片Fig.6 Partial training images

CNNs網絡結構設置為6C-2S-12C-2S-200F,卷積核大小為5×5,6C/12C表示映射出6個卷積層/12個卷積層;2S表示采樣窗口為2的采樣層;200F表示200個神經元組成的全連接層.CNNs網絡模型的訓練過程中,由于實驗環境和網絡結構以及選擇激勵函數的不同,訓練時間也會存在差別,本文實驗中進行一次訓練的時間約為40~70 s.以Softplus激勵函數神經網絡為例,遍歷整個訓練庫,每訓練50張圖片迭代一次,最終獲得卷積層和全連接層的權值和偏置,第二層神經層(卷積層)和第四層神經層的權值如表1、2所示,限于篇幅,表3只列舉了全連接層的偏置.錯誤率收斂如圖8所示,可見使用PReLUs-Softplus激勵函數的卷積神經網絡在迭代400次后錯誤率就下降到0.1%以下,相較于常用的Sigmoid激勵函數收斂速度顯著加快.

表2 神經網絡第四層訓練所得權值Tab.2 Training weight in fourth layer of neural network

采樣層的池化方式均采用均值池化,卷積層分別使用Sigmoid、Tanh、ReLUs、Softplus、Leaky-ReLUs、PReLUs-Softplus函數作為激勵函數.采用不同激勵函數神經網絡的分類正確率隨迭代次數變化的曲線如圖9所示.

表3 神經網絡連接層偏置Tab.3 Offset of connected layer in neural network

圖8 錯誤率收斂Fig.8 Convergence of error rate

圖9 不同激勵函數下的網絡識別準確率Fig.9 Network recognition accuracy under different excitation functions

正確率的計算公式為

(10)

式中:num(error)為分類錯誤的圖片數;num(test_library)為測試圖片總數.

從圖9中可以看出,以MNIST數據集作為實驗對象,卷積層使用Sigmoid函數作為激勵函數的網絡結構收斂速度最慢,最高識別率只有98.5%;使用Tanh激勵函數的神經網絡取得了較好的收斂效果和識別準確率,其準確率達到98.87%;使用Softplus函數作為卷積層激勵函數的網絡收斂速度相比于Sigmoid函數有所提高,識別準確率提高至98.80%;使用ReLUs函數作為卷積層激勵函數的神經網絡收斂速度較快,識別準確率達到99.09%;使用ReLUs族函數的收斂速度進一步提升且準確率最高可達到99%以上;使用本文提出的PReLUs-Softplus激活函數的卷積神經網絡的識別準確率高達99.55%.

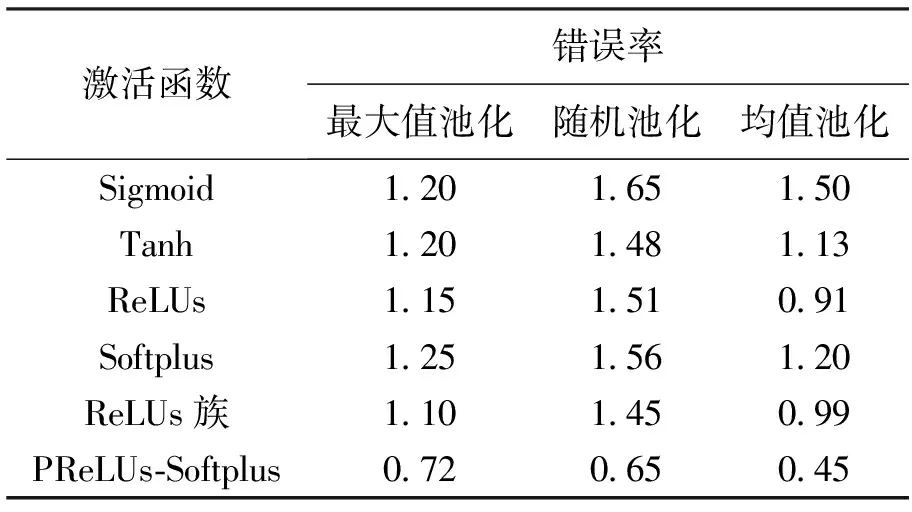

池化方式分別采用最大值池化和隨機池化進行上述實驗,數據庫遍歷次數設置為50次,測試結果如表4所示.

表4 MNIST數據集實驗結果Tab.4 Experimental results in MNIST database %

從表4中可以看出,在實驗的測試訓練過程中,采樣層的池化方式為最大池化時,傳統的激活函數網絡錯誤率均約為1.2%,而使用PReLUs-Softplus激勵函數的網絡錯誤率降低至0.72%;采用隨機池化時,傳統的激活函數網絡錯誤率均約為1.5%,而使用PReLUs-Softplus激勵函數的網絡錯誤率僅為0.65%,網絡識別性能得到了明顯改善.通過上述實驗驗證可知,PReLUs-Softplus激勵函數神經網絡在不同池化方式下均能明顯地提高圖像識別的準確率.

4.2 CIFAR-10數據庫實驗

CIFAR-10數據庫中含有圖片60 000張,圖片均為32×32的規格,其中50 000張用于神經網絡的訓練,10 000張用于測試神經網絡的性能.CIFAR-10數據庫中的圖片均為彩色圖片,因此在使用CNNs網絡時需要先進行灰度處理,然后進行歸一化.網絡結構的設置為8C-2S-16C-2S-240F,卷積核的大小仍為5×5.采樣層選取不同池化方式,卷積層選取不同激勵函數,神經網絡圖像識別的錯誤率如表5所示.

從表5可以看出,在不同池化方式下,選取PReLUs-Softplus作為激勵函數的神經網絡識別的錯誤率最低.

實驗結果表明,在選取不同池化方式的條件下,卷積神經網絡中使用PReLUs-Softplus作為激勵函數,在兩種數據集上均取得了較傳統神經網絡更低的識別錯誤率.其中,MNIST數據集上的最低錯誤率達到0.45%,而CIFAR-10數據集上錯誤率可降低至31.20%,相較其他形式的激勵函數識別錯誤率分別降低了約1%和2%.

表5 CIFAR-10數據集實驗結果Tab.5 Experimental results in CIFAR-10 database %

5 結 論

本文針對深度學習算法中卷積神經網絡卷積層ReLUs激勵函數對模型表達能力的不足,ReLUs族函數作為激勵函數時容易導致神經元壞死,Softplus函數欠缺稀疏表達能力等問題,提出了一種新型非線性修正函數PReLUs-Softplus作為神經元激勵函數.在MNIST和CIFAR-10兩個數據集上分別進行相關實驗,結果表明,在采用多種池化方式的卷積神經網絡結構中,使用PReLUs-Softplus非線性修正函數作為激勵函數顯著提高了圖像識別的收斂速度,在MNIST數據集上,識別準確率最高達到99.55%;在CIFAR-10數據集上識別準確率最高達到68.80%,相較于其他傳統激勵函數,準確率均有所提高.

[1] Krizhevsky A,Sutskever I,Hinton G E.ImageNet classification with deep convolutional neural networks [C]//Advances in Neural Information Processing Systems.New York,USA,2012:1097-1105.

[2] Abdel-llamid O,Mohamed A R,Hui J,et al.Convolutional neural networks for speech recog-nitionl [J].IEEE-ACM Transactions on Audio Speech and Language Processing,2014,22(10):1533-1545.

[3] Cheung B.Convolutional neural networks applied to human face classification [C]//11th International Conference on Machine Learning and Applications.Boca Raton,USA,2012:580-583.

[4] Ji S W,Xu W,Yang M,et al.3D convolutional neural networks for human action recognition [J].IEEE Transactions on Pattern Analysis and Machine Intelligence,2013,35(1):221-231.

[5] Jin J Q,Fu K,Zhang C S.Traffic sign recognition with hinge loss trained convolutional neural networks [J].IEEE Transactions on Intelligent Tranportation Systems,2014,15(5):1991-2000.

[6] Mao Q R,Dong M,Huang Z W,et al.Learning salient features for Speech emotion recognition using convolutional neural networks [J].IEEE Transaction on Multimedia,2014,16(1):2203-2213.

[7] Stefan D,Berlemont S,Lefebvre G,et al.3D gesture classification with convolutional neural networks [C]//IEEE International Conference on Acoustics.Florence,Italy,2015:5432-5436.

[8] Li S Z,Yu B,Wu W,et al.Feature learning based on SAEPCA network for human gesture recognition in RGBD images [J].Neuron Computing,2015,15(2):565-573.

[9] Nair V,Hinton G E.Rectified linear units improve restricted boltzmann machines [C]//Proceeding of the 27th International Conference on Machine Lea-rning(ICML-10).Madison,USA,2010:807-814.

[10]Zeiler M D,Fergus R.Stochastic pooling for regularization of deep convolutional neural networks [C]//International Conference on Learning Representation.Scottsdale,USA,2013:1-9.

[11]牛連強,陳向震,張勝男,等.深度連續卷積神經網絡模型構建與性能分析 [J].沈陽工業大學學報,2016,38(6):662-666.

(NIU Lian-qiang,CHEN Xiang-zhen,ZHANG Sheng-nan,et al.Model construction and performance analysis for deep consecutive convolutional neural network [J].Journal of Shenyang University of Technology,2016,38(6):662-666.)

ConvolutionalneuralnetworkbasedonPReLUs-Softplusnonlinearexcitationfunction

GAO Li-peng, ZHENG Hui

(College of Information and Communication Engineering, Harbin Engineering University, Harbin 150001, China)

Aiming at the problem that the expression ability and recognition effect of convolutional neural network (CNN) are affected by the excitation function of convolutional layer, a new nonlinear excitation function PReLUs-Softplus was proposed and applied to the convolutional layer in neural network.The contrast experiments on the image recognition of both new neural network and neural network with the traditional excitation function were performed in MNIST and CIFAR-10 standard database.The results show that compared with the neural network with the traditional excitation function, the convolutional neural network with PReLUs-Softplus excitation function has faster convergence rate in the calculation of image recognition under different pooling methods, and can effectively reduce the recognition error rate.

deep learning; convolutional neural network; excitation function; pattern recognition; nonlinear mapping; pooling; network structure; image recognition

2016-11-02.

國家自然科學基金資助項目(61571146).

郜麗鵬(1972-),男,黑龍江哈爾濱人,教授,博士,主要從事寬帶信號檢測、處理和識別以及信息融合等方面的研究.

* 本文已于2017-10-25 21∶12在中國知網優先數字出版.網絡出版地址:http://kns.cnki.net/kcms/detail/21.1189.T.20171025.2112.020.html

10.7688/j.issn.1000-1646.2018.01.10

TN 953

A

1000-1646(2018)01-0054-06

鐘 媛 英文審校:尹淑英)