RGB-D SLAM綜述

王旒軍,陳家斌,余 歡,朱匯申

(北京理工大學 自動化學院,北京 100081)

RGB-DSLAM綜述

王旒軍,陳家斌,余 歡,朱匯申

(北京理工大學 自動化學院,北京 100081)

RGB-D SLAM是指使用RGB-D相機作為視覺傳感器,進行同時定位與地圖構建(SLAM)的技術。RGB-D相機是近幾年推出的能夠同時采集環境RGB圖像和深度圖像的視覺傳感器。首先對主流RGB-D相機,RGB-D SLAM算法框架流程做了介紹,然后對RGB-D SLAM算法的國內外主要標志性成果,以及RGB-D SLAM的研究現狀進行介紹,并對RGB-D SLAM方法前端視覺里程計中特征檢測與匹配、后端位姿圖優化、回環檢測等關鍵技術進行介紹總結。最后,對RGB-D SLAM算法的優缺點進行了分析,并對RGB-D SLAM算法的研究熱點及發展趨勢進行了討論。

RGB-D相機;同時定位與地圖構建;視覺里程計;位姿圖優化;回環檢測

0 引言

對于自主移動機器人,在導航定位方面涉及三個方面的問題:1)我在哪里(where am I);2)我要去哪里(where am I going);3)我要怎么去(How should I get there)[1]。其中第一個是定位問題,第二個是任務規劃問題,第三個為路徑規劃問題。

同時定位與地圖構建( Simultaneous Localization and Mapping,SLAM) 問題描述為:一個機器人在一個陌生的環境中運動,通過自身攜帶的傳感器對周圍環境進行感知,然后繪制陌生環境的地圖,同時定位自己在地圖中的位置[2]。利用SLAM方法可以解決自主移動機器人的定位與建圖問題。使用相機作為傳感器的SLAM方法被稱為視覺 SLAM(VSLAM)。相比于傳統的慣性器件(Inertial Measurement Unit,IMU)和激光雷達(Laser Scanner)等傳感器,相機具有體積小、質量小和價格低等突出的優點,因此,VSLAM成為近年來SLAM算法研究的熱點。

RGB-D相機是新興的視覺傳感器,它可以同時獲取周圍環境的RGB圖像和每個像素的深度(Depth)信息。相比于單目相機和雙目立體相機利用算法計算空間點的三維坐標,RGB-D相機獲取空間點的3D信息更加直接方便,深度信息通過紅外結構光(Structured Light)或飛時(Time-of-flight,TOF)原理測得,和激光雷達有些相似。所以,有時候RGB-D相機又被稱為偽激光雷達(Fake Laser)。由于RGB-D相機能相對容易地獲取RGB圖像上每一個像素的深度數據,并且RGB-D相機價格相對便宜,近年來RGB-D SLAM技術得到快速發展。

1 RGB-D SLAM介紹

RGB-D SLAM使用RGB-D深度相機作為傳感器實現同時定位與地圖構建。經過十多年的研究,雖然不同的研究團隊使用的具體VSLAM算法有所區別,但是這些VSLAM算法都可以歸為前端和后端兩部分,RGB-D SLAM作為VSLAM的一個分支,當然也不例外。本節首先介紹目前使用的主流RGB-D相機的種類并做出對比,然后簡要介紹RGB-D SLAM算法流程,最后介紹RGB-D SLAM的標志性成果。

1.1 RGB-D相機介紹

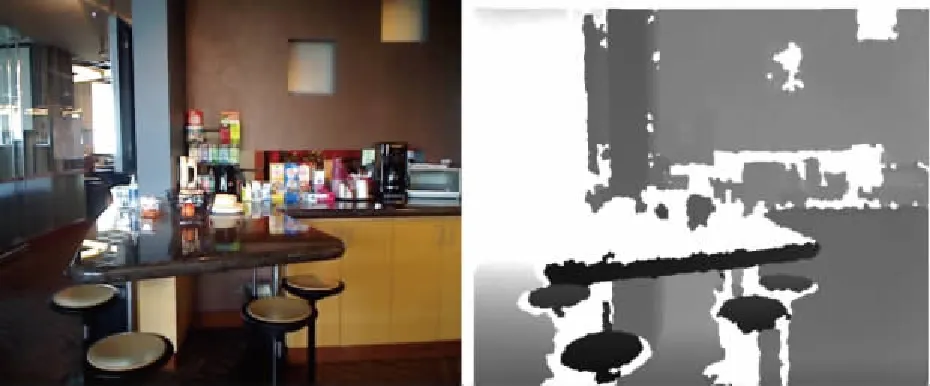

微軟公司于2010年推出的Kinect相機是世界上首款RGB-D相機,Kinect相機是微軟公司針對Microsoft Xbox 360發布的一款由PrimeSense公司開發的體感設備。它由RGB相機、3D深度傳感器、麥克風陣列和機動傾斜馬達等組成[3](圖1)。Kinect相機中間部位是一款RGB彩色鏡頭,圖像分辨率為640×480,最大幀率為30Hz。兩邊分別為紅外發射和接收裝置,組成Kinect的深度傳感器。其深度傳感器的分辨率為320×240,幀率同樣為30Hz。RGB-D相機采集的圖像數據如圖2所示[4]。

圖1 微軟Kinect相機Fig.1 Microsoft Kinect

圖2 RGB圖像(左)和Depth圖像(右)[4]Fig.2 RGB image (left) and Depth image (right) [4]

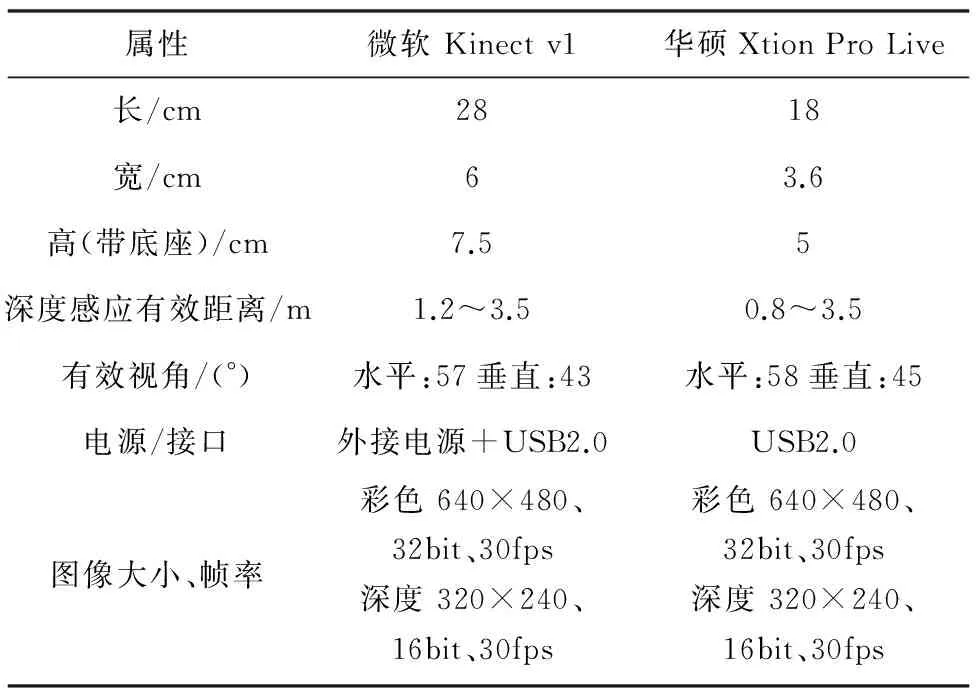

隨后華碩也發布了其體感控制設備Xtion Pro Live,它在外觀上和Kinect相似,但比Kinect尺寸略小,RGB和深度傳感器的配置和Kinect相差無幾。華碩Xtion Pro Live相機如圖3所示。Xtion Pro Live和Kinect參數對比如表1所示。

圖3 華碩Xtion Pro LiveFig.3 Asus Xtion Pro Live

屬性微軟Kinectv1華碩XtionProLive長/cm2818寬/cm63.6高(帶底座)/cm7.55深度感應有效距離/m1.2~3.50.8~3.5有效視角/(°)水平:57垂直:43水平:58垂直:45電源/接口外接電源+USB2.0USB2.0圖像大小、幀率彩色640×480、32bit、30fps深度320×240、16bit、30fps彩色640×480、32bit、30fps深度320×240、16bit、30fps

后來,微軟和英特爾(Intel)又相繼推出了Kinect V2 和Realsense 體感設備,使用了更加先進的技術,并在硬件品質上有所提升。由于RGB-D相機功能強大并且價格低廉,引起了社會的極大關注,并逐漸在SLAM領域占有一席之地。

1.2 RGB-D SLAM算法流程

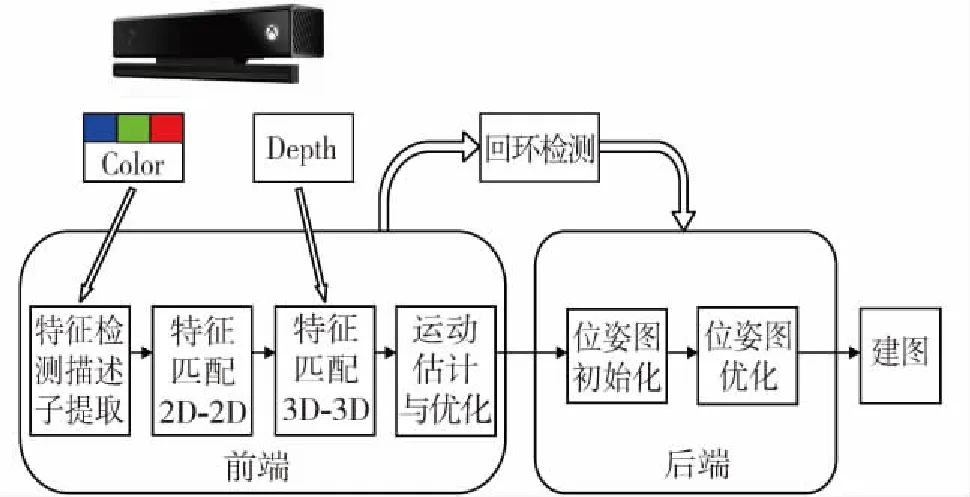

RGB-D SLAM算法大體上可分為前端視覺里程計、后端優化、回環檢測(又稱閉環檢測)和建圖幾個部分。

算法前端根據輸入RGB圖像和Depth圖像,對RGB圖像進行特征點檢測和特征描述子的計算(僅討論基于特征的方法);然后根據特征描述子進行相鄰兩幀圖像的特征匹配,得到2D-2D特征匹配點集;然后根據Depth圖像的深度信息,計算2D-2D特征匹配點對的空間三維坐標,得到3D-3D匹配點集。由匹配好的3D-3D點就可以計算出相鄰兩幀圖像間的旋轉和平移矩陣[4],最后對運動估計誤差進行優化,得到誤差最小的位姿估計結果。這樣就可以根據輸入的視頻流,不斷地得到相機位姿的增量變化,所以算法前端構建了視覺里程計(VO)。

算法后端主要是為了優化SLAM過程中的噪聲問題。實際應用當中,再精確的傳感器獲取的數據也會帶有一定的噪聲。所以,通過前端得到相鄰兩幀圖像之間的運動估計之后,還要關心這個估計帶有多大的噪聲。后端優化就是從這些帶有噪聲的數據中,估計整個系統的狀態,給出這個狀態的最大后驗概率(Maximum a Posteriori,MAP)。具體來說,后端接收不同時刻視覺里程計測量的相機位姿和回環檢測的約束信息,采用非線性優化得到全局最優的位姿。在VSLAM中,前端和計算機視覺研究領域更為相關,例如圖像的特征點檢測與匹配,而后端則主要是濾波與非線性優化算法。

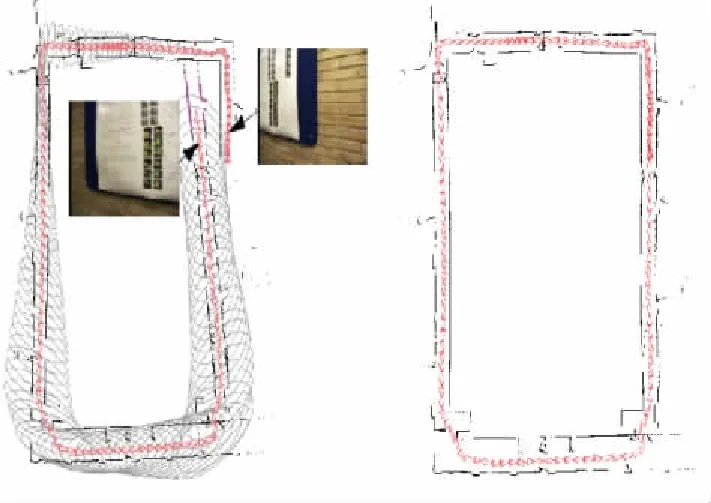

回環檢測又稱為閉環檢測(Loop Closure Detection),主要解決機器人位置隨時間漂移的問題。回環檢測就是讓機器人具有識別曾經到達過的場景的能力。視覺回環檢測就是通過比較兩幅圖像數據的相似性,由于圖像信息豐富,使得視覺回環檢測比較容易實現。如果回環檢測成功,則認為機器人曾經來過這個地點,把比對信息輸送給后端優化算法,后端根據回環檢測的信息,調整機器人軌跡和地圖。通過回環檢測,可以顯著地減小累積誤差[4](圖4)。

圖4 累積誤差與回環檢測校正結果[4]Fig.4 Cumulative error and the result after loop closing[4]

建圖(Mapping)是指構建地圖的過程,只有構建環境的地圖,才能實現機器人的定位或導航功能。根據實際應用的需要,SLAM算法構建的地圖大體可分為度量地圖(Metric Map)和拓撲地圖(Topological Map)兩種。

根據以上的敘述,RGB-D SLAM算法流程如圖5所示。

圖5 RGB-D SLAM算法流程圖Fig.5 Flow chart of RGB-D SLAM algorithm

1.3 RGB-D SLAM標志性成果

華盛頓大學(University of Washington)的Peter Henry、Michael Krainin、Evan Herbst聯合英特爾(Intel)實驗室的Xiaofeng Ren、Dieter Fox[4]最早提出基于RGB-D相機的SLAM算法。Peter Henry等使用尺度不變特征轉換(Scale Invariant Feature transform, SIFT)[6]方法對相鄰兩幀RGB圖像進行特征檢測與描述子提取,然后加入Depth圖像的數據生成3D-3D特征點對信息,使用隨機采樣一致性(Random Sample Consensus,RANSAC)方法[8]對3D-3D匹配點對進行配準并求出對應的變換矩陣,采用迭代最近點(Iterative Closest Point,ICP)[10]方法對運動變換進行優化。后端采用基于樹的網絡優化(Tree-based network Optimizer, TORO)[11]算法并加入基于視覺的回環檢測約束最終得到全局最優的三維場景地圖。

隨后不久,Peter Henry等又對他們之前提出的算法進行了改進[12]。針對SIFT方法速度較慢的缺陷,在特征提取時采用基于加速段的特征檢測子(Features from Accelerated Segment Test,FAST)[13]方法,描述子的計算采用Calonder方法。并對RANSAC階段預投影誤差進行了優化,提出只有當特征匹配失敗或者是匹配結果中包含的匹配點對數目較少時才進行ICP優化。后端使用性能更加優秀的稀疏光束平差法(Sparse Bundle Adjustment,SBA)[14]代替TORO算法進行全局優化,通過場景識別提高了閉環檢測的效率。

德國弗萊堡大學(University of Freiburg)計算機科學系的Nikolas Engelhard、Felix Endres和Jurgen Hess開發出了一套基于手持Kincet相機的RGB-D SLAM系統[15],在SLAM 算法前端使用基于加速魯棒性特征(Speeded Up Robust Features,SURF)[16]算法對輸入的RGB圖像進行特征檢測與特征描述子提取,對相鄰兩幀RGB圖像進行特征匹配。然后加入Depth圖像中的深度信息對匹配的特征點計算出三維空間坐標。運動估計與優化方面使用RANSAC方法估計兩幀圖像之間的運動,使用改進的ICP方法優化相機的運動轉移矩陣。算法后端使用HOGMAN位姿圖求解方法對前端計算出的運動轉移矩陣進行全局優化以得到全局最優位姿。最后輸出彩色點云數據表示的三維環境地圖。

之后,Felix Endres等又開發出了一套新的RGB-D SLAM系統[17]。在新的系統中,他們提出在后端優化部分使用開源的圖優化庫(General Graph Optimization,g2o)[18]進行全局位姿圖優化,得到一個全局的3D點云表示的三維環境地圖。最后,使用基于八叉樹(Octtree-based Mapping,OctoMap)的地圖構建框架對得到的點云進行體素(Voxel)化表示,最終得到一個3D柵格地圖。所得到的3D柵格地圖可以直接被用于機器人定位、路徑規劃和導航。

Willow Garage公司的Nicola Fioraio和Kurt Konolige提出了一種利用RGB-D相機構建稠密地圖的SLAM算法[19]。該算法在Depth圖像的兩兩配準中使用光束平差法(Bundle Adjustment,BA)[14]同時對Depth圖像和RGB圖像進行匹配,一方面根據所得2D匹配結果生成稀疏圖(Sparse Graph),另一方面根據所得的2D匹配結果使用RANSAC方法估算相機位姿,再利用GICP(Generalized-ICP)[20]方法以所得相機位姿為初始值對采樣后的兩幀圖像進行配準;后端全局配準中每當檢測到閉環時則使用g2o方法對稀疏圖進行優化,以得到全局最優配準結果。號稱此算法對兩幀圖像進行GICP配準時只需要10ms,具有實時性,比其他幾個RGB-D SLAM算法性能更優秀。

為了對來自世界各個機構和高校研究者提出的RGB-D SLAM 算法進行評估,德國Munich 理工大學的Jurgen Sturm 和Daniel Cremers 聯合Freiburg 大學的Nikolas Engelhard 和Felix Endres 一起制作了標準的RGBD SLAM 數據集[21]。他們采用高速運動攝像捕捉系統VICON捕捉手持的Kinect 的位置和姿態數據。這些數據被作為真實的軌跡(Ground Truth),可以和通過RGBD SLAM 算法程序估算出來的位姿和姿態信息作比較。此外,標準數據集還包括以時間戳命名的匹配好的RGB 圖像和Depth圖像。錄制數據集時,選取了工廠、辦公室等許多場景,具有代表性的數據集有FR1 ROOM 、FR2 DESK 、FR3 LONG OFFICE等 。

帝國理工學院(Imperial College London)的Richard A. Newcombe、Andrew J. Davison等聯合微軟研究院(Microsoft Research)的Shahram Izadi、Otmar Hilliges等提出的KinectFusion[22]是第一個基于Kinect深度相機的,能在GPU上實時構建稠密三維環境地圖的SLAM 算法。該算法僅使用Kinect相機一個傳感器計算相機的位姿并構建環境的三維地圖。

西班牙薩拉戈薩大學(University of Zaragoza)的Raul Mur-Artal和Juan Domingo Tardos繼2015年提出比較完整的單目ORB-SLAM算法[23]后,2016年他們又加入了對雙目相機和RGB-D相機的支持[24]。ORB-SLAM算法采用多線程處理,分為追蹤(Tracking)、地圖構建(Local Mapping)、閉環檢測(Loop Closing)幾個線程進行處理。特征提取與匹配、稀疏地圖創建和回環位置識別都是基于ORB(Oriented Robust Brief)[25]特征,在標準CPU上運行就可以實時地進行SLAM運算,而且精度很高。

2 RGB-D SLAM關鍵技術

2.1 特征點提取

VSLAM算法根據利用圖像信息的不同可以分為基于特征的SLAM算法和直接SLAM(Direct SLAM)[26]算法。基于特征點法的前端,長久以來被認為是SLAM的主流方法,它運行穩定,對光照、動態物體不敏感,是目前比較成熟的解決方案。

特征點是由關鍵點(Key Point)和描述子(Descriptor)兩部分組成。關鍵點是指該特征點在圖像里的位置,描述子通常是一個向量,按照人們的需求描述關鍵點周圍像素的信息。常用的特征提取算法有SIFT[6]、SURF[16]和ORB[25]等。

1999年British Columbia大學的David G.Lowe教授總結了基于不變量技術的特征檢測方法,并正式提出了一種基于尺度空間的、對圖像縮放、旋轉甚至仿射變換保持不變性的圖像局部特征描述算子SIFT,這種算法在2004年被加以完善[6]。SIFT算法經過十多年的發展,已經取得了巨大的成功[31-34]。在文獻[4]中,Peter Henry等使用SIFT算法對相鄰兩幀RGB圖像進行特征提取與描述子計算,在室內大型場景環境下測試取得了較好的結果。

SIFT算法充分考慮了圖像變換過程中出現的光照、尺度和旋轉等變化,但是計算量也隨之增大。到目前為止,普通的CPU還無法實時地計算SIFT特征,為此,Herbert Bay 等在2006年提出了SURF[16]算法。SURF算法中采用積分圖、近似的Hessian矩陣和Haar小波變換運算來提高時間效率,采用Haar小波變換增加魯棒性。與SIFT特征相比,SURF算法時間復雜度有所降低, 同樣具有尺度和旋轉不變性,且相對于SIFT特征的算法速度提高了3~7倍[35-37]。文獻[15]使用速度更快的SURF算法對Kinect相機采集的RGB圖像進行特征檢測與描述子提取,最終實現了實時地構建環境的3D模型。

ORB算法是由Ethan Rublee 在ICCV 2011上提出的[25]。該算法采用改進的具有方向性的FAST[38]和速度極快的二進制穩健基元獨立特征(Binary Robust Independent Elementary Features, BRIEF)[39]描述子。在文獻[25]中,作者測試了SIFT、SURF和ORB算法的性能:對同一幅圖像提取約1000個特征點的情況下,SIFT耗時約5228.7ms,SURF花費約217.3ms,而ORB則用了15.3ms。由此可以看出,ORB算法在兼有SIFT和SURF算法旋轉、尺度不變性的基礎上速度方面大為提升。文獻[23]中,University of Zaragoza的Raul Mur-Artal和Juan Domingo Tardos構建了基于單目相機的ORB特征檢測SLAM框架,并在小型、大型室內環境和常用的數據集上測試ORB-SLAM算法,實驗結果表明ORB-SLAM算法相比其他頂尖的SLAM算法性能大為提升。文獻[24]中,Raul Mur-Artal和Juan Domingo Tardos改進了原有的算法提出ORB-SLAM2算法,并增加了對雙目立體相機和RGB-D相機的支持。

2.2 后端優化

后端的優化方法一般分為兩大類:基于濾波器的方法和基于圖優化(Graph Optimization)[42]的方法。基于濾波器的方法理論基礎是概率論里的貝葉斯公式,利用控制信息對機器人的位姿進行先驗估計,然后利用觀測信息對機器人位姿和地圖進行后驗估計。早期的SLAM方法多采用濾波器優化,通常使用擴展卡爾曼濾波(Extended Kalman Filter,EKF)和粒子濾波(Particle Filter, PF)濾波器。直至21世紀早期,基于EKF濾波器的方法仍然占據了SLAM的主導地位。文獻[40]提出的最早的實時SLAM系統既是基于EKF濾波器開發的。

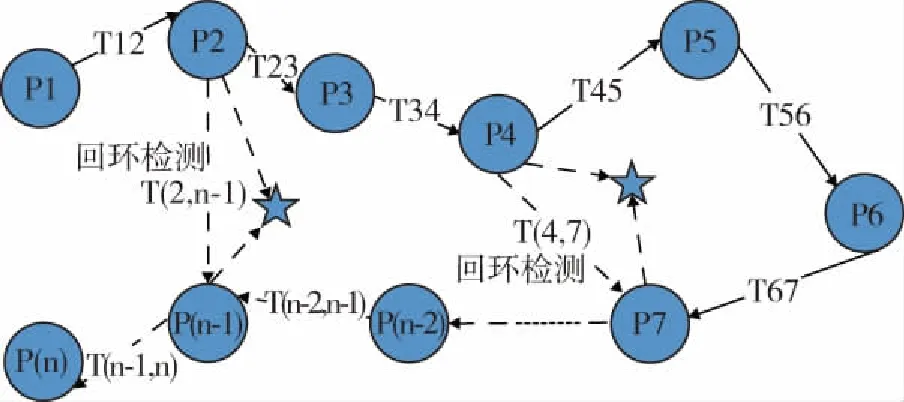

為了克服EKF濾波器的缺點:線性化誤差和噪聲高斯分布假設,研究者們提出了粒子濾波和非線性優化[41]等方法。基于圖優化的非線性優化方法將機器人的位姿轉化成圖論中的頂點(Vertex),將機器人位姿之間的約束,以及位姿與觀測量間的約束則構成了邊(Edge),從而將SLAM問題轉化為一個優化問題,并利用最小二乘法進行求解(圖6)。由于SLAM問題中雅可比矩陣具有稀疏結構,并得益于計算機技術和算法的優化,使得圖優化方法成為現實。

圖6 圖優化示意圖Fig.6 Graph Optimization

g2o[18]是一個開源的圖優化庫,是目前最常用的后端優化器,可供選擇的梯度下降方法有GN(Gauss-Newton)、LM(Levernberg-Marquardt)[43]和DogLeg(Powell’s dogleg)等。文獻[17]中Felix Endres等利用g2o優化器對位姿進行優化,得到全局一致的三維地圖。針對FR1數據包[21],該文詳細地敘述了其算法的運行速度和定位精度。因此該方法可以成為利用RGB-D數據完成SLAM的比較基準。

2.3 回環檢測

回環檢測的關鍵,就是如何能正確有效地判斷相機經過同一個地方,從而為后端提供更加有效的位姿約束,進而消除累積誤差,得到全局一致(Global Consistent)的位姿估計(圖7)。

圖7 回環檢測與優化Fig.7 Loop Closing and Optimization

回環檢測一般有兩種方案:基于里程計(Odometry Based)[44]和基于外觀(Appearance Based)[47]的。基于里程計的回環檢測通過當前相機的位置判斷是否曾經到達過先前的某個位置附近,檢測有沒有回環關系。但是由于累積誤差的存在,檢測相機回到之前位置附近在邏輯上存在悖論,因此,累積誤差較大時無法給出準確的結果[45]。基于外觀的回環檢測僅根據圖像相似關系來檢測回環,與之前的位姿沒有直接關系,因而使得回環檢測相對獨立于前端和后端,能給出更加真實有效的檢測結果,成為VSLAM回環檢測的主流方法[23,46-47]。

基于外觀的回環檢測多使用圖像特征的方法,詞袋(Bag of Words,BoW)[48]方法因其有效性得到了廣泛應用[23,49-51]。詞袋方法首先通過對大量的訓練圖像提取特征(SIFT、SURF、ORB等),并對這些特征(Word)進行分類(經典的是K-means聚類算法[52])獲得葉子節點即為詞典(Dictionary)。這樣,一幅圖像就可以根據是否出現相應的單詞(Word)描述為詞典下的一個向量。

文獻[51]中,使用一種K-means 擴展的K叉樹來表達詞典。在根節點,使用K-means++[53]方法把所有樣本聚成k類;對每一層的每個節點,把屬于該節點的樣本再聚成k類,得到下一層;以此類推,最終得到深度為L,每層分叉為k的樹,可以容納kL個單詞。樹的中間結構僅供快速查找時使用,在查找給定特征對應的單詞時,只需將它與每個中間節點的聚類中心比較(一共比較L次),即可找到最后的單詞,保證了對數級別查找的高效率。文獻[6]使用SIFT特征進行全局定位,用KD樹來排列地圖點。文獻[54-55]使用基于SURF特征描述子的詞典方法去進行閉環檢測特征, 提取約耗時400ms。文獻[23-24]使用效率和精度折中的ORB特征進行回環檢測,即使用基于ORB特征的詞典篩選出閉環,再通過相似性[56-57]計算進行閉環的驗證。

3 RGB-D SLAM優缺點與發展趨勢

3.1 RGB-D SLAM優缺點

單目SLAM系統無法通過單張圖像獲取像素的深度信息,一般通過三角測量的方法估計像素的深度。并且由于單目視覺的尺度不確定性,單目SLAM系統必須進行初始對準。雙目SLAM系統通過視差原理測得深度信息,利用左右相機的圖像的特征匹配獲取像素點對,消除了單目VSLAM系統的初始化問題。相比單目、雙目等SLAM系統,RGB-D SLAM系統能夠通過傳感器在硬件層面上測得圖像點的深度,無需考慮單目SLAM系統的初始對準問題,也不必像雙目SLAM系統消耗大量的資源計算深度。利用RGB-D SLAM進行稠密地圖的構建相對容易,并且RGB-D相機使用紅外結構光或飛時原理測量深度,保證了深度數據對紋理的無關性,這樣即使面對純色的物體,只要它能夠反光,RGB-D SLAM也能夠比較準確地獲取深度數據。

RGB-D SLAM也有其相應的缺點。由于RGB-D相機測量深度的原理,使得RGB-D相機容易受到日光或者其他傳感器發射的紅外光的干擾,因此使用多個RGB-D相機時會相互干擾,在室外使用效果也不好。對于透明材質的物體,因為反射光較少,也無法很好地測量其深度。而且由于主流RGB-D相機深度有效測量距離在0.5~4m的區間內,使得RGB-D SLAM無法應用在室外大場景下,應用環境受限。此外,RGB-D SLAM算法實時運行對計算平臺要求較高,還不能應用到輕量級的嵌入式平臺上。

3.2 RGB-D SLAM發展趨勢

RGB-D的一個研究熱點方向就是和深度學習相結合。到目前為止,SLAM的方案都處于特征點或者像素級別,利用特征點或像素的方法和我們日常生活實踐中的方式很不一樣。

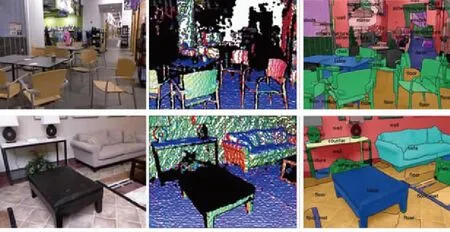

很久之前,研究者就試圖將物體信息結合到SLAM中。文獻[58-61]中把物體識別和VSLAM結合起來,構建帶標簽的地圖。文獻[62]將標簽信息引入到優化端的目標函數中進行優化。以上的工作都稱為語義SLAM(Semantic SLAM)(圖8[70])。綜合來說,SLAM與語義的結合點有以下兩個方面[63]:一方面語義輔助SLAM。傳統的語義分割和物體識別往往只考慮一幅圖片,而在SLAM中利用一臺移動的相機,如果把語義分割應用到SLAM中,將得到一個帶有標簽的語義地圖。另外,語義信息也可以為回環檢測和BA優化提供更多的信息。另一方面SLAM輔助語義。物體識別和語義分割都需要大量的訓練數據,并且需要人工從不同視角采集該物體的圖片,輸入分類器進行識別。利用SLAM,可以自動地計算物體在圖像中的位置,節省人力成本,并且能加快分類器的訓練。

圖8 語義SLAM[70]Fig.8 Semantic SLAM[70]

此外,基于詞袋的回環檢測算法完全依賴于外觀而沒有利用任何其他信息,這導致外觀相似的圖像容易被當成回環。從詞袋的模型來說,它本身是一個非監督的機器學習過程:構建詞典相當于對特征描述子進行聚類。因此,基于深度學習的框架完全可以應用到回環檢測當中[68-69]。

文獻[64-65]使用深度學習網絡對圖像進行識別、檢測和分割。文獻[66]利用RGB-D相機采集的室內RGB圖像和Depth圖像,進行了輪廓檢測,自底向上分組,目標檢測和語義分割(圖9)。文獻[67]創新性的將卷積神經網絡(Convolutional Neural Networks, CNN)應用到SLAM本身的位姿估計與回環檢測當中。雖然這些方法還沒有成為主流,但將SLAM與深度學習結合處理圖像將是一個很有前景的研究方向。

圖9 RGB-D圖像語義分割[66]Fig.9 Semantic segmentation of RGB-D images[66]

4 結束語

自從微軟2010年針對Microsoft Xbox 360 發布第一款RGB-D相機Kinect以來,世界各地的研究者們就競相將RGB-D相機應用到VSLAM技術當中。經過近些年的發展,RGB-D SLAM算法框架趨于成熟,也取得了比較好的實驗效果。但是,RGB-D SLAM算法遠沒有達到完善的地步:除了比較常用的特征點法,基于像素的直接法近年來也嶄露頭角;實際應用當中,RGB-D 相機與慣性器件(IMU)、激光雷達等傳感器的融合會得到更好的效果;將深度學習應用到RGB-D SLAM中將是今后的一個發展方向;RGB-D SLAM應用到AR、VR領域將會改變人們的生活。相信隨著硬件技術的進步、算法的日趨完備,RGB-D SLAM最終能揚長避短,得到廣泛的應用。

[1] Leonard J J, Durrant-Whyte H F, Cox I J. Dynamic map building for an autonomous mobile robot[M]. Sage Publications, Inc. 1992.

[2] 祝繼華, 鄭南寧, 袁澤劍,等. 基于ICP算法和粒子濾波的未知環境地圖創建[J]. 自動化學報, 2009, 35(8):1107-1113.

[3] 丁潔瓊. 基于RGB-D的SLAM算法研究[D]. 西安:西安電子科技大學, 2014.

[4] Henry P, Krainin M, Herbst E, et al. RGB-D mapping: Using depth cameras for dense 3D modeling of indoor environments[J]. International Journal of Robotics Research, 2010, 31(5):647-663.

[5] Newman P, Ho K. SLAM-loop closing with visually salient features[C]//Proceedings of the 2005 IEEE International Conference on Robotics and Automation. IEEE, 2006:635-642.

[6] Lowe D G. Distinctive image features from scale-invariant keypoints[J]. International Journal of Computer Vision, 2004, 60(2): 91-110.

[7] Bay H, Ess A, Tuytelaars T, et al. Speeded-up robust features (SURF)[J]. Computer Vision and Image Understanding, 2008, 110(3): 346-359.

[8] Rublee E, Rabaud V, Konolige K, et al. ORB: An efficient alternative to SIFT or SURF[C]//IEEE International Conference on Computer Vision. IEEE Computer Society, 2011:2564-2571.

[9] Fischler M A, Bolles R C . Random sample consensus: a paradigm for model fitting with applications to image analysis and automated cartography[J]. Communications of the ACM, 1981, 24(6):381-395.

[10] Zhang Z. Iterative point matching for registration of free-form curves and surfaces[J]. International Journal of Computer Vision, 1994, 13(2):119-152.

[11] Burgard W, Brock O, Stachniss C. A tree parameterization for efficiently computing maximum likelihood maps using gradient descent[C]//Robotics:Science and System, 2007:65-72.

[12] Henry P, Krainin M, Herbst E, et al. RGB-D mapping: Using Kinect-style depth cameras for dense 3D modeling of indoor environments[M]//Experimental Robotics. Springer Berlin Heidelberg, 2014:647-663.

[13] Rosten E, Drummond T. Machine learning for high-speed corner detection[C]//Proceedings of the European Conference on Computer Vision. 2006:430-443.

[14] Triggs B, Mclauchlan P F, Hartley R I, et al. Bundle adjustment - a modern synthesis[C]//International Workshop on Vision Algorithms: Theory and Practice. Greece, 1999:298-372.

[16] Bay H, Ess A, Tuytelaars T, et al. Speeded-up robust features[J]. Computer Vision amp; Image Understanding, 2008, 110(3):404-417.

[17] Endres F, Hess J, Engelhard N, et al. An evaluation of the RGB-D SLAM system[C]//IEEE International Conference on Robotics and Automation. IEEE, 2012:1691-1696.

[18] Kümmerle R, Grisetti G, Strasdat H, et al. g2o: A general framework for graph optimization[C]//2011 IEEE International Conference on Robotics and Automation (ICRA). IEEE, 2011: 3607-3613.

[19] Fioraio N, Konolige K. Realtime visual and point cloud SLAM[C]//Proceedings of the RGB-D Workshop on Advanced Reasoning with Depth Cameras at Robotics: Science and Systems Conference(RSS). 2011: 27.

[20] Segal A, Haehnel D, Thrun S. Generalized-ICP[C]//Proceedings of the Robotics: Science and Systems Conference(RSS). 2009: 435.

[21] Sturm J, Engelhard N, Endres F, et al. A benchmark for the evaluation of RGB-D SLAM systems[C]//2012 IEEE/RSJ International Conference on Intelligent Robots and Systems(IROS). IEEE, 2012:573-580.

[22] Newcombe R A, Izadi S, Hilliges O, et al. KinectFusion: Real-time dense surface mapping and tracking[C]//2010 10thIEEE International Symposium on Mixed and Augmented Reality(ISMAR). IEEE Computer Society, 2011:127-136.

[23] Mur-Artal R, Montiel J M M, Tardós J D. ORB-SLAM: a versatile and accurate monocular SLAM system[J]. IEEE Transactions on Robotics, 2015, 31(5):1147-1163.

[24] Murartal R, Tardos J D. ORB-SLAM2: An open-source SLAM system for monocular, stereo and RGB-D cameras[J]. IEEE Transactions on Robotics, 2017, 33(5): 1255-1262.

[25] Rublee E, Rabaud V, Konolige K, et al. ORB: An efficient alternative to SIFT or SURF[C]//2011 IEEE International Conference on Computer Vision(ICCV). IEEE Computer Society, 2011:2564-2571.

[26] Hmer J, Gumhold S, Cremers D. Real-time dense geometry from a handheld camera[C]//Joint Pattern Recognition Symposium. Springer, Berlin, Heidelberg, 2010: 11-20.

[27] Engel J, Sturm J, Cremers D. Semi-dense visual odometry for a monocular camera[C]//2013 IEEE International Conference on Computer Vision(ICCV). IEEE Computer Society, 2013:1449-1456.

[28] Newcombe R A, Lovegrove S J, Davison A J. DTAM: Dense tracking and mapping in real-time[C]//2011 IEEE International Conference on Computer Vision(ICCV). IEEE Computer Society, 2011:2320-2327.

[29] Forster C, Pizzoli M, Scaramuzza D. SVO: Fast semi-direct monocular visual odometry[C]//2014 IEEE International Conference on Robotics and Automation(ICRA). IEEE, 2014:15-22.

[30] Engel J, Sch?ps T, Cremers D. LSD-SLAM: Large-scale direct monocular SLAM[C]//Proceedings of the European Conference on Computer Vision. Springer, Cham, 2014: 834-849.

[31] Ali A M, Nordin M J. SIFT based monocular SLAM with multi-clouds features for indoor navigation[C]//TENCON 2010 - 2010 IEEE Region 10 Conference. IEEE, 2010:2326-2331.

[32] Wu E Y, Zhao L K, Guo Y P, et al. Monocular vision SLAM based on key feature points selection[C]//2010 IEEE International Conference on Information and Automation(ICIA).Harbin,China,2010:1741-1745.

[33] Chen C H, Chan Y P. SIFT-based monocluar SLAM with inverse depth parameterization for robot localization[C]//2007 IEEE Workshop on Advanced Robotics and Its Social Impacts(ARSO). IEEE, 2007:1-6.

[34] Zhu D X. Binocular vision-SLAM using improved SIFT algorithm[C]//2010 2ndInternational Workshop on Intelligent Systems and Applications(ISA). IEEE, 2010:1-4.

[35] Zhang Z, Huang Y, Li C, et al. Monocular vision simultaneous localization and mapping using SURF[C]//2008 7thWorld Congress on Intelligent Control and Automation(WCICA). IEEE, 2008:1651-1656.

[36] Ye Y. The research of SLAM monocular vision based on the improved SURF feather[C]//2014 International Conference on Computational Intelligence and Communication Networks(CICN). IEEE, 2014:344-348.

[37] Wang Y T, Feng Y C. Data association and map management for robot SLAM using local invariant features[C]//2013 IEEE International Conference on Mechatronics and Automation(ICMA). IEEE, 2013:1102-1107.

[38] Rosten E, Drummond T. Machine learning for high-speed corner detection[C]//Proceedings of the Computer Vision. 2006:430-443.

[39] Calonder M, Lepetit V, Strecha C, et al. BRIEF: Binary robust independent elementary features[C]//Proceedings of the European Conference on Computer Vision. Springer-Verlag, 2010:778-792.

[40] Davison A J, Reid I D, Molton N D, et al. MonoSLAM: Real-time single camera SLAM[J]. IEEE Transactions on Pattern Analysis amp; Machine Intelligence, 2007, 29(6):1052-1067.

[41] Strasdat H, Montiel J M M, Davison A J. Visual SLAM: Why filter? [J]. Image amp; Vision Computing, 2012, 30(2):65-77.

[42] Lu F, Milios E. Globally consistent range scan alignment for environment mapping[J]. Autonomous Robots, 1997, 4(4):333-349.

[43] Moré J J. The Levenberg-Marquardt algorithm: Implementation and theory[M]//Numerical Analysis. Springer, Berlin, Heidelberg, 1978: 105-116.

[44] Hahnel D, Burgard W, Fox D, et al. An efficient fast SLAM algorithm for generating maps of large-scale cyclic environments from raw laser range measurements[C]//2013 IEEE/RSJ International Conference on Intelligent Robots and Systems(IROS). IEEE Xplore, 2003:206-211.

[45] Beeson P, Modayil J, Kuipers B. Factoring the mapping problem: Mobile robot map-building in the hybrid spatial semantic hierarchy[J]. The International Journal of Robotics Research, 2010, 29(4):428-459.

[46] Latif Y, Cadena C, Neira J. Robust loop closing over time for pose graph SLAM[J]. The International Journal of Robotics Research, 2013, 32(14):1611-1626.

[47] Ulrich I, Nourbakhsh I. Appearance-based place recognition for topological localization[C]//2000 IEEE International Conference on Robotics and Automation(ICRA). IEEE Xplore, 2000:1023-1029.

[48] Nister D, Stewenius H. Scalable recognition with a vocabulary tree[C]//2006 IEEE Computer Society Conference on Computer Vision and Pattern Recognition. IEEE, 2006:2161-2168.

[49] Mur-Artal R, Tardós J D. Fast relocalisation and loop closing in keyframe-based SLAM[C]//2014 IEEE International Conference on Robotics and Automation (ICRA). IEEE, 2014: 846-853.

[50] Angeli A, Filliat D, Doncieux S, et al. A fast and incremental method for loop-closure detection using bags of visual words[J].IEEE Transactions on Robotics, 2008,24(5):1027-1037.

[51] Galvez-López D, Tardos J D. Bags of binary words for fast place recognition in image sequences[J]. IEEE Transactions on Robotics, 2012, 28(5):1188-1197.

[52] Lloyd S. Least squares quantization in PCM[J]. IEEE Transactions on Information Theory, 1982, 28(2):129-137.

[53] Arthur D, Vassilvitskii S. k-means++: The advantages of careful seeding[C]//Proceedings of the 18thAnnual ACM-SIAM Symposium on Discrete Algorithms. Society for Industrial and Applied Mathematics, 2007: 1027-1035.

[55] Cummins M, Newman P. Appearance-only SLAM at large scale with FAB-MAP 2.0[J]. The International Journal of Robotics Research, 2011, 30(9):1100-1123.

[56] Sivic J, Zisserman A. Video Google: A text retrieval approach to object matching in videos[C]//2003 IEEE International Conference on Computer Vision. IEEE Xplore, 2003:1470-1477.

[57] Robertson S. Understanding inverse document frequency: on theoretical arguments for IDF[J]. Journal of Documentation, 2004, 60(5):503-520.

[58] Nüchter A, Hertzberg J. Towards semantic maps for mobile robots[J]. Robotics amp; Autonomous Systems, 2008, 56(11):915-926.

[59] Civera J, Glvez-Lpez D, Riazuelo L, et al. Towards semantic SLAM using a monocular camera[C]//2011 IEEE/RSJ International Conference on Intelligent Robots and Systems(IROS). IEEE, 2011:1277-1284.

[60] Koppula H S, Anand A, Joachims T, et al. Semantic labeling of 3D point clouds for indoor scenes[C]//Advances in Neural Information Processing Systems. 2011: 244-252.

[61] Anand A, Koppula H S, Joachims T, et al. Contextually guided semantic labeling and search for three-dimensional point clouds[J]. The International Journal of Robotics Research, 2013, 32(1):19-34.

[62] Fioraio N, Stefano L D. Joint detection, tracking and mapping by semantic bundle adjustment[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition. IEEE, 2013:1538-1545.

[63] Cadena C, Carlone L, Carrillo H, et al. Past, present, and future of simultaneous localization and mapping: Toward the robust-perception age[J]. IEEE Transactions on Robotics, 2016, 32(6):1309-1332.

[64] Deng J, Dong W, Socher R, et al. ImageNet: A large-scale hierarchical image database[C]//2009 IEEE Conference onComputer Vision and Pattern Recognition(CVPR). IEEE, 2009:248-255.

[65] He K, Zhang X, Ren S, et al. Deep residual learning for image recognition[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition. IEEE, 2016:770-778.

[66] Gupta S, Arbelez P, Girshick R, et al. Indoor scene understanding with RGB-D images: Bottom-up segmentation, object detection and semantic segmentation[J]. International Journal of Computer Vision, 2015, 112(2): 133-149.

[67] Hou Y, Zhang H, Zhou S. Convolutional neural network-based image representation for visual loop closure detection[C]//2015 IEEE International Conference on Information and Automation. IEEE, 2015:2238-2245.

[68] Gao X, Zhang T. Loop closure detection for visual SLAM systems using deep neural networks[C]//2015 34thChinese Control Conference(CCC). IEEE, 2015:5851-5856.

[69] Gao X, Zhang T. Unsupervised learning to detect loops using deep neural networks for visual SLAM system[J]. Autonomous Robots, 2017, 41(1):1-18.

[70] Salas-Moreno R F, Glocken B, Kelly P H J, et al. Dense planar SLAM[C]//2014 IEEE International Symposium on Mixed and Augmented Reality(ISMAR). IEEE, 2014:157-164.

AnOverviewofRGB-DSLAM

WANG Liu-jun, CHEN Jia-bin, YU Huan, ZHU Hui-shen

(School of Automation, Beijing Institute of Technology, Beijing 100081,China)

RGB-D SLAM refers to Simultaneous Localization and Mapping (SLAM) using RGB-D camera as a visual sensor. RGB-D camera is a kind of vision sensor which can be used to capture RGB images and depth images of environment. Firstly, this paper introduced the RGB-D camera used frequently and the RGB-D SLAM algorithm framework. Then the main achievements of RGB-D SLAM method at home and abroad, research status of RGB-D SLAM and the key technologies of the RGB-D SLAM method, such as feature detection and matching, the pose graph optimization of the back end and the loop closure detection were introduced and summarized. Finally, the advantages and disadvantages of the RGB-D SLAM method were analyzed, and the research hotspot and development trend of the RGB-D SLAM method were discussed.

RGB-D camera; SLAM; Visual odometry; Pose graph optimization; Loop closure detection*

10.19306/j.cnki.2095-8110.2017.06.002

TP242.6

A

2095-8110(2017)06-0009-10

2017-04-15;

2017-09-06

國家國防基金(9140A09050313BQ01127);國家自然科學基金(91120010)

王旒軍(1992-),男,碩士,主要從事智能導航、視覺SLAM方向的研究。E-mail:wangliujun_bit@163.com

陳家斌(1964-),男,教授,博導,從事慣性導航、智能導航方向研究。E-mail:chenjiabin@bit.edu.cn