一種局部聚合描述符和組顯著編碼相結(jié)合的編碼方法

費(fèi)宇杰,吳小俊

(江南大學(xué) 物聯(lián)網(wǎng)工程學(xué)院,江蘇 無錫 214122)

一種局部聚合描述符和組顯著編碼相結(jié)合的編碼方法

費(fèi)宇杰,吳小俊

(江南大學(xué) 物聯(lián)網(wǎng)工程學(xué)院,江蘇 無錫 214122)

局部聚合描述符(vector of locally aggregated descriptors, VLAD)的特征編碼方法在大規(guī)模圖像檢索上取得了較好的效果。但是,VLAD存在硬分配難以準(zhǔn)確描述局部特征向量與視覺詞匯隸屬關(guān)系的問題,本文將兩種軟分配編碼與VLAD相結(jié)合來增強(qiáng)局部特征向量與視覺詞匯的隸屬關(guān)系。新的編碼方法在15 Scenes、Corel 10 和 UIIC Sports Event 數(shù)據(jù)庫(kù)上的實(shí)驗(yàn)結(jié)果表明:1)在VLAD中加入局部軟分配能夠提高分類準(zhǔn)確率,而且對(duì)比Fisher編碼在分類準(zhǔn)確率上也有一定的優(yōu)越性;2)除了軟分配,顯著性對(duì)提高分類準(zhǔn)確率也起到了一定的作用。

圖像分類;特征編碼;詞袋;局部聚合描述符;軟分配;顯著性

圖像分類是計(jì)算機(jī)視覺和模式識(shí)別中的一個(gè)重要的研究方向,它有廣泛的應(yīng)用,例如:視頻監(jiān)控[1]、圖像檢索[2]、網(wǎng)頁(yè)內(nèi)容分析[3]。從文本分析中的BoW(bag-of-words)模型[4]發(fā)展而來的BoF(bag-of-features)模型[5]是當(dāng)前最有效的圖像分類框架。

1 問題提出

如圖1所示,BoF模型通常包含5個(gè)步驟,特征提取、字典生成、特征編碼、特征池化和分類。所謂特征編碼是用字典中的視覺詞匯來表示圖像中的局部特征向量,局部特征在視覺詞匯上的響應(yīng)被稱為編碼系數(shù),將不同視覺詞匯的編碼系數(shù)組合在一起就是編碼向量。特征編碼是整個(gè)BoF模型的關(guān)鍵,編碼的好壞會(huì)對(duì)分類效果產(chǎn)生巨大的影響。根據(jù)文獻(xiàn)[6],我們將編碼方法分為4類,如圖2所示。編碼方法中,最簡(jiǎn)單的方法是將局部特征向量指定到離它最近的視覺詞匯上并設(shè)置其編碼系數(shù)為非零的值,用這個(gè)視覺詞匯來代表該特征向量,這種“硬指定(Hard-assignment)[5]”的編碼方法沒有考慮到特征向量隸屬視覺詞匯的模糊性[7],并且會(huì)產(chǎn)生巨大的量化誤差。文獻(xiàn)[8]提出一種“軟指定(Soft-assignment)”的編碼方法,通過指定特征向量到所有視覺詞匯上從而減輕了“硬指定”編碼帶來的問題。基于重構(gòu)的編碼方法是選擇一些視覺詞匯來重構(gòu)局部特征向量。例如:稀疏編碼[9](sparse coding)是使編碼向量稀疏,而LLC[10](local-constraint linear coding)是選擇局部的視覺詞匯來重構(gòu)特征向量。高維的編碼方法,像Fisher核編碼[11](fisher kernel coding)和SVC[12](super vector coding)只需少量的視覺詞匯就能獲得較好的分類結(jié)果。VLAD編碼[13]可以看作是Fisher核編碼的簡(jiǎn)化版,下一節(jié)將對(duì)它詳細(xì)介紹。最近,由于顯著編碼的高效性和有效性,它得到了很多關(guān)注。顯著編碼認(rèn)為顯著性是特征編碼的重要特性。SaC[14](salient coding)將顯著系數(shù)作為編碼系數(shù),顯著系數(shù)是通過局部特征到不同視覺詞匯間的距離計(jì)算得來的。GSC[15](gruop salient coding)是SaC的改進(jìn)版,它的思想是將視覺詞匯分成不同的組,不同的組得到不同的編碼系數(shù)。

圖1 BoF模型流程圖 圖2 編碼方法分類Fig.1 The general pipelineof the BoF framework Fig.2 A taxonomy ofcoding methods

通過對(duì)編碼方法的回顧可以發(fā)現(xiàn),無論是從Hard-assignment到Soft-assignment,還是從SaC到GSC都是通過軟分配的思想來增加局部特征與視覺詞匯之間的隸屬關(guān)系信息,從而提高了分類的正確率。我們將軟分配的思想加入VLAD中來改進(jìn)原始的VLAD。在不同的數(shù)據(jù)集上的實(shí)驗(yàn)結(jié)果表明:1)軟分配能夠提高原始VLAD的分類準(zhǔn)確率,并且對(duì)比Fisher核編碼在分類正確率上也有一定的優(yōu)越性。但是,并不是任意的軟分配都能提高分類正確率,只有局部的軟分配(這里局部的意思是特征向量只有在離它最近的幾個(gè)視覺詞匯上有響應(yīng)系數(shù))才能提高VLAD的分類正確率;2)除了軟分配,顯著性對(duì)提高分類正確率也起到了一定的作用,我們認(rèn)為這是因?yàn)轱@著編碼考慮到了不同視覺詞匯之間的聯(lián)系。

2 相關(guān)工作

1)Harding-assignmentCoding。局部特征xi只在離它最近的視覺詞匯上有編碼系數(shù)。

(1)

2)Soft-assignmentCoding。uij可以理解為局部特征xi在視覺詞匯bj上的隸屬度。

(2)

3)SaliencyCoding。顯著編碼(SaC)是將局部特征與離它最近的視覺詞匯和其他視覺詞匯的距離的比值作為該局部特征的編碼結(jié)果。

(3)

(4)

4)GroupSaliencyCoding。GSC可以看做SaC的“軟分配版本”,它把視覺詞匯分成不同的組,局部特征在不同組上得到不同的響應(yīng)系數(shù),圖3描繪了組顯著編碼的思想。

圖3 組顯著編碼Fig.3 Group saliency coding

(5)

(6)

(7)

(8)

3 改進(jìn)的VLAD編碼方法

根據(jù)上一章節(jié)的介紹,我們發(fā)現(xiàn)原始的VLAD存在硬分配難以準(zhǔn)確描述局部特征向量與視覺詞匯隸屬關(guān)系的問題。在這一章節(jié)中,提出3種新的VLAD編碼方法,分別是SA_VLAD編碼方法,GSC_VLAD編碼方法以及SaC_VLAD編碼方法。

1)SA_VLAD。SA_VLAD編碼是將Soft-assignment編碼中解決局部特征與視覺詞匯隸屬關(guān)系的方法加入到原始VLAD編碼中。Soft-assignment編碼中是用高斯核函數(shù)的值來表示局部特征向量與視覺詞匯的隸屬度。

(9)

(10)

2)GSC_VLAD。GSC_VLAD編碼是將GSC編碼中組顯著性的思想加入到原始VLAD中來解決局部特征向量與視覺詞匯的隸屬關(guān)系問題。GSC編碼中用顯著性來表示局部特征向量與視覺詞匯的隸屬度,同時(shí)顯著性考慮到了不同視覺詞匯之間的聯(lián)系。

(11)

(12)

(13)

(14)

式中:KGSC表示有編碼系數(shù)的視覺詞匯的個(gè)數(shù),即KGSC個(gè)視覺詞匯會(huì)有響應(yīng)系數(shù)。

3)SaC_VLAD。SaC中用顯著系數(shù)作為編碼系數(shù),顯著系數(shù)是指局部特征與離它最近的視覺詞匯和其他視覺詞匯的距離的比值,顯著系數(shù)考慮到了不同視覺詞匯之間的聯(lián)系。將SaC與原始VLAD相結(jié)合,使VLAD在編碼過程中考慮不同視覺詞匯之間潛在的聯(lián)系。

(15)

(16)

(17)

式中:KSaC表示有KSaC個(gè)視覺詞匯用來計(jì)算局部特征的顯著系數(shù)。

算法1 改進(jìn)的VLAD編碼方法

輸出VLAD向量。

%計(jì)算每個(gè)局部特征向量在各個(gè)視覺詞匯上的編碼系數(shù)

fori=1,2,…,N

根據(jù)式(9)或者式(11)或者式(15)計(jì)算相應(yīng)的uij

end

%計(jì)算VLAD向量

%根據(jù)文獻(xiàn)[17],對(duì)最終的VLAD向量進(jìn)行能量范數(shù)和L2范數(shù)歸一化

V=V/‖V‖2

4 實(shí)驗(yàn)結(jié)果與分析

本實(shí)驗(yàn)為了證明以下3點(diǎn):1)軟分配能提高VLAD的分類正確率,甚至對(duì)比Fisher編碼在分類正確率上有一定的優(yōu)越性;2)只有局部軟分配才能有效提高分類正確率;3)除了軟分配,顯著性對(duì)提高分類正確率也起到了一定的作用。

本文在3個(gè)數(shù)據(jù)集(15 Scenes[18]、Corel 10[19]和UIUC Sports Events[20])上進(jìn)行了實(shí)驗(yàn)。對(duì)于15 Scenes和Corel 10數(shù)據(jù)集,我們指定每張圖片的最大單邊像素為300。UIUC Sports Events數(shù)據(jù)集中圖片的分辨率較高,因此指定每幅圖片的最大單邊像素為400。我們采用Dense SIFT算法[21]來提取每幅圖像的sift特征向量,采樣的步長(zhǎng)是6個(gè)像素,每個(gè)采樣塊的大小為16×16。采用K-means[22]聚類算法生成視覺字典。分類器采用Lib-linearSVM[23],并指定SVM的懲罰系數(shù)為1。我們將數(shù)據(jù)集分為5組,每組隨機(jī)生成訓(xùn)練樣本和測(cè)試樣本,最后的分類正確率是5組實(shí)驗(yàn)的平均值。對(duì)于式(9)中的β和KSA,分別設(shè)置其值為10和10。對(duì)于式(11)中的KGSC設(shè)置其值為10。關(guān)于KSA和KGSC對(duì)實(shí)驗(yàn)結(jié)果的影響,將在4.2節(jié)中詳細(xì)討論。

4.1 新的編碼對(duì)比原始的VLAD和Fisher編碼

將4種編碼方法SA_VLAD、GSC_VLAD、VLAD和Fisher編碼進(jìn)行對(duì)比。

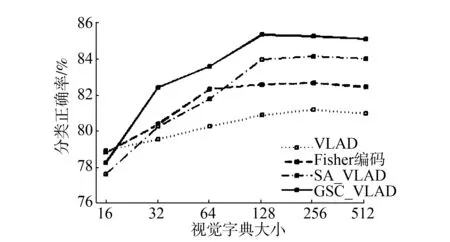

1)15Scenes。 該數(shù)據(jù)集由15個(gè)場(chǎng)景類別構(gòu)成,總共4 485張圖片。每個(gè)類別都是相似場(chǎng)景圖片的一個(gè)集合,大約包含200~400張圖片,每張圖片的平均尺寸為300×250。我們采用Lazebnik等[21]的實(shí)驗(yàn)設(shè)置,從每類場(chǎng)景中隨機(jī)選擇100張圖片作為訓(xùn)練集,其余圖片作為測(cè)試集。分別在不同的視覺字典大小下進(jìn)行了實(shí)驗(yàn),實(shí)驗(yàn)結(jié)果如圖4。

圖4 4種不同編碼方法在15 Scenes上的分類結(jié)果Fig.4 Performance comparison on the 15 Scenes

從圖4中可以看出,軟分配的VLAD比原始的VLAD編碼有顯著的提升,當(dāng)視覺字典的大小為512時(shí),VLAD的分類正確率為76.66%,SA_VLAD和GSC_VLAD的分類正確率分別為80.18%和80.84%,有4%~5%的提升。對(duì)比Fisher編碼的78.66%的正確率,也有2%的提升。同時(shí)GSC_VLAD的分類正確率在不同的視覺字典大小下均高于SA_VLAD,表1顯示了4種編碼各自的最佳分類正確率。

表1 15 Scenes數(shù)據(jù)集上的最佳分類正確率

2)Corel 10。該數(shù)據(jù)集共有10個(gè)類別,每類共有100張圖片,每張圖片的平均尺寸為384×256。本文從每類場(chǎng)景中隨機(jī)選擇50張圖片作為訓(xùn)練集,剩下的50張作為測(cè)試集。實(shí)驗(yàn)結(jié)果如圖5所示。

實(shí)驗(yàn)結(jié)果基本和15Scenes數(shù)據(jù)集上的結(jié)果類似,從圖4中可以看出,SA_VLAD和GSC_VLAD對(duì)比原始的VLAD在分類正確率上有明顯的提升,并且對(duì)比Fisher編碼有一定的可比性。值得注意的是GSC_VLAD的分類正確率在不同的視覺字典大小下還是均高于SA_VLAD。表2顯示了4種編碼各自的最佳分類正確率。

圖5 4種不同編碼方法在Corel 10上的分類結(jié)果Fig.5 Performance comparison on the Corel 10

編碼方法分類正確率(字典大小)VLAD88.36±1.05(512)Fisher編碼89.44±0.95(256)SA_VLAD90.75±0.91(512)GSC_VLAD89.32±0.97(512)

3)UIUC Sports Event。該數(shù)據(jù)集包含8個(gè)類別,總共1 579張圖片,每類大約有137~250張圖片。本文從每類中隨機(jī)抽取70張圖片作為訓(xùn)練集,從余下的圖片中隨機(jī)抽取60張作為測(cè)試集。實(shí)驗(yàn)結(jié)果如圖6所示。

圖6 4種不同編碼方法在UIUC上的分類結(jié)果Fig.6 Performance comparison on the UIUC

從圖6中可以看出,隨著視覺字典大小的增加,SA_VLAD和GSC_VLAD對(duì)比原始VLAD在分類正確率上有顯著的增加,對(duì)比Fisher編碼也有一定的優(yōu)越性。與上兩個(gè)實(shí)驗(yàn)相同,GSC_VLAD的分類正確率在不同字典大小下都超過了SA_VLAD。表3顯示了4種編碼各自的最佳分類正確率。

表3 UIUC數(shù)據(jù)集上的最佳分類正確率

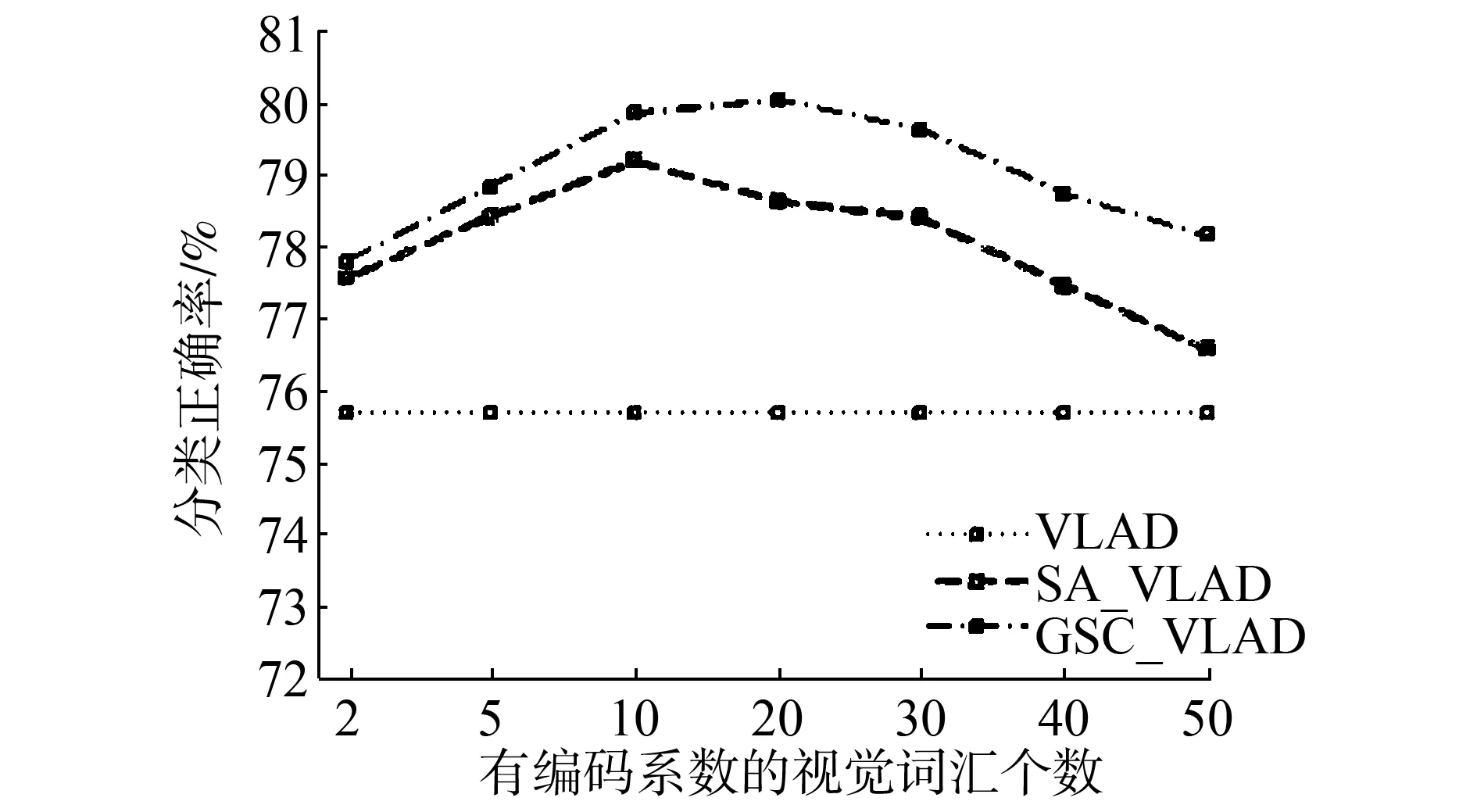

4.2 算法中參數(shù)的影響

這一節(jié)中,我們討論式(9)和式(11)中的KSA和KGSC這兩個(gè)參數(shù)對(duì)實(shí)驗(yàn)結(jié)果的影響。這兩個(gè)參數(shù)表示有編碼系數(shù)的視覺詞匯的個(gè)數(shù)。實(shí)驗(yàn)中這兩個(gè)參數(shù)都用K來表示,當(dāng)視覺字典大小為128時(shí),實(shí)驗(yàn)結(jié)果如圖7所示。

(a) 15 Scenes

(b)Corel 10

(c)UIUC圖7 參數(shù)K在不同數(shù)據(jù)集上的影響Fig.7 The effect of parameterKon different dataset

圖8中,我們加入了原始的VLAD以便比較。從圖中可以看到隨著K的遞增,SA_VLAD和GSC_VLAD的分類正確率逐漸減小,只有在K較小時(shí)才能達(dá)到比較高的分類正確率。這說明了并不是響應(yīng)局部特征的視覺詞匯越多越好,只有局部的軟分配才能有效地提升VLAD的分類正確率。

(a) 15 Scenes

(b)Corel 10

(c)UIUC圖8 顯著性對(duì)實(shí)驗(yàn)結(jié)果的影響Fig.8 The effect of saliency

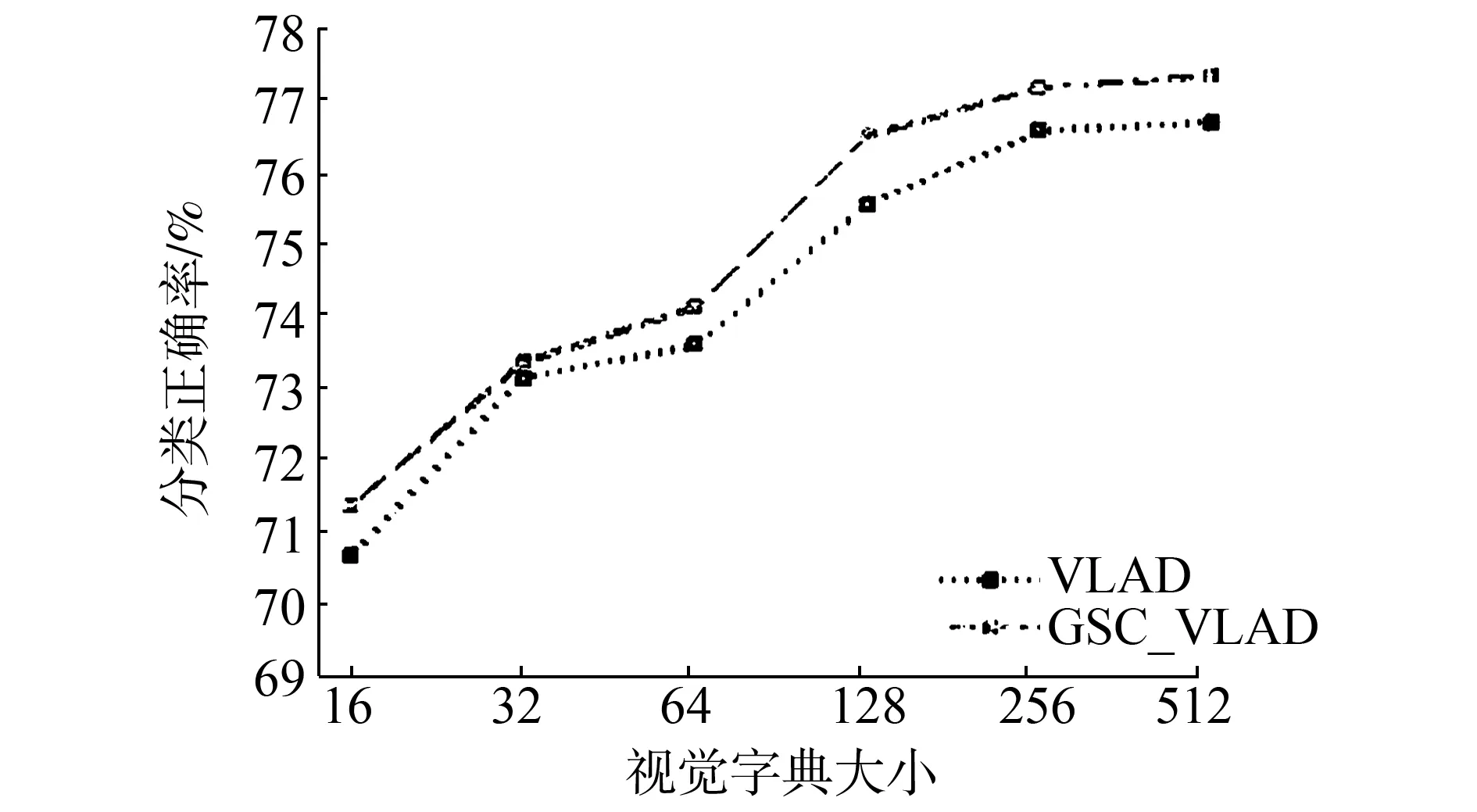

3.3 顯著性對(duì)結(jié)果的影響

根據(jù)上面兩節(jié)的介紹,我們發(fā)現(xiàn)GSC_VLAD的分類效果要略好于SA_VLAD,我們認(rèn)為這是顯著性帶來的影響,因?yàn)轱@著性考慮了不同視覺詞匯間的聯(lián)系。為了排除軟分配對(duì)實(shí)驗(yàn)結(jié)果的影響,我們用新的編碼算法SaC_VLAD與VLAD編碼進(jìn)行比較。圖7是視覺字典大小不同時(shí),SaC_VLAD算法在3個(gè)數(shù)據(jù)集上的結(jié)果。

對(duì)比原始的VLAD,SaC_VLAD對(duì)分類正確率有一定的提升。當(dāng)視覺字典的大小是128時(shí),在15 Scenes數(shù)據(jù)集上,VLAD的分類正確率是75.52±0.61%,SaC_VLAD的分類正確率是76.47±0.33%。在Core 10數(shù)據(jù)集上,VLAD的分類正確率是87.36±1.28%,SaC_VLAD的分類正確率是89.12±1.11%。在UIUC數(shù)據(jù)集上,VLAD的分類正確率是80.67±1.50%,SaC_VLAD的分類正確率是83.63±1.76%。實(shí)驗(yàn)結(jié)果證明,在VLAD中加入顯著性能提高原始VLAD的分類正確率。

5 結(jié)束語(yǔ)

本文提出的GSC_VLAD編碼方法能對(duì)原始的VLAD在分類正確率上帶來有效的提升,同時(shí)對(duì)比Fisher編碼也有一定的優(yōu)越性。這種提升的原因是:1)在VLAD中加入了局部的軟分配,解決了原始VLAD中硬分配難以準(zhǔn)確描述局部特征向量與視覺詞匯隸屬關(guān)系的問題;2)顯著性編碼考慮了不同視覺詞匯之間潛在的聯(lián)系,對(duì)提升分類效果也起到了一定的作用。

在實(shí)驗(yàn)的過程中,我們發(fā)現(xiàn)新的編碼方法在圖像有噪聲的情況下分類效果要好于原始的VLAD,但是正確率對(duì)比沒有噪聲時(shí)下降得很厲害,因此如何提升新的編碼方法的魯棒性將是未來的研究重點(diǎn)。

[1]COLLINS R T, LIPTON A J, KANADE T, et al. A system for video surveillance and monitoring[R]. CMU-RITR-00-12. Pittsburgh, Penn: Carnegie Mellon University, 2000.

[2]VAILAYA A, FIGUEIREDO M A T, JAIN A K, et al. Image classification for content-based indexing[J]. IEEE transactions on image processing, 2001, 10(1): 117-130.

[3]KOSALA R, BLOCKEEL H. Web mining research: a survey[J]. ACM SIGKDD explorations newsletter, 2000, 2(1): 1-15.

[4]JOACHIMS T. Text categorization with support vector machines: learning with many relevant features[C]//Proceedings of the 10th European Conference on Machine Learning. Berlin Heidelberg: Springer, 1998.

[5]DANCE C, WILLAMOWSKI J, FAN Lixin, et al. Visual categorization with bags of keypoints[C]//Proceedings of ECCV International Workshop on Statistical Learning in Computer Vision. Prague, CZ, 2004.

[6]HUANG Yongzhen, WU Zifeng, WANG Liang, et al. Feature coding in image classification: a comprehensive study[J]. IEEE transactions on pattern analysis and machine intelligence, 2014, 36(3): 493-506.

[7]VAN GEMERT J C, VEENMAN C J, SMEULDERS A W M, et al. Visual word ambiguity[J]. IEEE transactions on pattern analysis and machine intelligenc, 2010, 32(7): 1271-1283.

[8]VAN GEMERT J C, GEUSEBROEK J M, VEENMAN C J, et al. Kernel codebooks for scene categorization[C]//Proceedings of the European Conference on Computer Vision. Berlin Heidelberg: Springer, 2008: 696-709.

[9]YANG Jianchao, YU Kai, GONG Yihong, et al. Linear spatial pyramid matching using sparse coding for image classification[C]//Proceedings of 2009 IEEE Conference on Computer Vision and Pattern Recognition. Miami, FL: IEEE, 2009: 1794-1801.

[10]WANG Jinjun, YANG Jianchao, YU Kai, et al. Locality-constrained linear coding for image classification[C]//Proceedings of 2010 IEEE Conference on Computer Vision and Pattern Recognition. San Francisco, CA: IEEE, 2010: 3360-3367.

[11]PERRONNIN F, DANCE C. Fisher kernels on visual vocabularies for image categorization[C]//Proceedings of 2007 IEEE Conference on Computer Vision and Pattern Recognition. Minneapolis, MN: IEEE, 2007.

[12]ZHOU Xi, YU Kai, ZHANG Tong, et al. Image classification using super-vector coding of local image descriptors[C]//Proceedings of the 11th European Conference on Computer Vision. Berlin Heidelberg: Springer, 2010: 141-154.

[13]JéGOU H, DOUZE M, SCHMID C, et al. Aggregating local descriptors into a compact image representation[C]//Proceedings of 2010 IEEE Conference on Computer Vision and Pattern Recognition. San Francisco, CA: IEEE, 2010: 3304-3311

[14]HUANG Yongzhen, HUANG Kaiqi, YU Yinan, et al. Salient coding for image classification[C]//Proceedings of 2011 IEEE Conference on Computer Vision and Pattern Recognition. Providence, RI: IEEE, 2011.

[15]WU Zifeng, HUANG Yongzhen, WANG Liang, et al. Group encoding of local features in image classification[C]//Proceedings of the 21st International Conference on Pattern Recognition. Tsukuba: IEEE, 2012.

[16]LIU Lingqiao, WANG Lei, Liu Xinwang. In defense of soft-assignment coding[C]//Proceedings of 2011 IEEE International Conference on Computer Vision. Barcelona: IEEE, 2011.

[17]PERRONNIN F, SANCHEZ J, MENSINK T. Improving the fisher kernel for large-scale image classification[C]//Proceedings of the 11th European Conference on Computer Vision. Berlin Heidelberg: Springer, 2010: 143-156.

[18]LI F F, PERONA P. A Bayesian hierarchical model for learning natural scene categories[C]// IEEE Computer Society Conference on Computer Vision and Pattern Recognition. IEEE Computer Society, 2005: 524-531.

[19]LI Jia, WANG J Z. Automatic linguistic indexing of pictures by a statistical modeling approach[J]. IEEE transactions on pattern analysis and machine intelligence, 2003, 25(9): 1075-1088.

[20]LI Lijia, LI Feifei. What, where and who? Classifying events by scene and object recognition[C]//Proceedings of the 11th International Conference on Computer Vision. Rio de Janeiro: IEEE, 2007: 1-8.

[21]LAZEBNIK S, SCHMID C, PONCE J. Beyond bags of features: spatial pyramid matching for recognizing natural scene categories[C]//Proceedings of 2006 IEEE Computer Society Conference on Computer Vision and Pattern Recognition. New York, NY, USA: IEEE, 2006: 2169-2178.

[22]LLOYD S. Least squares quantization in PCM[J]. IEEE transactions on information theory, 1982, 28(2): 129-137.

費(fèi)宇杰,男,1992年生,碩士研究生,主要研究方向?yàn)閳D像分類、特征編碼。

吳小俊,男,1967年生,教授,主要研究方向?yàn)槟J阶R(shí)別,計(jì)算機(jī)視覺,模糊系統(tǒng),神經(jīng)網(wǎng)絡(luò),智能系統(tǒng)。

A new feature coding algorithm based onthe combination of group salient coding and VLAD

FEI Yujie, WU Xiaojun

(School of IoT Engineering, Jiangnan University, Wuxi 214122, China)

The vector of locally aggregated descriptors (VLAD) has achieved good results in addressing large-scale image retrieval problems; however, VLAD has a defect in that the relationship between local descriptors and visual words cannot be accurately described using hard assignments. In this paper, we therefore combine two kinds of soft assignment coding methods with VLAD to enhance the relationship between local feature vectors and visual words. We applied our method to 15 scenes from the Corel 10 and UIUC Sports Event datasets, with our experimental results showing that our combined partial soft assignment coding method and VLAD was able to enhance classification accuracy and achieve better classification accuracy than the well-known Fisher Coding approach. In addition to soft assignment, saliency also plays an important role in enhancing classification accuracy.

image classification; feature coding; bag-of-features; VLAD; soft assignment; saliency

2016-03-01.

日期:2017-01-16.

國(guó)家自然科學(xué)基金項(xiàng)目(61373055, 61672265); 江蘇省教育廳科技成果產(chǎn)業(yè)化推進(jìn)項(xiàng)目(JH10-28).

吳小俊. E-mail:xiaojun_wu_jnu@163.com.

10.11992/tis.201602010

http://www.cnki.net/kcms/detail/23.1538.tp.20170116.1115.002.html

TP391

A

1673-4785(2017)02-0172-07

費(fèi)宇杰,吳小俊. 一種局部聚合描述符和組顯著編碼相結(jié)合的編碼方法[J]. 智能系統(tǒng)學(xué)報(bào), 2017, 12(2): 172-178.

英文引用格式:FEI Yujie, WU Xiaojun. A new feature coding algorithm based on the combination of group salient coding and VLAD[J]. CAAI transactions on intelligent systems, 2017, 12(2): 172-178.