基于多時-空相關的AVS2快速幀間預測算法

陳 芳,李國平,王國中,趙海武,滕國偉

(上海大學 通信與信息工程學院,上海 200444)

?

基于多時-空相關的AVS2快速幀間預測算法

陳 芳,李國平,王國中,趙海武,滕國偉

(上海大學 通信與信息工程學院,上海 200444)

針對新一代視頻標準AVS2引進四叉樹分割、多參考幀等技術而帶來的幀間預測復雜度增加的問題,提出一種基于多時-空相關的快速幀間預測算法。該算法利用上下層相鄰編碼單元(Coding Unit, CU)和空時域相鄰CU在預測模式選擇上的相關性,計算當前CU的模式復雜度,根據復雜度為當前CU分配合適的候選預測模式;同時利用相鄰預測單元(Prediction Unit, PU)在參考幀選擇上的相關性,計算當前PU的參考幀索引,根據索引為當前PU分配合適的候選參考幀。實驗表明,該算法在BD-Rate(Bjontegaard delta bit rate)增加1.22%,BD-PSNR(Bjontegaard delta peak signal-to-noise rate)降低0.04 dB的前提下,平均減少47.54%的編碼時間。

AVS2;多時-空相關;模式復雜度;預測模式;參考幀

為了滿足高分辨率視頻的需求,進一步提高視頻壓縮率,AVS工作組歷時3年制作完成了新一代擁有自主知識產權的視頻編碼標準AVS2[1],它的編碼效率與最新國際標準H.265/HEVC相當,比上一代國家標準AVS1以及上一代國際標準H.264/AVC的效率提高1倍。特別對于監控視頻等場景類視頻,AVS2壓縮效率又翻了一番,達到H.264/AVC的4倍。

AVS2引入了一些新的編碼工具[2]以提升編碼效率,如大尺寸四叉樹編碼單元劃分、多參考幀預測、編碼單元非對稱分割、多角度幀內預測和像素自適應補償濾波等。這些技術在提高編碼效率的同時,也顯著增加了編碼復雜度。為了實現AVS2在電視直播、視頻會議等視頻通信系統中的實時應用,必須降低其編碼的計算復雜度。

在AVS2編碼標準中,幀間預測占據著大量的編碼時間,因此如何降低幀間預測的復雜度成為降低編碼復雜度的關鍵。目前,針對幀間預測快速算法的研究主要有兩種:一是模式快速選擇,基于空時域相鄰塊的相關性和一些已知的編碼參數對當前塊的劃分模式或預測模式提前判決。如文獻[3]利用上層相鄰塊和空時域相鄰塊的預測模式計算當前塊的預測模式復雜度,根據復雜度為當前塊分配合理的預測模式,跳過不需要的模式。這種方法充分利用了相鄰塊間的相關性,準確地預測了模式候選值。鄭蕭楨等提出了一種非對稱運動劃分(Asymmetric Motion Partitions, AMP)快速決策機制[4],利用水平、垂直非方形劃分模式的一致性,將對稱非方形劃分模式作為判斷是否使用非對稱非方形劃分的依據。這種方法充分利用了模式間的紋理相關性為AMP模式提前作出判決。二是參考幀快速選擇,減少各模式下參與運動估計的參考幀數目。如文獻[5]以運動矢量差值為閾值,選擇適當的相鄰塊的最佳參考圖像獲得當前塊的參考圖像集,減少參考幀遍歷的冗余。

文獻[3]雖然取得了較好的效果,但只是基于HEVC模型中幀間預測的特征統計對模式快速選擇。由于AVS2在編碼單元類型、運動矢量預測、率失真代價計算等方面和HEVC有很大的不同,該算法并不能直接應用在AVS2中。文獻[4]和[5]分別只是針對AVS2模型中的AMP特殊模式和參考幀選擇作出優化,降低的編碼時間有限。基于AVS2的預測模式和參考幀選擇的特征,本文提出了一種新的算法,充分利用具有較強相關性的下層相鄰的4個塊和空時域相鄰塊的預測模式獲得當前塊的候選模式,同時利用相鄰塊的參考幀索引預測當前塊的候選參考幀,減少遍歷預測模式和參考幀的時間。

1 AVS2幀間預測關鍵技術介紹

1.1 預測模式選擇

AVS2采用了更加靈活的編碼結構,包括編碼單元(Coding Unit,CU)、預測單元(Prediction Unit,PU)和變換單元(Transform Unit,TU)。一幅圖像被分割成固定大小的編碼樹單元(Coding Tree Unit,CTU),CTU按照四叉樹的迭代方式劃分為一系列的CU。CU尺寸范圍為8×8至64×64。CU又被劃分為一個或多個PU和TU。

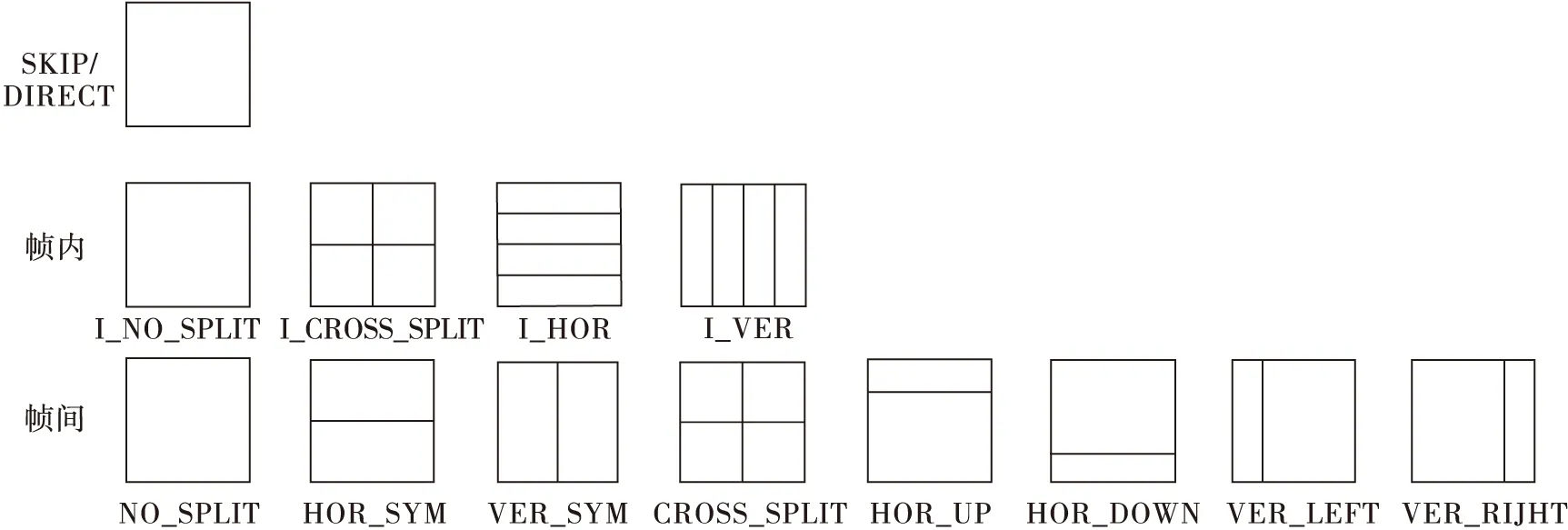

圖1 CU的預測模式

如圖1所示,幀間預測時CU有8種幀間預測模式(NO_SPLIT,HOR_SYM,VER_SYM,CROSS_SPLIT,HOR_UP,HOR_DOWN,VER_LEFT,VER_RIGHT)和4種幀內預測模式(I_NO_SPLIT,I_CROSS_SPLIT,I_HOR,I_VER)。CU的幀間預測模式還包括SKIP和DIRECT兩種特殊模式。

AVS2模型采用率失真優化方式決定最佳預測模式。遍歷圖1中所有預測模式,分別根據式(1)計算每種模式對應的率失真代價,選擇代價最小的模式作為最佳預測模式。

J(s,c,mode|QP,λmode)=SAD(s,c,mode|QP)+

λmodegR(s,c,mode|QF)

(1)

式中:mode為當前預測模式;SAD表示在給定量化參數QP的條件下,當前mode的重建塊c與原始塊s的絕對誤差和;λmode是拉格朗日乘子;R表示編碼運動矢量殘差、參考幀索引和變換塊系數等語法元素需要的比特數。

1.2 參考幀選擇

AVS2模型采用率失真優化方法選擇最優參考幀。在當前預測模式下對CU進行編碼時,對該CU的每個PU分別做運動估計,利用式(2)從參考幀配置集中選擇率失真代價最小的參考幀作為當前PU的最佳參考圖像。這種方法需要遍歷參考配置集中的每個參考幀。

J(mv,ref|λmotion)=SAD(s,r(ref,mv))+λmotion×

(R(mvd)+R(ref))

(2)

式中:ref為當前PU選擇的參考幀;SAD表示原始塊s與參考塊r(ref,mv)的絕對誤差和;mv是當前PU相對于參考塊的運動矢量;;R表示編碼運動矢量殘差(mvd)和ref需要的比特數。

根據上述分析,確定一個CU的最終劃分形式,需要遍歷CU的14種預測模式和CU下PU的每個參考幀,這使得幀間預測的復雜度很大。然而,相鄰CU在預測模式選擇和參考幀選擇上具有很大相關性,可以根據這種相關性減少遍歷帶來的復雜度。本文將統計相鄰CU的相關性,并根據相鄰CU的相關因子和編碼信息為當前CU分配合適的預測模式和參考幀。

2 快速幀間預測算法

2.1 相鄰CU的相關性分析

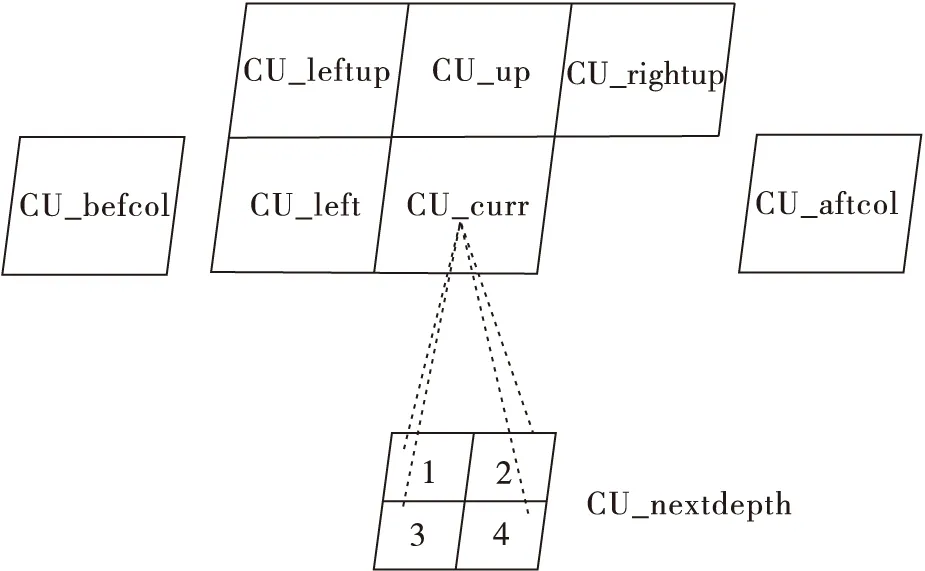

本文采用的相鄰CU的位置關系如圖2所示。CU_curr為當前編碼CU;CU_nextdepth為相鄰的下層深度的4個CU;CU_left,CU_leftup,CU_up,CU_rightup分別為空域相鄰的左、左上、上和右上CU;CU_belcol和CU_aftcol為前后相鄰幀的對應位置CU。AVS2模型采用類似四叉樹后序遍歷的方式對CU遍歷,因此在編碼當前CU時,這些相鄰CU均是已編碼CU,獲取它們的信息不會增加計算復雜度。

圖2 當前CU與相鄰CU的位置關系

幀間預測時,兩個相鄰CU間的運動一致性越高,相關性越強。為了統計相鄰CU的相關性,本文以AVS2參考軟件RD14.0為平臺,絕對誤差和(SAD)為相關性的指標。以CU_left為例,由RD14.0的傳統方法預測CU_left,可以得到CU_left在最佳編碼模式(包括最佳的預測模式、參考幀、運動矢量)下的SAD。CU_curr不作幀間預測,直接利用CU_left的最佳編碼模式編碼,同樣可得CU_curr的SAD。若這兩個CU的SAD值越接近,則它們的運動一致性越高,相關性越強。類似地,可統計得到當前CU與其他相鄰CU的相關性。

定義相關性因子RF表示各相鄰CU間的相關性,RF的計算公式為

(3)

式中:SADnei表示相鄰CU在最佳編碼模式下的SAD;SADcurr表示當前CU用相鄰CU的最佳編碼模式編碼得到的SAD。計算下層的每個CU的RF時,由于尺寸是當前CU的1/4,為了使SADnei與SADcurr具有可比性,取實際得到的下層CU的SAD值的4倍帶入SADnei。

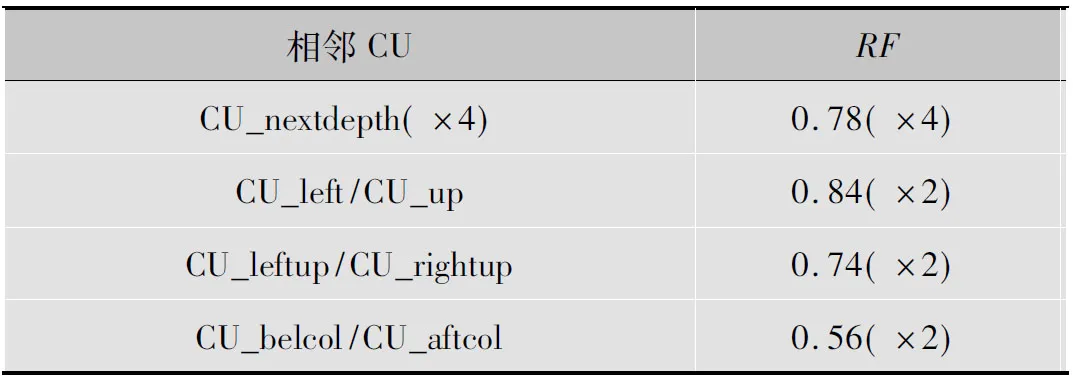

相鄰CU的相關性因子RF如表1所示。表中“(×)”中的數字表示CU的個數。這些相鄰CU的相關性均大于0.5,說明相鄰CU與當前編碼CU均具有較強的相關性。由于自然序列中水平和垂直的運動最頻繁,左邊和上邊CU的相關性最強。下一深度的4個CU和當前CU具有內容的重復性,相關性其次。前后幀對應位置的CU相關性相對最小。

表1 各相鄰CU的相關因子RF

2.2 預測模式快速選擇

紋理簡單、運動平緩的CU選擇簡單的預測模式以減少編碼比特率,而紋理復雜、運動劇烈的CU選擇復雜的預測模式增加預測準確度。因此,表2針對不同運動和紋理的CU,將CU的預測模式分為5類,定義模式復雜度因子MCF表征其運動和紋理的復雜度。

表2中MCF值的分配由實驗所得。每種預測模式對應一個MCF值,簡單的預測模式對應較小的MCF值,復雜的預測模式對應較大的MCF值。相鄰CU編碼選出最佳的預測模式后,根據表2將預測模式映射為相應的MCF值,結合表1中的相關因子RF,可預測當前CU的MCF值。根據預測得到的MCF值可為當前CU分配合適的候選預測模式。

表2 預測模式分類及與MCF的對應

定義由相鄰CU預測得到的當前CU的模式復雜因子為PMCF,即

(4)

式中:N取為9;MCFi表示各相鄰CU的模式復雜度因子MCF;RFi表示相鄰CU的相關因子RF;Ei表示相鄰CU是否存在。Ei=1表示相鄰CU存在,Ei=0則表示不存在。由表2可得PMCF的取值范圍為[0,5]。

PMCF很大程度上反映了當前CU的預測模式復雜度,根據PMCF的取值為CU分配適當的候選預測模式,分配公式為

(5)

式中:{MODEcand}表示當前CU的候選預測模式;Num表示相鄰CU的存在數量。當Num>N/2且相鄰CU都選擇SKIP模式時,PMCF=0,說明當前CU無運動且紋理很簡單,當前CU只選擇C1為預測模式;當0

2.3 參考幀快速選擇

自然視頻序列中當前幀與相鄰幀的相關性大于與遠端參考幀的相關性,相鄰幀被選為最佳參考幀的概率遠大于其他參考幀[6]。因此可利用視頻的特征減少對參考幀的搜索,減少編碼計算復雜度。

表1的數據顯示,相鄰CU具有強相關性。相鄰PU也具有類似的相關性。本文利用相鄰PU的最佳參考幀索引預測當前PU的參考幀索引值,根據預測得到的索引值為當前PU分配合適的候選參考幀,去除參考幀遍歷的冗余。前后幀對應位置的PU對當前PU參考幀選擇的參考意義較小,本文所選的相鄰PU不包含前后幀對應位置的PU。相鄰PU的位置關系類似圖2中相鄰CU的位置關系。

定義由相鄰PU預測得到的當前PU的參考幀索引為PRI。類似PMCF計算公式,PRI的計算公式為

(6)

式中:N取為7;RIi為各相鄰PU的最佳參考幀索引,RIi按照與當前幀距離由近到遠依次取值為1,2,3,…,M-1,M為總參考幀數;RFi表示相鄰PU的相關因子RF,本文采用表1中的相關性因子;Ei表示相鄰PU是否存在,Ei=1表示相鄰PU存在,Ei=0則表示不存在。

根據PRI的取值為當前PU分配候選的參考幀。候選參考幀的分配為

(7)

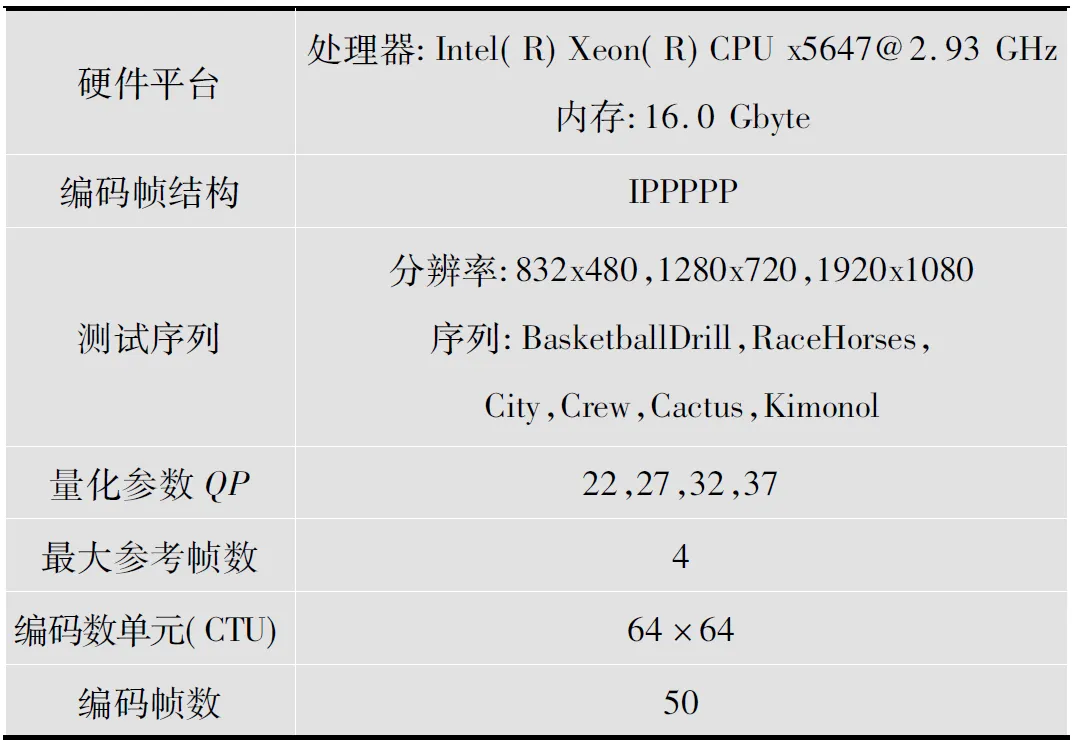

式中:{REFcand}為PU的候選參考幀;Num表示相鄰PU的存在數量。當Num>N/2且PRI=0時,相鄰PU都選擇最近的參考幀,說明當前PU與最近參考幀中的參考塊的相關性最強,當前PU選擇最近參考幀為最佳參考幀;當Num>2且PRI 為了驗證本文提出的快速幀間算法的有效性,在AVS2最新參考軟件RD14.0中實現本文算法,選擇不同分辨率和不同運動紋理程度的序列進行測試,實驗具體配置如表3所示。采用峰值信噪比差值(Bjontegaard delta peak signal-to-noise rate, BD-PSNR)和編碼比特率差值(Bjontegaard delta bit rate, BD-Rate)[7]分別衡量視頻序列中圖像失真程度和壓縮效率,評估算法的整體率失真特性。編碼時間變化則用ΔT表示,即 (8) 式中,TRD和Tpro分別表示RD14.0中傳統方法和所提的快速算法的編碼時間。 本文除了和RD14.0的傳統方法對比之外,還選擇在RD14.0的基礎上對文獻[5]的算法進行橫向對比,結果如表4所示。由表4可得,文獻[5]的算法相對于RD14.0傳統方法在BD-Rate增加3.00%,BD-PSNR降低0.1 dB的前提下,平均減少32.04%的編碼時間。而本文算法相對于RD14.0傳統方法在BD-Rate增加1.22%,BD-PSNR降低0.04 dB的前提下,平均減少47.54%的編碼時間。因此,本文算法比傳統方法節省了較多時間,而且與文獻[5]的算法相比,本文算法不僅額外節省15.5%的時間,而且BD-Rate降低1.78%,BD-PSNR增加0.06 dB。 表3 實驗測試條件 表4 各算法與RD14.0對比的結果 對于運動速度較快的RaceHorses和紋理相對復雜的City,本文所提算法節省的時間較少。而對于運動緩慢的Crew和紋理相對簡單的BasketballDrive,本文所提算法節省的時間較多。由于Crew存在鏡頭閃爍,Cactus旋轉運動較多,候選的預測模式和參考幀誤差相對其他序列較大,視頻質量下降較多。 選擇實驗數據中BD-Rate增加較多,BD-PSNR降低較多的序列Crew和Cactus繪制RD曲線。如圖3所示,本文算法與RD14.0方法的RD曲線基本重合,對這兩種序列的編碼效率影響很小。因此可證本文算法對于視頻編碼質量和壓縮效率影響很小。 圖3 本文算法與RD14.0傳統方法的的RD曲線 選擇實驗數據中時間節省較少的序列RaceHorses和City,分別繪制4個不同QP下,文獻[5]和本文算法較RD14.0中傳統方法的時間節省圖。如圖4所示,橫坐標為編碼的QP,縱坐標為相對于RD14.0的編碼時間節省。由圖4中走勢可得,隨著QP的增加,快速算法的時間節省越多,本文算法相對于RD14.0中的傳統方法時間節省較多。而且和文獻[5]比較,本文算法也能額外節省不少時間。因此,本文的快速算法是有效的。 圖4 各算法相對于RD14.0傳統方法的時間節省圖 本文重點研究了在AVS2的幀間預測中,使用多劃分模式、多參考幀技術帶來的編碼復雜度增加問題。針對這一問題,本文創新性地使用與當前編碼CU有著強相關性的下一深度的4個CU的編碼信息,并結合空時域相鄰CU的編碼信息。統計這些相鄰CU的相關性,并由相鄰CU的相關因子和預測模式為當前CU分配合理的候選預測模式,同時利用相鄰PU的相關因子和參考幀索引預測當前PU的候選參考幀,避免了預測模式和參考幀遍歷的冗余。實驗結果表明,本文算法與RD14.0的傳統方法相比,在BD-Rate增加1.22%,BD-PSNR降低0.04 dB的前提下,平均減少47.54%的編碼時間。與文獻[5]的算法相比,不僅節省15.5%的時間,而且BD-Rate降低1.78%,BD-PSNR增加0.06 dB。由此可見,本文算法在視頻質量和比特率損失很小的情況下,編碼時間節省較多。 [1] HE Z C,YU L, ZHENG X Z, et al. Framework of AVS2-video coding[C]//Proc. the 20th IEEE International Conference on Image Processing. Piscataway: IEEE,2013: 1515-1519. [2] 馬思偉.AVS視頻編碼標準技術回顧及最新進展[J].計算機研究與發展,2015,52(1):27-37. [3] SHEN L Q, ZHANG Z Y, LIU Z. Adaptive inter-mode decision for HEVC jointly utilizing inter-level and spatiotemporal correlations[J]. IEEE transactions on circuits and systems for video technology,2014,24(10): 1709-1722. [4] 鄭蕭楨.AVS_M3012:AVS快速決策機[EB/OL]. [2016-04-10]. ftp://124.207.250.92/public/avsdoc/1212_Beijing/contrib/. [5] 林琪,趙海武,王國中,等.面向AVS2的快速幀間預測算法[J].電視技術,2014,38(17):76-84. [6] 張淑芳,李華.基于H.264的多參考幀快速選擇算法[J].電子學報,2009,37(1):62-66. [7] BJONTEGAARD G. Calculation of average PSNR difference between RD-curves[EB/OL]. [2016-04-10]. http://ftp3.itu.ch/av-arch/video-site/0104-Aus/. 陳 芳(1992— ),女,碩士生,主研視頻編解碼技術; 李國平(1974— ),碩士生導師,主研視頻編解碼技術、復用技術等; 王國中(1962— ),博士生導師,主研視頻編碼與多媒體通信、圖像處理等; 趙海武(1973— ),碩士生導師,主研視頻編解碼技術、復用技術等; 滕國偉(1975— ),碩士生導師,主研視頻編解碼技術、智能視頻分析等。 責任編輯:薛 京 Fast inter-frame prediction algorithm for AVS2 based on multiple temporal-spatial correlations CHEN Fang, LI Guoping, WANG Guozhong, ZHAO Haiwu, TENG Guowei (ShanghaiUniversity,SchoolofCommunicationandInformationEngineering,Shanghai200444,China) The complexity of inter-frame prediction is increased in the new generation video standard AVS2 by introducing the technology of quad-tree division, multiple reference frames, etc. To solve the problem, a fasted inter-frame prediction algorithm based on multiple temporal-spatial correlations is proposed. The mode complexity of current coding unit(CU) is calculated by the correlations of adjacent depth and adjacent temporal-spatial CU in terms of the selection of prediction mode, then the appropriate candidates of prediction mode are distributed according to the mode complexity. At the same time, the reference index of current prediction unit(PU) is calculated by the correlations of adjacent PU in terms of the selection of reference frame, then the appropriate candidates of reference frame are distributed according to the reference index. Experimental results show that, the proposed algorithm can reduce the encoding time by 47.54% on average, with a 1.22% increase of Bjontegaard delta bit rate(BD-Rate) and a 0.04dB decrease of Bjontegaard delta peak signal-to-noise rate(BD-PSNR). AVS2; multiple temporal-spatial correlation; mode complexity; prediction mode; reference frame 國家自然科學基金項目(61271212);國家“863”計劃項目(2015AA015903) 陳芳,李國平,王國中,等.基于多時-空相關的AVS2快速幀間預測算法[J]. 電視技術,2016,40(12):1-6. CHEN F, LI G P, WANG G Z,et al.Fast inter-frame prediction algorithm for AVS2 based on multiple temporal-spatial correlations[J]. Video engineering,2016,40(12):1-6. TN919.81 A 10.16280/j.videoe.2016.12.001 2016-05-203 實驗結果

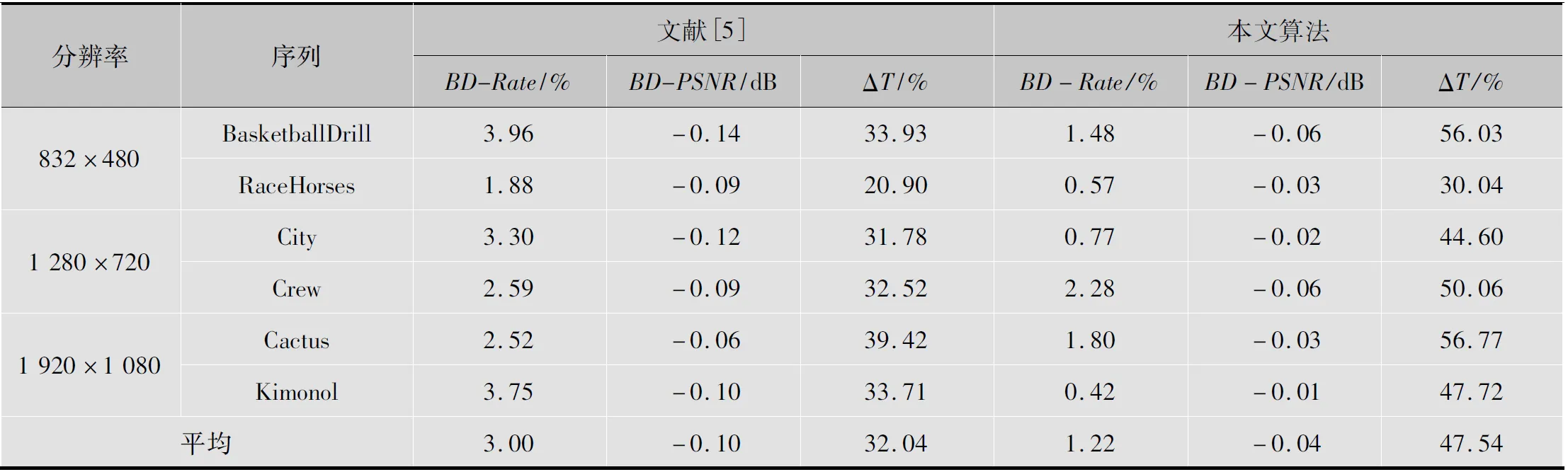

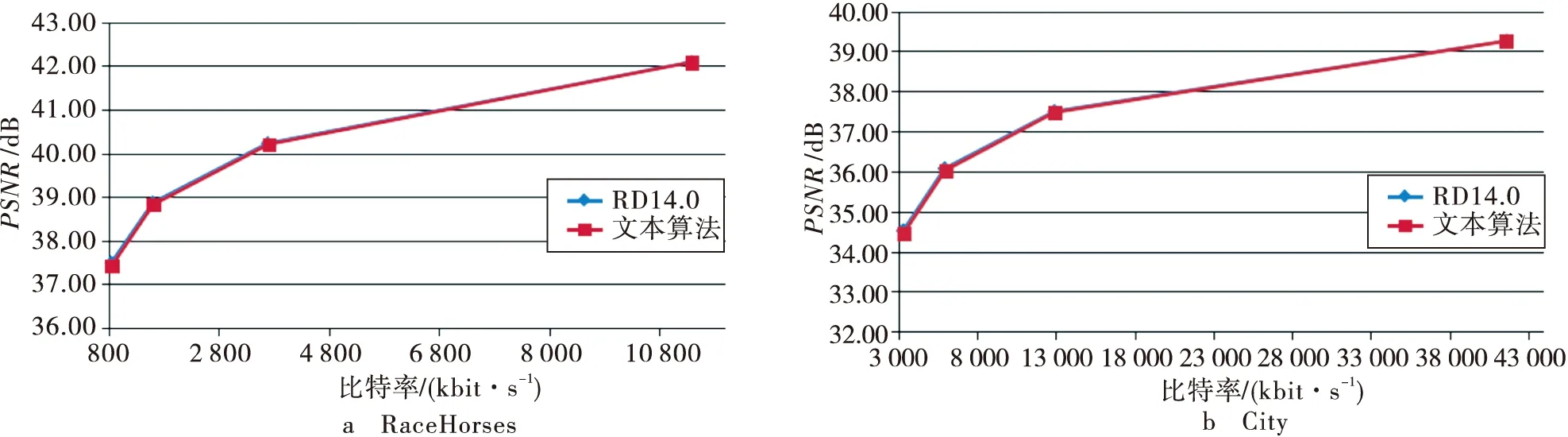

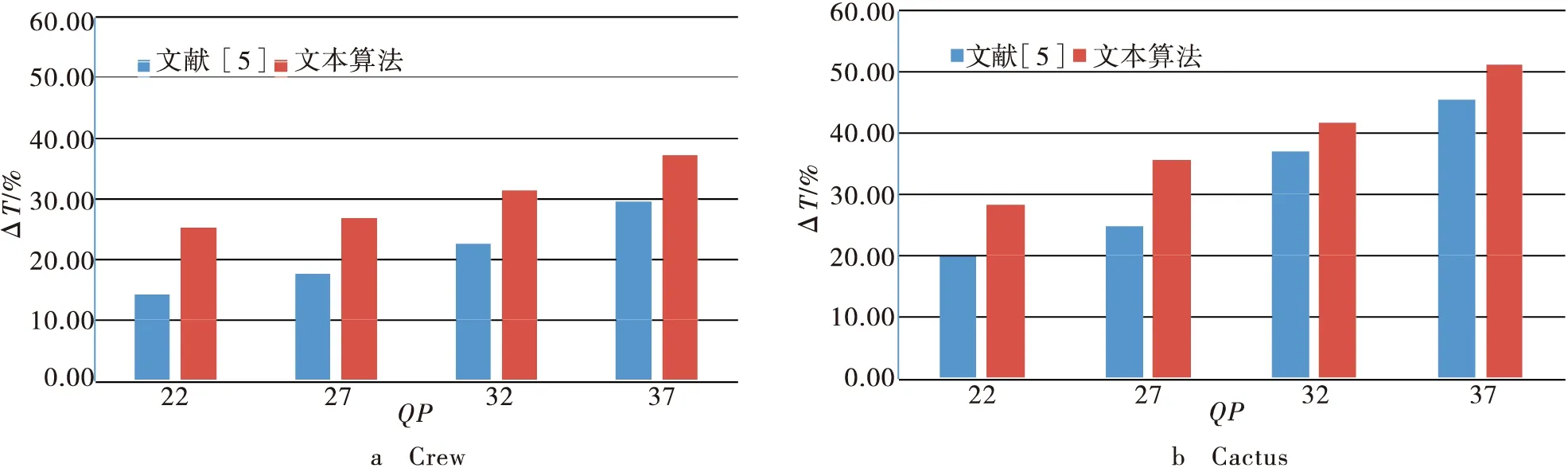

4 小結