PCA預(yù)訓(xùn)練的卷積神經(jīng)網(wǎng)絡(luò)目標(biāo)識別算法

史鶴歡,許悅雷,馬時平,李岳云,李 帥

(空軍工程大學(xué)航空航天工程學(xué)院,陜西西安 710038)

PCA預(yù)訓(xùn)練的卷積神經(jīng)網(wǎng)絡(luò)目標(biāo)識別算法

史鶴歡,許悅雷,馬時平,李岳云,李 帥

(空軍工程大學(xué)航空航天工程學(xué)院,陜西西安 710038)

針對卷積神經(jīng)網(wǎng)絡(luò)對合成孔徑雷達(dá)目標(biāo)識別訓(xùn)練在標(biāo)簽數(shù)據(jù)不足,平移、旋轉(zhuǎn)以及復(fù)雜情況下的識別率不高問題,提出一種優(yōu)化的卷積神經(jīng)網(wǎng)絡(luò)目標(biāo)識別算法.為克服標(biāo)簽數(shù)據(jù)不足,利用主成分分析非監(jiān)督訓(xùn)練一組特征集初始化卷積神經(jīng)網(wǎng)絡(luò);為提高訓(xùn)練速度,同時避免陷入過擬合,采用線性修正函數(shù)作為非線性函數(shù);為增強(qiáng)魯棒性,同時減小下采樣對特征表示的影響,引入概率最大化下采樣的方式,并在卷積層后對特征進(jìn)行局部對比度標(biāo)準(zhǔn)化.實(shí)驗(yàn)表明,與傳統(tǒng)的卷積神經(jīng)網(wǎng)絡(luò)相比,該算法對合成孔徑雷達(dá)目標(biāo)具有更高的識別率,并對圖像各種形變以及復(fù)雜背景具有較好的魯棒性.

卷積神經(jīng)網(wǎng)絡(luò);主成分分析;概率最大化下采樣;線性修正函數(shù);局部對比度標(biāo)準(zhǔn)化

對圖像中目標(biāo)的精確和魯棒識別是模式識別及人工智能領(lǐng)域的核心內(nèi)容.在軍事領(lǐng)域,隨著合成孔徑雷達(dá)(Synthetic Aperture Radar,SAR)成像技術(shù)的完善和合成孔徑雷達(dá)數(shù)據(jù)級數(shù)倍的增加,從大量數(shù)據(jù)及復(fù)雜場景中獲取并識別各類軍事目標(biāo)成為了研究熱點(diǎn).近年來,深度神經(jīng)網(wǎng)絡(luò)成為機(jī)器學(xué)習(xí)新的熱點(diǎn),基于卷積神經(jīng)網(wǎng)絡(luò)的圖像識別算法因其較強(qiáng)的魯棒性和突出的識別率被學(xué)術(shù)界和工業(yè)界所重視[1].

文獻(xiàn)[2]中提出基于大型深層卷積神經(jīng)網(wǎng)絡(luò)(Convolutional Neural Networks,CNN)的自然圖像識別算法,在ImageNet數(shù)據(jù)集上取得了很高的識別率;文獻(xiàn)[3]中提出了多核的卷積神經(jīng)網(wǎng)絡(luò),并采用圖形處理單元(Graphics Processing Unit,GPU)并行運(yùn)算的方法在三維NORB數(shù)據(jù)集上取得了很好的識別效果.以上算法都取得了較高的識別率,但由于采用有監(jiān)督的訓(xùn)練方式,網(wǎng)絡(luò)權(quán)值的調(diào)整需要大量標(biāo)簽數(shù)據(jù),當(dāng)數(shù)據(jù)量較小時會導(dǎo)致模型無法充分訓(xùn)練,故只適用于標(biāo)簽數(shù)據(jù)較多的大型數(shù)據(jù)集.針對此問題,目前主流的解決方法是采用特征提取算法進(jìn)行非監(jiān)督預(yù)訓(xùn)練,得到濾波器集對卷積神經(jīng)網(wǎng)絡(luò)進(jìn)行初始化.文獻(xiàn)[4]選用稀疏編碼提取輸入數(shù)據(jù)的基函數(shù)作為卷積神經(jīng)網(wǎng)絡(luò)的初始濾波器;文獻(xiàn)[5]利用獨(dú)立成分分析(Independent Component Analysis,ICA)預(yù)訓(xùn)練對卷積神經(jīng)網(wǎng)絡(luò)進(jìn)行權(quán)值初始化.兩種初始化權(quán)值的方法都使卷積神經(jīng)網(wǎng)絡(luò)的識別率有了一定的提高,但是兩者對數(shù)據(jù)特征提取的效果一般,所以需要探索更加高效、魯棒的算法進(jìn)行非監(jiān)督訓(xùn)練.

除初始權(quán)值外,下采樣層也是影響卷積神經(jīng)網(wǎng)絡(luò)識別率和魯棒性的又一重要因素.下采樣層主要負(fù)責(zé)對特征進(jìn)行模糊,從而獲得平移、尺度等不變性,該層神經(jīng)元的狀態(tài)由上一層局部“接受域”和采樣規(guī)則決定,采樣規(guī)則一般取“接受域”內(nèi)神經(jīng)元響應(yīng)值的最小值、均值、中值、最大值等.這些規(guī)則雖然能實(shí)現(xiàn)對特征的模糊和泛化,獲得平移和尺度的不變性,卻是不可逆的,網(wǎng)絡(luò)反向傳播的過程中必然造成數(shù)據(jù)特征的損失,直接限制卷積神經(jīng)網(wǎng)絡(luò)的識別率和魯棒性.文獻(xiàn)[6]使用了最大值采樣,經(jīng)過2次卷積、2次最大值下采樣,網(wǎng)絡(luò)的輸出值在重構(gòu)后,相對于原始輸入數(shù)據(jù)有了一定的損失,直接影響了識別的準(zhǔn)確性.文獻(xiàn)[7]對原有的下采樣方式進(jìn)行了優(yōu)化,提出概率最大化采樣方式,在保證不變性的同時最大程度地保留了特征信息.

針對以上問題,筆者提出基于主成分分析(Principal Component Analysis,PCA)[8]的卷積神經(jīng)網(wǎng)絡(luò)的目標(biāo)識別算法.首先,利用主成分分析非監(jiān)督預(yù)訓(xùn)練初始化卷積神經(jīng)網(wǎng)絡(luò),通過最小化重構(gòu)誤差獲得待識別圖像的隱層表示,進(jìn)而學(xué)習(xí)得到含有訓(xùn)練數(shù)據(jù)統(tǒng)計(jì)特性的濾波器集合.其次,為提高訓(xùn)練速度,在保證特征稀疏的同時避免陷入過擬合,將非線性函數(shù)改進(jìn)為線性修正函數(shù)(Rectified Linear Units,ReLU);為減小下采樣對特征的損失并增強(qiáng)魯棒性,引入概率最大化采樣規(guī)則,并在卷積層后對特征進(jìn)行局部對比度標(biāo)準(zhǔn)化.

1 主成分分析非監(jiān)督訓(xùn)練

假設(shè)卷積神經(jīng)網(wǎng)絡(luò)的輸入訓(xùn)練數(shù)據(jù)有N幅大小為m×n的訓(xùn)練圖像,卷積濾波器的大小為k1× k2.對訓(xùn)練數(shù)據(jù)的第i幅圖像Ii,在Ii中取出所有k1×k2的圖像塊,表示為,其中xi,j為圖像Ii中第j個圖像塊的向量表示形式;接著將xi,j去均值,獲得圖像Ii的圖像塊數(shù)據(jù)同理,訓(xùn)練數(shù)據(jù)的圖像塊數(shù)據(jù)為

利用主成分分析方法最小化重構(gòu)誤差求特征向量:

其中,IL是L×L的單位矩陣;V是協(xié)方差矩陣XXT的前L個特征向量,大小為(k1k2)×1,則V表示了輸入數(shù)據(jù)圖像塊的主成分.主成分分析學(xué)習(xí)到初始化卷積神經(jīng)網(wǎng)絡(luò)的濾波器組可表示為

通過主成分分析非監(jiān)督訓(xùn)練獲得訓(xùn)練數(shù)據(jù)局部圖像塊的主成分.這些主成分能夠最大程度地表示數(shù)據(jù)的局部特征,并作為濾波器能夠很好地獲得局部特征主要信息以及特征之間的變化和差異.因此,主成分分析訓(xùn)練濾波器可以視為一種非常簡單的自動編碼器.

2 卷積神經(jīng)網(wǎng)絡(luò)

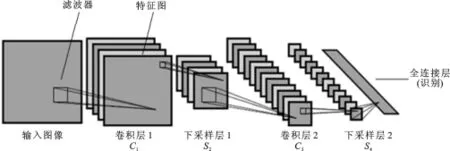

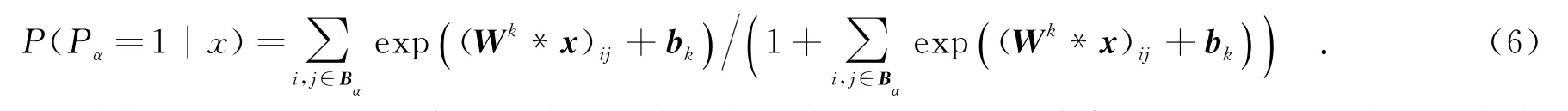

如圖1所示,卷積神經(jīng)網(wǎng)絡(luò)由卷積層、下采樣層和全連接層組成.輸入圖像在卷積層與濾波器進(jìn)行卷積,得到若干特征圖,接著在下采樣層進(jìn)行模糊和泛化,最后通過全連接層輸出用于識別圖像的特征[9-10].

輸入圖像與濾波器進(jìn)行卷積后通過一個激活函數(shù),就得到第1層輸出特征:

圖1 卷積神經(jīng)網(wǎng)絡(luò)結(jié)構(gòu)圖

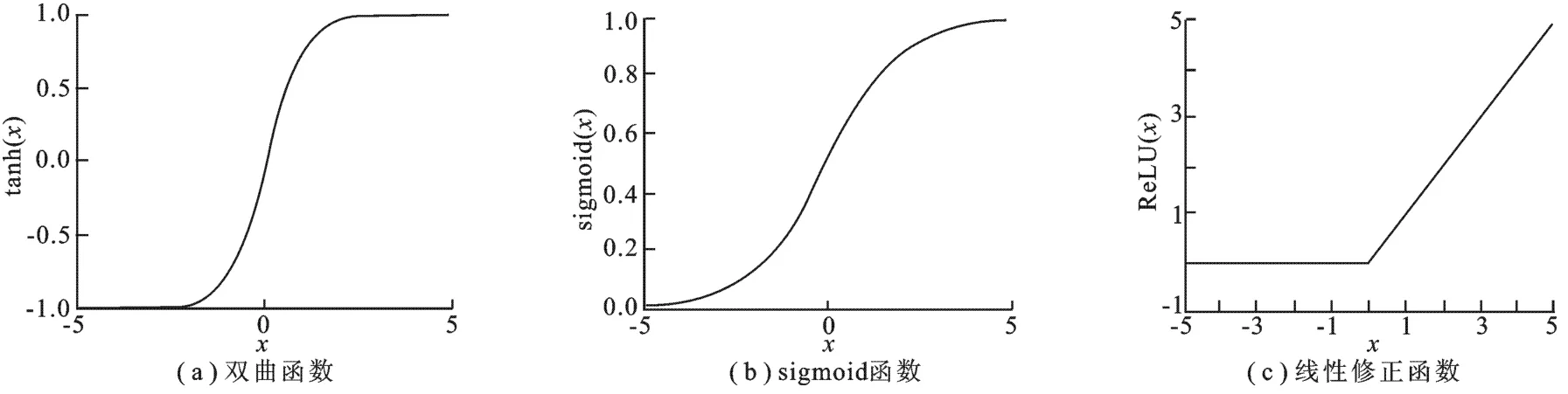

神經(jīng)網(wǎng)絡(luò)常用的非線性函數(shù)為雙曲函數(shù)和sigmoid函數(shù),如圖2(a)和(b)所示,而這兩種函數(shù)使網(wǎng)絡(luò)模型訓(xùn)練速度慢,易陷入過擬合.筆者選用如圖2(c)的線性修正函數(shù)的非線性函數(shù),即f(x)=max(x).

圖2 非線性函數(shù)

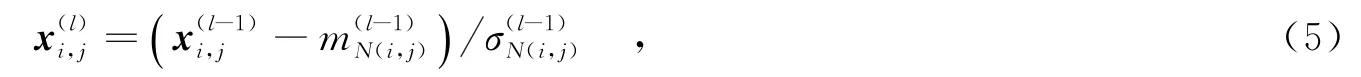

筆者提出的算法和傳統(tǒng)卷積神經(jīng)網(wǎng)絡(luò)的另一個不同之處,是在卷積層后增加了局部對比度標(biāo)準(zhǔn)化.該操作被證明可以提升特征的不變性并增加模型的稀疏度和魯棒性,提高識別率[12].具體標(biāo)準(zhǔn)化公式為

標(biāo)準(zhǔn)化后為下采樣.為保證特征不變性并最大程度地保留信息,獲得更強(qiáng)的魯棒性和較高的識別率,采用概率最大化采樣方式:當(dāng)采樣塊Bα中只要有一個神經(jīng)元開啟時,采樣值Pα就產(chǎn)生響應(yīng);否則,Pα不響應(yīng).表示為

卷積神經(jīng)網(wǎng)絡(luò)模型經(jīng)過下采樣后將所有特征圖輸入全連接層,經(jīng)過一層隱藏層后就得到最終用于分類的特征.將該特征直接輸入softmax分類器,就可以進(jìn)行目標(biāo)的分類識別了.

3 主成分分析非監(jiān)督訓(xùn)練的卷積神經(jīng)網(wǎng)絡(luò)目標(biāo)識別算法

基于卷積神經(jīng)網(wǎng)絡(luò)的模型和上述的主成分分析的非監(jiān)督預(yù)訓(xùn)練方法,圖3給出了基于視覺機(jī)制的卷積神經(jīng)網(wǎng)絡(luò)目標(biāo)識別算法的流程圖.

算法 基于視覺機(jī)制的卷積神經(jīng)網(wǎng)絡(luò)目標(biāo)識別算法.

步驟1 預(yù)訓(xùn)練濾波器:

(1)將訓(xùn)練集中的圖像裁剪成與濾波器相同尺寸k1×k2的圖像塊,按式(1)原理構(gòu)成數(shù)據(jù)X;

(2)按式(2)和式(3)原理,利用主成分分析從數(shù)據(jù)X非監(jiān)督訓(xùn)練得到卷積神經(jīng)網(wǎng)絡(luò)初始化濾波器權(quán)值.

步驟2 通過式(4)計(jì)算卷積并非線性化后的特征x(1).

步驟3 通過式(5)對x(1)進(jìn)行局部對比度標(biāo)準(zhǔn)化,輸出特征圖x(2).

步驟4 通過采樣規(guī)則為概率最大化下采樣的下采樣層對x(2)進(jìn)行模糊和泛化,得到x(3).

步驟5 將特征圖x(3)作為輸入數(shù)據(jù)重復(fù)步驟1~4,輸出特征圖x(4).

步驟6 將特征圖x(4)合并為一個列向量,作為全連接層的輸入,利用softmax分類器輸出識別結(jié)果.

圖3 算法流程圖

步驟7 計(jì)算識別結(jié)果和標(biāo)記的差異,通過反向傳播算法[12]自頂向下調(diào)節(jié)更新參數(shù)

步驟8 輸入測試圖像,利用訓(xùn)練得到的濾波器集合和全連接網(wǎng)絡(luò)權(quán)重參數(shù)對測試圖像進(jìn)行目標(biāo)識別.

4 仿真實(shí)驗(yàn)及分析

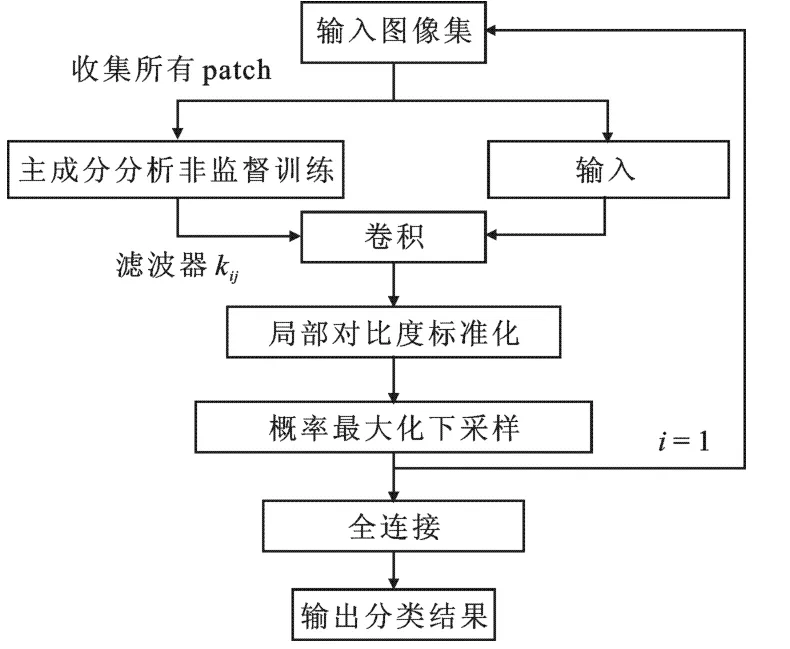

仿真實(shí)驗(yàn)采用運(yùn)動與靜止目標(biāo)的獲取與識別(Moving and Stationary Target Acquisition and Recognition,MSTAR)實(shí)測數(shù)據(jù),它由實(shí)測的合成孔徑雷達(dá)地面靜止軍用目標(biāo)數(shù)據(jù)組成.實(shí)驗(yàn)選用其中的3類合成孔徑雷達(dá)目標(biāo)(如圖4):BMP2(裝甲車)、BTR70(裝甲車)、T72(主戰(zhàn)坦克).圖像成像分辨率是0.3 m×0.3 m,方位角覆蓋范圍是0°~360°,圖像大小為128×128,訓(xùn)練樣本總數(shù)為698幅俯視角為15°的目標(biāo)圖像,測試樣本總數(shù)為1 365幅俯視角為17°的目標(biāo)圖像.由于經(jīng)過校正目標(biāo)基本處于圖像的中央位置,故將每一幅圖像的中央90×90的圖像塊作為實(shí)驗(yàn)數(shù)據(jù),并對數(shù)據(jù)進(jìn)行一定的預(yù)處理,減少背景對特征提取和目標(biāo)識別的影響.選擇MSTAR數(shù)據(jù)庫的原因是因?yàn)槠溆袠?biāo)簽的訓(xùn)練數(shù)據(jù)少,可以很好地體現(xiàn)文中的非監(jiān)督預(yù)訓(xùn)練算法的優(yōu)越性.實(shí)驗(yàn)用中央處理器(Central Processing Unit,CPU)為2.8 GHz、3 GB內(nèi)存,在Matlab(2010b)的環(huán)境下進(jìn)行.

圖4 MSTAR數(shù)據(jù)庫目標(biāo)

4.1算法識別率對比測試

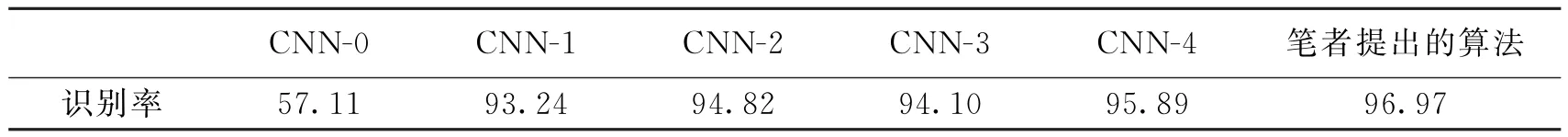

文中的卷積神經(jīng)網(wǎng)絡(luò)模型如圖1所示,根據(jù)圖3中的步驟進(jìn)行實(shí)驗(yàn).卷積神經(jīng)網(wǎng)絡(luò)由5層構(gòu)成:兩層卷積、兩層下采樣及全連接層.第1層卷積層濾波器個數(shù)為8,第2層卷積層濾波器個數(shù)為16,大小均為7×7;下采樣間隔為2,采樣方式為概率最大化采樣.對比算法為:①CNN-0.卷積濾波器隨機(jī)產(chǎn)生,下采樣方式為均值采樣,非線性函數(shù)為sigmoid函數(shù);②CNN-1.CNN-0中的卷積濾波器使用主成分分析非監(jiān)督訓(xùn)練得到;③CNN-2.CNN-1中的下采樣方式改為概率最大化采樣;④CNN-3.CNN-1中的非線性函數(shù)采用線性修正函數(shù);⑤CNN-4.卷積濾波器利用獨(dú)立成分分析非監(jiān)督訓(xùn)練得到,下采樣方式為概率最大化采樣,非線性函數(shù)采用線性修正函數(shù).實(shí)驗(yàn)結(jié)果如表1所示.

表1 不同條件下的卷積神經(jīng)網(wǎng)絡(luò)識別率對比%

由表1可以看出,筆者提出的算法對MSTAR數(shù)據(jù)的識別率相對于不同條件下的卷積神經(jīng)網(wǎng)絡(luò)的識別率有明顯的提高.卷積濾波器是影響卷積神經(jīng)網(wǎng)絡(luò)識別率的核心,卷積神經(jīng)網(wǎng)絡(luò)的訓(xùn)練就是對卷積濾波器的調(diào)整,從而調(diào)整卷積神經(jīng)網(wǎng)絡(luò)各層所提取的特征,利用這些特征進(jìn)行分類識別.CNN-0對MSTAR的識別率非常低,因?yàn)榫矸e濾波器的初始值是隨機(jī)產(chǎn)生的,在處理背景比較復(fù)雜且數(shù)據(jù)量較少的識別問題時很容易陷入局部最優(yōu),因而很難或者不能通過訓(xùn)練調(diào)整得到合適的卷積濾波器;主成分分析可以很好地通過輸入數(shù)據(jù)集得到所有數(shù)據(jù)線性組合的一組基,這組基能夠最大程度地表示輸入訓(xùn)練圖像的局部特征信息,用這組基作為濾波器能夠很好地從數(shù)據(jù)中獲得局部特征最主要的成分以及特征之間的變化和差異,因而可解決隨機(jī)初始化陷入局部最優(yōu)的問題,故CNN-1解決了卷積神經(jīng)網(wǎng)絡(luò)對MSTAR能否識別的問題.筆者提出的算法相對于CNN-4的識別率有了明顯的提升,是因?yàn)橹鞒煞址治霰泉?dú)立成分分析能夠從輸入數(shù)據(jù)中獲得更優(yōu)的卷積濾波器,具有更強(qiáng)的魯棒性和自適應(yīng)性;CNN-2和CNN-3較CNN-1的識別率有了一定的提高,在概率最大化下,采樣方式在保證不變性的同時能夠最大程度地保留特征信息,線性修正函數(shù)能夠有效地避免訓(xùn)練進(jìn)入局部最優(yōu),也能提升卷積神經(jīng)網(wǎng)絡(luò)的訓(xùn)練速度.

4.2算法魯棒性實(shí)驗(yàn)

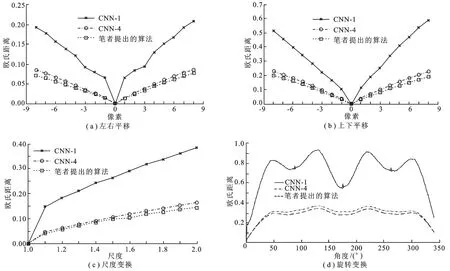

為驗(yàn)證文中卷積神經(jīng)網(wǎng)絡(luò)的魯棒性,選取不同類別的圖像,對其進(jìn)行平移、尺度、旋轉(zhuǎn)變換;然后計(jì)算圖像變換前后卷積神經(jīng)網(wǎng)絡(luò)的全連接層特征的歐氏距離,用歐氏距離的大小來衡量輸出特征對于目標(biāo)變化的魯棒性.距離越小,就說明特征對于目標(biāo)變化越不敏感,魯棒性就越好.利用MSTAR庫中任選的一幅圖片進(jìn)行實(shí)驗(yàn),對比算法為CNN-1和CNN-4,測試結(jié)果如圖5所示.

圖5 魯棒性實(shí)驗(yàn)結(jié)果

由圖5可以看出,筆者提出的算法對MSTAR數(shù)據(jù)集的平移、尺度、旋轉(zhuǎn)均表現(xiàn)出良好的魯棒性.相比而言,CNN-1提取的特征魯棒性較差,目標(biāo)圖像微小的變化就導(dǎo)致了特征較大的改變.筆者提出的算法魯棒性較好,首先是因?yàn)椴捎弥鞒煞址治龅姆椒ǚ潜O(jiān)督訓(xùn)練,得到的濾波器能夠很好地從數(shù)據(jù)中獲得局部特征最主要的成分以及特征之間的變化和差異;其次是因?yàn)楣P者提出的算法引入概率最大化下采樣的下采樣方式,并將非線性函數(shù)改進(jìn)為線性修正函數(shù),從而在保證不變性的同時能夠最大程度地保留特征信息,并且有效地避免了訓(xùn)練陷入局部最優(yōu);最后是筆者提出的算法采用了局部對比度標(biāo)準(zhǔn)化,對數(shù)據(jù)中存在噪聲的目標(biāo)圖像魯棒性增強(qiáng).

5 結(jié)束語

筆者提出基于主成分分析非監(jiān)督訓(xùn)練的卷積神經(jīng)網(wǎng)絡(luò)目標(biāo)識別算法.該算法利用主成分分析非監(jiān)督訓(xùn)練卷積濾波器,提高了卷積神經(jīng)網(wǎng)絡(luò)對MSTAR目標(biāo)的識別率,為使網(wǎng)絡(luò)更具魯棒性,進(jìn)一步提高識別率,引入概率最大化下采樣方式,并將非線性函數(shù)改為線性修正函數(shù),在保證不變性的同時能夠最大程度地保留特征信息,并且有效地避免了訓(xùn)練陷入局部最優(yōu),使特征更加稀疏.為使卷積神經(jīng)網(wǎng)絡(luò)對復(fù)雜背景圖像有更強(qiáng)的魯棒性,引入了局部對比度標(biāo)準(zhǔn)化.與不同條件下的卷積神經(jīng)網(wǎng)絡(luò)的對比實(shí)驗(yàn)表明,筆者提出的算法能夠獲得較高的識別率,并對平移、尺度和旋轉(zhuǎn)變換具有較強(qiáng)的魯棒性.

[1]李帥,許悅雷,馬時平,等.一種深度神經(jīng)網(wǎng)絡(luò)SAR遮擋目標(biāo)識別方法[J].西安電子科技大學(xué)學(xué)報(bào),2015,42(3): 154-160. LI Shuai,XU Yuelei,MA Shiping,et al.New Method for SAR Occluded Targets Recognition Using DNN[J].Journal of Xidian University,2015,42(3):154-160.

[2]KYIZHEUSKY A,SUTSKEVER I,HINTON G E,et al.Image Net Classification with Deep Convolutional Neural Networks[C]//Neural Information Processing Systems Conference.Nevada:Neural Information Processing Systems Foundation,2012:1106-1114.

[3]DAN C,UELI M,JURGEN S.Multi-column Deep Neural Networks for Image Classification[C]//IEEE Conference on Computer Vision and Pattern Recognition.Piscataway:IEEE,2012:3642-3649.

[4]KAVUKCUOGLU K,SERMANET P,BOUREAU Y,et al.Learning Convolutional Feature Hierarchies for Visual Recognition[C]//Advances in Neural Information Processing Systems Workshops.Real Hook:Neural Information Processing System Foundation,2010:1090-1098.

[5]KAVUKCUOGLU K,RANZATO M,FERGUS R,et al.Learning Invariant Features through Topographic Filter Maps [C]//IEEE Conference on Computer Vision and Pattern Recognition.Piscataway:IEEE Computer Society,2009: 1605-1612.

[6]ZEILER M D,FERGUS R.Visualizing and Understanding Convolutional Neural Networks[C]//European Conference on Computer Vision.Berlin:Springer International Publishing,2014:818-833.

[7]LEE H,GROSSE R,RANGANATH R,et al.Convolutional Deep Belief Networks for Scalable Unsupervised Learning of Hierarchical Representation[C]//Proceedings of the 26th International Conference on Machine Learning.New York: ACM,2009:609-616.

[8]BURGES C J C,PLATT J C,JANA S,et al.Distortion Discriminant Analysis for Audio Fingerprinting[J].IEEE Transactions on Speech and Audio Processing,2003,11(3):165-174.

[9]LECUN Y,BOTTOU L,BENGIO Y.Gradient-based Learning Applied to Document Recognition[J].Proceedings of the IEEE,2008,86(11):2278-2324.

[10]NEUBAUER C.Evaluation of Convolutional Neural Networks for Visual Recognition[J].IEEE Transactions on Neural Networks,1998,11(4):685-696.

[11]JARRETT K,KAVUKCUOGLU K,RANZATO M A,et al.What is the Best Multi-stage for Object Architecture? [C]//Proceedings of the IEEE 12th International Conference on Computer Vision.Piscataway:IEEE,2009:2146-2153.

[12]BOUVRIE J.Notes on Convolutional Neural Networks[EB/OL].[2014-11-24].http://www.math.duke.edu/~jvb/ papers/cnn?tutorial.pdf.

(編輯:郭 華)

Convolutional neural networks recognition algorithm based on PCA

SHI Hehuan,XU Yuelei,MA Shiping,LI Yueyun,LI Shuai

(Aeronautics and Astronautics Engineering College,Air Force Engineering Univ.,Xi’an 710038,China)

To improve the insufficiency of Synthetic Aperture Radar(SAR)labeled training data for Convolutional Neural Networks(CNN)and the recognition rate for large variations,a novel CNN recognition algorithm is proposed.Firstly,a set of features is extracted from the original data by unsupervised training based on PCA as the initial filter set for CNN.Secondly,in order to accelerate the training speed while avoiding over-fitting,the Rectified Linear Units(ReLU)is adopted as the non-linear function.Thirdly,to strengthen robustness and mitigate the defects of pooling upon features,a probabilistic max-pooling sampling method is introduced and local contrast normalization is exploited on features after the convolutional layer.Experiments demonstrate that our algorithm outperforms the original CNN in recognition rate and achieves better robustness for large variations and complex background.

convolutional neural network;principal component analysis;probabilistic max-pooling; rectified linear units;local contrast normalization

TP391.41

A

1001-2400(2016)03-0161-06

10.3969/j.issn.1001-2400.2016.03.028

2015-01-19

時間:2015-07-27

國家自然科學(xué)基金資助項(xiàng)目(61379104,61372167)

史鶴歡(1990-),男,空軍工程大學(xué)博士研究生,E-mail:shihehuan1990@126.com.

http://www.cnki.net/kcms/detail/61.1076.TN.20150727.1952.028.html