一種基于加權(quán)LDA模型的文本聚類方法

李 國(guó),張春杰,張志遠(yuǎn)

(中國(guó)民航大學(xué)a.計(jì)算機(jī)科學(xué)與技術(shù)學(xué)院;b.中國(guó)民航信息技術(shù)科研基地,天津 300300)

?

一種基于加權(quán)LDA模型的文本聚類方法

李國(guó)a,b,張春杰a,b,張志遠(yuǎn)a,b

(中國(guó)民航大學(xué)a.計(jì)算機(jī)科學(xué)與技術(shù)學(xué)院;b.中國(guó)民航信息技術(shù)科研基地,天津300300)

摘要:針對(duì)傳統(tǒng)聚類算法在處理大規(guī)模和高維文本聚類時(shí)存在的不足和局限性,提出了新的以LDA(latent dirichlet allocation)模型為基礎(chǔ)的聚類方法。通過(guò)LDA主題模型挖掘得到文本之中的潛在主題分布以及不同主題內(nèi)的詞語(yǔ)分布,分別計(jì)算文本在“文本-主題”特征空間和“主題-詞語(yǔ)”特征空間的相似度,然后對(duì)兩者線性加權(quán),獲得最終的文本相似度。利用經(jīng)典的K-Means算法,在中英文語(yǔ)料庫(kù)上進(jìn)行的實(shí)驗(yàn)表明,與單純地利用VSM結(jié)合K-Means相比,具有較好的聚類效果。

關(guān)鍵詞:LDA;向量空間模型;數(shù)據(jù)挖掘;文本聚類;K-Means

伴隨著互聯(lián)網(wǎng)近年來(lái)飛快的發(fā)展,圖書期刊、企業(yè)和個(gè)人信息、政府報(bào)告、多媒體資源和社會(huì)新聞等數(shù)據(jù)的規(guī)模都在快速膨脹,而以上這些內(nèi)容的基本呈現(xiàn)方式,大都是非結(jié)構(gòu)化的文本。由于這些文本信息發(fā)布的類別和渠道非常龐雜,人們想要在其中快速準(zhǔn)確地獲取有效的信息變得十分困難,在花費(fèi)了大量的時(shí)間和精力后往往也只是事倍功半。如何從這些海量文本中準(zhǔn)確高效地獲取人們真正想要得到的有用信息已成為目前迫切需要解決的問(wèn)題。作為一種無(wú)監(jiān)督機(jī)器學(xué)習(xí)方法,文本聚類算法已在文本自動(dòng)整理、數(shù)字圖書館服務(wù)和檢索結(jié)果的組織等方面獲得了比較廣泛的應(yīng)用。因?yàn)槭孪炔挥脤?duì)這些文本進(jìn)行類別的手工標(biāo)記,也無(wú)需訓(xùn)練過(guò)程,所以在文本的處理方面具有較高的簡(jiǎn)便靈活性,也日趨受到研究人員越來(lái)越多的關(guān)注。

在傳統(tǒng)的文本聚類中,應(yīng)用最廣泛的文本模型當(dāng)屬向量空間模型(vector space model,VSM)。該模型是由Salton等[1]于1969年提出來(lái)的,其采用文本中的詞作為特征項(xiàng),將文本集構(gòu)造成一個(gè)高維、稀疏的文本-詞語(yǔ)矩陣。但是VSM模型將詞語(yǔ)僅當(dāng)成一個(gè)標(biāo)量,忽視了其在文本中的內(nèi)在含義,無(wú)法辨別同義和多義詞。但在計(jì)算文本相似度時(shí),同義詞和多義詞具有相當(dāng)重要的作用。另外,由于文本和詞語(yǔ)數(shù)量通常都特別巨大,直接采用VSM模型產(chǎn)生的矩陣不僅維度高且極度稀疏,計(jì)算效率較低,因此在聚類之前通常需要對(duì)文本-詞語(yǔ)矩陣進(jìn)行降維操作[2]。目前高維矩陣的降維有多種方法,如概念索引(concept indexing,CI)、基于矩陣奇異值分解理論的隱含語(yǔ)義分析(latent semantic analysis,LSA)[3],以及多元統(tǒng)計(jì)分析理論中的主成分分析(principal component analysis,PCA)等[4]。特征提取也是一種有效的降維方式,常用方法包括信息增益(information gain,IG)、卡方(chi-square,CS)、術(shù)語(yǔ)強(qiáng)度(term strength,TS)及互信息(mutual information,MI)等[5]。上面所介紹的算法都是基于大規(guī)模語(yǔ)料的,在統(tǒng)計(jì)學(xué)基礎(chǔ)之上得到對(duì)文本類別具有較大作用的特征項(xiàng),但是在特征選擇過(guò)程中都沒(méi)有考慮非結(jié)構(gòu)化文本數(shù)據(jù)中的潛在主題信息,沒(méi)有從詞語(yǔ)的語(yǔ)義角度對(duì)文本所要選擇的特征進(jìn)行分析,因此在聚類效果上依然不是特別好。

近年來(lái),一些學(xué)者開(kāi)始研究利用LDA進(jìn)行降維并將其應(yīng)用于文本聚類中。鄭誠(chéng)等[6]使用LDA中的主題分布作為特征項(xiàng),由于選取的特征項(xiàng)過(guò)少,在計(jì)算文本相似度時(shí)必然會(huì)丟失大量有效信息,對(duì)文本的區(qū)分力度也明顯不夠。王振振等[7]使用不同主題內(nèi)詞語(yǔ)的分布作為特征項(xiàng),由于未考慮文本-主題之間的關(guān)系,對(duì)文本的區(qū)分度也存在一定影響。針對(duì)上述方法存在的缺陷,本文的特征選擇是基于LDA主題模型,利用建模之后的“主題-詞語(yǔ)”分布和“文本-主題”分布作為特征選擇的結(jié)果,發(fā)掘出文本之中潛在的主題信息,將文本用主題表示,將文本中的詞語(yǔ)映射到主題之中,分別計(jì)算文本在“文本-主題”特征空間和“主題-詞語(yǔ)”特征空間的相似度,然后對(duì)其進(jìn)行線性加權(quán),得到最終的相似度結(jié)果。使用該方法,在文本聚類時(shí)能有效降低文本表示的維度,同時(shí)又能解決同義和多義詞的問(wèn)題。在中英文語(yǔ)料上進(jìn)行的聚類實(shí)驗(yàn)表明,較其他聚類算法,本文所提算法的聚類結(jié)果更好。

1 研究與方法

1.1LDA概率主題模型

主題是一個(gè)較抽象的概念,表達(dá)了文本中的一種潛在主旨,一般采用詞語(yǔ)相應(yīng)于主題的條件概率分布描述。詞語(yǔ)與主題關(guān)系越密切,條件概率就越大,相反的話就越小。概率主題模型通過(guò)統(tǒng)計(jì)文本中詞的概率分布,確定每個(gè)詞語(yǔ)在相應(yīng)主題的概率,最終將文檔表示成不同概率的主題集合。

作為概率主題模型的前身,潛在語(yǔ)義分析(LSA)提出了語(yǔ)義維度,打破了以VSM為主導(dǎo)的單純以詞頻作為文本表示的模式,實(shí)現(xiàn)了文本在低維空間上的隱含語(yǔ)義表示。其通過(guò)奇異值分解(singular value decomposition,SVD)構(gòu)造一個(gè)新的隱形語(yǔ)義空間。它把非結(jié)構(gòu)化的文本量化為將詞語(yǔ)作為向量空間維度中的一個(gè)點(diǎn),假設(shè)在此空間之中的文本都包含特定的語(yǔ)義,且并非無(wú)規(guī)律分布。自然語(yǔ)言的文本是由一個(gè)個(gè)詞語(yǔ)構(gòu)成的,這些詞語(yǔ)又是在相應(yīng)的文本當(dāng)中去理解它們的真實(shí)含義,因此這里體現(xiàn)了一種“詞語(yǔ)-文本”的雙重關(guān)系。但LSA在處理同義詞問(wèn)題上效果仍然不是很理想,且由于SVD的計(jì)算時(shí)間較長(zhǎng),算法效率方面往往無(wú)法保證。另外,在最終的結(jié)果矩陣中存在結(jié)果在很多維度上是負(fù)數(shù),對(duì)此并無(wú)相應(yīng)的物理解釋。20世紀(jì)90年代后期,Hofmann等[8]在LSA的基礎(chǔ)上提出了概率潛在語(yǔ)義分析(probabilistic latent semantic analysis,PLSA)算法,與LSA有著類似的思想,在PLSA模型中同樣也加入了一個(gè)隱含的變量層,但其是以概率的形式來(lái)說(shuō)明LSA的問(wèn)題,大致思想是把文本和詞語(yǔ)同等對(duì)待,將語(yǔ)料庫(kù)中的每一篇文本和詞語(yǔ)映射成一個(gè)維度不高的語(yǔ)義空間中的一個(gè)點(diǎn)。經(jīng)過(guò)這一處理,既可以解決矩陣維度過(guò)高的難題,又可以將文本中詞語(yǔ)和詞語(yǔ)間的內(nèi)在聯(lián)系構(gòu)建出來(lái),而且在該語(yǔ)義空間上幾何距離越接近的詞語(yǔ),它們的語(yǔ)義也就越接近,它在一定程度上可以緩解文本模型中“一詞多義”的問(wèn)題。但PLSA最大的缺點(diǎn)就是其在文本層缺少了數(shù)學(xué)中的概率模型,使得算法過(guò)程中的參數(shù)數(shù)量會(huì)隨著文本數(shù)量的增多而增加,很容易出現(xiàn)過(guò)度擬合的問(wèn)題。Blei等[9]通過(guò)引入狄利克雷先驗(yàn)分布擴(kuò)展了PLSA模型,克服了PLSA在文本表示時(shí)的種種不足,即LDA概率主題模型。

在LDA概率主題模型中,首先需介紹“文本集”、“文本”和“詞語(yǔ)”的概念,以此表示文本類的數(shù)據(jù),其定義如下:

1)詞語(yǔ)數(shù)據(jù)集中的基本單位,可以由數(shù)據(jù)集中的詞表序列{1,2,…,V}選取,用w表示,并且w∈{1,2,…,V}。

2)文本由N個(gè)詞語(yǔ)所構(gòu)成的組合,用w表示,其表達(dá)式是w =(w1,w2,…,wn),這里wn指的是文本之中的第n個(gè)詞語(yǔ)。

3)文本集由M篇文本所構(gòu)成的文本語(yǔ)料庫(kù),這里用D表示,其表達(dá)式是D =(w1,w2,…,wm),其中wm指的是文本集之中的第m篇文本。

LDA的主要思想是把文本集中的每一篇文本表示成主題這一變量的分布,對(duì)于每一個(gè)潛在主題,則利用詞語(yǔ)的概率分布來(lái)表示。這里,Blei有著如下的假設(shè):①狄利克雷分布的維數(shù)和文本集之中主題的數(shù)量一致,這個(gè)K是固定和已知的;②文本中主題與詞語(yǔ)上的概率用參數(shù)矩陣β來(lái)表示,這其中每個(gè)元素代表的是主題zi于詞語(yǔ)wj上的概率(在文中,變量的下標(biāo)表示的是這個(gè)變量在文本集之中的序號(hào),變量的上標(biāo)代表的是這個(gè)變量的取值范圍或值,如這里的zi代表的是主題z的值是i),而且這個(gè)參數(shù)也是固定的。

依據(jù)上面的假設(shè),可以得到文本主題的分布參數(shù)θ、文本d中主題z和Nd個(gè)詞語(yǔ)w在已給定參數(shù)α和β的情況下的聯(lián)合分布概率為

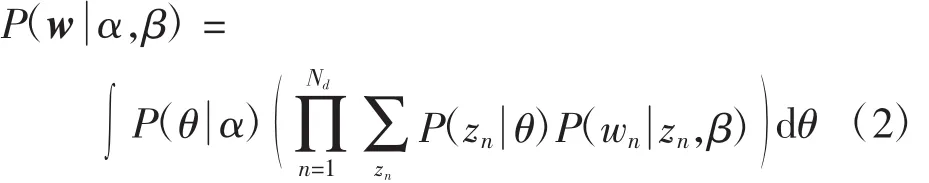

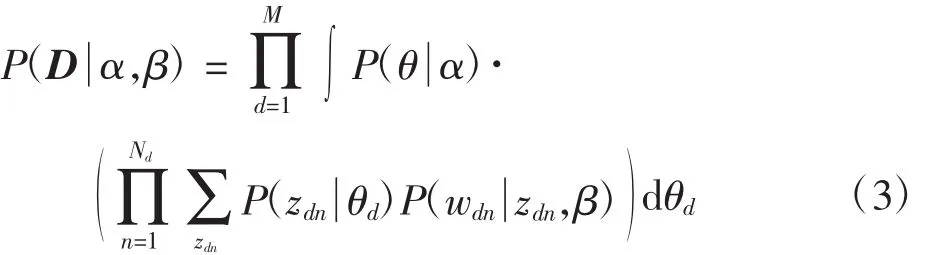

對(duì)式(1)在θ上求積分并且在主題z上求和,可得到邊緣概率分布如下

利用式(2)可求得文本集之中所有文本的邊緣分布概率,進(jìn)而求得文本集D的概率分布為

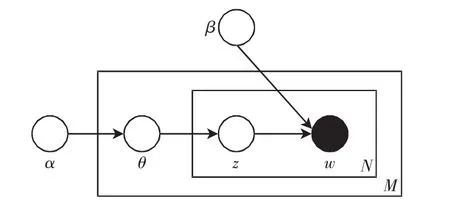

圖1是LDA的概率圖模型,從中可知LDA是一個(gè)三層模型:參數(shù)α和β都是文本集層的參數(shù),只有等所有文本集都生成完成后才會(huì)更新一次;變量θ指的是文本層的變量,當(dāng)每一篇文本生成結(jié)束之后就會(huì)更新;而變量z和w都是詞語(yǔ)層的變量,每個(gè)詞語(yǔ)的生成就表示它們要更新一次。

圖1 LDA概率圖模型Fig.1 Probability graph model of LDA

因?yàn)樯鲜胶卸鄠€(gè)隱變量,直接通過(guò)推導(dǎo)求出會(huì)十分困難,因此需要得到其近似解。本文選用更好的Gibbs抽樣來(lái)求解參數(shù),下面詳細(xì)介紹Gibbs抽樣算法。

1.2Gibbs抽樣

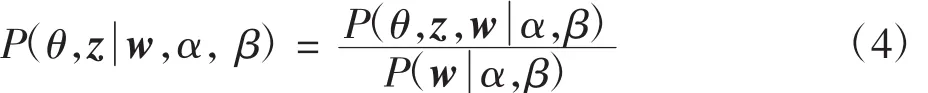

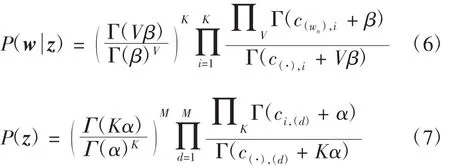

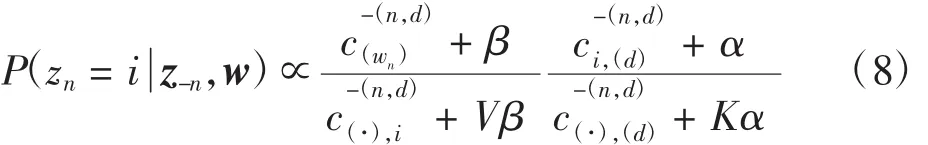

按照Blei在LDA模型中的假設(shè),Dirichlet分布的參數(shù)α和主題分布的參數(shù)β在文本的生成過(guò)程中是固定值,所以針對(duì)某一個(gè)文本d而言,其隱含變量后驗(yàn)概率分布為

在此,按照貝葉斯理論可得到

這里P(z)只與參數(shù)θ相關(guān),而P(w z)只與參數(shù)φ相關(guān),所以在參數(shù)θ和φ上分別積分,得到

其中:c(·),i表示文本中的所有詞語(yǔ)屬于主題i的數(shù)量;表示所有文本集中詞語(yǔ)wn屬于主題i的數(shù)量;c(·),(d)表示當(dāng)前d中全部主題出現(xiàn)的數(shù)量;ci,(d)表示當(dāng)前d中主題i出現(xiàn)的次數(shù)。然而式(4)中的P(α,β)仍然不能求得,它與文本集中全部詞語(yǔ)的主題分布情況相關(guān)。

故可把文本集中的全部詞語(yǔ)視作離散的變量空間,這其中每個(gè)變量的狀態(tài)可從主題集合中選取,進(jìn)而構(gòu)建了馬爾可夫鏈,再依據(jù)P(θ,φw,α,β)對(duì)所有的變量采樣,在馬爾可夫鏈穩(wěn)定后,對(duì)其中的所有變量狀態(tài)進(jìn)行統(tǒng)計(jì),可根據(jù)最終的統(tǒng)計(jì)量來(lái)估計(jì)目標(biāo)概率的分布。

在更新鏈的狀態(tài)時(shí),可以采用Gibbs抽樣方法[10],這里需計(jì)算P(z-n, w)。針對(duì)文本d中的第n個(gè)位置上的詞語(yǔ),其條件概率分布為

其中:i表示主題的編號(hào),i∈{1,2,…,K};統(tǒng)計(jì)量c的下標(biāo)表示此統(tǒng)計(jì)量之中樣本的條件,上標(biāo)指的是此統(tǒng)計(jì)量之中樣本的范圍;(·)代表在對(duì)應(yīng)維度上的元素全集;-(x)表示在對(duì)應(yīng)維度上取x的補(bǔ)集,所以這里的表示除了第d篇文本之中第n個(gè)位置的詞語(yǔ)所屬于的主題之外,文本集中剩余詞語(yǔ)被賦予主題i的數(shù)量,其余統(tǒng)計(jì)量的定義與此類似。這里,式(8)的前半部分表示的是詞語(yǔ)wn從屬于主題i的概率,后半部分表示的是文本d中主題i的概率。這兩部分分別對(duì)應(yīng)于本文所論述的“主題-詞語(yǔ)”分布和“文本-主題”分布。

詳細(xì)采樣過(guò)程如下:

2)按照均勻分布,在[0,1]之中隨機(jī)選取一個(gè)值P 且0<P≤1;

3)按照P在P(i)上屬于的變量值當(dāng)做新的主題。

而Gibbs采樣的更新步驟如下:

1)初始化馬爾可夫鏈的初始狀態(tài)zi,其取值范圍是{1,2,…,K};

2)按照式(8)的概率分布更新所有zi;

3)多次迭代后,當(dāng)馬氏鏈穩(wěn)定之后,這時(shí)的目標(biāo)分布達(dá)到收斂,此刻zi的取值就是最終分布的隨機(jī)變量的樣本。

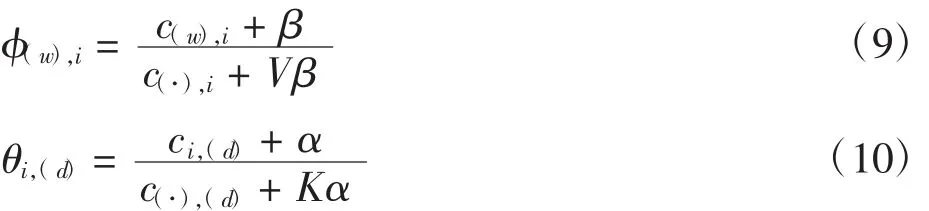

利用這時(shí)的zi估算LDA中的參數(shù),其表達(dá)式為

通過(guò)這些參數(shù),可以預(yù)測(cè)新文本中詞語(yǔ)w在已有w和z的前提下對(duì)應(yīng)的主題z和它的后驗(yàn)分布。

1.3加權(quán)LDA的文本建模

1.3.1語(yǔ)料選擇

為驗(yàn)證算法的有效性,本文分別在中文和英文語(yǔ)料集合上對(duì)算法進(jìn)行了試驗(yàn)。其中,英文語(yǔ)料使用的是20-News-Group語(yǔ)料庫(kù),特別選取了其中的10個(gè)類:comp.graphics,comp.sys.ibm.pc.hardware,motorcycles,rec.sport.baseball,rec.sport.hockey,sci.electronics,sci. med,sci.space,soc.religion,talk.politics.guns。每個(gè)子類分別取500篇文檔,共5 000篇。中文語(yǔ)料使用的是復(fù)旦大學(xué)中文語(yǔ)料庫(kù),選取了其中的10個(gè)子類:Agriculture,History,Space,Sports,Politics,Environment,Economy,Computer,Education,Law。每個(gè)子類選取了100篇文本,一共1 000篇。

1.3.2LDA主題數(shù)的選擇

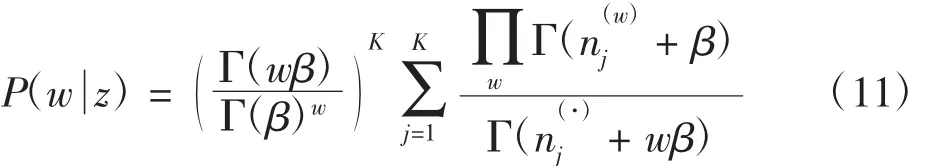

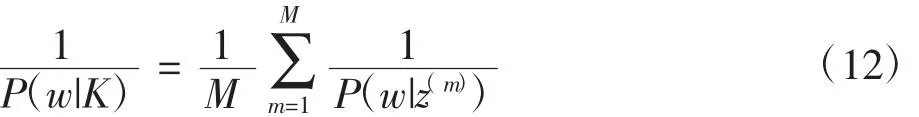

主題數(shù)目K的確定對(duì)于LDA模型的準(zhǔn)確率至關(guān)重要。通過(guò)LDA的建模過(guò)程可知,多項(xiàng)分布θ和φ的狄利克雷先驗(yàn)分布的參數(shù)分別對(duì)應(yīng)于α和β,通過(guò)其自然共軛的性質(zhì),P(w,z)的值可以通過(guò)對(duì)θ和φ積分計(jì)算得到。P(w,z)= P(w|z)P(z),并且φ和θ單獨(dú)出現(xiàn)于第一項(xiàng)和第二項(xiàng),對(duì)φ積分獲得第一項(xiàng)值為[11]

其中,M為Gibbs抽樣算法迭代次數(shù)。

1.3.3文本相似度計(jì)算

LDA主題模型是在統(tǒng)計(jì)學(xué)基礎(chǔ)上,通過(guò)文檔集的潛在信息,將文檔映射到基于隱含主題的特征空間上,并且將主題映射到詞語(yǔ)的特征空間上。VSM模型首先是基于詞頻統(tǒng)計(jì)的理論,利用文本中詞語(yǔ)的TFIDF值在向量維度上對(duì)2篇文本進(jìn)行相似度計(jì)算。TFIDF思想中的IDF理論從本質(zhì)上來(lái)講是一種有效的在文本表層知識(shí)方面抑制噪聲的加權(quán)處理方法,雖然在相似度計(jì)算上可以取得不錯(cuò)的效果,但同時(shí)由于只是在詞表層方面對(duì)文本進(jìn)行探究,必然會(huì)丟失掉大量文本的深層語(yǔ)義信息。另一方面,利用LDA主題模型挖掘得到文本內(nèi)部的潛在主題知識(shí),在一定程度上彌補(bǔ)了前者在相似度計(jì)算方面的不足,但由于文本映射到主題空間的維度相對(duì)較低,導(dǎo)致在計(jì)算時(shí)文本信息的完整性很難保證,進(jìn)而對(duì)于文本類別的區(qū)分能力顯得不夠。所以,本文把以上二者進(jìn)行有機(jī)結(jié)合,在文本詞語(yǔ)和潛在主題兩個(gè)不同層次計(jì)算文本之間的相似度。由于考慮了各自模型的優(yōu)勢(shì),彌補(bǔ)兩者的不足之處,進(jìn)而保證了最終文本聚類的質(zhì)量。

在主題-詞語(yǔ)這個(gè)特征空間上,對(duì)每一個(gè)主題選擇前N(本文實(shí)驗(yàn)取N=100)個(gè)特征詞,計(jì)算每一個(gè)特征詞在整個(gè)文檔集中的TF-IDF權(quán)重,再結(jié)合文檔-主題這個(gè)特征空間,利用線性加權(quán)求和的方法,將其進(jìn)行結(jié)合,從而有效地提高計(jì)算文本相似度的質(zhì)量。

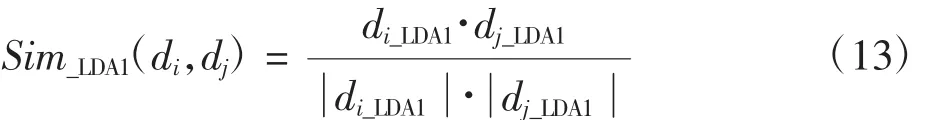

文檔di在主題-詞特征空間上的向量可表示為di_LDA1=(w1,w2,…,wn),其中n為從所有K個(gè)主題中所選擇的詞匯數(shù)量。則文本di、dj基于主題-詞特征空間的余弦相似度為

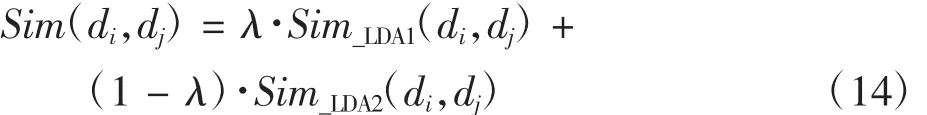

文檔di在文本-主題特征空間上的向量可表示為di_LDA2=(z1,z2,…,zK),其中K表示主題的個(gè)數(shù)。則文本之間基于文本-主題特征空間的余弦相似度為Sim_LDA2(di,dj)。本文將這兩種相似度進(jìn)行線性融合,計(jì)算公式為

其中λ∈(0,1)為線性參數(shù),表示主題-詞模型和文檔-主題模型按一定比例的加權(quán)求和。

2 結(jié)果與分析

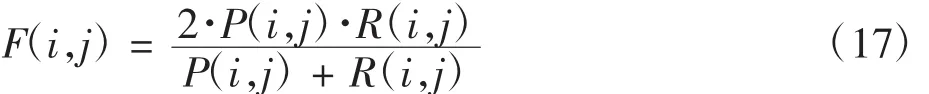

本文選用經(jīng)典的K-means聚類算法,用F值來(lái)作為最終實(shí)驗(yàn)好壞的評(píng)價(jià)指標(biāo)。F度量值是將實(shí)驗(yàn)的準(zhǔn)確率和召回率聯(lián)合起來(lái)對(duì)實(shí)驗(yàn)結(jié)果進(jìn)行評(píng)估的綜合性指標(biāo)。其中,準(zhǔn)確率P(i,j)和召回率R(i,j)可分別定義為

其中:nij是聚類j中隸屬于類別i的文本數(shù)目;ni是類別i的文本數(shù)目。對(duì)應(yīng)的F度量值定義為

全局聚類的F度量值定義為

2.1實(shí)驗(yàn)步驟

在對(duì)文本進(jìn)行LDA建模前,先要對(duì)語(yǔ)料庫(kù)中的文本進(jìn)行相應(yīng)的處理,這里包括去停用詞以及對(duì)于中文語(yǔ)料的分詞,進(jìn)而將文本表示為詞向量的形式。由于LDA主題模型使用的是詞袋模型,因此在對(duì)中文語(yǔ)料進(jìn)行分詞操作之后,中英文語(yǔ)料的建模過(guò)程是基本相同的。在建模過(guò)程中,使用Gibbs抽樣算法得到實(shí)驗(yàn)過(guò)程中需要的參數(shù),具體設(shè)置為α= K/50、β=0.01,Gibbs抽樣次數(shù)為2 000。實(shí)驗(yàn)中的λ值依次從0.01取到0.99,經(jīng)過(guò)多次實(shí)驗(yàn),當(dāng)λ為0.85時(shí)聚類質(zhì)量最高。通過(guò)實(shí)驗(yàn)研究了主題數(shù)目K對(duì)Gibbs抽樣算法的影響。當(dāng)K取不同值時(shí)分別運(yùn)行Gibbs抽樣算法,觀察-logP(w|K)值的變化。在英文語(yǔ)料上的實(shí)驗(yàn)結(jié)果如圖2所示。

圖2 英文語(yǔ)料-logP(w|K)與K的關(guān)系圖Fig.2 Relationship of topic number K and -logP(w|K)

由圖2可以看出,對(duì)于20-News-Group英文語(yǔ)料,K值取50的時(shí)候,-logP(w|K)的值最大,證明這時(shí)文本集中對(duì)于信息的有效程度擬合達(dá)到最優(yōu)。同理,經(jīng)過(guò)實(shí)驗(yàn)得知復(fù)旦大學(xué)中文語(yǔ)料當(dāng)主題數(shù)K取80的時(shí)候-logP(w|K)的值最大。因此后續(xù)實(shí)驗(yàn)英文語(yǔ)料和中文語(yǔ)料主題數(shù)K的值分別取50和80。

2.2實(shí)驗(yàn)結(jié)果及分析

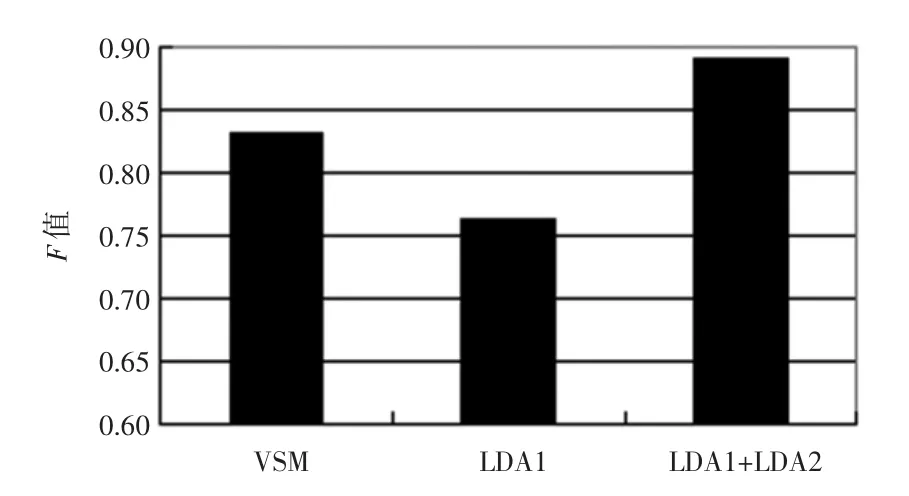

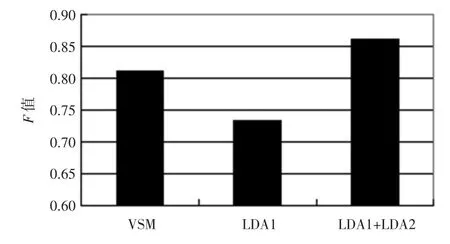

當(dāng)確定最優(yōu)主題數(shù)后就利用LDA模型對(duì)文本進(jìn)行聚類。實(shí)驗(yàn)結(jié)果如圖3和圖4所示。

圖3 20-News-Group英文語(yǔ)料基于平均F值的比較結(jié)果Fig.3 20-News-Group English corpora comparison based on average value F

圖4 復(fù)旦大學(xué)中文語(yǔ)料基于平均F值的比較結(jié)果Fig.4 Fudan University Chinese corpora comparison based on average value F

圖中的VSM指將文本集中所有不同詞語(yǔ)作為特征時(shí)的文本聚類結(jié)果;LDA1指僅利用文本-主題這一特征空間作為特征項(xiàng)時(shí)的聚類結(jié)果;LDA1+LDA2指將文本-主題和主題-詞語(yǔ)這2個(gè)特征空間聯(lián)合起來(lái)作為特征項(xiàng)時(shí)進(jìn)行的文本聚類的結(jié)果。

從圖中可以看出,單獨(dú)使用文本-主題特征空間進(jìn)行聚類效果很差,這是因?yàn)镵比較小,選取的特征值數(shù)量不夠。而將文本-主題和主題-詞這兩個(gè)特征空間聯(lián)合起來(lái)作為進(jìn)行聚類卻可以明顯地提高F值,比單獨(dú)使用VSM結(jié)合K-means提高了近5%,獲得了較好的聚類效果。

3 結(jié)語(yǔ)

通過(guò)將LDA主題模型與傳統(tǒng)的文本聚類方法有效結(jié)合,在原來(lái)單純的以詞頻為基礎(chǔ)的空間向量模型中加入了文本的深層次語(yǔ)義知識(shí),利用本文方法具有以下優(yōu)點(diǎn):

1)可以明顯地提高文本相似度的計(jì)算準(zhǔn)確性。

2)本文通過(guò)LDA對(duì)文本進(jìn)行建模,使文本映射到“文本-主題”和“主題-詞語(yǔ)”這2個(gè)特征空間中,一方面增強(qiáng)了向量表示文本的語(yǔ)義含義,另一方面大大縮小了文本表示的向量維度。

3)由于在文本聚類時(shí)加入了文本的潛在主題,使聚類效果有了明顯的提高。

4)中英文語(yǔ)料庫(kù)的對(duì)比聚類實(shí)驗(yàn)證明,本文算法結(jié)果要好于單純使用VSM模型的聚類結(jié)果。

參考文獻(xiàn):

[1]唐果.基于語(yǔ)義領(lǐng)域向量空間模型的文本相似度計(jì)算[D].昆明:云南大學(xué),2013.

[2]孫昌年,鄭誠(chéng),夏青松.基于LDA的中文文本相似度計(jì)算[J].計(jì)算機(jī)技術(shù)與發(fā)展,2013(1):217-220.

[3]DEERWESTER S,DUMAIS STA. Indexing by latent semantic analysis [J].Journalofthe Societyfor Information Science,1990,41(6):391-407.

[4]高茂庭,王正歐.幾種文本特征降維方法的比較分析[J].計(jì)算機(jī)工程與應(yīng)用,2011,42(30):157-159.

[5]王剛,邱玉輝,蒲國(guó)林.一個(gè)基于語(yǔ)義元的相似度計(jì)算方法研究[J].計(jì)算機(jī)應(yīng)用研究,2008(11):3253-3255.

[6]鄭誠(chéng),李鴻.基于主題模型的K-均值文本聚類[J].計(jì)算機(jī)與現(xiàn)代化,2013(8):78-80,84.

[7]王振振,何明,杜永萍,等.基于LDA主題模型的文本相似度計(jì)算[J].計(jì)算機(jī)科學(xué),2013,40(12):229-232.

[8]HOFMANN T. Unsupervised learning by probabilistic latent semantic analysis[J].Machine Learning,2001,42(1):177-196.

[9]BLEI D,NG A,JORDAN M. Latent dirichlet allocation[J].Journal of Machine Learning Research,2003(3):993-1022.

[10]GRIFFITHS T L,STEYVERS M. Finding scientific topics[J]. PNAS,2004,101(1):1137-1145.

[11]石晶,胡明,石鑫,等.基于LDA模型的文本分割[J].計(jì)算機(jī)學(xué)報(bào),2008,31(10):1865-1873.

(責(zé)任編輯:楊媛媛)

Text clustering method based on weighted LDA model

LI Guoa,b,ZHANG Chunjiea,b,ZHANG Zhiyuana,b

(a. College of Computer Science and Technology;b. Airport Engineering Research Base,CAUC,Tianjin 300300,China)

Abstract:In order to overcome the shortcomings and limitations of traditional clutering algorithms in dealing with largescale and high dimension text clustering,a text clustering method is presented based on weighted LDA(latent dirichlet allocation)model. Two distributions are obtained by LDA: the topic distribution and the word distribution of different topics hidden in the text,which are then combined as the text feature to obtain the final text similarity. Using the classic K-Means algorithm in both English and Chinese corpus,the experimental results show that compared with the pure VSM combined with K-Means,this algorithm has better clustering effect.

Key words:LDA;vector space model;data mining;text clustering;K-Means

中圖分類號(hào):TP18

文獻(xiàn)標(biāo)志碼:A

文章編號(hào):1674-5590(2016)02-0046-06

收稿日期:2015-04-01;修回日期:2015-04-23基金項(xiàng)目:國(guó)家自然科學(xué)基金項(xiàng)目(61201414,61301245,U1233113)

作者簡(jiǎn)介:李國(guó)(1966—),男,河南新鄉(xiāng)人,教授,博士,研究方向?yàn)橹悄苄畔⑻幚?

中國(guó)民航大學(xué)學(xué)報(bào)2016年2期

中國(guó)民航大學(xué)學(xué)報(bào)2016年2期

- 中國(guó)民航大學(xué)學(xué)報(bào)的其它文章

- Lipschitz連續(xù)強(qiáng)單調(diào)逆變分不等式的迭代算法

- 基于AHP-BP神經(jīng)網(wǎng)絡(luò)的航空材料供應(yīng)商選擇

- 影響航空公司客流分擔(dān)率的服務(wù)屬性因素分析

——以京滬快線為例 - 復(fù)合材料雷擊損傷熱電耦合數(shù)值仿真分析

- 機(jī)場(chǎng)道面平整度評(píng)價(jià)技術(shù)進(jìn)展及發(fā)展方向

- 低功耗無(wú)線傳感器網(wǎng)絡(luò)節(jié)點(diǎn)的實(shí)現(xiàn)與壽命評(píng)估