基于感知器的中文分詞增量訓練方法研究

韓 冰,劉一佳,車萬翔,劉 挺

(哈爾濱工業大學 計算機學院社會計算與信息檢索研究中心,黑龍江 哈爾濱 150001)

?

基于感知器的中文分詞增量訓練方法研究

韓 冰,劉一佳,車萬翔,劉 挺

(哈爾濱工業大學 計算機學院社會計算與信息檢索研究中心,黑龍江 哈爾濱 150001)

該文提出了一種基于感知器的中文分詞增量訓練方法。該方法可在訓練好的模型基礎上添加目標領域標注數據繼續訓練,解決了大規模切分數據難于共享,源領域與目標領域數據混合需要重新訓練等問題。實驗表明,增量訓練可以有效提升領域適應性,達到與傳統數據混合相類似的效果。同時該文方法模型占用空間小,訓練時間短,可以快速訓練獲得目標領域的模型。

中文分詞;領域適應;增量訓練

1 引言

詞是漢語中的最小語義單元。由于漢語以字為基本書寫單位,詞與詞之間沒有明顯的分割標記,中文分詞成為中文信息處理的基礎與關鍵,在信息檢索、文本挖掘等任務中被廣泛使用。近年來,基于統計的中文分詞方法在新聞領域取得了很好的性能[1-4]。但隨著互聯網、社交媒體與移動平臺的迅猛發展,當前中文分詞方法處理的數據不單局限于新聞領域,不斷增長的開放領域數據對中文分詞方法提出了新的挑戰。前人研究[5-7]表明,使用新聞領域資料訓練的中文分詞模型切換到諸如論壇、微博、小說等領域時,性能往往嚴重下降。

前人工作[6]將這種訓練與測試領域的不一致導致模型性能下降的問題歸納為領域適應問題。在使用新聞領域訓練的分詞模型處理開放領域時,新聞領域為源領域,開放領域為目標領域。出現這種問題主要有兩點原因: 一是不同領域數據文體不一致,例如,小說與新聞使用不同的語言風格;二是不同領域間領域詞典不一致,例如,金融領域經常使用“做空”“配資”等新聞領域不常用的詞匯。Liu和Zhang[6]通過在分詞詞性標注聯合模型上加入聚類特征的方式捕捉源領域與目標領域的相似性,以解決文體差異過大問題。Zhang等[5]將目標領域詞典融入模型,避免了源領域與目標領域詞典差異過大。Liu等[7]提出了一種利用網絡文本中自然存在的分詞邊界的方法,在基于條件隨機場(CRF)模型的分詞系統上提高了領域適應性。

上述研究表明,使用目標領域切分數據訓練模型是一種領域適應問題的高精度方法。同時,在源領域切分數據的基礎上加入目標領域數據這類混合訓練數據的方法可以進一步提高切分中文分詞準確率[5,7-8]。然而,多方面因素限制了這一類方法的適用性。其一,大規模切分數據往往很難獲得,使得混合訓練數據的方法難以應用于實際場景;其二,針對每個目標領域,混合數據方法都需要在包含源領域的大規模數據上重新訓練模型,使得這種方法很難快速獲得模型并部署。

針對上述問題,本文提出一種了基于感知器的中文分詞增量訓練方法。該方法通過在已有模型的基礎上繼續訓練,可以在不需要源領域切分數據的情況下,利用少量目標領域標注數據獲得與混合模型相近的性能。同時本文針對增量訓練提出了一種優化的實現方法,顯著降低了訓練代價。本文分詞器將在https://github.com/HIT-SCIR/ltp開源。

2 問題描述

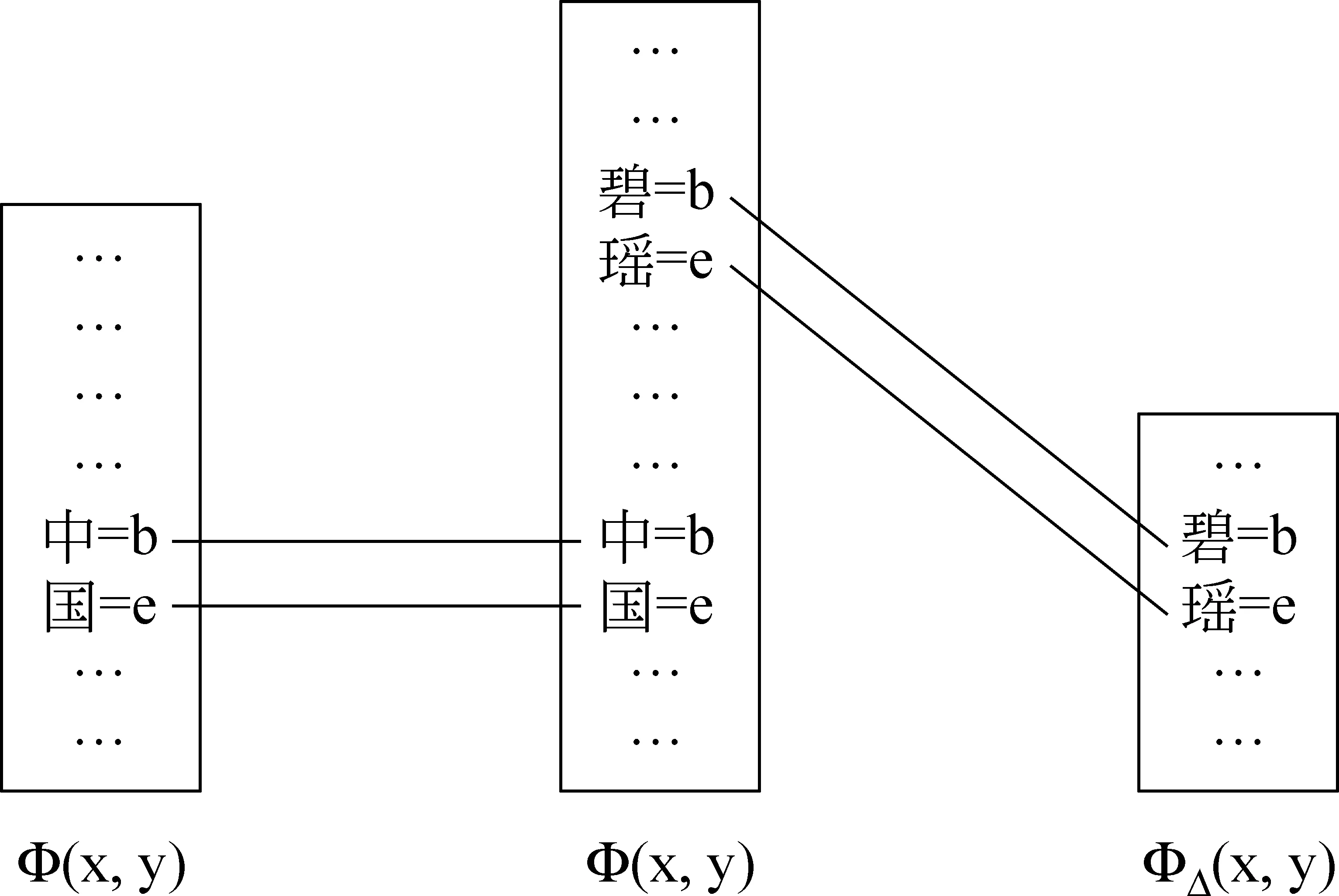

本文主要解決多領域應用場景下的中文分詞領域適應問題(圖1)。本文假設源領域數據在訓練領域適應模型時對用戶不可見,但源領域模型可見。本文同時假設用戶有少量目標領域標注數據。最后,本文假設源領域模型同時服務于多個目標領域。

圖1 多領域應用場景示意圖

針對以上問題描述,本文訓練算法應具有下述特點:

? 不更改源領域模型;

? 目標領域模型與混合數據訓練的模型性能相近;

? 目標領域模型精簡。

3 基于感知器的中文分詞

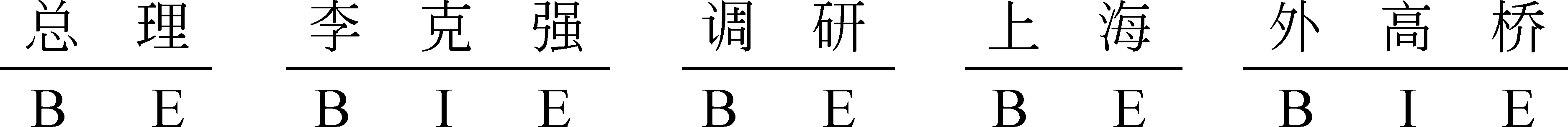

本文參照前人工作[3,9],將中文分詞建模為基于字的序列標注問題。模型給句子中的每個字標注一個表示詞邊界的標記。本文采用了{B、I、E、S}四種標記,其中B代表詞語的開始,I代表詞語的中間,E代表詞語的結尾,S代表單個字詞語。以“總理李克強調研上海外高橋”為例,標注結果如圖2所示。

圖2 分詞序列標注示例

本文采用結構化感知器模型(Structured Perceptron[10])訓練。為了防止模型過擬合,采用平均感知器算法對訓練過程中的參數求平均。基于感知器的中文分詞訓練算法如算法1所示。

算法1 平均感知器模型訓練算法1:輸入:D={(x,y)}N2:w←03:fort=1…Tdo4: forxi,yi()∈Ddo5: z=argmaxy'∈GEN(xi)(φ(xi,y')·w)6: ifz≠ythen w←w+φxi,yi()-φ(xi,z)8: endif9: endfor10:endfor11:w-=1NT∑n=1..N,t=1..Twn,t12:returnw-

4 平均感知器增量訓練算法

為了解決重復訓練,領域數據快速更迭等問題,本文在結構化感知器中文分詞的基礎上提出一種增量式訓練算法。

4.1 算法

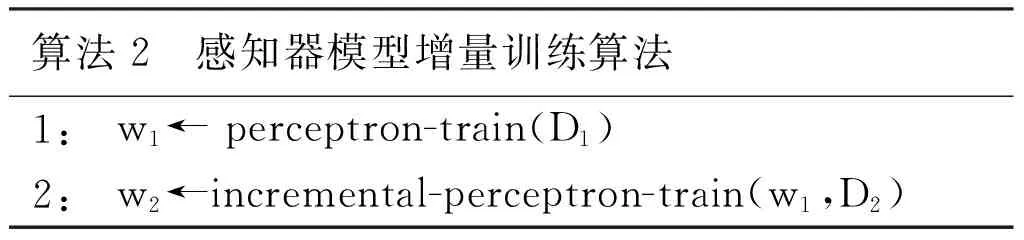

本文方法可以歸納為在已有感知器分詞模型基礎之上繼續訓練。增量式訓練算法包含兩個階段: 第一階段的訓練算法與傳統感知器算法相同,用數據集D1訓練得到模型w1;第二階段,用數據集D2和模型w1訓練模型得到模型w2(如算法2所示)。

算法2 感知器模型增量訓練算法1:w1←perceptron-train(D1)2:w2←incremental-perceptron-train(w1,D2)

在實際應用情景中,D1是相對豐富且不同于目標領域的標注數據,例如新聞領域數據;D2是目標領域(如財經、小說等)的相對較少的標注數據。第二階段的訓練算法,以模型w1和目標領域數據D2為輸入。設D1有N1條數據,第一階段迭代訓練T1次,第二階段同理,wn,t表示在第t輪更新第n個數據時的參數向量,則第二階段的平均參數為式(1)。

(1)

4.2 增量訓練收斂性的證明

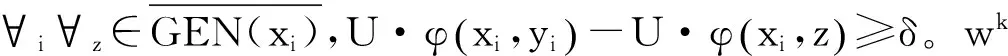

Collins等人[10]證明了結構化感知器算法的收斂性。本文提出了一種增量訓練算法,需要回答“增量訓練算法能否在D2數據上有限步驟內收斂”,亦即證明其收斂性。由于增量訓練采用第一階段的模型參數做為初始參數值,增量訓練的收斂性證明問題等價于證明感知器算法在初始權重w1≠0時的收斂性。本文沿用Collins等人[10]的證明方法,在這一段證明增量訓練算法在D2線性可分的情況下收斂。

定理: 增量訓練算法在D2線性可分情況下收斂。

同理可證線性不可分的情況下增量訓練依舊收斂,限于篇幅限制該證明省略。

4.3 優化的增量訓練實現方法

在上述增量訓練算法中,第二階段先復制創建一個與w1一樣的模型,并在此基礎上增添訓練語料D2迭代更新參數,最終輸出一個新的模型w2。然而,第二階段僅更新了在D2語料中出現的特征對應的參數,完全復制一份w1在空間上是十分低效的。為此本文提出了一種更高效的實現方法。在第二階段,方法創建一個新的模型wΔ來記錄原始第二階段訓練的參數改變量,新模型wΔ的工作依賴于w1。原始領域特征空間、混合訓練特空間與增量訓練特空間如圖3所示。由于第二階段僅更新了D2中出現的參數,因此增量模型wΔ只需記錄與D2相關的參數,大大縮小了空間。優化后的增量訓練第二階段算法如算法3所示。

圖3 特征空間對比圖

算法3 優化增量訓練第二階段算法1:輸入:D2={(x,y)}N2,w12:fort=T1+1…T2do3: forxi,yi()∈D2do4: z=argmaxy'∈GENxi()(φ(xi,y')·w+φΔ(xi,y')·wΔ)5: ifz≠ythen6: wΔ←wΔ+φΔxi,yi()-φΔ(xi,z)7: endif8: endfor9:endfor10:wΔ=1N1T1+N2T2?è?∑n=1..N1,t=1..T1wn,t+∑n=1..N2,t=T1.T1+T2.wn,t??÷11:returnwΔ

5 實驗

5.1 實驗設置

本文在CTB5.0和誅仙網絡小說數據上進行試驗。CTB5.0數據劃分參照前人工作[11],用于訓練第一階段模型。誅仙小說數據劃分參照Zhang等[5],訓練集用于訓練第二階段模型,測試集用于評價模型性能。為了模擬不同訓練數據規模下算法的性能,隨機選取500句誅仙訓練數據作為小規模訓練集,并用全部訓練數據作為大規模數據。

在基于字的分詞模型的特征方面,本文參考張梅山等[12]的論文,并從一定程度上簡化了其中的詞典特征。本文的分詞器使用的特征列表如表1所示。

表1 分詞器使用的特征

其中,下標i代表特征模板中的字與待標注字的相對位置。dup(x,y)表示x,y是否為相同字,chartype(c)表示c的字類型,字類型包括字母(例如,“A”),數字(例如,“1”)以及標點(例如,“,”)。本文使用的詞典特征主要有三類,match_prefix(c0,D)表示以c0為詞首的句子片段在詞典D中匹配的最長的詞,match_mid(c0,D)表示以c0為詞中而match_suffix(c0,D)表示以c0為詞尾。本文使用的詞典通過訓練語料構造。構造方法是抽取訓練語料中出現的頻率大于等于5的詞以及其詞性構成詞典。

5.2 增量訓練實驗

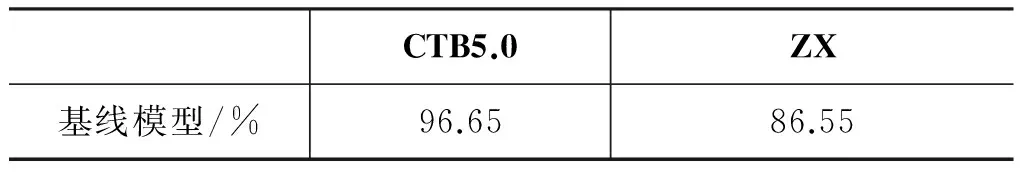

本文基線系統是使用CTB5.0訓練數據訓練的基于字的感知器中文分詞模型,表2顯示了基線模型的實驗結果。本文分別在新聞(CTB5.0)和誅仙(ZX)測試集上評價基線模型性能。在與訓練數據同源的新聞(CTB5.0)測試集上,基線模型的F值為96.65%,而在誅仙測試集上,F值降到86.55%。這說明單獨由新聞領域數據訓練的模型在誅仙數據集上存在領域適應問題。

表2 基線分詞模型實驗結果

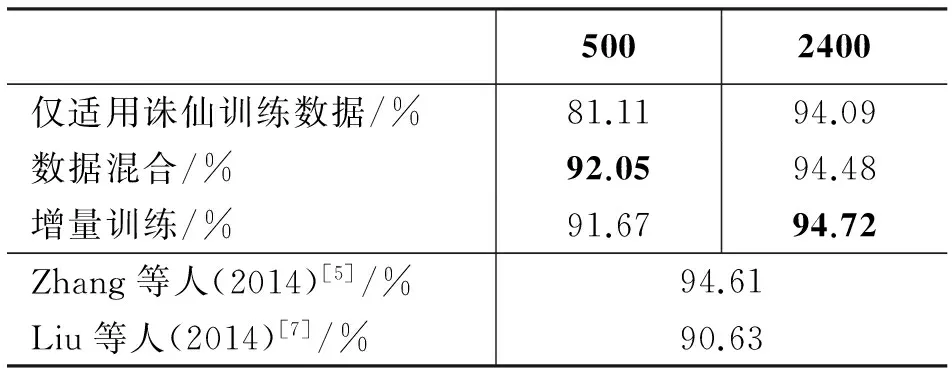

為模擬不同規模目標領域的情況,本文分別采用隨機選取的500句和2 400句誅仙領域語料作為目標領域的訓練數據。表3顯示了不同方法利用兩種規模訓練數據訓練的模型在誅仙測試集上的性能。第一行表示僅使用誅仙訓練數據訓練模型的情況下模型的性能;第二行表示使用新聞語料和誅仙語料混合訓練獲得的模型在誅仙領域上的性能;第三行表示使用本文提出的增量訓練方法訓練獲得的模型的性能。

表3 增量訓練實驗結果

通過對比表3第一行和第二行結果,可以得出結論: 對于數據規模較小的領域,單獨使用小規模數據并不能獲得性能令人滿意的模型。通過對比表3第二行和第三行結果,F值在小規模訓練集上下降0.39%,在大規模數據集上提升了0.24%,結果表明二者性能相近。

本文也將實驗結果與相同數據集上的前人工作進行了對比。本文提出的增量訓練方法在2 400句訓練數據條件下,較Zhang等人[5]提出的當前準確率最好的模型獲得了微小的提升。但由于Zhang等人使用的模型是分詞詞性標注聯合模型,同時使用了詞典以及自學習等策略。兩者不具備直接考可比性。

5.3 實驗分析

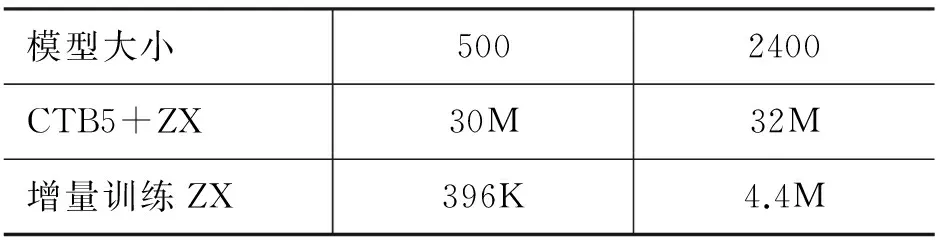

在關注增量訓練準確率的同時,模型大小以及模型訓練時間也是本文關注的一個方面。本文經驗性地比較了增量訓練與傳統混合訓練的模型大小(表4)。從表4可以看出,本文提出的優化實現方法可以顯著減少模型大小。

表4 不同實現方法的模型大小

同時,本文比較了增量訓練與混合數據方式訓練的時間開銷。在開發集上,本文將不同數據規模下增量訓練的時間收斂曲線如圖4所示。在小規模訓練集上,增量訓練相對于傳統訓練迅速達到最優結果。在大規模訓練集上,二者趨于一致。

圖4 訓練時間效率對比圖左圖為500句訓練集的,右圖為2 400句訓練集,圖中橫軸代表訓練時間,單位為秒,縱軸為開發集上的F值

上述實驗表明,增量訓練算法可以有效解決領域適應問題,通過在增量訓練第二階段添加目標領域語料,能有效提高在目標領域的性能。增量訓練相對于傳統混合訓練方式,在準確性上基本持平,而在空間效率和時間效率上具有明顯優勢。

6 結論

針對領域適應問題,本文提出了一種增量訓練算法來解決增加目標領域數據方面的限制。我們證明了增量訓練算法可以在目標領域訓練數據收斂。實驗表明,通過在增量訓練第二階段添加目標領域訓練語料,可以有效提升目標領域分詞效果,并且增量訓練算法模型占用的空間小,訓練速度更快。

[1] XUE N, SHEN L. Chinese word segmentation as LMR tagging[C]//Proceedings of the second SIGHAN workshop on Chinese language processing. 2003, 17: 176-179.

[2] ZHANG Y, CLARK S. Chinese Segmentation with a Word-Based Perceptron Algorithm[C]//Proceedings of the 45th Annual Meeting of the Association of Computational Linguistics. 2007: 840-847.

[3] SHI Y, WANG M. A dual-layer CRFs based joint decoding method for cascaded segmentation and labeling tasks[C]//Proceedings of IJCAI. 2007, 7: 1707-1712.

[4] SUN W. Word-based and Character-based Word Segmentation Models: Comparison and Combination[C]//Proceedings of the COLING 2010: Posters. 2010: 1211-1219.

[5] ZHANG M, ZHANG Y, CHE W,et al. Type-Supervised Domain Adaptation for Joint Segmentation and POS-Tagging[C]//Proceedings of the 14th Conference of the European Chapter of the Association for Computational Linguistics. 2014: 588-597.

[6] LIU Y, ZHANG Y. Unsupervised Domain Adaptation for Joint Segmentation and POS-Tagging[C]//Proceedings of COLING 2012: Posters. 2012: 745-754.

[7] LIU Y, ZHANG Y, CHE W, et al. Domain Adaptation for CRF-based Chinese Word Segmentation using Free Annotations[C]//Proceedings of the 2014 Conference on Empirical Methods in Natural Language Processing (EMNLP). 2014: 864-874.

[8] LIU Y, ZHANG M, CHE W, et al. Micro blogs Oriented Word Segmentation System[C]//Proceedings of the Second CIPS-SIGHAN Joint Conference on Chinese Language Processing. 2012: 85-89.

[9] XUE N. Chinese word segmentation as character tagging[J]. Computational Linguistics and Chinese Language Processing, 2003, 8(1): 29-48.

[10] COLLINS M. Discriminative Training Methods for Hidden Markov Models: Theory and experiments with perceptron algorithms[C]//Proceedings of the ACL-02 conference on Empirical methods in natural language processing-Volume 10. 2002: 1-8.

[11] SUN W, XU J. Enhancing Chinese word segmentation using unlabeled data[C]//Proceedings of the Conference on Empirical Methods in Natural Language Processing. 2011: 970-979.

[12] 張梅山, 鄧知龍, 車萬翔,等. 統計與詞典相結合的領域自適應中文分詞[J]. 中文信息學報, 2010, 26(2): 8-12.

An Incremental Learning Scheme for Perceptron Based Chinese Word Segmentation

HAN Bing, LIU Yijia, CHE Wanxiang, LIU Ting

(Research Center for Social Computing and Information Retrieval,Harbin Institute of Technology, Harbin, Hei Longjiang 150001, China)

In this paper, we propose an incremental learning scheme for perceptron based Chinese word segmentation. Our method can perform continuous training over a fine tuned source domain model, enabling to deliver model without annotated data and re-training. Experimental results shows the scheme proposed can significantly improve adaptation performance on Chinese word segmentation and achieve comparable performance with traditional method. At the same time, our method can significantly reduce the model size and the training time.

Chinese word segmentation; domain adaptation; incremental learning

韓冰(1990—),碩士研究生,主要研究領域為自然語言處理。E-mail:bhan@ir.hit.edu.cn劉一佳(1988—),博士研究生,主要研究領域為自然語言處理。E-mail:yjliu@ir.hit.edu.cn車萬翔(1980—),副教授,主要研究領域為自然語言處理。E-mail:car@ir.hit.edu.cn

1003-0077(2015)05-0049-06

2015-07-26 定稿日期: 2015-09-16

TP391

A