利用詞的分布式表示改進作文跑題檢測

陳志鵬,陳文亮,朱慕華

(1. 蘇州大學 計算機科學與技術學院,江蘇 蘇州 215006;2. 軟件新技術與產(chǎn)業(yè)化協(xié)同創(chuàng)新中心,江蘇 蘇州 215006;3. 淘寶(中國)軟件有限公司,浙江 杭州 311100)

?

利用詞的分布式表示改進作文跑題檢測

陳志鵬1,2,陳文亮1,2,朱慕華3

(1. 蘇州大學 計算機科學與技術學院,江蘇 蘇州 215006;2. 軟件新技術與產(chǎn)業(yè)化協(xié)同創(chuàng)新中心,江蘇 蘇州 215006;3. 淘寶(中國)軟件有限公司,浙江 杭州 311100)

作文跑題檢測任務的核心問題是文本相似度計算。傳統(tǒng)的文本相似度計算方法一般基于向量空間模型,即把文本表示成高維向量,再計算文本之間的相似度。這種方法只考慮文本中出現(xiàn)的詞項(詞袋模型),而沒有利用詞項的語義信息。該文提出一種新的文本相似度計算方法:基于詞擴展的文本相似度計算方法,將詞袋模型(Bag-of-Words)方法與詞的分布式表示相結(jié)合,在詞的分布式表示向量空間中尋找與文本出現(xiàn)的詞項語義上相似的詞加入到文本表示中,實現(xiàn)文本中單詞的擴展。然后對擴展后的文本計算相似度。該文將這種方法運用到英文作文的跑題檢測中,構(gòu)建一套跑題檢測系統(tǒng),并在一個真實數(shù)據(jù)中進行測試。實驗結(jié)果表明該文的跑題檢測系統(tǒng)能有效識別跑題作文,性能明顯高于基準系統(tǒng)。

文本相似度;詞分布式表示;跑題檢測;文本表示

1 引言

作文跑題指文章偏離了預設的主題。舉個例子,例如,現(xiàn)在有一個題目“online shopping”,很明顯是要求寫關于網(wǎng)上購物的文章。如果學生寫的文章與此無關,而是寫的其他主題的文章,比如寫的是關于讀書的文章或者是關于大學生活的文章,我們就認為該作文跑題。作文的質(zhì)量和是否跑題沒有必然聯(lián)系,有的文章雖然寫的很短很差,但是并沒有跑題。作文跑題的原因很多,可能是作者有意為之,也可能是無意間的提交錯誤。

作文跑題檢測用于判斷一篇作文是否跑題,其核心是計算文本之間的相似度,根據(jù)相似度和跑題標準來判斷文章是否跑題[1]。文本相似度是表示兩個文本之間相似程度的一個度量參數(shù)。除了用于文章跑題檢測,在文本聚類[2]、信息檢索[3]、圖像檢索[4]、文本摘要自動生成[5]、文本復制檢測[6]等諸多領域,文本相似度的有效計算都是解決問題的關鍵所在。

目前最常用的文本表示模型是向量空間模型VSM (Vector Space Model)。向量空間模型的基本思想是用向量形式來表示文本:vd=[w1,w2,w3,……,wn],其中wi是第i個特征項的權重。最典型的向量空間模型是詞袋模型(Bag-of-Words)。該方法以文本中的詞作為特征項形成向量表示,并且采用詞的TF-IDF值作為特征權重*TF-IDF是常用的特征權重計算方法。除此之外,亦可采用二元特征或者以詞頻作為權重。。詞袋模型方法簡單而且有一定效果,但是這種方法忽略了文本中詞項的語義信息,沒有考慮到詞與詞之間的語義相似度。例如,“筆記本”和“手提電腦”這兩個詞在詞袋模型中被認為兩個獨立的特征而沒有考慮這兩個詞在語義上的相近性。

針對傳統(tǒng)向量空間模型在文本相似度計算中存在的問題,很多研究人員進行了研究,其中詞擴展是最常見的一種策略。現(xiàn)有詞擴展方法主要采用基于詞典的方法,比如使用WordNet[7]、HowNet等詞典。文獻[8]提出了基于WordNet詞擴展計算英語詞匯相似度的方法。文獻[9]提出了基于HowNet計算詞匯語義相似度的方法,并將其用于文本分類。這些方法嚴重依賴于人工構(gòu)造的詞典資源,在新語言和新領域應用中會遇到很多問題。

針對上述現(xiàn)有方法的不足,本文將詞袋模型與詞語的語義信息結(jié)合起來,提出一種基于詞分布式表示[10]的文本相似度計算方法。我們首先對文本中單詞進行分布式表示,即將它們映射為向量形式,然后在分布式的詞向量空間中找出與其語義上相近的詞,并將它們加入到文本表示中,最后再計算擴展后的文本相似度。本文將這種方法運用到英文作文的跑題檢測中,構(gòu)建了一套跑題檢測系統(tǒng),并在一個真實數(shù)據(jù)集上進行了測試。實驗結(jié)果表明本文的跑題檢測系統(tǒng)能有效識別跑題作文,性能明顯高于基準系統(tǒng)。

本文的其余部分做如下安排:第2節(jié)對相關工作進行介紹;第3節(jié)詳細介紹我們提出的計算文本相似度的方法。第4節(jié)介紹實驗和結(jié)果分析,第5節(jié)是結(jié)論和下一步工作介紹。

2 相關工作

TF-IDF方法是一種經(jīng)典的基于向量空間模型的文本相似度計算方法。它用詞的TF-IDF值來衡量其對于文本的重要程度,一個詞的重要程度與它在文章中出現(xiàn)的次數(shù)成正比,但同時也會與它在語料庫中出現(xiàn)的頻率成反比。這里包含了兩個重要的概念。

詞頻(TermFrequency),即一個詞在文檔中出現(xiàn)的次數(shù)。一個詞在文章中出現(xiàn)的次數(shù)越多,它對這篇文章就越重要,它與文章的主題相關性也就越高。要注意的是停用詞(stopwords),像中文的“的”、“了”,英文的“a”、“the”,這些詞并不具備這種性質(zhì),它們雖然出現(xiàn)的次數(shù)比較多,但是它們不能反映文章的主題,應該將它們過濾掉。

逆文檔頻率(InverseDocumentFrequency),如果一個詞在文檔集合中出現(xiàn)的次數(shù)越多,說明這個詞的區(qū)分能力越低,越不能反映文章的特性;反之,如果一個詞在文檔集合中出現(xiàn)的次數(shù)越少,那么它越能夠反映文章的特性。例如,有100篇文檔,如果一個詞A只在一篇文檔中出現(xiàn),而詞B在100篇文檔中都出現(xiàn),那么,很顯然,詞A比詞B更能反映文章的特性。

將上面兩個概念結(jié)合起來,我們可以計算一個詞項的TF-IDF值,對于一個詞項(wi):

(1)

其中TFIDF(wi)表示當前詞項wi的TF-IDF值,tf(wi)表示詞項wi的詞頻,idf(wi)表示詞項wi的逆文檔頻率,詞項wi的TFIDF(wi)等于tf(wi)乘以idf(wi)。很顯然,詞頻就等于一篇文檔中該詞項出現(xiàn)的次數(shù)除以文章的總詞數(shù),而逆文檔頻率的計算公式如式(2)所示。

(2)

N表示的是文檔集合中文檔的總數(shù),df(wi)是包含詞項wi的文檔的總數(shù),加1是為了防止分母為0。將式(2)帶入到式(1)中,詞項TF-IDF值的計算公式為

(3)

根據(jù)上述公式計算出文本中每個詞項wi的TD-IDF值,然后利用這些TF-IDF值,將文檔轉(zhuǎn)化成一個向量空間模型,再利用余弦公式來計算相似度。余弦公式[11]如下:

(4)

其中,D1,D2表示兩個文本向量,a1k表示第一篇文章D1中單詞的TF-IDF值,a2k表示第二篇文章D2中單詞的TF-IDF值。

TF-IDF方法是一種簡單有效的計算文本相似度的方法,但是這種方法并沒有考慮詞語背后的語義信息,忽視了詞與詞之間的相似度。人們?yōu)榱烁鼫蚀_的計算文本相似度,提出了一些基于語義的相似度計算法:文獻[12]和文獻[13]提出了基于本體的文本特征抽取和相似度計算方法。文獻[14]提出了基于HowNet語義詞典的文本相似度計算方法。文獻[15]利用WordNet語義詞典研究局部相關性信息以此來確定文本之間的相似性。這些方法利用了特定領域的知識庫來構(gòu)建詞語之間的語義關系,與基于統(tǒng)計學的方法相比準確率有提高,但是知識庫的建立是一項復雜而繁瑣的工程,需要耗費大量人力。與上述方法不同的是,本文將詞進行分布式向量表示,在新的分布式表示空間,自動地找出與某個詞項語義上相似的單詞,將這些詞加入到文本的表示中,然后再用傳統(tǒng)的方法對文本進行相似度計算。

作文跑題檢測的研究起于國外,目的是為了提高作文自動評分系統(tǒng)的性能。隨著研究的深入,許多研究者提出了檢測作文跑題的方法。文獻[1]提出了一種不需要特定主題訓練數(shù)據(jù)的跑題檢測方法。文獻[16]利用主題描述來檢測作文跑題的方法,通過計算文章與主題描述的相似性來判斷文章是否跑題。和這些方法相比,本文的不同之處在于計算文章與范文的相似度來判斷是否跑題,計算時采用了基于詞分布式表示的詞擴展方法,提高了檢測系統(tǒng)的性能。

3 作文跑題檢測

本文將詞的分布式表示和向量空間模型結(jié)合,提出一種新的作文跑題檢測方法。

3.1 詞的分布式表示(WordDistributedRepresentation)

自然語言處理中,將一個詞表示為向量的最簡單、最常用方式是One-hotRepresentation。這種方法把詞表中的每個詞表示為一個很長的向量,向量的維度是詞表大小,其中絕大多數(shù)元素為 0,只有一個維度的值為 1,這個維度就代表了當前的詞。比如:“筆記本”和“手提電腦”,“筆記本”的表示為[0,0,0,1,0…0…],“手提電腦”的表示為[0,0,0,0,0,0,1,0,0…0…]。這種表示方法簡單有效,不過忽視了詞的語義信息,“筆記本”和“手提電腦”是語義上近似的詞,但這種方法表示出的向量卻無法反映這點。

詞的分布式表示(WordDistributedRepresentation)是指將詞表中的詞映射為一個稠密的、低維的實值向量,每一維表示詞的一個潛在特征。這種方法基于深度學習,可以表示出詞與詞之間的聯(lián)系。例如,“筆記本”表示成[0.231,0.678,-0.535,0.178…],“手提電腦”表示成[0.032,0.561,0.233,0.411…],向量的維數(shù)可以在訓練前通過手工設定,是一個固定的值。雖然我們無法確切解釋每一個維度具體表示什么,但是我們可以根據(jù)單詞的向量形式找出與其語義上相近的詞。

3.2 基于詞分布式表示的詞擴展

基于詞的分布式表示,本節(jié)先進行詞擴展,然后基于詞擴展結(jié)果計算文檔間相似度。基于詞擴展的文檔相似度計算具體描述如下所示。

3.3 跑題檢測

在本文跑題檢測任務中,對每個作文題目給定K篇文章作為范文。利用上節(jié)描述的詞擴展得到的文本表示,計算學生作文和范文之間的相似度。本文使用余弦相似度(Cosine)來計算相似度。假設給定的K篇范文集合記為D,其中第m篇范文記為dm(1≤m≤K),學生作文dx,則相似度計算過程如下。

首先,使用之前所述的方法計算范文與學生作文的相似度Sim(dm,dx),然后系統(tǒng)取均值作為最終相似度Sim(dx),如式(5)所示。

(5)

我們用最終相似度作為系統(tǒng)對文章的評分,將其與系統(tǒng)的閾值進行對比,以此來判斷作文有沒有跑題。

4 實驗

本節(jié)先介紹實驗數(shù)據(jù),再介紹如何構(gòu)造標準集,以及實驗的評價方法,最后一部分是實驗的結(jié)果和分析。

4.1 實驗數(shù)據(jù)

本次實驗中,我們收集了10 709篇英文作文,共包括20個不同的題目,每個題目下有500篇左右的文章。這些文章都有教師對文章的總體評分,評分越高的文章寫得越好,為了便于比較,在實驗前,我們先對每個題目下的文章評分進行歸一化處理,將文章的人工評分映射到0到1的范圍。對于每個作文題目,選擇人工評分靠前的K篇文章作為我們的范文。

為了學習詞語的idf值和訓練詞向量,我們另外收集了41 225篇不帶評分的英文作文。

詞向量的訓練方法有很多,Bengio等人提出FFNNLM模型[17](Feed-forwardNeuralNetLanguageModel)可以訓練出詞的向量表示形式,不過FFNNLM并非是專門用來訓練詞向量,詞向量只是訓練模型過程中產(chǎn)生的副產(chǎn)品。Google開源了一款專門用來訓練詞向量的工具Word2Vec[18-20],它可以根據(jù)給定的語料庫,通過訓練后的模型將詞表示成向量形式,并能找出與某個詞語義上相近的詞。相比較FFNNLM模型,Word2Vec對訓練模型做出了優(yōu)化,運行速度更快。我們的實驗使用Word2Vec工具*https://github.com/NLPchina/Word2VEC_java來訓練詞向量。

4.2 構(gòu)造標準集

標準集里面包含的是人工判斷為跑題的文章的集合。由于文章數(shù)目較多,不可能人工檢查所有文章,因此我們借助教師評分自動構(gòu)造標準集。構(gòu)造標準集的步驟如下。

(1) 將各個題目下的文章按照人工評分從高到低排序。評分越高說明文章寫得越好,這部分文章幾乎不會跑題;而分數(shù)越低說明文章寫得越不好,這里面可能就有跑題的文章出現(xiàn)。

(2) 對于每個作文題目的文章,取得分最低的十篇文章,人工閱讀每一篇文章,判斷它有沒有跑題,如果跑題則將它加入到標準集中。對于這十篇文章,如果它們?nèi)桥茴}的文章,或者絕大多數(shù)是跑題的文章,就接著往上檢查十篇文章,循環(huán)操作直到出現(xiàn)大部分的不跑題文章為止。如果這十篇文章只有少部分跑題,或者完全沒有跑題的文章,就完成該作文題目的跑題作文人工檢查工作。

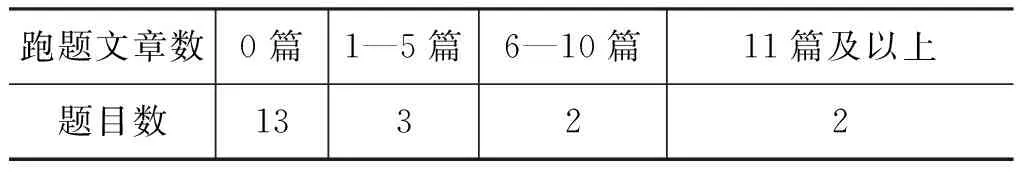

最后得到的標準集共有54篇文章。每個題目下的跑題文章數(shù)是不一樣的,有的題目比較好寫,沒有文章跑題;而有的題目比較難寫,相對而言,跑題文章較多。表1給出了不同題目下跑題文章的分布。

從表1中我們可以看出,有13個題目下沒有跑題文章,占65%,很大的比例;另外,有三個題目下跑題文章數(shù)在1到5篇之間;跑題文章數(shù)為在6—10篇之間和11篇以上的題目數(shù)都是兩個。

表1 跑題文章的分布

4.3 實驗評價方法

我們利用準確率(Precision)、召回率(Recall)和F1值來評價系統(tǒng)。首先要構(gòu)造標準集和預測集兩個集合,標準集是正確答案的集合,按上述方法構(gòu)造。預測集是系統(tǒng)預測答案的集合。我們用M來表示標準集合中元素的數(shù)目,N表示預測集中元素的數(shù)目,假設預測集中有K個元素是標準集中的元素。用P來表示準確率,R表示召回率,F(xiàn)表示F1值,則計算方法如下:

(6)

(7)

(8)

為了更好地分析系統(tǒng),我們計算召回率取不同

值的時候的準確率和F1值,具體就是計算出當召回率為0.1、0.2、0.3.....1.0的時候的系統(tǒng)的準確率和F1值,以此作為我們評價系統(tǒng)的依據(jù)。

4.4 實驗結(jié)果

本次實驗,我們共構(gòu)建了四套不同的跑題檢測系統(tǒng)。除了上述的TF-IDF方法和基于詞分布式表示的詞擴展方法,還有另外兩種方法作為比較:Word2Vec方法和Sent2Vec方法。Word2Vec方法是進行簡單地替代和拼接。用單詞訓練出的詞向量來代替TF-IDF方法中的TF-IDF值,然后再將所有單詞的詞向量首尾相連,拼接成一個長的向量,最后使用余項公式來計算相似度。假設之前TF-IDF方法中的文章表示為一個1×M的向量,每一維表示一個詞的TF-IDF值,使用Word2Vec訓練出的詞向量是N維,用詞向量代替TF-IDF值后,文章就表示為一個1×MN的向量。Sent2Vec方法是使用Sent2Vec工具*http://research.microsoft.com/en-us/downloads/731572aa-98e4-4c50-b99d-ae3f0c9562b9/,與Word2Vec不同的是它可以對句子進行分布式向量表示,我們將一篇英文文章看作一句話,然后訓練出一篇文章的向量表示,直接用余弦公式計算文章之間的相似度。

圖1和圖2是選取一篇文章作為范文的實驗結(jié)果,對于詞擴展(WordExtend)方法,每個單詞擴展了50個詞。

圖1 一篇范文時準確率隨召回率變化的曲線

圖2 一篇范文時F1值隨召回率變化的曲線

圖3和圖4是選取五篇文章作為范文的實驗結(jié)果。

圖3 五篇范文時準確率隨召回率變化的曲線

圖4 五篇范文時F1值隨召回率變化的曲線

從實驗結(jié)果,我們可以看出:

(1)Word2Vec方法性能略低于傳統(tǒng)的TF-IDF方法,Sent2Vec方法的性能最差,而詞擴展方法的性能要明顯優(yōu)于其他三種方法。

(2) 當范文數(shù)為一的時候,我們可以看到:R=0.6的時候,TF-IDF方法的F1達到峰值,為0.455, 而詞擴展方法的F1值為0.611;TF-IDF方法的準確率只有0.363;而詞擴展方法的準確率為0.611,相比較之下,使用詞擴展方法的系統(tǒng)的整體

性能有明顯的提升。

(3) 當范文數(shù)為5的時候,TF-IDF方法的F1值最高為0.635,而詞擴展方法的F1值的峰值為0.66,略高于TF-IDF方法。

(4) 另外,對比范文數(shù)為1的和范文數(shù)為5的結(jié)果。我們可以發(fā)現(xiàn),范文數(shù)少的情況下,詞擴展方法的效果比傳統(tǒng)的TF-IDF方法明顯要好很多。這是因為通過詞擴展的方式,一篇范文所包含的語義信息更加豐富,所以系統(tǒng)的判斷也會更加準確。在實際使用中這點很有用,因為實際情況下一般不會提供太多范文。

5 結(jié)論和下一步工作介紹

本文提出了一種基于詞分布式表示的作文跑題檢測方法。這種方法將傳統(tǒng)的TF-IDF方法和單詞語義信息相結(jié)合,尋找與文本中單詞語義上相近的詞,并將其加入到文本的表示中,實現(xiàn)了對文本的詞擴展。在此基礎上,對擴展后的文本用TF-IDF方法計算相似度。實驗結(jié)果表明這種方法要明顯優(yōu)于傳統(tǒng)的TF-IDF方法。

在接下來的工作中,我們還會進行更深入的研究。例如,文中的詞擴展數(shù)目是人工選取的50個單詞,雖然效果提升明顯,但還不是最優(yōu)解,還有待于通過開發(fā)集來選取最優(yōu)值。另外,還可以改進我們詞擴展的方式,尋找一種更好的方式來將單詞的語義信息融入到文本相似度的計算中。

[1]DHiggins,JBursteinAttali.Identifyingoff-topicstudentessayswithouttopic-specifictrainingdata[J],NaturalLanguageEngineering, 2006, 12(2): 145-159.

[2]AHuang.Similaritymeasuresfortextdocumentclustering[C]//ProceedingsoftheNewZealandComputerScienceResearchStudentConference, 2008: 44-56.

[3]KUMARN.Approximatestringmatchingalgorithm[J].InternationalJournalonComputerScienceandEngineering, 2010, 2(3): 641-644.

[4]COELHOTAS,CALADOPP,SOUZALV, 等.Imageretrievalusingmultipleevidenceranking[J].IEEETransonKnowledgeandDataEngineering, 2004, 16(4): 408-417.

[5]KOY,PARKJ,SEOJ.Improvingtextcategorizationusingtheimportanceofsentences[J].InformationProcessingandManagement,2004, 40(1): 65-79.

[6]THEOBALDM,SIDDHARTHJ,SpotSigs:robustandefficientnearduplicatedetectioninlargewebcollection[C]//Proceedingsofthe31stAnnualInternationalACMSIGIRConferenceonResearchandDevelopmentinInformationRetrieval.NewYork:ACMPress, 2008: 563-570.

[7]MillerG.Wordnet:AnOn-lineLexicalDatabase[J].InternationalJournalofLexicography, 1990, 3(4): 235-244.

[8] 顏 偉, 荀恩東. 基于WordNet的英語詞語相似度計算[C]//計算機語言學研討會論文集. 2004.

[9] 朱嫣嵐, 閔錦, 周雅倩, 等. 基于HowNet的詞匯語義傾向計算[J]. 中文信息學報, 2006, 20(1):14-20.

[10]Lee,DanielD,H.SebastianSeung.Algorithmsfornon-negativematrixfactorization[C]//ProceedingsoftheAdvanceinNeuralInformationProcessingSystem.MITPress,2001:556-562.

[11] 張霞, 王建東, 顧海花. 一種改進的頁面相似性度量方法[J]. 計算機工程與應用, 2010, 46(19): 141-144.

[12]SánchezJA,MedinaMA,StarostenkoO, 等.OrganizingOpenArchivesviaLightweightOntologtoFacilitatetheUseofHeterogeneousCollection[J].AslibProceedings, 2012, 64(1): 46-66.

[13]VicientC,SánchezD,MorenoA.AnAutomaticApproachforOntology-BasedFeatureExtractionfromHeterogeneousDocumentalResource[J].EngineeringApplicationofArtificialIntelligence, 2013, 26: 1092-1106.

[14]LiuQ,LiSJ.SemanticSimilarityCalculationBasedonHowNet[C]//Proceedingsofthe3rdChineseLexicalSemanticsWorkshop.Taipei,China, 2002: 59-76.

[15]RamageD,RaffertyAN,ManningCD.Randomwalksfortextsemanticsimilarity[C]//Proceedingsofthe2009WorkshoponGraph-basedMethodsforNaturalLanguageProcessing.Suntec,Singapore, 2009: 23-31.

[16]ALouis,DHiggins.Off-topicessaydetectionusingshortprompttexts[C]//ProceedingsoftheNAACLHLT2010FifthWorkshoponInnovativeUseofNLPforBuildingEducationalApplications,LosAngeles,California, 2010:92-95.

[17]YBengio,RDucharme,PVincent,etal.Aneuralprobabilisticlanguagemodel[J].JournalofMachineLearningResearch, 3:1137-1155.

[18]TomasMikolov,KaiChen,GregCorrado,etal.EfficientEstimationofWordRepresentationsinVectorSpace[C]//ProceedingsofWorkshopatICLR, 2013.

[19]TomasMikolov,IlyaSutskever,KaiChen,etal.DistributedRepresentationsofWordsandPhrasesandtheirCompositionality[C]//ProceedingsofNIPS, 2013.

[20] Tomas Mikolov, Wen-tau Yih, Geoffrey Zweig. Linguistic Regularities in Continuous Space Word Representations[C]//Proceedings of NAACL HLT, 2013:746-751.

Exploiting Distributed Representation of Words for Better Off-Topic Essay Detection

CHEN Zhipeng1,2, CHEN Wenliang1,2,ZHU Muhua3

(1. School of Computer Science and Technology, Soochow University, Suzhou, Jiangsu 215006, China;2. Collaborative Innovation Center of Novel Software Technology and Industrialization, Suzhou, Jiangsu 215006, China;3.Taobao (China) Software Co., Ltd,Hangzhou,Zhejiang 311100, China)

Similarity measure is the core component of off-topic essays detection. To compute the text similarity, the bag-of-words model is widely used, which represents a text as a vector with each dimension corresponds to a word. To further capture the word semantic information, this paper proposes a new method to compute text similarity: a method exploits word distributed representation. The proposed method combines the traditional bag-of-words model with the word semantic information. For each word in a text, we search for a set of similar words in a text collection, and then extend the text vector with these words. Finally we compute text similarity with the updated text. Experimental results show that our method is more effective than baseline systems.

text similarity; word distributed representation; digress test; text representation

陳志鵬(1991—),碩士研究生,主要研究領域為自然語言處理。E-mail:chenzhipeng341@163.com陳文亮(1977—),通信作者,博士,主要研究領域為自然語言處理。E-mail:wlchen@suda.edu.cn朱慕華(1981—),博士,主要研究領域為自然語言處理。E-mail:zhumuhua@gmail.com

1003-0077(2015)05-0178-07

2015-06-29 定稿日期: 2015-09-18

國家自然科學基金(61203314, 61333018)

TP391

A