基于改進型深度LLE和隨機森林的人臉檢測算法*

宋全有,李萬高

(1.河南交通職業(yè)技術(shù)學院 交通信息工程系,鄭州 450052;2.河南工程學院計算機學院,鄭州 451191)

?

基于改進型深度LLE和隨機森林的人臉檢測算法*

宋全有1*,李萬高2

(1.河南交通職業(yè)技術(shù)學院 交通信息工程系,鄭州 450052;2.河南工程學院計算機學院,鄭州 451191)

摘要:針對人臉檢測問題的特點,提出一種基于改進型深度LLE(Locally Linear Embedding)算法和隨機森林相結(jié)合的人臉檢測算法。首先,通過采集圖像的深度信息,結(jié)合圖像的顏色信息,構(gòu)建三維圖像信息數(shù)據(jù)庫,再通過改進的LLE算法得到最優(yōu)降維結(jié)果,按一定比例選取訓練集,輸入隨機森林算法建立數(shù)據(jù)分類器;最后,將測試集輸入到訓練完成的分類器中,實現(xiàn)人臉圖像的檢測。選取Yale,JAFFE 2類數(shù)據(jù)集與傳統(tǒng)算法進行對比實驗,驗證算法的優(yōu)越性和可行性。實驗結(jié)果表明:所提出的算法可以有效地完成人臉檢測,檢測率高于傳統(tǒng)算法7%左右。

關(guān)鍵詞:人臉檢測;局部線性嵌入;深度;降維;隨機森林

近年來,人臉檢測問題是模式識別領(lǐng)域較為熱點問題。一些特定的算法與分類算法結(jié)合,可以有效地完成人臉檢測問題,由于人臉圖像屬于高維數(shù)據(jù),一般需進行特征提取,其代表算法有:主成分分析(PCA)[1],核主成分分析(KPCA)[2],梯度方向直方圖(HOG)[3]等,這些算法的本質(zhì)是提取人臉圖像的特征向量,再輸入到訓練完成的分類器。數(shù)據(jù)分類算法有:支持向量機(SVM)[4],線性判別分析(LDA)[5],核線性判別分析(KLDA)[6]等,利用特征向量和分類器即可完成人臉檢測。

針對數(shù)據(jù)流形問題,Roweis等人[7]提出局部線性嵌入(LLE)算法,利用流形降維的方式區(qū)別各類數(shù)據(jù),郭峰等人[8]將LLE算法與SVM算法結(jié)合,提出使用數(shù)據(jù)流形降維,完成人臉的檢測;王憲等[9]將KPCA算法和高斯核相結(jié)合,有效地解決人臉檢測問題,而這些算法只是簡單地處理二維平面人臉圖像,并沒有有效地使用三維立體信息,在背景復雜的環(huán)境下,往往檢測率較低。

針對傳統(tǒng)算法的缺點,提出一種基于改進型深度LLE和隨機森林[10-11]相結(jié)合的人臉檢測算法,將深度信息加入到傳統(tǒng)圖像的顏色信息中,擴展了人臉圖像信息量,利用改進的LLE算法進行降維后,輸入到隨機森林進行分類。選取Yale數(shù)據(jù)集和JAFFE數(shù)據(jù)集驗證算法在人臉檢測中的可行性。

1 本文算法

Kinect的是由一個正常數(shù)碼攝像頭、一個CMOS紅外傳感器,一個紅外線接收傳感器組成。當Kinect開始運行后,3個攝像頭同時采集數(shù)據(jù)流,中間的數(shù)碼攝像頭采集正常的彩色圖片,兩邊的紅外傳感器采集彩色圖片的深度值,我們利用顏色和深度信息,再結(jié)合改進型LLE算法提取人臉區(qū)域特征向量。

1.1Kinect深度圖像采集

Kinect深度跟蹤處理流程的核心是一個無論周圍環(huán)境的光照條件如何,都可以讓Kinect感知人體位置的CMOS紅外傳感器。該傳感器通過黑白光譜的方式來感知環(huán)境:純黑代表無窮遠,純白代表無窮近。黑白間的灰色地帶對應物體到傳感器的物理距離。它收集視野范圍內(nèi)的每一點,并形成一幅代表周圍環(huán)境的景深圖像。傳感器以30幀/s的速度生成景深圖像流,從而有效地得到人臉圖像像素點顏色數(shù)據(jù)和深度數(shù)據(jù),并建立數(shù)據(jù)庫。

1.2深度信息

一般的圖像只具有顏色信息,屬于二維平面圖像,利用Kinect的深度攝像功能,可采取人臉圖像的深度信息。設(shè)圖像維數(shù)為,則任意一幅人臉圖像向量可表示為

(1)

Kinect采集圖像的深度信息從像素點出發(fā),采集每個像素點距離攝像頭的距離,則圖像深度向量可表示為

(2)

將深度向量加入到顏色向量中,得到人臉的三維信息向量,結(jié)合式(1)、式(2),可得

(3)

其中,Wi表示三維信息向量,且維數(shù)為2n。

1.3LLE算法的改進

傳統(tǒng)LLE算法[12-15]的鄰近點選取沒有統(tǒng)一的標準,一般根據(jù)樣本數(shù)量的不同而改變,而鄰近點的個數(shù)直接決定數(shù)據(jù)降維的結(jié)果。設(shè)(a1,a2,…,an)表示n類數(shù)據(jù)集,每類數(shù)據(jù)為n維,為了保證降維后的數(shù)據(jù)更具代表性,則必須保證類內(nèi)離差最小,類間離差最大。

設(shè)ai,aj為任意2類數(shù)據(jù)集,降維后可表示為,

則類內(nèi)離差Ti可表示為

(4)

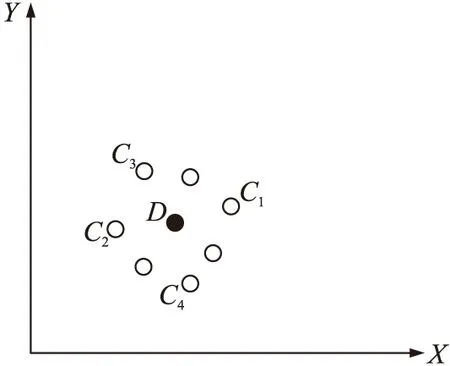

計算類間離差時,需要知道同類數(shù)據(jù)分布的大致區(qū)域,選擇區(qū)域中的某個數(shù)據(jù)點作為代表其余數(shù)據(jù)的代表點,當降維后的數(shù)據(jù)超過3維時,已經(jīng)無法將其在坐標平面進行展現(xiàn),以2維坐標平面為例,代表點選取如圖1所示。

圖1 代表點選取示意圖

(5)

根據(jù)式(5)進行推演,n維空間下的代表點表示為

(6)

類間離差可表示為

(7)

其中,Di表示任意一類數(shù)據(jù)的代表點,根據(jù)式(4)、式(7),離差比ω可表示為

ω=Tc/Tl

(8)

由式(8)可以看出,類內(nèi)離差Tl越小,類間離差Tc越大,則離差比ω越大,表示降維后的數(shù)據(jù)越具代表性,越理想。

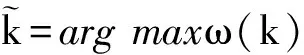

當數(shù)據(jù)不變時,離差比ω由鄰近點個數(shù)k所決定,則最優(yōu)化鄰近點個數(shù)可表示為

(9)

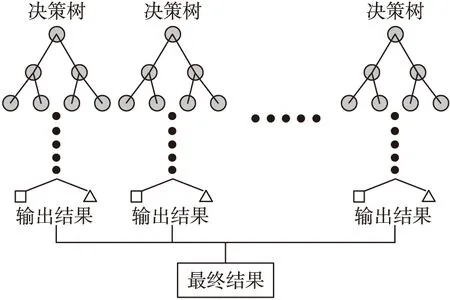

2 隨機森林算法

決策樹是隨機森林算法的基本單元,決策樹的構(gòu)造是由一個隨機向量所決定。隨機森林算法的本質(zhì)是組合多個弱分類器(決策樹),使其分類誤差減小的一種分類算法,一般采用二叉決策樹作為基本模型,其模型如圖2所示。

由于二叉決策樹只能對數(shù)據(jù)進行2分類,針對多類數(shù)據(jù)需對二叉決策樹進行節(jié)點多分叉,形成每個節(jié)點多次分叉的過程,從而構(gòu)造了多叉決策樹模型。

圖2 隨機森林模型圖

隨機森林的生成過程分以下4步:

Step 1(Bagging過程):假設(shè)每類訓練集中有N個樣本,有放回地隨機抽取n個樣本,作為一棵決策樹的訓練樣本。

Step 2(分裂屬性選擇過程):假設(shè)特征向量是m維,選取m1維作為子集指定給每個節(jié)點,從m1中選擇分類效果最佳的一維特征作為接點的分類屬性,且保證在隨機森林的生長過程中m1保持不變,采用信息熵作為判斷節(jié)點分裂屬性選擇的依據(jù),設(shè)數(shù)據(jù)集種類為m,任意一個數(shù)據(jù)集的分類概率為Pi,則信息熵表達式H(X)為

(10)

Step 3(決策樹的生長過程):當每個節(jié)點的分類純度達到期望比例或者生長層數(shù)達到給定值時,則停止決策樹的生長,保證每個決策樹都最大限度的生長,且沒有剪枝情況。

Step 4(生成隨機森林過程):重復Step 1~Step 3,生長出多顆決策樹,從而生成森林。

從以上步驟可以看出,隨機森林算法的誤差更為穩(wěn)定,克服了單一決策樹的不足,體現(xiàn)了多個弱分類器合成強分類器的優(yōu)勢。

3 算法的實現(xiàn)

結(jié)合改進的LLE算法和隨機森林算法,本文算法的實現(xiàn)分以下步驟

Step 1:利用Kinect采集人臉圖像的顏色和深度信息,按照式(3),將其轉(zhuǎn)化為三維信息向量,建立向量集。

Step 4:將測試集輸入到構(gòu)建完成的數(shù)據(jù)分類器,實現(xiàn)人臉檢測。

4 實驗分析

本文在Inter(R)Core(TM)Duo-E7500的CPU,內(nèi)存6G的Windows 7操作系統(tǒng)下進行實驗。采用Yale數(shù)據(jù)集和Japanese Female Facial Expression(JAFFE)數(shù)據(jù)集,對本文所提方法進行可行性的驗證。

4.1Yale數(shù)據(jù)集實驗

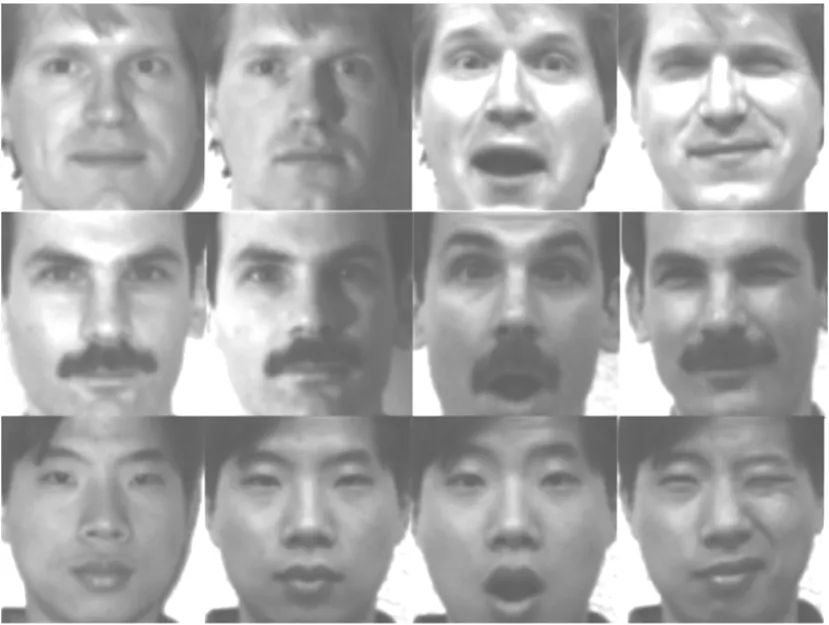

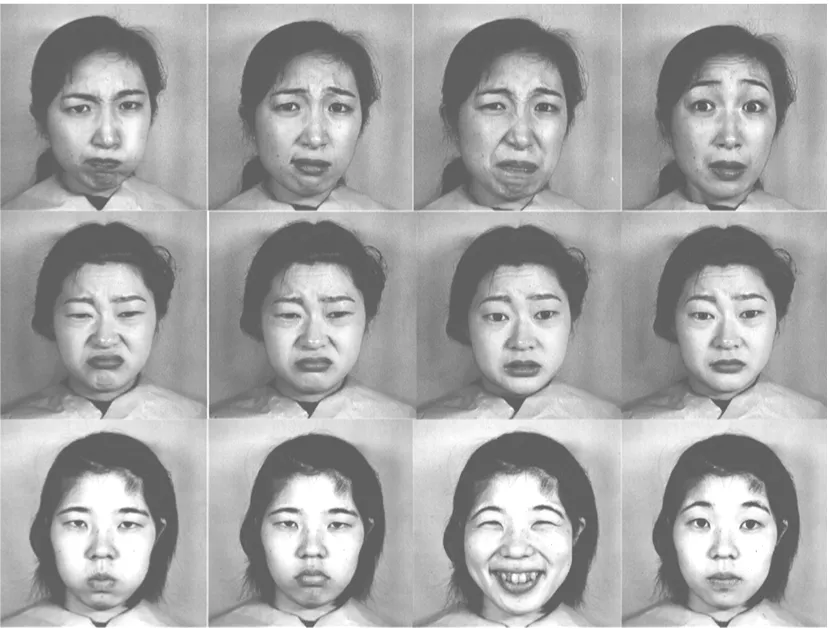

Yale數(shù)據(jù)集是由耶魯大學推行的包含不同光照、表情的人臉數(shù)據(jù)庫,模式類別數(shù)為15,每類各有11個模式樣本,圖像大小為100×100,灰度級256,總共有165個樣本,部分數(shù)據(jù)圖如圖3所示。

圖3 Yale數(shù)據(jù)集部分人臉圖像

依據(jù)數(shù)據(jù)集人臉模型,利用Kinect的深度值還原功能,將圖像深度值進行采樣。將三維信息向量集輸入改進的LLE算法中進行降維,將最佳降維數(shù)據(jù)輸入隨機森林進行人臉檢測,設(shè)測試集數(shù)量為nc,準確檢測人臉數(shù)量為nt,則檢測率Pt可表示為

pt=(nt/nc)×100%

(11)

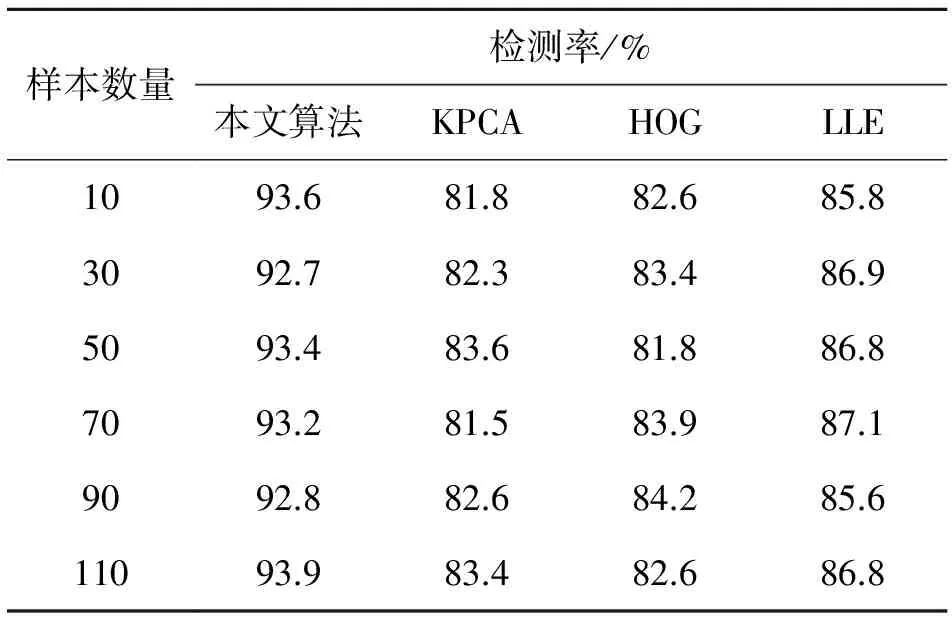

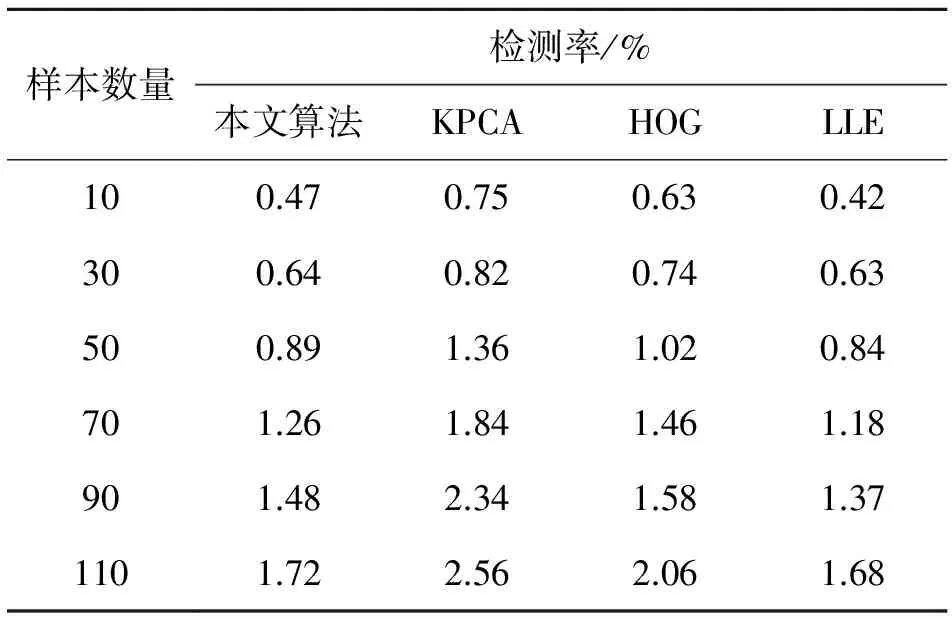

將本文算法結(jié)果與KPCA算法,HOG算法,LLE算法所得結(jié)果進行對比,比較結(jié)果如表1、表2所示。

表1 檢測率比較結(jié)果

表2 檢測時間比較結(jié)果

由表1可得,本文算法的檢測率平均保持在93%左右,而KPCA算法,HOG算法,LLE算法分別保持在81%,82%,86%左右,高于傳統(tǒng)算法中檢測率最高的LLE算法7%左右。表2表明:本文算法在檢測時間方面略長于LLE算法,平均檢測時間多0.1 s左右,這由于本文算法加入了深度信息,加大了圖像的維數(shù),但檢測率明顯提高,檢測時間的略增長對檢測效率的影響并不大,體現(xiàn)出本文算法的可行性及優(yōu)越性。

4.2JAFFE數(shù)據(jù)集實驗

JAFFE數(shù)據(jù)集是由日本婦女的多種表情圖像所組成,模式類別數(shù)為10,每類各有20個左右的模式樣本,圖片尺寸,灰度級256,總共有213個樣本,部分數(shù)據(jù)圖像如圖4所示。

圖4 JAFFE數(shù)據(jù)集部分人臉圖像

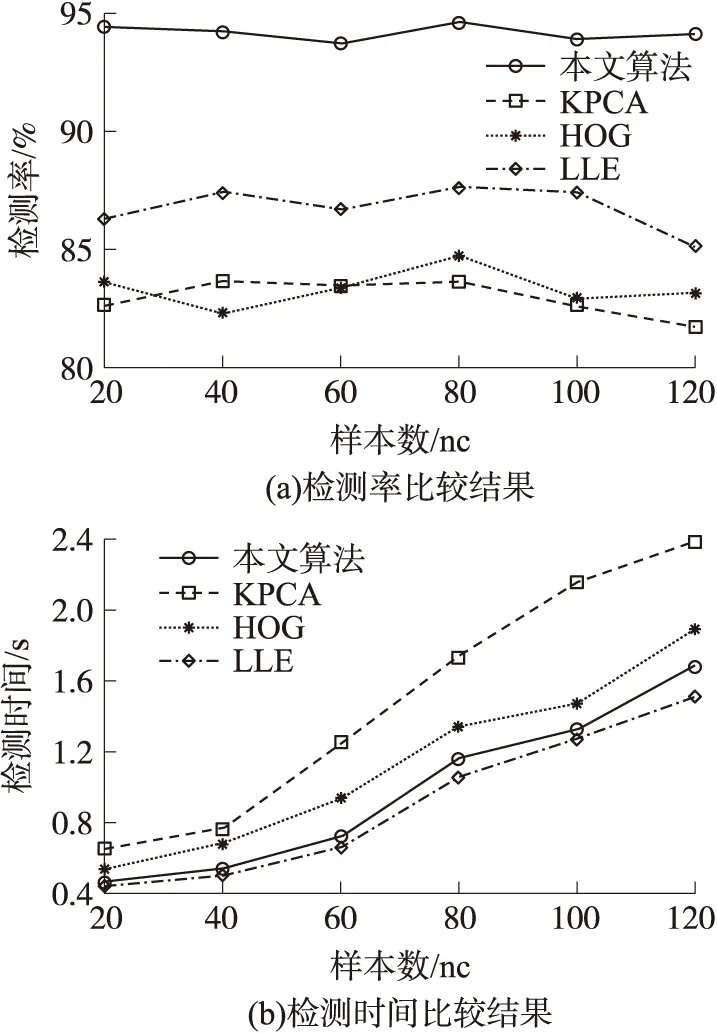

按照4.1節(jié)中對數(shù)據(jù)集的分配比例構(gòu)建對應的訓練集和測試集,按照其實驗方法進行人臉檢測實驗,將本文算法再次與KPCA算法,HOG算法,LLE算法比較,所得結(jié)果如圖5所示。

由圖5(a)可以看出,本文算法在JAFFE數(shù)據(jù)集的平均檢測率為94.2%,而KPCA算法,HOG算法,LLE算法分別保持在83.4%,83.5%,87.3%,明顯優(yōu)于傳統(tǒng)人臉檢測算法;圖5(b)可得,本文算法在JAFFE數(shù)據(jù)集的檢測時間與LLE算法大致相同,且優(yōu)于KPCA算法和HOG算法,說明了本文算法雖在檢測效率上沒有明顯提高,但在檢測率上提高10%,證明本文算法在人臉檢測中具有一定的優(yōu)勢。

圖5 JAFFE數(shù)據(jù)集比較結(jié)果

5 結(jié)論

本文對LLE算法進行深入研究,結(jié)合隨機森林算法,提出一種改進型深度LLE的人臉檢測算法。該算法首先利用圖像深度信息結(jié)合顏色信息,擴展了人臉圖像的信息量,再利用改進LLE算法進行最優(yōu)化數(shù)據(jù)降維,再通過隨機森林算法對降維數(shù)據(jù)進行分類,建立人臉圖像分類器,實現(xiàn)人臉檢測。

實驗結(jié)果表明:本文算法有較強的適用能力,針對多個數(shù)據(jù)庫具有較好的檢測率。Yale數(shù)據(jù)集和JAFFE數(shù)據(jù)集實驗表明算法針對圖像數(shù)據(jù)具有較高的檢測率,平均保持在93%和94.2%,優(yōu)于傳統(tǒng)算法,體現(xiàn)算法在人臉圖像檢測中具有一定的優(yōu)勢。今后的任務是進一步研究人臉圖像檢測中的干擾因素,提高算法抗干擾能力。

參考文獻:

[1]Rencher A C,Christensen W F.Methods of Multivariate Analysis[M].3 Ed.Hoboken:Wiley Press,2012:405-433.

[2]Wang J,Zhou Y S,Du X J,et al.Personal Credit Assessment Based on KPCA and SVM[C]//Proceedings of International Conference on Business Intelligence and Financial Engineering,Beijing:IEEE Press,2012:25-28.

[3]Dalai N,Triggs B.Histograms of Oriented Gradients for Human Detection[C]//Proceedings of IEEE Conference on Computer Vision and Pattern Recognition.San Diego:IEEE Press,2005:886-893.

[4]Gentle J E,H?rdle W K,Mori Y C.Handbook of Computational Statistics:Concepts and Methods[M].2nd Ed.Germany:Springer Press,2012:883-926.

[5]Iosifidis A,Tefas A,Nikolaidis N,et al.Multi-View Human Movement Recognition Based on Fuzzy Distances and Linear Discriminant Analysis[J].Computer Vision and Image Understanding,2012,116(3):347-360.

[6]Zafeiriou S,Tzimiropoulos G,Petrou M,et al.Regularized Kernel Discriminant Analysis with a Robust Kernel for Face Recognition and Verification[J].IEEE Transactions on Neural Networks and Learning Systems,2012,23(3):526-534.

[7]Roweis S T,Saul L K.Nonlinear Dimensionality Reduction by Locally Linear Embedding[J].Science,2000,290(5500):2323-2326.

[8]郭峰,劉麗麗,呂凝.基于LLE和SVM的人像識別方法[J].吉林大學學報(信息科學版),2008,26(1):49-52.

[9]王憲,慕鑫,張彥,等.基于曲波域與核主成分分析的人臉識別[J].光電工程,2011,38(10):98-102.

[10]Mendoza M R,da Fonseca G C,Loss-Morais G,et al.RFMirTarget:Predicting Human MicroRNA Target Genes with a Random Forest Classifier[J].PloS one,2013,8(7):127-153.

[11]Boulesteix A L,Bender A,Bermejo J L,et al.Random Forest Gini Importance Favours SNPs with Large Minor Allele Frequency:Impact,Sources and Recommendations[J].Briefings in Bioin-formatics,2012,13(3):292-304.

[12]馬瑞,王家廞,宋亦旭.基于局部線性嵌入(LLE)非線性降維的多流形學習[J].清華大學學報(自然科學版),2008,48(4):582-585.

[13]Chang Y,Hu C B,Feris R,et al.Manifold Based Analysis of Facial Expression[J].Image and Vision Computing,2006,24(6):605-614.

[14]Rivera S,Martinez A.Learning Deformable Shape Manifold[J].Pattern Recognition,2012,45(4):1792-180.

[15]翟永前,喬建,趙力.基于簡化Gabor小波的人臉識別算法研究[J].電子器件,2012,35(6):687-681.

宋全有(1963-),男,河南孟州人,碩士,副教授,主要研究方向為計算機應用,通信與信息系統(tǒng),61915600@163.com。

FaceDetectionAlgorithmBasedonModifiedDepthLLEandRandomForest*

SONGQuanyou1*,LIWangao2

(1.Department of Traffic Engineering,Henan Vocational and Technical College of Communications,Zhengzhou 450052,China;2.Computer College,Henan Institute of Engineering,Zhengzhou 451191,China)

Abstract:For the characteristics of face detection,a novel face detection algorithm based on modified depth Locally Linear Embedding(LLE)and Random Forest is proposed.Firstly,the depth information of images are collected by Kinect,and the three-dimensional image data base can be established by the depth information and colour information.Secondly,the dimension of data sets are reduced by modified LLE,and the optimal results of data dimension reduction can be gotten.The training sets are gotten by the proportion of data sets,and data classifier can be gotten by Random Forest.Finally,the test sets are input,and the face detection can be achieved.The two classes of data sets are selected as the experimental data,which consist of Yale and JAFFE.The experiment results show that the proposed method not only has a great effect to achieve face detection,but the detection rate is higher than the traditional algorithms about 7%.

Key words:face detection;locally linear embedding(LLE);depth;dimension reduction;random forest

doi:EEACC:6210C10.3969/j.issn.1005-9490.2014.04.010

中圖分類號:TP391.41

文獻標識碼:A

文章編號:1005-9490(2014)04-0626-05

收稿日期:2013-09-16修改日期:2013-10-31

項目來源:國家自然科學基金項目(61272253)