目標跟蹤技術綜述

高 文,朱 明,賀柏根,吳笑天

(1.中國科學院長春光學精密機械與物理研究所,吉林長春130033;

2.中國科學院航空光學成像與測量重點實驗室,吉林長春130033)

1 引言

目標跟蹤技術一直是計算機視覺研究領域中的熱點之一,其在軍事偵察、精確制導、火力打擊、戰場評估以及安防監控等諸多方面均有廣泛的應用前景。目標的不定向運動改變了目標和場景的外觀模式、非剛性目標結構、目標間及目標與場景間的遮擋、攝像機的運動等情況使目標跟蹤任務變得更加困難。跟蹤常應用于那些需要了解目標每幀的位置及形狀的應用環境中,并常用假設來約束特定應用環境中的跟蹤問題。

跟蹤可簡單地定義為估計物體圍繞一個場景運動時在圖像平面中軌跡,即一個跟蹤系統給同一個視頻中不同幀的跟蹤目標分配相一致的標簽。目標跟蹤是一個頗具挑戰性的問題。在計算機視覺領域目標跟蹤是一項重要工作。隨著高性能計算機的增多,物美價廉攝影機的普及,對自動視頻分析與日俱增的需求引起人們對目標跟蹤算法濃厚興趣。

本文主要就單目標跟蹤問題展開論述,目標不定向運動使跟蹤目標變得困難,因為它改變了目標和場景的外觀模式、非剛性目標結構、目標間及目標與場景間的遮擋。常用假設來約束特定應用中的跟蹤問題,如幾乎所有跟蹤算法都假設物體運動是平滑不會突變的。還可以根據推理信息將物體約束為勻速或等加速運動。利用先前物體數量和大小或外觀和形狀知識也可簡化問題。

本文將從目標跟蹤的應用、目標表示法、跟蹤方法研究現狀、難點及趨勢等方面進行展開討論。

2 跟蹤技術的應用

目標跟蹤應用于以下相關工作中:

(1)智能視頻監控:基于運動識別(基于步法的人類識別,自動物體檢測等),自動化監測(監視一個場景以檢測可疑行為);交通監視(實時收集交通數據用來指揮交通流動)。

(2)人機交互:傳統人機交互是通過計算機鍵盤和鼠標進行的。而人們期望計算機更智能地以自然方式與人交流。實現這一目標的方式之一是使計算機具有識別和理解人的姿態、動作、手勢等能力,跟蹤是完成這些任務的關鍵一步。

(3)機器人視覺導航:視覺傳感器是智能機器人一種重要的信息源,為能自主運動,智能機器人須認識和跟蹤環境中的物體。在機器人手眼應用中,跟蹤技術用安裝在機器人手上的攝像機拍攝物體,計算其運動軌跡,選擇最佳姿態抓取物體。

(4)虛擬現實:虛擬環境中3D交互和虛擬角色動作模擬直接得益于視頻人體運動分析的研究成果,可給參與者提供更加豐富的交互形式。從視頻中獲取人體運動數據,用新的虛擬人物或具有類似關節模型的物體替換原視頻中的人物,以得到意想不到的特殊效果。其關鍵技術是人體運動跟蹤分析。

(5)醫學診斷:超聲波和核磁共振技術已被廣泛應用于病情診斷。跟蹤技術在超聲波和核磁序列圖像的自動分析中有廣泛應用。由于超聲波圖像中的噪聲經常會淹沒單幀圖像有用信息,使靜態分析十分困難,如果利用序列圖像中目標在幾何上的連續性和時間上的相關性,則得到的結果將更加準確。

3 目標表示法

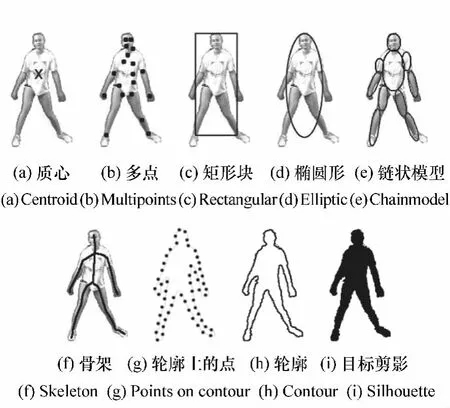

跟蹤目標可被定義成任何便于進一步分析的目標,如船、魚、車、飛機、行人等,在特定領域是一系列重要跟蹤目標。首先描述跟蹤常用目標形狀表示法,然后描述節點形狀和外觀表示法。

(1)點。如圖1(a)質點和圖1(b)多點。一般情況下,適合于圖像占很小區域的目標。

(2)簡單的幾何形狀。目標的形狀用矩形、橢圓表示,如圖1(c),(d)。通常用轉移、仿射或投影(單應性)轉換來構造這些表現形式的物體的運動模型。

圖1 目標表示Fig.1 Object representations

(3)鏈狀模型。目標由主體各部分組成,各部分通過節點連在一起。如人是腿、頭、腳等由節點鏈在一起的物體。各部分由運動學模型支配。可用圓柱或橢圓構造表示鏈狀物體部分模型,如圖1(e)。

(4)骨骼模型。目標的骨骼可以通過對物體剪影進行中間軸轉換提取出來。這種模型通常作為識別目標的一種形狀表示法。見圖1(f)。

(5)物體的剪影和輪廓。輪廓表示法定義了物體的邊界,如圖1(g),(h)。輪廓的中間區域被稱作物體的剪影,見圖1(i)。該法適合跟蹤復雜非剛性目標。

物體外觀特征有很多的表示方式,在跟蹤中形狀表示法也可以與外觀表示法相結合。在目標跟蹤環境中一些常見的外觀表示法有:

(1)物體外觀的概率密度。物體外觀的概率密度分為參數形式(如高斯分布和高斯分布的混合形式)和非參數形式(如密度評估窗體[1]或直方圖)。

(2)模板。模板由簡單的幾何形狀或輪廓構成。模板的優勢在于它可以同時包含空間和外觀信息。但是模板只能編碼從單一視角產生的目標外觀。

(3)主動外觀模型。對物體形狀外觀同時建模。通常由一系列標記定義。該模型要求能從一系列樣本中識別形狀和相應外觀瞄準位,如主成分分析。

(4)多視角外觀模型。該模型對物體不同視角編碼。一種方法是從給定視角中產生一個子空間。另一種是通過一系列分類器(支持向量機[2]和貝葉斯網絡[3])。該模型需要提前形成所有視角外觀。

通常目標表示法與跟蹤算法密切聯系。根據應用領域選擇目標表示法。對于非常小的目標適合用點表示法。文獻[4]用點表示法跟蹤移動盤子序列中的種子。文獻[5]用點表示法跟蹤遙遠鳥群。簡單幾何形狀表示法適合形狀近似矩形或橢圓的目標。文獻[6]用橢圓形表示法從橢圓區域計算顏色直方圖來對外觀建模。文獻[7]用特征向量表示外觀。對于復雜形狀的目標(如人體),適合用輪廓或剪影表示法。文獻[8]在監視應用中用剪影進行目標跟蹤。

4 目標跟蹤技術的研究現狀

目標跟蹤的目的[9]是定位目標在每幀視頻圖像中的位置,產生目標運動軌跡。跟蹤器能得到目標在每幀中的圖像區域。目標跟蹤可以依據目標類型分為點目標跟蹤和對于目標占有一定區域有紋理、輪廓等特征的目標跟蹤兩種情況,下面分別介紹,后者可分為基于特征點檢測的方法、基于背景相減的幀差法、基于分割思想的方法、基于監督學習的方法及基于目標形狀輪廓等特征的方法。

4.1 點目標跟蹤

跟蹤可以表述為不同幀中檢測目標間的通信。在目標阻塞、誤檢測、進入和退出情況下,點通信是復雜問題。其可分為兩大類:

(1)通信的確定性方法

確定性方法使用定性運動啟發法來約束通信問題,其定義了用運動約束將t-1幀中的目標與t幀中的目標結合起來的成本。通信成本最小化是組合優化問題。Shafique[5]提出了一種多幀方法來保持速度和位置的當前一致性,將通信表示成一個用曲線圖表示的理論問題。多幀通信是為了發現到達每個點最好的唯一路徑。對于誤檢測或阻塞目標,路徑將包含相應幀的失蹤位置。產生定向圖表,然后通過貪婪算法建立通信。圖2為此算法跟蹤鳥的結果。

圖2 Shafique方法跟蹤鳥群Fig.2 Tracking birds using the Shafique's algorithm

(2)通信的統計學方法

概率統計方法進行目標測量,其通過在目標狀態估計中考慮測量和模型不確定性來解決跟蹤問題。統計學通信方法使用狀態空間方法對目標性能(如位置、速度和加速度)進行建模。對于單個目標且初始狀態和噪音是高斯分布,則可以用濾波器進行理想狀態估算。濾波分預測和改正。如果不是線性函數,可用Taylor展開來得到擴展濾波器,從而使其線性化。當使用卡爾曼或質點濾波器跟蹤多重目標時,須將特定目標最可能的測量與目標狀態連接起來,即在這些濾波器應用前需解決通信問題。但是如果目標彼此距離太近,往往會導致通信不準確。聯合概率數據關聯(JPDAF)和多假設跟蹤(MHT)是兩種廣泛應用于數據關聯技術的方法。

4.2 基于特征點檢測的目標跟蹤方法

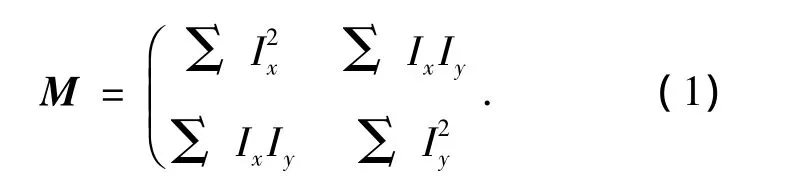

特征點在跟蹤問題中已廣泛使用。其特性是不隨光照和照相機視角的改變而改變。常用的特征點包括 Moravec 特征[10],Harris[11],KLT[12]和SIFT[13]。

Moravec工具計算4×4區域內水平、垂直、右斜線線和左斜線方向的圖像灰度差,選擇4個值中的最小值作為窗口的代表值。若該值在一個12×12的區域中是局部最大值,則為特征點。

Harris計算圖像水平和垂直方向的一階導數表示各方向上的灰度差,可用一個二維矩陣M表示。

特征點可由M行列式識別,M的跡用來測量局部鄰域R=del(M)-k·tr2(M)中的差值,其中k是常量。特征點通過R與指定的值進行比較得到,效果見圖3(a)。方程(1)中的矩陣M在KLT跟蹤方法特征點探測中也用到。特征點置信度R由M的最小特征值計算出。候選特征點通過閾值選出。KLT去掉了空間距離很近的候選點(圖3(b))。本質上Harris和KLT相似都強調灰度差。Harris中R與計算M特征值的特征多項式有關,KLT直接計算特征值。實際上他們找到的特征點幾乎相同,唯一不同的是KLT預先定義了被檢測特征點的空間距離。理論上M矩陣對旋轉和移動不變,但在仿射和投影變換中并非一成不變。

圖3 感興趣點檢測Fig.3 Interest points detected by applying

考慮不同轉換中特征點的穩定性,Lowe提出SIFT(尺度不變性特征)方法,分4步:首先用高斯濾波器以不同比例對圖像濾波產生尺度空間,從最大和最小高斯圖像中選出特征點。然后內插入鄰近像素點的顏色值以更新每個候選點坐標;差別小的候選點和沿邊緣的候選點被去除;最后根據候選點周圍鄰近區域的梯度方向直方圖安排特征點方向。相對其他特征點,SIFT[14]產生更多特征點是因為其以不同比例和分辨率累加的。文獻[15]表明SIFT比大部分特征點對圖像變化適應性更好。

4.3 基于幀差法的目標跟蹤方法

通過找出構造的背景模型中每幀差異進行跟蹤。背景模型中圖像區域的任何顯著變化都可能是運動物體。為進一步處理,對區域中正在變化的像素點做標記,用相關聯算法來獲得與目標相一致的關聯區域,這個過程為背景減法。Wren[16]用3D(YUV空間)高斯算法對靜態背景中各像素點顏色建模。標記背景模型中偏離的像素點為顯著像素點。但單高斯分布不適合用于戶外場景[17],因為在某一坐標點上由于重復的物體運動、陰影或反射可能會觀察到多重顏色。通過使用多統計模型來描述每個像素的背景顏色使背景模型獲得很大改善。

Elgammal[18]使用無參數內核密度估計來對各像素背景建模。減法過程中當前像素點不僅與背景模型中相應像素點匹配,還和鄰近像素坐標位置相匹配,可以處理背景中的照相機抖動或微小運動。

Rittscher[19]用隱式馬爾科夫模型(HMM)按照像素屬于背景、前景或陰影進行圖像分塊。Stenger[20]使用HMMs對光源時亮時暗的事物進行背景相減。HMMs優勢是用訓練樣本獲得某些用無監督背景建模方法很難精確建模的事物。

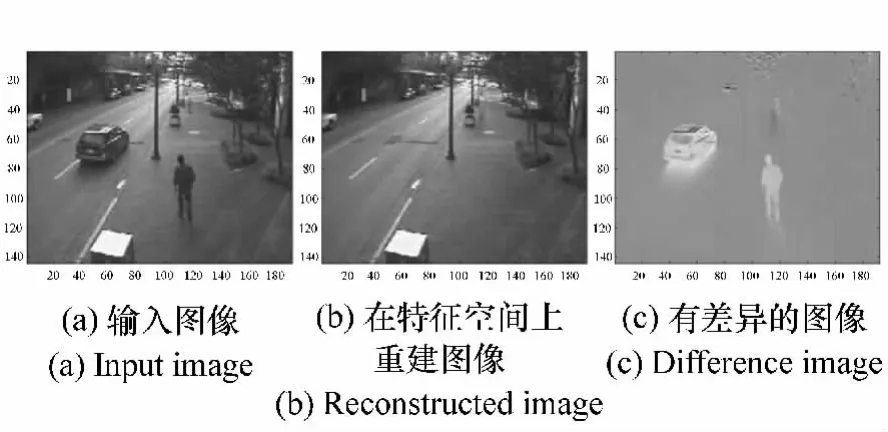

Oliver[21]不是根據單個像素的差值建模,而提出使用特征空間分解的一種整體方法。背景由特征矢量描述,實現視角(FOV)中所有可能的光照。因此,該方法對光照更不敏感。通過當前圖像到特征空間并發現重建圖像和實際圖像的不同來檢測前景目標。圖4中為目標檢測結果。

圖4 特征空間基于分解的背景相減Fig.4 Eigenspace decomposition-based background subtraction

Monnet[22]和 Zhong[23]提出的方法可處理隨時間變化的背景,其圖像區域采用自回歸運動平均(ARMA)進行建模,可以預測場景中的運動模式。

4.4 基于分割思想的目標跟蹤方法

圖像分割算法的目的是有感知地將圖像分成相似的區域。每個分割算法都強調了一個好的分割標準和獲得有效分割的方法。本文在這個部分將討論近代與目標跟蹤相關的分割技術。

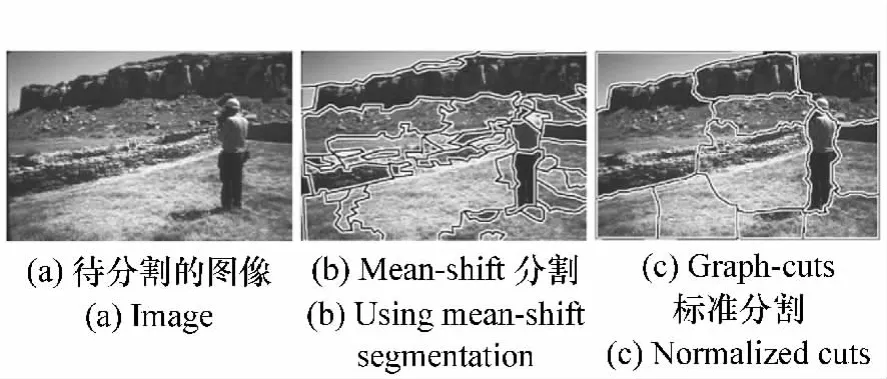

(1)Mean-Shift聚集

對于圖像分割問題,Comaniciu[24]提出 meanshift方法用以發現空間和顏色交接點的空間中的簇[l,u,v,x,y],其中[l,u,v]表示顏色,[x,y]表示空間位置。mean-shift矢量迭代計算直到簇中心的位置不再改變。在mean-shift迭代期間,一些簇可能發生合并。圖5(b)為mean-shift方法分割的圖像。基于分割的Mean-shift算法各參數(如顏色選擇、空間內核帶寬和區域最小化閾值)對分割結果有很大影響。

圖5 分割結果Fig.5 Segmentation result

(2)使用Graph-Cuts的圖像分割

圖像分割也可表達成一個圖表分割問題,通過修剪圖表權重邊緣將其分解成N個分離子圖表(區域)。兩個子圖之間的修剪邊緣權重總和成為切口。權重通過兩個節點間的顏色、亮度或紋理相似性計算出。使用最小化切口標準實現切口最小分割方式。

最小化切口的局限性在于它的斜紋朝向圖像切割的上部分。這種效果是因為隨著橫跨兩個切割塊的邊緣的增加,切口的成本增加。在圖5(c)展示了通過標準化切口的方法得到的分割結果。

(3)主動輪廓

該結構中,可通過將封閉輪廓演變成目標邊界,將輪廓緊緊圍繞目標區域,從而獲得目標分割。輪廓演變由輪廓對于假定目標區域的合適性決定。

基于輪廓方法的一個重要問題是輪廓初始化;另一個是選擇正確輪廓表示法。目標輪廓Γ可明確地用控制點V或含蓄地用等值面φ表示。明確表示法,控制點間的關系定義成曲線等式。含蓄法定義成等值面網格的0交叉口。含蓄法比明確法的優勢是能靈活適應拓撲變化(分離和合并)。

4.5 基于監督學習的目標跟蹤方法

通過監督學習方法從一系列樣本中自動學習不同的物體視圖,從而進行目標檢測跟蹤。不同的目標視圖的學習不需要一個完整系列的模板。通過一系列學習樣本,監督學習方法產生一個輸入到輸出的映射函數。對目標檢測,學習樣本由成對的目標特征和相關聯的目標種類組成,樣本數量手動定義。

特征選擇在分類中起著重要作用,如面積、方向、外觀和直方圖等。一旦特征被選擇,可通過監督學習目標的不同外觀(包括神經網絡[25]、自適應推進[26]、決策樹[27]和支持向量機[28])計算出一個超曲面用以在高維度空間將目標類與其他類分離。

監督學習方法要求從目標種類中收集大量樣本,這些樣本須手動貼標簽。減少手動標簽量的一種方法是協同訓練[29]。事實表明,從兩個有獨立特征的標簽數據集中的一個小集合開始,協同訓練可提供一個非常精確的分類原則,以減少自適應增強環境中訓練時手工交互的數量[30]。下面將討論自適應增強和支持向量機。

(1)自適應增強

增強[31]是一種迭代方法,它通過結合眾多比較精確的基本分類器發現一個非常精確的分類器。在自適應增強算法訓練階段,第一步是在訓練集上構造權重初始分布;然后增強設備選擇一個錯誤最少的基本分類器,其中錯誤與錯誤分類數據的權重成比例;其次,與通過選擇的基本分類器錯誤分類的數據相聯系的權重增加。因此,這個算法鼓勵在下一次迭代中選擇在錯誤分類數據上表現更好的其他分類器。Viola[26]使用自適應增強框架檢測行人。

(2)支持向量機

作為一個分類器,支持向量機(SVM)通過找到將類別區分開的最大邊緣的超曲面將數據聚簇成兩種類別。最大化的超曲面邊緣定義成超曲面和最近數據點間的距離。在超曲面邊緣的數據點稱為支持矢量。在目標檢測的環境中,這些種類與目標種類(真實樣本)和非目標種類(底片樣本)一致。從手動產生的標簽訓練樣本作目標和非目標,通過二次規劃編程計算大量超曲面。

盡管SVM是線性分類器,它也可用核方法從輸入中提取輸入特征矢量作為非線性分類器。Papageorgiou[28]用 SVM 檢測圖像中的行人和臉部。

4.6 基于目標的形狀輪廓等特征的目標跟蹤方法

內核跟蹤是通過計算簡單目標每一幀運動狀態來實現的,一幀代表一個運動狀態。目標的運動狀態由運動參數(平移、旋轉、仿射變換等)或者由后面幀的密集流場組成。從外觀表示、跟蹤目標的數目、估計目標運動的方法來區分內核跟蹤算法的不同。從外觀表示這個角度,內核跟蹤算法分成:模板和基于密度的外觀模型、多視角的外觀模型、形狀匹配和輪廓跟蹤。

(1)模板和基于密度的外觀模型的跟蹤

由于相對簡單和低計算成本,模板和基于密度的外觀模型被廣泛應用。根據被跟蹤目標是否是單獨還是聯合把該跟蹤方法再分成兩個子類。

跟蹤單目標最常用的方法是模板匹配。模板匹配是一種窮盡搜索方法。當前圖像在模板中的位置用相似度測量方法(例如交叉相關)。

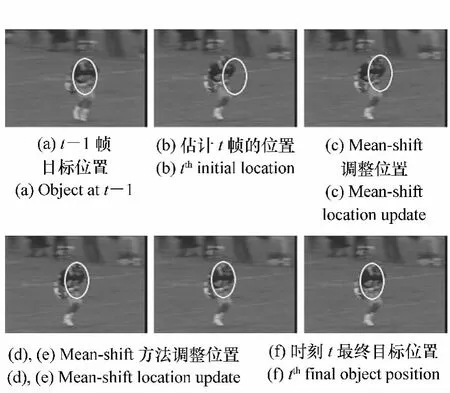

Comaniciu[6]從一個圓形區域計算出一個加權[32]直方圖來表示目標。用Mean-shift方法去定位目標,通過反復對比目標直方圖Q和假設目標位置窗口P來最大化外觀相似性Bhattacharya系數。圖6為mean-shift跟蹤結果。其與標準模板匹配相比,最明顯優點是未采用窮盡搜索方法而是用幾次迭代方法來計算目標區域的變換。

圖6 Mean-shift跟蹤迭代Fig.6 Mean-shift tracking iterations

另一個跟蹤簡單形狀區域的方法是光流法。光流法是在灰度恒定的約束條件下通過代數或者幾何方法計算每個像素點的流失量用來生成密集的流場。Shi和Tomasi提出了KLT跟蹤器,一旦捕捉到興趣點的新位置,在接下來的多幀中KLT跟蹤器在這個新位置的相應區域通過計算仿射變換來估計被跟蹤區域的特性。如果當前區域和仿射區域的平方差總和小,將繼續跟蹤特征;否則特征就會被排除。

Isard[33]提出了前景和背景的聯合模型跟蹤。背景的外觀是由混合高斯模型表示的,所有的前景目標的外觀同樣如此。用圓柱體為這些目標的形狀建模。假設地平面是已知的,三維目標的位置可以計算出來。用粒子濾波器[34-35]中的狀態向量(包括場景中所有3D目標位置、形狀和運動速度)實現跟蹤。他們為粒子濾波器提出了一個修正預測和校正計劃方案,這個方案可以增加或減少狀態向量的大小從而添加或刪除目標,同時也可以忽略目標間的遮擋。但是場景中目標最大數目需預先設定,另外一個缺陷是對所有的前景目標使用同樣的外觀模型,因此對前景區域的建模需要培訓。

(2)用多視覺的外觀模型跟蹤

前面介紹的跟蹤方法中,外觀模型如直方圖、模板等通常在線生成。目標從不同角度看各不相同,如果在跟蹤過程中某個目標的視角變化較大,那么它的外觀模型將不再有效,跟蹤可能丟失。為克服這個問題目標不同視角可離線學習并用來跟蹤。

Black[7]提出了一個基于子空間的方法,用特征向量計算目標的當前圖像到目標的重構圖像的仿射變換。首先,用主成分分析來建立子空間上目標的外觀表示。然后,用一個子空間不變方程估算利用特征向量重構的圖像和原始圖像的差別,計算圖像到其特征方程的轉換。找到子空間的系數,計算仿射參數。反復估算仿射參數,直到原始圖像和預計圖像之間的差別達到最小,跟蹤完成。

(3)形狀匹配

形狀匹配方法是查找當前幀目標的輪廓和它相關聯的模型,根據上一幀中生成的虛擬目標輪廓模型計算目標的相似度來完成查找,輪廓僅僅從上一幀平移到下一幀,因此并不能很精確的處理非剛性物體的運動。對于用邊緣圖像表示的目標模型,每幀被定位后再重新處理目標的外觀變化。這種方法不僅可以克服視角變化和光照環境變化引起的跟蹤問題,同時可以處理非剛性目標的運動。Li[36]提出用 Hausdorff距離來驗證運動軌跡和姿態匹配問題。計算內部的虛擬輪廓來估算光流矢量,根據平均的光流失量得到目標的新的位置,這樣就可以完成跟蹤。

(4)輪廓跟蹤

輪廓跟蹤方法是相對于形狀匹配方法來說的,其迭代逐步形成了前一幀中初始輪廓在當前幀中的新位置。這個輪廓逐步形成的過程要求前一幀中的目標區域和當前幀目標區域有部分重疊。輪廓跟蹤用兩種方法可以實現,第一種方法用卡爾曼濾波或粒子濾波實現狀態空間模型對輪廓的形狀和運動建模;第二種方法是直接演變輪廓,即通過直接最小化方法(如梯度下降法)來最小化輪廓能源。

圖7 用水平集方法對車輛進行跟蹤Fig.7 Car tracking using the level sets method

Mansouri[37]用水平集方法進行輪廓跟蹤,用于半徑為r的環形鄰近的完整目標區域內窮盡搜索每個像素計算流失量。一旦流失量計算出來,基于恒定亮度約束的輪廓能源也被估算出來。這個過程反復進行直到輪廓能源達到最小。圖7為輪廓跟蹤結果。

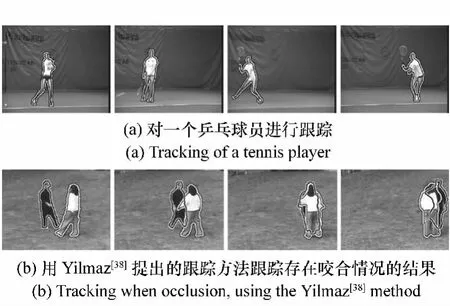

Yilmaz[38]用基于形狀模型的水平集方法為目標形狀和變化建模。基于形狀模型的水平集解決了跟蹤期間目標相互咬合遮擋的問題(圖8(b))。

圖8 輪廓跟蹤的結果Fig.8 Contour tracking results

5 目標跟蹤研究的難點及未來發展方向

近年來目標跟蹤技術發展取得了很大進步[62]。研發出了多個性能優良的跟蹤器,可以在簡單場景中實時跟蹤目標。應用假設可以使跟蹤的問題簡單化(如平滑的運動、少量阻塞、光照恒定性、高對比度背景等),但這些假設在現實場景中是不存在的,限制了其在自動化監控、人機交互、視頻檢索、交通監控、車輛導航等應用領域的應用。跟蹤的難點在于:

(1)目標外觀隨時間而變化,如尺度變化、旋轉、超平面旋轉、光照變化引起的目標顏色劇烈及不均勻變化、非剛體形變、視角變化引起的外觀變化等;

(2)背景復雜多變,使建模難度增加且目標容易淹沒在背景中;

(3)多個目標出現咬合阻塞現象的處理;

(4)由于相機不穩、相機幀頻、傳感器等原因造成高速運動目標的模糊;

(5)完全遮擋或丟失后造成的時間不連續,而后目標重新出現;

發展不受約束、長期穩定的目標跟蹤算法是未來的發展趨勢也是挑戰。因此,研究更有效的目標表示方法以及目標相似性度量方法以適應目標的外觀變化是重要的研究方向。同時對于基于學習的智能算法仍需研究并引入以應對目標隨時間的變化,監督學習需要大量人工干預,半監督學習近年來已被眾多學者所研究并在目標跟蹤方面有很高的研究和應用價值。另外,無論是基于檢測思想的還是基于時間關聯性跟蹤的方法,對于目標的有效搜索都是一個關鍵問題,基于粒子濾波、均值漂移、金字塔搜索等跟蹤算法仍有進一步研究的價值,同時對于其他學科中np問題的解法等也可以引入跟蹤搜索,以提高算法效率和執行速度,針對特定的場景利用一些附加信息,進行上下情景信息的融合,可以使跟蹤更有效。

6 結束語

本文闡述了目標跟蹤的基本概念以及其應用領域與價值[39-41],詳細分析了目標表示方法、目標跟蹤的研究現狀,最后指出了難點和趨勢,相信通過眾多學者的共同努力,更多魯棒、高效、長期穩定的目標跟蹤算法會不斷涌現。

[1] ELGAMMAL A,DURAISWAMI R,HARWOOD D,et al..Background and foreground modeling using nonparametric kernel density estimation for visual surveillance[J].IEEE,2002,90(7):1151-1163.

[2] AVIDAN S.Support vector tracking[J].IEEE Trans.Patt.Analy.Mach.Intell.,2004,26(8):1064-1072.

[3] PARK S,AGGARWAL J K.A hierarchical bayesian network for event recognition of human actions and interactions.Multimed[J].Syst.,2004,10(2):164-179.

[4] VEENMAN C,REINDERS M,BACKER E.Resolving motion correspondence for densely moving points[J].IEEE Trans.Patt.Analy.Mach.Intell.,2001,23(1):54-72.

[5] SHAFIQUE K,SHAH M.A non-iterative greedy algorithm for multi-frame point correspondence[J].IEEE Trans.Patt.Analy.Mach.Intell.,2005,27(1):110-115.

[6] COMANICIU D,RAMESH V,MEER P.Kernel-based object tracking[J].IEEE Trans.Patt.Analy.Mach.Intell.,2003,25:564-575.

[7] BLACK M,JEPSON A.Eigentracking:robust matching and tracking of articulated objects using a view-based representation[J].Int.J.Comput.Vision,1998,26(1):63-84.

[8] HARITAOGLU I,HARWOOD D,DAVIS L.W4:real-time surveillance of people and their activities[J].IEEE Trans.Patt.Analy.Mach.Intell.,2000,22(8):809-830.

[9] 馮小勇,趙忠華,劉新明.日間恒星實時探測的視頻圖像處理[J].中國光學,2011,4(6):622-628.FENG X Y,ZHAO ZH H,LIU X M.Video image processing of real-time star detection in daylight[J].Chinese J.Optics,2011,4(6):622-628.(in Chinese)

[10] MORAVEC H.Visual mapping by a robot rover[C].Proceedings of the International Joint Conference on Artificial Intelligence(IJCAI),San Francisco,USA,August 20,1979:598-600.

[11] HARRIS C,STEPHENS M.A combined corner and edge detector[C].In 4th Alvey Vision Conference,August 31-September 2,1988:147-151.

[12] SHI J,TOMASI C.Good features to track[C].IEEE Conference on Computer Vision and Pattern Recognition(CVPR),Seattle,WA,June 21-32,1994:593-600.

[13] LOWE D.Distinctive image features from scale-invariant keypoints[J].Int.J.Comput.Vision,2004,60(2):91-110.

[14] 郝志成,高文.多模跟蹤技術在輪式偵察車圖像處理器的應用[J].中國光學,2011,4(5):480-488.

HAO ZH CH,GAO W.Application of multi-pattarn tracking technique in image processor of wheel type scout car[J].Chinese J.Optics,2011,4(5):480-488.(in Chinese)

[15] MIKOLAJCZYK K,SCHMID C.A performance evaluation of local descriptors[J].IEEE Trans.Patt.Analy.Mach.Intell.,2005,27(10):1615-1630.

[16] WREN C,AZARBAYEJANI A,PENTLAND A.Pfinder:Real-time tracking of the human body[J].IEEE Trans.Patt.Analy.Mach.Intell.,1997,19(7):780-785.

[17] GAO X,BOULT T,COETZEE F,et al..Error analysis of background adaption[C].IEEE Conference on Computer Vision and Pattern Recognition(CVPR),Hilton Head Island,SC,June 13-15,2000:503-510.

[18] ELGAMMAL A,HARWOOD D,DAVIS L.Non-parametric model for background subtraction[C].In European Conference on Computer Vision(ECCV),Dublin,Ireland,June 26-July 1,2000,2:751-767.

[19] RITTSCHER J,KATO,JOGA S,et al..A probabilistic background model for tracking[C].In European Conference on Computer Vision(ECCV),Dublin,Ireland,June 26-July 1,2000,2:336-350.

[20] STENGER B,RAMESH V,PARAGIOS N,et al..Topology free hidden markov models:application to background modeling[C].IEEE International Conference on Computer Vision(ICCV),Vancouver,BC,July 7-14,2001:294-301.

[21] OLIVER N,ROSARIO B,PENTLAND A.A bayesian computer vision system for modeling human interactions[J].IEEE Trans.Patt.Analy.Mach.Intell.,2000,22(8):831-843.

[22] MONNET A,MITTAL A,PARAGIOS N,et al..Background modeling and subtraction of dynamic scenes[C].IEEE International Conference on Computer Vision(ICCV),Nice,France,October 13-16,2003:1305-1312.

[23] ZHONG J,SCLAROFF S.Segmenting foreground objects from a dynamic textured background via a robust kalman filter[C].IEEE International Conference on Computer Vision(ICCV),Nice,France,October 13-16,2003:44-50.

[24] COMANICIU D,MEER P.Mean shift:a robust approach toward feature space analysis[J].IEEE Trans.Patt.Analy.Mach.Intell.,2002,24(5):603-619.

[25] ROWLEY H,BALUJA S,KANADE T.Neural network-based face detection[J].IEEE Trans.Patt.Analy.Mach.Intell.,1998,20(1):23-38.

[26] VIOLA P,JONES M,SNOW D.Detecting pedestrians using patterns of motion and appearance[C].IEEE International Conference on Computer Vision(ICCV),Nice,France,October 13-16,2003:734-741.

[27] GREWE L,KAK A.Interactive learning of a multi-attribute hash table classifier for fast object recognition[J].Comput.Vision Image Understand,1995,61(3):387-416.

[28] PAPAGEORGIOU C,OREN M,POGGIO T.A general framework for object detection[C].IEEE International Conference on Computer Vision(ICCV),January 4-7,1998:555-562.

[29] BLUM A,MITCHELL T.Combining labeled and unlabeled data with co-training[C].11th Annual Conference on Computational Learning Theory,July 24,1998:92-100.

[30] LEVIN A,VIOLA P,FREUND Y.Unsupervised improvement of visual detectors using co-training[C].IEEE International Conference on Computer Vision(ICCV),Nice,France,October 13-16,2003:626-633.

[31] 顏佳,吳敏淵.遮擋環境下采用在線Boosting的目標跟蹤[J].光學 精密工程,2012,20(2):439-446.

YAN J,WU M Y.On-line boosting based target tracking under occlusion[J].Opt.Precision Eng.,2012,20(2):439-446.(in Chinese)

[32] 匡金駿,柴毅,熊慶宇.結合標準對沖與核函數稀疏分類的目標跟蹤[J].光學 精密工程,2012,20(11):2540-2547.

KUANG J J,CHAI Y,XIONG Q Y.Visual object tracking combined normal hedge and kernel sparse representation classification[J].Opt.Precision Eng.,2012,20(11):2540-2547.(in Chinese)

[33] ISARD M,BLAKE A.Condensation-conditional density propagation for visual tracking[J].International J.Computer Vision,1998,29(1):5-28.

[34] 王國良,劉金國.基于粒子濾波的多自由度運動目標跟蹤[J].光學 精密工程,2011,19(4):864-869.

WANG G L,LIU J G.Moving object tracking with multi-degree-of-freedom based on particle filters[J].Opt.Precision Eng.,2011,19(4):864-869.(in Chinese)

[35] 龔俊亮,何昕,魏仲慧,等.采用改進輔助粒子濾波的紅外多目標跟蹤[J].光學 精密工程,2012,20(2):413-421.

GONG J L,HE X,WEI ZH H,et al..Multiple infrared target tracking using improved auxiliary particle filter[J].Opt.Precision Eng.,2012,20(2):413-421.(in Chinese)

[36] LI B,CHELLAPPA R,ZHENG Q,et al..Model-based temporal object verification using video[J].IEEE Trans.Image Process,2001,10(6):897-908.

[37] MANSOURI A.Region tracking via level set pdes without motion computation[J].IEEE Trans.Patt.Analy.Mach.Intell.,2002,24(7):947-961.

[38] YILMAZ A,LI X,SHAH M.Contour based object tracking with occlusion handling in video acquired using mobile cameras[J].IEEE Trans.Patt.Analy.Mach.Intell.,2004,26(11):1531-1536.

[39] 丘文濤,趙建,劉杰.結合區域分割的SIFT圖像匹配方法[J].液晶與顯示,2012(6):827-831.

QIU W T,ZHAO J,LIU J.Image matching algorithm combining SIFT with region segmentation[J].,2012(6):827-831.(in Chinese)

[40] 王田,劉偉寧,韓廣良,等.基于改進MeanShift的目標跟蹤算法[J].液晶與顯示,2012(3):396-400.

WANG T,LIU W N,HAN G L,et al..Target tracking algorithm based on improved meanshift[J].,2012(3):396-400.(in Chinese)

[41] 李麗,李平,楊明,等.基于SIFT特征匹配的電力設備外觀異常檢測方法[J].光學與光電技術,2010,8(6):25-31.

LI L,LI P,YANG M,et al..Research on abnormal appearance detection approach of electric power equipment[J].Opt.Optoelectronic Technol.,2010,8(6):25-31.(in Chinese)