基于智能相機的混合交通流檢測方法

魏 巍,李志慧,趙永華,曲昭偉,江 晟,柴婷婷

(1.吉林大學 交通學院,長春 130022;2.吉林大學 計算機公共教學中心,長春 130022)

0 引 言

目前,交通視頻監控通常利用道路兩側的攝像頭獲取道路圖像信息,傳輸到交通監控中心集中分析處理,形成了巨大的通信量,增加了多路圖像信息集中并發處理的困難。混合交通是我國交通的重要組成部分,但目前尚缺乏混合交通流參數檢測的方法和設備。為了降低交通監控過程巨大通訊量和滿足高效便捷的混合交通流參數檢測的需要,研發面向混合交通流檢測的智能相機分布式設備,實現單點攝像機圖像信息處理,直接應用于交通信號控制的設備或交通監控中心尤為重要。

嵌入式設備具有高效、便捷、低能耗等優點,近年來國內外研究人員開展了將嵌入式技術應用在交通監控領域的研究。如:Bramberger等[1-2]采用LM-9618CMOS傳感器與雙TMS320DM642DSP芯片等構建智能相機硬件框架體系與原型,利用高斯背景差分和前景閾值分割檢測車輛;Arth[3]等利用三個TMS320C6414DSP芯片與外置攝像頭構建智能相機框架體系與原型,通過中值背景估計、前景差分分割、攝像機參數映射、Viola-Jones檢測、CAMShift預處理和Kalman跟蹤等算法檢測與跟蹤運動車輛;Wei等[4]利用圖像捕獲單元、FPGA視頻分析處理單元、圖像顯示單元構建智能相機框架體系與原型檢測車輛信息,其中FPGA視頻分析處理單元由Harris交點檢測、局部二進制模式分類與分析等構成;Houben[5]等利用CMOS傳感器、FPGA和嵌入式工業PC構建智能相機原型,采用Harris交點和邊緣信息進行3D重構、聚類和跟蹤檢測運動車輛;Macesic[6]等利用OMAP平臺,通過Kalman濾波器跟蹤車輛,獲取物體的軌跡,檢測異常軌跡,實現交通事件預警。上述相關研究促進了嵌入式智能相機技術在交通監控領域的發展,但這些研究仍局限于交通車輛單一交通流形態的檢測,缺乏混合交通流檢測的研究,無法滿足我國混合交通的應用需要。

針對目前缺乏混合交通視頻檢測智能設備的問題,本文利用CCD傳感器與DSP芯片構建了智能相機框架體系和硬件原型系統,采用背景初始化、背景模型與前景獲取、物體分割、特征提取、多目標識別分類、攝像機參數標定等視頻圖像處理技術,構建了混合交通流檢測軟件方法體系,開發了相應的嵌入式算法系統,實現了混合交通流參數檢測。

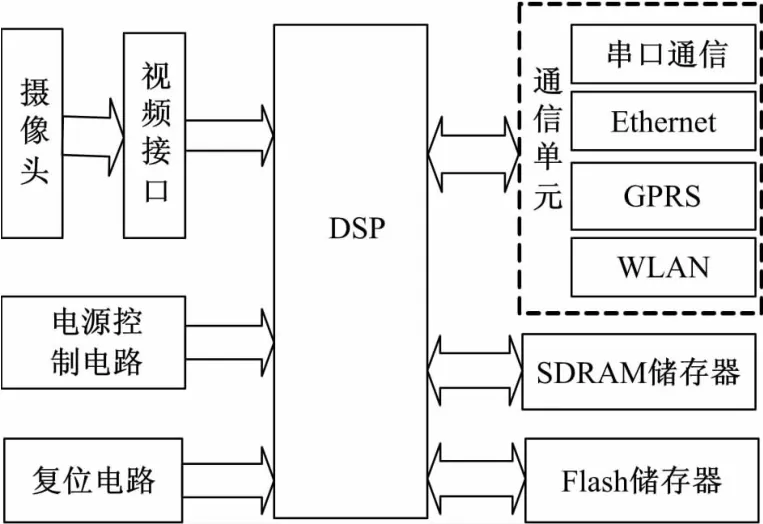

1 智能相機硬件架構

為降低道路監控攝像頭向監控中心傳輸的數據量,實現圖像采集后直接分析處理,處理數據傳輸至監控中心或交通信號控制機等。本文構建了圖1所示的混合交通流智能相機硬件體系結構。圖2為智能相機硬件原型系統。

圖1 混合交通視頻檢測智能相機硬件體系結構框圖Fig.1 Block diagram of the hardware architecture

圖2 混合交通視頻檢測智能相機硬件系統原型Fig.2 Prototype of the embedded DSP vision platform

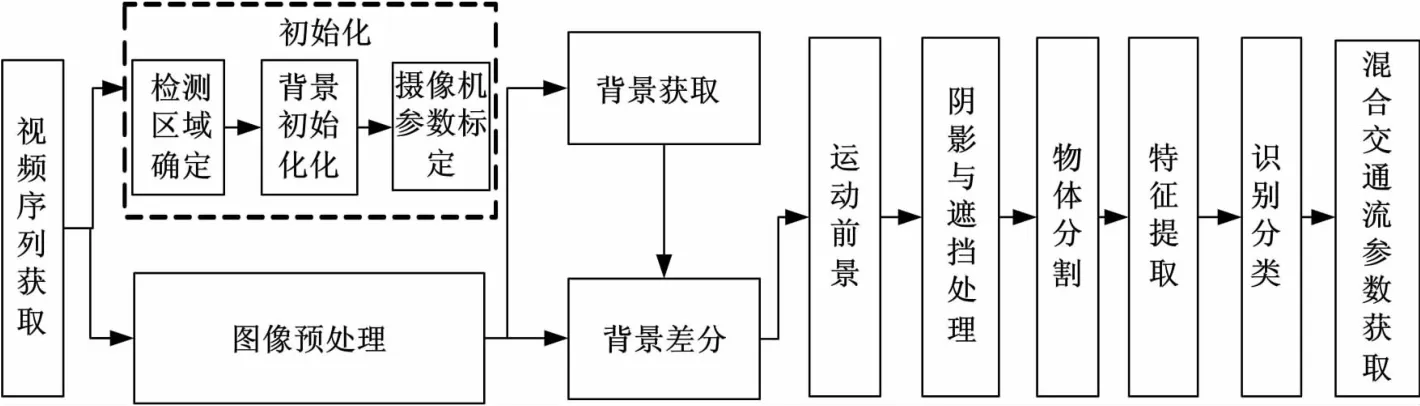

2 混合交通流檢測軟件框架體系

混合交通流智能檢測設備軟件系統的體系結構框圖,如圖3所示。

2.1 背景模型

通常利用背景差分獲取視頻場景中的運動前景,即實現行人、自行車、機動車檢測,如式(1)所示:

式中:Ft為當前時刻前景;It為當前視頻幀;Bt-1為前一時刻背景。

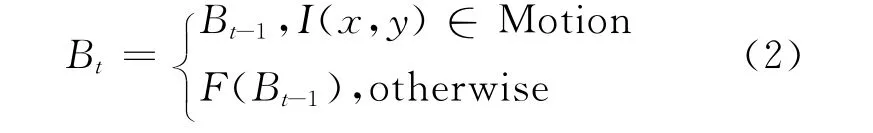

背景模型作為前景物體檢測的關鍵,受外界光照、環境等變化影響明顯。為有效獲取混合交通背景,本文采用了基于對象選擇更新的混合高斯背景模型[7],如式(2)所示:

圖3 混合交通視頻智能檢測設備檢測算法框圖Fig.3 Software Framework of Smart Device on Mixed Traffic Detection

其中F(Bt-1)為混合高斯背景模型更新過程,參見文獻[8]。該模型對存在感興趣運動物體的區域不更新,否則參照混合高斯背景模型選擇性更新。由式(2)可以看出,背景模型需要初始背景作為其零啟動,為獲取零啟動背景,本文采用基于聚類識別的背景初始化方法[9]獲取初始背景,該方法可滿足場景內包括運動前景物體或前景物體靜止遮擋率大于50%的應用環境。

2.2 攝像機參數標定

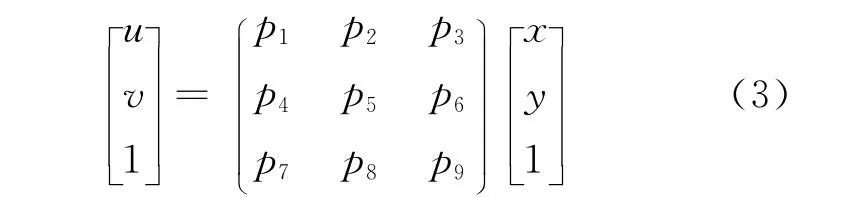

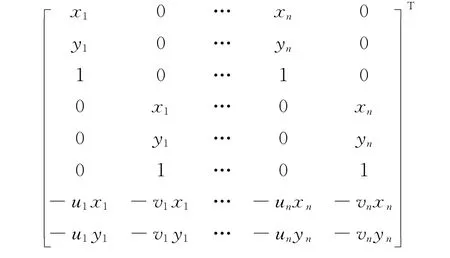

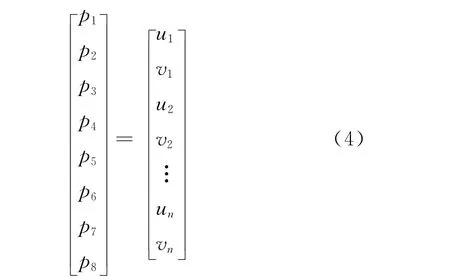

攝像機參數實現了圖像坐標與交通場景位置坐標的映射變換。為方便獲取攝像機內外參數,本文采用了黑箱攝像機標定方法[10]計算映射關系。通常圖像坐標與空間位置關系可表達為

式中:p矩陣表示攝像機內外參數。根據已知圖像坐標與空間位置坐標點對,利用最小二乘法估計求解映射變換p矩陣。為簡化p矩陣求解,令p9=1,則需要n(n≥4)對 {(xi,yi) ,(ui,vi)}對應點對構成2n個線性方程求解p矩陣,該方程組表達為

根據式(4),可利用最少4對參照點計算求解映射變換p矩陣,獲取空間坐標與圖像坐標之間的映射關系。該方法與傳統方法相比,僅需一幅模板圖像,降低了特征點與模板個數,簡化了計算,且具有穩定性強、計算精度高的特點。

2.3 前景物體識別分類

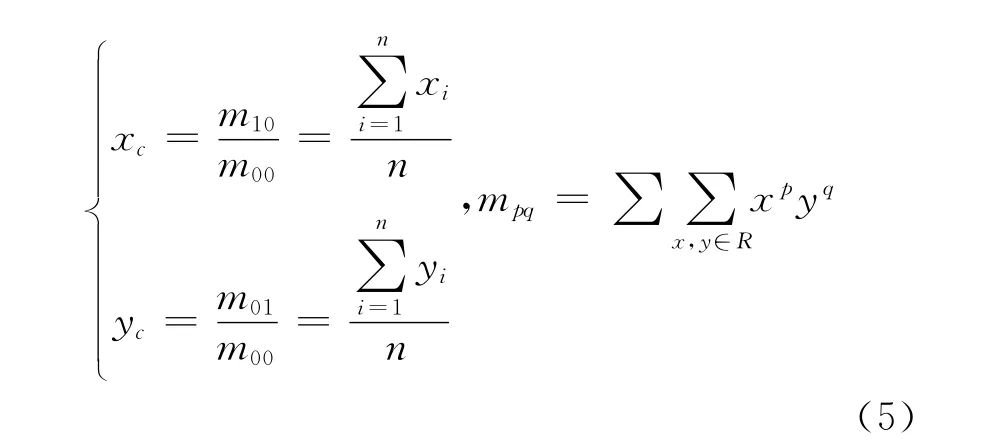

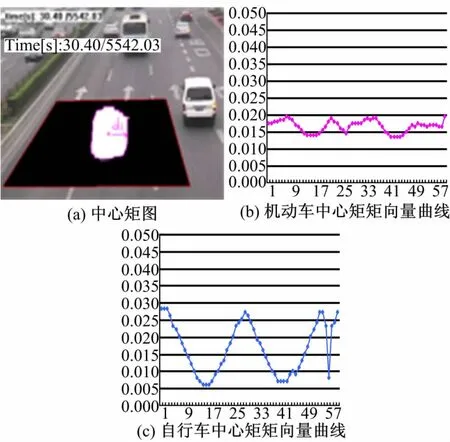

由于混合交通個體運動過程受形變、遮擋等影響,根據行人、機動車、自行車的幾何輪廓特點,本文構建了交通個體中心距向量特征表達方法,該方法具有較好的旋轉、伸縮、平移不變性。

為構建交通物體旋轉、伸縮、平移不變的特征,首先獲取物體重心G(xc,yc),其表達式為

式中:mpq為區域的pq階矩。

其次,選取區域邊緣上距離重心最遠點作為區域主方向,令重心作為極坐標中心,在[0,2π]范圍內按照逆時針方向旋轉,在每間隔θ角的方向上選取區域外邊緣點,獲取相應點與極坐標中心的距離,作為中心距li,則構成N維中心距向量l= [l1,l2,…,ln];最后,令中心距向量l除以中心距最大值l1,獲取歸一化的中心距向量l′=,實現混合交通個體特征提取與表達。

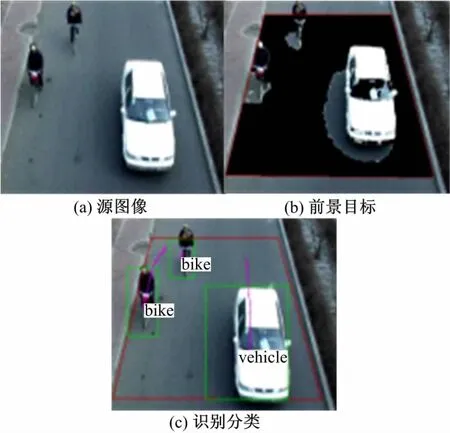

支持向量機(SVM)[11-13]作為基于統計學習的經驗風險最小化原則的一種監督式機器學習,其分類模式中利用相應的分類核函數將輸入向量映射到一個高維空間,然后根據最優化理論尋求分類器的范化誤差最小,獲取最優分類超平面,實現不同模式的分類識別。在訓練學習階段,本文選取行人、自行車、機動車與非交通個體樣本圖像訓練學習,訓練過程采用Ado boosting算法[14]對SVM的強、弱分類器分配不同權重系數加快樣本空間學習,建立其分類超平面,實現混合交通物體的分類識別。

3 實驗結果

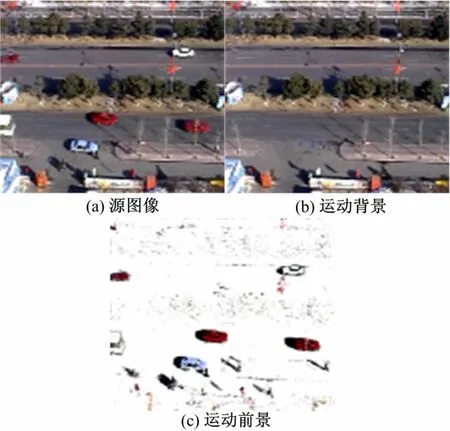

本文利用圖2所示的智能相機原型系統采集交通視頻圖像,采用本文構建的軟件算法對不同交通狀況下的混合交通流進行檢測實驗,其中圖4給出了運動背景與前景物體的檢測結果。圖5給出了不同混合交通物體的矩向量特征表示曲線形式,圖6給出了混合交通物體分類識別結果。從給定的實驗結果圖像可以看出,本文算法可以較好地獲取交通視頻的運動背景、前景、混合物體特征表達與識別分類。同時,為了檢驗本文算法的檢測性能,對不同交通狀態下的1400個混合交通物體識別分類準確度進行了測試,本文算法的識別準確度大于95%,反映了本文構建的混合交通流智能檢測相機具有較好的性能,可應用于混合交通流檢測。

圖4 長春市人民大街交通視頻處理結果Fig.4 Processing Result at Renmiing street site in Changchun

圖5 混合交通個體矩向量表達曲線圖Fig.5 Moment Vector Represent Curves of Mixed traffic object

圖6 混合交通個體識別分類結果Fig.6 Classification Results of Mixed Traffic Object

4 結 論

針對目前缺乏混合交通視頻檢測智能設備的問題,本文利用CCD傳感器與DSP芯片構建了智能相機框架體系和硬件原型系統,采用背景初始化、背景模型與前景獲取、物體分割、特征提取、多目標識別分類、攝像機參數標定等視頻圖像處理技術,構建了混合交通流檢測軟件方法體系,開發了相應的嵌入式算法系統,實現了混合交通流參數檢測。不同交通狀態下的測試結果反映了該系統具有良好的性能,可實現混合交通流參數檢測。本方法可為混合交通流智能相機的研發提供借鑒和參考。

[1]Bramberger M,Brunner J,Rinner B,et al.Real-time video analysis on an embedded smart camera for traffic surveillance[C]∥In:Real-Time and Embedded Technology and Applications Symposium,2004Proceedings RTAS 200410th IEEE,2004:174-181.

[2]Bramberger M,Roman P Pflugfelder,Maier Arnold,et al.A smart camera for traffic surveillance[C]∥Proceedings of the First Workshop on Intelligent Solutions in Embedded Systems;2003;Vienna University of Technology,Austria;2003:153-164.

[3]Arth C,Bischof H,Leistner C.TRICam-an embedded platform for remote traffic surveillance[C]∥Computer Vision and Pattern Recognition Workshop,2006 CVPRW'06Conference on,2006:125.

[4]Wei Bei-na,Shi Yu,Ye Ge-tian ,et al.Developing a smart camera for road traffic surveillance[C]∥Multimedia Signal Processing,2008IEEE 10th Workshop on,2008:826-831.

[5]Houben Q,Czyz J,Diaz J C Tocino,et al.Featurebased stereo vision using smart cameras for traffic surveillance[C]∥Fritz M,Schiele B,Piater JH,eds.Computer Vision Systems,Proceedings;2009:144-153.

[6]Macesic M,Jelaca V,Nino-Castaneda J O.et al.Realtime detection of traffic events using smart cameras[C]∥In:Proceedings of SPIE-IS and T Electronic Imaging-Intelligent Robots and Computer Vision XXIX:Algorithms and Techniques,Burlingame,CA,United states,2012.

[7]李志慧,張長海,曲昭偉,等.交通流視頻檢測中背景模型與陰影檢測算法[J].吉林大學學報:工學版,2006,36(6):993-997.Li Zhi-hui,Zhang Chang-hai,Qu Zhao-wei,et al.Background extraction model and shadow detection algorithm in traffic flow video detection[J].Journal of Jilin University(Engineering and Technology Edition),2006,36(6):993-997.

[8]Stauffer Chris,Grimson W E L.Adaptive background mixture models for real-time tracking[J].Proceedings of the IEEE Computer Society Conference on Computer Vision and Pattern Recognition,1999,2(Compendex):246-252.

[9]李志慧,張長海,曲昭偉,等.交通流視頻檢測中背景初始化算法[J].吉林大學學報:工學版,2008,38(1):148-151.Li Zhi-hui,Zhang Chang-hai,Qu Zhao-wei,et al.Background initialization algorithm in traffic flow video detection[J].Journal of Jilin University(Engineering and Technology Edition),2008,38(1):148-151.

[10]曲昭偉,陳紅艷,李志慧,等.基于單模板的二維場景重建方法[J].吉林大學學報:工學版,2007,37(5):1159-1163.Qu Zhao-wei,Chen Hong-yan,Li Zhi-hui,et al.2D view reconstruction method based on single calibration pattern[J].Journal of Jilin University(Engineering and Technology Edition),2007,37(5):1159-1163.

[11]Cortes Corinna,Vapnik Vladimir.Support-vector networks[J].Machine Learning,1995,20(3):273-297.

[12]Scholkopf B,Smola A J,Williamson R C,et al.New support vector algorithms[J].Neural Computation,2000,12(5):1207-1245.

[13]Scholkopf B,Platt J C,Shawe-Taylor J,et al.Estimating the support of a high-dimensional distribution[J].Neural Computation,2001,13(7):1443-1471.

[14]Rangel Pedro,Lozano Fernando,Garcia Elkin.Boosting of support vector machines with application to editing[C]∥ICMLA 2005:4th International Conference on Machine Learning and Applications,Los Angeles,CA,United States:Inst of Elec and Elec Eng Computer Society,2005:374-379.