基于特征貢獻度的特征選擇方法在文本分類中應用

孟佳娜, 林鴻飛, 李彥鵬

(1.大連理工大學計算機科學與工程系,遼寧大連 116024;2.大連民族學院理學院,遼寧大連 116600)

0 引 言

文本分類是信息檢索與數據挖掘領域的研究熱點問題,其核心任務為根據給定的訓練數據,構造高性能的分類器,實現對新文本的自動分類.在實際應用中,根據預定義類別的數量不同,分類系統可分為兩類分類器和多類分類器兩種.從文本所屬類別的個數來看,文本分類技術又可以分為單標簽和多標簽兩種.

文本分類的主要算法包括樸素貝葉斯方法[1、2]、KNN[3]、最大熵方法[4]、神經網絡[5]、支持向量機[6]方法等.最常用的文本特征表示模型是向量空間模型(vector space model,VSM),這種方法將分類文檔中出現的全部詞條作為特征,將分類空間視為一組正交詞條向量所張成的向量空間,原始空間的維數十分巨大,因此,找到一種有效的特征選擇方法顯得至關重要.文本分類中常用的特征選擇方法有文檔頻率(document frequency,DF)[7]、互信息(mutual information,MI)[7]、χ2統計(chi-square statistic,CHI)[7]及幾率比(odds ratio,OR)[8]等.文獻[7]比較了一些常用的特征選擇方法,并指出χ2統計和信息增益方法是最有效的,其次是文檔頻率和互信息.文獻[8]提出了幾率比的特征選擇方法,僅使用了多分類的樸素貝葉斯分類器在reuters-21578語料集上進行了實驗,并與其他方法進行了比較,同時提出該方法是效果最好的特征選擇方法.人們利用這些特征評價函數從不同的知識角度對特征項與文本之間的相關程度進行了研究[9、10],文獻[9]使用SVM分類器分析了不同特征選擇方法的效果,并提出了一種新的特征選擇方法BNS,該方法在一些特定的情況下分類結果優于常用的方法.文獻[10]給出了一組特征選擇函數需滿足的基本約束條件,并基于該約束條件提出了一個構造高性能特征選擇方法的通用方法.

上述方法從不同的角度改進了特征選擇方法,提高了分類效果,但忽略了特征詞在各個類中的分布情況,而特征詞在各個類的分布情況會反映特征對區分每個類的貢獻.本文提出基于特征詞在各個類的分布情況的統計信息,即特征貢獻度的一種特征選擇方法,這種方法通過計算特征的貢獻度值對特征進行選擇,傾向于選擇出在某一類文檔中頻繁出現同時在其他類中出現次數少的特征,認為這種特征能夠為文本分類提供更有價值的信息.

1 基于特征貢獻度(FCD)的特征選擇方法

1.1 FCD特征選擇方法

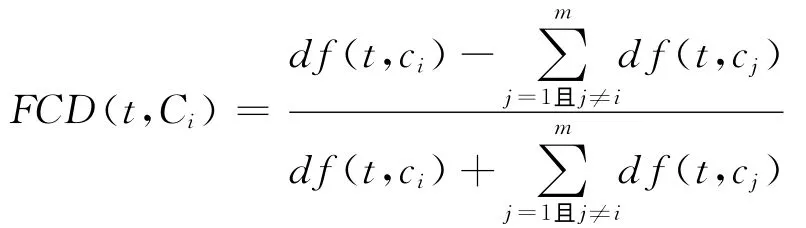

為了選擇出對分類貢獻度大的特征,本文首先用下面的公式計算每個特征的貢獻度值:

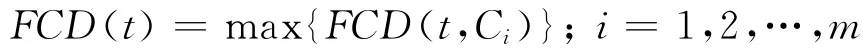

特征t的最終的FCD值計算公式定義為

由上式計算的FCD值越大,說明特征對于某一類區別于其他類的區分貢獻程度越大,對于分類的指導意義越大;該值越小,說明其對于類別區分的貢獻程度越弱,對于分類的指導性越小.本文算法在提取特征時,是按FCD值從大到小的次序依次提取,因此FCD值越高的特征將有更大的機會被選擇.

綜上所述,本文考慮到特征詞在各個類別中的分布情況不同,而特征在各個類的分布情況的統計信息對分類具有指導意義,從而提出了基于特征貢獻度的一種特征選擇方法,這種方法通過計算特征的貢獻度值對特征進行選擇,而特征貢獻度值能夠很好地反映出類別分布情況的統計信息.該方法傾向于選擇出在某一類文檔中出現次數多同時在其他類中出現次數少的特征,認為這種特征能夠為文本分類提供更有價值的信息.

1.2 舉 例

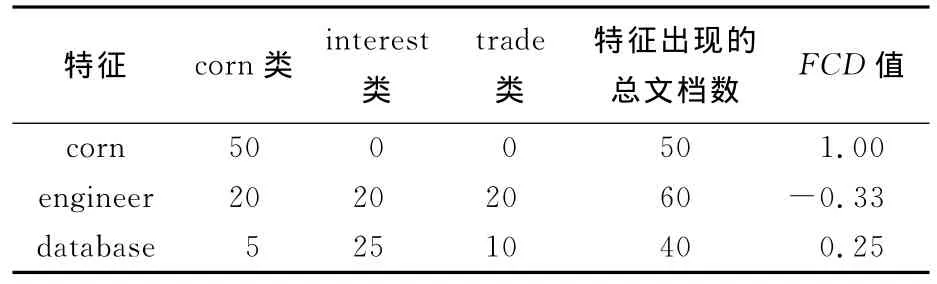

為說明本文方法進行特征選擇的具體情況,下面舉一個例子進行說明.表1列出了在一個簡單的文本語料集中特征的FCD值比較.其中,第1列表示語料集中出現的幾個特征,第2、3、4列分別表示該特征在三類文檔中出現的文檔數,第5列為特征在數據集中出現的總文檔數,最后一列為特征的FCD值.對于特征“corn”來說,它在所有文檔中只在corn類中出現過,此時,FCD(corn,corn)=(50-0)/(50+0)=1,同時,FCD(corn,{interest,trade})=(0-50)/(0+50)=-1,所以FCD(corn)=max{1,-1,-1}=1;對于特征“engineer”來說,它在所有文檔中的每一類中出現的次數相同,FCD(engineer,{corn,interest,trade})=(20-40)/(20+40)=-0.33,所以FCD(engineer)=-0.33;最后,考慮特征“database”,FCD(database,corn)=-30/40=-0.75,FCD(database,interest)=10/40=0.25,FCD(database,trade)=-20/40=-0.5,所以FCD(database)=0.25.

從以上例子可以看出,特征“corn”的FCD值最高,此特征對于類別區分的貢獻度最大;特征“engineer”的FCD值最低,此特征對于類別區分的貢獻度最小.本文方法正是依據選擇那些對于分類貢獻度大的特征來達到提高分類效果的目的的.

表1 在一個簡單的語料集上特征的FCD值比較Tab.1 Comparison between features FCD value in a simple corpus

2 實驗結果

本文選擇支持向量機(SVM)算法作為分類器,SVM是Vapnik提出的一種在缺乏先驗知識的條件下,以最小化結構風險為目標,對有限樣本進行學習的統計學習方法.Joachims于1998年將其引入自動文本分類研究領域,取得了非常理想的文本分類效果[11、12].為了說明本文方法的有效性,將其和一些常用的特征選擇方法進行了比較.主要包括χ2統計法、文檔頻率、幾率比及互信息選擇方法,實驗對比結果在后文給出.

2.1 語料集

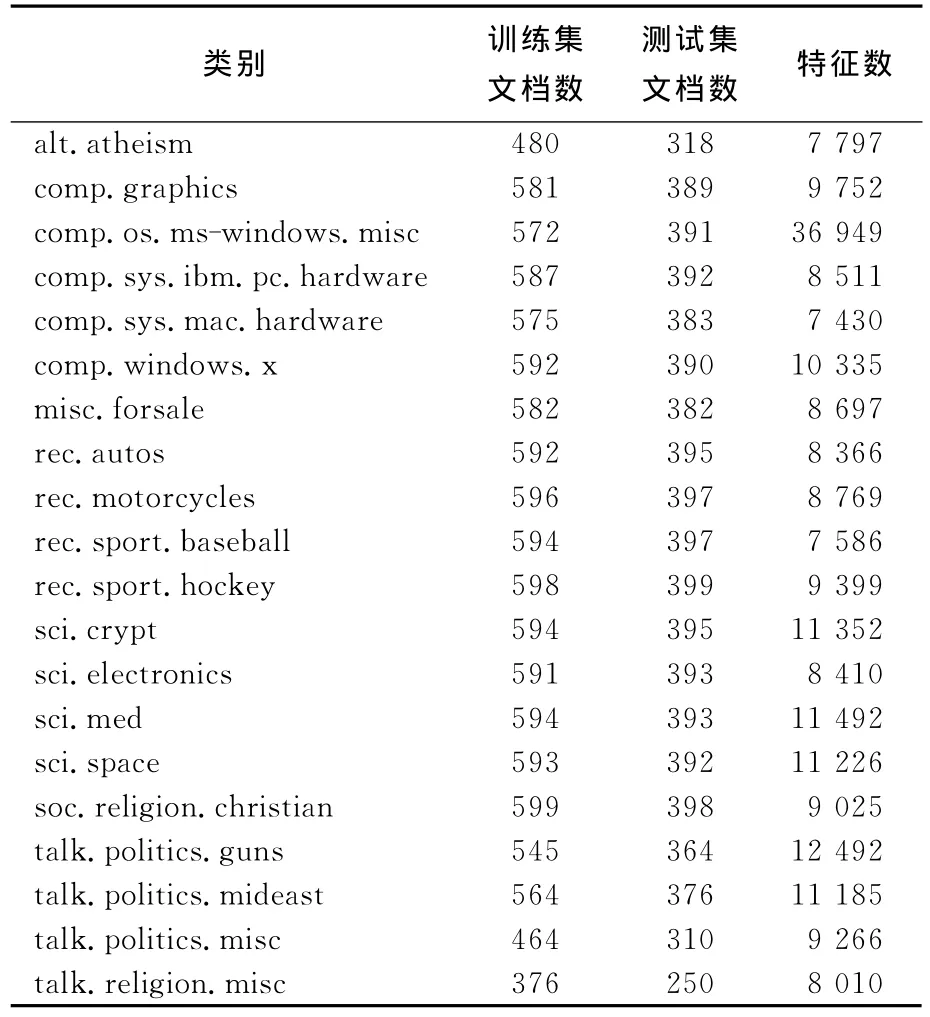

實驗中使用了20Newsgroups[13]和reuters-21578[11]兩個語料集.20Newsgroups語料集是由互聯網用戶在Usenet上張貼的19 997條消息組成的.這些消息分布在20個不同的新聞組中,每個新聞組對應一個文本類別.實驗中使用了其20news-bydate-matlab語料集,該語料集詳細的數據統計見表2.取其中的10個類別作為實驗語料集,5 633篇文檔作為訓練集,3 742篇文檔作為測試集.實驗所采用的第2個語料集是reuters-21578,使用由David Lewis搜集的Mod Apte子集,包含reuters-21578最大的10個類,分別是acq、corn、crude、earn、grain、interest、money-fx、ship、trade、wheat.實驗中隨機選擇訓練文檔7 193篇,測試文檔2 787篇.訓練集中類的分布是不均衡的,最大類有文檔2 877篇,最小類只有181篇.

表2 20Newsgroups的bydate-matlab版本的語料集的數據統計Tab.2 Data statistics of 20Newsgroups corpus in bydate-matlab version

2.2 評價方法

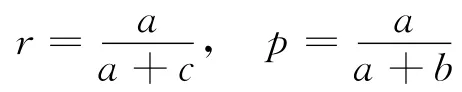

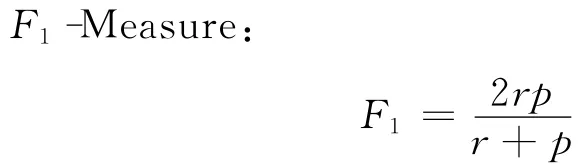

文本分類的評價方法和準則不盡相同,本文使用宏平均F1(macro-averagingF1)和微平均F1(micro-averagingF1)[14]的評價方法.首先介紹查全率、查準率和F-Measure.查全率r和查準率p分別定義為

其中a表示分類器認為屬于這個類而實際也屬于該類的文檔數,b表示分類器認為屬于這個類而實際不屬于該類的文檔數,c表示分類器認為不屬于這個類而實際屬于該類的文檔數.

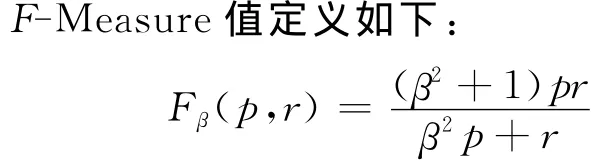

其中β是一個調整參數,用于以不同的權重綜合查全率和查準率.當β=1時,查全率和查準率被平等對待,如下式所示,這時F-Measure又被稱為

上面提出的查全率、查準率及F1-Measure都是針對單個類的分類情況而言的,當需要評價某個分類算法時,還需要將所有類上的結果綜合起來得到平均的結果.綜合的方法通常有兩種,分別為宏平均F1和微平均F1,即

2.3 實驗結果和分析

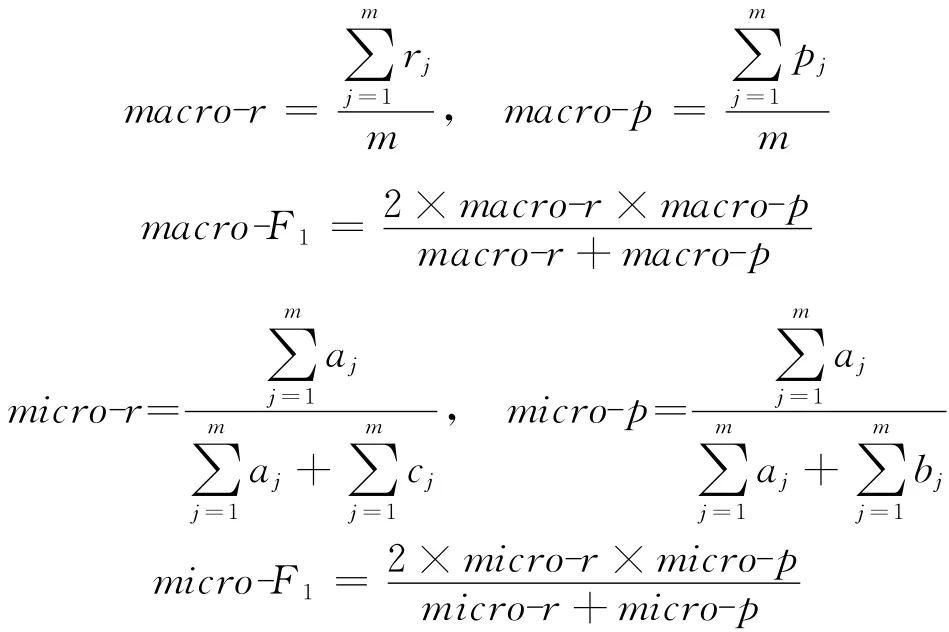

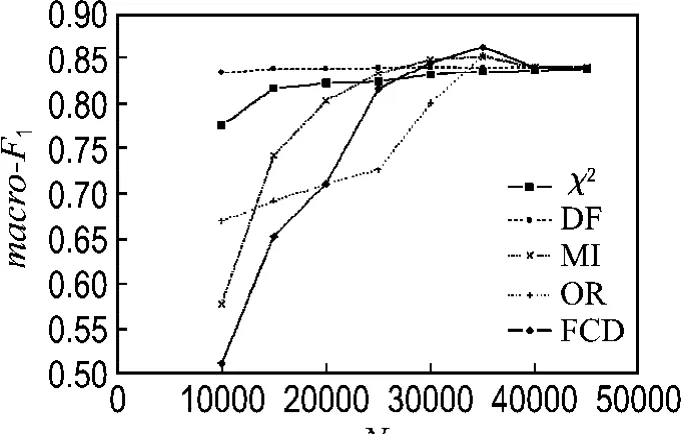

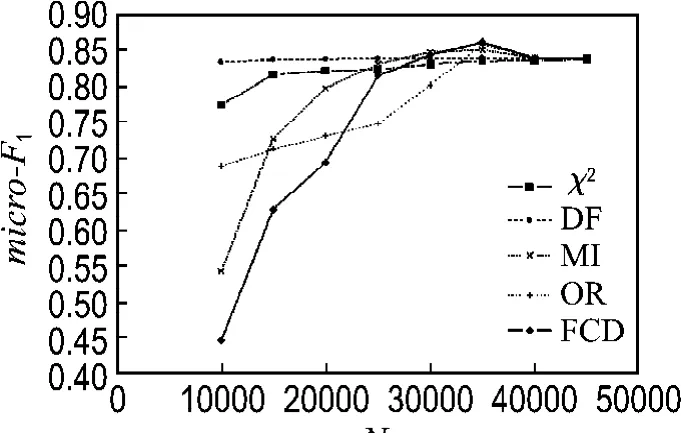

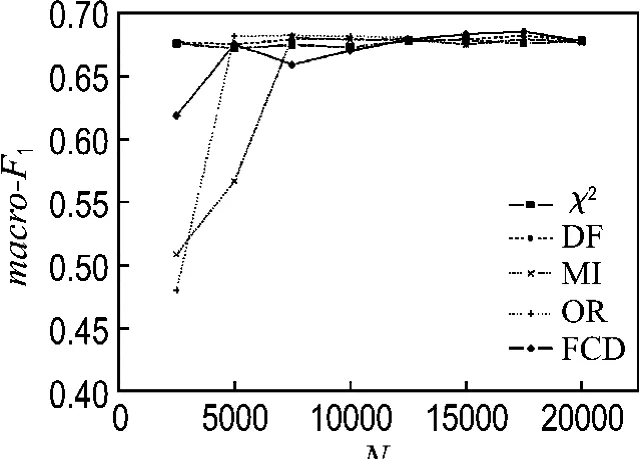

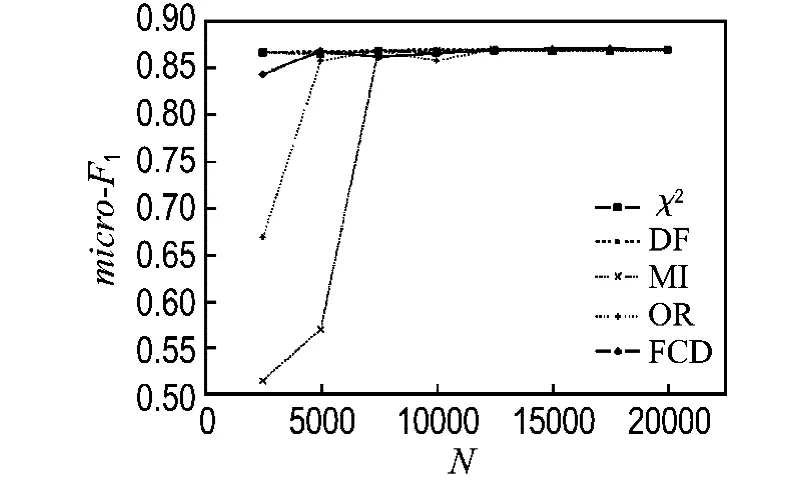

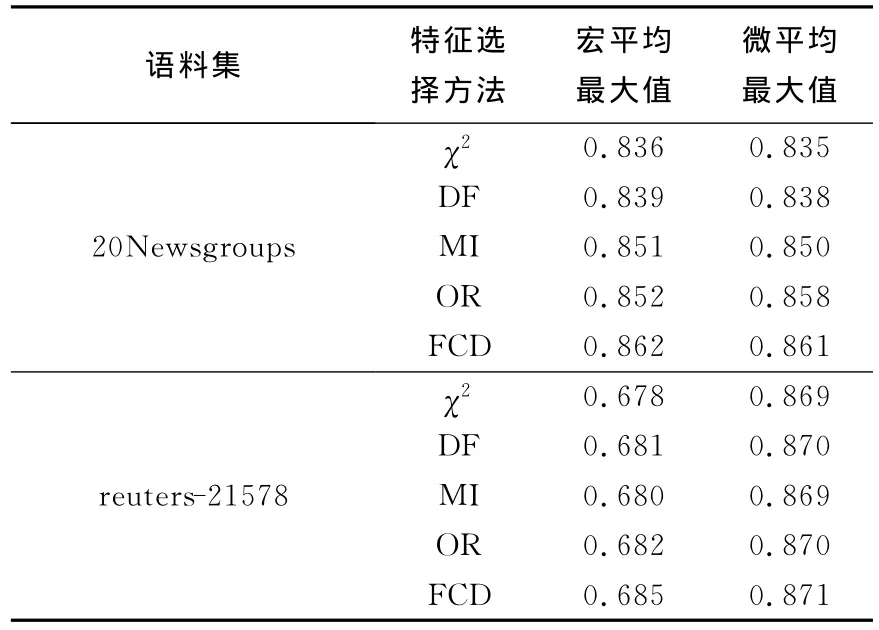

圖1和2分別列出了在20Newsgroups語料集上使用各種特征選擇方法的宏平均F1和微平均F1分類結果,從分類結果中可以看出,在選擇10 000個特征時,FCD方法在所有列出的特征選擇方法中分類效果最不好,其次是互信息方法;此時文檔頻率方法效果最好,其次是χ2統計方法,這可能與FCD方法和互信息方法選擇了大量的低頻詞有關,而文檔頻率方法選擇的都是出現頻率最高的特征;在特征數逐步增大的過程中,FCD方法分類效果提高得非常明顯,在特征數達到35 000時,分類效果最好,而文檔頻率方法在特征數增加時,其分類效果提高得很小,而互信息方法在特征數增大時,分類效果提高得比較明顯.在特征數增大到一定程度時,FCD方法分類效果下降,這與其他的特征選擇方法的結果相同.圖3和4列出了在reuters-21578語料集上使用各種特征選擇方法在SVM分類器上的宏平均F1和微平均F分類結果,從分類結果中可以看出,FCD方法在特征數增大時,分類效果提高得比較緩慢,而OR和MI方法則提高得最為顯著.表3列出了所有特征選擇方法在語料集上的宏平均F1和微平均F1的最大值,綜合兩個語料集上的分類結果來看,FCD方法在所列出的幾種特征選擇方法中為所有分類器效果最好的,這也驗證了該方法的分類有效性.

圖1 有關的特征選擇方法在20Newsgroups語料集上的宏平均F1值Fig.1 Macro-F1 values of relative feature selection methods in 20Newsgroups corpus

圖2 有關的特征選擇方法在20Newsgroups語料集上的微平均F1Fig.2 Micro-F1 values of relative feature selection methods in 20Newsgroups corpus

圖3 有關的特征選擇方法在reuters-21578語料集上的宏平均F1Fig.3 Macro-F1 values of relative feature selection methods in reuters 21578 corpus

圖4 有關的特征選擇方法在reuters-21578語料集上的微平均F1Fig.4 Micro-F1 values of relative feature selection methods in reuters-21578 corpus

表3 有關的特征選擇方法在兩個語料集上的效果統計Tab.3 Performance statistic using relative feature selection methods in two text corpuses

3 結 語

文本分類是信息檢索、信息過濾和搜索引擎工作的技術基礎.文本特征的高維性是影響各種分類器分類精度和效率的一個重要因素,如何進行有效的特征降維成為文本分類的一個研究熱點.因為文本分類是一個分類問題,所以類別信息對于特征選擇是很重要的.本文提出了一種稱之為FCD的特征選擇方法,該方法利用特征的統計結果將對于類別區分具有高貢獻度的特征過濾出來,實驗結果表明該方法與其他幾種常用的特征選擇方法相比簡單、有效,該結果在20Newsgroups和reuters-21578語料集上得到了驗證.

未來的工作將集中在將該方法用于具有更多特征和文檔的大語料集上,同時FCD方法沒有考慮何時特征和類別共現,何時特征和類別不共現,如果將該統計結果加入到特征選擇方法中,可能分類效果會得到提高.

[1]MITEHELL T.Machine Learning[M].New York:McGraw-Hill,1997

[2]MCCALLUM A,NIGAM K.A comparison of event models for Nave Bayes text classification[C]//Proceedings of the AAAI-98 Workshop on Learning for Text Categorization.Wisconsin:AAAI Press,1998

[3]COVER T M,HART P E.Nearest neighbor pattern classification[J].IEEE Transactions on Information Theory,1967,13(1):21-27

[4]ADWAIT R.Maximum entropy models for natural language ambiguity resolution[D].Pennsylvania:University of Pennsylvania,1998

[5]NG Hwee-tou,GOH Wei-boon,LOW Kok-leong.Feature selection,perceptron learning,and a usability case study for text categorization[C]//Proceedings of the 20th Annual International ACM SIGIR Conference on Research and Development in Information Retrieval.New York:ACM Press 1997

[6]VAPNIK V.The Nature of Statistical Leaning Theory[M].New York:Springer-Verlag,1995

[7]YANG Y,PEDERSEN J.A comparative study on feature selection in text categorization[C]//Proceedings of the 14thInternational Conference on Machine Learning(ICML′97).Nashville:Morgan Kaufmann Publishers,1997

[8]MLADENIC D,GROBELNIK M.Features selection for unbalanced class distribution and Nave Bayes[C]//Proceedings of the 16thInternational Conference on Machine Learning.Slovenia:Morgan Kaufmann Publishers,1999

[9]FORMAN G.An extensive empirical study of feature selection metrics for text classification[J].Journal of Machine Learning Research,2003,3(7-8):1289-1305

[10]徐 燕,李錦濤,王 斌,等.基于區分類別能力的高性能特征選擇方法[J].軟件學報,2008,19(1):82-89

[11]JOACHIMS T.Text categorization with support vector machines:Leaning with many relevant features[C]//Machine Learning:ECML-98.Chemnitz:Springer,1998

[12]JOACHIMS T.Making large-scale SVM learning practical[M]//Advances in Kernel Methods:Support Vector Learning.Cambridge:MIT Press,1999

[13]LANG K.NewsWeeder:Learning to filter netnews[C]//Proceedings of the 12th International Conference on Machine Learning.San Francisco:Morgan Kaufmann Publisher,1995

[14]YANG Yi-ming.An evaluation of statistical approaches to text categorization[J].Journal of Information Retrieval,1999,1(1-2):67-88