基于鄰接矩陣優化和負采樣的圖卷積推薦

摘 要:

為了緩解推薦系統中隨機初始化用戶和物品的嵌入、忽視不同卷積層的重要程度以及負樣本數量太少且質量不高的問題,提出了一種基于鄰接矩陣優化和負采樣的圖卷積推薦方法(graph convolution recommendation method based on adjacency matrix optimization and negative sampling,AMONS)。具體來說,模型利用鄰接矩陣對用戶和物品進行嵌入優化,并在卷積層聚合時引入層衰減系數,區分不同層的重要程度。接著,為每對用戶-正樣本生成一組經過篩選的負樣本,讓模型能夠充分利用用戶-物品的歷史交互數據,更好地學習用戶偏好。在Gowalla和Amazon-Books兩個公開數據集上進行了充分的實驗,與相關方法相比,AMONS取得了最佳的性能表現,證明了方法的有效性。

關鍵詞:推薦系統;圖卷積網絡;協同過濾;嵌入優化

中圖分類號:TP391"" 文獻標志碼:A""" 文章編號:1001-3695(2024)12-014-3628-06

doi: 10.19734/j.issn.1001-3695.2024.04.0126

Graph convolutional recommendation based on adjacency matrix optimization and negative sampling

Wang Hui1, Liang Xingzhu1, 2, Zhang Xu1, Xia Chenxing1

(1.School of Computer Science amp; Engineering, Anhui University of Science amp; Technology, Huainan Anhui 232001, China; 2. Anhui University of Technology First Affiliated Hospital (Huainan First People’s Hospital), Huainan Anhui 232007, China)

Abstract:

In order to alleviate the problems of randomly initializing users and items, ignoring the importance of different convolutional layers, and having too few negative samples with low quality in recommendation systems, this paper proposed AMONS. Specifically, the algorithm used adjacency matrix for embedding optimization of users and items, and introduced layer attenuation coefficients in convolutional layer aggregation to distinguish the importance of different layers. Next, it gene-rated a filtered set of negative samples for each pair of user positive samples, allowing the model to fully utilize the historical interaction data between users and items, and better learn user preferences. The experiments were conducted extensively on the Gowalla and Amazon-Books public datasets. Compared to related methods, AMONS achieves the best performance, demonstrating the effectiveness of the method.

Key words:recommendation system; graph convolutional network; collaborative filtering; embedding optimization

0 引言

推薦系統[1]是一種利用機器學習和數據挖掘的工具,它根據用戶的歷史行為、興趣和偏好,為用戶推薦個性化的商品、內容或服務。傳統的推薦方法主要以基于內容[2]和協同過濾[3]為主,基于內容的方法是根據物品本身的特征和屬性進行推薦,通過分析物品的內容信息,向用戶推薦與其過去喜歡的物品相似的物品。但是這種方法通常只能利用到物品本身的特征和屬性信息,而忽略了用戶的個性化興趣和行為,無法準確反映用戶的潛在需求。協同過濾方法是基于用戶-物品交互數據進行推薦,通過分析用戶之間的相似性或物品之間的相似性,向用戶推薦其他用戶喜歡的物品或與其興趣相近的物品。協同過濾方法會考慮到用戶與物品之間的交互關系,能更加個性化地滿足用戶的需求,但是卻存在著數據稀疏性和冷啟動問題,面對新用戶或新物品,無法進行有效的推薦。

圖卷積網絡(graph convolutional networks, GCN)[4]通過學習用戶和物品的低維表示,在一定程度上解決了數據稀疏性和冷啟動問題。早期的圖卷積方法基于用戶-物品交互圖進行推薦,GC-MC[5]從鏈路預測的角度解決推薦系統中的評分預測問題,GCN4RS[6]采用異質卷積和同質卷積的組合來解決冷啟動問題。接著,NGCF[7]通過圖卷積網絡學習節點之間的表示提取到了高階用戶-物品交互信息,證明了圖卷積嵌入傳播能提高嵌入質量。后來,LR-GCCF[8]和 LightGCN[9]又證明了去除圖卷積中的非線性特征變換會在降低復雜性的情況下提高推薦性能。UltraGCN[10]是超簡化的GCN公式,它跳過了無限層的消息傳播過程,通過公式變換直接達到收斂狀態。盡管這些方法[11~16]提高了推薦的準確度,但是仍存在一些問題:a)采用正態分布來初始化用戶和物品的嵌入,這種隨機初始化會帶來不確定性,從而影響模型的性能;b)忽略了不同卷積層的重要程度,在聚合時對每層的輸出進行平等拼接,無法突出重要信息;c)BPR[17]損失函數生成的負樣本數量太少且質量不高,訓練數據的缺乏導致模型無法準確學習到用戶的偏好。

為了解決上述問題,本文提出了一種基于鄰接矩陣優化和負采樣的圖卷積推薦方法(adjacency matrix optimization and negative sampling, AMONS)。經典線性殘差圖卷積網絡模型LR-GCCF的訓練過程如圖1(a)所示,AMONS方法如圖1(b)所示。相較于前者,AMONS在隨機初始化嵌入之后,通過歷史交互優化嵌入(historical interaction optimized embedding, HIOE)模塊,利用鄰接矩陣對用戶和物品初始嵌入再次進行優化操作,增強嵌入表達能力,減少不穩定因素。同時,考慮到最后一個卷積層的特征往往包含了更高階的交互信息,本文在進行圖卷積層聚合時,對除了最后一層的前K-1個卷積層都乘以1/(1+K),通過乘以一個與層數相關的衰減系數來平衡不同層對最終結果的影響,從而使得模型更加穩定和可靠。最后,在模型訓練階段采用優化后的損失函數OpBPR,針對每一對用戶-正樣本生成一組負樣本集合,通過引入更多的負樣本,讓模型更好地學習用戶和物品之間的關系。本文的貢獻如下:

a)在用戶和物品嵌入初始化后,利用鄰接矩陣優化操作,充分利用歷史交互信息,減少隨機初始化所帶來的不確定性。

b)在進行圖卷積層聚合時,采取了一種新的策略:對前K-1個卷積層乘以1/(1+K),突出優化后的初始嵌入和最高階信息的作用,以此來平衡卷積層輸出對最終結果的影響。

c)在損失函數的設計方面,針對每一對用戶-正樣本,生成一組負樣本,并確保這些隨機生成的負樣本與正樣本不重疊。通過引入負樣本集合,讓模型學習更完善的用戶偏好。

d)在完全相同的實驗設置下與LR-GCCF相比,本文模型在Gowalla數據集上HR提升了19.30%,NDCG提升了17.24%,recall提升了19.89%;在Amazon-Books數據集上HR提升了42.52%,NDCG提升了41.47%,recall提升了39.53%,從分析和實證兩方面證明了本文模型的先進性與高效性。

1 方法

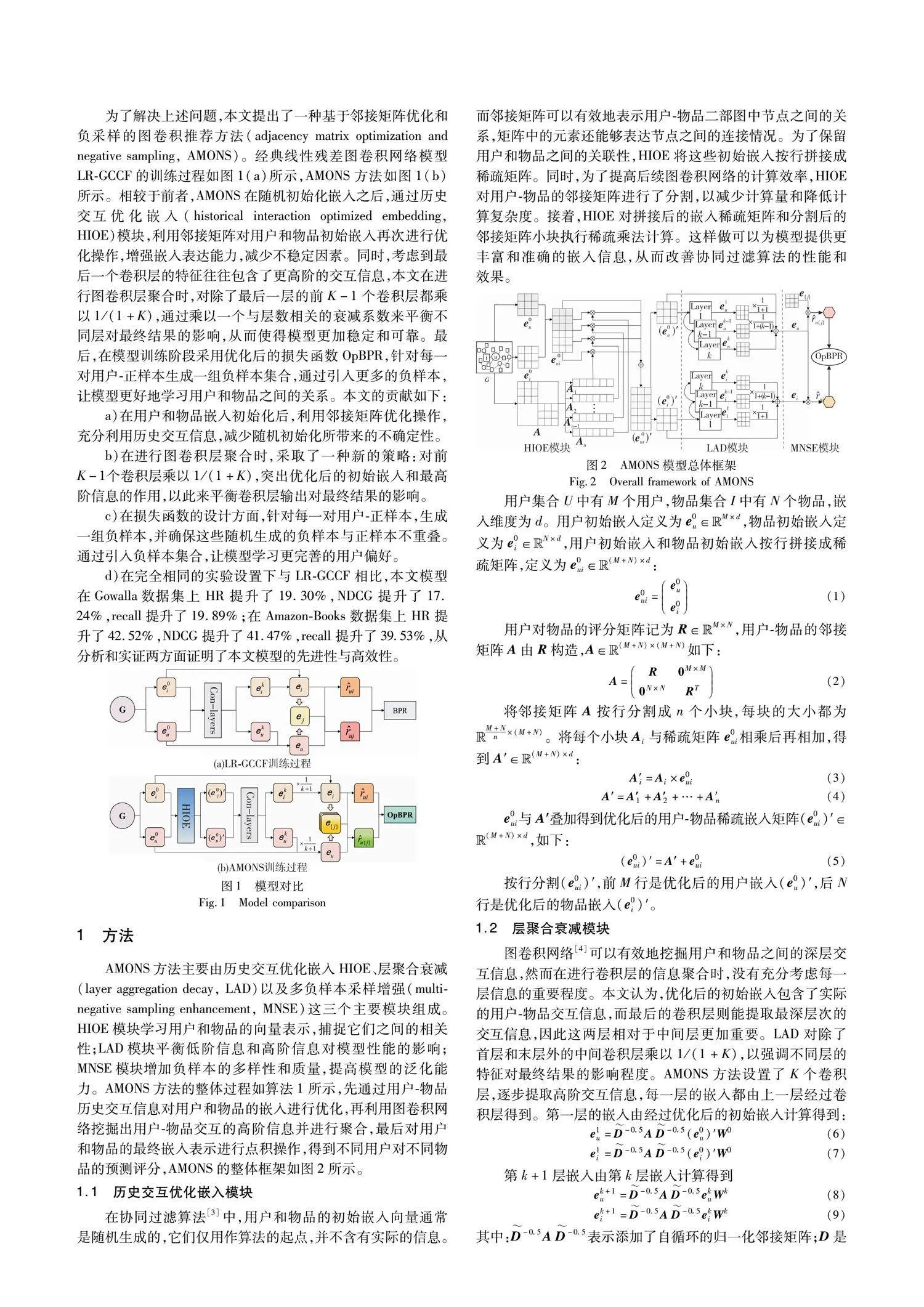

AMONS方法主要由歷史交互優化嵌入HIOE、層聚合衰減(layer aggregation decay, LAD)以及多負樣本采樣增強(multi-negative sampling enhancement, MNSE)這三個主要模塊組成。HIOE模塊學習用戶和物品的向量表示,捕捉它們之間的相關性;LAD模塊平衡低階信息和高階信息對模型性能的影響;MNSE模塊增加負樣本的多樣性和質量,提高模型的泛化能力。AMONS方法的整體過程如算法1所示,先通過用戶-物品歷史交互信息對用戶和物品的嵌入進行優化,再利用圖卷積網絡挖掘出用戶-物品交互的高階信息并進行聚合,最后對用戶和物品的最終嵌入表示進行點積操作,得到不同用戶對不同物品的預測評分,AMONS的整體框架如圖2所示。

1.1 歷史交互優化嵌入模塊

在協同過濾算法[3]中,用戶和物品的初始嵌入向量通常是隨機生成的,它們僅用作算法的起點,并不含有實際的信息。而鄰接矩陣可以有效地表示用戶-物品二部圖中節點之間的關系,矩陣中的元素還能夠表達節點之間的連接情況。為了保留用戶和物品之間的關聯性,HIOE將這些初始嵌入按行拼接成稀疏矩陣。同時,為了提高后續圖卷積網絡的計算效率,HIOE對用戶-物品的鄰接矩陣進行了分割,以減少計算量和降低計算復雜度。接著,HIOE對拼接后的嵌入稀疏矩陣和分割后的鄰接矩陣小塊執行稀疏乘法計算。這樣做可以為模型提供更豐富和準確的嵌入信息,從而改善協同過濾算法的性能和效果。

1.2 層聚合衰減模塊

圖卷積網絡[4]可以有效地挖掘用戶和物品之間的深層交互信息,然而在進行卷積層的信息聚合時,沒有充分考慮每一層信息的重要程度。本文認為,優化后的初始嵌入包含了實際的用戶-物品交互信息,而最后的卷積層則能提取最深層次的交互信息,因此這兩層相對于中間層更加重要。LAD對除了首層和末層外的中間卷積層乘以1/(1+K),以強調不同層的特征對最終結果的影響程度。AMONS方法設置了K個卷積層,逐步提取高階交互信息,每一層的嵌入都由上一層經過卷積層得到。第一層的嵌入由經過優化后的初始嵌入計算得到:

e1u=D-0.5AD-0.5(e0u)′W0(6)

e1i=D-0.5AD-0.5(e0i)′W0(7)

第k+1層嵌入由第k層嵌入計算得到

ek+1u=D-0.5AD-0.5ekuWk(8)

ek+1i=D-0.5AD-0.5ekiWk(9)

其中:D-0.5AD-0.5表示添加了自循環的歸一化鄰接矩陣;D是大小為(M+N)×(M+N)的對角矩陣;Wk是線性變換。

在進行卷積層聚合操作時,LAD對除了最后一層外的前K-1個卷積層都乘以1/(1+K),具體公式如下:

eu=eKu+∑K-1k=01k+1eku(10)

ei=eKi+∑K-1k=01k+1eki(11)

1.3 負樣本采樣增強

推薦模型廣泛使用BPR損失函數作為排序損失[7],BPR損失函數的定義如下:

Euclid Math OneLApBPR=-∑Mu=1 ∑i∈Nu ∑jNuln σ(fs(ui-uj))+λ‖Θ‖2(12)

通過用戶-物品歷史交互記錄獲得每個用戶u與若干個物品之間的交互信息,這些與用戶交互過的物品被視為正樣本i。針對每對用戶u和正樣本i生成相應的負樣本j,即j是用戶u未曾與之交互過的物品。〈u,i, j〉表示用戶、正樣本和負樣本三元組,ui為正樣本評分,uj為負樣本評分。利用BPR損失函數將正樣本和負樣本的評分轉換為損失,并通過反向傳播結合優化器對參數進行更新。

考慮到用戶交互過的物品數量有限,大部分用戶的正樣本數據過于稀疏。相反,負樣本的數量卻相對較多。為了更好地學習用戶偏好,并降低在訓練期間可能存在的正樣本過度擬合風險,MNSE對每一組〈u,i〉生成一組負樣本集合{j},集合中的元素j都是在物品[0,N]隨機生成的。然后,遍歷用戶u的正樣本集合Nu,確保生成的負樣本j不屬于用戶正樣本集合。若屬于,則重新生成,直到滿足先前設定的條件。u{j}表示這一組負樣本集合{j}中每個負樣本所對應評分的集合。通過以上過程,本文能夠更有效地訓練模型,并降低過度擬合的風險。優化后的函數定義如下:

Euclid Math OneLApOpBPR=-∑Mu=1 ∑i∈Nu ∑{j}Nuln σ(fs(ui-u{j}))+λ‖Θ‖2(13)

其中: fs(x)是sigmoid函數;λ控制L2正則化強度;Θ=(e0ui)′。

算法1 AMONS算法

輸入:用戶初始嵌入e0u;物品初始嵌入e0i;評分矩陣R;卷積層個數K。

輸出:用戶和物品的最終嵌入eu和ei。

a) repeat

// 歷史交互優化嵌入

b) 隨機生成用戶初始嵌入矩陣e0u和物品的初始嵌入矩陣e0i,通過式(1)拼接得到e0ui

c) 通過式(2)構造用戶-物品鄰接矩陣A

d) 將A按行分割成n塊,執行式(3)(4),每小塊分別與e0ui相乘再相加

e) 執行式(5)得到優化后的用戶-物品稀疏嵌入矩陣,按行分割矩陣,前M行是優化后的用戶嵌入,后N行是優化后的物品嵌入

// 層聚合衰減

f) 將優化后的用戶和物品嵌入送入卷積層,通過式(6)~(9)進行卷積層嵌入傳播

g) 執行式(10)(11),對K個卷積層的特征表示進行聚合,得到用戶和物品的最終嵌入表示

// 負樣本采樣增強

h) 根據用戶-正樣本集合,生成一組負樣本,執行式(13)得到優化后的損失

i) until模型收斂

j) 返回用戶和物品的最終嵌入

2 實驗與分析

2.1 實驗設置

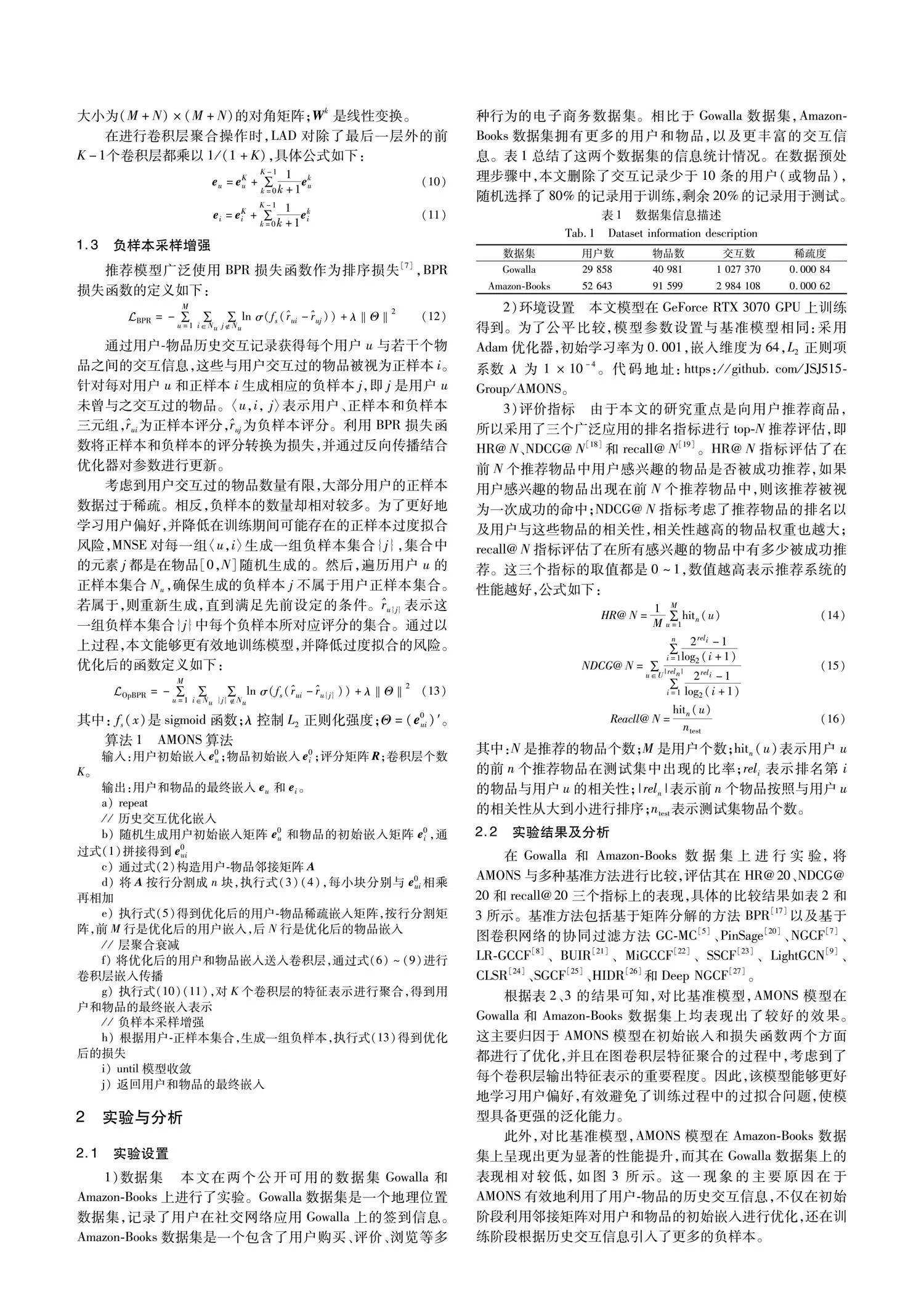

1)數據集 本文在兩個公開可用的數據集Gowalla和Amazon-Books上進行了實驗。Gowalla數據集是一個地理位置數據集,記錄了用戶在社交網絡應用Gowalla上的簽到信息。Amazon-Books數據集是一個包含了用戶購買、評價、瀏覽等多種行為的電子商務數據集。相比于Gowalla數據集,Amazon-Books數據集擁有更多的用戶和物品,以及更豐富的交互信息。表1總結了這兩個數據集的信息統計情況。在數據預處理步驟中,本文刪除了交互記錄少于10條的用戶(或物品),隨機選擇了80%的記錄用于訓練,剩余20%的記錄用于測試。

2)環境設置 本文模型在GeForce RTX 3070 GPU上訓練得到。為了公平比較,模型參數設置與基準模型相同:采用Adam優化器,初始學習率為0.001,嵌入維度為64,L2正則項系數λ為1×10-4。代碼地址:https://github.com/JSJ515-Group/AMONS。

3)評價指標 由于本文的研究重點是向用戶推薦商品,所以采用了三個廣泛應用的排名指標進行top-N推薦評估,即HR@N、NDCG@N[18]和recall@N[19]。HR@N指標評估了在前N個推薦物品中用戶感興趣的物品是否被成功推薦,如果用戶感興趣的物品出現在前N個推薦物品中,則該推薦被視為一次成功的命中;NDCG@N指標考慮了推薦物品的排名以及用戶與這些物品的相關性,相關性越高的物品權重也越大;recall@N指標評估了在所有感興趣的物品中有多少被成功推薦。這三個指標的取值都是0~1,數值越高表示推薦系統的性能越好,公式如下:

HR@N=1M∑Mu=1hitn(u)(14)

NDCG@N=∑u∈U∑ni=12reli-1log2(i+1)∑|reln|i=12reli-1log2(i+1)(15)

Reacll@N=hitn(u)ntest(16)

其中:N是推薦的物品個數;M是用戶個數;hitn(u)表示用戶u的前n個推薦物品在測試集中出現的比率;reli表示排名第i的物品與用戶u的相關性;|reln|表示前n個物品按照與用戶u的相關性從大到小進行排序;ntest表示測試集物品個數。

2.2 實驗結果及分析

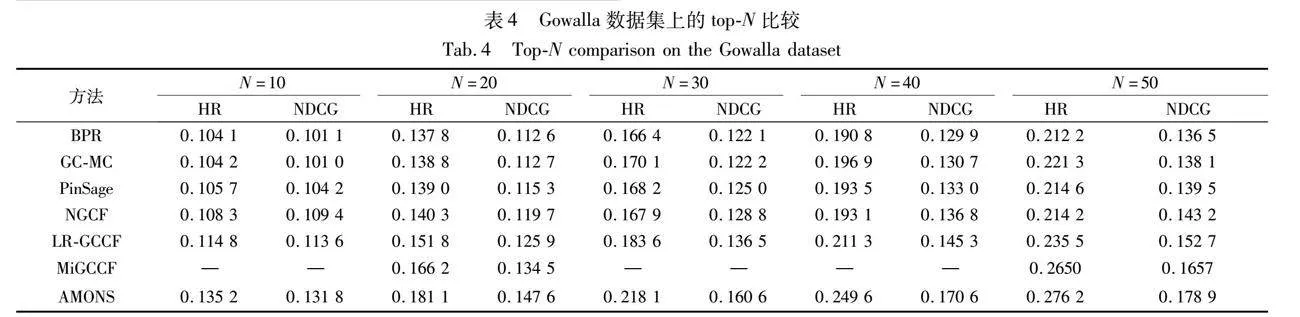

在Gowalla和Amazon-Books數據集上進行實驗,將AMONS與多種基準方法進行比較,評估其在HR@20、NDCG@20和recall@20三個指標上的表現,具體的比較結果如表2和3所示。基準方法包括基于矩陣分解的方法BPR[17]以及基于圖卷積網絡的協同過濾方法GC-MC[5]、PinSage[20]、NGCF[7]、LR-GCCF[8]、BUIR[21]、MiGCCF[22]、SSCF[23]、LightGCN[9]、CLSR[24]、SGCF[25]、HIDR[26]和Deep NGCF[27]。

根據表2、3的結果可知,對比基準模型,AMONS模型在Gowalla和Amazon-Books數據集上均表現出了較好的效果。這主要歸因于AMONS模型在初始嵌入和損失函數兩個方面都進行了優化,并且在圖卷積層特征聚合的過程中,考慮到了每個卷積層輸出特征表示的重要程度。因此,該模型能夠更好地學習用戶偏好,有效避免了訓練過程中的過擬合問題,使模型具備更強的泛化能力。

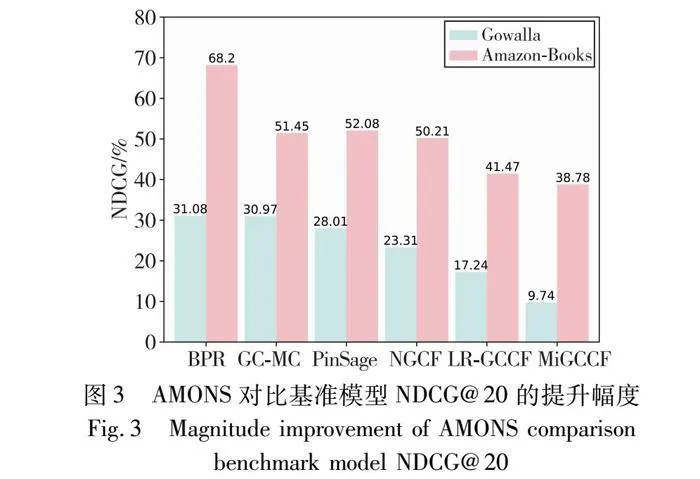

此外,對比基準模型,AMONS模型在Amazon-Books數據集上呈現出更為顯著的性能提升,而其在Gowalla數據集上的表現相對較低,如圖3所示。這一現象的主要原因在于AMONS有效地利用了用戶-物品的歷史交互信息,不僅在初始階段利用鄰接矩陣對用戶和物品的初始嵌入進行優化,還在訓練階段根據歷史交互信息引入了更多的負樣本。

隨著數據集規模的增加,交互數據的豐富程度也相應提升,從而使得模型對用戶偏好的學習更為精細化。考慮到Amazon-Books數據集規模遠遠超過Gowalla數據集,其中所包含的用戶-物品交互信息更加豐富多樣,因此AMONS模型在該數據集上的推薦性能更為突出。

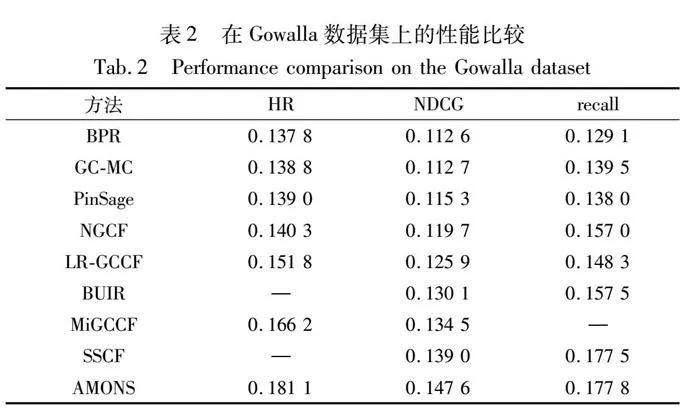

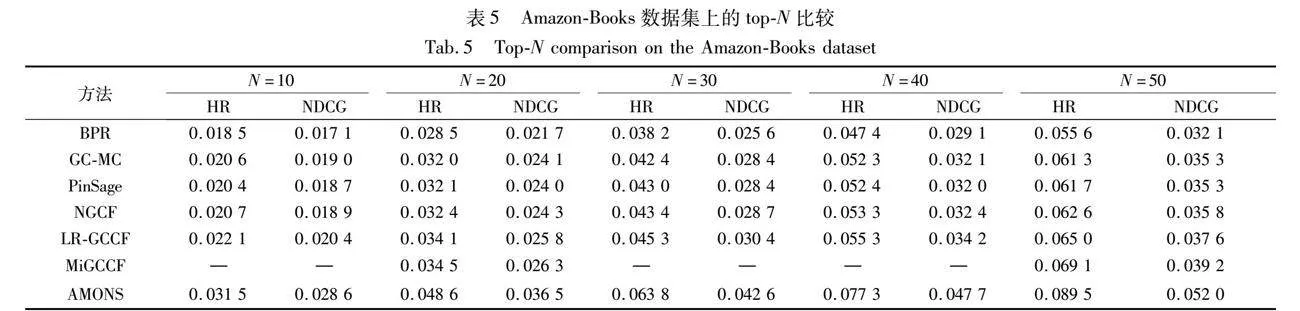

本文將top-N分別設置為10、20、30、40、50,并在Gowalla和Amazon-Books數據集上開展了實驗,實驗結果如表4和5所示。與BPR、GC-MC、PinSage、NGCF、LR-GCCF以及MiGCCF等基準模型相比,AMONS在各個top-N下始終保持領先地位,展現出更為優異的推薦效果,并且隨著推薦數量的增加,準確度也在逐步提升,證明AMONS能夠更好地滿足用戶的需求,為用戶提供更多符合其興趣與偏好的推薦結果。

2.3 消融實驗

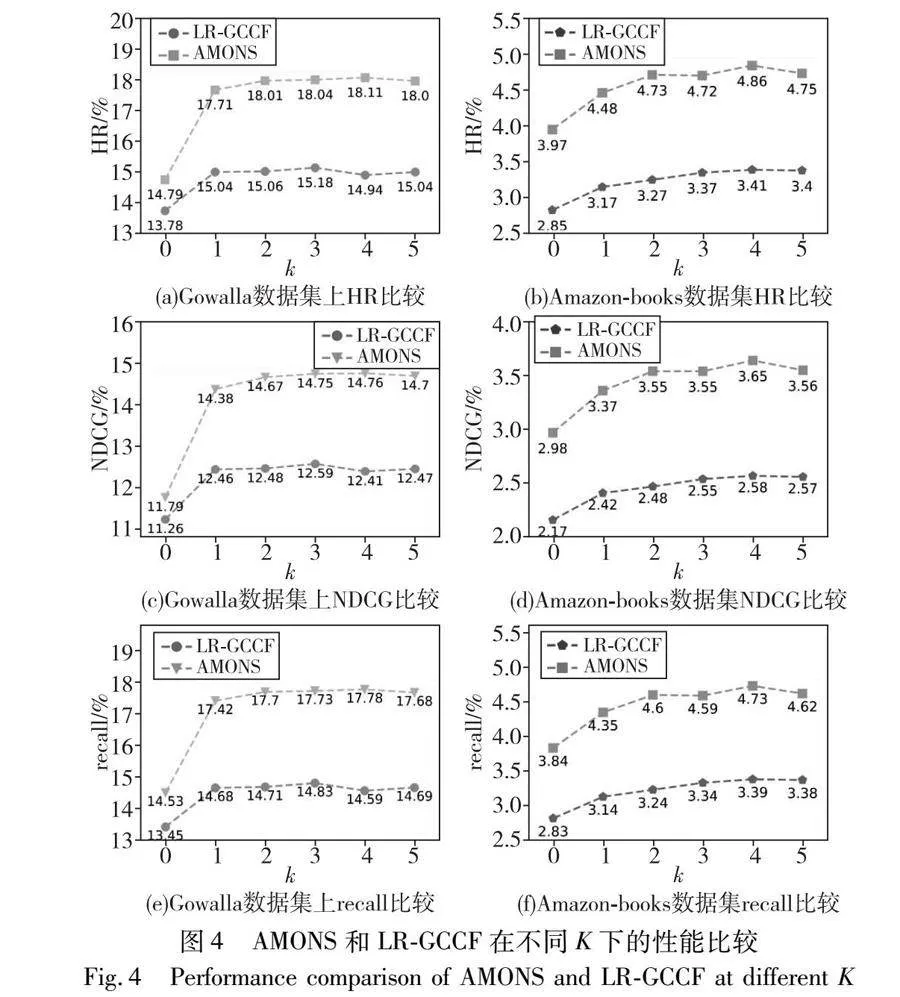

基于GCN的協同過濾模型優勢在于其能夠利用卷積層來挖掘深層次的用戶-物品交互信息。然而,并不是卷積層數量越多、信息傳播深度越大,模型效果就越好,因此需要對傳播深度K的影響進行詳細分析。AMONS與基準模型LR-GCCF在Gowalla和Amazon-Books兩個數據集上的變化情況以及性能差距如圖4所示,這里的top-N均設置為20。觀察這些圖可以發現,在兩個數據集上,相同的K值下, AMONS都表現出比LR-GCCF更好的性能。并且,當K值從0增加到1時,AMONS和LR-GCCF在這兩個數據集上的性能都有顯著提升,這得益于GCN能夠提取用戶-物品高階交互信息,提高了模型推薦的準確性。此外,在Amazon-Books數據集上,AMONS和LR-GCCF都在傳播深度為4時達到了最佳性能。而在Gowalla數據集上,LR-GCCF在K=3時達到最佳性能,AMONS則在K=4時表現最出色。這說明本文模型能夠更有效地捕獲用戶-物品的高階交互信息,這一點歸功于AMONS模型中的歷史交互優化嵌入模塊,通過在初始嵌入中融入用戶-物品的歷史交互信息,擴展了信息傳播的深度,從而實現了更深層次的信息挖掘。然而,當傳播深度大于4時,本文的模型性能開始下降,這可能是因為隨著卷積層數的增加,信息在層與層之間傳遞時丟失過多,導致模型無法學習到有效的特征表示。

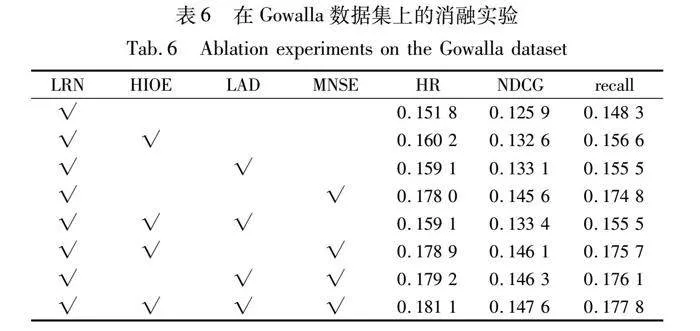

本文在Gowalla數據集上進行了消融實驗來證明AMONS模型的每個模塊都具有實際意義,評價指標HR@20、NDCG@20和recall@20的結果如表6所示。基礎框架僅包含線性殘差網絡(linear residual network, LRN),這時AMONS退化為LR-GCCF模型。在此框架基礎上,本文分別加入了HIOE、LAD以及MNSE模塊進行實驗。相較于LR-GCCF模型,加入HIOE或LAD模塊后,模型的各個指標提升了5%左右;加入MNSE模塊后,模型的HR@20指標提升了17.26%,NDCG@20指標提升了15.65%,recall@20指標提升了17.87%。這一結果證明了三個模塊都能在一定程度上提升模型的推薦性能。其中MNSE模塊的提升效果最為顯著,這是由于用戶的正樣本數量稀少,該模塊引入了大量的負樣本,反向豐富了用戶的偏好,從而使得模型能夠更準確地為用戶推薦感興趣的物品。

此外,本文還將HIOE、LAD、MNSE這三個模塊兩兩結合,并在LRN框架上進行了實驗。同時采用HIOE和LAD模塊,HR@20指標提升了4.81%,NDCG@20指標提升了5.96%,recall@20指標提升了4.86%;同時采用HIOE和MNSE模塊,HR@20指標提升了17.85%,NDCG@20指標提升了16.04%,recall@20指標提升了18.48%;同時采用LAD和MNSE模塊,HR@20指標提升了18.05%,NDCG@20指標提升了16.20%,recall@20指標提升了18.75%。這些結果表明,本文的三個模塊之間存在良好的協同關系。并且當HIOE或LAD模塊結合了MNSE模塊時,模型的性能能夠得到較大幅度的提升。同時,MNSE模塊加上HIOE或LAD模塊,模型的推薦效果也比單獨只有MNSE模塊要強。這是因為HIOE模塊利用了用戶-物品的歷史交互信息,增強了用戶和物品的初始嵌入,所以后續能夠通過圖卷積運算更準確地提取高階用戶-物品交互信息。而LAD模塊強調了聚合過程中不同卷積層的不同重要性,以此來平衡卷積層輸出特征對模型性能的影響。因此,無論是與HIOE模塊還是LAD模塊相結合,MNSE模塊的性能始終優于其獨立模塊。

2.4 實例說明及分析

為了驗證AMONS的實際應用效果,本文選擇了一個電影推薦系統作為實例進行說明和分析。使用了某電影平臺的歷史用戶交互數據,并對推薦結果進行了詳細分析。

1)用戶歷史行為數據 用戶A觀看過的電影有《肖申克的救贖》《霸王別姬》《阿甘正傳》;用戶B觀看過的電影有《盜夢空間》《星際穿越》《黑客帝國》。

2)推薦結果 用戶A的推薦列表為《阿凡達》《泰坦尼克號》《辛德勒的名單》;用戶B的推薦列表為《蝙蝠俠:黑暗騎士》《復仇者聯盟》《星球大戰》。

3)結果分析 a)準確性分析:從推薦結果來看,用戶A的推薦列表中的《泰坦尼克號》是用戶喜歡的經典電影的延續,而《阿凡達》和《辛德勒的名單》也同樣有較高的評分,準確性較高;用戶B的推薦列表中,《蝙蝠俠:黑暗騎士》和《復仇者聯盟》與其觀看的科幻和動作電影偏好一致,而《星球大戰》則是經典科幻系列,推薦準確度較高。b)多樣性分析:用戶A的推薦列表包含了不同類型的經典電影,如愛情片《泰坦尼克號》、科幻片《阿凡達》以及傳記片《辛德勒的名單》,多樣性良好;用戶B的推薦列表主要集中在科幻和動作類電影,但也涵蓋了不同的亞類型,具有一定的多樣性。

通過上述實例分析可以看出,AMONS能夠有效利用用戶的歷史交互數據,提供準確、多樣的推薦結果,為用戶帶來更好的使用體驗。

3 結束語

本文提出了一種基于鄰接矩陣優化和負采樣的圖卷積推薦方法AMONS。首先,在隨機初始化用戶和物品的嵌入后,引入用戶-物品的鄰接矩陣對嵌入進行優化,利用歷史交互信息來提高嵌入表達能力。其次,在卷積層特征聚合過程中,設計了一種加權策略,對除了首、尾層以外的中間層特征乘以1/(1+K)的系數,以減弱中間卷積層的影響,突出首尾嵌入的重要性。最后,針對每一對用戶-正樣本生成了一組經過篩選的負樣本,以此來優化損失函數,從而幫助模型更準確地學習用戶的偏好。在未來的研究中,本文將探索如何更好地將注意力機制融入信息傳播過程中,使模型能夠自動關注圖中具有重要性的節點或邊,從而進一步增強基于圖卷積網絡的協同過濾算法的性能。

參考文獻:

[1]Covington P, Adams J, Sargin E. Deep neural networks for YouTube recommendations [C]// Proc of the 10th ACM Conference on Re-commender Systems. New York: ACM Press, 2016: 191-198.

[2]Pazzani M J, Billsus D. Content-based recommendation systems [M]// The Adaptive Web: Methods and Strategies of Web Personali-zation. Berlin: Springer, 2007: 325-341.

[3]Linden G, Smith B, York J. Amazon.com recommendations: item-to-item collaborative filtering [J]. IEEE Internet Computing, 2003, 7(1): 76-80.

[4]Kipf T N, Welling M. Semi-supervised classification with graph convo-lutional networks [EB/OL]. (2017-02-22). http://doi. org/10. 48550/arx-iv. 1609. 02907.

[5]Berg R, Kipf T N, Welling M. Graph convolutional matrix completion [EB/OL]. (2017-10-25). http://doi. org/10. 48550/arxiv. 1706. 02263.

[6]葛堯, 陳松燦. 面向推薦系統的圖卷積網絡 [J]. 軟件學報, 2020, 31(4): 1101-1112. (Ge Yao, Chen Songcan. Graph convolutional networks for recommendation systems [J]. Journal of Software, 2020, 31(4): 1101-1112.)

[7]Wang Xiang, He Xiangnan, Wang Meng, et al. Neural graph collabo-rative filtering [C]// Proc of the 42nd International ACM SIGIR Conference on Research and Development in Information Retrieval. New York: ACM Press, 2019: 165-174.

[8]Chen Lei, Wu Le, Hong Richang, et al. Revisiting graph based collaborative filtering: a linear residual graph convolutional network approach [C]// Proc of AAAI Conference on Artificial Intelligence. Palo Alto,CA: AAAI Press, 2020: 27-34.

[9]He Xiangnan, Deng Kuai, Wang Xiang, et al. LightGCN: simplifying and powering graph convolution network for recommendation [C]// Proc of the 43rd International ACM SIGIR Conference on Research and Development in Information Retrieval. New York: ACM Press, 2020: 639-648.

[10]Mao Kelong, Zhu Jieming, Xiao Xi, et al. UltraGCN: ultra simplification of graph convolutional networks for recommendation [C]// Proc of the 30th ACM International Conference on Information amp; Knowledge Management. New York: ACM Press, 2021: 1253-1262.

[11]Sun Junhua, Zhang Yingxue, Guo Wei, et al. Neighbor interaction aware graph convolution networks for recommendation [C]// Proc of the 43rd International ACM SIGIR Conference on Research and Development in Information Retrieval. New York: ACM Press, 2020: 1289-1298.

[12]Wang Xiang, Jin Hongye, Zhang An, et al. Disentangled graph collaborative filtering [C]// Proc of the 43rd International ACM SIGIR Conference on Research and Development in Information Retrieval. New York: ACM Press, 2020: 1001-1010.

[13]Choi J, Jeon J, Park N. LT-OCF: learnable-time ode-based collaborative filtering [C]// Proc of the 30th ACM International Conference on Information amp; Knowledge Management. New York: ACM Press, 2021: 251-260.

[14]Zhao Sen, Wei Wei, Zou Ding, et al. Multi-view intent disentangle graph networks for bundle recommendation [C]// Pro of AAAI Conference on Artificial Intelligence. Palo Alto,CA: AAAI Press, 2022: 4379-4387.

[15]王光, 尹凱. 融合用戶社交關系的自適應圖卷積推薦算法 [J]. 計算機應用研究, 2024, 41(2): 482-487. (Wang Guang, Yin Kai. Adaptive graph convolutional recommendation algorithm integrating user social relationships [J]. Application Research of Computers, 2024, 41(2): 482-487.)

[16]Fan Wenqi, Liu Xiaorui, Jin Wei, et al. Graph trend filtering networks for recommendation [C]// Proc of the 45th International ACM SIGIR Conference on Research and Development in Information Retrieval. New York: ACM Press, 2022: 112-121.

[17]Rendle S, Freudenthaler C, Gantner Z, et al. BPR: Bayesian personalized ranking from implicit feedback [EB/OL]. (2012-05-09). http://doi. org/10. 48550/arxiv. 1205. 2618.

[18]Chen Jingyuan, Zhang Hanwang, He Xiangnan, et al. Attentive collaborative filtering: multimedia recommendation with item-and component-level attention [C]// Proc of the 40th International ACM SIGIR Conference on Research and Development in Information Retrieval. New York: ACM Press, 2017: 335-344.

[19]He Ruining, McAuley J. Ups and downs: modeling the visual evolution of fashion trends with one-class collaborative filtering [C]// Proc of the 25th International Conference on World Wide Web. [S.l.]: WWW Press, 2016: 507-517.

[20]Ying R, He Ruining, Chen Kaifeng, et al. Graph convolutional neural networks for Web-scale recommender systems [C]// Proc of the 24th ACM SIGKDD International Conference on Knowledge Discovery amp; Data Mining. New York: ACM Press, 2018: 974-983.

[21]Lee D, Kang S K, Ju H, et al. Bootstrapping user and item representations for one-class collaborative filtering [C]// Proc of the 44th International ACM SIGIR Conference on Research and Development in Information Retrieval. New York: ACM Press, 2021: 317-326.

[22]鄭特駒, 劉向陽. 區分交互意圖的圖卷積協同過濾算法 [J]. 計算機應用研究, 2023, 40(4): 1059-1064. (Zheng Teju, Liu Xiangyang. Graph convolutional collaborative filtering algorithm for distinguishing interaction intentions [J]. Application Research of Computers, 2023, 40(4): 1059-1064.)

[23]Albora G, Mori L R, Zaccaria A. Sapling similarity: a performing and interpretable memory-based tool for recommendation [J]. Knowledge-Based Systems, 2023, 275: 110659.

[24]Zheng Yu, Gao Chen, Chang Jiangxin, et al. Disentangling long and short-term interests for recommendation [C]// Proc of ACM Web Conference. New York: ACM Press, 2022: 2256-2267.

[25]He Li, Wang Xianzhi, Wang Dingxian, et al. Simplifying graph-based collaborative filtering for recommendation [C]// Proc of the 16th ACM International Conference on Web Search and Data Mining. New York: ACM Press, 2023: 60-68.

[26]吳田慧, 孫福振, 張文龍, 等. 基于層次意圖解耦的圖卷積神經網絡推薦模型 [J]. 計算機應用研究, 2023, 40(5): 1341-1351. (Wu Tianhui, Sun Fuzhen, Zhang Wenlong, et al. Hierarchical intent disentangling for graph convolution neural network recommendation model [J]. Application Research of Computers, 2023, 40(5): 1341-1351.)

[27]潘潤超, 虞啟山, 熊泓霏, 等. 基于深度圖神經網絡的協同推薦算法 [J]. 計算機應用, 2023, 43(9): 2741-2746. (Pan Runchao, Yu Qishan, Xiong Hongfei, et al. Collaborative recommendation algorithm based on depth map neural network [J]. Journal of Computer Applications, 2023, 43(9): 2741-2746.)