DeepMind聯合麻省理工學院團隊開發Fluid讓自回歸模型實現文生圖的大規模擴展

在視覺領域,擴散模型已然成為圖像生成的新范式。我們熟知的Stable Diffusion、DALL-E和Imagen等文生圖工具都以擴散模型為基礎。而在語言模型領域,自回歸模型則占據主導位置,大名鼎鼎的ChatGPT就使用了此類模型來生成回復。所謂的擴展法則在以自回歸模型為基礎的大模型身上展現出了強大的力量,可以有效地提升性能。不過,如果回到視覺領域(比如文本生成圖像),擴展自回歸模型并未像在大語言模型中那樣顯著有效。許多研究人員正在努力搞清楚原因,并且想辦法彌合自回歸模型在視覺模型與語言模型之間的性能差距。

近日,來自谷歌DeepMind和美國麻省理工學院的研究人員發表了一篇預印本論文,介紹了他們在“提升自回歸文生圖模型性能”方面的最新進展。

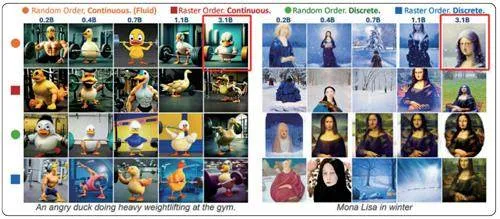

該研究團隊開發的新模型Fluid,通過采用連續Token和隨機順序策略,成功實現了自回歸模型在文生圖任務上的大規模擴展,不僅在多項基準測試中達到了領先水平,還提出了關于自回歸模型的新見解。自回歸模型在自然語言處理領域取得了巨大成功,但在計算機視覺特別是文生圖任務中的表現一直不如擴散模型。為了探究背后的原因,研究團隊對自回歸圖像生成模型的兩個關鍵設計因素進行了系統性的研究:Token(離散或連續)和生成順序(光柵順序或隨機順序)。研究發現,采用連續Token的模型在視覺質量和評估指標上都顯著優于使用離散Token的模型。這主要是因為離散Token化過程會導致大量信息丟失,即使增加模型參數也無法彌補這一缺陷。

例如,在生成著名的蒙娜麗莎畫像時,基于離散Token的模型即使擴展到30億參數,也無法準確還原畫像細節。相比之下,基于連續Token的模型可以生成更高質量、更符合文本描述的圖像。

在生成順序方面,研究表明隨機順序模型在生成多個對象和復雜場景時表現更佳。這可能是因為隨機順序允許模型在每個預測步驟中調整圖像的全局結構,而光柵順序模型則缺乏這種靈活性。這一發現對提高文本到圖像的對齊度具有重要意義。基于這些新發現,研究團隊開發了Fluid模型。Fluid采用連續Token和隨機順序生成策略,在可擴展性和生成質量上都表現出色。實驗結果顯示,Fluid模型的驗證損失、FID(是用于衡量兩個多元正態分布之間距離的評價指標)評分和GenEval得分都隨著模型參數規模的增加而持續改善。值得注意的是,僅有3.69億參數的小型Fluid模型就達到了7.23的零樣本FID得分,還在GenEval基準測試中達到了0.62,與擁有200億參數的Parti模型(谷歌開發的自回歸文生圖模型)持平。受到這一趨勢的啟發,研究團隊將Fluid模型進一步擴展到105億參數。該模型在MS-COCO數據集上實現了6.16的零樣本FID得分,在GenEval基準測試中的綜合得分達到0.69,超越了DALL-E 3和StableDiffusion3等多個使用擴散模型的文生圖系統。

Fluid模型的成功不僅體現在量化指標上,在視覺質量方面也有顯著提升。

研究人員展示了Fluid模型在各種復雜場景下的生成結果,使用了如“一只憤怒的鴨子在健身房舉重”“冬天的蒙娜麗莎”“辦公室里三只穿西裝的泰迪熊為朋友慶祝生日”等提示。

這些生成的圖像不僅細節豐富,而且準確反映了文本描述的內容和情感,展現出模型對文本和圖像之間復雜關系的深入理解。

研究團隊的實驗還揭示了一個現象,即驗證損失與評估指標(如FID和GenEval得分)之間存在強相關性。這意味著通過簡單地監測驗證損失,就可以在一定程度上預測模型在下游任務中的表現。

此外,研究還發現與語言模型類似的是,增加訓練步數和計算量可以持續提升Fluid模型的性能。但是,該團隊也觀察到對于較小的模型,增加訓練步數的效果不如直接擴大模型規模。這一發現強調了模型規模在提升性能中的關鍵作用。

Fluid模型不僅標志著自回歸模型在文生圖任務上的新進展,也為計算機視覺領域的模型擴展提供了新的思路。課題組指出,這項工作可能有助于縮小視覺模型和語言模型在擴展性能上的差距。

然而,研究人員也承認,盡管Fluid模型在多個指標上取得了領先,但在某些方面仍有提升空間。

例如,在GenEval基準測試的某些子任務中,如位置關系理解和渲染兩個物體,Fluid模型的表現仍落后于一些最先進的擴散模型。這表明在處理某些特定類型的視覺任務時,不同的模型架構可能各有優勢。總的來說,這項研究為自回歸文生圖模型的發展開辟了新方向。通過采用連續Token和隨機順序生成策略,Fluid模型成功實現了大規模擴展,在多個關鍵指標上達到或超越了現有最先進的模型。隨著這一技術的進一步發展和完善,我們或許可以期待看到更多令人驚嘆的應用,如更精確的圖像編輯工具、更智能的視覺內容創作輔助工具等。也可以激發更多人探索自回歸模型在視覺任務中的潛力,推動人工智能在理解和生成視覺內容方面取得新的突破。