基于深度學(xué)習(xí)的文旅內(nèi)容命名實(shí)體識(shí)別研究

摘 要:實(shí)體是非結(jié)構(gòu)化文本中的重要組成部分,是構(gòu)成詞匯短語(yǔ)的關(guān)鍵內(nèi)容,每個(gè)研究領(lǐng)域通常都有其特定的實(shí)體集,因此好的實(shí)體識(shí)別研究可以幫助人工智能更準(zhǔn)確地理解語(yǔ)料內(nèi)容,對(duì)后續(xù)的關(guān)系抽取和更深層次的語(yǔ)義分析有重要作用。本文為了更準(zhǔn)確地從景區(qū)文化內(nèi)容相關(guān)文本中提取出具有研究意義和應(yīng)用價(jià)值的命名實(shí)體內(nèi)容,使用改進(jìn)的RoBERTa預(yù)訓(xùn)練模型,結(jié)合BiLSTM-CRF模型,提出了一種景區(qū)文化內(nèi)容實(shí)體識(shí)別的深度學(xué)習(xí)方法,并完成在該領(lǐng)域應(yīng)用的模型訓(xùn)練。并將該模型與其他常見實(shí)體識(shí)別模型進(jìn)行比較,證明了本方法在這項(xiàng)任務(wù)中的優(yōu)越表現(xiàn)。

關(guān)鍵詞:命名實(shí)體識(shí)別;深度學(xué)習(xí);景區(qū)文化

中圖分類號(hào):TP 391" " " 文獻(xiàn)標(biāo)志碼:A

旅游景區(qū)文化產(chǎn)業(yè)是現(xiàn)代產(chǎn)業(yè)體系的重要組成部分。2023年文化和旅游部印發(fā)的《國(guó)內(nèi)旅游提升計(jì)劃(2023—2025年)》提出了“加快智慧旅游發(fā)展,培育智慧旅游沉浸式體驗(yàn)新空間新場(chǎng)景”,標(biāo)志景區(qū)文化內(nèi)容數(shù)字化已成為現(xiàn)代化旅游產(chǎn)業(yè)下一個(gè)階段發(fā)展的主要目標(biāo)。將計(jì)算機(jī)技術(shù)應(yīng)用于新型旅游文化體系的建設(shè)不僅具有現(xiàn)實(shí)價(jià)值,還具有創(chuàng)新意義。

1 研究現(xiàn)狀

命名實(shí)體識(shí)別是從文本數(shù)據(jù)中抽取既定實(shí)體信息的技術(shù)。專家系統(tǒng)、基于規(guī)則和詞典的技術(shù)是早期的實(shí)體識(shí)別的常用手段。一些學(xué)者基于機(jī)器學(xué)習(xí)提出了新方法。在此基礎(chǔ)上,YU等結(jié)合KNN分類器和CRF模型構(gòu)建了半監(jiān)督的學(xué)習(xí)框架。與基于機(jī)器學(xué)習(xí)的方法相比,深度學(xué)習(xí)更有利于發(fā)現(xiàn)隱藏特征。

有學(xué)者(COLLOBERT R、CHO K和HUANG Z等)提出了長(zhǎng)、短期記憶人工神經(jīng)網(wǎng)絡(luò)(LSTM)及其變種門控循環(huán)單元(GRU)。2018年,李莉雙等[1]將BiLSTM模型應(yīng)用于生物醫(yī)學(xué)數(shù)據(jù)集上。2021年GHADDAR A[2]提出了一種基于晶格的長(zhǎng)短期記憶網(wǎng)絡(luò)(Lattice-LSTM)模型。可見,通用領(lǐng)域的命名實(shí)體識(shí)別效果較好,但是專門領(lǐng)域內(nèi)的研究較少,尤其對(duì)旅游文化領(lǐng)域的命名實(shí)體識(shí)別研究略顯不足,這也是本文研究的重點(diǎn)。

2 模型結(jié)構(gòu)

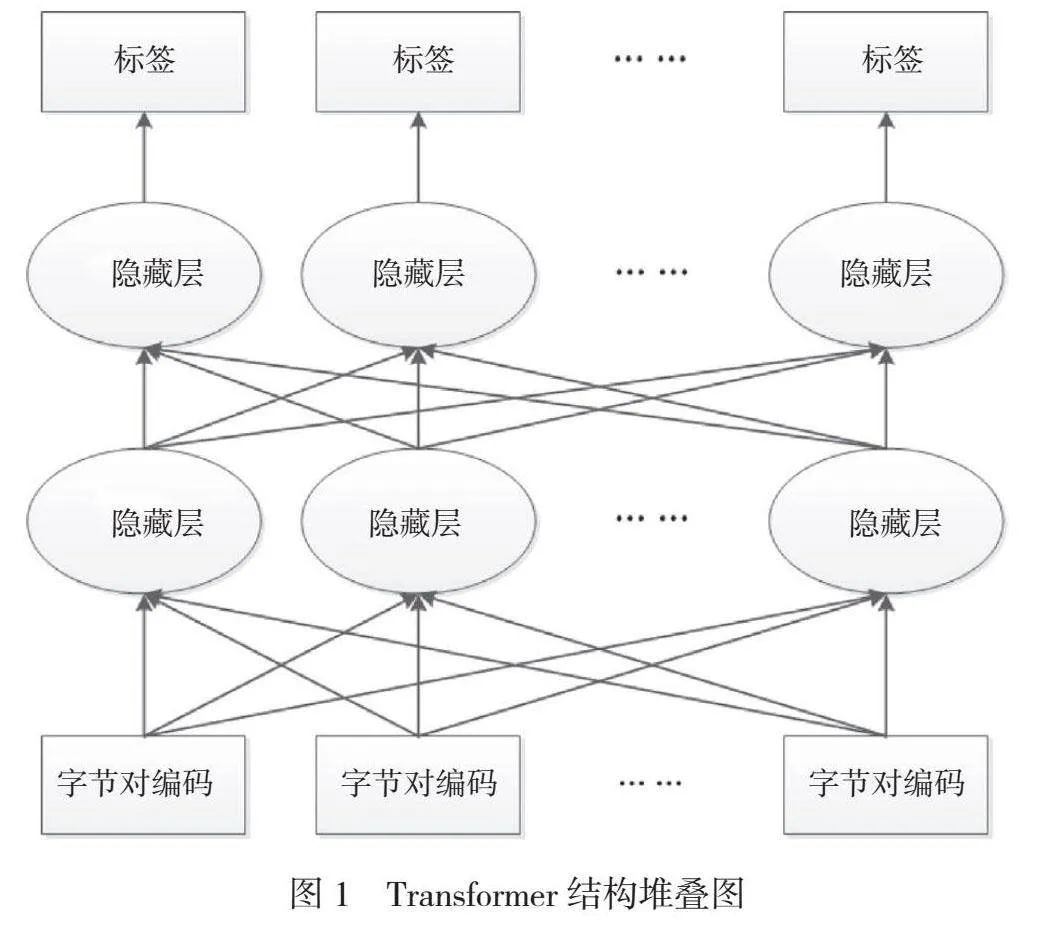

試驗(yàn)?zāi)P徒Y(jié)構(gòu)主要由3個(gè)部分構(gòu)成。首先,將標(biāo)注的語(yǔ)料輸入RoBERTa模型中,通過(guò)預(yù)訓(xùn)練的方式得到高質(zhì)量的詞向量。其次,將訓(xùn)練好的詞向量輸入BiLSTM網(wǎng)絡(luò)中進(jìn)行訓(xùn)練,得到初步的詞分類結(jié)果與標(biāo)簽。最后,將訓(xùn)練結(jié)果輸入CRF模型中進(jìn)行檢查和糾錯(cuò),根據(jù)對(duì)每個(gè)詞匯上下文的識(shí)別結(jié)果和訓(xùn)練相似度修正識(shí)別結(jié)果,完成整個(gè)命名實(shí)體識(shí)別流程。

2.1 RoBERTa預(yù)訓(xùn)練模型

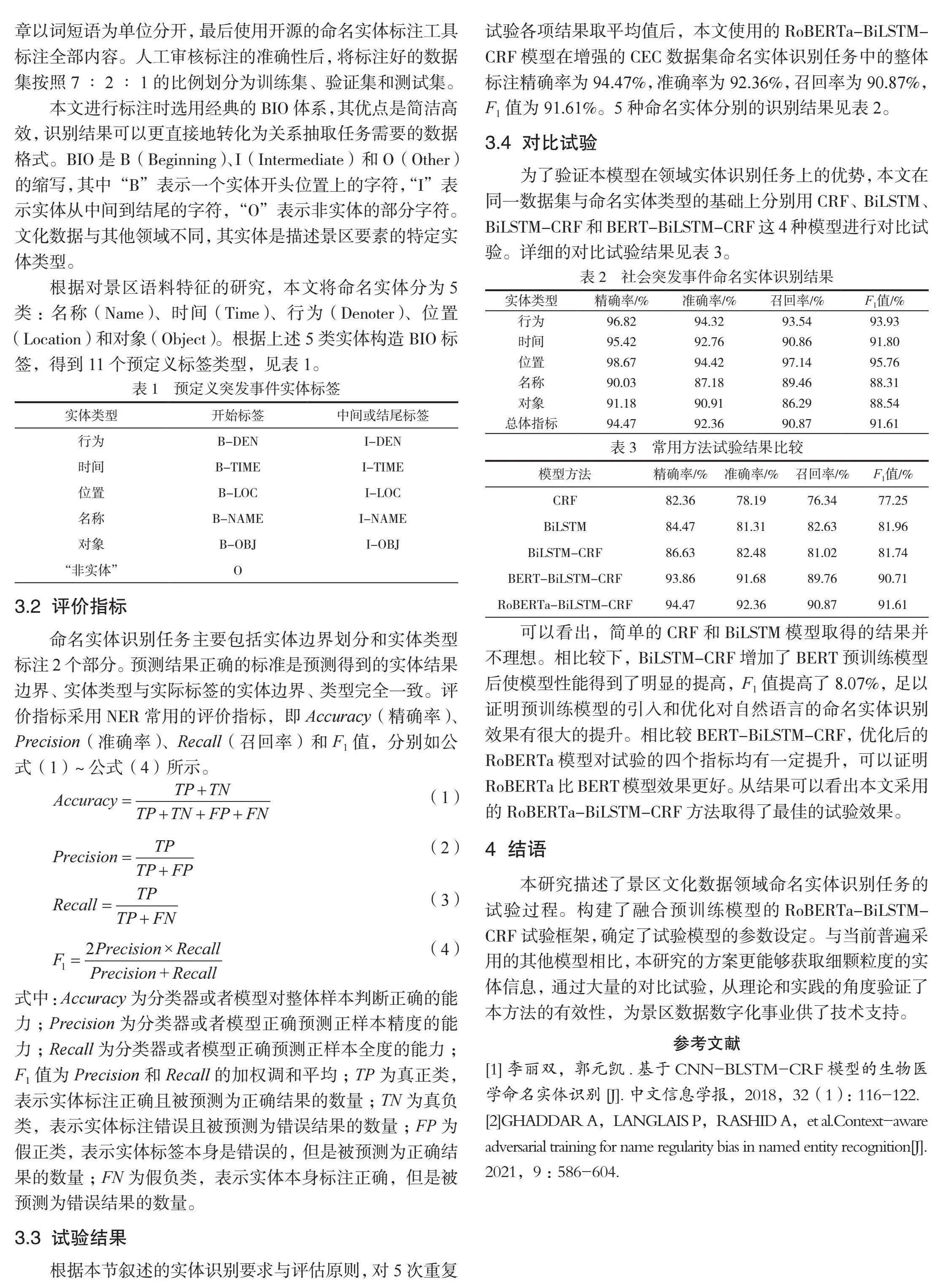

RoBERTa模型的主體結(jié)構(gòu)由多層Transformer結(jié)構(gòu)堆疊而成,該結(jié)構(gòu)形成了更深層的神經(jīng)網(wǎng)絡(luò)模型,如圖1所示。通常的預(yù)訓(xùn)練模型是單向計(jì)算的,該模型只能獲取單個(gè)方向的上下文信息,并受模型結(jié)構(gòu)的限制,詞匯的表征能力不足。該模型最大的不同點(diǎn)是使用了雙向的Transformer組件,并將Transformer層堆疊,可以同時(shí)得到前向和后向的Token,直接以P(wi|w1,...wi-1,wi+1,...,wn)為目標(biāo)函數(shù)進(jìn)行訓(xùn)練,進(jìn)一步形成可以融合前向和后向文本信息的語(yǔ)言表征網(wǎng)絡(luò)模型。

利用堆疊的Transformer結(jié)構(gòu),RoBERTa模型會(huì)將完整的前后文語(yǔ)段信息作為消息嵌入的一部分,這需要在嵌入層的同時(shí)輸入字符的詞信息、句子信息和位置信息,進(jìn)而確保輸入端獲得了詞匯的完整語(yǔ)法信息。

RoBERTa的訓(xùn)練過(guò)程讓豐富的語(yǔ)義信息輸入可以充分發(fā)揮價(jià)值。1)動(dòng)態(tài)mask語(yǔ)言模型。模型在每次向內(nèi)提供輸入時(shí)動(dòng)態(tài)地生成mask,用時(shí)刻變化的[mask]隱藏掉輸入過(guò)程中15%的詞匯Token。在訓(xùn)練過(guò)程中模型發(fā)現(xiàn)了隨機(jī)詞被隱藏,獲取該位置詞信息時(shí)必須參考前后文的信息來(lái)推斷。因?yàn)門ransformer具有全局可視的特點(diǎn),同時(shí)統(tǒng)計(jì)學(xué)表明,由于15%的詞匯隱藏對(duì)試驗(yàn)結(jié)果造成的負(fù)面影響可以忽略不計(jì),使用這種方法可以提升詞前后文的信息獲取率。因此每次向模型輸入一個(gè)序列時(shí)都會(huì)生成新的掩碼模式。在大量數(shù)據(jù)輸入的過(guò)程中模型將適應(yīng)全部掩碼策略,學(xué)習(xí)到最豐富的語(yǔ)言特征。2)字節(jié)對(duì)編碼(BPE)的方式。字節(jié)對(duì)編碼是混合使用了字符級(jí)別和單詞級(jí)別編碼的編碼方式,目前自然語(yǔ)言處理任務(wù)中廣泛采用了該編碼方式。為了獲取更細(xì)致的訓(xùn)練信息,模型采用byte BPE對(duì)詞匯特征進(jìn)行編碼,即用byte級(jí)別的實(shí)現(xiàn)方式對(duì)文本輸入進(jìn)行標(biāo)記。這一改變使詞表長(zhǎng)度擴(kuò)充到了原先的1.6倍,增加了2000萬(wàn)參數(shù)量,雖然一定程度上造成了模型效率下降,但是模型的準(zhǔn)確率有了可觀的提升。

2.2 BiLSTM層

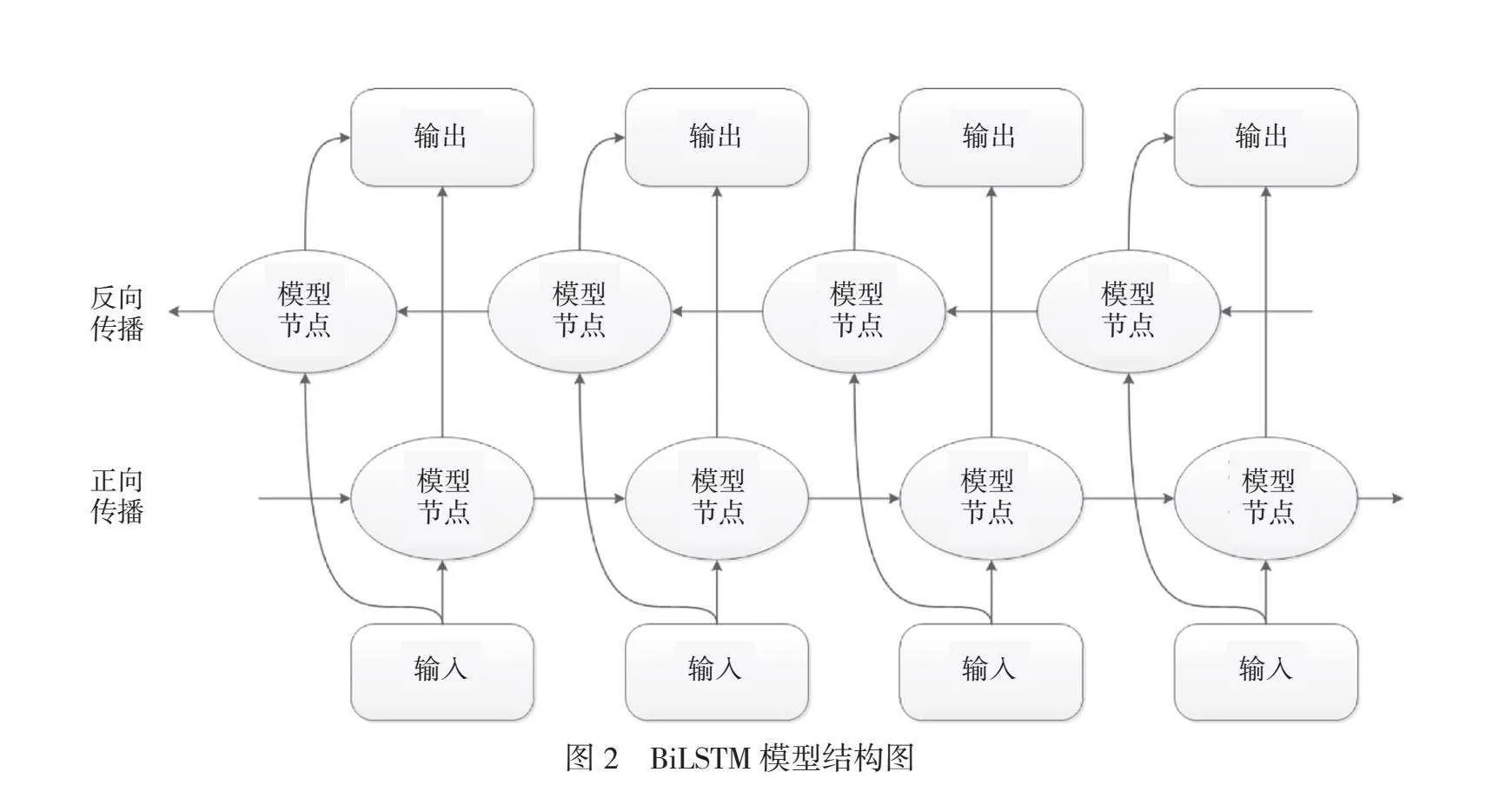

BiLSTM(Bi-directional Long Short-Term Memory)是由2個(gè)方向相反的LSTM模型構(gòu)成的,分別從正向和反向傳遞模型參數(shù)。由于經(jīng)典的LSTM模型只能獲取單向文本信息,而在語(yǔ)言學(xué)中一個(gè)詞語(yǔ)的含義通常受上下文內(nèi)容的影響,BiLSTM模型的提出巧妙地解決了這個(gè)問題。模型最終的輸出向量是由正向和反向的模型訓(xùn)練結(jié)果拼接而成的,因此該模型具有同時(shí)獲得詞匯前后文信息的能力。

BiLSTM模型結(jié)構(gòu)圖如圖2所示。BiLSTM由2個(gè)反向的LSTM模型組合而成。輸入信息是從RoBERTa模型訓(xùn)練得到的特征向量,模型中一部分從前向后處理輸入序列,另一部分反向處理輸入序列,2個(gè)LSTM模型分別互不干擾,計(jì)算出各自的訓(xùn)練結(jié)果,兩者的計(jì)算結(jié)果只有在各自計(jì)算結(jié)束后才會(huì)進(jìn)行拼接,進(jìn)而得到最終輸出結(jié)果。

對(duì)于景區(qū)文化領(lǐng)域的命名實(shí)體識(shí)別的任務(wù),BiLSTM層計(jì)算特征向量對(duì)應(yīng)標(biāo)簽的主要模型層。一些傳統(tǒng)的試驗(yàn)方法通過(guò)Word2Vec或者其他特征向量計(jì)算方法獲取輸入詞匯的特征向量,并將其輸入BiLSTM模型中進(jìn)行訓(xùn)練,直接得到分類結(jié)果。為了提高試驗(yàn)正確率,本文將RoBERTa作為預(yù)訓(xùn)練模型生成輸入特征向量,將CRF模型作為下一步試驗(yàn)的模型,既發(fā)揮了BiLSTM本身的優(yōu)勢(shì),又規(guī)避了模型本身的不足。

2.3 條件隨機(jī)場(chǎng)

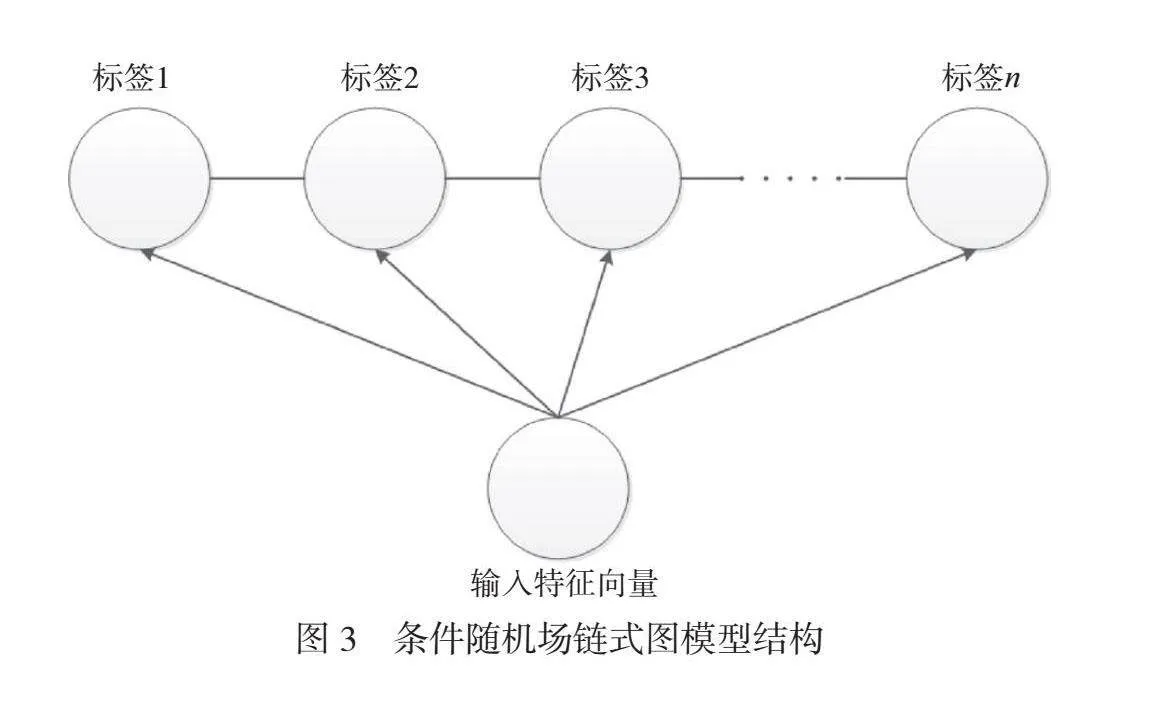

條件隨機(jī)場(chǎng)鏈?zhǔn)綀D模型結(jié)構(gòu)如圖3所示。條件隨機(jī)場(chǎng)(CRF)本質(zhì)上是一種用判別式構(gòu)成的無(wú)向圖模型。模型根據(jù)對(duì)概率情況的條件分布進(jìn)行建模,而不是直接對(duì)聯(lián)合分布進(jìn)行建模,因此條件隨機(jī)場(chǎng)可以看作基于條件概率衍生出的一種圖結(jié)構(gòu)模型。模型的輸入是以組為單位的隨機(jī)變量,通過(guò)模型的計(jì)算輸出得到另一組隨機(jī)變量,可用于不同場(chǎng)景下的預(yù)測(cè)問題。條件隨機(jī)場(chǎng)的輸入和輸出的表達(dá)式如下:設(shè)x={x1,x2,…,xn}為觀測(cè)序列,對(duì)應(yīng)的標(biāo)記序列y={y1,y2,…,yn},則條件隨機(jī)場(chǎng)的目標(biāo)函數(shù)可以記作P(y|x)。

3 試驗(yàn)過(guò)程

3.1 數(shù)據(jù)集和數(shù)據(jù)預(yù)處理

本文使用的訓(xùn)練語(yǔ)料來(lái)源于網(wǎng)絡(luò)公開數(shù)據(jù),包括中國(guó)旅游網(wǎng)、文旅部政務(wù)門戶以及各大景區(qū)官網(wǎng)等平臺(tái)。借助信息提取技術(shù)從網(wǎng)頁(yè)中獲取10124篇文章,經(jīng)過(guò)篩選,剔除掉重復(fù)、低質(zhì)量文章后,剩余5000篇文章。將這些文章順序打亂,防止相近內(nèi)容過(guò)于集中,使用分詞技術(shù)將文章以詞短語(yǔ)為單位分開,最后使用開源的命名實(shí)體標(biāo)注工具標(biāo)注全部?jī)?nèi)容。人工審核標(biāo)注的準(zhǔn)確性后,將標(biāo)注好的數(shù)據(jù)集按照7∶2∶1的比例劃分為訓(xùn)練集、驗(yàn)證集和測(cè)試集。

本文進(jìn)行標(biāo)注時(shí)選用經(jīng)典的BIO體系,其優(yōu)點(diǎn)是簡(jiǎn)潔高效,識(shí)別結(jié)果可以更直接地轉(zhuǎn)化為關(guān)系抽取任務(wù)需要的數(shù)據(jù)格式。BIO是B(Beginning)、I(Intermediate)和O(Other)的縮寫,其中“B”表示一個(gè)實(shí)體開頭位置上的字符,“I”表示實(shí)體從中間到結(jié)尾的字符,“O”表示非實(shí)體的部分字符。文化數(shù)據(jù)與其他領(lǐng)域不同,其實(shí)體是描述景區(qū)要素的特定實(shí)體類型。

根據(jù)對(duì)景區(qū)語(yǔ)料特征的研究,本文將命名實(shí)體分為5類:名稱(Name)、時(shí)間(Time)、行為(Denoter)、位置(Location)和對(duì)象(Object)。根據(jù)上述5類實(shí)體構(gòu)造BIO標(biāo)簽,得到11個(gè)預(yù)定義標(biāo)簽類型,見表1。

3.2 評(píng)價(jià)指標(biāo)

命名實(shí)體識(shí)別任務(wù)主要包括實(shí)體邊界劃分和實(shí)體類型標(biāo)注2個(gè)部分。預(yù)測(cè)結(jié)果正確的標(biāo)準(zhǔn)是預(yù)測(cè)得到的實(shí)體結(jié)果邊界、實(shí)體類型與實(shí)際標(biāo)簽的實(shí)體邊界、類型完全一致。評(píng)價(jià)指標(biāo)采用NER常用的評(píng)價(jià)指標(biāo),即Accuracy(精確率)、Precision(準(zhǔn)確率)、Recall(召回率)和F1值,分別如公式(1)~公式(4)所示。

(1)

(2)

(3)

(4)

式中:Accuracy為分類器或者模型對(duì)整體樣本判斷正確的能力;Precision為分類器或者模型正確預(yù)測(cè)正樣本精度的能力;Recall為分類器或者模型正確預(yù)測(cè)正樣本全度的能力;F1值為Precision和Recall的加權(quán)調(diào)和平均;TP為真正類,表示實(shí)體標(biāo)注正確且被預(yù)測(cè)為正確結(jié)果的數(shù)量;TN為真負(fù)類,表示實(shí)體標(biāo)注錯(cuò)誤且被預(yù)測(cè)為錯(cuò)誤結(jié)果的數(shù)量;FP為假正類,表示實(shí)體標(biāo)簽本身是錯(cuò)誤的,但是被預(yù)測(cè)為正確結(jié)果的數(shù)量;FN為假負(fù)類,表示實(shí)體本身標(biāo)注正確,但是被預(yù)測(cè)為錯(cuò)誤結(jié)果的數(shù)量。

3.3 試驗(yàn)結(jié)果

根據(jù)本節(jié)敘述的實(shí)體識(shí)別要求與評(píng)估原則,對(duì)5次重復(fù)試驗(yàn)各項(xiàng)結(jié)果取平均值后,本文使用的RoBERTa-BiLSTM-CRF模型在增強(qiáng)的CEC數(shù)據(jù)集命名實(shí)體識(shí)別任務(wù)中的整體標(biāo)注精確率為94.47%,準(zhǔn)確率為92.36%,召回率為90.87%,F(xiàn)1值為91.61%。5種命名實(shí)體分別的識(shí)別結(jié)果見表2。

3.4 對(duì)比試驗(yàn)

為了驗(yàn)證本模型在領(lǐng)域?qū)嶓w識(shí)別任務(wù)上的優(yōu)勢(shì),本文在同一數(shù)據(jù)集與命名實(shí)體類型的基礎(chǔ)上分別用CRF、BiLSTM、BiLSTM-CRF和BERT-BiLSTM-CRF這4種模型進(jìn)行對(duì)比試驗(yàn)。詳細(xì)的對(duì)比試驗(yàn)結(jié)果見表3。

可以看出,簡(jiǎn)單的CRF和BiLSTM模型取得的結(jié)果并不理想。相比較下,BiLSTM-CRF增加了BERT預(yù)訓(xùn)練模型后使模型性能得到了明顯的提高,F(xiàn)1值提高了8.07%,足以證明預(yù)訓(xùn)練模型的引入和優(yōu)化對(duì)自然語(yǔ)言的命名實(shí)體識(shí)別效果有很大的提升。相比較BERT-BiLSTM-CRF,優(yōu)化后的RoBERTa模型對(duì)試驗(yàn)的四個(gè)指標(biāo)均有一定提升,可以證明RoBERTa比BERT模型效果更好。從結(jié)果可以看出本文采用的RoBERTa-BiLSTM-CRF方法取得了最佳的試驗(yàn)效果。

4 結(jié)語(yǔ)

本研究描述了景區(qū)文化數(shù)據(jù)領(lǐng)域命名實(shí)體識(shí)別任務(wù)的試驗(yàn)過(guò)程。構(gòu)建了融合預(yù)訓(xùn)練模型的RoBERTa-BiLSTM-CRF試驗(yàn)框架,確定了試驗(yàn)?zāi)P偷膮?shù)設(shè)定。與當(dāng)前普遍采用的其他模型相比,本研究的方案更能夠獲取細(xì)顆粒度的實(shí)體信息,通過(guò)大量的對(duì)比試驗(yàn),從理論和實(shí)踐的角度驗(yàn)證了本方法的有效性,為景區(qū)數(shù)據(jù)數(shù)字化事業(yè)供了技術(shù)支持。

參考文獻(xiàn)

[1]李麗雙,郭元?jiǎng)P.基于CNN-BLSTM-CRF模型的生物醫(yī)學(xué)命名實(shí)體識(shí)別[J].中文信息學(xué)報(bào),2018,32(1):116-122.

[2]GHADDAR A,LANGLAIS P,RASHID A,et al.Context-aware"adversarial training for name regularity bias in named entity recognition[J].2021,9:586-604.