國際出版機構使用人工智能工具的出版倫理政策分析

[摘 要] 從科學網(Web of Science)的期刊引證報告(Journal Citation Reports)數據庫排名前70的出版機構中篩選出23家,分析其人工智能(AI)出版倫理政策。在作者使用AI方面,出版機構主要從署名、AI使用邊界、披露形式進行了規范。出版機構對AI身份問題已達成共識,即AI不能成為署名作者;出版機構允許在研究和寫作中使用AI,但使用者需要對內容負責且充分披露,而目前只有少數(26.1%)機構明確規定了作者的AI使用邊界,且各機構之間對于如何披露的規定存在差異。關于審稿者使用AI的政策,鑒于保密性要求,機構一般不允許審稿者將稿件上傳至無法保證安全性的AI工具,但關于如何披露和違反AI使用政策的懲罰措施還有待完善。針對上述問題,建議出版機構從倫理、技術和法律三個層面,以及協同治理的角度,與學術共同體和管理部門合作,共同制定學術出版中AI使用的倫理規范,以營造健康的學術生態環境。

[關鍵詞] 人工智能 生成式 出版倫理 透明化

[中圖分類號] G237 [文獻標識碼] A [文章編號] 1009-5853 (2024) 06-0015-11

Analysis on Publishing Ethics Policies of International Publishers for the Use of Artificial Intelligence Tools

Dong Min Liu Xuemei Du Liang Lei Fang

(West China Hospital, Sichuan University, Chengdu, 610041)

[Abstract] The article selectes 23 publishing institutions from the top 70 in the Journal Citation Reports database of Web of Science and analyzes their artificial intelligence (AI) publishing ethics policies. In terms of the author’ s use of AI, publishing institutions have mainly standardized the authorship, AI usage boundaries and disclosure forms. Publishing institutions have reached a consensus on the issue of AI identity. That is, AI cannot become a co-author. Publishing institutions allow the use of AI in research and writing, but require authors’ responsibility and full disclosure. Currently only a few institutions (26.1%) have clearly defined the boundaries of authors’ AI usage, and there are differences among institutions on how to disclose them. Regarding the policy on the use of AI by reviewers, due to confidentiality requirements, institutions generally do not allow reviewers to upload manuscripts to AI tools that cannot guarantee security. However, there is still room for improvement on how to disclose and punish violations of AI usage policies. In response to the above issues, it is suggested that publishing institutions collaborate with academic communities and management departments from the perspectives of ethics, technology and law, as well as collaborative governance, to jointly develop ethical standards for AI applications in academic publishing, in order to create a healthy academic ecosystem.

[Key words] Artificial intelligence Generative Publishing ethics Transparency

2022年11月,ChatGPT的推出引發了全球廣泛關注。這款由OpenAI公司開發的人工智能(AI)語言模型,憑借其卓越的自然語言處理能力和深度學習技術,迅速成為全球熱門話題。ChatGPT 與以前版本 GPT的顯著不同在于它的輸出質量、交互能力和進行類人對話的能力、速度以及通過用戶或專家改進其輸出的能力[1]。越來越多的領域開始嘗試使用ChatGPT,如教育、醫療衛生[2]。有人認為禁止 ChatGPT 在學術出版中使用可能不切實際[3],因為將會有更多的研究者在研究和寫作過程中使用ChatGPT,可能造成論文爆發式增長,如索姆·比斯瓦斯(Som Biswas)醫生利用 ChatGPT 在 4 個月內寫 16 篇論文,其中 5 篇已發表[4]。此外,還有學者開始研究生成式AI/大型語言模型(large language models,LLMs)對稿件評估的作用,發現該工具能總結稿件的主要內容,包括稿件的主要目標和結論,并對寫作風格和可讀性提供了一些標準評估[5]。有研究者認為,生成式AI可以提供一種加速和自動化系統審查的方法,有可能大大改變同行評審專家和編輯的角色[6]。

隨著生成式AI /大型語言模型在研究、寫作、稿件評估中的使用,AI倫理問題再次引起廣泛熱議,給出版機構帶來巨大挑戰[7]。因此,出版界急需建立、健全關于AI工具,特別是生成式AI工具使用的倫理政策,為相關人員(如編輯、作者、同行評審專家)提供明確的指導原則,確保出版行業的道德準則得到遵守,防范潛在的倫理問題。

1 文獻綜述

AI概念最早由美國計算機科學家約翰·麥卡錫(John McCarthy)及其同事于1956年達特茅斯會議(Dartmouth Conference)上提出[8],隨后應用于科學研究和寫作。1965年費根鮑姆(Feigenbaum)與勒德貝格(Lederberg)利用AI開發了化學分析系統DENDRAL,1972年研究者開發了診斷血源性傳染病的MYCIN系統,2009年科學家推出自運行研究系統 Adam [9]。2019年施普林格·自然(Springer Nature) 推出首本利用機器學習創作的研究圖書《鋰離子電池:機器生成的當前研究概要》(Lithium-ion batteries: A machine-generated summary of current research)。AI可從6個方面輔助科學研究與學術寫作:研究想法啟發與研究設計,內容開發和構建,文獻綜述與整合,數據管理和分析,編輯、審閱和發表支持,傳播推廣與風險檢測和評估(剽竊檢測、道德風險評估等)[10]。但AI技術的固有缺陷如數據偏差與系統性偏見、決策過程的透明度缺失與結果可解釋性不足,以及數據隱私保護與安全性風險等,導致AI應用始終伴隨倫理及著作權等法律問題的爭議。

學術界通常對新興技術持中立論,認為技術本身無善惡,其影響取決于使用和社會環境。然而,隨著算法和AI的普及,技術中立論受到質疑。相對地,技術價值論認為技術具有價值負荷,在政治、經濟、文化、倫理上非中性,可進行價值判斷。有學者認為在數字出版智能語言模型治理路徑上應調試理念,將兩種觀點辯證統一[11];應采用善治理念,制定“良法”,進行引導、規范和促進知識生產[12]。出版道德委員會(COPE)于2021年發布AI應用于學術出版的指導政策,內容包括期刊選擇、識別論文主題,確定該主題是否符合期刊范圍、篩選同行評審專家、語言質量評估、剽竊檢測以及評估實驗設計和統計學分析等[13]。但該政策是針對出版機構如何規范使用AI。在ChatGPT出現前,相關出版協會、機構及期刊并未制定作者、審稿專家使用AI的規范。

以ChatGPT為代表的生成式AI,由于其算法獨創性、能力綜合性、應用廣泛性,將徹底改變出版內容生產范式和內容供給模式,但其技術局限性(AI幻覺、過度優化困境、算法歧視和有害指令)和不合理使用將加劇著作權問題,增加技術倫理失范和學術倫理失范的風險[14][15],如在ChatGPT出現初期,有研究者將ChatGPT列為作者,此舉遭到很多學者反對[16]。因此,面對AI生成內容,出版界需重點關注著作權與倫理問題,如技術倫理和學術倫理失范等[17]。針對研究、寫作、稿件評審過程中的AI工具使用,ChatGPT出現后,國際協會/委員會如出版道德委員會、國際醫學期刊編輯委員會(ICMJE)、世界醫學編輯協會(WAME)等[18][19][20]于2023年制定相關政策,但以上機構對作者和審稿專家使用AI的規范存在差異。

出版機構是學術內容質量、準確性、合法性和倫理性的“把關人”。一些出版機構,如愛思唯爾(Elsevier)與施普林格·自然正持續關注AI應用情況,并制定相應的倫理政策,為作者、審稿者提供AI使用指導。倫德(Lund)等調查了300種學術期刊的作者使用AI政策,發現58.7%的期刊有相關政策,但該研究范圍比較局限,未能涵蓋AI使用邊界、審稿者AI使用規范[21],且隸屬于施普林格·自然、愛思唯爾等出版機構的期刊均遵循其出版機構的AI作者政策。因此,有必要對出版機構關于作者和審稿者AI使用規范進行系統梳理。本文基于此目的對當前出版機構AI工具使用政策進行調查,包括AI使用邊界、披露內容和形式等,以期全面了解AI的出版倫理政策及存在的問題。

2 研究設計

國際出版機構名單來源于科學網(Web of Science)的期刊引證報告(Journal Citation Reports)數據庫,最近更新日期為2023年10月18日。科學網按2022年收錄期刊數量對出版機構的排序,本文選擇排名前70的出版機構。首先,由于這些出版機構的出版物數量和質量均較高,全球聲譽高、影響力大,其AI應用倫理政策權威性高;其次,他們制定AI出版政策時充分考慮倫理、法律、社會和經濟等多方面因素,內容綜合性強;再者,其出版物涵蓋專業廣泛,幾乎涉及理工農醫所有專業,政策內容具有可推廣性。

從出版機構官方網站發布的出版/編輯倫理(publication/editorial ethics)、作者/審稿專家指南(rguidelines for authors/peer re-viewers)中收集關于作者和審稿專家的AI出版政策。檢索時間為2024年1月2—8日。納入標準:(1)若出版機構之間是從屬關系,AI出版政策完全相同,則納入期刊數量最多的出版機構;(2)有的出版機構之間雖然是從屬關系,但出版政策描述不完全一致,則分別統計;(3)名單中重復的出版機構則納入其中1個;(4)如果出版機構有針對圖書和期刊的不同出版政策,則選擇針對期刊的AI出版政策。

排除標準:(1)出版機構官方網站無AI相關政策;(2)針對AI的使用政策以新聞(news)、社論(editorial)、觀點(opinion、perspective)等形式發表,未在網站的出版/編輯倫理、作者/審稿專家指南出現;(3)出版政策中只提到參考出版道德委員會、國際醫學期刊編輯委員會政策或提供其網址鏈接,并未對AI使用做特別要求和詳細描述。

由一位作者分析AI出版倫理政策,另一位作者核對結果,如有分歧則通過討論解決。

最終納入23家出版機構。納入機構收錄期刊數均>40種,其中,施普林格·自然、愛思唯爾、泰勒弗朗西斯(Taylor & Francis)和威利(Wiley)收錄期刊數均>1000種。

3 國際出版機構AI使用的出版政策現狀

3.1 出版機構對AI身份問題已達成共識

生成式AI導致新型著作權爭議,如AIGC權利歸屬、侵權、AIGC版權保護等問題[22]。AIGC責任主體涉及內容提供者、程序開發者、使用者、平臺運營商[23]。各AI平臺對于生成內容的歸屬權也有不同界定。根據 Midjourney的條款,免費用戶創造或制作的內容的所有權利均歸平臺,而OpenAI將輸出內容的所有權利、所有權和利益(若有)全部轉讓給使用者[24]。

23家(100.0%)出版機構都明確AI和AI工具不能成為作者和合著者。其中有兩家(8.7%)出版機構包括愛思唯爾、多學科數字出版機構(Multidisciplinary Digital Publishing Institute,MDPI),規定不能將AI作為作者引用。16家(69.6%)出版機構認為作者對稿件的內容負有最終責任。5家(21.7%)出版機構提醒作者,AI技術應在人工監督和控制下使用,需仔細審查AI生成內容。目前,出版機構明確AI不能成為著作權主體,且使用者對稿件內容負有責任。在AIGC權利歸屬問題上,還有很多待解決的問題,如知識產權的認定、版權歸屬、利益分配等。界定AI使用范圍對保護原創作品的完整性、界定版權歸屬、降低侵權風險、促進合理使用等有重要意義。

3.2 出版機構AI使用邊界政策存在差異

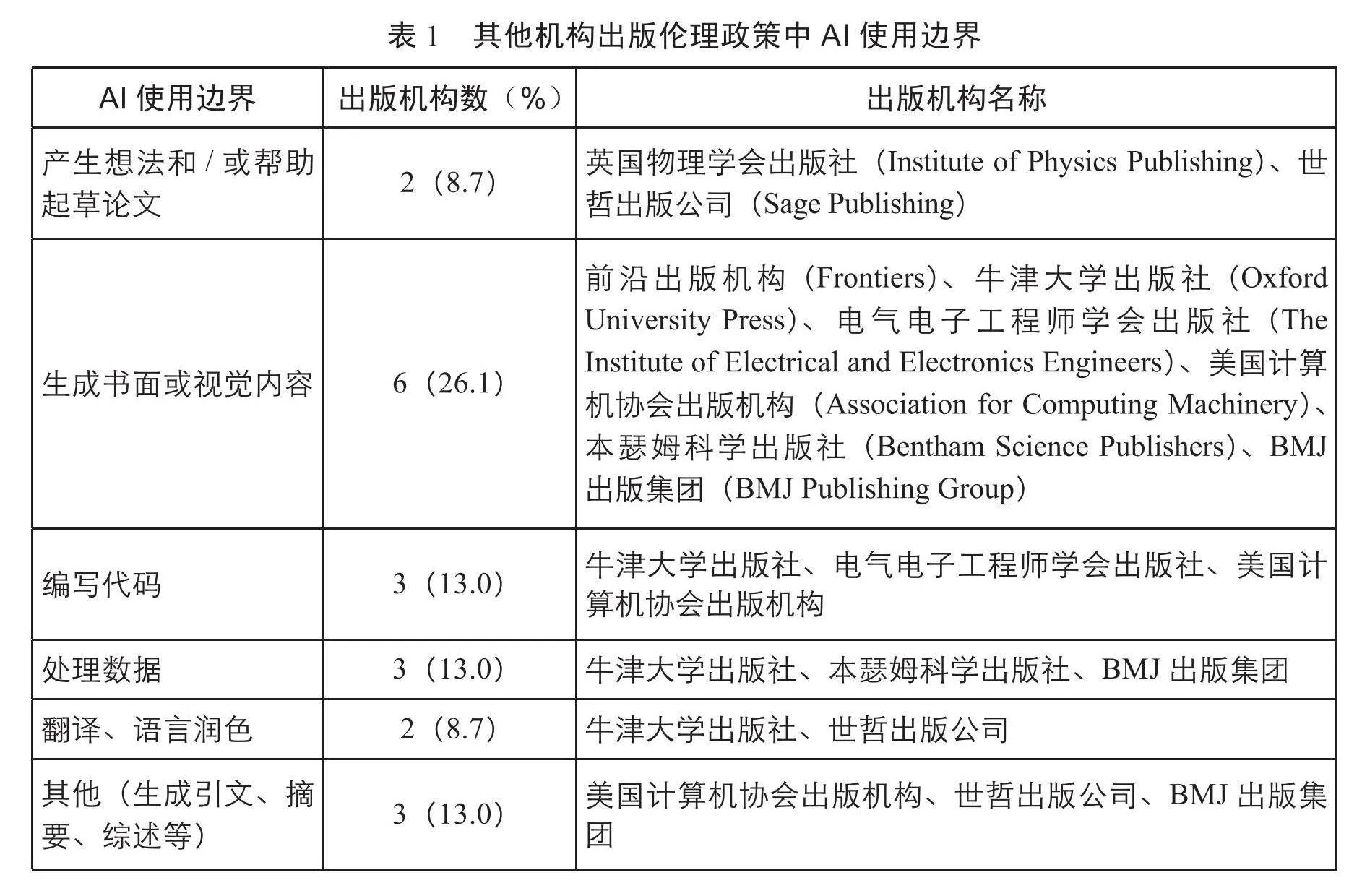

研究者和作者在AI使用中可能面臨一系列倫理和法律風險,如隱私侵犯、著作權糾紛等。明確AI使用邊界對于學術誠信、知識產權保護等具有重要意義。此次調查中僅6家(26.1%)出版機構明確AI使用邊界,且不同出版機構間存在差異。因AI生成圖像引發新的版權問題和研究真實性問題,有3家(13.0%)出版機構,包括施普林格·自然、愛墨瑞得出版集團(Emerald Group Publishing)、愛思唯爾,明確一般情況下不接受生成式AI生成的圖像和視頻。

1家(4.3%)機構(愛墨瑞得出版集團)不允許使用生成式AI工具如大型語言模型撰寫文章的任何部分,包括生成摘要或文獻綜述,不允許使用AI工具或大型語言模型生成或報告結果或進行統計數據的文本報告。兩家(8.7%)機構,包括德古意特出版社(Walter De Gruyter)、約翰·霍普金斯大學出版社(Johns Hopkins University Press),不接受任何實質上由AI如大型語言模型撰寫的稿件。AI和AI輔助技術在寫作過程中,3家(13.0%)機構,包括愛思唯爾、愛墨瑞得出版集團、智力出版公司(Intellect Ltd),聲明只能用于提高稿件的可讀性和語言表達。

其余出版機構未特別界定AI使用范圍,但在要求作者進行AI使用披露時列舉了一些使用內容,見表1。從范圍上來看,這些出版機構比上述6家出版機構AI允許使用的范圍更廣,主要體現在允許圖片、觀點、摘要、表格、代碼等生成。

調查結果顯示,出版機構在AI使用邊界上意見不一。少數機構明確限制AI使用,尤其是視覺內容和完全由AI撰寫的文章。而其他機構對作者的AI使用說明較模糊,政策較為寬松。尤其AI工具在文本和數據分析中的應用可能加劇剽竊的隱蔽性。

出版機構界定AI使用范圍尚未達成共識的原因可能是AI技術的快速進步帶來了層出不窮的新技術和新應用,使得人們難以全面理解AI的廣泛應用范圍和其潛在的深遠影響,因此,目前出版機構難以制定出既全面又明確的規定。同時,國際協會/委員會未能跟上AI技術的快速發展,也未明確AI使用范圍,出版機構尚不能在其指導下制定相關政策,顯示出一定的滯后性。

3.3 出版機構AI披露政策存在分歧

ChatGPT介入學術論文創作涉及著作權的底層邏輯、學術誠信的本位邏輯、可信AI的頂層邏輯,三重邏輯都要求作者履行透明度義務[25]。目前,出版界已經達成共識,允許作者使用,但均要求作者進行披露(100.0%,23/23)。但對如何披露、在文章中披露的位置及披露的內容,出版機構之間尚存差異。4家(17.4%)出版機構,包括約翰·本杰明斯出版公司(John Benjamins Publishing Co)、劍橋大學出版社(Cambridge University Press)、德孚醫藥出版社(Dove Medical Press)、泰勒弗朗西斯,未說明需要披露的位置。9家(39.1%)出版機構,包括約翰·霍普金斯大學出版社、施普林格·自然、IOS出版社(IOS Press)、德古意特出版社、電氣電子工程師學會出版社(The Institute of Electrical and Electronics Engineers)、美國計算機協會出版機構(Association for Computing Machinery)、蒂墨醫學出版社(Thieme Me-dical Publishers)、威利及牛津大學出版社(Oxford University Press),未說明具體需要披露的內容。

本瑟姆科學出版社(Bentham Science Publishers)要求在方法部分說明AI工具使用方法以及類型;愛思唯爾要求作者在方法中解釋AI工具使用方法,以及AI 的產品信息,如果在寫作過程中使用了AI工具,需要在正文和參考文獻之間設置獨立的部分披露工具名稱和使用原因;瑪麗·安·利伯特出版社(Mary Ann Liebert, Inc)要求在方法中提供軟件的名稱和版本、最初使用的日期以及啟動AI響應時所給的相關提示、信號,在結果中應討論AI使用結果的潛在偏差和局限性; 蒂墨出版集團、威利、卡格爾出版社(Karger)和英國物理學會出版社(Institute of Physics Publishing)要求在方法或致謝部分進行披露,此外,卡格爾出版社還要求提供補充材料;愛墨瑞得出版集團要求在方法和致謝部分披露已創建或已修改的內容;多學科數字出版機構要求作者在材料和方法中披露AI工具的使用細節,在致謝中披露AI工具詳細的產品信息;BMJ出版集團要求在貢獻者部分披露AI技術的名稱、使用原因、完成任務,在補充材料中說明原始輸入提示和輸出內容。

此外,愛墨瑞得出版集團和卡格爾出版社聲明,如果作者使用了AI工具,要求其像引用其他軟件一樣對AI進行引用。約翰·霍普金斯大學出版社要求在文本、圖像、圖表或工作的其他部分使用生成式AI或大型語言模型,必須像使用任何外部來源一樣進行引用。BMJ出版集團、卡格爾出版社和世哲出版公司提到,如果沒有按照其要求充分披露AI的使用,可能會被拒稿或出版后再進行更正等。

在稿件中披露AI工具使用不僅是對研究方法的補充,也是對學術誠信、透明度的承諾,可以幫助其他學者更好地理解AI工具的應用,推動AI技術在學術界的普及和應用。同時,也有助于避免因為對AI工具的誤解或不了解而導致的錯誤使用或濫用。出版機構向研究者和作者聲明未充分披露導致的后果,對其有警示作用,不僅能夠促使他們在進行研究和創作時更加謹慎和負責任,還能夠引導他們充分認識到AI技術潛在的風險和挑戰。

3.4 審稿專家AI使用政策待完善

本文調查對象中僅有13家(56.5%)出版機構制定了審稿專家AI使用政策。11家(47.8%)出版機構要求不能將稿件或其中任何部分上傳至生成式AI,其中愛思唯爾還要求審稿專家不能將評審報告上傳至生成式AI。愛思唯爾、多學科數字出版機構要求審稿專家對評審報告內容負責。如果在審稿中使用了AI技術和工具,僅3家機構要求審稿專家在評審報告中進行聲明,透明化處理;但所有出版機構均未說明如果評審過程中超出AI使用邊界或未充分披露將造成的后果,見表2。

由于生成式AI通過公開數據進行訓練,使用其進行審稿有諸多弊端。首先,保密原則是稿件評審的重要原則,過早透露稿件信息可能會侵犯作者的隱私權,包括個人隱私和數據隱私;其次,可能會產生偏見內容[26][27][28][29];

再次,缺乏透明度,導致評審結果缺乏可解釋性,而且不可避免會產生錯誤信息。有研究者嘗試利用大型語言模型對預印版稿件進行評審,發現聊天機器人提供虛假文獻[30]。還有研究者認為大型語言模型缺乏人類評審的深度和洞察力,會提供一些看似有用的虛假評審報告,無法完全替代人類評審[31]。因此,2024版國際醫學期刊編輯委員會推薦[32]中新增“審稿指南必須包括AI使用的指導”。

4 AI出版倫理建設的啟示

我國先后出臺了《新一代人工智能治理原則:發展負責任的人工智能》(2019年)、《新一代人工智能倫理規范》(2021年)、《關于加強科技倫理治理的意見》(2022年)和《科技倫理審查辦法(試行)》(2023年),力圖通過AI與倫理的有機結合,引導AI走上“科技向善”的健康發展道路[33]。AI工具使用的出版倫理是目前出版倫理建設中需要重點關注的內容。為研究者、作者、審稿專家制定詳盡、透明的指導規范是出版機構的重要職責。此次調查結果顯示,大部分出版機構還未向研究者和作者明確AI工具的使用范圍,未說明未充分披露的后果,且同行評審過程中的AI使用政策待完善。目前,國內只有少部分期刊制定了AI使用規范。因此,國內出版機構需盡快探討和建立一套完善的出版倫理政策來規范AI在學術研究、寫作、審稿中的應用。政策制定需平衡AI技術與著作權、出版倫理之間的關系,體現數據使用倫理性、研究透明度和可重復性、技術偏見與公平性、責任歸屬等。

4.1 明確AI工具的使用邊界

AI使用邊界在技術倫理學中占有重要地位。明確AI的使用范圍、使用條件和責任歸屬等,有助于確保AI技術的發展和應用能夠符合倫理原則,促進公平公正,明確責任歸屬,以防范AI濫用[34]。有研究提出,出版機構應該明確稿件中AI使用范圍,明確AIGC剽竊的界限[35]。

AI的穩健進步與科技倫理的引導之間存在顯著的正向聯系,通過加強技術責任制度的實際建設,可以提升科技工作者對倫理準則的執行水平[36]。在ChatGPT出現初期,我國一些期刊對作者AI生成論文內容制定了相關政策,如2023年2月,《暨南學報》《天津師范大學學報(基礎教育版)》發布《關于使用人工智能寫作工具的說明》,但并未對AI的使用邊界進行說明。目前,愛思唯爾禁止使用生成式AI或AI輔助工具創建或更改稿件中的圖片,施普林格·自然禁止使用AI生成的圖片和視頻。2023年9月,中國科學技術信息研究所聯合愛思唯爾、施普林格·自然、威利發布的《學術出版中AIGC使用邊界指南》[37](以下簡稱《指南》)中,關于圖表使用作了更明確的建議:AI可用于推薦合適的統計圖表類型、輔助調整圖表樣式、對圖表進行格式化處理;但實驗生成類圖像必須由真實開展的實驗研究獲得,不可通過AI直接生成。

目前,國內僅有極少數期刊發布了關于AI使用范圍的政策。在制定AI出版倫理政策時,須深思我國期刊出版特性與現狀。2024年1月,中華醫學會雜志社發布了《中華醫學會雜志社關于在論文寫作和評審過程中使用生成式人工智能技術的有關規定》[38](以下簡稱《規定》),明確作者附條件使用AI的情況,包括:文獻檢索、選題、關鍵詞推薦等啟發式探索用途;統計分析;潤色、翻譯;推薦圖表類型、輔助制圖;參考文獻格式的規范化檢查、參考文獻與正文對應的自動化排序、自動引用生成等方面。國內醫學期刊可以參考《指南》和《規定》為作者和審稿者制定AI使用邊界。而AI技術的應用范圍在不同學科領域可能表現出差異性,這要求其他領域期刊在參考《指南》制定相關出版政策時,需要依據本行業、協會相關政策及學科特性,與法律、技術、倫理等多領域的專家共同研究和探討,以制定出一套科學、合理、可行的解決方案。同時需明確,AI政策應該是動態變化的,需要根據新形勢作出調整。

4.2 持續完善AI披露政策

在論文寫作中使用生成式AI具有客觀隱匿性和主觀隱匿性,客觀隱匿性指的是AI的“黑箱”問題,生成過程不可見;主觀隱蔽性是指使用者利用AI介入論文生成過程,其他人不知情,造成信息不對稱[39]。

透明度義務是學術誠信的基本要求。在稿件中對AI全面披露對于維護技術倫理和保護著作權至關重要,讓使用者、讀者能夠深入理解AI系統的運作方式,包括其功能、限制、風險及影響;有助于編輯和審稿專家在審查和出版稿件時考慮這些技術的局限性和偏見[40];有助于構建有效的監督和審查機制,確保AI技術的發展與應用符合倫理標準和社會期望;有助于了解作者和AI的貢獻內容和貢獻程度,對著作權歸屬和侵權責任判定具有重要意義。關于如何披露AI,出版道德委員會要求在稿件的材料和方法(或類似部分)中披露AI工具的使用方法以及類型。2024版國際醫學期刊編輯委員會推薦[41]要求在投稿信和稿件中披露,如果AI用于輔助寫作,在致謝部分對此進行說明;如果AI用于數據收集、分析或圖形生成,則在方法中進行披露。世界醫學編輯協會要求作者完整地列出所使用聊天機器人的技術規格(包括名稱、版本、型號和來源)以及使用方法(包括查詢結構和語法),并在投稿信和文章適當位置進行披露。但有研究者認為在致謝中披露AI的使用不合理,因為它沒有自由意志,因此,不能對其行為承擔道德或法律責任[42]。從此次調查結果看,不同國際出版機構關于如何披露尚存差異。

在ChatGPT之前,已有大型語言模型用于研究和寫作,但出版機構未要求進行披露。生成式AI/大型語言模型(如ChatGPT)具有隱蔽性和混合性,促使重視學術質量的出版機構相繼出臺相關政策,以透明度義務確保高品質學術自由[43]。目前,國內出版機構關于如何披露AI的研究較少,還需繼續探討并完善AI披露細節,披露內容應盡可能詳盡、全面,包括公開AI的使用目的、使用時間、重要步驟、主要類型等[44]。此外,瑪麗·安·利伯特出版社建議在結果中討論AI使用的潛在偏見和局限性,卡格爾出版社、BMJ出版集團要求將輸入指令和AI的原始輸出作為補充材料進行提交,通過提供這些原始數據,可以使研究過程更加透明。國內出版機構在制定AI披露形式時,可以參考國際同行的做法。

4.3 加強對審稿專家AI使用關注及完善指導方針

在學術出版領域,隨著稿件數量不斷上升,同行評審專家承受的評審壓力亦相應增大。有研究認為可以使用AI技術協助審稿[45]。但出版道德委員會和世界醫學編輯協會等相關委員會顯然缺乏關于審稿專家是否應使用基于AI的工具以及如果使用、在什么條件下使用等問題的指導方針。

本文調查發現,僅有13家(56.5%)出版機構制定了針對同行評議的AI使用政策,這一比例相對較低,表明對審稿專家AI使用的關注度不足。此外,這些出版機構在其網站上描述的政策中,均未明確處理潛在違規行為的程序。對于審稿專家或編輯使用或疑似使用生成式AI的情況,缺乏透明度,處理方式及流程不明確,且不清楚是否由期刊倫理委員會或研究誠信團隊負責。出版機構是否具備檢測AI生成內容的手段也未知。在同行評審過程中,對使用生成式AI的審稿專家是否采取制裁措施尚未明確。這種政策缺失對同行評審構成風險,可能影響各方信任,挑戰稿件決策,引發作者與期刊糾紛,進而威脅同行評審系統的完整性、真實性。

國內外出版機構在強化審稿過程中AI應用的監管層面,應采納一系列具體策略:首先,編寫一套詳盡的審稿專家AI使用指南,明確界定AI工具的應用范疇、適用條件、操作流程及倫理準則。其次,實施定期AI技能培訓與教育項目,以提升審稿專家對AI技術的認知水平及其在審稿實踐中的合理運用;此外,審稿聲明中應納入AI使用條款,要求審稿專家承諾并披露AI的應用細節;同時,建立AI使用記錄系統,以便追蹤審稿過程中的AI工具應用情況;在審稿流程中增設監督環節,確保AI使用的合規性;建立反饋與評估機制,以便于從作者和編輯處收集對審稿專家AI使用的評價,并根據反饋進行周期性評估。最后,促進跨機構合作與交流,共享審稿專家AI使用的經驗與最佳實踐,以推動行業標準的提升。

4.4 加強AIGC審查與治理制度建設

針對其他學術不端和出版倫理問題,國際協會制定了相關政策,但目前還未對超出AI使用范圍和未充分披露AI制定相應的審查和治理措施。AI生成的文本、圖像等具有高度的復雜性和不確定性,增加了檢測的難度;大型語言模型不斷迭代,但目前AIGC檢測軟件還未普及,因此要依賴于使用者負責任地使用及透明化使用過程。為了應對這一問題,制定明確的處理措施至關重要,這樣編輯在遇到相關問題時可以有據可依。同時,這也提醒研究者和作者在學術研究和寫作中合理使用AI技術,遵循AI使用規范,維護學術誠信。

超出AI使用范圍和未充分披露是學術倫理失范的表現形式之一。國內外出版機構應迅速建立和完善AI倫理審查制度。這樣的制度不僅能夠預防潛在的法律和責任問題,還能降低因技術應用不當而帶來的倫理風險。審核的重點應包括數據的合法性、內容的合規性、敏感數據的處理方式以及知識產權的保護問題等。

此外,為了形成更加全面和有效的治理體系,出版機構在推進AI技術在學術出版中的應用時,應主動與高等教育機構、科研單位、項目資助機構等多元主體建立緊密的合作關系。通過合作,各方可以共同探討和制定一套關于AI使用的治理規范,以引導和規范AI技術在學術出版領域的合理運用。這種跨學科、跨領域的合作模式,將極大地提高AI技術在學術出版中應用的透明度,確保其操作流程和結果的可追溯性,從而為AI技術的健康發展提供有力的制度保障。

5 結 語

本文采用嚴格的納入與排除標準,僅從排名前70的國際出版機構中選取23家,樣本量相對有限。但這些出版機構均在國際上享有盛譽,旗下擁有眾多期刊,能夠代表高水平的出版標準。本文對這些機構的政策進行了深入分析,并獲得了有意義的發現。同時,注意到一些國際出版機構及其期刊以社論、新聞、觀點文章等多種形式發布了關于AI出版的倫理政策。本文主要檢索了官方網站上正式發布的政策與倫理聲明,未專門搜尋相關文章,可能導致部分信息的遺漏或不全面。

隨著AI技術的飛速發展,AI在出版領域的應用日益廣泛,AI出版倫理也逐漸成為期刊倫理建設的核心組成部分。通過本文調查可以發現,出版機構在一些總的出版原則上與國際協會/委員會一致,如不承認AI工具的作者身份、透明化披露AI使用及使用者對稿件內容負全部責任。但目前關于AI的使用邊界還比較模糊,披露細節也存在差異。關于AI使用還有很多問題待解決,如AIGC的檢測、對剽竊的判定、AIGC版權歸屬,同時錯誤虛假的AIGC給同行評審也帶來挑戰。在未來的學術出版實踐中,還會不斷涌現出新的AI出版倫理問題,為了更好地應對這些問題,需要從倫理、技術、法律等多個維度,規范AI在學術研究及出版中的應用,明確使用者的主導地位;從協同治理理念出發,聯合多方學術共同體及管理部門完善倫理規范,引導其沿著科技向善的方向穩定推進,營造良好的學術生態。

注 釋

[1] Lambert J, Stevens M. ChatGPT and generative AI technology: a mixed bag of concerns and new opportunities [J]. Computers in the Schools, 2023:1-25

[2] Sedaghat S. Early applications of ChatGPT in medical practice, education and research [J]. Clinical Medicine(Lond) , 2023, 23(3): 278

[3] Rahimi F, Talebi Bezmin Abadi A. ChatGPT and publication ethics [J]. Archives of Medical Research, 2023, 54(3): 272

[4] ChatGPT helps radiologist churn out 16 papers in 4 months [EB/OL]. [2024-01-17]. https://healthimaging.com/topics/artificial-intelligence/chatgpt-helps-radiologist-churn-out-16-papers-4-months

[5][30] Donker T. The dangers of using large language models for peer review[J]. The Lancet Infectious Diseases, 2023, 23(7): 781

[6][31] Hosseini M, Horbach SPJM. Fighting reviewer fatigue or amplifying bias? Considerations and recommendations for use of ChatGPT and other large language models in scholarly peer review [J]. Research Square, 2023, rs.3.rs-2587766

[7] Ali MJ, Singh S. ChatGPT and scientific abstract writing: pitfalls and caution [J]. Graefes Archive for Clinical and Experimental Ophthalmology, 2023, 261(11): 3205

[8] 華劼. 合理使用制度運用于人工智能創作的兩難及出路[J]. 電子知識產權,2019(4):28-39

[9] 英倫閣. 人工智能在研究與出版業的應用 [EB/OL]. [2024-01-16]. https://www.enago.cn/academy/ren-gong-zhi-neng-zai-yan-jiu-yu-chu-ban-ye-de-ying-yong

[10] Khalifa M, Albadawy M. Using artificial intelligence in academic writing and research: An essential productivity tool [J]. Computer Methods and Programs in Biomedicine Update, 2024( 5): 100145

[11][14] 任安麒. 數字出版領域智能語言模型的應用、風險與治理:基于ChatGPT技術特征的分析 [J]. 出版科學,2023,31(3):94-102

[12][17]宋時磊, 楊逸云. 應用場景、風險與前景:ChatGPT類大語言模型時代的學術出版 [J]. 出版科學,2023,31(5):76-84

[13] COPE. Discussion document:Artificial intelligence(AI)in decision making[EB/OL]. [2024-01-17]. https://publicationethics.org/sites/default/files/ai-in-decision-making-discussion-doc.pdf

[15][22] 方卿, 丁靖佳. 人工智能生成內容(AIGC)的三個出版學議題 [J]. 出版科學,2023,31(2):5-10

[16] Stokel-Walker C. ChatGPT listed as author on research papers:Many scientists disapprove[J]. Nature, 2023, 613(7945): 620-621

[18] COPE. COPE position statement (2023) In: Authorship and AI tools[EB/OL]. [2024-01-16]. https:// publicationethics.org/cope-position-statements/ai-author

[19][32][41] ICMJE. Recommendations for the conduct, reporting, editing, and publication of scholarly work in medical journals[EB/OL]. [2024-01-17]. https://icmje.org/recommendations

[20] Zielinski C, Winker MA, Aggarwal R, et al. Chatbots, Generative AI, and Scholarly Manuscripts. WAME Recommendations on Chatbots and Generative Artificial Intelligence in Relation to Scholarly Publications[EB/OL]. [2024-01-17]. https://wame.org/pdf/Chatbots-Generative-AI-and-Scholarly-Manuscripts.pdf

[21] Lund B D, Naheem K T. Can ChatGPT be an author? A study of artificial intelligence authorship policies in top academic journals [J]. Learned Publishing, 2024, 37(1): 13-21

[23] 范心悅. 從算法認知看人工智能的責任主體問題[D]. 甘肅:蘭州大學,2023:7

[24] OpenAI. Terms of use [EB/OL]. [2024-02-17]. https://openai.com/policies/terms-of-use

[25][39][43][44] 程睿. ChatGPT介入學術論文透明度義務的可視正義功能 [J]. 科學學研究,2023,41(12):2138-2146

[26] Fujimoto S, Takemoto K. Revisiting the political biases of ChatGPT [J]. Frontiers in Artificial Intelligence,2023(12):2138-2146

[27] Alawida M, Mejri S, Mehmood A, et al. A comprehensive study of ChatGPT: Advancements, limitations, and ethical considerations in natural language processing and cybersecurity[J]. Information, 2023, 14(8): 462

[28] Yuan WZ, Liu PF, Neubig G. Can we automate scientific reviewing [J].2021, arXiv:2102.00176

[29] Graf A, Bernardi RE. ChatGPT in research: Balancing ethics, transparency and advancement [J]. Neuroscience,2023, 515: 71

[33] 李志祥.倫理學視域下的人工智能發展 [EB/OL]. [2024-01-17]. https://news.gmw.cn/2024-02/19/content_37150949.htm

[34] 韓旭至. 生成式人工智能治理的邏輯更新與路徑優化 [J]. 行政法學研究, 2023(6): 30-42

[35] 蔣雪穎, 劉欣. 生成式人工智能技術下的學術生產與出版:變革、失范與路徑 [J]. 數字圖書館論壇, 2023,19(5): 64-71

[36] 鄧若玉. 人工智能發展的科技倫理反思 [J]. 廣西社會科學, 2020(10): 93-97

[37] 吉林大學學報工學版. 《學術出版中AIGC使用邊界指南》正式發布[OL].[2024-01-17]. https://mp.weixin.qq.com/s?biz=MzI2MjUzMDUwOQ==&mid=2247489029&idx=2&sn=ee1c3984ba809ee8a522e7e52360ad4a&chksm=ea48e2a7dd3f6bb1eeefc99a401efd33b230b7c98963a29a741b98026ca6ad48f98f4b389c4c&scene=27

[38]中華口腔醫學雜志. 中華醫學會雜志社關于在論文寫作和評審過程中使用生成式人工智能技術的有關規定[OL]. https://mp.weixin.qq.com/s?__biz=MzA5Nzc2MjE5NQ==&mid=2653558636&idx=1&sn=370aafb6456cb83191f104c612d88b95&chksm=8b455990bc32d0862170c5ded1d019c3c642e7e70bd148ca937c3618274047cd448c80fec9ec&scene=27

[40] Gaggioli A. Ethics: Disclose use of AI in scientific manuscripts [J]. Nature, 2023, 614(7948): 413

[42] Hosseini M, Resnik DB, Holmes K. The ethics of disclosing the use of artificial intelligence tools in writing scholarly manuscripts [J]. Research Ethics, 2023, 19(4):449-465

[45] Bauchner H, Rivara FP. Use of artificial intelligence and the future of peer review [J]. Health Affairs Scholar, 2024, 2(5): qxae058

(收稿日期:2024-02-20;修回日期:2024-09-04)