基于改進注意力機制與VGG?BiLSTM的暴力行為檢測

摘 "要: 為解決單一深度卷積神經網絡VGG特征提取的局限性,以及單一循環神經網絡RNN在記憶歷史信息方面的困難,提出改進注意力機制與深度時空網絡的深度學習模型VBA?net的暴力行為檢測方法。首先,通過VGG的深層神經網絡提取關鍵局部特征;其次,運用改進后的注意力機制捕捉和優化最顯著的特征;最后,利用雙向長短期記憶網絡處理過去和未來的時序數據。仿真實驗結果表明,VBA?net在規模較小的HockeyFight和Movies數據集上的準確率分別達到了97.42%和98.06%,在具有多樣化內容和復雜環境數據集RWF?2000和RLVS上準確率分別達到89.00%和95.50%,因此其在復雜環境的綜合魯棒性優于同類算法,可有效提升暴力行為檢測任務中的準確率。

關鍵詞: 暴力行為檢測; 深度卷積神經網絡; 雙向長短期記憶網絡; 注意力機制; VBA?net; 特征提取

中圖分類號: TN919?34; TP391.41 " " " " " " " " 文獻標識碼: A " " " " " " " " " "文章編號: 1004?373X(2024)21?0131?08

Violence behavior detection based on improved attention mechanism and VGG?BiLSTM

LI Jincheng, YAN Ruiao, DAI Xuejing

(College of Public Security Information Technology and Intelligence, Criminal Investigation Police University of China, Shenyang 110854, China)

Abstract: In view of the limitations of feature extraction in a single deep convolutional neural network VGG (visual geometry group) and the challenges of historical memory in a single recurrent neural network (RNN), an improved deep learning model for violence behavior detection, known as the visual geometry group network?bidirectional long short?term memory network?improved attention mechanism (VBA?net), has been proposed. This model is based on improved attention mechanism and deep spatio?temporal network. The approach begins by extracting key local features with the deep neural network (DNN) of the VGG. Subsequently, an improved attention mechanism is employed to capture and optimize the most significant features. Finally, the bidirectional long short?term memory network (Bi?LSTM) is used to process temporal data of both past and future contexts. Simulation results demonstrate that the VBA?net achieves accuracy rates of 97.42% and 98.06% on the smaller HockeyFight and Movies datasets, respectively, and accuracy rates of 89.00% and 95.50% on the more diverse and complex RWF?2000 and RLVS datasets, respectively. Thus, it exhibits superior comprehensive robustness in complex environment in comparison with the similar algorithms. To sum up, it can improve the accuracy of the tasks of violent behavior detection effectively.

Keywords: violence behavior detection; DCNN; Bi?LSTM; attention mechanism; VBA?net; feature extraction

0 "引 "言

近年來,隨著計算機視覺領域的快速發展,暴力行為識別已成為研究熱點之一,并且在校園安全管理、城市監控系統以及家庭安全等方面具有應用價值。隨著深度學習技術的發展,這一領域的研究方法呈現快速發展的趨勢。與傳統技術相比,深度學習能夠自動地提取低層次到高層次的抽象特征,特別是卷積神經網絡(CNN)和循環神經網絡(Recurrent Neural Network, RNN)成為處理此類問題的主流技術,吸引眾多學者構建新的模型。文獻[1]采用3D SE?Densenet模型提取視頻中的時空特征信息,但未充分考慮暴力行為的時序性。文獻[2]將前景圖輸入到網絡模型中提取視頻特征。首先利用輕量化EfficientNet提取前景圖中的幀級空間暴力特征;然后利用卷積長短時記憶(ConvLSTM)網絡進一步提取視頻序列的全局時空特征。文獻[3]提出一種改進R?C3D網絡的暴力行為時序定位方法,將殘差模塊的直接映射分支結構進行優化,減少時空特征丟失,同時將殘差分支進行時空特征密集拼接,減少梯度彌散。文獻[4]使用卷積長短期記憶網絡來學習檢測暴力視頻的方法,通過使用ConvLSTM網絡結構,利用視頻序列的時空信息進行暴力行為檢測,但缺乏數據處理的靈活性和泛化能力。

注意力機制已經被證實是一種有效的策略,通過對不同模塊的自動加權,關注輸入序列中的特定部分。文獻[5]提出一種基于注意力機制的BiLSTM模型,該模型通過注意力機制對行為序列中的重要部分進行自動加權,有效地分析行為前后關系,從而實現高精度的行為識別。

綜上所述,我國在計算機科學領域已取得一系列重要成就,但在模型分類和仿真技術方面仍存在一定的缺陷。因此,本文提出一種改進注意力機制與深度時空神經網絡的暴力行為檢測模型——VBA?net(Visual Geometry Group Network?Bidirectional Long Short?Term Memory Network?Improving Attention Mechanism)。該模型結合VGG網絡(Visual Geometry Group Network)和雙向長短期記憶(BiLSTM)神經網絡的優勢來提取視頻序列中的時空特征。在VGG網絡中引入一種基于格拉姆矩陣運算的殘差自注意力機制,進一步增強模型對于關鍵特征的識別能力,從而提升模型在暴力行為檢測任務中的準確率和魯棒性。

1 "方法及原理

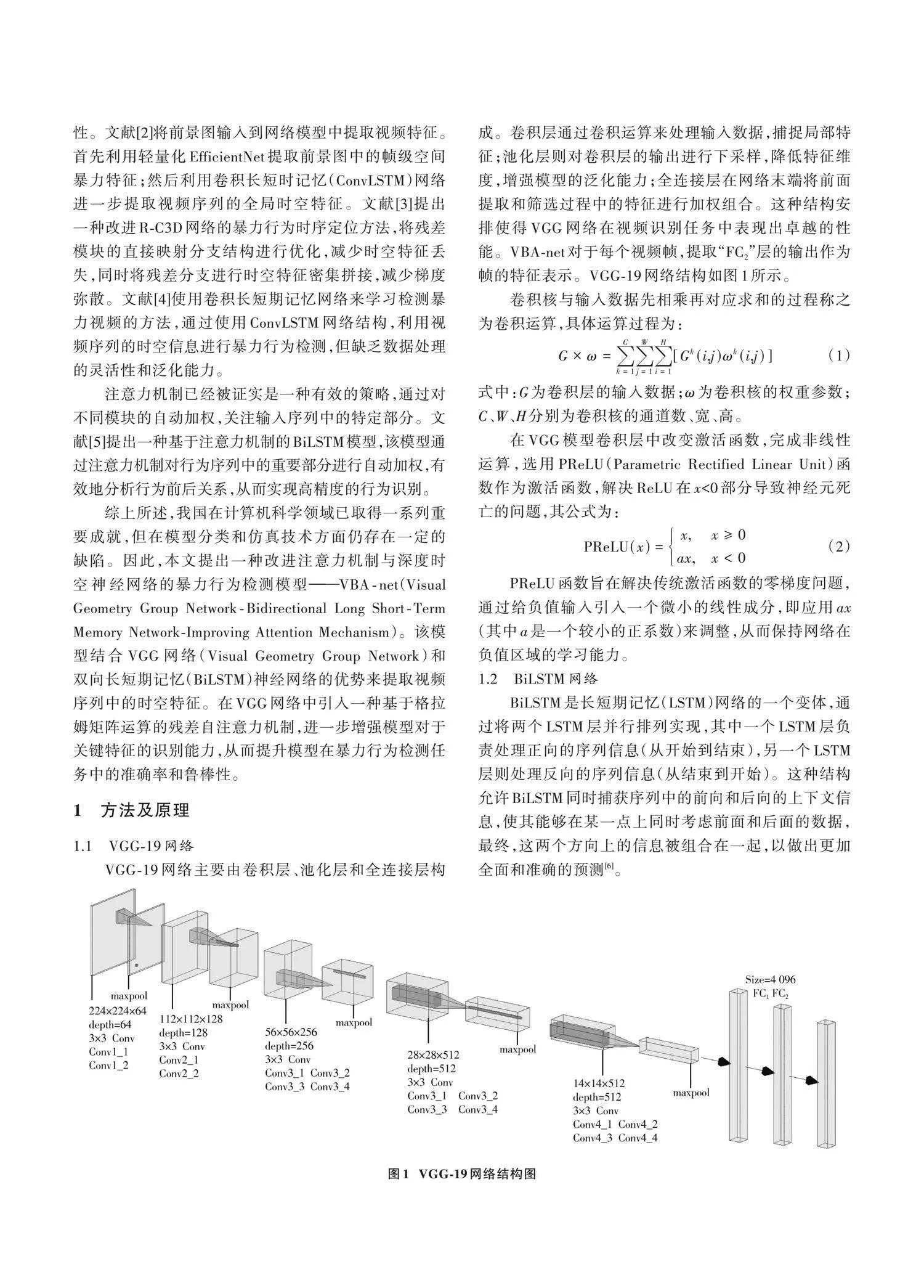

1.1 "VGG?19網絡

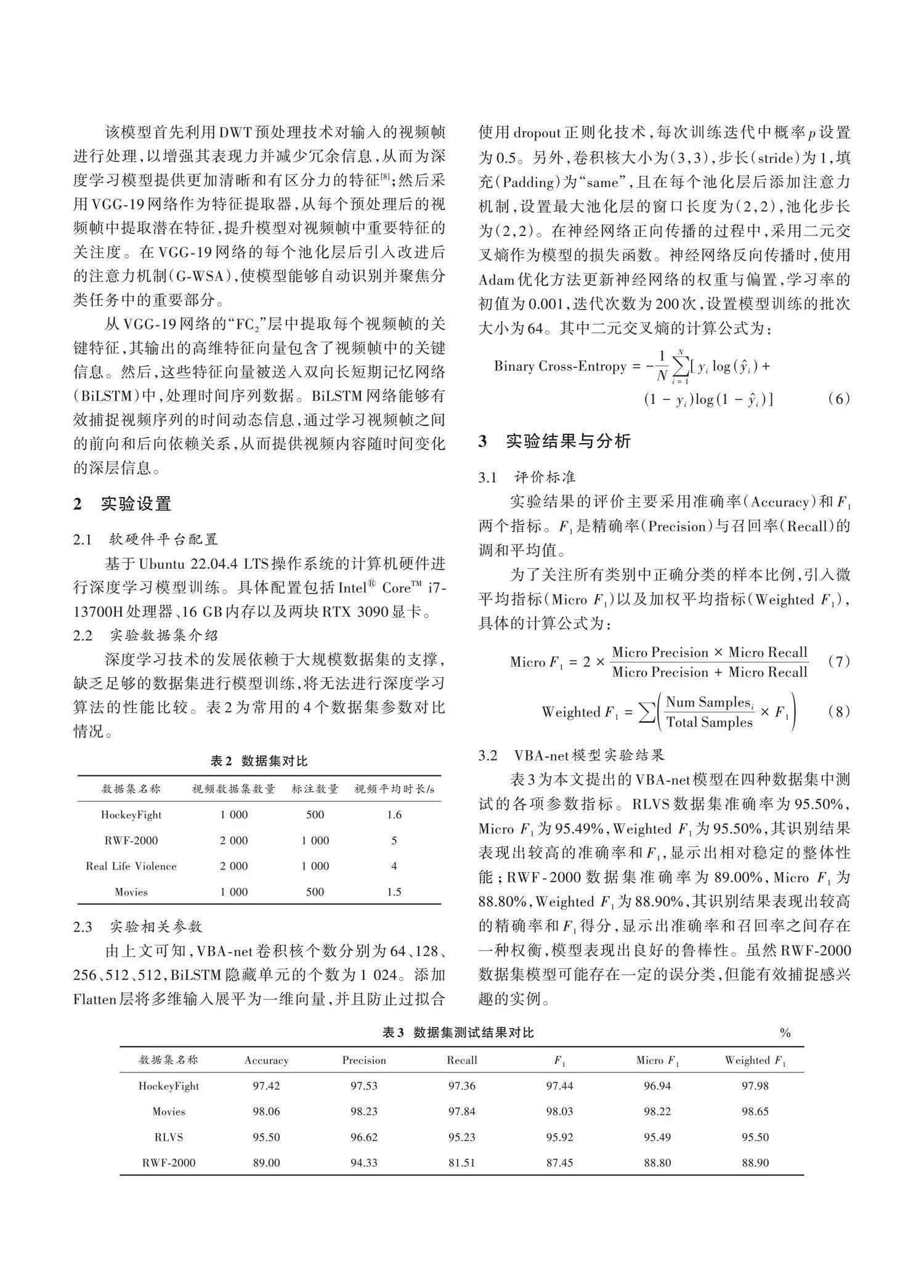

VGG?19網絡主要由卷積層、池化層和全連接層構成。卷積層通過卷積運算來處理輸入數據,捕捉局部特征;池化層則對卷積層的輸出進行下采樣,降低特征維度,增強模型的泛化能力;全連接層在網絡末端將前面提取和篩選過程中的特征進行加權組合。這種結構安排使得VGG網絡在視頻識別任務中表現出卓越的性能。VBA?net對于每個視頻幀,提取“FC2”層的輸出作為幀的特征表示。VGG?19網絡結構如圖1所示。

卷積核與輸入數據先相乘再對應求和的過程稱之為卷積運算,具體運算過程為:

[G×ω=k=1Cj=1Wi=1H[Gk(i,j)ωk(i,j)]] (1)

式中:[G]為卷積層的輸入數據;[ω]為卷積核的權重參數;[C]、[W]、[H]分別為卷積核的通道數、寬、高。

在VGG模型卷積層中改變激活函數,完成非線性運算,選用PReLU(Parametric Rectified Linear Unit)函數作為激活函數,解決ReLU在[x]lt;0部分導致神經元死亡的問題,其公式為:

[PReLU(x)=x,x≥0ax,xlt;0] (2)

PReLU函數旨在解決傳統激活函數的零梯度問題,通過給負值輸入引入一個微小的線性成分,即應用[ax](其中[a]是一個較小的正系數)來調整,從而保持網絡在負值區域的學習能力。

1.2 "BiLSTM網絡

BiLSTM是長短期記憶(LSTM)網絡的一個變體,通過將兩個LSTM層并行排列實現,其中一個LSTM層負責處理正向的序列信息(從開始到結束),另一個LSTM層則處理反向的序列信息(從結束到開始)。這種結構允許BiLSTM同時捕獲序列中的前向和后向的上下文信息,使其能夠在某一點上同時考慮前面和后面的數據,最終,這兩個方向上的信息被組合在一起,以做出更加全面和準確的預測[6]。

BiLSTM網絡結構如圖2所示。

在時間步[t]的網絡輸出預測值為:

[ylt;tgt;=g(Wy[alt;tgt;;alt;tgt;]+by)] (3)

式中:[alt;tgt;]、[alt;tgt;]分別為時間步[t]的正向LSTM隱藏狀態和反向LSTM隱藏狀態;[t]代表時間;[Wy]代表輸出層的權值向量,用于將BiLSTM網絡的隱藏狀態轉換為輸出;[by]代表輸出層的偏置向量,用于激活函數之前的線性變換;[g]代表激活函數sigmoid,值域為[0,1]。

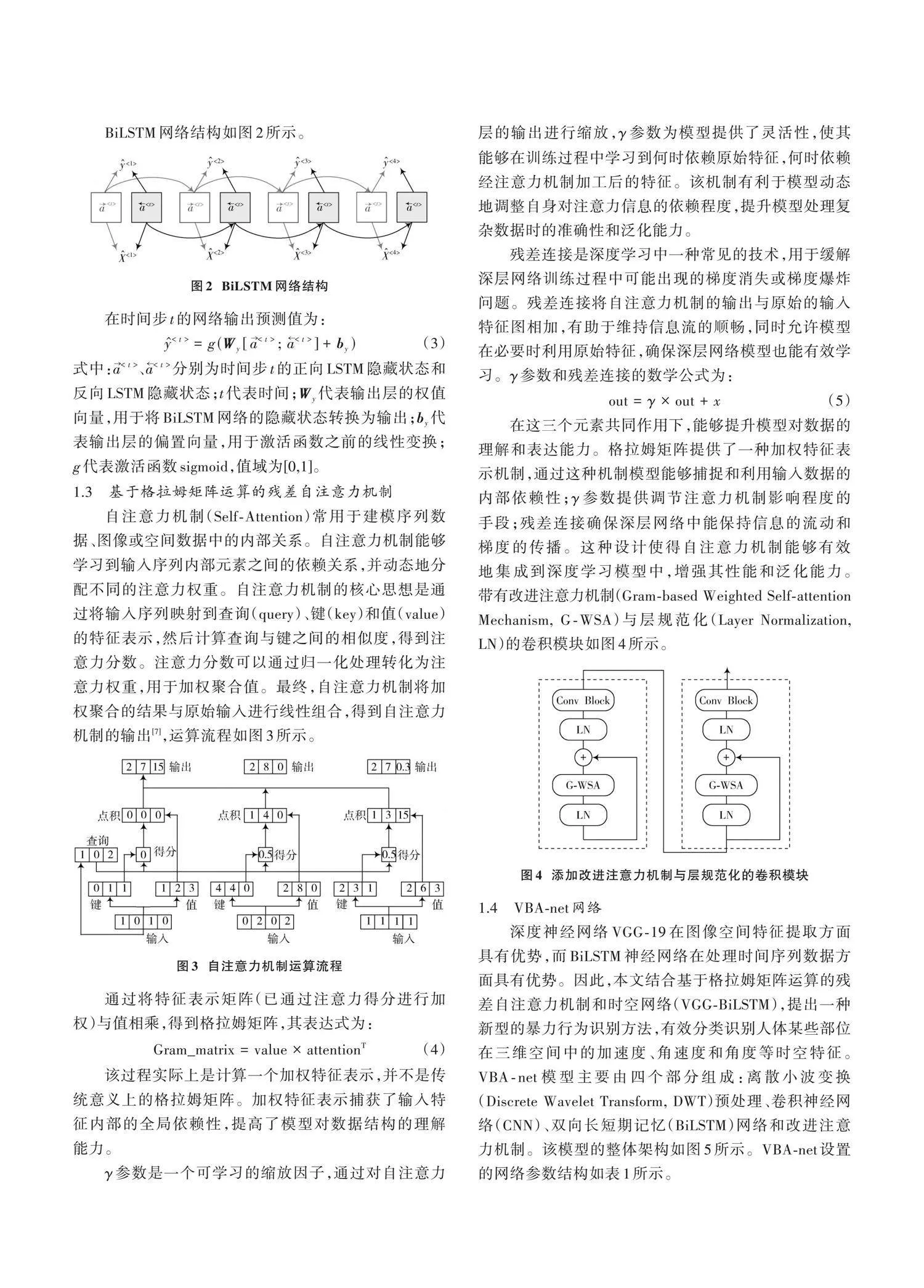

1.3 "基于格拉姆矩陣運算的殘差自注意力機制

自注意力機制(Self?Attention)常用于建模序列數據、圖像或空間數據中的內部關系。自注意力機制能夠學習到輸入序列內部元素之間的依賴關系,并動態地分配不同的注意力權重。自注意力機制的核心思想是通過將輸入序列映射到查詢(query)、鍵(key)和值(value)的特征表示,然后計算查詢與鍵之間的相似度,得到注意力分數。注意力分數可以通過歸一化處理轉化為注意力權重,用于加權聚合值。最終,自注意力機制將加權聚合的結果與原始輸入進行線性組合,得到自注意力機制的輸出[7],運算流程如圖3所示。

通過將特征表示矩陣(已通過注意力得分進行加權)與值相乘,得到格拉姆矩陣,其表達式為:

[Gram_matrix=value×attentionT] (4)

該過程實際上是計算一個加權特征表示,并不是傳統意義上的格拉姆矩陣。加權特征表示捕獲了輸入特征內部的全局依賴性,提高了模型對數據結構的理解能力。

[γ]參數是一個可學習的縮放因子,通過對自注意力層的輸出進行縮放,[γ]參數為模型提供了靈活性,使其能夠在訓練過程中學習到何時依賴原始特征,何時依賴經注意力機制加工后的特征。該機制有利于模型動態地調整自身對注意力信息的依賴程度,提升模型處理復雜數據時的準確性和泛化能力。

殘差連接是深度學習中一種常見的技術,用于緩解深層網絡訓練過程中可能出現的梯度消失或梯度爆炸問題。殘差連接將自注意力機制的輸出與原始的輸入特征圖相加,有助于維持信息流的順暢,同時允許模型在必要時利用原始特征,確保深層網絡模型也能有效學習。[γ]參數和殘差連接的數學公式為:

[out=γ×out+x] (5)

在這三個元素共同作用下,能夠提升模型對數據的理解和表達能力。格拉姆矩陣提供了一種加權特征表示機制,通過這種機制模型能夠捕捉和利用輸入數據的內部依賴性;[γ]參數提供調節注意力機制影響程度的手段;殘差連接確保深層網絡中能保持信息的流動和梯度的傳播。這種設計使得自注意力機制能夠有效地集成到深度學習模型中,增強其性能和泛化能力。帶有改進注意力機制(Gram?based Weighted Self?attention Mechanism, G?WSA)與層規范化(Layer Normalization, LN)的卷積模塊如圖4所示。

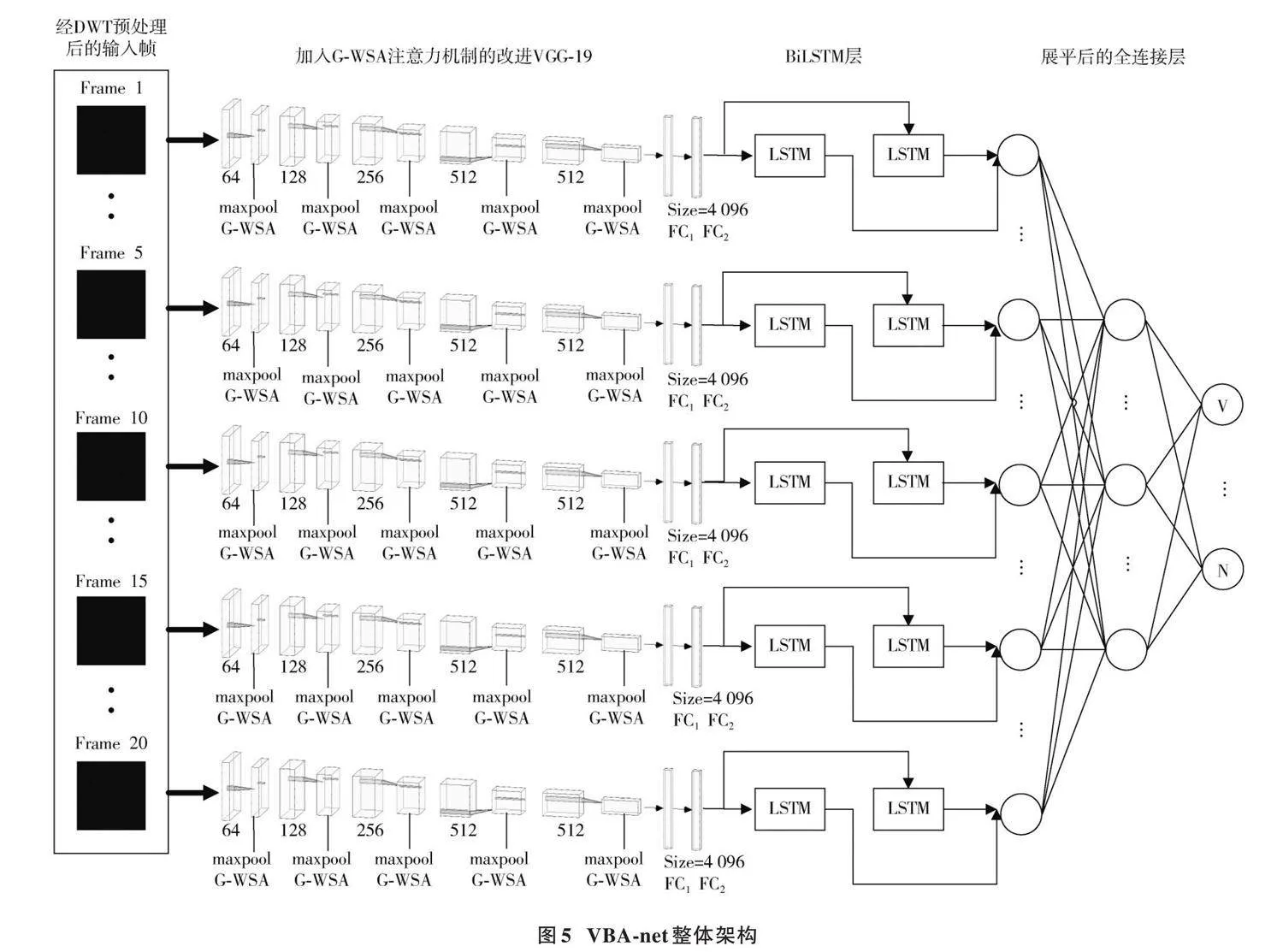

1.4 "VBA?net網絡

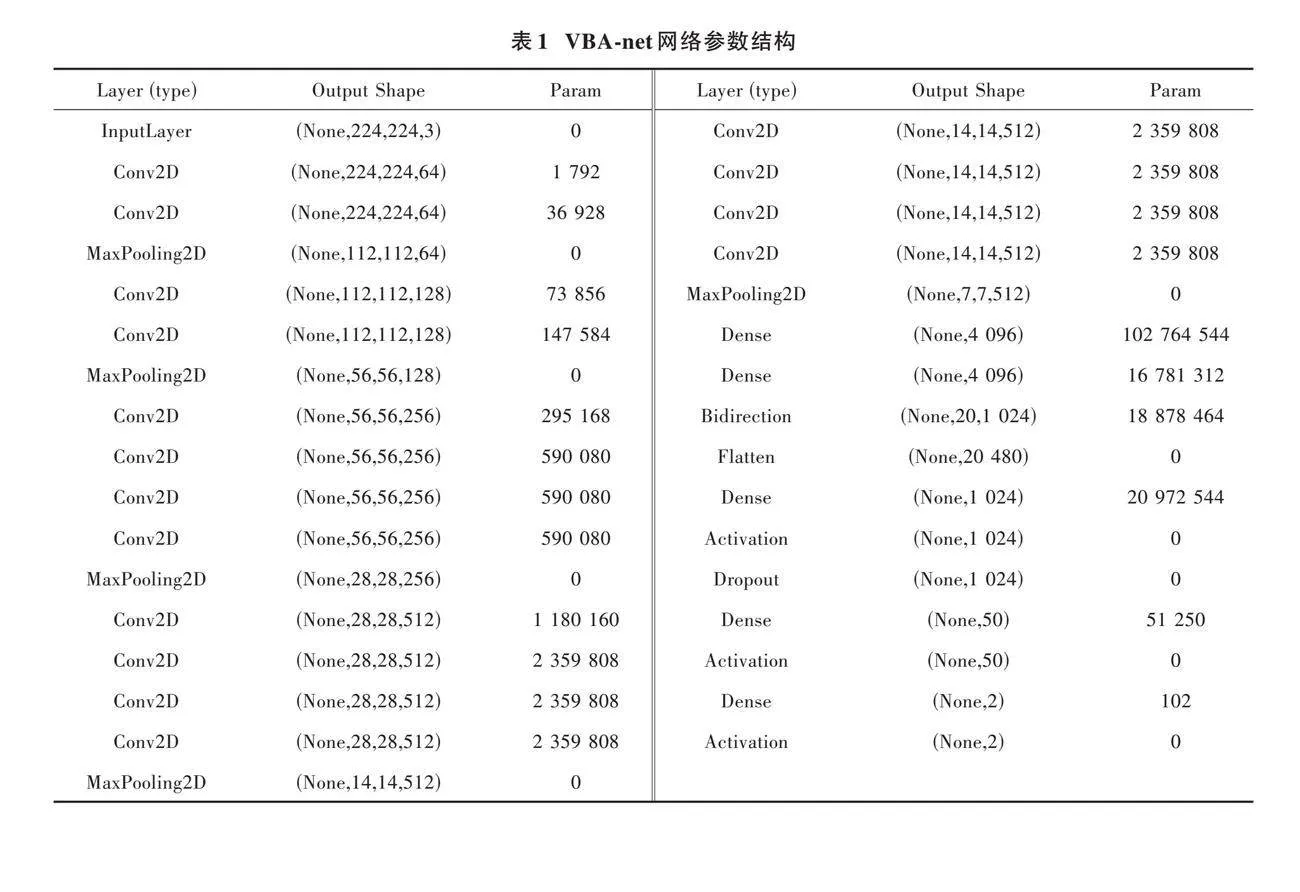

深度神經網絡VGG?19在圖像空間特征提取方面具有優勢,而BiLSTM神經網絡在處理時間序列數據方面具有優勢。因此,本文結合基于格拉姆矩陣運算的殘差自注意力機制和時空網絡(VGG?BiLSTM),提出一種新型的暴力行為識別方法,有效分類識別人體某些部位在三維空間中的加速度、角速度和角度等時空特征。VBA?net模型主要由四個部分組成:離散小波變換(Discrete Wavelet Transform, DWT)預處理、卷積神經網絡(CNN)、雙向長短期記憶(BiLSTM)網絡和改進注意力機制。該模型的整體架構如圖5所示。VBA?net設置的網絡參數結構如表1所示。

該模型首先利用DWT預處理技術對輸入的視頻幀進行處理,以增強其表現力并減少冗余信息,從而為深度學習模型提供更加清晰和有區分力的特征[8];然后采用VGG?19網絡作為特征提取器,從每個預處理后的視頻幀中提取潛在特征,提升模型對視頻幀中重要特征的關注度。在VGG?19網絡的每個池化層后引入改進后的注意力機制(G?WSA),使模型能夠自動識別并聚焦分類任務中的重要部分。

從VGG?19網絡的“[FC2]”層中提取每個視頻幀的關鍵特征,其輸出的高維特征向量包含了視頻幀中的關鍵信息。然后,這些特征向量被送入雙向長短期記憶網絡(BiLSTM)中,處理時間序列數據。BiLSTM網絡能夠有效捕捉視頻序列的時間動態信息,通過學習視頻幀之間的前向和后向依賴關系,從而提供視頻內容隨時間變化的深層信息。

2 "實驗設置

2.1 "軟硬件平臺配置

基于Ubuntu 22.04.4 LTS操作系統的計算機硬件進行深度學習模型訓練。具體配置包括Intel[?] CoreTM i7?13700H處理器、16 GB內存以及兩塊RTX 3090顯卡。

2.2 "實驗數據集介紹

深度學習技術的發展依賴于大規模數據集的支撐,缺乏足夠的數據集進行模型訓練,將無法進行深度學習算法的性能比較。表2為常用的4個數據集參數對比情況。

2.3 "實驗相關參數

由上文可知,VBA?net卷積核個數分別為64、128、256、512、512,BiLSTM隱藏單元的個數為1 024。添加Flatten層將多維輸入展平為一維向量,并且防止過擬合使用dropout正則化技術,每次訓練迭代中概率[p]設置為0.5。另外,卷積核大小為(3,3),步長(stride)為1,填充(Padding)為“same”,且在每個池化層后添加注意力機制,設置最大池化層的窗口長度為(2,2),池化步長為(2,2)。在神經網絡正向傳播的過程中,采用二元交叉熵作為模型的損失函數。神經網絡反向傳播時,使用Adam優化方法更新神經網絡的權重與偏置,學習率的初值為0.001,迭代次數為200次,設置模型訓練的批次大小為64。其中二元交叉熵的計算公式為:

[Binary Cross?Entropy=-1Ni=1N[yilog(yi)+ " " " " " " " " " " " " " " " " " " " " " " "(1-yi)log(1-yi)]] (6)

3 "實驗結果與分析

3.1 "評價標準

實驗結果的評價主要采用準確率(Accuracy)和[F1]兩個指標。[F1]是精確率(Precision)與召回率(Recall)的調和平均值。

為了關注所有類別中正確分類的樣本比例,引入微平均指標(Micro [F1])以及加權平均指標(Weighted [F1]),具體的計算公式為:

[Micro F1=2×Micro Precision×Micro RecallMicro Precision+Micro Recall] (7)

[Weighted F1=Num SamplesiTotal Samples×F1] (8)

3.2 "VBA?net模型實驗結果

表3為本文提出的VBA?net模型在四種數據集中測試的各項參數指標。RLVS數據集準確率為95.50%,Micro [F1]為95.49%,Weighted [F1]為95.50%,其識別結果表現出較高的準確率和[F1],顯示出相對穩定的整體性能;RWF?2000數據集準確率為89.00%,Micro [F1]為88.80%,Weighted [F1]為88.90%,其識別結果表現出較高的精確率和[F1]得分,顯示出準確率和召回率之間存在一種權衡,模型表現出良好的魯棒性。雖然RWF?2000數據集模型可能存在一定的誤分類,但能有效捕捉感興趣的實例。

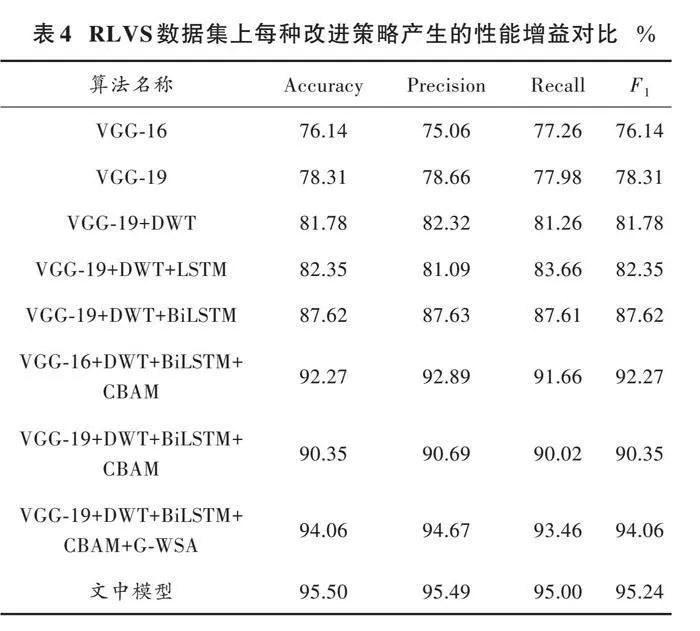

3.3 "消融實驗

為詳細研究本文算法各個模塊產生的性能增益,以VGG?net模型為基礎網絡,選擇添加DWT預處理、LSTM、BiLSTM、卷積塊注意力模塊(Convolutional Block Attention Module, CBAM)、G?WSA,評估算法在RLVS復雜環境數據集的性能指標,結果如表4所示。

1) 在視頻預處理方面,采用常規圖像增廣的方式來增加數據集數量的同時,還對圖像視頻進行離散小波變化(DWT)預處理,選擇感興趣的小波系數進行處理,可以實現數據的壓縮以及減小存儲空間和傳輸帶寬的需求。由實驗數據可知,進行圖像預處理是必要的,可以提高訓練結果的準確率。

2) 如表4所示,模型對“[FC2]”層輸出數據的處理,表現出BiLSTM的耦合性相較于LSTM更優異。BiLSTM通過充分利用序列數據中的雙向上下文信息,既包括從序列起點至當前時刻的歷史信息,也涵蓋從序列終點回溯至當前時刻的未來信息。BiLSTM依托于兩個獨立運作的LSTM單元,分別對數據序列的正向和反向進行處理,并在之后將這兩個方向的信息有效融合,此過程增強模型對于時間序列數據的深度理解。LSTM僅能處理當前時刻的歷史信息,而無法獲取及利用未來時刻的信息,從而限制其在處理具有強時序依賴特性的效能。因此,BiLSTM的設計架構對于需要深度時序分析的應用場景而言,顯示出更加卓越的性能表現。

3) 基于格拉姆矩陣運算的殘差自注意力機制(G?WSA)的添加,對整個模型的整體效能提升顯著,相比CBAM注意力機制效果較好。基于格拉姆矩陣計算注意力得分,可以判斷模型在做出決策時哪些輸入元素起了關鍵作用,從而提高模型的可解釋性。[γ]參數和殘差連接的引入使得自注意力層可以更加有效地集成到深度網絡中,有助于加速訓練過程,其中[γ]參數是一個可學習的縮放因子,允許模型在訓練過程中逐漸評判注意力機制的重要程度。模型在學習期間可以自適應地調整自注意力機制的影響程度,決定將多少注意力特征融合到最終的輸出中。

3.4 "在復雜數據集中與其他檢測方法的比較

為了說明VBA?net模型的魯棒性和有效性,全面評估其識別能力,分別選擇了6種前沿的暴力檢測模型與VBA?net模型在2個復雜環境數據集(RWF?2000、RLVS)下進行識別率對比,結果如表5所示。由表中數據可知,本文所提出的VBA?net模型對復雜環境下暴力行為識別綜合準確率最高。

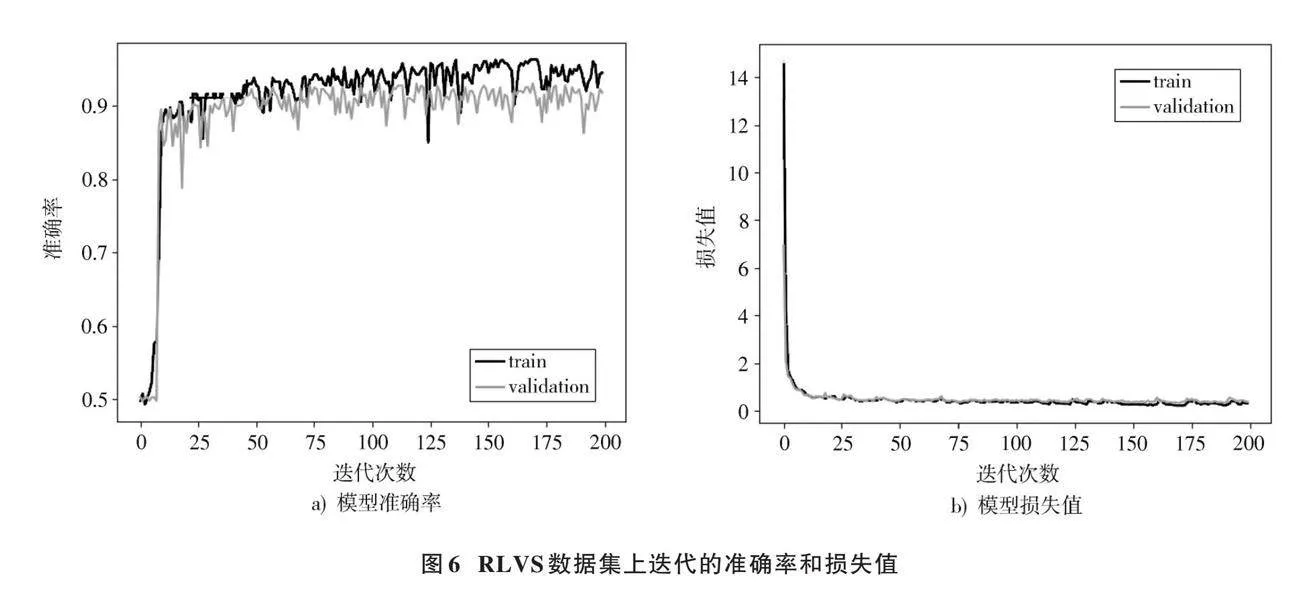

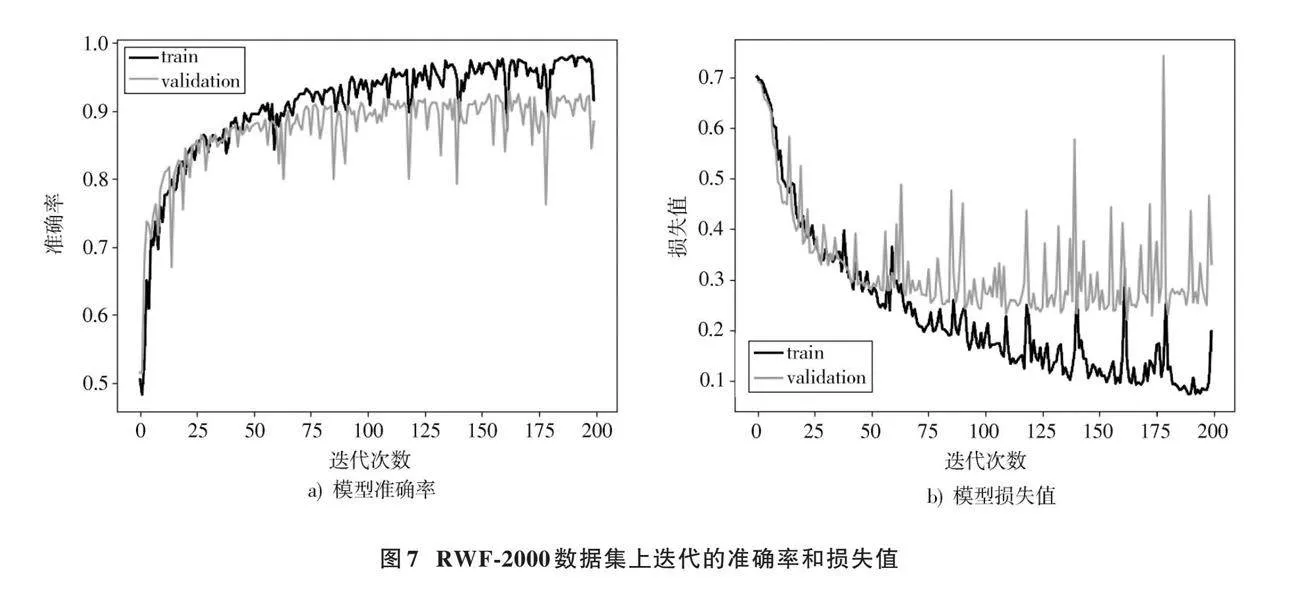

圖6和圖7為VBA?net模型在RLVS和RWF?2000數據集上的訓練與驗證過程中的準確率變化以及損失函數的迭代過程。各模型在RLVS數據集上的準確率隨著訓練迭代次數的增加逐漸提高,并最終趨于穩定。RWF?2000數據集上的準確率整體表現良好,但在后期的部分迭代過程中出現劇烈下跌,但隨后迅速恢復到穩定狀態,這種現象反映了模型在處理復雜數據集時部分組件的耦合性不足。本文提出的VBA?net網絡模型在訓練集上表現出較快的收斂速度,并在達到穩定后表現出較高的準確率,證明了VBA?net在處理動態和復雜視覺數據方面的優越性和魯棒性。

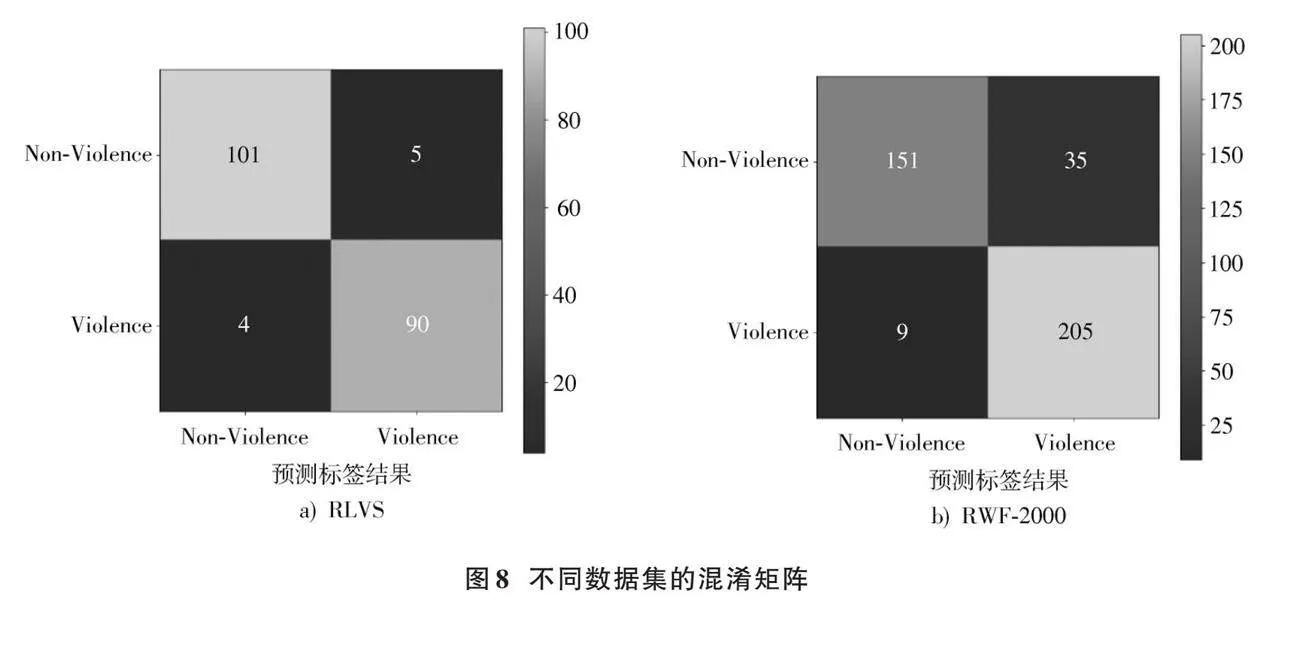

圖8a)和圖8b)分別為RLVS和RWF?2000數據集上的混淆矩陣。混淆矩陣左側的分類代表樣本的實際類別,底側的分類代表模型的預測類別。矩陣中每個單元格的數值反映了對應類別的樣本數量,主對角線上的數值表示模型正確分類的樣本數量,其余單元格的數值則表示分類錯誤的樣本數量。

在RLVS數據集中,模型將5個非暴力行為樣本誤分類成暴力行為,以及4個暴力行為樣本誤分類成非暴力行為,在非暴力行為檢測上存在一定程度的誤分類,但模型整體表現良好。在RWF?2000數據集上,模型將35個非暴力行為樣本誤分類成暴力行為,9個暴力行為樣本誤分類成非暴力行為。非暴力行為的誤報數量(186個樣本中的35個)表明模型可能在標記非暴力行為時過于保守;暴力行為的較低漏報率(214個樣本中的9個)表現出模型在識別暴力行為方面的高準確率。

4 "結 "語

本文提出一種VBA?net模型,其引入了基于格拉姆矩陣運算的殘差自注意力機制(G?WSA),從而能動態地聚焦于更具信息量的特征,同時抑制次要信息,這一特征加權機制使得該模型極大地增強了特征表示能力。VBA?net在HockeyFight、Movies、RWF?2000和RLVS等數據集上進行了廣泛的訓練和驗證。實驗結果表明,VBA?net對于復雜環境下的數據集,特別是RWF?2000和RLVS,相較于其他模型具有更高的綜合識別精度,證明VBA?net在不同場景下暴力行為識別的有效性。盡管VBA?net在復雜環境中表現突出,但對于簡易環境數據集的識別精度略顯不足。因此,未來的研究將著重探索能在各類數據集上表現均優異的模型算法,研究出更具有魯棒性和泛用性的暴力行為檢測模型。

注:本文通訊作者為代雪晶。

參考文獻

[1] 陳杰,李展,顏普,等.基于3D SE?Densenet網絡的視頻暴力行為識別改進算法[J].安徽建筑大學學報,2023,31(1):56?63.

[2] 蔡興泉,封丁惟,王通,等.基于時間注意力機制和EfficientNet的視頻暴力行為檢測[J].計算機應用,2022,42(11):3564?3572.

[3] 靳偉昭.基于深度學習的暴力行為檢測方法研究[D].西安:西安電子科技大學,2021.

[4] SUDHAKARAN S, LANZ O. Learning to detect violent videos using convolutional long short?term memory [C]// Proceedings of the 14th IEEE International Conference on Advanced Video and Signal Based Surveillance. New York: IEEE, 2017: 1?6.

[5] 朱銘康,盧先領.基于Bi?LSTM?Attention模型的人體行為識別算法[J].激光與光電子學進展,2019,56(15):153?161.

[6] CHATTERJEE R, HALDER R. Discrete wavelet transform for CNN?BiLSTM?based violence detection [C]// International Conference on Emerging Trends and Advances in Electrical Engineering and Renewable Energy. Heidelberg: Springer, 2020: 41?52.

[7] YANG B S, WANG L Y, WONG D F, et al. Convolutional self?attention networks [EB/OL]. [2019?04?24]. http://arxiv.org/abs/1904.03107.

[8] 張帥濤,蔣品群,宋樹祥,等.基于注意力機制和CNN?LSTM融合模型的鋰電池SOC預測[J].電源學報,2024,22(5):269?277.

[9] JAIN A, VISHWAKARMA D K. Deep NeuralNet for violence detection using motion features from dynamic images [C]// 2020 3rd International Conference on Smart Systems and Inventive Technology (ICSSIT). New York: IEEE, 2020: 826?831.

[10] TRAN D, BOURDEV L, FERGUS R, et al. Learning spatiotemporal features with 3D convolutional networks [C]// Proceedings of the IEEE International Conference on Computer Vision. New York: IEEE, 2015: 4489?4497.

[11] QIU Z F, YAO T, MEI T. Learning spatio?temporal representation with pseudo?3D residual networks [C]// Proceedings of the IEEE International Conference on Computer Vision. New York: IEEE, 2017: 5534?5542.

[12] SANTOS F A O, DURAES D, MARCONDES F S, et al. Efficient violence detection using transfer learning [C]// Procee?dings of the Practical Applications of Agents and Multi?agent Systems. Heidelberg: Springer, 2021: 65?75.

[13] TRAN D, WANG H, TORRESANI L, et al. A closer look at spatiotemporal convolutions for action recognition [C]// Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition. New York: IEEE, 2018: 6450?6459.

[14] RENDON?SEGADOR F J, ALVAREZ?GARCIA J A, ENRIQUEZ F, et al. ViolenceNet: Dense multi?head self?attention with bidirectional convolutional LSTM for detecting violence [J]. Electronics, 2021, 10: 1601.

[15] ALDAHOUL N, KARIM H A, DATTA R, et al. Convolutional neural network?long short term memory based IoT node for violence detection [C]// 2021 IEEE International Conference on Artificial Intelligence in Engineering and Technology (IICAIET). New York: IEEE, 2021: 1?6.

[16] ULLAH F U M, MUHAMMAD K, HAQ I U, et al. AI?assisted edge vision for violence detection in IoT?based industrial surveillance networks [J]. IEEE transactions on industrial informatics, 2022, 18(8): 5359?5370.

[17] SU Y K, LIN G S, ZHU J H, et al. Human interaction learning on 3D skeleton point clouds for video violence recognition [C]// Proceedings of 16th European Conference on Computer Vision. Heidelberg: Springer, 2020: 74?90.

[18] CHENG M, CAI K J, LI M. RWF?2000: An open large scale video database for violence detection [C]// 2020 25th International Conference on Pattern Recognition (ICPR). New York: IEEE, 2020: 4183?4190.

[19] VIJEIKIS R, RAUDONIS V, DERVINIS G. Efficient violence detection in surveillance [J]. Sensors, 2022, 22(6): 2216.

[20] HUSZáR V D, ADHIKARLA V K, NEGYESI I, et al. Toward fast and accurate violence detection for automated video surveillance applications [J]. IEEE access, 2023, 11: 18772?18793.

[21] 朱光輝,繆君,胡宏利,等.基于自增強注意力機制的室內單圖像分段平面三維重建[J].圖學學報,2024,45(3):464?471.

作者簡介:李金成(2001—),男,湖北宜昌人,碩士研究生,研究方向為步態識別技術。

閆睿驁(2000—),男,內蒙古赤峰人,碩士研究生,研究方向為步態識別技術。

代雪晶(1970—),女,遼寧鳳城人,博士研究生,教授,碩士生導師,研究方向為聲像資料技術。