基于MediaPipe-MeshFace模型的面部多特征疲勞駕駛檢測算法

摘要:針對當前疲勞檢測技術在精確評估駕駛員疲勞程度、建立監測指標關聯性,以及在處理極端頭部運動時面部追蹤方面的不足,提出了一種創新的解決方案,該方案依托于MediaPiPe-MeshFace模型,旨在實現更精細的疲勞駕駛識別。該模型通過精準定位面部468個關鍵點,特別強調了眼瞼作為眼部疲勞判斷的關鍵要素,以此捕獲更為微妙的疲勞跡象,增強檢測準確性。此外,引入歐拉角分析頭部的空間姿態變化,提高了在頭部快速大幅度移動情況下的穩定追蹤能力。通過整合眼瞼活動性、口部形態變化以及頭部姿態的動態信息,構建了一套多維度面部特征融合的疲勞檢測機制。實驗驗證了該方法不僅能夠有效辨識駕駛員的疲勞狀態,還成功實現了疲勞級別的劃分,并在面對特定挑戰如劇烈頭部動作時,顯著改善了面部疲勞特征的提取效能。

關鍵詞:疲勞駕駛;多特征融合;MediaPiPe-MeshFace模型;眼瞼;歐拉角分析;頭部姿態追蹤

中圖分類號:TP391 文獻標識碼:A

文章編號:1009-3044(2024)22-0014-05

開放科學(資源服務)標識碼(OSID) :<E:\飛翔打包文件目錄001\電腦2024年8月上第二十二期打包文件\9.01xs202422\Image\image39.jpeg>

0 引言

根據數據統計顯示,疲勞駕駛是導致交通事故的主要原因之一[1]。疲勞駕駛引發交通事故的概率是正常駕駛的4~6倍[2]。每年約有20%的交通事故由疲勞駕駛所致,而特大交通事故中,有40%以上與疲勞駕駛有關[3]。若能及早發出警示以避免交通事故的發生[4],對交通安全具有重要意義[5]。

隨著科學技術的發展,疲勞駕駛檢測方法不斷完善,尤其是計算機視覺技術和深度卷積神經網絡技術[6]。許多學者利用視覺傳感器提取面部特征,并使用人臉檢測技術和面部特征關鍵點定位方法來判斷駕駛員的疲勞狀態[7]。2019年,劉敏等首次提出了Adaboost+ASM+膚色檢測+瞳孔定位的算法,該算法通過點頭率、頭部異常率和眨眼率等指標,為疲勞監測問題提供了解決思路和方案[8]。2012年,李昌智等人提出了一種方案,該方案優化了傳統眼部和嘴部檢測方法的局限性。他們使用膚色模型快速檢測并確定人臉區域,并結合二值化和水平灰度方法準確定位眼睛位置,通過分析PERCLOS、眼睛閉合時間、眼睛眨眼頻率、嘴巴張開程度和頭部運動等綜合因素對駕駛員的疲勞程度進行判定[9]。盡管早期相關研究在疲勞駕駛檢測方面取得了一定進展,但現有的一些檢測方法尚未能很好地量化駕駛員的疲勞程度和監測指標之間的關系,且疲勞的分級不夠準確,以及在頭部晃動幅度過大過快時無法跟蹤面部等問題。因此,設計一種能夠對疲勞狀態進行分級,且穩定性好、識別率高的算法非常重要。

因此,本文提出了一種基于 MediaPipe-MeshFace 框架的面部多特征疲勞駕駛檢測算法 FMFDD-3M (Facial Multi-feature Fatigue Driving Detection Algorithm Based on MediaPipe-MeshFace Modeling)。首先,采用 Google 的 MediaPipe-MeshFace 面網模型,能夠精確定位面部的468個關鍵點。首次將眼瞼作為眼部疲勞檢測的重要參數之一,獲取更細微的特征,以提高疲勞檢測的識別率。然后,用歐拉角的變換來檢測頭部空間姿態[10],以增加頭部晃動時目標檢測的穩定性。最后,將眼瞼動態與嘴部長寬比和頭部空間姿態變化融合,得到一種面部多特征疲勞檢測方法。該方法能夠有效識別疲勞駕駛狀態,實現疲勞狀態分級,在頭部晃動幅度過大過快時具有很高的穩定性。

1 眼部疲勞狀態判斷

1.1 眼瞼信息提取與定位

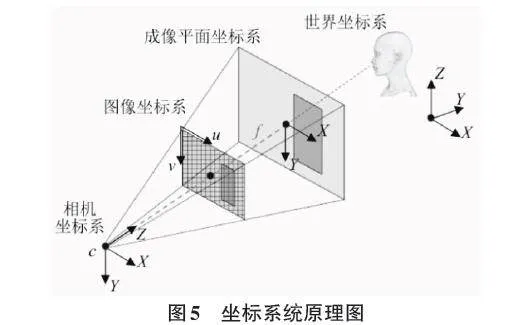

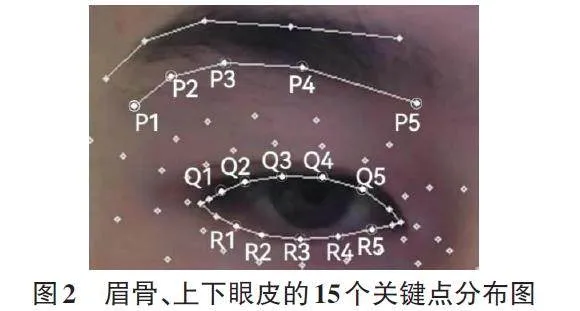

眼部的變化能夠很好地反映駕駛員的疲勞狀態。在疲勞時,眼睛閉眼是其主要表現特征之一[11]。在閉眼的過程中,眼瞼也會發生變化。因此,通過測量眼瞼相關數據,可以更準確地獲取眼睛的當前狀況,從而識別駕駛員更細微的疲勞狀態。觀察發現,當眼睛閉合時,眼瞼寬度增大,上下眼皮的距離減小。眼瞼寬度與上下眼皮距離的比值的變化更為明顯。因此,通過觀察這些變化,可以更明顯地判斷駕駛員是否疲勞。眼瞼寬度與上下眼皮距離的具體分布如下:

在眼瞼定位方面,傳統的 Dlib 模型僅包含68個標記點[12],僅檢測眼部的上下眼皮和眼角的6個點。而 Google 的 MediaPipe-MeshFace 面網標記的468個關鍵點模型提供了更細微的面部檢測,包括眉骨和上下眼皮的15個點。如圖2所示,其中表示眉骨的5個選定點,表示上眼皮的5個選定點,表示下眼皮的5個選定點。利用眉骨和上眼皮各點之間的距離可以很好地描述眼瞼的變化。

1.2 眼部疲勞狀態識別

眨眼是人眼快速閉合和重新打開的過程[14]。每個人的眨眼過程略有差異,包括眼睛閉合和打開速度、眼瞼寬度的變化以及眨眼持續時間等方面。通常情況下,眨眼持續時間約為100 ms到400 ms[15]。可以通過分析眼瞼的閉合程度、眨眼頻率以及眼瞼寬度等參數來評估駕駛員的疲勞程度和注意力狀態[16]。如果發現駕駛員的眼瞼寬度長時間保持較大值或者頻繁眨眼,這可能表示駕駛員處于疲勞狀態或者注意力不集中[17],需要及時發出警告以減少交通事故的風險。此外,國際上公認的疲勞狀態判定準則之一是 PERCLOS(Percent of Eye Closure over Time) 指標[18]。該指標綜合考慮了駕駛員眼睛閉合的幀數所占比例 ECR(Eye Closure Rate) 、最長持續閉眼時間 MECT(Max Eye Closure Time) 以及眨眼頻率 BF(Blink Frequency) 等因素,使疲勞狀態的判斷更加準確。因此,本文使用眼瞼寬度與上下眼皮的距離比值,并結合眼睛閉合程度、眨眼頻率以及 PERCLOS 指標,來識別出眼部的疲勞狀態。

眼瞼寬度與上下眼皮的距離的比值的計算過程如下:

任意兩個三維坐標點 V1、V2 之間的空間距離計算公式:

[V1-V2x,y,z=x1-x22+y1-y22+z1-z22] (1)

首先,需要明確的是,人的眼睛形狀并非完美的橢圓形,而更接近于一個扁平的球體。然而,為了簡化計算和理解,本文將其近似為橢圓形。這些權重代表了眼睛不同部位對疲勞檢測的影響程度。具體來說,0.05、0.20、0.50、0.20、0.05這五個權值分別代表了眼睛上下眼皮對應點的視覺重要性。在這個權值設置中,最大的權值是0.50,代表的是眼睛的中間部分,也就是瞳孔所在的區域。其次,0.20的權值代表的是眼睛的上半部分和下半部分。這兩部分雖然不如瞳孔區域重要,但仍然對疲勞檢測有一定的影響。最后,0.05的權值代表的是眼睛的最上方和最下方。這兩部分對疲勞檢測的影響最小。

[rations=0.05,0.20,0.50,0.20,0.05]

眼瞼寬度與上下眼皮的距離的比值([eye_value]) 的計算公式:

[eye_value=n=05Pn-QnQn-Rn×rationsn] (2)

式(2) 中,當[n(n=1,2…5)]為1時[P1-Q1Q1-R1]表示第一組數據值,從睜眼到閉眼的過程中,第一組眼瞼寬度[P1-Q1]增大,第一組上下眼皮的距離[P1-Q1]減小,[eye_value]值變大,因此,通過分析[eye_value]值,便可判斷眼睛的閉合狀態。

通過多次實驗分析數據發現,在正常情況下,眼睛的[eye_value]值大約在范圍內。而閉眼狀態下,[eye_value]值在[0.2±0.03]范圍內。因此,本文將閾值設定為0.3作為判斷眼部狀態的主要依據。當眼睛的[eye_value]值低于0.3時,可以判斷為閉眼行為的發生。據調查,普通人在清醒狀態下,眨眼頻率為15~20次/分鐘,眨眼間隔時間為3~4 s,每次眨眼的持續時間平均為100~400 ms[19]。在疲勞狀態下,人的注意力更難集中,閉眼的持續時間也會明顯延長。因此,閉眼持續時間是判斷疲勞狀態的主要指標之一。基于以上數據和多次實驗證明,本文可以設定參數來判斷疲勞狀態。例如,設定一個判斷周期為50幀,當閉眼持續時間超過判斷周期的60%時,本文初步判斷該駕駛員處于疲勞狀態。

如圖3所示,0~100幀內發生了兩次眨眼,而100~350幀內發生了兩次長時間閉眼和長時間睜眼。此外,大于400幀的區間發生了快速眨眼。圖中清楚地展示了根據eye_value值眼部狀態的時間序列變化。通過設定特定的閾值和圖中的變化,可以了解眼部狀態的變化,包括眨眼、長時間閉眼和長時間睜眼,以及快速眨眼的情況。

2 嘴部疲勞狀態判斷

在疲勞駕駛檢測中,嘴部也是主要的檢測指標之一[20]。在Dlib提出的68個關鍵點標記中,嘴唇只有8個標記點,無法精確測量嘴部變化。然而,在MediaPiPe-MeshFace面網模型中,嘴唇的特征點多達80個。通過多次實驗,本文選取了16個具有代表性的特征點,這些特征點可以很好地衡量嘴唇的各種變化,同時提高了精度和結果的可靠性。常見的嘴部狀態可分為閉合、張開和打哈欠等3種情況[21]。其中,打哈欠是最明顯的瞌睡跡象[22],因此可以通過分析打哈欠的過程來判斷駕駛員是否疲勞。根據嘴部閉合幀數所占比例MCR (Mouth Closure Rate)、嘴巴最長持續閉合時間MMCT (Max Mouth Closure Time)以及嘴巴張開頻率MOF (Mouth Opening Frequency)等相關參數來分析駕駛員是否疲勞。

在上嘴唇和下嘴唇各選取7個點,左右嘴角分別選取1個點。其中,上嘴唇選取的7個點分別標記為[H1-H7],下嘴唇選取的7個點分別標記為[L1~L7],左嘴角選取點標記為W1,右嘴角選取點標記為W2。嘴部各點的具體位置如圖4所示。為判斷駕駛員疲勞狀態的數據值([mouth_value]) ,使用上下嘴唇距離與兩嘴角距離的比值。具體計算過程如下:

上下嘴唇距離([distance]) 的計算公式:

[distance=n=07Hn-Ln] (3)

兩嘴角距離([corner]) 計算公式:

[corner=W1-W2] (4)

上下嘴唇距離與兩嘴角距離的比值([mouth_value]) 計算公式:

[mouth_value=distance7corner] (5)

在嘴巴從閉合到張開的過程中,[distance]增大,[corner]減小,[mouth_value]值將會增大,因此,通過分析[mouth_value]值可初步判斷駕駛員的疲勞狀態。

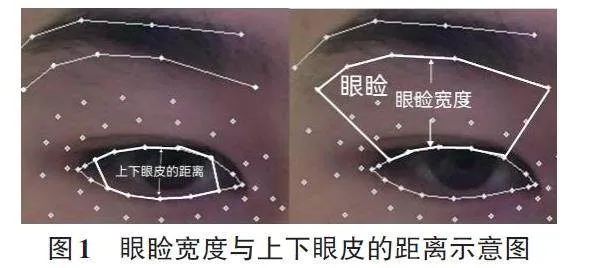

3 頭部姿態估計

在真實的駕駛環境中,駕駛員的頭部姿態估計主要用于判斷駕駛員是否疲勞,以確保安全并減少事故[23]。因此,頭部姿態是評估駕駛員疲勞程度中的一個重要指標。本文利用 Google 的 MediaPipe-MeshFace 面網模型標記的468個關鍵點,對駕駛員頭部姿態進行估計。具體方法是將以世界坐標系表示的3D人臉坐標映射到以圖像坐標系表示的2D關鍵點坐標。轉換原理如圖5所示。

在圖5中,從左到右依次為相機坐標系、圖像坐標系、成像平面坐標系和世界坐標系。由于系統是通過相機提取人臉圖像,因此首先需要將世界坐標系映射到相機坐標系,也就是將坐標系與攝像機對齊[25]。其中,世界坐標系中的x軸和y軸與圖像的x軸和y軸對齊,正 z軸與攝像機的光軸對齊。坐標系轉換的公式如下。

[XCYCZC1=RT01XWYWZW1] (6)

在公式(6)中,[R]為旋轉矩陣;[T]為平移矩陣。由圖5可知,從相機坐標系到圖像坐標系之間的轉換其實是一種透視變換,在透視變換的過程中產生了一個成像平面坐標系,其中成像平面在相機坐標系中的深度為焦距[f],轉換關系為:

[λXiYi1=f000f0001XCYCZC] (7)

成像平面坐標系通過式(7)映射到圖像坐標系中:

[XPYP1=mxsx00myy0001XiYi1] (8)

公式(8)中,[mx]和[my]為每個圖像方向的像素比例因子;[s]為傳感器的傾斜因子;[x0]和[y0]為光軸和像素平面的交叉點。

最終將式(6)-(8)相結合,得到圖像坐標系與世界坐標系的映射關系為:

[RT01XWYWZW=λfmxsx00fmyy0001-1XpYp1] (9)

簡化為:

[RT01XW=λK-1XP] (10)

公式(9)中,矩陣[K]為攝像機參數矩陣,通過相機標定的方法可以獲取相機的內參矩陣。

在3DMM(Morphable Face Model) [26],即可變形的三維人臉模型,是一個通用的三維人臉模型,用固定的點數來表示人臉。獲取到世界坐標系中心位置后,得到像素坐標位置和相機的內參便可以利用旋轉矩陣[R]和平移矩陣得到駕駛員頭部的歐拉角,詳細表達見公式(10)、(11)。

至此,已成功完成駕駛員頭部姿態的估計,并實時計算出與該姿態相關的歐拉角。在駕駛員嚴重疲勞時,頭部可能會向前傾斜,左右搖擺等行為表現。為了評估駕駛員的疲勞程度,本文使用了低頭頻率 HL (Head Lower) 結合頭部空間姿態的變化進行了疲勞分析。

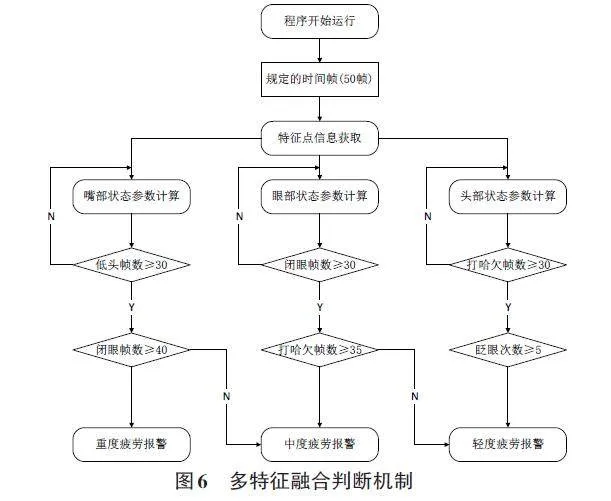

4 多特征融合判斷機制

如圖6所示,通過提取輸入圖像中的特征點,并將其分為眼部、嘴部和頭部三個部分,通過傳入的特征可以計算當前狀態。考慮到疲勞是一個過程,本文規定將視頻中的50幀作為一次判斷疲勞狀態的一個周期。每周期計算一次低頭、閉眼和打哈欠幀數。如果打哈欠幀數大于30,同時眨眼次數大于5次,則判斷為輕度疲勞。當閉眼幀數大于30,同時打哈欠幀數大于35時,將其判斷為中度疲勞。如果其中打哈欠幀數小于35次,則將其歸為輕度疲勞。當同時滿足低頭幀數大于30、閉眼幀數大于40幀時,將其判斷為重度疲勞。如果其中閉眼幀數小于40次,則將其歸為中度疲勞。

5 實驗及結果分析

為了驗證研究方法的性能,本文設計了利用在NTHU駕駛員疲勞檢測視頻數據集部分數據上的實驗,該測試數據中選用7種不同場景:白天戴眼鏡、戴太陽鏡、不戴眼鏡、晚上戴眼鏡、不戴眼鏡、白天顛簸和夜晚顛簸[28]。每個場景中選取了5組數據,每組數據包含輕度、中度疲勞和重度疲勞三種狀態。由于本文在評估眼部疲勞時加入了眼瞼作為判斷參數之一,而傳統的Dlib68面部關鍵點檢測模型無法提取眼部的眼瞼特征,所以本實驗選用 MeshFace 468 面部關鍵點檢測模型下進行實驗。

根據表1中的實驗結果,可以看出 FMFDD-3M 算法在疲勞狀態檢測和疲勞分級識別方面表現良好。這是因為FMFDD-3M算法利用 MediaPipe-MeshFace面部標記中的468個關鍵點面部檢測模型,將眼瞼視為眼部疲勞檢測的重要參數之一,并獲取了更細微的眼部特征。然后,它有效地將眼瞼動態與嘴部特征和頭部空間姿態的變化進行融合,從而提高在不同場景下疲勞檢測的準確率和疲勞分級識別率。實驗結果顯示,在白天和晚上帶顛簸的兩種場景下,FMFDD-3M 算法的識別率分別達到92%和87%。這表明,使用歐拉角變換來檢測頭部空間姿態來追蹤頭部晃動的方法是有效的。

6 結論

本文使用 MediaPipe-MeshFace 模型,提出一種面部多特征疲勞駕駛檢測算法 FMFDD-3M。該算法首先利用 MediaPipe-MeshFace 面網模型來精確定位眼部,將眼瞼作為眼部疲勞檢測的重要參數之一,以獲取更詳細的特征。接著,將眼瞼的動態特征與嘴部特征和頭部空間姿態變化進行融合,從而提高在不同場景下疲勞檢測的準確率和疲勞分級的識別率。此外,該算法還使用歐拉角的變化來檢測頭部空間姿態,有效解決了頭部晃動過大或過快等特殊情況下無法提取面部疲勞特征的問題。實驗結果表明,該方法能夠有效識別駕駛員的疲勞狀態,實現疲勞狀態的分級,特別是在顛簸環境下,識別率明顯提高,能夠準確檢測疲勞狀態。FMFDD-3M 算法僅在 NTHU 駕駛員疲勞檢測視頻數據集的部分數據上進行了實驗。該數據集干凈,環境較理想,幾乎沒有干擾。然而,在實際檢測過程中,會出現一些特殊情況,如視頻模糊、反光強烈、環境復雜等。這些對于疲勞狀態的檢測和判斷具有十分重要的意義。因此,提高算法在上述復雜環境下的識別率、穩定性和魯棒性是下一步需要繼續研究的工作。

參考文獻:

[1] 劉秀, 王長君, 何慶. 疲勞駕駛交通事故的特點分析與預防[J]. 中國安全生產科學技術, 2008, 4(1): 128-131.

[2] 陳見哲.疲勞駕駛檢測方法研究進展[J].汽車實用技術,2023,48(21):179-186.

[3] 牛清寧,周志強,金立生,等.基于眼動特征的疲勞駕駛檢測方法[J].哈爾濱工程大學學報,2015,36(3):394-398.

[4] 陸榮秀,張筆豪,莫振龍.基于臉部特征和頭部姿態的疲勞檢測方法[J].系統仿真學報,2022,34(10):2279-2292.

[5] 趙曉,楊晨,王若男,等.基于注意力機制ResNet輕量網絡的面部表情識別[J].液晶與顯示,2023,38(11):1503-1510.

[6] WANG F W,GU T S,YAO W C.Research on the application of the Sleep EEG Net model based on domain adaptation transfer in the detection of driving fatigue[J].Biomedical Signal Processing and Control,2024,90:105832.

[7] 陳立潮,王冠男.基于面部多特征的駕駛員疲勞狀態檢測[J].計算機與數字工程,2023,51(3):721-726.

[8] 劉敏.基于頭部特征和姿態估計的疲勞駕駛檢測技術的研究[D].上海:東華大學,2019.

[9] 李昌智,陳升業,周顯琳,等.基于頭部狀態的司機疲勞綜合檢測系統[J].科技信息,2012(31):157-159.

[10] 莫紫雯,王江濤,張子翔.基于樹莓派的駕駛員分心駕駛檢測系統[J].電子制作,2023,31(21):61-64,74.

[11] 劉旭,戰凱,于騫翔,等.基于人臉特征的疲勞檢測在礦山遠程駕駛中的應用[J].有色金屬工程,2022,12(4):124-130.

[12] 劉南艷,魏鴻飛,馬圣祥.融合局部動態特征的面部表情識別[J].計算機工程與科學,2023,45(5):849-858.

[13] 倪廣興, 徐華, 王超. 融合改進YOLOv5及Mediapipe的手勢識別研究[J/OL]. 計算機工程與應用, 2023:1-11. [2023-12-25]. https://kns-cnki-net.webvpn.xjau.edu.cn/kcms/detail/11.2127.TP.20231129.1045.002.html.

[14] 張光遠,胡晉,章子睿,等.基于面部特征的高速鐵路調度員疲勞程度判定方法研究[J].鐵道學報,2021,43(8):10-17.

[15] 王梅霞,徐怡彤,楊照宇,等.基于Dlib與OpenCV的疲勞駕駛檢測系統[J].中阿科技論壇(中英文),2023(3):88-92.

[16] 于子平,程杰,丁巖康,等.基于深度學習的課堂注意力檢測[J].電子測試,2021(22):55-57.

[17] 王暢,李雷孝,楊艷艷.基于面部多特征融合的疲勞駕駛檢測綜述[J].計算機工程,2023,49(11):1-12.

[18] 高珍, 陳超, 許靖寧, 等. 基于車載視覺的端到端駕駛員疲勞檢測模型[J/OL].同濟大學學報(自然科學版), 2023: 1-9 [2023-12-25]. https://kns-cnki-net.webvpn.xjau.edu.cn/kcms/ detail/31.1267.N.20231211.0919.002.html.

[19] 楊艷艷,李雷孝,林浩.提取駕駛員面部特征的疲勞駕駛檢測研究綜述[J].計算機科學與探索,2023,17(6):1249-1267.

[20] 王鵬,神和龍,尹勇,等.基于深度學習的船舶駕駛員疲勞檢測算法[J].交通信息與安全,2022,40(1):63-71.

[21] 李依玲.基于多尺度特征融合的疲勞駕駛檢測方法研究[D].重慶:重慶大學,2022.

[22] 宋佳堯,尉斌,安姝潔,等.基于Dlib的面部疲勞檢測模型[J].軟件工程,2023,26(12):38-40,58.

[23] 張蕊,趙帥,張慶余,等.基于觸覺信息的駕駛員操作意圖識別方法[J].汽車實用技術,2023,48(22):49-59.

[24] 王康,樊繼東.基于多特征融合的疲勞駕駛檢測[J].湖北汽車工業學院學報,2023,37(1):39-44.

[25] 丁海濤.人臉識別技術的應用研究及改進措施[J].無線互聯科技,2023,20(18):86-88,104.

[26] 晏軼超,程宇豪,陳琢,等.基于神經網絡的生成式三維數字人研究綜述:表示、渲染與學習[J].中國科學(信息科學),2023,53(10):1858-1891.

[27] 胡峰松,程哲坤,徐青云,等.基于多特征融合的疲勞駕駛狀態識別方法研究[J].湖南大學學報(自然科學版),2022,49(4):100-107.

[28] 李泰國,張天策,李超,等.基于面部倒立擺模型與信息熵的駕駛員疲勞檢測[J].交通運輸系統工程與信息,2023,23(5):24-32.

【通聯編輯:唐一東】