EnGAN:醫學圖像分割中的增強生成對抗網絡

摘 要:原始采集的醫學圖像普遍存在對比度不足、細節模糊以及噪聲干擾等質量問題,使得現有醫學圖像分割技術的精度很難達到新的突破。針對醫學圖像數據增強技術進行研究,在不明顯改變圖像外觀的前提下,通過添加特定的像素補償和進行細微的圖像調整來改善原始圖像質量問題,從而提高圖像分割準確率。首先,設計引入了一個新的優化器模塊,以產生一個連續分布的空間作為遷移的目標域,該優化器模塊接受數據集的標簽作為輸入,并將離散的標簽數據映射到連續分布的醫學圖像中;其次,提出了一個基于對抗生成網絡的EnGAN模型,并將優化器模塊產生的遷移目標域用來指導對抗網絡的目標生成,從而將改善的醫學圖像質量知識植入模型中實現圖像增強。基于COVID-19數據集,實驗中使用U-Net、U-Net+ResNet34、U-Net+Attn Res U-Net等卷積神經網絡作為骨干網絡,Dice系數和交并比分別達到了73.5%和69.3%、75.1%和70.5%,以及75.2%和70.3%。實驗的結果表明,提出的醫學圖像質量增強技術在最大限度保留原始特征的條件下,有效地提高了分割的準確率,為后續的醫學圖像處理研究提供了一個更為穩健和高效的解決方案。

關鍵詞:醫學圖像分割;圖像質量;圖像增強;域遷移;對抗生成網絡

中圖分類號:TP751.1 文獻標志碼:A 文章編號:1001-3695(2024)07-039-2195-08

doi: 10.19734/j.issn.1001-3695.2023.08.0509

EnGAN: enhancement generative adversarial network in medical image segmentation

Abstract:The quality issues commonly found in original medical images, such as insufficient contrast, blurred details, and noise interference, make it difficult for existing medical image segmentation techniques to achieve new breakthroughs. This study focused on the enhancement of medical image data. Without significantly altering the appearance of the image, it improved the quality problems of the original image by adding specific pixel compensation and making subtle image adjustments, thereby enhancing the accuracy of image segmentation. Firstly, it introduced a new optimizer module, which generated a continuous distribution space as the target domain for transfer. This optimizer module took the labels of the dataset as input and mapped the discrete label data to the continuous distribution of medical images. Secondly, it proposed an EnGAN model based on generative adversarial networks(GAN), and used the transfer target domain generated by the optimizer module to guide the target generation of the adversarial network, thereby implanting the knowledge of improving medical image quality into the model to achieve image enhancement. Based on the COVID-19 dataset, convolutional neural networks, including U-Net, U-Net+ResNet34, U-Net+Attn Res U-Net, were utilized as the backbone network in the experiment, and the Dice coefficient and intersection over union reached 73.5% and 69.3%, 75.1% and 70.5%, and 75.2% and 70.3% respectively. The empirical results demonstrate that the proposed medical image quality enhancement technology effectively improves the accuracy of segmentation while retaining the original features to the greatest extent, providing a more robust and efficient solution for subsequent medical image processing research.

Key words:medical image segmentation; image quality; image enhancement; domain migration; generative adversarial networks

0 引言

以卷積神經網絡(convolutional neural network,CNN)[1]為代表的深度學習模型在圖像處理中得到了廣泛的應用,醫學圖像也從中受益,U-Net[2]這樣的網絡模型大幅提高了分割的準確性。然而,由于醫學成像設備的固有限制和成像過程的局限性,導致部分醫學圖像存在對比度不足、細節模糊以及噪點干擾等問題。這些問題對神經網絡的語義分割造成了較大的干擾,導致分割準確率下降的問題。因此,許多方法都嘗試對醫學圖像進行增強,通過提升圖像質量來提高分割準確率。現有的圖像增強方法雖然可以顯著提升網絡分割的準確率,但會改變圖像的外觀,例如圖像亮度、對比度等特征,更嚴重的甚至會改變目標特征,此類方法很難在不改變圖像外觀的條件下提升圖像質量。

本文設計了一種新的醫學圖像增強網絡模型,該模型在不明顯改變圖像外觀的同時,通過添加特定的像素補償和進行細微的調整來增強圖像,提升分割準確度。因此,原始醫學圖像通過該模型增強后的效果與原始圖像外觀保持高度一致,不存在肉眼所見的失真情況。

為了通過添加特定的像素補償和進行細微的圖像調整來增強分割準確度,本文設計了一個新的醫學圖像增強網絡EnGAN(enhancement generative adversarial network),它基于對抗生成網絡(generative adversarial network,GAN)[3]的框架,利用GAN的可遷移性完成數據域的映射。首先,本文設計了一個優化器來生成目標域[4],它是預訓練分割模型的反向網絡。將數據集的標簽作為其輸入,將標簽中的分割信息與模型中的分布結合,生成GAN所需的目標域。其次,當得到一個目標域后,訓練GAN的生成器將數據遷移到目標域,使原始數據得以增強,最終提高圖像分割的準確率。

本文的主要貢獻概括如下: a)提出了一種用于分割任務的數據增強對抗生成網絡EnGAN,完成域遷移,提高數據質量,并在不改變分割網絡的情況下提高性能;b)提出了一個優化器結構,生成具有更好數據分布的目標域,并提供給GAN進行遷移學習;c)提出了一個三方交替訓練模型,將目標域的生成插入到GAN的對抗訓練中。

1 相關工作

醫學圖像分割任務對于后續的診斷和治療具有重要指導意義,但由于復雜的數據格式、噪聲、干擾和遮擋等不利因素,使得這一任務變得困難。為解決此類問題,研究人員提出了許多高效的分割方法和模型。

Leclerc等人[5]對用于醫學圖像分割的不同方法,如CNN[1]、全卷積網絡(fully convolutional network,FCN)[6]、U-Net[2]、循環神經網絡(recurrent neural network,RNN)[7]等進行了調研。FCN與CNN相比具有更高的計算效率和更少的存儲空間,它源于AlexNet[8],并對其進行了像素級分類的語義分割內容的改造。使用這種方法,輸出大小可被恢復為與輸入圖像相同的大小。

為了提高分割精度,Ronneberger等人[2]設計了一個名為U-Net的U型結構網絡。U-Net包括編碼器和解碼器,其中編碼器用于提取特征,解碼器用于恢復原始分辨率。編碼器獲取圖像的細節和輪廓信息,然后將提取的特征傳輸到解碼器;解碼器接收到特征后,將多個尺度的特征結合起來進行恢復。實驗表明,U-Net在小樣本數據集上表現出色。

SegNet[9]是為自動駕駛或智能機器人的圖像語義分割而提出的,它源自FCN,并集成了VGG-16[10]網絡修改。在編碼器部分,部分使用了VGG16網絡,包括五個塊,每個塊包括卷積層和最大池化層。解碼器部分對應編碼器層,使用了softmax,它通過輸出不同分類的最大值以獲得最終的分割圖。

Chen等人[11]提出了基于CNN的DeepLab,此后,又陸續提出了DeepLabv2、DeepLabv3和DeepLabv3+[12~14]。DeepLabv3+的編碼器使用空洞卷積來提取圖像特征,特別是包括了改進的Xception網絡和帶有空洞的空間金字塔池化模塊。DeepLabv3+的解碼器將提取的全局特征上采樣到1/4的大小,然后與局部特征融合,最后將特征上采樣到與原始圖像相同的大小,并生成預測的分割圖像。

GAN[3]在醫學圖像領域有廣泛的應用。Yang等人[15]提出一個結合了感知相似性的WGAN模型[16],引入了人類視覺感知的概念,并將其應用于如何去除低劑量CT圖像的噪聲。它可以在去噪后更好地保留圖像的細節,但丟棄了3D空間信息。隨后,Shan等人[17]在LDCT的基礎上,構建了一個結合2D和3D的傳送路徑卷積編碼解碼器。它彌補了前者浪費空間信息的缺點,并實現了更快的3D圖像去噪。

在超分辨率應用領域,Chen等人[18]基于GAN構建了一個多級密集連接超分辨率網絡,實現了從低分辨率的3D磁共振圖像中恢復高分辨率的細節。通過結合GAN和單圖像超分辨率技術,Sun等人[19]完成了動態對比增強乳腺磁共振圖像的高質量超分辨率任務,大大縮短了磁共振檢查的時間。Xie等人[20]提出使用CycleGAN[21],從無配對的磁共振圖像生成沿不同成像方向的高分辨率磁共振圖像,然后通過圖像融合實現超分辨率圖像生成的目標。

在圖像樣本增強方面,Calimeri等人[22]使用GAN實現了人腦磁共振圖像數據的擴展,有效地提高了診斷算法的泛化能力,但只能生成2D圖像。隨后,Han等人[23]使用GAN實現了多序列腦磁共振圖像的數據增強,并使用條件PGGAN實現了遷移性腦腫瘤檢測任務中的數據增強。Madani等人[24]使用了GAN進行心血管異常分類任務中的胸部X光圖像數據的擴展。Bailo等人[25]將Pix2PixHD模型應用于紅細胞分割任務的圖像增強。

在GAN進行醫學圖像分割增強方面,Shi等人[26]通過Style-Based GAN提出了一種新穎的數據增強框架,用于合成增強的訓練數據。首先,訓練風格編碼器和生成器直到能夠重構數據集中的圖像,然后利用從數據集中提取的風格庫以隨機風格合成增強數據,從而在風格方面平衡數據集。該方法在公開的LIDC-IDRI數據集上得到驗證,結果證明該數據增強框架不僅能生成逼真的圖像,而且能提高分割模型的穩定性和準確性。

文獻[27]提出了一種基于Seg2GAN架構的兩階段對抗網絡,該網絡允許創建擴展的合成醫學圖像分布,從而在分割任務中取得更好的結果,該方法已在生成與膝蓋軟骨及眼底和冠狀動脈血管相關的合成醫學數據,并在分割生成圖像方面顯示出其有效性。此外,該方法在多個分割指標方面提高了分割的Dice得分。

為了提高腦瘤分割的準確性并充分利用MRI數據的多模態信息,文獻[28]提出了一種名為TensorMixup的腦瘤分割算法。首先,從具有相同模態的兩個MRI腦圖像中獲取腫瘤圖像塊及其一熱編碼標簽;然后,使用一個張量Λ混合兩個圖像塊,并將映射自Λ的矩陣Λ*用于混合兩個一熱編碼標簽序列,從而合成新的圖像及獨熱編碼標簽。該方法可用于訓練模型并緩解腦瘤分割任務中數據不足的問題,通過增加數據訓練量來提升分割Dice得分。

盡管上述研究已經在醫學圖像增強和分割方面取得了進步,但仍存在一些挑戰。一方面,有些方法雖然可以提高分割的準確率,但可能會改變圖像的外觀,導致后續的圖像分析任務受到影響;另一方面,有些方法雖然保持了圖像的外觀,但其對分割精度的提升并不明顯。因此,如何在保持圖像外觀的同時提高分割精度,是一個需要進一步研究的問題。

為了解決這個問題,本文提出了EnGAN對醫學圖像進行增強,本文方法主要通過添加特定的像素補償和進行必要的圖像調整來解決分割網絡可能遇到的干擾問題,同時避免破壞原有圖像結構。通過EnGAN框架,圖像的細節得到填充,不利因素被剔除,實現了在保證外觀相似度的條件下顯著提升語義分割網絡表現的圖像增強效果。

2 增強生成網絡EnGAN

本文設計了一個基于生成對抗網絡(GAN)結構的醫學圖像增強框架EnGAN。在該框架中,生成器被用于實現從源域到目標域的增強,而判別器則用于判定數據遷移的效果。在醫學圖像分割中,有效的目標域應能提高分割精度,并適應已訓練的分割網絡,但一個隱含條件是源域和目標域圖像需要具有高度的相似性[29],并且醫學圖像中的組織結構和紋理信息不應被修改。

在框架EnGAN下,本文設計了一個新的優化器用于生成所需的目標數據。它將數據標簽作為輸入,以攜帶精確的分割信息;它自身是分割網絡的逆網絡,將分割網絡的分布信息遷移到目標域數據[30];在操作過程中,它只產生微小偏移量,這些偏移量被疊加到源域數據上,以確保源域和目標域數據的相似性[31]。

2.1 增強方案

2.1.1 問題定義

假設有一組醫學圖像數據x∈Euclid Math OneXAp,每個圖像x~Ps,其中Ps是原始數據集中標簽分類的分布。在圖像分割場景中,p∈Ps代表每個點的真實類別標簽分布,具體來說,對于圖像中的某個像素點i,如果其分類標簽是c,那么pi,c=1,否則pi,c=0。

對于單張圖像而言,增強的目標是通過修改原始圖像x的部分像素,得到新的目標圖像xt,使得修改后的圖像xt輸入到相同的網絡fSeg后,輸出的分割結果有更高的準確率,即Acc[fSeg(xt)]>Acc[fSeg(x)]。其中,fSeg是一個分割網絡,Acc是一個評估fSeg(x)準確性的度量函數。

按照此定義,對集合中所有的圖像進行增強后,會產生一個新的圖像集合Euclid Math OneXApt,所有圖像的分割結果形成了新的數據分布,即需要求解的分布Pt。

2.1.2 優化器設計

本文設計了一個優化器來生成變量δ,它是一個與x具有相同像素大小的偏移量,將其添加到x形成xt,從而生成目標分布域xt~Pt。優化器的目標是提高分割精度Acc[fSeg(xt)],這等同于最小化分割網絡的損失值。同時,為了保持xt和x之間的相似性,δ應該盡可能小。因此,這個問題可以轉換為求解δ和優化分割損失的最優化問題,定義如下:

min c‖δ‖2+Loss(fSeg(tanh(x+δ)))(1)

其中:‖·‖2是二范數;c是一個超參數,用于控制兩部分之間的平衡;Loss是預訓練分割網絡的損失函數。由于xt是一個醫學圖像,所以使用xt=tanh(x+δ)來限制其像素值在[-1,1]。

在以上優化目標函數中,c‖δ‖2和Loss(fSeg(tanh(x+δ)))兩部分存在對抗關系。為了獲得目標函數最優值,需要生成較大的隨機值δ,從而減小Loss(fSeg(tanh(x+δ))),此時合成的圖像xt表現為失去原始圖像的外部特征。因此,為了保留圖像的原始特征,本文在目標函數中引入正則化項c‖δ‖2,該正則化項引導目標函數朝著生成較小δ的方向尋找最優目標值,從而實現制約原始圖像被修改的程度。因此,通過這個優化過程,可以找到這兩部分之間的平衡,從而得到優化的δ。

在整個數據集中,對于每一個x∈Euclid Math OneXAp,都有一個對應的δ,使得xt=tanh(x+δ),得到一個新的增強后的圖像集合xt,其中包含了所有增強后的圖像。這個圖像集合xt就形成了目標分布Pt。

2.1.3 目標遷移

為了求解Pt,本研究采用了生成網絡的方案,其目標是找到一個生成器G,它可以將源域x~Ps的圖像增強到目標域xt~Pt。生成器被定義為

G:xt=G(x)

such that Acc[fSeg(xt~Pt)]>Acc[fSeg(x~Ps)](2)

在這個過程中,本文使用了生成對抗網絡的框架。GAN網絡在訓練過程中,通過交替訓練生成器和判別器,逐步提升生成器的效果。本研究的創新之處在于,將優化器也加入到該模型中,形成了一個三步訓練的過程:a)在每次迭代中,優化器首先生成偏移量δ;b)然后將這個δ作為判別器的目標,接著使用同樣的方式訓練GAN;c)通過多次迭代優化,最終得到了優化后δ的分布,而xt=tanh(x+δ)的集合形成了目標分布Pt。

生成器G的目標是將原始的分布x遷移到目標分布xt上。通過對G的訓練,最終使得G(x)的分布趨近于xt,此為目標遷移過程。該方法通過對數據集中的每一張圖像進行獨立的優化,實現了在保持相似性的同時提高分割精度的目標。這是本文方法的一個重要特點和創新,也是在醫學圖像分割任務中取得良好效果的關鍵。

2.2 網絡設計

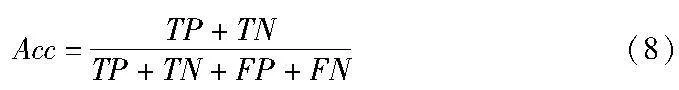

網絡框架由優化器、生成器和判別器三個部分組成。其中,通過訓練優化器O創建具有連續分布xt~Pt的目標域,生成器G用于接收x生成xt,而判別器D負責判定生成數據xt的質量。整體架構如圖1所示。

優化器結構基于U-Net,并且網絡在前向傳播中被應用于分割。在每個下采樣過程中都增加了一個可變形的卷積層,使得特征圖在每個下采樣過程中逐層編碼,并且特征信息連接跳躍到上采樣階段,變形特征逐步恢復。

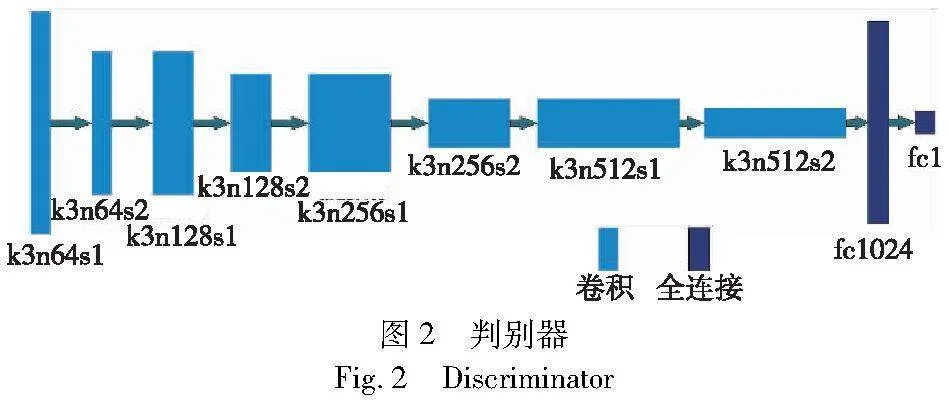

判別器由8個卷積層和2個全連接層組成,其結構如圖2所示。其中,8個卷積層的卷積核大小為3×3,步長為1或2。如果步長為1,圖像大小保持不變;如果步長為2,圖像大小減半。卷積核的數量從64增加到512。第一個全連接層使用1 024個神經元將二維特征圖轉換為一維數組。第二個全連接層使用一個神經元通過閾值函數完成預測。

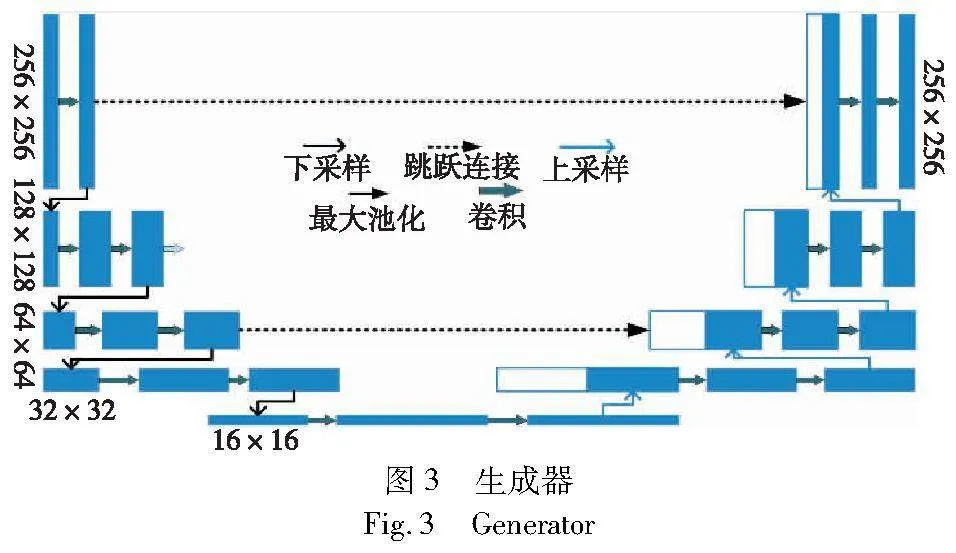

生成器結構如圖3所示,包含八個塊,每個塊有四個3×3的卷積層,后面跟著一個下采樣或上采樣層。下采樣層是帶有步長2的卷積,后面跟著LeakyReLU、批量歸一化和dropout。上采樣層是帶有步長12的反卷積,后面跟著LeakyReLU、批量歸一化和dropout。如前所述,生成器內部也保持了跳躍連接,并通過使用與ResNet相似的策略,采用1×1的卷積層在塊之間傳遞特征。

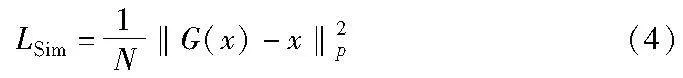

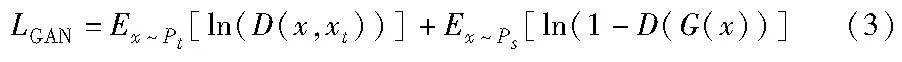

損失函數由三部分組成。生成器和判別器的損失函數定義與GAN相同。此外,為了限制圖像修改,添加了相似性損失,并且還添加了優化器的損失,以確定圖像傳輸的效果。生成模型的損失函數為

為了確保圖像與增強后圖像之間的相似性,損失函數中添加了一個相似性損失來約束距離:

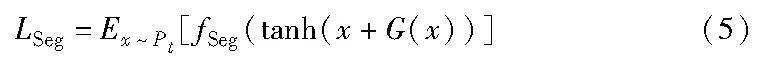

其中:N是該圖像中的像素個數。增強圖像作為輸入的分割網絡的損失值為

總損失如式(6)所示,超參數α和β用于控制三部分的平衡:

L(G,D)=LGAN+αLSim+βLSeg(6)

2.3 實現方法

2.3.1 初始化

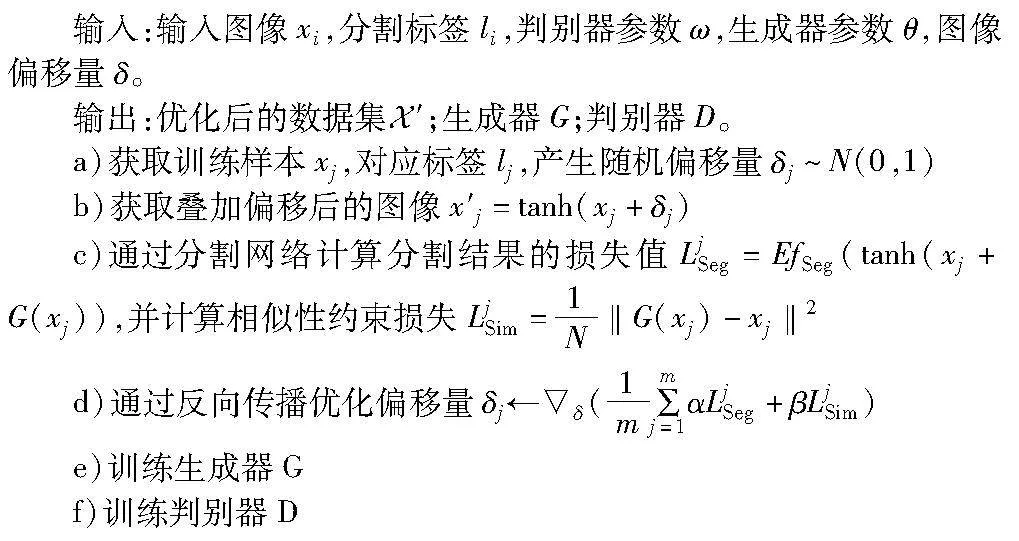

在初始化階段,首先定義訓練過程所需的基本參數,輸入圖像xi、真實標簽li、判別器參數ω、生成器參數θ、預訓練的優化器η,以及優化的偏移量δ。這些參數是訓練過程的基礎,為后續的訓練和優化提供了初始設定。

2.3.2 循環訓練

本階段的核心是圍繞生成器參數θ的收斂進行循環訓練。在每一次循環中,執行兩層嵌套循環,外層循環對i進行迭代,內層循環對j進行迭代。在內層循環中,首先采樣原始數據xj,對應的標簽lj和隨機偏移量δj~N(0,1),其中N(0,1)是標準正態分布。

然后通過x′j=tanh(xj+δj),并根據式(5)作為損失函數,在反向傳播過程中更新優化偏移量δ。 接下來計算新的偏移量δ^=G(x),以及按照式(3)計算生成器損失LiGAN。這個階段的主要目的是通過循環不斷優化生成器和判別器的參數,以逼近最優解。

2.3.3 參數更新

在每次內循環結束后,通過Adam[32]優化器更新判別器參數ω和生成器參數θ。這個階段是訓練過程中的關鍵,它保證了模型參數能夠朝著最優解的方向不斷更新。

2.3.4 算法流程

算法1描述了EnGAN的算法流程,通過逐步優化生成器和判別器的參數,實現從原始數據分布到高質量數據分布的遷移。通過循環訓練和參數更新,最終得到了優化后的參數集Euclid Math OneXAp′,為后續的醫學圖像分割任務提供了有力的支持。

算法1 EnGAN交替訓練實現

3 實驗

實驗使用了三個不同的數據集,包括乳腺超聲圖像數據集、心臟超聲圖像分割數據集以及COVID-19 CT圖像數據集。每個數據集都包含了不同的醫學圖像,這些圖像來自不同的病患,涵蓋了多種病變類型。使用多種模態的數據集進行實驗,可有效驗證本文方法的泛化性。

3.1 數據集

乳腺超聲圖像數據集(BUSI)[34]收集了600名年齡在25~75歲的女性患者的乳腺超聲圖像。數據集中的圖像數量超過700張,由Baheya醫院收集的DICOM格式數據被轉換成PNG格式的灰度圖像。圖像的平均尺寸為500×500像素。根據不同的病變,這些圖像被劃分為常見、良性和惡性三個類別。

心臟超聲圖像分割數據集(CAMUS)[5]包含了450名患者的心臟超聲檢查的1 800張單獨圖像。每位患者的超聲檢查包含四張圖片:兩張是心室收縮末期(ES)的心尖四腔視圖(A4C)和心尖二腔視圖(A2C),另外兩張是心室舒張末期(ED)的A4C和A2C視圖。CAMUS數據集總共包含900張ES圖像和900張ED圖像。CAMUS中的數據具有一定的異質性,A4C和A2C視圖,ED和ES圖像的混合給神經網絡的自動分割帶來了挑戰。在CMAUS數據集的450名患者中,有366名(81%)患者的心臟超聲圖像質量良好,84名(19%)患者的心臟超聲圖像質量較差。

由意大利醫學和介入放射學會收集的數據集[35],包含了40多名COVID-19患者的100張CT圖像。圖像已經被縮小,轉為灰度,并編譯為512×512像素的NIFTI格式。一位放射科醫生已經根據胸膜積液、磨玻璃樣改變和實變三個類別分割了每張圖像。

3.2 評價指標

本節將詳細介紹用于評估分割模型性能的指標,包括 Dice 系數(Dice similarity coefficient)、準確率(pixel accuracy)、召回率(recall rate)和交并比(intersection over union,IoU)。這些指標能夠從不同維度全面評估模型的表現,包括預測結果與標注結果的一致性、模型在不同類別圖像上的分割精度、模型對真實邊界的檢測能力,以及模型的精確率和召回率等。通過這些指標,可以全面了解模型的性能,從而為模型的評估、改進和優化提供定量依據。

Dice 系數是一種常用于衡量兩個樣本集相似度的指標,尤其適用于評估圖像分割任務的性能,其計算公式為

其中:X和Y分別代表預測區域和真實區域的像素集。Dice系數的值為0~1,值越接近1,表示預測區域與真實區域的重疊程度越高,分割模型的性能越好。

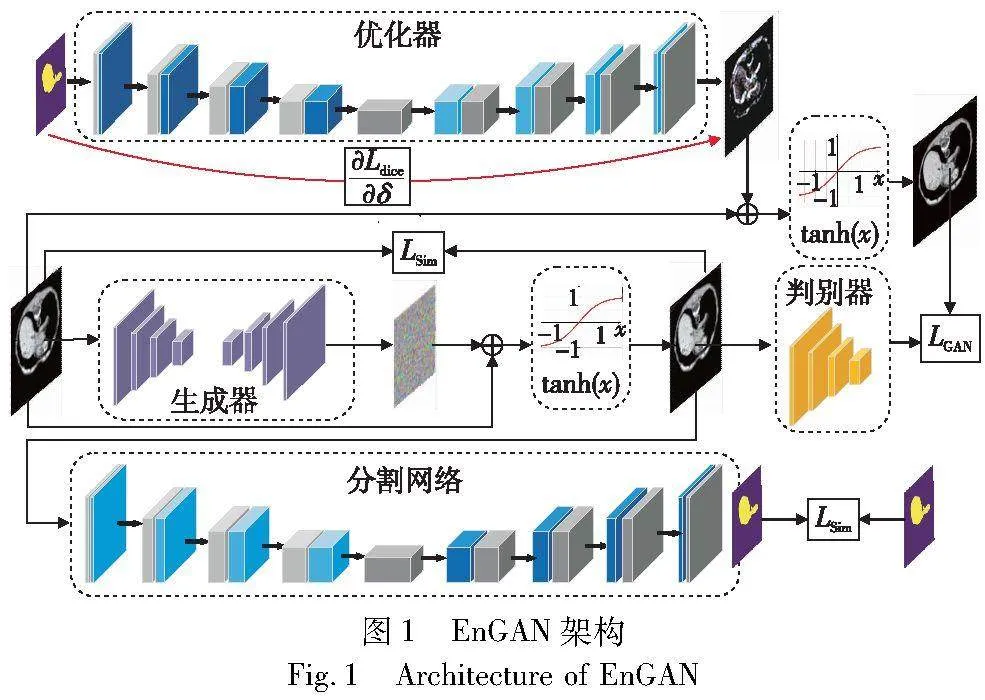

準確率是衡量模型分類正確性的基本指標,其計算公式為

其中:TP(真正例)、TN(真負例)、FP(假正例)和 FN(假負例)是混淆矩陣的四個組成部分,準確率衡量了模型在所有樣本中正確分類的能力。

召回率衡量了模型在所有真正例中正確識別正例的能力,其計算公式為

召回率是評估模型查全率的重要指標,尤其在不平衡數據集的情境中具有重要意義。

交并比是一種衡量圖像分割任務中預測區域和真實區域重疊程度的指標,其計算公式為

其中:X是預測區域;Y是真實區域。交并比的值為0~1,值越接近1,表示預測區域與真實區域的重疊程度越高,分割模型的性能越好。

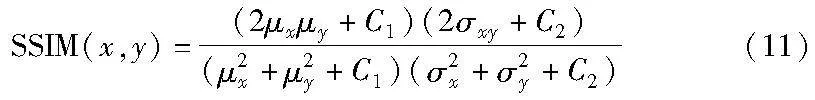

為了評估圖像增強前后的差異,本文采用了結構相似度指標(structural similarity index,SSIM),它是一種用于衡量兩幅圖像相似度的指標,其主要思想是通過比較圖像的亮度、對比度和結構信息來評估圖像的相似度。SSIM的計算公式如下:

其中:x和y分別表示兩幅圖像;μx和μy分別表示x和y的均值;σ2x和σ2y分別表示x和y的方差;σxy表示x和y的協方差;C1和C2是為了避免分母為0而設定的常數。SSIM指標的值為-1~1,值越接近1,表示兩幅圖像越相似。

通過以上評估指標,本文能夠從不同維度全面地評價模型在特定任務上的性能,并為模型的優化提供定量依據。

3.3 實驗設置

實驗選擇了U-Net作為基礎網絡,并添加了ResNet34和注意力機制。每個網絡都經過預訓練,以達到特定級別的分割精度。在此基礎上,提出了EnGAN增強方法。一個預訓練的模型同時具有兩個身份。前向傳播用于預測該分割模型的分割結果。它也是EnGAN中的優化器,通過反向傳播調整原始圖像的偏移量δ。

實驗選擇了PyTorch[36]作為框架,并以批次大小為32進行模型訓練。優化器是AdamGrad[32],學習率為0.001。實驗在Ubuntu 20.04的服務器上進行,內存為64 GB,使用TeslaV100顯卡進行CUDA計算。

3.4 應用策略

首先,使用未增強的數據對模型進行預訓練,為模型提供一個良好的初始狀態。其次,開始使用由EnGAN生成的增強數據進行微調。在此過程中,為了確保增強數據的有效性,按照4∶1的比例混合原始數據和增強數據進行訓練。

在實際應用中,首先將輸入的醫學圖像通過EnGAN進行增強,然后再將增強后的圖像輸入到U-Net+ResNet34中進行分割。這種雙階段的處理策略確保了在實際應用中,既能夠受益于增強數據的高質量,同時也能夠充分利用深度網絡對圖像特征的強大捕獲能力。

通過上述的實現方法和策略,本研究所提出的模型能夠有效地應對醫學圖像的多樣性和不均衡性,從而在實際應用中獲得良好的分割效果。

3.5 實驗結果分析

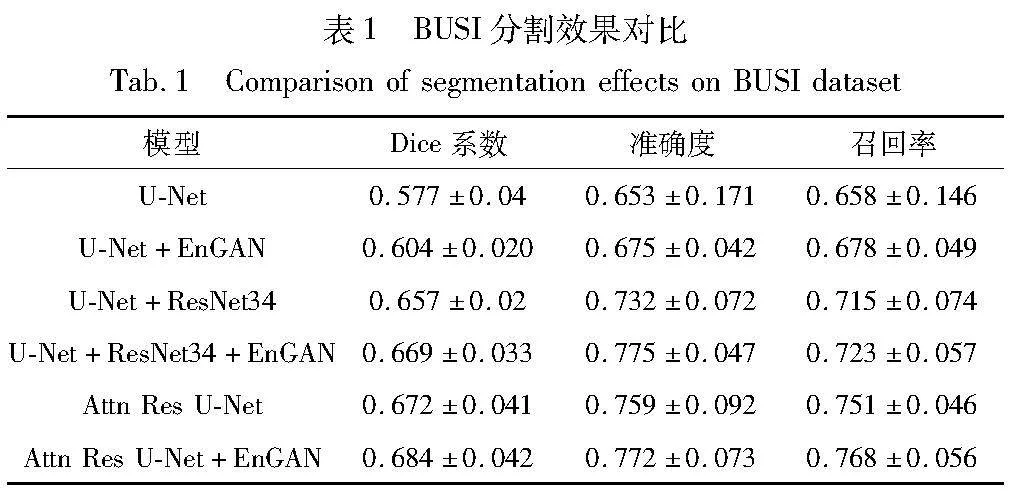

3.5.1 BUSI數據集實驗結果

從表1中可以看出,無論是U-Net、U-Net+ResNet34還是Attn U-Net+ResNet34模型,與EnGAN結合后,其在乳腺超聲圖像分割任務上的性能都有所提升。這說明了EnGAN能夠有效地提升模型的分割性能。同時,Attn U-Net+ResNet34+EnGAN模型在所有指標上的表現最好,是因為該模型結合了注意力機制和深度殘差網絡,使得模型能夠更好地關注和學習圖像的重要特征。

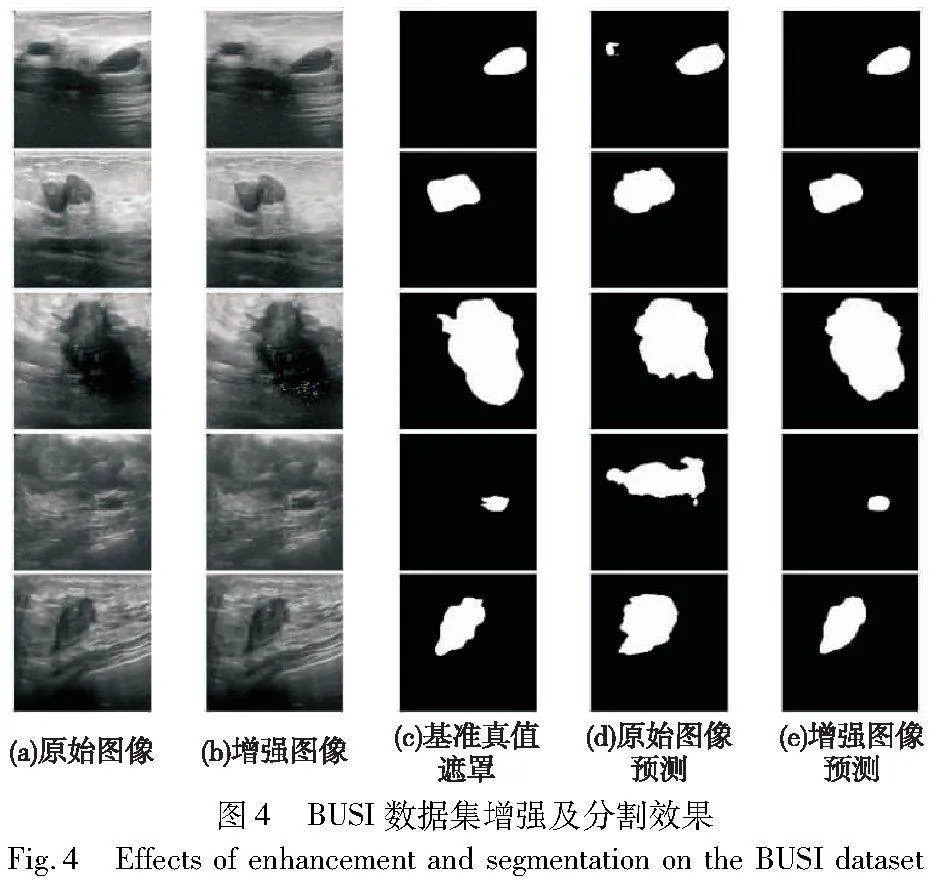

對比的實驗結果如圖4所示,在使用EnGAN對圖像進行增強之后,圖像與原圖具有較高的相似度,但是分割結果有較大的提升。

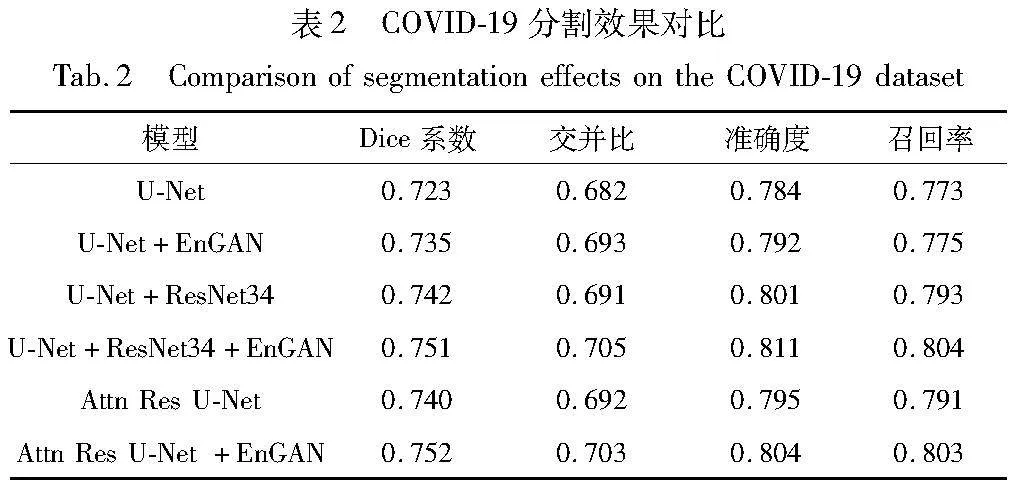

3.5.2 COVID-19數據集實驗

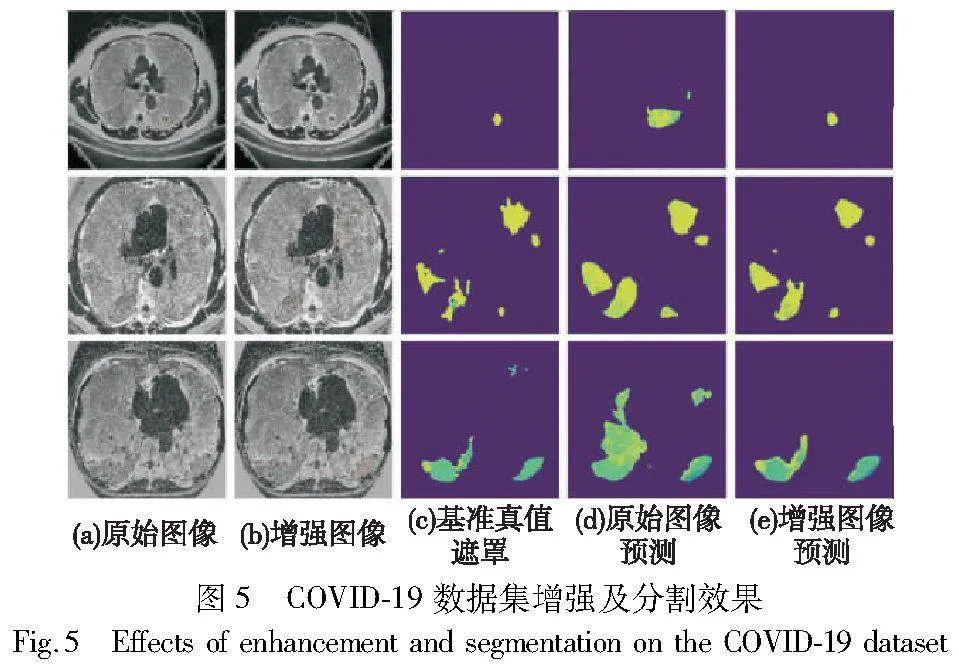

在COVID-19數據集上也測試了U-Net、U-Net+EnGAN、U-Net+ResNet34,以及U-Net+ResNet34+EnGAN四種模型。實驗結果表明,引入EnGAN的模型能顯著提高分割精度,COVID-19分割效果對比如表2所示,COVID-19數據集效果對比如圖5所示。

U-Net+ResNet34+EnGAN模型在所有測試的模型中表現最為優秀。這表明ResNet34的深度殘差學習框架和EnGAN的生成對抗網絡能夠有效地提升U-Net的性能。這也證實了在CT數據上,EnGAN增強的數據同樣可以提高醫學圖像的分割精度。

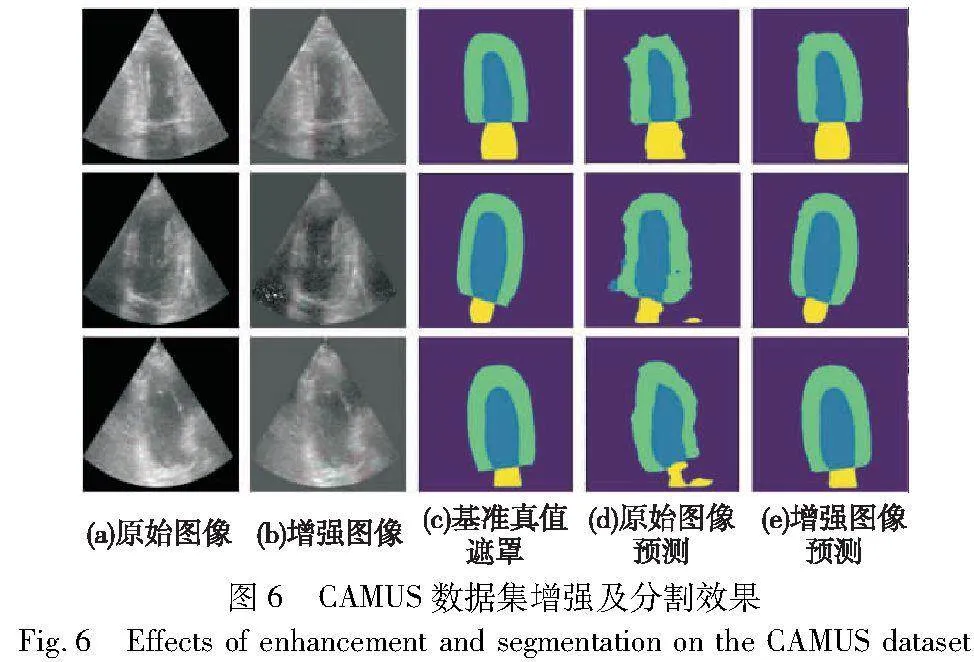

3.5.3 CAMUS數據集實驗

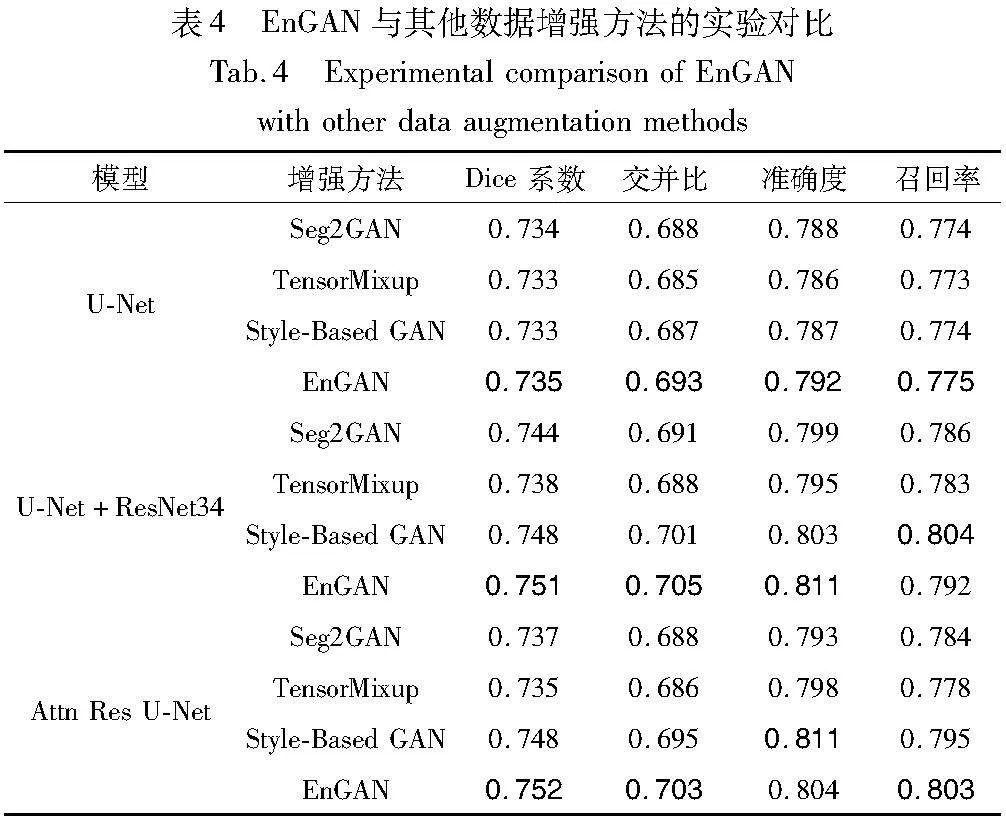

表3展示了在CAMUS數據集上的分割評估結果。選擇了四種不同的方法進行比較,即U-Net、U-Net+EnGAN、U-Net+ResNet34、U-Net+ResNet34+EnGAN,以及這四種方法加入注意力機制后的結果。每一種方法都在三個不同的數據質量級別(低、中、高)下進行了評估,分別對LVEndo、LVEpi和LA進行了分割。

從結果顯示,無論在哪種數據質量級別下,加入EnGAN的方法都比未加入EnGAN的方法表現要好。例如,在低質量級別下,U-Net+EnGAN在LVEndo上的表現為82.27%,而未加入EnGAN的U-Net在同一條件下的表現為80.76%。這說明本文提出的EnGAN增強方法在多分類的數據集上也具有提升效果。

在所有方法中,U-Net+ResNet34+EnGAN的表現最好。這表明,ResNet34和EnGAN的結合能進一步提升分割精度。從圖像分割的效果可以看出,其不僅分割準確度有較大提升,增強圖像的邊緣平滑度、整體的連貫程度也有較大的提升,如圖6所示。

3.5.4 EnGAN與其他數據增強方法的對比實驗

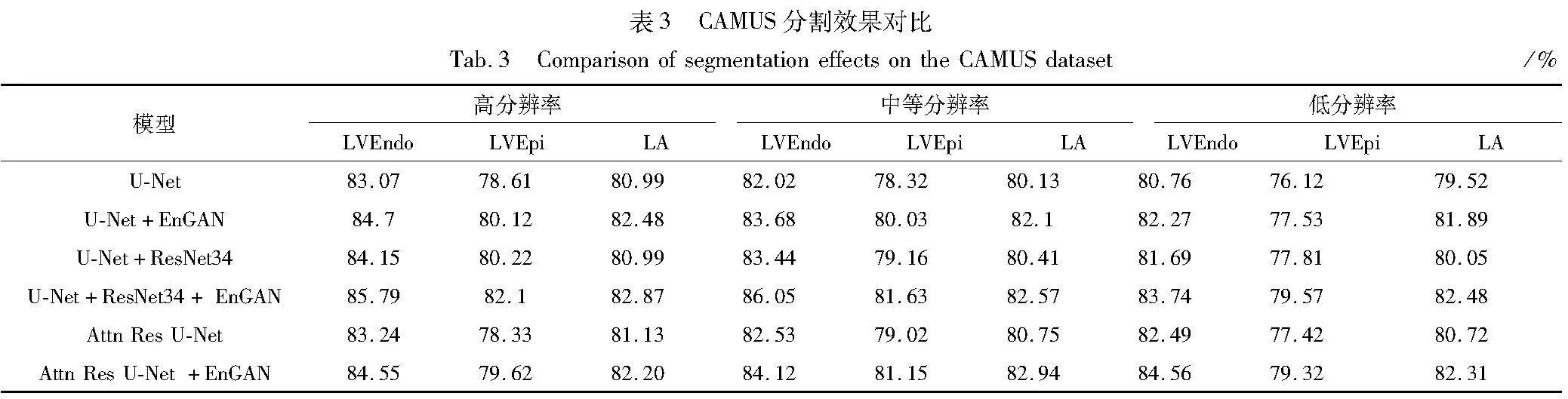

表4展示了EnGAN和其他模型的實驗對比結果。首先可以從整體上觀察到,EnGAN在所有三種模型(U-Net、U-Net+ResNet34和Attn Res U-Net)上都實現了Dice系數和召回率的最優結果,這明確地證明了EnGAN在增強方法中的優越性。

在U-Net模型中,EnGAN在所有指標上均取得了最佳表現。具體來說,其Dice系數為0.735,比第二高的Seg2GAN提高了0.1百分點;交并比為0.693,領先于Style-Based GAN的0.687,提高0.6百分點;在準確度和召回率上,EnGAN分別達到了0.792和0.775,均略高于其他增強方法。

這些數據表明,EnGAN在U-Net模型中具有顯著的數據增強優勢。

對于U-Net+ResNet34模型,EnGAN同樣展現出了較好性能。其Dice系數達到了0.751,領先于第二名的Style-Based GAN的0.748,提升了0.3百分點;交并比達到了0.705,超過第二名的Style-Based GAN的0.701,差距為0.4百分點。在準確度上,EnGAN的0.811同樣是所有方法中的最高值。盡管召回率上EnGAN的0.792略低于Style-Based GAN的0.804,但其在其他三個指標上的明顯優勢確保了其整體表現的領先。

在Attn Res U-Net模型中,EnGAN繼續展現出卓越的性能。其Dice系數為0.752,是所有方法中的最高值,與第二名的Style-Based GAN相比有0.4百分點的優勢;交并比上,EnGAN的0.703超出第二名的Style-Based GAN的0.695,差距為0.8百分點。雖然在準確度上,Style-Based GAN的0.811略高于EnGAN的0.804,但EnGAN在召回率上以0.803的成績領先,與第二名的Style-Based GAN有0.8百分點的優勢。這進一步證明了EnGAN增強方法的有效性和優越性。

實驗結果表明,EnGAN增強方法在U-Net、U-Net+ResNet34和Attn Res U-Net三種模型上均展現出顯著的優勢。特別是,它在Dice系數和召回率上均達到了最優表現。無論是與Seg2GAN還是Style-Based GAN進行比較,EnGAN在各個評價指標上均表現出色。盡管在某些指標上可能略遜于其他方法,但EnGAN的整體性能確保了其在各種模型條件下的領先地位,證明了其在數據增強方面的出色性能。

3.5.5 魯棒性分析

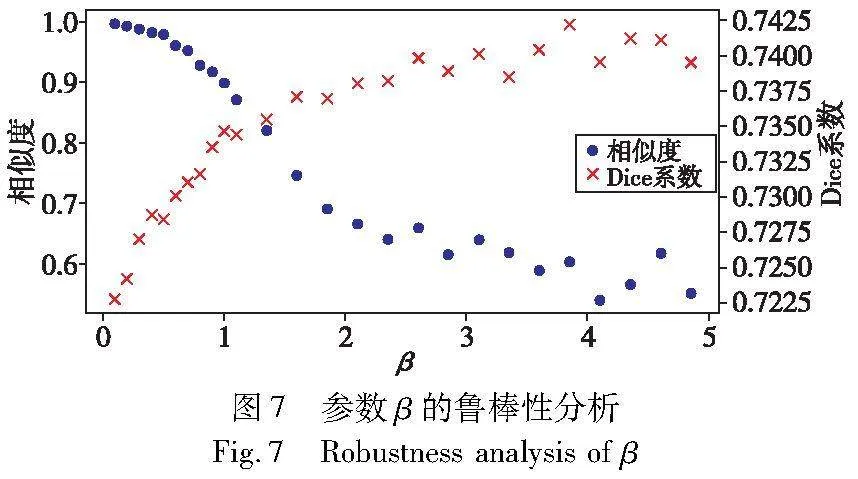

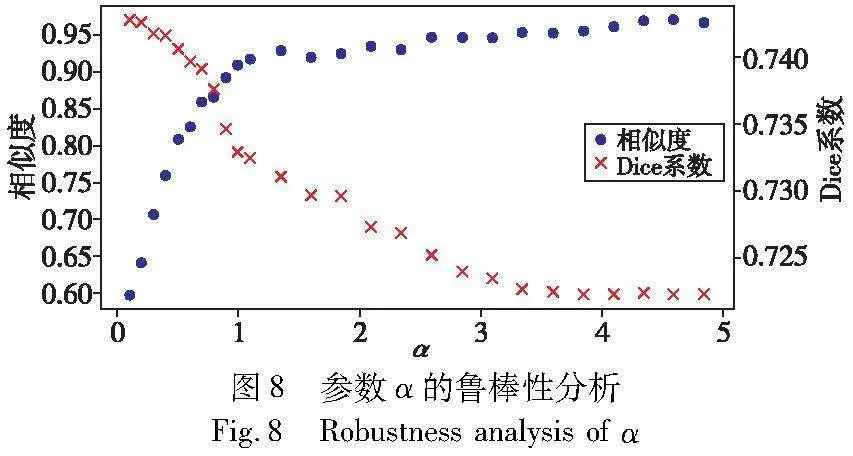

為了進一步探索EnGAN模型的魯棒性,根據式(6)對模型損失函數中的兩個關鍵超參數α和β進行了深入研究。α是通過相似性損失來約束距離的超參數,而β是增強圖像作為輸入的分割網絡的損失值的超參數。魯棒性實驗采用COVID-19數據集,使用U-Net+EnGAN模型。在本研究中,進行了兩組實驗:第一組實驗設置α=1,調整β的值域為[0.1,5]進行測試;第二組實驗設置β=1,調整α的值域為[0.1,5]。觀測指標使用評估分割準確率的Dice系數,以及評估圖像相似度的SSIM指標,如圖7所示。

當β值較低(β<1)時,LSeg在損失函數中的比重較小,因此LSim占主導地位,圖像的變更相對較小,相似性指標表現得相對較好;但隨著β的增加,對于圖像分割準確率的權重提升,對于圖像的優化方向逐漸傾向LSeg,因此相似性逐漸下降。與此同時,由于LSeg權重的提升,Dice系數隨β的增加快速提升。但是當β繼續增大時,LSeg權重增大,圖像的相似度逐漸變小,而且難以收斂,相應的Dice值增長緩慢,同時也出現了發散現象。

根據這些實驗數據可以發現,簡單地增加β值并不會始終提升模型性能。進一步分析,可以發現存在一個最優β值,在該值時模型可以達到最佳的性能平衡。

在另一組實驗中,固定β=1,調整α進行對比分析。如圖8所示,隨α值的遞增,可以看到相似性和Dice系數兩大性能指標的變化呈現出一種特定關系。

具體地,在α值較低的區間,相似性指標顯著上升,表明模型在這個范圍內對相似性的約束能力逐漸增強。但當α進一步增加時,相似性指標逐漸趨于穩定,并且逼近到1。而Dice系數在α初期增加時略顯下降,但隨后基本穩定,表明α的權重增大之后,LSim的懲罰加大,使優化的方向趨向于保持圖形的相似度,最終導致增強圖像和原始圖像高度相似時,分割的結果也趨近原始的數值。

基于對α和β的魯棒性的初步分析,進一步展開了深入的實驗研究。實驗結果表明,在α取值為[0.65, 1.1],以及β取值為[0.7, 1.5],圖像的相似度能夠穩定維持在[0.8,0.9],并且此時模型的分割準確率達到最優表現。

在EnGAN模型的構建與優化中,超參數α和β的選擇和調整顯得尤為關鍵。深入了解并妥善調整這兩參數間的相互關系,有助于確保模型在多種應用場景下呈現出穩健的高效性能。

3.5.6 實驗結果分析

本文在三個數據集上進行了數據增強實驗。由于相似性損失的限制,如圖4~6所示,增強前后的圖像差異非常小,在視覺上難以察覺。一般的數據增強處理方法為擴展數據集空間,這會對數據本身造成損傷和損失。本文在第四個實驗中證明了EnGAN方法的優越性。從四個實驗的結果來看,本文的增強方法保護了數據的一致性和完整性,只對數據造成了微小的改變。然而,相似性損失的效果仍然有限,一些增強圖像中出現了更明顯的噪聲,如圖4的第三張圖片所示。

表1~4的分割結果顯示,無論是使用基線的U-Net,還是添加注意機制或添加ResNet模塊,原始圖像經過EnGAN增強后,圖像分割的準確性都有所提高。生成器遷移的目標是連續空間中的標簽分布,優化器作為映射函數由分割網絡執行。因此,生成器服從標簽和分割網絡的聯合分布,并通過GAN的遷移能力獲取先驗知識,從而有效地增強圖像。

這種方法已在不同模態的數據集上得到驗證,適用于二元分割和多類分割任務,表明這種方法對不同數據類型具有良好的適應性。一些圖像的分割精度得到了顯著提高,如圖4中的第四張圖片。全數據的準確性也得到了提高,顯示出一定的適應性。無論模型和數據集選擇怎樣的,其改進效率都相對穩定。

4 結束語

本文提出了一種在醫學圖像中使用自標簽的數據增強方法。在該方法中,使用了一個優化器將離散分布的標簽數據映射到連續空間,并將其添加到GAN中,為GAN提供一個目標域。同時,限制了增強圖像與原始圖像之間的差異,以確保數據本身不受損害。訓練過的GAN可以增強原始圖像,并提高系統的分割精度。通過多模態的實驗,結果表明,增強圖像能使分割精度穩定提升,顯示了該方法的穩定性和適應性。需要指出的是,實驗中出現了隨機噪聲。而本文中的相似性損失無法防止這種情況的發生,這需要在后續的研究中尋找解決方法。

參考文獻:

[1]Albawi S,Mohammed TA,Al-Zawi S. Understanding of a convolutio-nal neural network [C]// Proc of International Conference on Engineering and Technology. Piscataway,NJ:IEEE Press,2017: 1-6.

[2]Ronneberger O,Fischer P,Brox T. U-Net: convolutional networks for biomedical image segmentation [C]// Proc of International Confe-rence on Medical Image Computing and Computer-Assisted Intervention. Berlin:Springer,2015: 234-241.

[3]GoodFellow I,Pouget-Abadie J,Mirza M,et al. Generative adversarial nets [C]// Advances in Neural Information Processing Systems. 2014.

[4]王紹帆,馬馳,胡輝,等. 基于對抗學習的醫學圖像分割領域自適應研究 [J]. 計算機應用研究,2022,39(4): 1270-1273.( Wang Shaofan,Ma Chi,Hu Hui,et al. Research on domain adaptation medical image segmentation based on adversarial learning[J]. Application Research of Computers,2022,39(4): 1270-1273.)

[5]Leclerc S,Smistad E,Pedrosa J,et al. Deep learning for segmentation using an open large-scale dataset in 2D echocardiography [J]. IEEE Trans on Medical Imaging,2019,38(9): 2198-2210.

[6]Long J,Shelhamer E,Darrell T. Fully convolutional networks for semantic segmentation [C]// Proc of IEEE Conference on Computer Vision and Pattern Recognition. Piscataway,NJ:IEEE Press,2015: 3431-3440.

[7]Medsker L R,Jain L C. Recurrent neural networks [J]. Design and Applications,2001,5(64-67): 2.

[8]Krizhevsky A,Sutskever I,Hinton G E. ImageNet classification with deep convolutional neural networks [J]. Communication of the ACM Processing Systems,2012,60(6): 84-90.

[9]Badrinarayanan V,Kendall A,Cipolla R. SegNet:a deep convolutional encoder-decoder architecture for image segmentation [J]. IEEE Trans on Pattern Analysis and Machine Intelligence,2017,39(12): 2481-2495.

[10]Simonyan K,Zisserman A. Very deep convolutional networks for large-scale image recognition [EB/OL].(2014). https://arxiv.org/abs/1409. 1556.

[11]Chen L C,Papandreou G,Kokkinos I,et al. Semantic image segmentation with deep convolutional nets and fully connected CRFs [EB/OL].(2014).https://arxiv.org/abs/1412. 7062.

[12]Chen L C,Papandreou G,Kokkinos I,et al. DeepLab: semantic image segmentation with deep convolutional nets,atrous convolution,and fully connected CRFs [J]. IEEE Trans on Pattern Analysis and Machine Intelligence,2017,40(4): 834-848.

[13]Chen L C,Papandreou G,Schroff F,et al. Rethinking atrous convolution for semantic image segmentation [EB/OL].(2017). https://arxiv.org/abs/1706. 05587.

[14]Chen L C,Zhu Yukun,Papandreou G,et al. Encoder-decoder with atrous separable convolution for semantic image segmentation [C]// Proc of European Conference on Computer Vision. Cham: Springer,2018: 801-818.

[15]Yang Qingsong,Yan Pingkun,Zhang Yanbo,et al. Low-dose CT image denoising using a generative adversarial network with Wasserstein distance and perceptual loss [J]. IEEE Trans on Medical Ima-ging,2018,37(6): 1348-1357.

[16]Gulrajani I,Ahmed F,Arjovsky M,et al. Improved training of Wasserstein GANs [EB/OL].(2017). https://arxiv.org/abs/1704. 00028.

[17]Shan Hongming,Zhang Yi,Yang Qingsong,et al. 3-D convolutional encoder-decoder network for low-dose CT via transfer learning from a 2-D trained network [J]. IEEE Trans on Medical Imaging,2018,37(6): 1522-1534.

[18]Chen Yuhua,Shi Feng,Christodoulou A G,et al. Efficient and accurate MRI super-resolution using a generative adversarial network and 3D multilevel densely connected network [C]// Proc of International Conference on Medical Image Computing and Computer-Assisted Intervention. Berlin:Springer,2018: 91-99.

[19]Sun Kun,Qu Liangqiong,Lian Chunfeng,et al. High-resolution breast MRI reconstruction using a deep convolutional generative adversarial network [J]. Journal of Magnetic Resonance Imaging,2020,52(6): 1852-1858.

[20]Xie Huaiqian,Lei Yang,Wang Tao,et al. Synthesizing high-resolution MRI using parallel cycle-consistent generative adversarial networks for fast MR imaging [J]. Medical Physics,2021,49(1): 357-369.

[21]Zhu J Y,Park T,Isola P,et al. Unpaired image-to-image translation using cycle-consistent adversarial networks [C]// Proc of IEEE International Conference on Computer Vision. Piscataway,NJ:IEEE Press,2017: 2223-2232.

[22]Calimeri F,Aldo M,Claudio S,et al. Biomedical data augmentation using generative adversarial neural networks[C]// Proc of International Conference on Artificial Neural Networks. Cham: Springer,2017: 626-634.

[23]Han C,Hayashi H,Rundo L,et al. GAN-based synthetic brain MR image generation[C]//Proc of the 15th IEEE International Symposium on Biomedical Imaging. Piscataway,NJ: IEEE Press,2018: 734-738.

[24]Madani A,Moradi M,Karargyris A,et al. Chest X-ray generation and data augmentation for cardiovascular abnormality classification [C]// Proc of SPIE 10574,Medical Imaging:Image Processing.2018:415-420.

[25]Bailo O,Ham D,Shin Y M. Red blood cell image generation for data augmentation using conditional generative adversarial networks [C]// Proc of IEEE/CVF Conference on Computer Vision and Pattern Re-cognition Workshops. Piscataway,NJ:IEEE Press,2019: 1039-1048.

[26]Shi Haoqi,Lu Junguo,Zhou Qianjun.A novel data augmentation me-thod using style-based GAN for robust pulmonary nodule segmentation [C]// Proc of Chinese Control and Decision Conference. Piscataway,NJ:IEEE Press,2020: 2486-2491.

[27]Beji A,Blaiech A G,Said M,et al. An innovative medical image synthesis based on dual GAN deep neural networks for improved segmentation quality [J]. Applied Intelligence,2023,53(3): 3381-3397.

[28]Wang Yu,Ji Yarong,Xiao Hongbin. A data augmentation method for fully automatic brain tumor segmentation [J]. Computers in Biology and Medicine,2022,149: 106039.

[29]Ding Yi,Wu Guozheng,Chen Dajiang,et al. DeepEDN: a deep-learning-based image encryption and decryption network for Internet of Medical Things[J]. IEEE Internet of Things Journal,2020,8(3): 1504-1518.

[30]Guo Zhiwei,Yu Keping,Neeraj K,et al. Deep-distributed-learning-based POI recommendation under mobile-edge networks[J]. IEEE Internet of Things Journal,2022,10(1): 303-317.

[31]Ding Feng,Zhu Guopu,Alazab M,et al. Deep-learning empowered digital forensics for edge consumer electronics in 5G HetNets [J]. IEEE Consumer Electronics Magazine,2020,11(2):42-50.

[32]Kingma D P,Ba J. Adam: a method for stochastic optimization [EB/OL].(2014). https://arxiv.org/abs/1412. 6980.

[33]Guo Zhiwei,Yu Keping,Bashir A K,et al. Deep information fusion-driven POI scheduling for mobile social networks [J]. IEEE Network,2022,36(4): 210-216.

[34]Al-Dhabyani W,Gomaa M,Khaled H,et al. Dataset of breast ultrasound images [J]. Data in Brief,2020,28: 104863.

[35]Li Lin,Qin Lixin,Xu Zeguo,et al. Artificial intelligence distinguishes COVID-19 from community acquired pneumonia on chest CT [J]. Radiology,2020,296(2):200905.

[36]Paszke A,Gross S,Massa F,et al. PyTorch: an imperative style,high-performance deep learning library [C]// Proc of the 33rd International Conference on Neural Information Processing System. Red Hook,NY: Curran Associates Inc.,2019: 8026-8037.