教AI學會遺忘

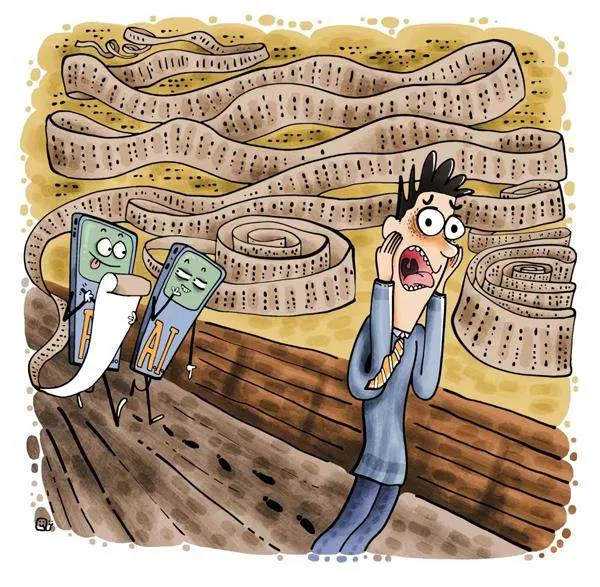

現在,由AI驅動的聊天機器人,如ChatGPT,已經很強大,強大到令人不安。譬如,假如你是林黛玉,有一天你在ChatGPT上輸入:“請提供關于林黛玉的一些信息。”結果,ChatGPT很快便給你輸出一長串信息,包括林黛玉的身份證號、銀行卡號、過去和現在的住址、健康狀況、愛吃的美食、讀過的書、跟誰談過戀愛,等等。這肯定會嚇你一大跳。

ChatGPT是怎么獲得這些信息的?當然是從互聯網上,你寫的文章或帖子、你在社交媒體發布的信息、你瀏覽過的網站等多方渠道收集匯總來的。

你想:那好吧,我盡我所能,把那些文章或帖子都刪去,把社交媒體清空,把瀏覽網站的蹤跡抹去。現在ChatGPT總該收集不到這些隱私信息了吧。然后,你再問ChatGPT同樣的問題。可是,讓你驚訝的是,ChatGPT照樣能給你同樣的答復。換句話說,ChatGPT是有記憶的,一旦記住了,就再也無法忘記!

這真要把我們嚇出一身冷汗,這些隱私要是被黑客或者壞蛋知道了,多危險啊!這就不難理解,教會AI學習固然重要,但教會AI遺忘,有時候也很重要。

可是,如何教AI遺忘呢?那還得從如何教AI學習說起。

AI聊天機器人是如何學習的

新一代AI聊天機器人,都以大型語言模型為基礎。這些模型是在大量數據基礎上訓練出來的。這些數據來自互聯網,從社交媒體上的帖子到大約25萬本電子書,以及幾乎所有公開的信息,包括新聞網站和百科網頁。它們從中學會了預測句子中最可能出現的下一個單詞。這使得它們能流利地回答我們提出的幾乎每一個問題。

問題在于,這種工作方式意味著,當它們學會某些東西后,就無法遺忘。一般的網頁,我們可以自行刪除文章或帖子,自己刪不了還可以請求管理員刪帖,但語言模型是根據匯總的數據生成回復的。這些數據是在過去某個時間段收集來的,不會實時更新,而且,一旦訓練完成,就不再能影響AI。這就像網頁上的一篇文章,如果我們閱讀后記住了,哪怕刪去文章,也不會把我們的記憶刪去。為了提高AI的性能,我們此后當然還會拿更多的新數據訓練它,但新的訓練只會增加AI的知識儲備,不會把原來的記憶抹去。

AI有過目不忘的本領,這相較于健忘的人類,當然是一個無可比擬的優點。但這不僅侵犯了我們的隱私權,甚至有可能被壞人利用。譬如,你的某個敵人為了誹謗你,先在網站上散布大量謠言。然后,這些數據被拿去訓練AI,于是當別人在ChatGPT上查詢有關你的信息時,他們從那里了解到的盡是不實之詞。

好消息是,考慮到這些危險,研究如何有選擇性地刪除AI知識庫中信息的工作已經開始。壞消息是,這項工作并不能一蹴而就。

讓AI學習遺忘

目前,AI公司只能依靠“沉默”來解決這個問題,即通過編程阻止用戶訪問某些信息并拒絕回復。例如,當我要求ChatGPT告訴我有關林黛玉的信息時,它會說:“非常抱歉,我無法滿足你的要求。”這種方法在一定程度上可行。但數據仍在AI的“記憶”中,仍有可能由于故障或惡意誘導而出現在回復中。

讓AI遺忘得最徹底的方法是,刪除特定的數據點,然后從頭開始訓練語言模型。但這需要一切從頭開始,并需要很長時間。有沒有辦法在不從頭開始的情況下,移除或至少屏蔽特定信息呢?

有一種方法是,在訓練AI的時候,不在全部數據上訓練,而是把數據分割成一塊一塊的,分別對每個小塊進行訓練,然后再合并結果。這樣,當一個人要求刪除某些信息時,你只需修改相關數據的片段,再對這塊數據進行重新訓練,這就大大地降低了訓練成本。

不過,上述方法往往會削弱AI強大的學習能力。為了規避這個問題,還有一種方法是選擇事后處理。這種方法被稱為“知識解除學習”,即對于一條AI已懂得的知識,不是完全刪除它,而是將其擱置一邊,永遠不去引用它。“知識解除學習”不必對語言模型進行傷筋動骨的改造,目前是這一領域最有前景的方法之一。

(和葉摘自《大科技·科學之謎》2024年3月A,邱炯圖)