基于深度強化學習的多路徑調度模型

摘 要:文章提出一種基于深度強化學習的多路徑調度模型,在聚合場景中將深度學習技術應用于流量管理,以解決多路徑環境下的數據包調度問題。文章使用了一個多路徑快速UDP網絡連接協議(MPQUIC)來實現多路徑場景中的路徑選擇,并訓練了一個代理人(Agent)來改進最優選擇路徑的算法,展示了將深度Q網絡代理(DQN Agent)應用于數據流量管理問題的優勢。實驗證明了在實時環境中使用DQN Agent來提高包調度器性能的可行性,以及使用該技術對新的5G網絡進行優化的潛力。實驗結果表明:基于深度強化學習的多路徑調度模型能夠自適應地調整路徑選擇策略,從而提高網絡的穩定性和可靠性。改進的模型不僅具有理論價值,還為實際應用提供了有益的參考和借鑒。

關鍵詞:5G網絡;多路徑;分組調度;深度強化學習;QUIC;MPTCP

中圖分類號:TP181 文獻標志碼:A

*基金項目:甘肅省基礎研究計劃-軟科學專項“‘強省會戰略下推進‘四型機場建設的實施路徑和策略研究—以蘭州中川國際機場為例”(22JR4ZA108)。

作者簡介:趙靜(1981-),女,碩士,講師,主要研究方向:人工智能技術。

0 引言

隨著人工智能技術的不斷發展,深度強化學習作為一種新興的學習范式,正在被廣泛應用于各個領域。在傳統的調度問題中,如任務調度、生產調度等,采用深度強化學習進行多路徑調度優化已成為研究熱點。然而,在實際應用中,仍然存在著許多問題和挑戰,如路徑選擇、任務分配、資源利用率等方面的優化。文章旨在基于深度強化學習,設計并構建一種多路徑調度模型,以解決傳統調度問題中存在的優化難題,提高路徑選擇、任務分配和資源利用率的效率和準確性。通過對多路徑調度模型進行深入研究和實驗驗證,探索深度強化學習在該領域的應用前景,提高多路徑調度問題的解決效率和質量。5G 架構的關鍵概念之一是網絡接入(Access Networks,AN)的合并。5G系統架構[1]定義了一個具有公共接口AN-CN的融合核心網(CN),它集成了第三代合作伙伴計劃(3GPP)和非3GPP網絡,如Wi-Fi或固定接入網,在這些場景中可以同時使用多個網絡接入[2]。通過多訪問架構,可以定義新的應用場景,并根據訪問的用途進行分類:(1)聚合應用,它以終端用戶只感知一個接入的方式聚合接入網絡,具有底層接入(如聚合帶寬,延遲等)的聚合特性;(2)彈性應用,它只使用一個網絡接入,并使用其余的網絡接入進行冗余。彈性應用的一個例子是Apple Siri服務[3],它默認使用Wi-Fi網絡接入,但通過移動網絡接入打開會話以進行備份。

文章采用深度強化學習算法,考慮任務調度、路徑選擇、資源利用率等因素,構建多路徑調度模型。首先,將對傳統的調度問題進行深入分析,明確問題的關鍵點和難點;其次,設計出基于深度強化學習的多路徑調度模型;最后,在模型構建完成后,將進行大量的仿真實驗和案例分析,以驗證模型的有效性和優越性。文章的研究工作主要集中在聚合場景中,特別是符合寬帶論壇(BBF)規范的架構。主要關注L4多路徑網絡,其主要特點是使用多路徑傳輸協議,通過多條路徑來控制流量。基于前述BBF規范,根據策略、數據包流量類別和每個可用訪問路徑的性能,將流量分布在不同的路徑上。

根據性能選擇最佳路徑通常稱為分組調度(Packet Scheduling)。大多數多路徑協議的實現都使用平滑往返時間(Smoothed Round-Trip Time,SRTT)和擁塞窗口作為表征訪問路徑性能的參數。尤其是在擁塞窗口不滿的情況下,選擇SRTT較低的路徑對數據包進行調度,以實現多路徑傳輸控制協議(MPTCP)[4]。理論上講,在明確網絡參數的前提下,可以建立一個提供最優性能的調度器。但在實際應用中,網絡訪問的延遲會隨著時間而變化,特別是在移動網絡中,帶寬也會隨著并發連接數的變化而變化。通過引入其他參數和更復雜的算法,研究認為可以通過預測訪問的演化來改進分組調度。

在強化學習領域,深度學習系統廣泛應用于許多Atari視頻游戲,提出利用機器學習技術對Packet Schedule算法進行改進,并將該方法應用于深度強化學習代理作為數據包調度器,通過與測試環境的交互來查看代理人(Agent)如何學習,以得到分發數據包的最佳算法。結果表明,在某些場景中,深度強化學習方法給出了最優的結果。因此,文中技術可以用于改進大多數多路徑實現中使用的默認包調度器。

1 研究背景及相關研究綜述

隨著互聯網的飛速發展和大數據時代的到來,網絡流量呈現出爆炸式增長的態勢。傳統的單路徑傳輸方式已經難以滿足日益增長的網絡需求,多路徑傳輸因其能夠充分利用網絡資源、提高傳輸效率而備受關注。然而,多路徑調度問題涉及復雜的決策過程,傳統的優化方法難以應對其動態性和不確定性。因此,文章提出利用深度強化學習技術來解決多路徑調度問題,以期實現更高效的網絡傳輸。

1.1 相關概念

1.1.1 深度強化學習

深度強化學習(Deep Reinforcement Learning,DRL)是一種結合深度學習和強化學習的技術,通過深度神經網絡來逼近強化學習中的值函數或策略函數,從而處理更加復雜和大規模的問題。

1.1.2 多路徑調度

多路徑調度(Multi-path Scheduling)指在網絡傳輸中,根據一定的策略將數據流分配到不同的路徑上進行傳輸,以充分利用網絡資源,提高傳輸效率。

1.2 已有研究分類

1.2.1 基于傳統優化算法的研究

這類研究主要利用數學優化方法,如線性規劃、整數規劃等,來解決多路徑調度問題。雖然這些方法在理論上有較好的性能保證,但在實際應用中,由于問題的復雜性和動態性,往往難以獲得理想的效果。

1.2.2 基于啟發式算法的研究

啟發式算法通過模仿人類決策過程或借鑒自然界中的某些現象來進行路徑選擇和調度。這類方法通常具有較好的實時性和適應性,但在處理大規模復雜問題時,其性能往往不穩定。

1.2.3 基于深度強化學習的研究

近年來,隨著深度強化學習技術的快速發展,越來越多的研究開始嘗試利用DRL來解決多路徑調度問題。這類方法能夠自動學習和優化調度策略,適應網絡環境的動態變化,具有較高的潛力和應用價值。

傳統優化算法雖然理論性強,但在實際應用中難以處理復雜的動態問題;啟發式算法雖然實時性好,但性能不穩定;而深度強化學習則能夠結合深度學習的表征學習能力和強化學習的決策能力,有效應對多路徑調度問題的復雜性和動態性。然而,目前基于深度強化學習的多路徑調度研究仍處于探索階段,面臨著諸多挑戰,如模型設計、訓練效率、穩定性等問題。

綜上所述,基于深度強化學習的多路徑調度模型研究具有重要的理論價值和實踐意義。文章旨在探索更加高效的深度強化學習算法,以解決多路徑調度問題中的關鍵挑戰。具體研究問題包括:設計合適的深度神經網絡結構以充分提取網絡狀態的特征;設計有效的獎勵函數以引導模型學習到高質量的調度策略;提高模型的訓練效率和穩定性。通過解決這些問題,期望能夠為多路徑調度問題的研究提供新的思路和方法。

2 實驗平臺與實驗過程

2.1 研究目標

研究的主要目標是使用深度強化學習代理來改進多路徑協議的數據包調度。主要的挑戰是如何在網絡系統中集成現有的、最先進的、具有強制性低延遲性的Agent。一方面,通過對通信網絡有時延要求,在新的5G網絡中,超可靠低時延通信(Ultra Reliable Low Latency Communications,URLLC)服務的時延要求為1 ms;另一方面,包調度器的實現必須是快速的,達到微秒級甚至納秒級,以不干擾實驗的結果。

2.2 實驗中使用的技術

2.2.1 多路徑協議

在實驗中,使用 MPQUIC 作為多路徑協議。MPQUIC是基于QUIC協議的改進QUIC-GO5,使用Go編程語言實現。該協議的優點之一是不依賴于內核實現,并且允許“快速實現-運行-測試”的周期循環。

2.2.2 深度強化學習代理

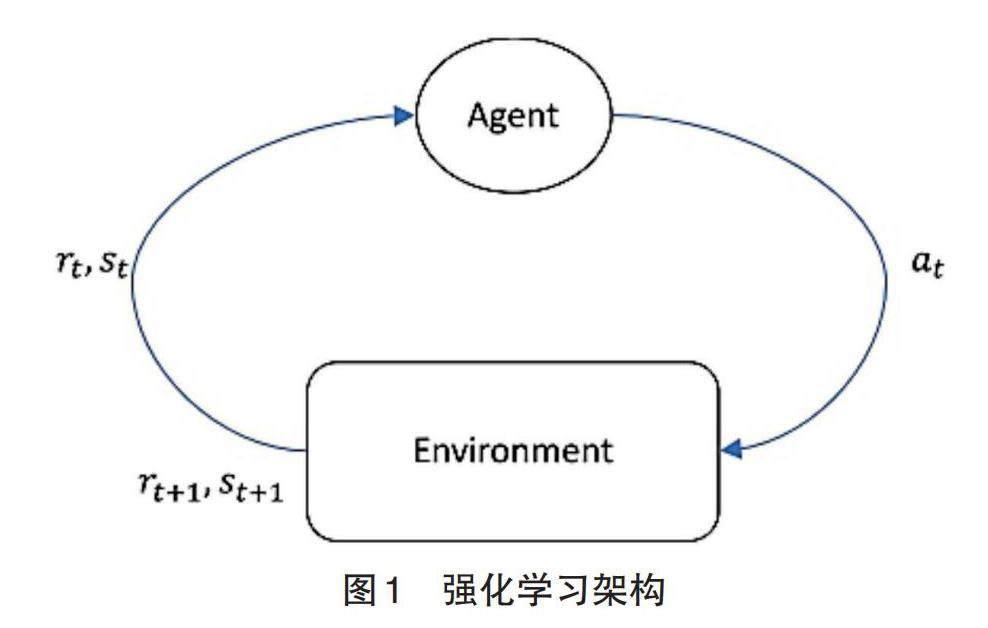

深度強化學習(DRL)是融合了試錯法學習范式的強化學習(Reinforcement Learning,RL)和使用深度神經網絡的深度學習(Deep Learning,DL)的創新概念。DeepMind公司在2013年推出了應用于舊式Atari游戲的新范式,其結果有時竟然超過了人類。這項工作使用Q-Learning強化學習技術,基于從初始狀態 s 0 開始,尋找在連續步驟中獲得最大獲益的策略。圖1演示了強化學習技術的流程架構。即:Agent讀取當前的環境狀態s t ,并從可用的動作集合A中選擇一個動作 a t ∈A ;通過執行選定的動作,過渡到另一個狀態 s t+1 ,并為Agent r t+1 提供一個可觀獎賞,并通過學習選擇獎賞最大化的最優算法。DeepMind 最初的目標是通過一個深度神經網絡(Deep Neural Network,DNN)來代替傳統的獲取最佳動作的算法。因此,這種新技術被稱為深度Q網絡(Deep Q Network,DQN),而實現它的Agent就是DQN Agent。

2.3 實驗流程

圖2展示了一個深度強化學習代理的體系結構,包括2個主要階段:(1)前饋,其中Agent使用當前狀態作為深度神經網絡的輸入,并獲得具有最佳預測獎勵的動作(最優動作);(2)反向傳播,其中Agent使用以前的經驗(批量回放)來更新深度神經網絡的權重和偏置。由于反向傳播消耗大量的計算資源,該任務必須在離線模式下完成,即與數據包調度分離。TensorFlow庫中DQN Agent的最新實現的快速審查結果表明,前饋過程需要在5~10 ms,這與5G網絡中所需的延遲處于同一數量級。為此,在2個模塊中實現一個DQN Agent:其中一個模塊嵌入到MPQUIC服務器中,為每個狀態選擇最優動作;以及另一個具有學習邏輯的離線模塊。為模塊之間的通信定義了2個接口:第一個接口包含一個公共分離值(CSV)文件,其中包含在線Agent的經驗,即狀態列表 s t ,動作 a t 和獎勵 r t 。這些信息被離線Agent用于執行學習。第二個接口用于將DNN的新值上傳至在線Agent。為此,使用了層級數據格式5(hdf5)文件,其廣泛應用于現有框架。

2.4 狀態、獎勵和行為

最優狀態和獎賞函數的選擇對深度強化學習的性能至關重要。此外,還需要保證選擇與馬爾可夫決策過程(MDP)框架兼容,特別是狀態向量s表示唯一的狀態。在DQN Agent[5]的原始工作中,這個問題是通過在狀態向量中堆疊框架來解決的。在案例中,提出了保證唯一性的特征組合:平滑往返時間、擁塞窗口和發送的數據。

2.4.1 平滑往返時間(SRTT)

往返時延(Round-Trip Time,RTT)是MPTCP的內核實現[6]和MPQUIC原型[7]中分組調度算法使用的基本參數。同時使用了Smooth RTT,即:

SRTT= ( ) 1-α *SRTT+α*R ' (1)

式中:R ' 是最后一個RTT, α= 1 / 8 。

在DQN Agent的實現中使用了SRTT特征。

SRTT '=SRTT/150 (2)

式中:SRTT ' 為將SRTT特征重新縮放到150 ms。

2.4.2 擁塞窗口(CWND)

擁塞窗口特征是通過擁塞控制算法計算得到的擁塞窗口的字節大小。

CWND '=CWND /(300 * TCP_MSS) (3)

式中:CWND ' 意為將CWND特征重新縮放為300個最大片段的尺寸(MaximumSegment Size,MSS),在實現中定義為1 460個字節。

2.4.3 發送字節(BiF)

BiF 是指 Flight 中的字節數,即未收到相應的(ACK消息)從而被確認為未確認發送的字節數。它是狀態向量中使用的最后一個特征。

BiF '=BiF/CWND (4)

式中:BiF ' 為將BIF特征被重新縮放到CWND的大小。

另一個需要界定的,是如何進行獎勵計算。因為它是Agent的反饋,因此比狀態定義更為關鍵。獎勵和懲罰之間的不平衡可能會導致學習過程中的錯誤。

partial Reward = sentBits /(3 500 * sessionTime)(5)

式中:參數 partial Reward (部分獎勵)以兆比特每秒(Mbps)為單位,表示在部分獎勵的情況下,基于會話具有任意數量的3 500個數據包的假設前提下,使用MPQUIC服務器發送的尚未確認的字節數和會話的持續時間來估計會話的吞吐量。

最終的獎勵定義為會話的平均吞吐量,用兆比特每秒(Mbps)表示。此外,當 MPQUIC 達到限制值,例如最大不帶ACK的數據包數時,或者在沒有丟包的理想信道中存在重傳或丟包時,獎勵中存在懲罰。

2.5 Agent實現

深度強化學習Agent分2個模塊實現。在線模塊在MPQUIC的包調度內執行,為簡化操作,只作為MPQUIC服務器的一部分,對下行流進行測試。離線模塊是對keras-rl框架的擴展實現,該框架在Py?thon中實現深度強化學習算法,并與流行的深度學習Python庫keras9集成。

2.5.1 在線Agent

在線Agent的主要組件是gorl庫,它實現了深度Q網絡。為了重用代碼,實現了一個通用的DNN,其中包含了這項工作所需的基本要素。它支持基于全連接層的多層神經網絡,具有任意的層數和可配置的層大小。它還支持最常見的激活函數,包括該工作中使用的激活函數(ReLu和Linear)。深度神經網絡定義在spec文件中,激活為keras格式。該庫支持2種工作模式:訓練與生產。在學習階段,使用了Training(訓練)模式,因為它每一層級產生一個CSV文件,其中包含一個用于每個數據包調度的行,元組為( r t 、 s t 、a t )。在案例中,每個情節被映射到一個 MPQUIC 會話,情節描述文件中包含的關于Agent 的狀態、獎勵和動作的信息被用于離線訓練。gorl支持使用從離線代理導出的HDF5文件對DNN進行更新。另一個組件插入到MPQUIC服務器的包調度器中,該組件的任務是設置 DNN,從MPQUIC服務器中可用的信息中收集狀態向量 s t ,調用DNN獲取動作 a t 并計算獎勵 r t 。

DQN Agent必須解決的基本問題是探索與開發之間的平衡。Agent必須尋找一個狀態的不同行動方案,從而確定最優方案。為此它將測試不同的行動方案下不同獎勵,并更新Deep Q網絡。在線代理實現了2個功能:選擇最優動作(對于非學習型運行)的ArgMax函數和以概率進行探索的ε-greedy函數以 ε 的概率進行利用。在訓練的執行過程中,使用了一個 ε∈[ 0.1,0.9],從0.9開始,線性減小直到0.1,至訓練結束。

2.5.2 離線Agent

離線Agent使用keras-rl框架實現,它是實驗框架的一部分。通過擴展了kera的DQNAgent的行為,以支持在線代理生成的CSV情節文件。keras-rl框架很好的集成到了Gym OpenAI環境中,提供了不同場景的環境基礎。在案例中,創建一個OpenAI環境,用于加載CSV情節文件,以便為離線代理提供在線代理的經驗。此外還擴展了keras-rl DQN Agent,以便在訓練過程中使用由在線代理決定的動作a t 。

2.6 實驗流程及結果

文章提供了一個執行代理的環境來進行訓練和測試Agent。基本設置是一個MPQUIC客戶端和服務器運行在Mininet網絡仿真器之上,該仿真器模擬網絡拓撲,NetEm仿真器允許配置通道的帶寬和它們的延遲。實驗流程如圖3所示,包括從MPQUIC客戶端下載文件,直到有足夠的信息開始離線訓練。離線訓練完成后,將新的DNN模型加載到在線代理中繼續測試。

流程中包括為MPQUIC客戶端配置了2條可能的路徑,通過在交換機上增加2條連接,交換機上也有1條通往MPQUIC服務器的路徑。該框架支持離線 Agent 的執行,并提供了用于創建不同測試的Jupyter筆記本應用程序。最后,用所有的實驗框架創建一個Docker鏡像,以允許在任何環境中重現實驗結果。

3 實驗結果分析

實驗目的是評估多條路徑帶寬聚合的效率。為了衡量效率,使用在下載固定大小(2 MB)文件的實驗中測量吞吐量。在實驗框架中,配置了帶寬為5 Mbps,基延遲為100 ms的MPQUIC路徑。為了比較不同場景下的結果,改變其中1條路徑的延遲,以模擬它們之間存在延遲的非對稱路徑,即delta(ms)∈[0,50]。第一個實驗設置了MPQUIC協議的性能基線,用于測量效率。如圖4所示,圖(a)表示使用單條路徑測量吞吐量的結果,并以此作為該場景下MPQUIC協議吞吐量的基礎。圖(b)表示使用默認調度器RTT的多路徑場景下的吞吐量,圖(c)表示隨機選擇任意路徑的隨機調度器。初始測試結果表明,選擇低延遲路徑和隨機選擇路徑之間只有很小的差異。

一旦基線建立,即可對延遲為0的不同場景進行 DQN Agent 的訓練,其中 delta(ms)∈[0,50]。且考慮到消耗的時間和資源,必須對訓練進行限制。此外,假設在訓練過程中,不同路徑的測量SRTT之間的差異在δ范圍內變化,因此Agent將在所有可能的SRTT值中進行訓練。圖5描述了DQN Agent在訓練時間上的演化,以步數(預定數據包)為橫軸進行了分析。訓練經過130 000步后具有最大的吞吐量,此模型用于訓練的驗證。

為了比較聚合策略的效率,定義聚合效益(Ag?gregation Benefit,ABen)為:

式中:?是實測吞吐量的平均值,?s 是MPQUIC在單路徑場景下的基線平均吞吐量。

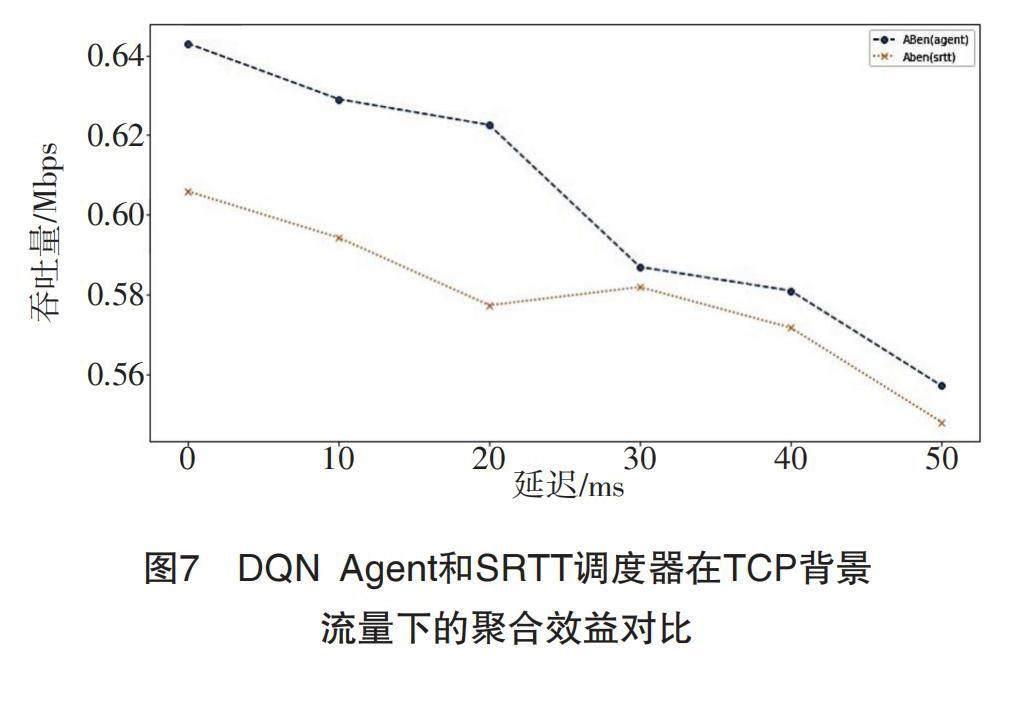

圖6描述了MPQUIC默認包調度器(SRTT)和訓練好的DQN Agent之間的聚合效益對比ABen。可以看到,盡管DQN Agent僅在0延遲場景下訓練,但聚集效益在delay(ms)∈[0,50]范圍內得到了提高,驗證了實驗假設。

綜合效益在4.45%和7.58%之間得到改善,見表1。

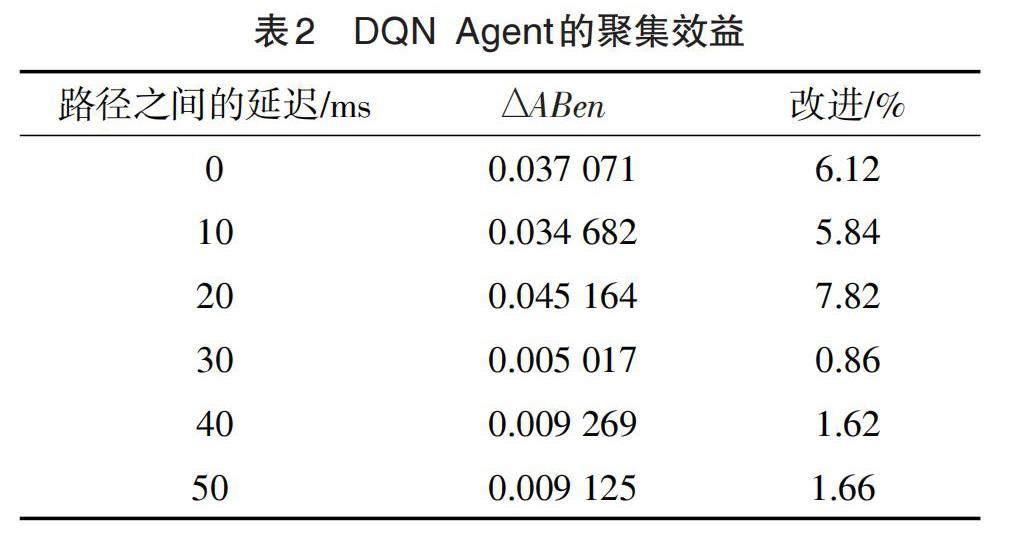

為了測試DQN Agent的魯棒性,文章使用背景流量進行了重復實驗。為此,在Agent的訓練和測試過程中,通過網絡的 2 條路徑生成背景 TCP 流量。由于在之前的場景中取得了不錯的效果,只在0 延遲場景中重復訓練DQN Agent,并在24 050步取得了最大的吞吐量。使用訓練好的代理,得到了類似的改進結果,但只有 delay(ms)∈[ 0 ,20 ]。從30 ms的差異來看,聚合效益的改善下降到1 %,如圖7和表2所示。

4 結論與討論

文章分析了深度強化學習在一個具體的流量管理問題中的應用,即多路徑環境下的數據包調度問題。在實驗中,證明了在實時環境中使用DQN Agent來提高包調度器性能的可行性,以及使用這種技術對新的5G網絡進行優化的潛力。在實驗過程中使用了一個全連接層的DNN。今后可以嘗試引入其他具有時間記憶的模型,如卷積神經網絡(CNN)或長短期記憶網絡(LSTM)。這些模型可以更好地預測路徑條件的變化,從而更好地學習最優行為。離線-在線架構工作良好,但仍需要占用大量的資源和時間,使得工作效率還有待提升。今后可以使用預訓練的方法,通過使用Gym OpenAI環境來模擬網絡和多路徑行為。研究過程中將 DQN Agent與MPQUIC協議集成,將Agent動作定義為選擇發送數據包的路徑,結果并不理想不足以解決完整的問題,今后可能需要 DQN Agent 通過控制MPQUIC的更多方面,如重傳控制或數據包來進行更加充分的集成。最后,在獎勵方面,定義的微調也可以促進學習的改進,這也是今后改進的方向。

文章深入探討了基于深度強化學習的多路徑調度模型,并將其應用于網絡流量優化問題中。通過對模型的構建、訓練以及實驗驗證,得出了以下結論:

(1)模型有效性。文章設計的深度強化學習多路徑調度模型在復雜的網絡環境中表現出了顯著的有效性。通過不斷地學習和調整,模型能夠自適應地選擇最優路徑,實現網絡流量的高效調度。

(2)性能優勢。與傳統的調度算法相比,基于深度強化學習的多路徑調度模型在多個評價指標上均表現出了明顯的優勢。特別是在高負載和網絡擁堵的情況下,該模型能夠更好地平衡網絡負載,減少數據包的丟失和延遲。

(3)可擴展性。文章提出的模型具有良好的可擴展性。通過調整模型的參數和結構,可以將其應用于不同類型的網絡和調度場景,滿足不同的流量優化需求。

雖然文章取得了一定的研究成果,但仍存在一些有待解決的問題。未來的研究可以進一步探索模型的優化策略,提高其適應性和魯棒性。同時,也可以考慮將更多先進的深度學習技術引入到多路徑調度中,以實現更高效、更智能的網絡流量管理。

綜上所述,基于深度強化學習的多路徑調度模型在網絡流量優化方面表現出色,具有廣闊的應用前景和研究價值。文章為網絡流量管理提供了新的思路和方法,對于提升網絡性能和服務質量具有重要意義。

參考文獻:

[1]石紅曉,程永志. 基于5G核心網的網絡演進及策略研究[J]. 通信與信息技術,2020(4):39-41+50.

[2]賈靖,王恒,夏旭,等. 空地一體網絡接入選擇與切換控制技術研究[J]. 無線電通信技術,2023,49(5):826-833.

[3]高菁陽.下一場戰役:人機對話 — —對話Siri創始人諾曼(Norman Winarsky)[J]. 清華管理評論,2017(Z2):8-13.

[4]廖彬彬,張廣興,刁祖,等. 基于深度強化學習的MPTCP動態編碼調度系統[J]. 高技術通訊,2022,32(7):727-736.

[5]LI J,Dang X,LI S. DQN- based decentralized multi-agent JSAP resource allocation for UAV swarm commu?nication[J]. Journal of Systems Engineering and Elec?tronics,2023,34(2):289-298.

[6]夏雨峰,占敖,吳呈瑜,等. 基于MPTCP耦合的自適應帶寬估計算法[J]. 無線電通信技術,2022,48(2):336-341.

[7]黃培紀,蔣艷,陳斌,等. 基于線性規劃的MPQUIC調度算法[J]. 計算機時代,2023(6):38-42.

Multi-path Scheduling Model Based on Deep Reinforcement Learning

ZHAO Jing

(School of Information Engineering, Lanzhou Vocational Technical College,Lanzhou Gansu 730070,China)

Abstract::In this paper, a multi-path scheduling model based on deep reinforcement learning is proposed,and deep learning technology is applied to traffic management in aggregation scenario to solve the problem of packet scheduling in multi-path environment. A multi-path Quick UDP Internet Connection is used to implement path se?lection in multi-path scenarios, and an agent is trained to improve the optimal path selection algorithm, demonstrat?ing the advantages of applying DQN Agent to data traffic management problems. Experiments demonstrate the feasi?bility of using DQN Agent to improve the performance of packet scheduler in real-time environment, and the poten?tial of using this technology to optimize the new 5G networks. The experimental results show that the multi-path scheduling model based on deep reinforcement learning can adaptively adjust the path selection strategy, thereby improving the stability and reliability of the network. The improved model not only has theoretical value, but also provides useful reference for practical application.

Key words::5G network; multi-path; packet scheduling; deep reinforcement learning; QUIC; MPTCP