基于改進KCF算法的織物折皺回復(fù)檢測研究

郭栩源 李忠健 王蕾 潘如如 高衛(wèi)東

Research on fabric wrinkle recovery detection based on an improved KCF algorithm

摘要:織物折皺回復(fù)性能是評價織物形態(tài)穩(wěn)定性的關(guān)鍵指標(biāo)。傳統(tǒng)折皺回復(fù)角測試方法存在檢測過程依賴人工操作、難以量化折皺動態(tài)演變等問題。為實現(xiàn)對折皺回復(fù)全過程的自動化監(jiān)測,文章提出一種基于改進核相關(guān)濾波算法的動態(tài)折皺回復(fù)檢測方法。該方法使用高速攝像機捕捉織物折皺形變回復(fù)過程,應(yīng)用改進的核相關(guān)濾波算法檢測追蹤折皺頂點的運動角度變化。通過引入多特征融合提高檢測魯棒性,利用Canny邊緣檢測自適應(yīng)調(diào)整目標(biāo)區(qū)域,減小邊界效應(yīng)。在此基礎(chǔ)上提取感興趣區(qū)域骨架,計算折皺頂角度隨時間變化信息。結(jié)果表明,不同織物折皺角度變化規(guī)律與織物組織結(jié)構(gòu)高度相關(guān)。最后與標(biāo)準(zhǔn)測試結(jié)果建立線性模型,驗證所提方法的有效性。文章實現(xiàn)了對織物折皺回復(fù)全過程的自動化檢測與定量評估,提供了一種更為高效準(zhǔn)確的折皺回復(fù)性能檢測新思路,具有廣闊應(yīng)用前景。

關(guān)鍵詞:折皺回復(fù)角;特征融合;目標(biāo)追蹤;核相關(guān)濾波器;改進KCF

中圖分類號:TS103.7

文獻標(biāo)志碼:A

文章編號:10017003(2024)04007908

DOI:10.3969j.issn.1001-7003.2024.04.010

收稿日期:20230731;

修回日期:20240307

基金項目:紡織之光應(yīng)用基礎(chǔ)研究計劃項目(J202109);國家自然科學(xué)基金項目(61802152);浙江省基礎(chǔ)公益研究計劃項目(LGG21F030007);中國博士后科學(xué)基金面上資助項目(2020M681736);江南大學(xué)研究生科研與實踐創(chuàng)新項目(KYCX-23-ZD0 KYCX-23-ZD02)

作者簡介:郭栩源(1997),男,碩士研究生,研究方向為數(shù)字化紡織技術(shù)。通信作者:王蕾,副研究員,wangl_jn@163.com。

織物折皺回復(fù)性能是評價織物形態(tài)穩(wěn)定性的一項重要指標(biāo)。在服裝生產(chǎn)和日常使用過程中,織物都會出現(xiàn)不同程度的折皺,而折皺的快速消除對保證織物手感舒適、外觀效果及提高生產(chǎn)效率都有重要影響,織物折皺回復(fù)性能的優(yōu)劣在某種程度上直接決定面料及服裝的品質(zhì)與檔次[1]。良好的折皺回復(fù)性能可以使織物在折疊、運輸、加工等情況下迅速恢復(fù)原狀,從而提高織物的實用性。

目前,國內(nèi)外廣泛采用的評價織物折皺回復(fù)性能的標(biāo)準(zhǔn)測試方法主要是折皺回復(fù)角測試,即對織物進行折疊加壓處理,然后放松對其約束并在一定條件下測量其自然回復(fù)的折痕角度大小,以評估織物的折皺回復(fù)能力[2]。這種方法操作簡便,能夠直觀反映織物的折皺回復(fù)程度。但是傳統(tǒng)折皺回復(fù)角測試方法也存在一些問題,主要體現(xiàn)在:1)檢測過程需要過多人工參與,效率較低[3];2)測試結(jié)果易受人為因素影響,難以保證測量時間的準(zhǔn)確及角度測量的精度[4];3)無法區(qū)分不同時刻的折皺回復(fù)情況[5]。因此,這種方法只能給出折皺回復(fù)性能的整體略評,對織物折皺回復(fù)規(guī)律的細(xì)節(jié)描述不夠。針對傳統(tǒng)折皺回復(fù)角測試法的不足,學(xué)術(shù)界提出了一些改進方案,如在標(biāo)準(zhǔn)測試的基礎(chǔ)上增加不同方向折皺回復(fù)角度檢測[6]、結(jié)合圖像處理技術(shù)計算折皺面積比例[7]等。這些方法擴展了測試指標(biāo),但仍然存在檢測過程依賴人工操作、難以量化折皺動態(tài)演變等問題[8]。因此,開發(fā)一種能夠?qū)崿F(xiàn)對織物折皺回復(fù)全過程的自動化檢測與分析方法,對于提高折皺回復(fù)性能的測試效率與結(jié)果可靠性具有重要意義[9]。

為實現(xiàn)對織物折皺的全自動檢測分析,降低系統(tǒng)計算開銷,提高分析針對性和精確度,本文將折皺頂點區(qū)域作為目標(biāo)進行跟蹤分析。在眾多目標(biāo)跟蹤算法中,由于KCF(Kernel Correlation Filter)算法[10]具有極強的魯棒性和實時性,在對運動目標(biāo)追蹤方面具有良好的表現(xiàn)效果[11],本文決定使用KCF算法作為織物折皺頂角跟蹤算法。KCF算法是一種高效的核相關(guān)濾波算法,由Henriques等[10]在2012年提出,KCF算法屬于由Bolme等[12]所提出的相關(guān)濾波器算法的一種,是在MOSSE(Minimum Output Sum of Square Error)算法基礎(chǔ)上引入高斯核、循環(huán)矩陣、脊回歸等相關(guān)概念。新特性的引入同時帶來了跟蹤精度下降、邊界效應(yīng)等問題出現(xiàn)。針對這些問題,Bertinetto等[13]在KCF算法基礎(chǔ)上加入顏色特征,但當(dāng)目標(biāo)發(fā)生形變時仍會丟失目標(biāo)信息。潘長城等[14]提出融合類殘差更新策略的KCF改進算法,但該算法在對目標(biāo)進行持續(xù)跟蹤時仍有部分時刻丟失目標(biāo)信息,無法完整記錄目標(biāo)狀態(tài)信息。孫曉鋒等[15]使用目標(biāo)丟失重檢測及擴充區(qū)域重檢測的方法,但很難對丟失目標(biāo)進行重新定位。為了對織物折皺頂角進行完整準(zhǔn)確跟蹤,本文提出一種多特征融合及自適應(yīng)邊界調(diào)整的KCF算法。該算法能夠?qū)椢镎郯欗斀堑恼麄€動態(tài)過程進行完整跟蹤檢測,保證本文整套測試方法的有效性和準(zhǔn)確性。

1? 織物折皺回復(fù)性檢測方法

1.1? 方法概述

本文提出了一種基于改進KCF算法的織物折皺回復(fù)檢測方法,流程如圖1所示。該方法可以實現(xiàn)對織物折皺形成與消失過程的自動化監(jiān)測,并精確提取折皺動態(tài)參數(shù),給出客觀評價。首先,使用定制裝置對織物進行加壓釋放處理,然后使用高速攝像機采集織物折皺回復(fù)過程中的圖像序列,使用改進的KCF算法跟蹤折皺區(qū)域,獲取感興趣的折皺部位圖像。接著進行折皺區(qū)域圖像二值化與骨架化處理,最后使用直線擬合函數(shù)和反、正切函數(shù)直接提取折皺關(guān)鍵點角度信息。通過對不同組織規(guī)格織物進行實驗,獲取各織物試樣折皺回復(fù)過程中的折皺頂角角度信息,分析比較織物折皺回復(fù)性能。

1.2? 傳統(tǒng)KCF算法

1.2.1? 傳統(tǒng)KCF算法基本原理

KCF算法基本原理是構(gòu)建一個核相關(guān)濾波器來實時跟蹤視頻序列中的目標(biāo)。算法的關(guān)鍵在于利用核技巧將線性相關(guān)濾波推廣到非線性空間,使圖像特征可以映射到高維空間[10]。這樣可以利用核方法提取目標(biāo)的更多非線性特征,提高跟蹤魯棒性,通過在核空間中學(xué)習(xí)訓(xùn)練相關(guān)濾波器,使所得相關(guān)濾波器可以對新樣本進行分類,具體算法流程如圖2所示。

1.2.2? 傳統(tǒng)KCF算法在檢測中的問題

經(jīng)過預(yù)實驗,發(fā)現(xiàn)直接應(yīng)用KCF算法進行織物折皺頂角的跟蹤主要存在以下兩個問題:

算法使用單一HOG特征[16],對織物折皺頂角外觀變形、光照變化等情況缺乏魯棒性,容易導(dǎo)致跟蹤目標(biāo)丟失;跟蹤框邊界效應(yīng)明顯,在目標(biāo)出現(xiàn)形變時無法有效捕捉邊界信息,降低了跟蹤精度,為后續(xù)頂角角度計算處理帶來過多干擾。

1.3? 改進KCF算法

為解決這兩個問題,本文在傳統(tǒng)KCF算法的基礎(chǔ)上在特征表達(dá)和目標(biāo)區(qū)域調(diào)整兩個方面進行優(yōu)化。在特征表達(dá)方面,采用了多特征融合的策略,同時結(jié)合HOG特征和SIFT特征來表達(dá)折皺頂角的紋理與輪廓信息,以提高檢測魯棒性。在目標(biāo)區(qū)域調(diào)整方面,提出了一種基于邊緣檢測的自適應(yīng)邊界調(diào)整方法,根據(jù)檢測到的邊緣位置與方向信息,自適應(yīng)調(diào)整跟蹤框的大小與位置,以減小邊界效應(yīng),提高定位精度。

1.3.1? 多特征融合

為增強對織物折皺頂角的檢測魯棒性,本文采用了多特征融合的策略。具體來說,同時結(jié)合HOG特征和SIFT特征[17]來表達(dá)折皺頂角的紋理與輪廓信息。其中,HOG特征通過統(tǒng)計目標(biāo)局部方向梯度直方圖來描述形狀;SIFT特征通過檢測關(guān)鍵點與計算描述子來表示局部紋理。為降低特征維數(shù),本文首先利用主成分分析(PCA)算法對HOG和SIFT特征進行降維處理,然后將經(jīng)降維的兩種特征拼接起來進行核相關(guān)跟蹤,這樣既提高了特征表達(dá)能力,又減少了計算量。假設(shè)原始的特征向量為x∈Rd(x屬于d維實數(shù)空間),PCA的目標(biāo)是找到一個變換矩陣W∈Rd×k,其中k是降維后的維度,使得投影后的特征向量y=WTx∈Rk最大化方差。具體來說,PCA可以通過以下步驟實現(xiàn):

1)對所有的特征向量進行中心化,即將每個特征向量減去均值,得到:

X=xHOGxSIFT(1)

式中:xHOG∈RdHOG表示HOG特征向量,xSIFT∈RdSIFT表示SIFT特征向量。

通過在這兩個向量上進行垂直拼接,得到了長為dHOG+dSIFT的列向量X,它將這兩個特征向量中的信息一起編碼成了一個單一的向量。假設(shè)通過PCA將這兩種特征向量降至k維,得到降維后的特征向量為:

yHOG=WTHOGxHOG∈Rk(2)

ySIFT=WTSIFTxSIFT∈Rk(3)

式中:yHOG和ySIFT分別是HOG特征和SIFT特征的降維矩陣。

2)計算協(xié)方差矩陣:

Cy=1n∑ni=1yiyTi(4)

式中:n是樣本數(shù),yi是第i個樣本的降維后的特征向量。

3)對協(xié)方差矩陣進行特征值分解,得到特征值和特征向量:

Cy=UΛUT(5)

式中:Λ=diag (λ λ …,λk)是特征值矩陣,U=[u u …,uk]是特征向量矩陣,且滿足UTU=I。

4)選擇前m個特征向量,組成降維矩陣:

U(:,1:m)(6)

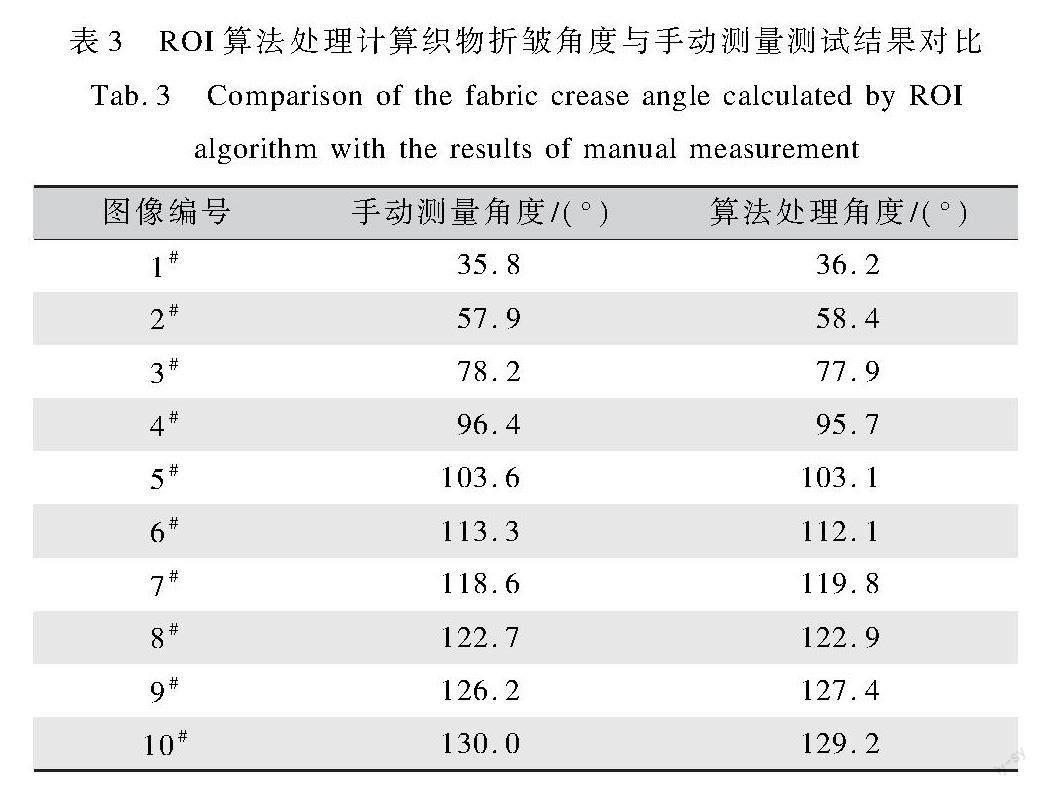

式中:m 5)將HOG特征和SIFT特征的降維矩陣分別乘以降維矩陣V,得到融合后的特征向量: yfusion=[yHOG,ySIFT]V∈R2k×m(7) 式中:[,]表示特征向量的拼接操作,yfusion是融合后的特征向量,維度為2k×m。 通過將HOG特征和SIFT特征進行PCA降維,并將降維后的特征向量融合,可以得到更加緊湊且表達(dá)能力更強的特征向量,從而提高圖像識別的準(zhǔn)確度。 1.3.2? 基于邊緣檢測的自適應(yīng)邊界調(diào)整 為減小邊界效應(yīng)對跟蹤精度的影響,本文提出了一種基于邊緣檢測的自適應(yīng)邊界調(diào)整方法。具體來說,利用Canny邊緣檢測算法檢測折皺頂角的邊緣輪廓,根據(jù)檢測到的邊緣位置與方向信息,自適應(yīng)調(diào)整跟蹤框的大小與位置,使其能夠準(zhǔn)確鎖定目標(biāo)邊界。這樣可以有效減小邊界效應(yīng),提高跟蹤精度。該方法包括以下幾個步驟: 1)初始化目標(biāo)跟蹤框:在第一幀圖像中,使用KCF算法初始化目標(biāo)跟蹤框,得到目標(biāo)區(qū)域的中心位置(xc,yc)、寬度w和高度h。 2)檢測目標(biāo)邊緣:在每一幀圖像中,使用Canny邊緣檢測算法來檢測目標(biāo)的邊緣,得到邊緣的位置和方向(xe,ye)和θc。 3)計算目標(biāo)區(qū)域的調(diào)整量:根據(jù)邊緣的位置和方向,計算目標(biāo)區(qū)域的調(diào)整量dw、dh、dx、dy,其中dw、dh表示目標(biāo)區(qū)域的寬度和高度的調(diào)整量,可以根據(jù)邊緣的寬度和高度以一定的比例進行計算;dx、dy表示目標(biāo)區(qū)域中心位置的調(diào)整量,可以根據(jù)邊緣方向的余弦和正弦值以一定的比例進行計算。 4)調(diào)整目標(biāo)區(qū)域的大小和位置:根據(jù)目標(biāo)區(qū)域的當(dāng)前大小和位置,以及計算得到的調(diào)整量,自適應(yīng)地調(diào)整目標(biāo)區(qū)域的大小和位置。具體來說,可以使用下式進行計算: w′=w+α·dw h′=h+α·dh x′c=xc+α·dx y′c=yc+α·dy(8) 式中:α是調(diào)整步長,用于控制目標(biāo)區(qū)域大小和位置的調(diào)整速度。 通過調(diào)整目標(biāo)區(qū)域的大小和位置,可以減少邊界效應(yīng)的影響,提高目標(biāo)跟蹤的準(zhǔn)確性。 5)更新目標(biāo)跟蹤器:使用新的目標(biāo)區(qū)域大小和位置,更新KCF算法的目標(biāo)跟蹤器,繼續(xù)跟蹤目標(biāo)。 1.4? ROI圖像處理 為了獲得織物折皺頂角角度信息,需要對經(jīng)過KCF算法處理后獲取的一系列ROI圖像進行進一步處理,來提取折皺角度特征參數(shù)。首先進行圖像二值化,使用Otsu方法[18]根據(jù)圖像直方圖確定一個全局閾值,對圖像進行閾值分割,將圖像中的像素分類為前景和背景兩個部分以濾除背景噪聲,突出折皺的輪廓特征。然后對二值化圖像進行骨架化處理,使用Zhang-Suen算法[19]迭代腐蝕圖像而保留拓?fù)浣Y(jié)構(gòu),得到折皺區(qū)域的細(xì)化代表,以便突出折皺的拓?fù)湫螤睿軌蛟诒P藿嵌刃畔⒌耐瑫r大大降低后續(xù)處理的復(fù)雜度。之后在骨架圖像上使用最小二乘法擬合直線,并計算兩條直線的夾角。本文采用簡單高效的最小二乘法來進行幾何特征擬合,既能提取出折皺頂點的角度信息,又避免了較為復(fù)雜的模型擬合。最后利用反正切函數(shù)求出兩直線的夾角值,即為折皺頂點的角度。ROI圖像通過上述處理可以從原始圖像中有效提取出折皺回復(fù)研究所需的角度信息。 2? 實? 驗 2.1? 裝置及操作方法 為實現(xiàn)對織物折皺回復(fù)全過程進行檢測,本文自主設(shè)計并搭建了織物折皺回復(fù)測試裝置,如圖3所示。該裝置主要由樣品臺、升高裝置、加載裝置、高速攝像機等組成。樣品臺采用光滑不銹鋼材質(zhì),可以調(diào)節(jié)傾斜角度;升高裝置和加壓裝置分別用于抬高和加壓樣品;高速攝像機最大幀率為960 fps,采集圖像分辨率為1 280×1 024像素。測試過程使用氣壓傳動作為動力系統(tǒng)。 本文選擇了6種不同規(guī)格的面料作為試樣,以全面評估所提出方法的魯棒性和泛化能力。這些面料樣本覆蓋了不同的纖維類型、織物結(jié)構(gòu)、厚度和密度,試樣具體規(guī)格參數(shù)如表1所示。具體而言,選擇的面料包括純棉、滌綸、滌棉和亞麻等不同纖維類型,代表了常見服裝面料的主要組成材質(zhì)。此外,還選擇了平紋、斜紋和方格等不同的基本織物結(jié)構(gòu),以檢驗織物組織對方法適用性的影響。不同規(guī)格的紗線和不同的織物密度也在選樣范圍內(nèi),以代表厚度和密度不同的織物材質(zhì)。通過在這些具有差異性的參數(shù)的面料上進行測試,可以全面驗證所提出方法的適用范圍,以證明該方法的廣泛適用性,不受具體面料參數(shù)的限制。實驗操作前,對每種面料剪取10片大小為26 cm×15 cm的樣品,所有樣品在標(biāo)準(zhǔn)狀態(tài)(溫度20 ℃±2 ℃,相對濕度65%±5%)條件下放置24 h后進行測試。 通過預(yù)實驗,本文發(fā)現(xiàn)將織物折皺回復(fù)檢測裝置參數(shù)設(shè)置為試樣臺傾斜30°,升高裝置抬起升高15 cm,加壓壓力60 N,加壓時間設(shè)定為60 s時,采集所選規(guī)格織物試樣折皺回復(fù)過程圖像更為理想。 使用織物折皺回復(fù)檢測裝置具體方法為:將試樣固定在試樣臺上,其中試樣23處與儀器升高裝置線對齊。打開氣閥開關(guān),調(diào)整氣壓數(shù)值使氣壓表壓力達(dá)到60 N;打開升高裝置,將織物試樣升起到指定高度之后,打開加壓裝置開關(guān),使兩端力臂對織物試樣進行加壓處理使其產(chǎn)生折皺。加載結(jié)束后,同時關(guān)閉升高裝置和加載裝置,使樣品自由下落并開始折皺回復(fù)過程,高幀率攝像機記錄織物下落過程中頂角折皺回復(fù)形變過程。在對織物進行加壓折皺處理后,對折皺回復(fù)過程進行記錄,使用改進KCF算法追蹤并截取感興趣區(qū)域內(nèi)圖像。在全過程中,高速攝像機以240 fps的速度對樣品圖像動態(tài)進行采集,隨后每隔10幀從采集的圖像序列中選取一幀進行算法處理。對每種面料隨機選擇5片樣品進行測試。 2.2? 基于改進KCF算法的折皺回復(fù)過程分析 利用改進的KCF算法處理高速攝像機采集的折皺回復(fù)圖像序列,實現(xiàn)對面料折皺區(qū)的準(zhǔn)確跟蹤。首先選擇面料折皺區(qū)頂點作為目標(biāo)區(qū)域進行初始化,然后應(yīng)用改進的KCF算法自動跟蹤折皺頂點在復(fù)原過程中的運動軌跡。為增強跟蹤魯棒性,算法融合使用HOG和SIFT特征,并輔以Canny邊緣檢測調(diào)整目標(biāo)區(qū)域。 為了驗證改進KCF算法在研究中的必要性和有效性,本文使用改進KCF算法和傳統(tǒng)KCF算法對相同織物折皺頂角圖像序列進行測試,測試過程中部分圖像如圖4所示。其中紅色虛線部分為傳統(tǒng)KCF算法跟蹤框,綠色部分為改進后的KCF算法跟蹤框。由圖4可以看出,相較于改進后的KCF算法,傳統(tǒng)KCF算法在面對較大形變時,會出現(xiàn)跟蹤丟失的情況。 對跟蹤ROI部分進行截圖(圖5(a)),提取折皺頂點對應(yīng)的圖像區(qū)域。截取ROI圖像的目的是精確定位感興趣的折皺頂點區(qū)域,便于進行后續(xù)定量分析,并將ROI圖像轉(zhuǎn)化為二值化圖像(圖5(b))。進行二值化處理是為了濾除背景及不相關(guān)區(qū)域,突出折皺頂點的輪廓特征,簡化形狀表達(dá)。使用骨架提取算法處理二值圖像可以得到折皺區(qū)域的細(xì)化(圖5(c))。骨架提取通過細(xì)化可以有效保留目標(biāo)區(qū)域的拓?fù)浣Y(jié)構(gòu),本文采用Zhang-Suen算法進行骨架提取。該算法計算開銷較低,易于實現(xiàn),能夠有效細(xì)化折皺頂點區(qū)域,突出其角度特征。對細(xì)化后骨架圖像使用直線擬合函數(shù)進行擬合計算,并使用反正切函數(shù)求出兩直線夾角角度,即折皺頂點角度。通過對骨架使用簡單的幾何特征擬合,可以提取折皺頂點角度這一定量參數(shù),便于進行動態(tài)跟蹤分析。對每幀圖像重復(fù)該過程,獲得不同面料樣品折皺頂點角度變化規(guī)律,并進行對比分析。 3? 結(jié)果與分析 3.1? 改進KCF算法有效性驗證 為了驗證算法準(zhǔn)確性和有效性,本文將基于多特征融合和自適應(yīng)邊界調(diào)整的改進KCF算法與傳統(tǒng)KCF算法在VOT-2016(Visual Object Tracking, 2016)數(shù)據(jù)集上進行對比測試。VOT-2016數(shù)據(jù)集是一個用于視覺目標(biāo)跟蹤算法評估的公開數(shù)據(jù)集,并且提供了一套評估指標(biāo),用于定量地評估算法的性能,包括準(zhǔn)確性、魯棒性和速度等方面。實驗操作系統(tǒng)環(huán)境為:64位專業(yè)版Windows 11操作系統(tǒng),Python 3.9. AMD5800H,NVIDIA RTX3080Ti,16 G內(nèi)存;本文選取ROC曲線(Receiver Operating Characteristic Curve)下的面積AUC(Area Under Curve)、追蹤成功率SR(Success Rate)及每秒處理幀率FPS作為對比參考指標(biāo),其中各指標(biāo)定義及計算方法如下: 1)AUC指標(biāo):AUC指Area Under Curve,代表ROC(Receiver Operating Characteristic)曲線下的面積值。它通過在不同閾值下計算真正率和假正率,即在二分類問題中,被正確地預(yù)測為正例的樣本數(shù)量與實際正例樣本數(shù)量之間的比例和被錯誤地預(yù)測為正例的負(fù)例樣本數(shù)量與實際負(fù)例樣本數(shù)量之間的比例,進而繪制ROC曲線。曲線下面積值越大,表示分類性能越好。其計算方法是將ROC曲線下的面積數(shù)值化到0~1。 在本文中,AUC指標(biāo)反映了改進KCF算法在不同判定閾值下的檢測精度,值越大表示檢測準(zhǔn)確率越高。 2)SR指標(biāo):SR表示Success Rate,代表跟蹤成功率。它是跟蹤過程中成功跟蹤幀數(shù)占總幀數(shù)的比例,計算方法為: SR=NsuccessNtotal(9) 式中:Nsuccess和Ntotal分別代表成功追蹤到目標(biāo)的幀數(shù)和總幀數(shù)。 SR指標(biāo)反映了目標(biāo)跟蹤的穩(wěn)定性,SR值越大表示改進算法跟蹤更加穩(wěn)定可靠。 3)FPS指標(biāo):FPS代表每秒處理幀數(shù)(Frame Per Second),計算方法為: FPS=NframesTtotal(10) FPS指標(biāo)反映了算法的處理效率。本文中,F(xiàn)PS值越大表示改進算法在保證精度的前提下,處理幀數(shù)越多,實時性越好。 傳統(tǒng)KCF與本文改進KCF在VOT-2016數(shù)據(jù)集測試結(jié)果對比如表2所示。 由表2的數(shù)據(jù)可以看出,在VOT-2016數(shù)據(jù)集上的測試中,相比原始的KCF算法,加入HSP(HOG+SIFT+PCA)模塊和ABT(Adaptive Boundary Tuning)模塊的KCF+HSP+ABT算法效果最好,AUC指標(biāo)反映檢測準(zhǔn)確率,本文改進算法KCF+HSP+ABT的AUC值為0.785,較原始KCF算法的0.463顯著提高了69.5%。這表示融合多特征和自適應(yīng)調(diào)整技術(shù)大大提高了檢測精度,使得算法在織物折皺頂角跟蹤過程中對目標(biāo)的提取和定位更準(zhǔn)確,有效降低因傳統(tǒng)算法邊際效應(yīng)帶來的織物折皺頂角部分圖像跟蹤丟失的比率。SR指標(biāo)反映跟蹤穩(wěn)定性,本文改進算法的SR為0.68 較KCF的0.396提高了72.2%。這意味著改進算法明顯增強了對織物折皺頂點的跟蹤魯棒性,說明HSP和ABT模塊對提升KCF算法的魯棒性與準(zhǔn)確率有積極作用,也證明在整個目標(biāo)跟蹤過程中,改進后的KCF算法更加穩(wěn)定可靠,對于織物折皺動態(tài)回復(fù)過程的提取更加完整。另外,對于追蹤織物頂角任務(wù),改進算法的FPS下降在可接受范圍內(nèi),考慮到性能指標(biāo)的大幅度提升,該計算代價可接受。 3.2? ROI處理算法有效性驗證 為保證算法的速度和精確度,本文對上述ROI圖像處理過程進行實驗。在速度測試部分,測試環(huán)境與系統(tǒng)環(huán)境保持一致,在該環(huán)境下算法處理一幀ROI圖像的平均速度為20 ms,考慮到每秒需處理24幀圖像,該算法滿足測試速度需求;在算法準(zhǔn)確性測試部分,本文對1#織物試樣進行實驗處理,將1#織物試樣折皺回復(fù)過程每隔1.5 s記錄一次,選取其中連續(xù)記錄的10幀頂角圖像分別使用算法測量和人工手動測量進行對比測試,測試結(jié)果如表3所示。計算其平均誤差為0.70°,測試結(jié)果表明對ROI圖像的處理算法可以滿足實際檢測需要。 同時表3數(shù)據(jù)也可以看出,織物試樣在開始階段折皺回復(fù)形變速度較快,后續(xù)逐漸減緩,逐漸趨于穩(wěn)定的回復(fù)過程。這反映出1# 織物試樣折皺回復(fù)的動態(tài)演變過程,不同階段的折皺形態(tài)也可以通過頂角角度數(shù)據(jù)量化反映。 3.3? 測試方法與標(biāo)準(zhǔn)方法測試結(jié)果對比 為驗證該方法有效性,本文選取該方法下不同織物在回復(fù)穩(wěn)定狀態(tài)下同一時刻的頂角角度與標(biāo)準(zhǔn)織物折皺回復(fù)角檢測法測得結(jié)果進行對比。按照AATCC 66—2017《機織物折皺回復(fù):回復(fù)角法》標(biāo)準(zhǔn)檢測要求對所選織物試樣折皺回復(fù)性進行檢測,檢測結(jié)果與本文方法所得結(jié)果對比如表4所示。 經(jīng)過相關(guān)性檢驗,兩者的皮爾遜相關(guān)系數(shù)為0.857 (大于0.500),顯著性水平為0.000 4(小于0.01),說明兩種方法所得測試結(jié)果之間存在較強正相關(guān),呈現(xiàn)高度的線性相關(guān)關(guān)系。經(jīng)過計算,兩種方法所得結(jié)果相關(guān)系數(shù)R2為0.73 R2較高說明本文方法所得結(jié)果可以與標(biāo)準(zhǔn)折皺角檢測方法結(jié)果很好擬合。使用線性回歸計算出二者存在一元線性模型: Y=0.549×X+34.754(11) 式中:X為ROI區(qū)域織物頂角角度,Y為標(biāo)準(zhǔn)方法測量的織物折皺回復(fù)角平均值。 該結(jié)果驗證了基于改進KCF算法的動態(tài)折皺回復(fù)檢測方法能夠有效反映面料折皺回復(fù)性,測試結(jié)果與標(biāo)準(zhǔn)方法具有可比性,可以作為一種新的折皺回復(fù)性能評價手段。 4? 結(jié)? 論 本文提出了一種基于改進KCF算法的動態(tài)織物折皺回復(fù)檢測方法。對傳統(tǒng)KCF算法在織物折皺回復(fù)檢測任務(wù)中的問題,提出了兩種優(yōu)化策略。第一是采用多特征融合的方法,綜合運用HOG、SIFT等特征表達(dá),增強了算法對織物紋理的適應(yīng)性,提高了檢測魯棒性。第二是基于Canny邊緣檢測結(jié)果進行自適應(yīng)目標(biāo)區(qū)域調(diào)整,有效減小了邊界效應(yīng),提高了定位精度。兩種策略相互協(xié)同,形成了一種改進的KCF算法。實驗結(jié)果表明,該改進算法相比原KCF方法,在處理織物折皺動態(tài)回復(fù)圖像序列時性能提升顯著,其中AUC指標(biāo)達(dá)到0.78 相較于原KCF算法提高了69.5%;SR指標(biāo)達(dá)到0.68 相較于原KCF算法提高了72.2%,這驗證了所提出的兩種優(yōu)化策略的有效性。本文整套測試方法流程實現(xiàn)了對整個折皺回復(fù)過程的自動監(jiān)測與分析,基于該改進算法,實現(xiàn)了對不同織物折皺回復(fù)過程的自動化監(jiān)測和參數(shù)化分析,方法檢測結(jié)果與標(biāo)準(zhǔn)測試結(jié)果具有很好的一致性(R2=0.736)。相比傳統(tǒng)折皺回復(fù)角測試法,該方法實現(xiàn)了對折皺回復(fù)動態(tài)過程的精確捕捉,測量結(jié)果平均誤差控制在0.70°,大幅提高了檢測效率與結(jié)果可重復(fù)性,該方法無需人工參與,檢測周期短,提供了一種更為高效準(zhǔn)確的織物折皺回復(fù)性能評估新思路。后續(xù)工作將進一步增強算法魯棒性,并擴展應(yīng)用到包括服裝面料在內(nèi)的更多織物折皺回復(fù)檢測。 參考文獻: [1]韓茹. 影響棉織物折皺回復(fù)性因素的探討[J]. 輕工科技, 2015, 31(10): 92-93. HAN R. Discussion on factors affecting the wrinkle recovery of cotton fabrics[J]. Light Industry Science and Technology, 2015, 31(10): 92-93. [2]魏艷紅, 劉新金, 李文靜, 等. 幾種不同組織結(jié)構(gòu)的襯衫面料保形性研究[J]. 絲綢, 2020, 57(1): 20-25. WEI Y H, LIU X J, LI W J, et al. Study on shape preservation of shirt fabrics with several different weave structures[J]. Journal of Silk, 2020, 57(1): 20-25. [3]張小琪. 形狀記憶紡織品和遮熱紡織品檢測方法的研究[D]. 上海: 東華大學(xué), 2018. ZHANG X Q. Testing Methods for Shape Memory Fabric and Thermal Shielding Fabric[D]. Shanghai: Donghua University, 2018. [4]蔣雙歌, 王蕾, 王靜, 等. 織物折皺回復(fù)的各向異性表征[J]. 紡織學(xué)報, 2016, 37(6): 42-47. JIANG S G, WANG L, WANG J, et al. Characterization on anisotropy of fabric wrinkle recovery[J]. Journal of Textile Research, 2016, 37(6): 42-47. [5]楊書會. 基于織物結(jié)構(gòu)與力學(xué)參數(shù)的純棉織物抗皺性能研究[D]. 天津: 天津工業(yè)大學(xué), 2017. YANG S H. Research on Wrinkle Resistance of Cotton Fabrics Based on Fabric Structure and Mechanical Parameters[D]. Tianjin: Tiangong University, 2017. [6]劉婷, 劉成霞. 織物多向抗皺性分析研究[J]. 毛紡科技, 2015, 43(12): 47-51. LIU T, LIU C X. Wrinkle resistance test research and analysis of fabric in multi-angle[J]. Wool Textile Journal, 2015, 43(12): 47-51. [7]唐千惠, 王蕾, 高衛(wèi)東. 基于圖像處理的織物保形性檢測[J]. 紡織學(xué)報, 2021, 42(3): 89-94. TANG Q H, WANG L, GAO W D. Detection of fabric shape retention based on image processing[J]. Journal of Textile Research, 2021, 42(3): 89-94. [8]姚金波, 王志意, 董敏, 等. 溫濕環(huán)境下棉織物的抗皺性能變化規(guī)律及其預(yù)測模型[J]. 天津工業(yè)大學(xué)學(xué)報,202 39(5):43-49. YAO J B, WANG Z Y, DONG M, et al. Change and prediction model of crease resistance of cotton fabric under warm and humid environment[J]. Journal of Tiangong University, 2020, 39(5): 43-49. [9]唐千惠, 王蕾, 傅佳佳, 等. 織物保形性檢測系統(tǒng)開發(fā)初探[J]. 棉紡織技術(shù), 2020, 48(5): 31-34. TANG Q H, WANG L, FU J J, et al. Primary investigation of fabric conformality detection system[J]. Cotton Textile Technology, 2020, 48(5): 31-34. [10]HENRIQUES J F, CASEIRO R, MARTINS P, et al. Exploiting the circulant structure of tracking-by-detection with kernels[C]. Providence, RI, USA: IEEE Conference on Computer Vision and Pattern Recognition, 2012. [11]張薇, 康寶生. 相關(guān)濾波目標(biāo)跟蹤進展綜述[J]. 中國圖象圖形學(xué)報, 2017, 22(8): 1017-1033. ZHANG W, KANG B S. Recent advances in correlation filter-based object track[J]. Journal of Image and Graphics, 2017, 22(8): 1017-1033. [12]BOLME D S, BEVERIDGE J R, DRAPER B A, et al. Visual object tracking using adaptive correlation filters[C]The 23th IEEE Conference on Computer Vision and Pattern Recognition. San Francisco, USA: IEEE, 2010. [13]BERTINETTO L, VALMADRE J, GOLODETZ S, et al. Staple: Complementary Learners for Real-time Tracking[C]. Las Vegas: Proceedings of IEEE Conference on Computer Vision and Pattern Recognition, 2016. [14]潘長城, 劉妍妍, 鄭志強, 等. 類殘差更新策略的核相關(guān)濾波目標(biāo)跟蹤[J]. 電光與控制, 2019, 26(10): 1-6. PAN C C, LIU Y Y, ZHENG Z Q, et al. Kernel correlation filtering target tracking based on quasi-residua updating strategy[J]. Electronics Optics & Control, 2019, 26(10): 1-6. [15]孫曉鋒, 賈子彥, 張雷, 等. 基于重檢測機制的核相關(guān)濾波跟蹤算法[J]. 電光與控制, 2021, 28(8): 44-47. SUN X F, JIA Z Y, ZHANG L, et al. A kernel correlation filter tracking algorithm based on re-detection mechanism[J]. Electronics Optics & Control, 2021, 28(8): 44-47. [16]DALAL N. Histograms of oriented gradients for human detection[C]International Conference on Computer Vision & Pattern Recognition. San Diego, CA, USA: IEEE Computer Society, 2005. [17]LOWED G. Object Recognition from local scale-invariant features[C]Proceedings of the Seventh IEEE International Conference on Computer Vision. Bombay, India: IEEE, 1999. [18]OTSU N. A Threshold selection method from gray-level histograms[C]IEEE Transactions on Systems, Man, Cybernetics. Philadelphia, PA, USA: IEEE, 1979. [19]CHEN Y S, HSU W H. A modified fast parallel algorithm for thinning digital patterns[J]. Pattern Recognition Letters, 1988, 7(2): 99-106. Research on fabric wrinkle recovery detection based on an improved KCF algorithm GUO Xuyuan1, LI Zhongjian2, WANG Lei1, PAN Ruru1, GAO Weidong1 ( 1.Key Laboratory of Science & Technology of Eco-Textile, Ministry of Education, Jiangnan University, Wuxi 214122, China; 2.Key Laboratory of Clean Dyeing and Finishing Technology of Zhejiang Province, Shaoxing University, Shaoxing 312000, China) Abstract:Fabric wrinkle recovery performance is an important indicator for evaluating the shape retention of fabrics. It reflects the ability of fabrics to spontaneously recover their original shape after wrinkling during use and processing. Good wrinkle recovery performance enables fabrics to quickly recover after folding, transportation and cutting, thereby improving utility. The currently widely used standard method for evaluating fabric wrinkle recovery performance is the wrinkle recovery angle test. This involves folding and pressing fabric samples and then measuring the angle of recovery for the resulting creases to assess the fabrics wrinkle recovery capability. However, this method is complex to operate, relies on manual judgment and measurement for testing, yields results vulnerable to subjective effects, and cannot distinguish or quantify the dynamic evolution of wrinkles during different recovery stages. It can only provide an approximate overall evaluation and fails to accurately describe wrinkle recovery patterns in detail. Therefore, there is a need to develop a new testing method to achieve automated monitoring and quantified parameterization analysis of the entire wrinkle recovery process, in order to more efficiently, precisely and comprehensively evaluate the wrinkle recovery performance of different fabric materials and provide a basis for fabric performance optimization. In view of this, this study proposed a fabric wrinkle recovery detection method based on an improved kernel correlation filter algorithm to achieve automated monitoring and key parameter extraction of the entire fabric wrinkle recovery process. As for the method, a high-speed camera was used to collect and record images throughout the dynamic process of the formation and recovery of fabric wrinkles and a set of detection system was designed to process and analyze the image sequence. In the system, a robustness-enhanced improved KCF algorithm was first applied to track and locate fabric wrinkle areas. This algorithm improved adaptation to texture and shape changes by fusing multiple feature expressions and employed an edge adaptive adjustment algorithm to reduce boundary effects. Next, morphological binarization and skeleton extraction were performed on the wrinkle area of interest to preserve the topological structure while simplifying structural expression. Finally, based on the principles of analytic geometry, polyline fitting was performed on the skeletonized graphical shapes to calculate the vertex angle parameter, thereby obtaining time-series data on the variation of the wrinkle peak angle over time. The method achieved automated monitoring of the entire fabric wrinkle recovery process, avoided subjective judgment, and greatly improved detection efficiency, enabling detection and record of fabric crease recovery at different stages. By comparing the results obtained by this new method with those obtained by the standard wrinkle recovery angle test method, it is found that the two test results have strong correlation, which verifies the effectiveness of this new method and shows that this method can be used as a new technical means to evaluate the crease recovery performance of fabrics more accurately and comprehensively. This study establishes detection technology and analysis methods that lay the foundations for building an intelligent fabric wrinkle recovery evaluation platform going forwards. Future work will progress in the following areas: (i) to continue to improve algorithm robustness to address detection issues under conditions involving light, occlusion, etc.;(ii) to expand the algorithms scope of application to enable generalized detection across more fabric types; (iii) to collect and annotate large quantities of dynamic wrinkle process data to train deep neural network models for intelligent analysis of fabric wrinkle morphology to support structural design and performance enhancement of fabrics. Progress in the above areas will make testing methods more efficient and precise, promote advances in wrinkle recovery evaluation techniques, and provide new ideas to improve fabric structural design and performance. Key words: wrinkle recovery angle; feature fusion; target tracking; kernel correlation filter; improved KCF