基于多尺度YOLOv5的交通標(biāo)志檢測(cè)

朱寧可,張樹地,王翰文,李紅松,余鵬飛

(云南大學(xué) 信息學(xué)院,云南 昆明 650504)

0 引言

隨著現(xiàn)代網(wǎng)絡(luò)技術(shù)以及經(jīng)濟(jì)的發(fā)展,汽車的使用方便了大眾的生活,自動(dòng)駕駛以及智能輔助駕駛系統(tǒng)逐漸進(jìn)入商業(yè)領(lǐng)域。交通標(biāo)志的檢測(cè)對(duì)于行車安全至關(guān)重要,但是交通標(biāo)志常常會(huì)受到天氣、光照、遮擋等因素的影響,這給無人駕駛的應(yīng)用帶來了很大的安全挑戰(zhàn),因此設(shè)計(jì)出一種既實(shí)時(shí)又準(zhǔn)確的交通標(biāo)志檢測(cè)智能系統(tǒng)至關(guān)重要。

交通標(biāo)志檢測(cè)是智慧交通系統(tǒng)(Intelligent Traffic System, ITS)以及無人駕駛系統(tǒng)的基礎(chǔ)。在過去的幾十年中,目標(biāo)檢測(cè)所采用的方法較為傳統(tǒng),通過采用手工設(shè)計(jì)特征加淺層分類器來進(jìn)行目標(biāo)的獲取以及分類。例如,朱雙東等[1]通過將RGB彩色交通標(biāo)志圖片轉(zhuǎn)化到HIS顏色空間以降低光照對(duì)圖片的影響,但此過程仍具有一定的計(jì)算量。Gavrila等[2]通過方向梯度直方圖(Histogram of Oriented Gridients, HOG)進(jìn)行模板匹配的形狀檢測(cè)。湯凱等[3]提出一種顏色特征、形狀特征和尺度特征的多特征協(xié)同方法,采用支持向量機(jī)(Support Vector Machine,SVM)對(duì)融合的特征進(jìn)行分類來獲取預(yù)測(cè)結(jié)果。甘露等[4]使用Gabor濾波來提取交通標(biāo)志的紋理特征以及形狀特征,將紋理特征以及形狀特征融合輸入到BP神經(jīng)網(wǎng)絡(luò)進(jìn)行分類,有效地提升了精度。時(shí)至今日,交通標(biāo)志檢測(cè)的主流方法是通過深度學(xué)習(xí)進(jìn)行交通標(biāo)志的分類以及預(yù)測(cè)位置。由于基于候選框的深度學(xué)習(xí)目標(biāo)檢測(cè)算法精度較高,被研究人員廣泛關(guān)注,其中,兩階段目標(biāo)檢測(cè)算法代表性的是由Girshick等[5]提出的一種基于候選區(qū)域的目標(biāo)檢測(cè)算法——R-CNN(Regions with CNN features),該網(wǎng)絡(luò)通過深度卷積神經(jīng)網(wǎng)絡(luò)(Convolutional Neural Network,CNN)對(duì)目標(biāo)區(qū)域進(jìn)行分類取得不錯(cuò)的效果,但是該網(wǎng)絡(luò)過多地重復(fù)選取候選框造成大量存儲(chǔ)資源以及計(jì)算資源的浪費(fèi)。Girshick[6]提出的Fast R-CNN以及Ren等[7]提出的Faster R-CNN在R-CNN的基礎(chǔ)上進(jìn)一步將候選窗口的生成和候選窗口的分類與回歸統(tǒng)一到一個(gè)網(wǎng)絡(luò)中聯(lián)合學(xué)習(xí),大大提升了網(wǎng)絡(luò)的檢測(cè)速度。另外,一階段代表性的目標(biāo)檢測(cè)算法主要包括SSD[8]算法以及YOLO系列算法,其中SSD算法采用不同特征層來預(yù)測(cè)不同大小的物體,YOLO則是將圖像分成N×N大小的子區(qū)域,并預(yù)測(cè)每個(gè)區(qū)域是否存在目標(biāo)物體以及目標(biāo)物體的類別、概率和位置。一階段目標(biāo)檢測(cè)算法速度快,可以滿足實(shí)時(shí)檢測(cè)的要求,但是其精度不如兩階段目標(biāo)檢測(cè)算法。因此,本文選擇YOLO系列進(jìn)行改進(jìn),以提升交通標(biāo)志檢測(cè)的準(zhǔn)確率。

YOLOv5是目前比較主流的一種單級(jí)目標(biāo)檢測(cè)器,具有優(yōu)秀的性能以及檢測(cè)速度,同時(shí)還具有清晰的結(jié)構(gòu)來進(jìn)行分解和調(diào)整[9]。雖然YOLOv5是一個(gè)強(qiáng)大的目標(biāo)檢測(cè)模型,但是其本身被設(shè)置為一種通用模型,對(duì)于交通標(biāo)志這種小目標(biāo)物體檢測(cè)效果并不會(huì)過于顯著[10]。因此本文提出了一種多尺度的YOLOv5檢測(cè)模型來融合更多尺度的信息,以更好地提升檢測(cè)效果。主要貢獻(xiàn)有:

① 將YOLOv5原本的3層特征融合改進(jìn)為4層特征融合,以便于更好地保留底層信息(包括位置信息、紋理信息等);

② 為了使網(wǎng)絡(luò)更好地關(guān)注小目標(biāo),對(duì)CBAM注意力機(jī)制進(jìn)行改進(jìn),在空間注意力中引入U(xiǎn)型結(jié)構(gòu)以及殘差結(jié)構(gòu)以提升CBAM對(duì)小目標(biāo)的敏感度;

③ 將Fusion模塊嵌入到Path Aggregation Network(PANet)下采樣過程中,促進(jìn)底層信息的保留與融合;

④ 將Adaptively Spatial Feature Fusion(ASFF)模塊嵌入到3個(gè)檢測(cè)頭前,以便于獲取更加豐富的特征進(jìn)行分類以及位置預(yù)測(cè)。

1 YOLOv5模型結(jié)構(gòu)

1.1 網(wǎng)絡(luò)結(jié)構(gòu)分析

YOLOv5的結(jié)構(gòu)是在YOLOv4的基礎(chǔ)上進(jìn)行改進(jìn),其中改進(jìn)的部分主要是在主干部分使用了Focus網(wǎng)絡(luò)結(jié)構(gòu),使圖片在下采樣的過程中,在信息不丟失的情況下,將圖像的像素信息集中到通道上,再使用3×3的卷積對(duì)其進(jìn)行特征提取,使得特征提取得更加充分。另外在主干部分以及特征加強(qiáng)網(wǎng)絡(luò)中也加入了CSPlayer,以更好地提取特征。中間部分是特征加強(qiáng)網(wǎng)絡(luò),所采用的結(jié)構(gòu)是PANet[11]。最后是檢測(cè)頭部分,用于檢測(cè)不同大小的目標(biāo)物體。

1.2 YOLOv5不足之處

首先,YOLOv5是一種通用的一階段目標(biāo)檢測(cè)模型,如果直接應(yīng)用于自動(dòng)駕駛領(lǐng)域則存在對(duì)小目標(biāo)檢測(cè)能力不足的問題,尤其是在目標(biāo)存在模糊、密集以及遮擋的情況下;其次,YOLOv5中的特征增強(qiáng)模塊PANet側(cè)重于深度特征圖的融合,而忽略了底層的細(xì)節(jié)特征,削弱了對(duì)小目標(biāo)的檢測(cè)能力,對(duì)于小目標(biāo)的交通標(biāo)志來說會(huì)產(chǎn)生大量的特征冗余,造成計(jì)算資源的浪費(fèi);最后,小目標(biāo)物體在經(jīng)過多次卷積之后會(huì)存在部分細(xì)節(jié)信息和位置信息消失的問題[12]。因此本文對(duì)YOLOv5模型進(jìn)行改進(jìn),融合多尺度信息來加強(qiáng)網(wǎng)絡(luò)對(duì)交通標(biāo)志目標(biāo)的檢測(cè)能力。

2 模型改進(jìn)

根據(jù)以上存在的不足,本文分別對(duì)特征加強(qiáng)網(wǎng)絡(luò)、注意力機(jī)制進(jìn)行改進(jìn)。首先,從主干網(wǎng)絡(luò)中多引出一層改進(jìn)特征層,將引出的特征繼續(xù)與加強(qiáng)特征網(wǎng)絡(luò)融合,使得網(wǎng)絡(luò)更多地融合底層的位置信息;其次,底層的特征中也存在著較多的噪聲并且對(duì)于目標(biāo)物體的聚焦程度不足,因此在主干網(wǎng)絡(luò)輸出到特征加強(qiáng)網(wǎng)絡(luò)的特征中添加改進(jìn)的注意力機(jī)制CBAM_U,能夠有效地融合底層的語義信息并過濾掉大部分噪聲,使得網(wǎng)絡(luò)對(duì)于目標(biāo)物體更加敏感。然后在網(wǎng)絡(luò)中添加細(xì)融合Fusion模塊,促進(jìn)自身特征之間的細(xì)融合;最后在特征加強(qiáng)網(wǎng)絡(luò)后加入ASFF消除融合后特征之間的沖突。改進(jìn)的YOLOv5結(jié)構(gòu)如圖1所示。

圖1 改進(jìn)YOLOv5結(jié)構(gòu)Fig.1 Structure of improved YOLOv5

2.1 PANet改進(jìn)

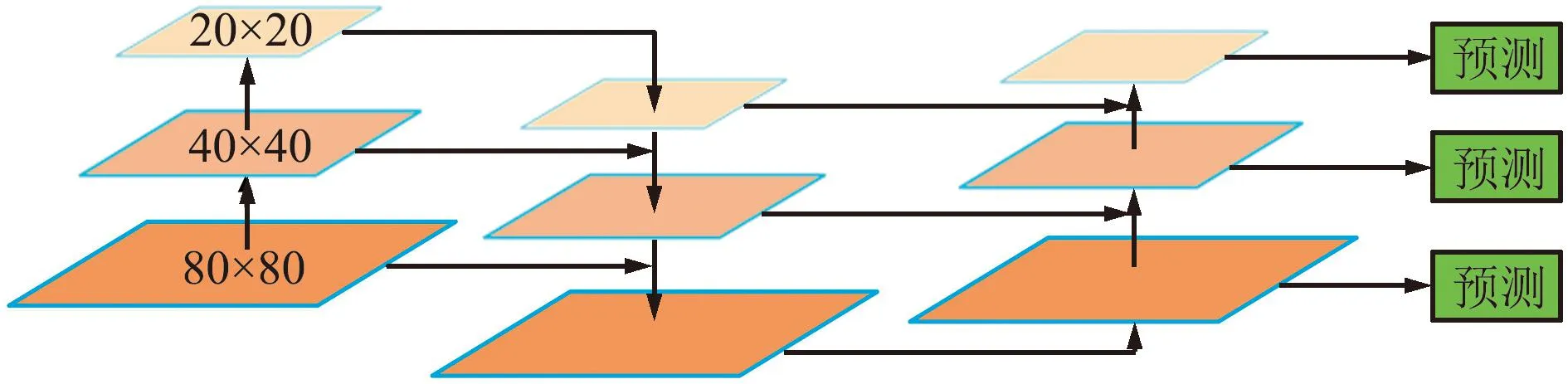

在自動(dòng)駕駛的真實(shí)場(chǎng)景圖片中,交通標(biāo)志的像素僅占很小一部分;不同的交通標(biāo)志有著尺度不一的特點(diǎn),想要更加精確地識(shí)別交通標(biāo)志,低層次的語義信息顯得格外重要。YOLOv5與YOLOv4所使用的PANet結(jié)構(gòu)相似,均是采用雙多向融合的方式,即由下向上融合以及由上向下融合。在YOLOv4的PANet結(jié)構(gòu)中,每次進(jìn)行Concat拼接之后會(huì)經(jīng)過5次卷積來調(diào)整通道數(shù),加深網(wǎng)絡(luò),以此來增強(qiáng)特征的提取能力。而YOLOv5中使用的是C3模塊,對(duì)特征進(jìn)行反復(fù)的提取,但在C3模塊中,先將特征的通道數(shù)進(jìn)行降低后再進(jìn)行卷積,所以產(chǎn)生的參數(shù)量更少。在YOLOv5的PANet中,由主干網(wǎng)絡(luò)傳入3個(gè)有效特征層,層級(jí)之間經(jīng)過尺度變換進(jìn)行融合,使得卷積網(wǎng)絡(luò)的高級(jí)特征包含對(duì)象的全局語義信息,有助于區(qū)分不同的目標(biāo)對(duì)象,具體結(jié)構(gòu)如圖2所示。

圖2 原始PANet結(jié)構(gòu)Fig.2 Structure of original PANet

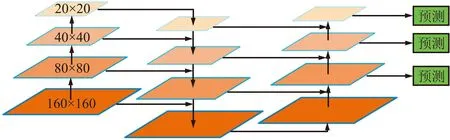

然而隨著卷積層的加深,卷積網(wǎng)絡(luò)對(duì)于目標(biāo)物體位置的變化不再敏感,導(dǎo)致高層次特征在物體的位置定位方面顯得不足[13]。在低層次的特征中存在較多的位置空間信息,為了融合全局語義信息和空間位置信息,本文提出一種改進(jìn)的PANet——PANet_M,在YOLOv5的PANet基礎(chǔ)上額外增加一層融合,將高層次語義信息與低層次特征相結(jié)合,以獲取更加豐富的信息和表達(dá)準(zhǔn)確的特征圖。

在YOLOv5中,頸部特征加強(qiáng)網(wǎng)絡(luò)共設(shè)定3個(gè)檢測(cè)尺度,分別是80×80、40×40和20×20,其中80×80的尺度用來檢測(cè)小目標(biāo),40×40與20×20的尺度分別用來檢測(cè)中目標(biāo)以及大目標(biāo),具體結(jié)構(gòu)見圖2。本文從YOLOv5的主干網(wǎng)絡(luò)中額外引出一層160×160的特征層與80×80的特征層進(jìn)行融合,加強(qiáng)低層的語義信息,使每個(gè)特征層的語義信息更加豐富。具體改進(jìn)結(jié)構(gòu)如圖3所示。

圖3 PANet_M結(jié)構(gòu)Fig.3 Structure of PANet_M

2.2 CBAM注意力機(jī)制改進(jìn)

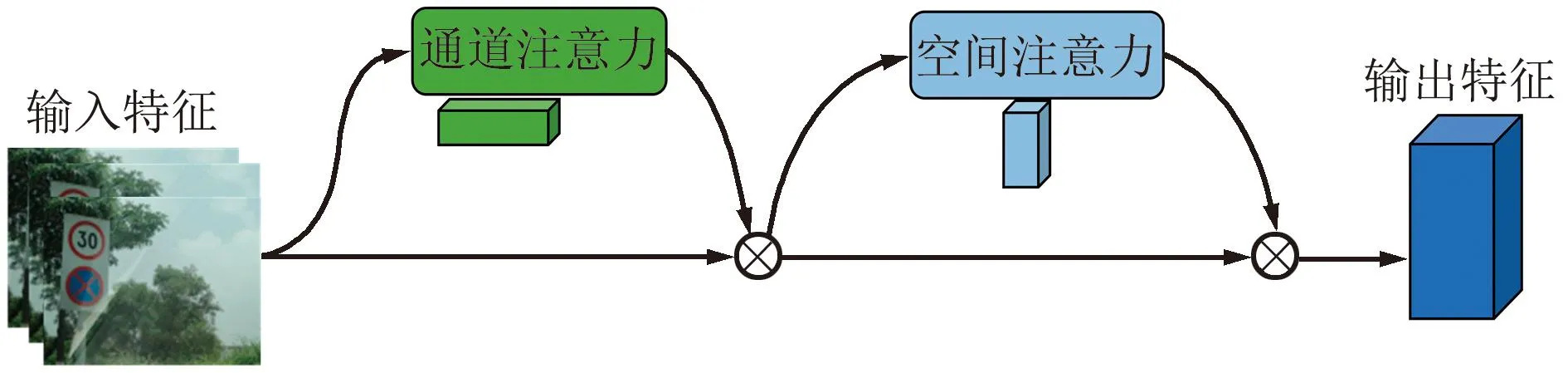

注意力機(jī)制能有效地將計(jì)算資源分配給更重要的任務(wù),同時(shí)解決信息超載問題。CBAM注意力是一種結(jié)合了空間(spatial)和通道(channel)的注意力機(jī)制模塊[14]。CBAM中通道注意力機(jī)制聚焦于“什么”是有意義的輸入圖像,使用平均池化操作對(duì)輸入特征圖的空間維度進(jìn)行壓縮,來聚合特征圖的空間信息并生成平均池化特征,與此同時(shí)使用最大池化聚焦于獨(dú)特的物體特征并生成最大池化特征,所生成的2個(gè)特征被轉(zhuǎn)發(fā)到一個(gè)共享的網(wǎng)絡(luò)來產(chǎn)生通道注意力映射,最后共享網(wǎng)絡(luò)應(yīng)用于每個(gè)描述符后使用Element-Wise求和的方式來合并輸出特征向量,通過Sigmoid函數(shù)進(jìn)行標(biāo)準(zhǔn)化得到通道特征權(quán)值。空間注意力模塊聚焦在“哪里”是最具信息量的部分,首先將通道注意力模塊產(chǎn)生的特征圖經(jīng)過最大池化與平均池化得到2個(gè)H×W×1的特征圖,其次這2個(gè)特征圖基于通道做Concat拼接操作聚合成一個(gè)特征圖的通道信息,然后將這些信息通過一個(gè)標(biāo)準(zhǔn)卷積產(chǎn)生2D空間注意力,最后通過Sigmoid進(jìn)行標(biāo)準(zhǔn)化得到最終注意力特征圖,CBAM結(jié)構(gòu)如圖4和圖5所示。

圖4 CBAM模塊Fig.4 CBAM module

圖5 通道注意力模塊與空間注意力模塊Fig.5 Channel attention module and spatial attention module

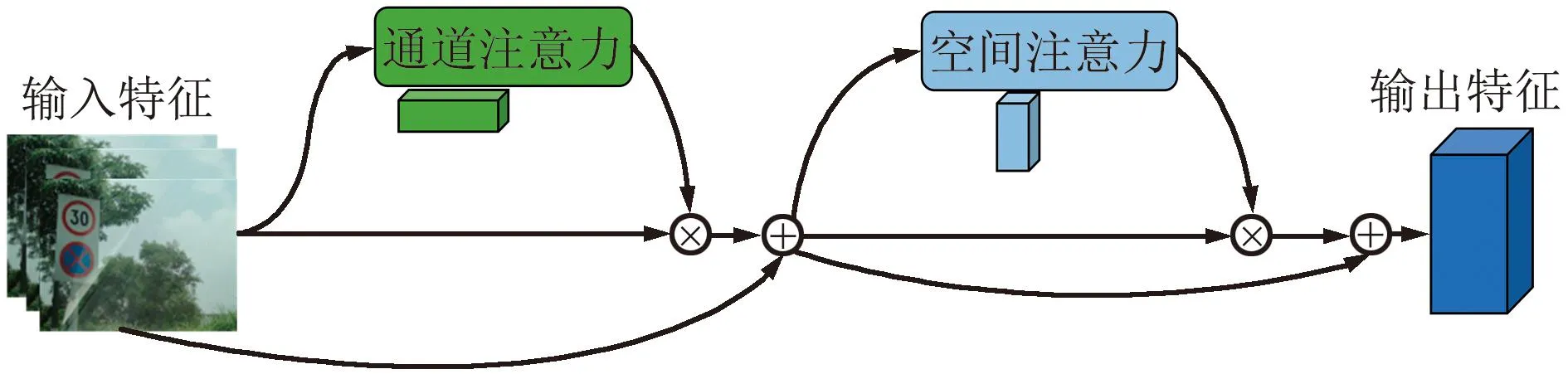

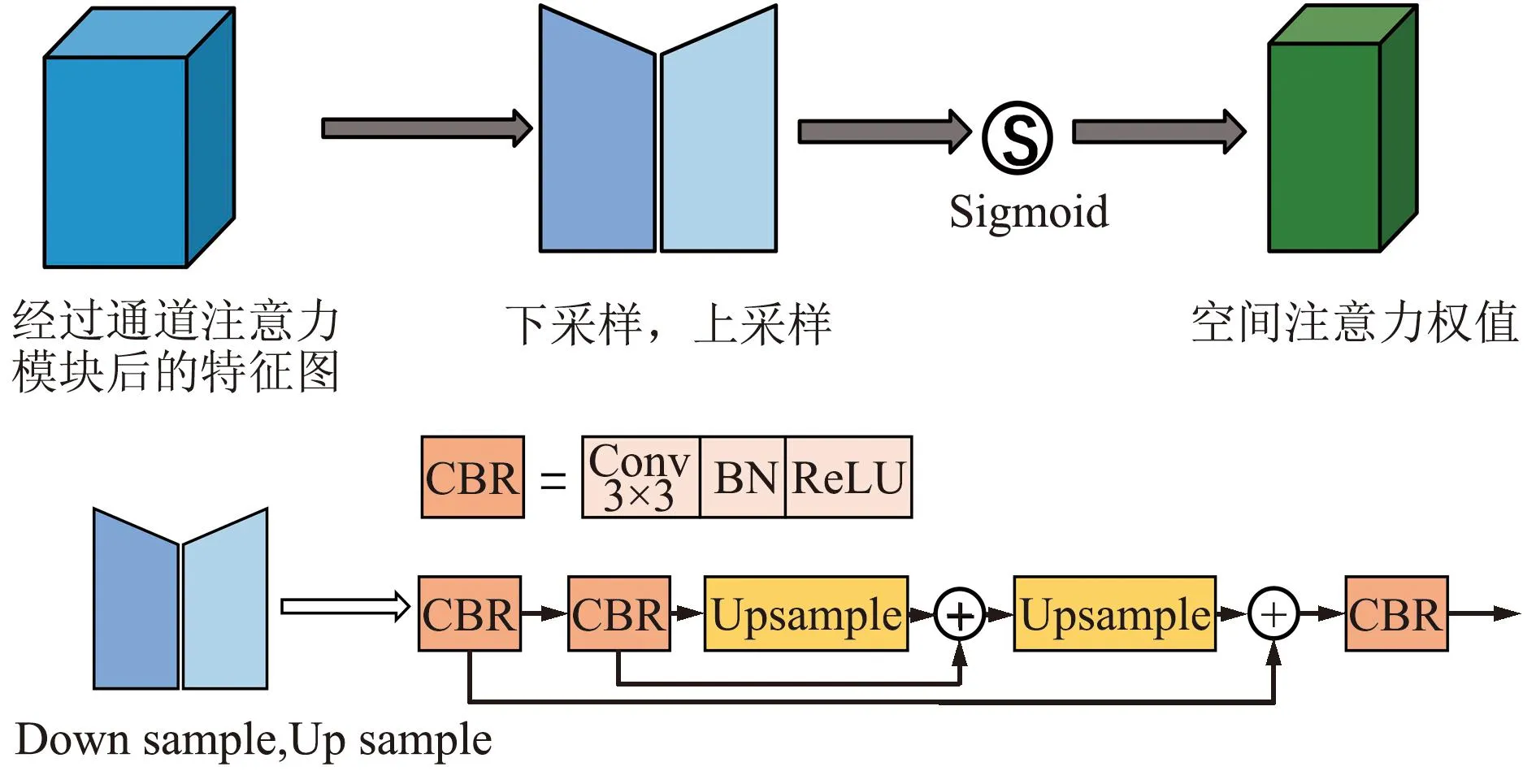

本文中使用CBAM注意力機(jī)制并對(duì)其進(jìn)行改進(jìn),使其更適應(yīng)小目標(biāo)交通標(biāo)志的特性。通過對(duì)交通真實(shí)場(chǎng)景進(jìn)行分析,可以發(fā)現(xiàn)復(fù)雜道路背景的干擾信息是交通標(biāo)志定位和識(shí)別過程的一大障礙[15]。在目標(biāo)檢測(cè)的過程中,神經(jīng)網(wǎng)絡(luò)通常會(huì)滑動(dòng)圖片的所有區(qū)域進(jìn)行特征提取,而不區(qū)分對(duì)象區(qū)域和非對(duì)象區(qū)域,因此沒有特別的模塊突出對(duì)象區(qū)域的重要性[16]。通過以上分析,本文改進(jìn)了CBAM中的空間注意力模塊——CBAM_U來解決上述問題,改進(jìn)結(jié)構(gòu)如圖6和圖7所示。

圖6 CBAM_U模塊Fig.6 CBAM_U module

圖7 改進(jìn)空間注意力模塊Fig.7 Improved spatial attention module

空間注意力機(jī)制主要模擬人眼的視覺神經(jīng),聚焦于特征圖中重要的目標(biāo)區(qū)域并過濾掉特征圖中的干擾區(qū)域。受PANet以及U-Net[17]的啟發(fā),U型結(jié)構(gòu)能夠有效突出目標(biāo)物體并且過濾掉部分干擾信息,因此本文在空間注意力模塊中引入U(xiǎn)型結(jié)構(gòu)來探索每個(gè)特征圖的空間信息,通過2次卷積快速獲取高層次語義信息。高層次特征圖中含有高級(jí)語義信息和少量空間位置信息,通過U型機(jī)制,低層次的語義信息能夠通過跳躍連接與高層次語義信息進(jìn)行融合,將底層的位置信息發(fā)送給高層。同時(shí)為了在不破壞原始特征圖的情況下使用與殘差網(wǎng)絡(luò)[18]相似的結(jié)構(gòu),將高級(jí)特征與低級(jí)特征合并,并逐元素相加融合。使用Sigmoid函數(shù)增加網(wǎng)絡(luò)的非線性,輸出特征權(quán)值。另外,在通道注意力機(jī)制中加入殘差連接確保每次聚焦特征層的有效性。

2.3 Fusion模塊

在特征加強(qiáng)網(wǎng)絡(luò)中,由于YOLOv5在特征融合中使用了多個(gè)上采樣進(jìn)行多層次的融合,即不同層級(jí)之間實(shí)現(xiàn)粗融合,使得一些關(guān)鍵性的細(xì)節(jié)信息丟失。為了解決此問題,在更細(xì)粒度的級(jí)別上合并多級(jí)特征,本文引入了一種Fusion模塊來獲取更精細(xì)的特征,具體結(jié)構(gòu)如圖8所示。本文提出的Fusion模塊借鑒了RFB[19]的Inception結(jié)構(gòu)的思想,輸入的特征通過2個(gè)不同的分支并行,其中一個(gè)分支通過一個(gè)1×1卷積獲取原始特征,相當(dāng)于保險(xiǎn)絲的作用;另一個(gè)分支增加額外的3×3卷積來增加不同的感受野,不同的2個(gè)卷積核產(chǎn)生具有不同感受野的2個(gè)特征,相當(dāng)于產(chǎn)生2個(gè)不同的尺度特征。簡(jiǎn)單地將這2個(gè)特征通過逐元素相加的方式實(shí)現(xiàn)精細(xì)的局部多尺度融合,使得自身某些細(xì)小的特征得到加強(qiáng),即實(shí)現(xiàn)下采樣特征的細(xì)融合。

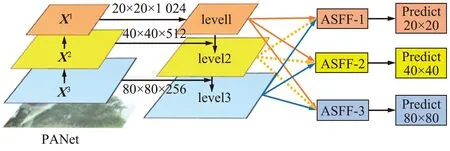

2.4 ASFF模塊

在YOLOv5的特征金字塔中,多尺度融合是解決多尺度目標(biāo)檢測(cè)的有效方法,但是不同層級(jí)之間的特征存在一定的信息沖突,即不一致性,不同特征尺度之間的不一致性是基于特征金字塔的單階段檢測(cè)器的主要限制。為了抑制這種不一致性,Wang等[20]與Zhu等[21]將相鄰級(jí)別的相應(yīng)區(qū)域設(shè)置為忽略區(qū)域,但相鄰級(jí)別的松弛往往會(huì)導(dǎo)致更差的預(yù)測(cè)為誤報(bào)。本文引入ASFF模塊[22]來抑制不同層級(jí)之間的特征的信息沖突,提高PANet的融合效果,進(jìn)而提高目標(biāo)檢測(cè)的能力,具體結(jié)構(gòu)如圖9所示。

圖9 ASFF模塊Fig.9 ASFF module

(1)

(2)

即通過不同層級(jí)之間自適應(yīng)學(xué)習(xí)各尺度特征圖融合的空間權(quán)重來解決不同層級(jí)之間存在的信息沖突。

3 實(shí)驗(yàn)與結(jié)果分析

3.1 數(shù)據(jù)處理

本文所使用的是長(zhǎng)沙理工大學(xué)制作的2021版CCTSDB中國(guó)交通標(biāo)志數(shù)據(jù)集[23],包含1.2萬張圖片以及對(duì)應(yīng)的標(biāo)注信息。本文的交通標(biāo)志主要分為3類:警告類(warning)、禁止類(prohibitory)以及指示類(mandatory)。為了提高模型的泛化能力以及魯棒性,使用了YOLOv5中的Mosaic[24]數(shù)據(jù)增強(qiáng)。

Mosaic數(shù)據(jù)增強(qiáng)簡(jiǎn)單來說就是將4張圖片通過隨機(jī)縮放、隨機(jī)裁剪和隨機(jī)排布的方式進(jìn)行拼接,該數(shù)據(jù)增強(qiáng)的方法能夠豐富檢測(cè)物體的背景以及小目標(biāo),極大地豐富了數(shù)據(jù)集,使網(wǎng)絡(luò)更具有魯棒性。

3.2 實(shí)驗(yàn)環(huán)境及評(píng)價(jià)指標(biāo)

本文采用pytorch深度學(xué)習(xí)框架,Windows 10操作系統(tǒng)以及GeForce RTX 3090顯卡進(jìn)行實(shí)驗(yàn)。使用隨機(jī)梯度下降法(SGD)來優(yōu)化調(diào)整網(wǎng)絡(luò)參數(shù),初始學(xué)習(xí)率為0.01,權(quán)重衰減系數(shù)為0.000 5,還使用了動(dòng)態(tài)調(diào)整學(xué)習(xí)率進(jìn)行訓(xùn)練,其中動(dòng)態(tài)調(diào)整學(xué)習(xí)率的方式為cos,另外還使用了混合精度以節(jié)省顯存資源。

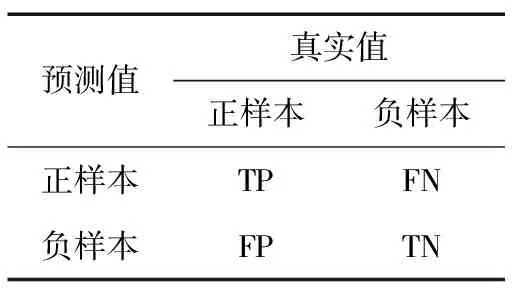

本文所采用的評(píng)價(jià)指標(biāo)為平均準(zhǔn)確率(mAP@0.5)、召回率(Recall)、查準(zhǔn)率(Precision)以及F1-Score。將測(cè)試結(jié)果劃分為四大類,分別為真正樣本(True Positive,TP)、假正樣本(False Positive,FP)、真負(fù)樣本(True Negative,TN)和假負(fù)樣本(False Negative,FN),具體方式如表1所示。

表1 混淆矩陣

Precision是指所有正樣本中檢測(cè)結(jié)果為正樣本所占的比例,能夠衡量模型的錯(cuò)檢程度,即:

(3)

Recall是指所有正樣本中正確識(shí)別的概率,能夠很好地衡量模型的漏檢程度,即:

(4)

mAP@0.5的值與AP有關(guān),AP表示當(dāng)混淆矩陣的IoU置信度取0.5時(shí),針對(duì)目標(biāo)檢測(cè)中的某一類別具有x個(gè)正樣本預(yù)測(cè)框,按照置信度進(jìn)行降序排列,每一個(gè)預(yù)測(cè)框?qū)?yīng)一個(gè)查準(zhǔn)率(Pi),將所有的查準(zhǔn)率求和取平均即可得到該類別AP的值,即:

(5)

mAP@0.5定義為檢測(cè)目標(biāo)中所有類的AP值取平均,mAP@0.5衡量一個(gè)模型對(duì)于每一類的查準(zhǔn)率隨召回率的變化,能更直觀地表現(xiàn)出分類器的性能,mAP@0.5的計(jì)算為:

(6)

F1-Score是查準(zhǔn)率與召回率的調(diào)和平均數(shù),能夠很好地評(píng)價(jià)檢測(cè)算法的優(yōu)劣。由于交通標(biāo)志識(shí)別關(guān)系到安全方面的問題,需要較高的Precision與Recall,本文將二者的權(quán)重設(shè)置為相同,具體為:

(7)

3.3 實(shí)驗(yàn)分析

3.3.1 消融實(shí)驗(yàn)與分析

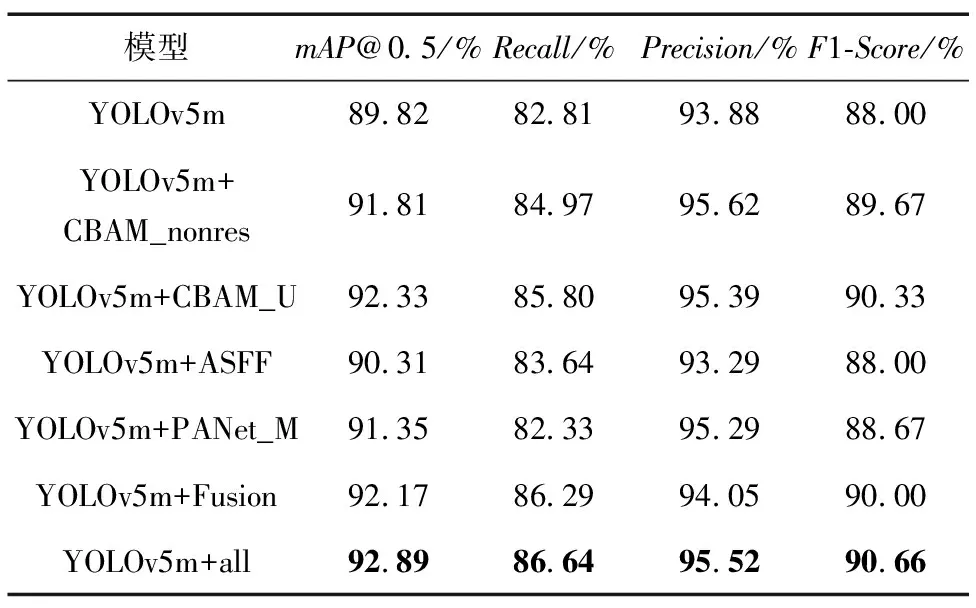

為了驗(yàn)證本文改進(jìn)模塊的效果進(jìn)行消融實(shí)驗(yàn),消融實(shí)驗(yàn)所得出的結(jié)果如表2所示。

表2 消融實(shí)驗(yàn)

由表2消融實(shí)驗(yàn)可得,在CBAM通道注意力中加入殘差連接相比于不加時(shí),在mAP@0.5上提升了0.52%,確保了每次聚焦特征的有效性,通過將不同尺度的特征層分別進(jìn)行粗融合與細(xì)融合,本文所提出的各個(gè)模塊在原始模型中都有較大的提升。另外,本文提出的改進(jìn)YOLOv5與原模型相比,mAP@0.5提升3.07%,Recall提升3.83%,做到交通標(biāo)志檢測(cè)的漏檢程度更低;通過引入改進(jìn)的注意力機(jī)制使得網(wǎng)絡(luò)能更好地聚焦于目標(biāo)物體,使得Precision提升了1.64%,準(zhǔn)確率得到較大提升;另外F1-Score提升了2.66%,做到了Recall與Precision的平衡,檢測(cè)算法更加優(yōu)秀,具有良好的應(yīng)用價(jià)值。

3.3.2 交通標(biāo)志檢測(cè)模型對(duì)比

交通標(biāo)志檢測(cè)模型對(duì)比如表3所示。可以看出,本文改進(jìn)的YOLOv5模型相比于SSD、FCOS、YOLOv4和Centernet檢測(cè)模型,mAP@0.5分別提升了4.92%、6.17%、2.59%和1.55%,另外F1-Score分別提高了22.99%、9.33%、2.66%和0.53%。相比于較新的目標(biāo)檢測(cè)模型YOLOv5-6.0、文獻(xiàn)[25-26],mAP@0.5分別高出0.7%、8.54%和0.42%,Recall與Precision也都有部分提升,由于模型參數(shù)量增加,所以在檢測(cè)速度方面存在少許下降,但仍能滿足實(shí)時(shí)性的要求。可見通過將多尺度的不同信息進(jìn)行融合能夠使網(wǎng)絡(luò)捕捉到更多的細(xì)節(jié)信息,提升不同尺寸檢測(cè)下的精度,改進(jìn)的YOLOv5模型相比于這些模型更能滿足在真實(shí)駕駛場(chǎng)景中高準(zhǔn)確率的需求。

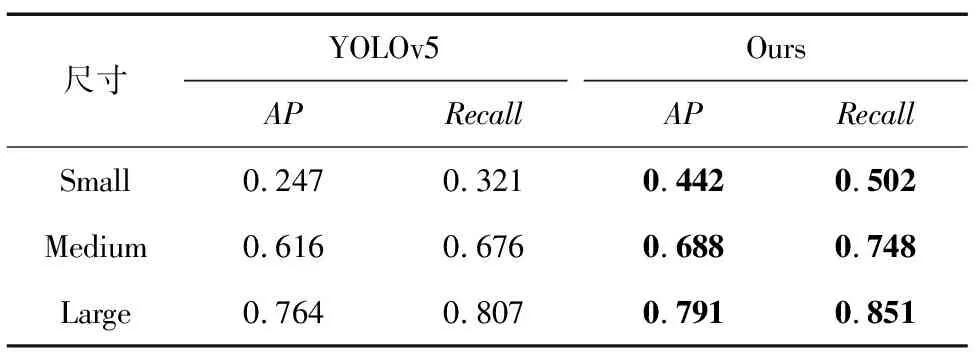

不同尺寸指標(biāo)對(duì)比如表4所示。可以看出,在不同尺寸的檢測(cè)中,本文的算法相比于原始網(wǎng)絡(luò)在APs、APm以及APl中分別提升19.5%、7.2%以及2.7%,另外Recall分別提升18.1%、7.2%以及4.4%,做到了Precision以及Recall的同時(shí)提升,基本解決了小目標(biāo)檢測(cè)難、漏檢率高的問題。

表4 不同尺寸指標(biāo)對(duì)比

3.3.3 圖片檢測(cè)結(jié)果與分析

隨機(jī)抽取網(wǎng)絡(luò)搜集的不同目標(biāo)尺寸的交通標(biāo)志圖片進(jìn)行可視化比較,如圖10所示,從左到右依次是YOLOv5檢測(cè)結(jié)果以及改進(jìn)YOLOv5檢測(cè)結(jié)果,將目標(biāo)物體分為小、中、大3種不同的尺寸進(jìn)行檢測(cè)。從圖10可以看出,在小目標(biāo)檢測(cè)中,原始YOLOv5檢測(cè)算法存在漏檢的情況,而本文改進(jìn)的算法對(duì)于小目標(biāo)較為敏感。在中目標(biāo)檢測(cè)中,原始YOLOv5算法存在誤檢的情況,將背景物體檢測(cè)為交通標(biāo)志,這對(duì)無人駕駛領(lǐng)域是不安全的。在大目標(biāo)檢測(cè)中,本文的檢測(cè)算法精度更高。綜上,改進(jìn)的YOLOv5算法在交通標(biāo)志檢測(cè)中具有更好的性能。

圖10 CCTSDB檢測(cè)結(jié)果可視化Fig.10 Visualization of CCTSDB detection results

通過模擬不同場(chǎng)景下的檢測(cè)來檢驗(yàn)網(wǎng)絡(luò)的合理性。本文在網(wǎng)絡(luò)搜集的交通標(biāo)志圖片中模擬了霧天、雨天以及夜間的場(chǎng)景分別進(jìn)行檢測(cè)。不同場(chǎng)景檢測(cè)結(jié)果可視化如圖11所示,通過圖11霧天模擬場(chǎng)景可以看出,改進(jìn)后的YOLOv5能夠檢測(cè)出大部分的交通標(biāo)志,而原始網(wǎng)絡(luò)僅能檢測(cè)出一個(gè),并且存在誤檢的情況。雨天場(chǎng)景中2種網(wǎng)絡(luò)均能檢測(cè)出所有交通標(biāo)志,但是改進(jìn)的YOLOv5算法的置信度更高,受噪聲影響較小。在夜間檢測(cè)的情況下本文算法沒有出現(xiàn)誤檢的情況,而原始網(wǎng)絡(luò)將指示類標(biāo)志(mandatory)檢測(cè)為禁止類(prohibitory),這對(duì)于真實(shí)的應(yīng)用場(chǎng)景來說是很不恰當(dāng)?shù)摹?/p>

圖11 不同場(chǎng)景檢測(cè)結(jié)果可視化Fig.11 Visualization of detection results in different scenarios

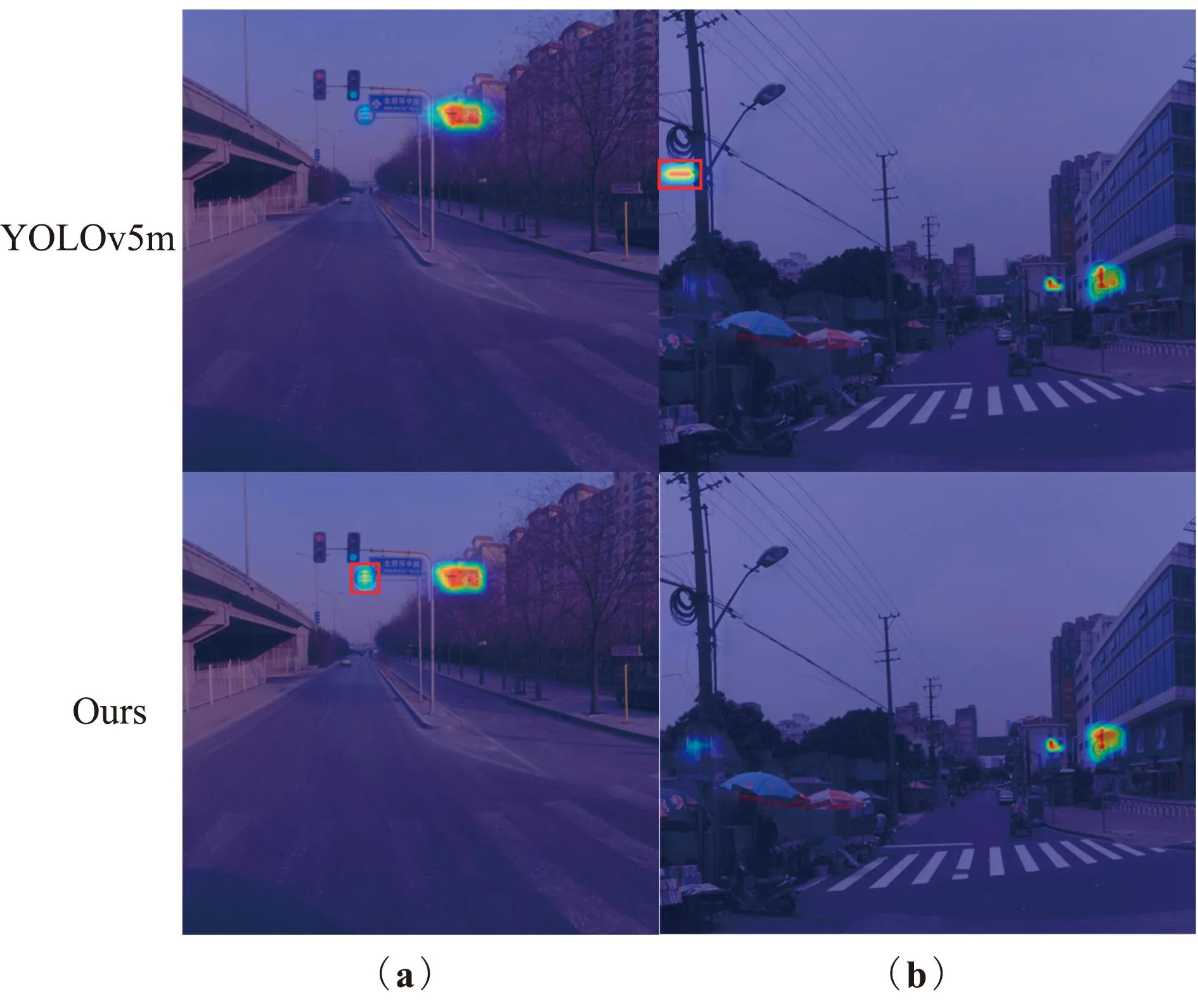

另外,本文通過熱力圖Grad-CAM[27]來解釋改進(jìn)的網(wǎng)絡(luò)對(duì)于不同尺寸目標(biāo)物體所帶來的提升,通過圖12能直觀地觀察到在小目標(biāo)檢測(cè)中,原始網(wǎng)絡(luò)對(duì)于小目標(biāo)的注意是不夠的,在圖12(a)的檢測(cè)中存在多個(gè)目標(biāo)并且小目標(biāo)居多,原始網(wǎng)絡(luò)在檢測(cè)中存在漏檢的問題,較小的警告類標(biāo)志未檢測(cè)出來;在較遠(yuǎn)距離的小目標(biāo)檢測(cè)圖12(b)中對(duì)于目標(biāo)物體的敏感程度是不夠的。本文所提出的網(wǎng)絡(luò)能更精確地定位到小目標(biāo)交通標(biāo)志,并且不存在漏檢的情況。

圖12 小目標(biāo)熱力圖Fig.12 Small object heatmap

對(duì)于中目標(biāo),通過圖13(a)能夠看出,本文的網(wǎng)絡(luò)能夠很好地注意到目標(biāo)區(qū)域,而原始網(wǎng)絡(luò)受到過多的背景信息干擾使得指示類標(biāo)志敏感度降低。在圖13(b)的檢測(cè)中,原始網(wǎng)絡(luò)將背景信息的一卷線纜誤識(shí)別為目標(biāo)物體,這對(duì)交通標(biāo)志檢測(cè)領(lǐng)域來說是很不恰當(dāng)?shù)摹?/p>

圖13 中目標(biāo)熱力圖Fig.13 Medium object heatmap

對(duì)于大目標(biāo)物體來說,尺寸較大,相對(duì)較好檢測(cè),但是在背景信息比較復(fù)雜的情況下原始網(wǎng)絡(luò)的目標(biāo)聚焦程度可能會(huì)受到很大的影響。圖14(a)中的背景較為復(fù)雜,原始網(wǎng)絡(luò)很容易受到干擾,而本文的網(wǎng)絡(luò)通過注意力以及多尺度融合使網(wǎng)絡(luò)對(duì)于目標(biāo)物體的聚焦程度增加,性能表現(xiàn)更優(yōu)。圖14(b)中的檢測(cè)則是背景信息與目標(biāo)信息較為相似,原始網(wǎng)絡(luò)將目標(biāo)物體誤認(rèn)為背景信息,而改進(jìn)的YOLOv5算法表現(xiàn)更佳,能夠注意到所有的目標(biāo)物體。

4 結(jié)論

本文為了解決交通標(biāo)志檢測(cè)中檢測(cè)難、精確度低以及漏檢率高等問題,提出了一種改進(jìn)的YOLOv5算法。通過融合多層的主干特征解決對(duì)目標(biāo)物體位置信息不足的問題,將輸入的特征層通過改進(jìn)的注意力機(jī)制濾除多余的噪聲。在特征金字塔中加入Fusion結(jié)構(gòu)促進(jìn)特征之間的細(xì)融合,使用ASFF結(jié)構(gòu)對(duì)輸出的3個(gè)特征進(jìn)行一致性融合,提升網(wǎng)絡(luò)的檢測(cè)能力。改進(jìn)的YOLOv5模型在小、中、大3種目標(biāo)尺寸的檢測(cè)中mAP@0.5、Precision和Recall均有很大提升。所以本文提出的改進(jìn)算法在自動(dòng)駕駛輔助系統(tǒng)以及無人駕駛技術(shù)中有著較高的實(shí)用價(jià)值。本文所提出的模型存在一定的局限性,由于CCTSDB僅存在3種類別,模型可檢測(cè)的種類可以做進(jìn)一步拓展。針對(duì)自動(dòng)駕駛的應(yīng)用還可以將改進(jìn)的算法進(jìn)一步優(yōu)化,以方便移植到算力有限的移動(dòng)設(shè)備中。