線卷積網(wǎng)絡(luò)在二維線檢測(cè)和三維線框重建中的應(yīng)用

戴錫笠,龔海剛,劉 明

(電子科技大學(xué) 計(jì)算機(jī)科學(xué)與工程學(xué)院,成都 611731)

0 引 言

目前在三維重建任務(wù)中,基于局部特征(如基于SIFT的角點(diǎn)表達(dá))的重建方法被廣泛應(yīng)用于實(shí)際生產(chǎn)和生活中.然而,局部特征方法在穩(wěn)定性和完整性上有其天然的缺陷.例如當(dāng)圖像中存在重復(fù)結(jié)構(gòu),反光鏡面,以及多視角之間視角變化過(guò)大等情況時(shí),局部特征將失效.

三維重建中的整體表征,是指用高層語(yǔ)義的幾何基結(jié)構(gòu)(如線、平面和布局)來(lái)表達(dá)和重建三維場(chǎng)景[1].例如對(duì)一個(gè)規(guī)則立方體形狀的房間進(jìn)行三位重建,可以用平面來(lái)代替點(diǎn)云進(jìn)行三維重建.因此,相比于局部表征,整體表征對(duì)場(chǎng)景的表達(dá)更加緊湊、穩(wěn)健和易于使用.這一理念啟發(fā)了最近一系列關(guān)于從圖像中識(shí)別幾何結(jié)構(gòu)的工作[2-9].

在上面提到的所有幾何元素中,線可以說(shuō)是最重要和最基本的一個(gè).一個(gè)準(zhǔn)確的點(diǎn)線檢測(cè)系統(tǒng)是眾多下游視覺(jué)任務(wù)的基礎(chǔ),例如消失點(diǎn)檢測(cè)[10]、相機(jī)姿態(tài)估計(jì)[11]、相機(jī)校準(zhǔn)[12]、立體匹配[13],甚至是場(chǎng)景三維重建[14].

點(diǎn)線檢測(cè)(Wireframe Detection)任務(wù)是在文獻(xiàn)[2]中首次提出的.該工作提供了一個(gè)帶有點(diǎn)線標(biāo)注的大規(guī)模數(shù)據(jù)集和一個(gè)基準(zhǔn)方法以及評(píng)價(jià)指標(biāo).之后,文獻(xiàn)[3]提出了一個(gè)端到端的深度學(xué)習(xí)解決方案,并顯著提高了性能.文獻(xiàn)[15]與文獻(xiàn)[3]互為同期工作,也引入了一個(gè)新的標(biāo)注數(shù)據(jù)集.同時(shí),文獻(xiàn)[16]是文獻(xiàn)[17]的后續(xù)工作,保持著目前最好的結(jié)果.文獻(xiàn)[18]為點(diǎn)線檢測(cè)任務(wù)設(shè)計(jì)了一個(gè)基于hough-transform的卷積算子.為了處理結(jié)點(diǎn)和線條的拓?fù)浣Y(jié)構(gòu),文獻(xiàn)[19]提出了一種基于圖神經(jīng)網(wǎng)絡(luò)的方法來(lái)處理點(diǎn)線任務(wù).最近,LETR[20],一種基于Transformer的方法,被提出用于檢測(cè)點(diǎn)線.嚴(yán)格來(lái)說(shuō),線段檢測(cè)不是點(diǎn)線檢測(cè),因?yàn)樗粰z測(cè)多個(gè)線段的連接點(diǎn).因此,本文僅與點(diǎn)線檢測(cè)方法中的線檢測(cè)結(jié)果進(jìn)行比較.

目前大多數(shù)基于深度學(xué)習(xí)的線檢測(cè)方法都為兩階段檢測(cè)[3,15,16],這種方法已被證明是有效的,并達(dá)到了迄今為止最高精確度[16].然而,這種兩階段的方法犧牲了效率,因?yàn)樗枰靡粋€(gè)額外的子網(wǎng)絡(luò)來(lái)處理大量的候選線.隨后有工作[21,28]提出通過(guò)單階段模型對(duì)線段進(jìn)行直接檢測(cè).這些方法提高了線檢測(cè)的速度,但是卻犧牲了線段檢測(cè)性能.

本文針對(duì)這些單階段線檢測(cè)方法進(jìn)行總結(jié),尤其對(duì)其線表征方法進(jìn)行分析歸納,提出了適合于單階段方法的線卷積模塊,并且通過(guò)分析,證明該線卷積模塊依然滿足等變性.

最后,通過(guò)在大型真實(shí)圖像數(shù)據(jù)集上的實(shí)驗(yàn),結(jié)果表明本模型不僅在指標(biāo)上比當(dāng)前最優(yōu)算法HAWP[16]高出 3個(gè)百分點(diǎn),并且相比于同類型的單階段模型TPLSD[21],在指標(biāo)上更是高出8個(gè)百分點(diǎn).此外,本文還在合成的數(shù)據(jù)集SceneCity上進(jìn)行單張圖三維線框重建的實(shí)驗(yàn),實(shí)驗(yàn)結(jié)果表明,高質(zhì)量的線檢測(cè)可以大幅度提高三維線框重建的性能.并且對(duì)比于其它三維線框重建的方法,具有明顯的優(yōu)勢(shì).

1 線卷積網(wǎng)絡(luò)

本節(jié)將對(duì)現(xiàn)有單階段線方法的線表征進(jìn)行歸納總結(jié),隨后提出本文的線卷積模塊.通過(guò)分析,證明該線卷積模塊滿足等變性.最后,給出線卷積網(wǎng)絡(luò)實(shí)現(xiàn)細(xì)節(jié),包括網(wǎng)絡(luò)結(jié)構(gòu),損失函數(shù),以及改進(jìn)的數(shù)據(jù)增強(qiáng)方法和非極大值抑制方法.

1.1 線表征

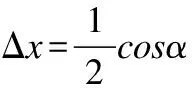

令pc∈R2為圖片中線段中點(diǎn)坐標(biāo),pl∈R2和pr∈R2分別表示線段左右端點(diǎn).可以得到如下關(guān)系:

(1)

(2)

圖1 線表征Fig.1 Line representation

1.2 一維旋轉(zhuǎn)卷積操作

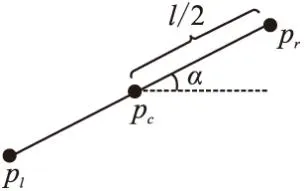

在單階段目標(biāo)檢測(cè)任務(wù)中,要想準(zhǔn)確檢測(cè)出目標(biāo)中點(diǎn),模型輸出的特征圖的感受野(receptive filed)需大于所檢測(cè)的目標(biāo).同理,要準(zhǔn)確檢測(cè)到某線段中點(diǎn),其感受野必須包含整條線段,即模型“看見(jiàn)”線段左右兩端點(diǎn).然而,不同于目標(biāo)檢測(cè)任務(wù),二維卷積操作會(huì)對(duì)線檢測(cè)任務(wù)帶來(lái)額外噪聲.如圖2(a),當(dāng)3×3的卷積核作用在一條線段上(灰色格子),卷積核上的有效激活單元只有3個(gè),其余6個(gè)單元皆為噪聲信息.因此信噪比只有1/2,而該信噪比會(huì)隨著線段長(zhǎng)度的增加而進(jìn)一步降低(即噪聲比例增大).

圖2 二維卷積和一維旋轉(zhuǎn)卷積及數(shù)據(jù)角度分布Fig.2 2D convolutional,1D rotated convolutional,and angle distribution

一維旋轉(zhuǎn)卷積操作,如圖2(b)可以有效的降低噪聲,提高線段中點(diǎn)以及線長(zhǎng)度的檢測(cè)性能.然而,旋轉(zhuǎn)卷積操作的計(jì)算開(kāi)銷會(huì)隨著旋轉(zhuǎn)次數(shù)的增加而增加,(例如總共旋轉(zhuǎn)180度,每次旋轉(zhuǎn)45度,則旋轉(zhuǎn)次數(shù)為4.即每個(gè)像素需進(jìn)行4次一維卷積操作.)幸運(yùn)的是,在我們生活的城市環(huán)境下,拍攝出來(lái)的照片中的線段絕大部分都是水平或者垂直的.如圖2(c),圖2(d)為ShanghaiTech和YorkUrban兩個(gè)線檢測(cè)數(shù)據(jù)集中所有標(biāo)注線段與水平夾角的統(tǒng)計(jì)直方圖.從圖中可以看出,水平方向和垂直方向的線段數(shù)量占主導(dǎo).

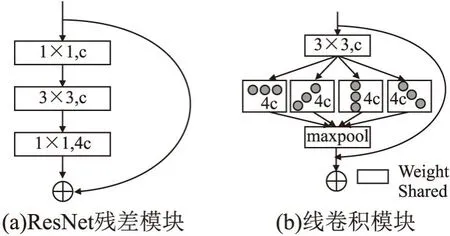

因此,本文提出由一維旋轉(zhuǎn)卷積和最大池化所組成的線卷積模塊,如圖3(b).相比于普通殘差模塊(圖3(a),輸入通道數(shù)為c,輸出通道數(shù)為4c),線卷積模塊的殘差分支由一個(gè)3×3的卷積層,4個(gè)權(quán)重共享的不同角度的一維卷積分支,以及最大池化構(gòu)成.由于本文選用的線表征為線段中點(diǎn),長(zhǎng)度,角度;其中角度的預(yù)測(cè),需要二維整體信息,因此還是需要采用二維卷積來(lái)提取特征,因此本文對(duì)線卷積模塊的第1層采用二維卷積.隨后的共享一維卷積層和最大池化層可以有效提高模型在抓取線特征時(shí)的信噪比,從而提高線段中點(diǎn)以及線長(zhǎng)度的檢測(cè)性能.

圖3 普通殘差模塊及線卷積模塊結(jié)構(gòu)圖Fig.3 ResNet block and line convolutional block

1.3 一維旋轉(zhuǎn)卷積的數(shù)學(xué)表達(dá)及其等變性(Equivariant)

公式(3)是以1×3為例的一維旋轉(zhuǎn)卷積和最大池化操作的數(shù)學(xué)表達(dá),其中w為卷積核,f為輸入特征圖.

(3)

(4)

等變性(Equivariant):等變性是卷積神經(jīng)網(wǎng)絡(luò)的重要數(shù)學(xué)性質(zhì),尤其在圖像檢測(cè),分割等任務(wù)中尤為重要.文獻(xiàn)[29]首次引入群理論來(lái)分析卷積神經(jīng)網(wǎng)絡(luò),并且證明由二維卷積和最大池化組成的卷積網(wǎng)絡(luò)滿足等變性.此外,論文還進(jìn)一步證明對(duì)二維卷積引入P4群操作(即旋轉(zhuǎn)二維卷積),該操作依然滿足等變性.

不同于文獻(xiàn)[29]中的操作,本文采用一維旋轉(zhuǎn)卷積和最大池化操作,借助文獻(xiàn)[29]中的分析方法,本文進(jìn)行如下分析證明.首先引入基本卷積操作的等變性表示,其中w為卷積核,f為輸入特征圖,Lt為某種變換,*為卷積操作.

[Ltf]*w=Lt[f*w]

(5)

則本文提出的線卷積模塊中4個(gè)一維旋轉(zhuǎn)卷積分支加最大池化可以表示成公式(6),其中w1,w2,w3,w4分別表示4個(gè)不同角度的一維卷積.

max{[f*w1],[f*w2],[f*w3],[f*w4]}

(6)

當(dāng)對(duì)特征圖f施加變換Lt,得到如下推導(dǎo)過(guò)程.

max{[Ltf]*w1,[Ltf]*w2,[Ltf]*w3,[Ltf]*w4}

(7)

=max{Lt[f*w1],Lt[f*w2],Lt[f*w3],Lt[f*w4]}

(8)

=Ltmax{[f*w1],[f*w2],[f*w3],[f*w4]}

(9)

其中根據(jù)公式(5),可以從公式(7)推導(dǎo)至公式(8).再根據(jù)文獻(xiàn)[29]中公式(20)的結(jié)論,最大池化操作滿足等變性,即Ltmax{f*w}=max{Lt[f*w]}.因此,公式(8)可以推導(dǎo)至公式(9).至此,可以證明本文提出的線卷積模塊滿足等變性.

1.4 模型實(shí)現(xiàn)

深度學(xué)習(xí)方法的實(shí)現(xiàn)至關(guān)重要,好的實(shí)現(xiàn)細(xì)節(jié)直接決定了方法是否有效.因此,本節(jié)將對(duì)關(guān)鍵實(shí)現(xiàn)細(xì)節(jié)進(jìn)行詳細(xì)描述.包括網(wǎng)絡(luò)結(jié)構(gòu),損失函數(shù),數(shù)據(jù)增強(qiáng),以及最后的非極大值抑制方法.

1.4.1 基礎(chǔ)網(wǎng)絡(luò)

本文選擇一個(gè)當(dāng)前最優(yōu)的并行多分辨率網(wǎng)絡(luò)結(jié)構(gòu)HRNet[22],該網(wǎng)絡(luò)結(jié)構(gòu)在許多視覺(jué)任務(wù)中表現(xiàn)出最好的性能,如圖像分割、檢測(cè)和識(shí)別.本文在HRNet的網(wǎng)絡(luò)結(jié)構(gòu)基礎(chǔ)上,將里面的所有殘差模塊替換成本文的線卷積模塊,從而得到本文的基礎(chǔ)網(wǎng)絡(luò).此外,為了驗(yàn)證本文提出的線卷積模塊的有效性,本文選用另一個(gè)在線檢測(cè)問(wèn)題中常用的網(wǎng)絡(luò)結(jié)構(gòu)Hourglass[23],將里面的所有殘差模塊替換成本文的線卷積模塊,從而得到另一版本的基礎(chǔ)網(wǎng)絡(luò).

本文利用墨爾本大學(xué)Rajkumar Buyya教授開(kāi)發(fā)的Cloudsim-3.0.3云計(jì)算仿真平臺(tái)[8],測(cè)試本文提出的云計(jì)算資源調(diào)度方法的有效性.實(shí)驗(yàn)中考慮了資源的處理速度和待處理任務(wù)的長(zhǎng)度,以不同規(guī)模的資源請(qǐng)求環(huán)境下任務(wù)的完成時(shí)間作為評(píng)價(jià)指標(biāo).具體參數(shù)設(shè)置為:種群規(guī)模為30,計(jì)算資源數(shù)量為10,學(xué)習(xí)因子c1、c2均為1.2,權(quán)重值wmax和wmin分別設(shè)定為0.9和0.4.

1.4.2 模型輸出及損失函數(shù)

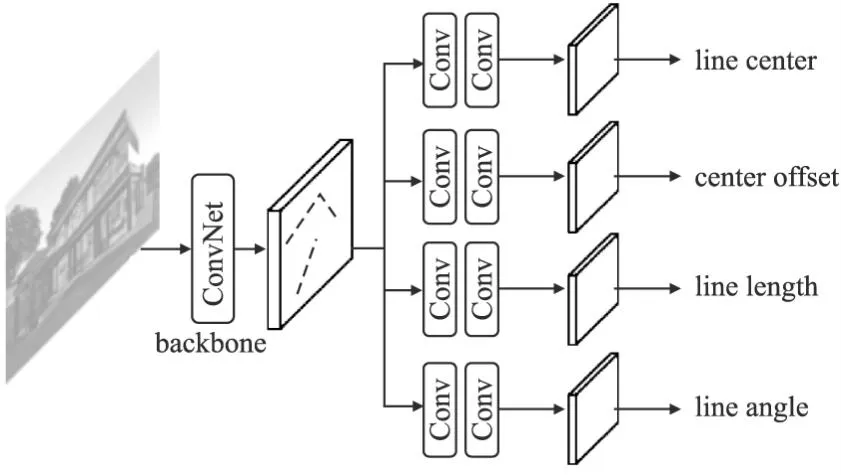

借鑒線檢測(cè)中常用的方式,令基礎(chǔ)網(wǎng)絡(luò)的輸入大小為512×512(即圖片大小),輸出的特征圖大小為128×128.隨后,在該特征圖之上,再接出4個(gè)子網(wǎng)絡(luò)(如圖4所示),分別對(duì)線中心,線中心偏移,線長(zhǎng)度,線角度進(jìn)行預(yù)測(cè).4個(gè)子網(wǎng)絡(luò)均由2個(gè)3×3的卷積層和一個(gè)1×1的卷積層組成.

圖4 線卷積網(wǎng)絡(luò)結(jié)構(gòu)圖Fig.4 Line convolutional network architecture

(10)

該損失函數(shù)為focal loss的簡(jiǎn)單變形,其中β是focal loss的超參數(shù),N是分?jǐn)?shù)圖上的單元數(shù)量,是分?jǐn)?shù)特征圖經(jīng)過(guò)softmax之后的概率圖.

第1個(gè)子網(wǎng)絡(luò)只能判斷哪些單元中存在線中心,第2個(gè)子網(wǎng)絡(luò)則會(huì)在其結(jié)果之上,給出線中心相對(duì)于單元中心的具體偏移值.輸出為2個(gè)128×128的數(shù)值圖,本文采用回歸來(lái)預(yù)測(cè)偏移值,則損失函數(shù)如下:

(11)

其中O為真實(shí)偏移值.

(12)

(13)

L和A分別表示長(zhǎng)度和角度的真實(shí)結(jié)果.在實(shí)現(xiàn)中,本文將長(zhǎng)度和角度的真實(shí)標(biāo)簽歸一化到0~1之間,來(lái)對(duì)網(wǎng)絡(luò)進(jìn)行訓(xùn)練.具體來(lái)說(shuō),由于輸入圖像統(tǒng)一大小為512×512,因此線長(zhǎng)度不會(huì)超過(guò)5122,通過(guò)將所有線長(zhǎng)除以5122來(lái)達(dá)到歸一化的效果.同樣對(duì)于線角度,其與水平方向的夾角不會(huì)超過(guò)180度(當(dāng)考慮線段與水平方法的夾角時(shí),90度和270度的情況是一樣的),通過(guò)除以180,將其歸一化到0~1之間.在預(yù)測(cè)環(huán)節(jié),將預(yù)測(cè)的0~1之間的值分別乘以5122和180來(lái)得到真實(shí)的線長(zhǎng)度和線角度值.

最終總損失函數(shù)如下:

L=λCLC+λoLo+λlLl+λαLα

(14)

1.4.3 數(shù)據(jù)增強(qiáng)

為了使模型對(duì)各種角度和大小的線更加魯棒,本文采用以下數(shù)據(jù)增強(qiáng).第1步,以等概率方式對(duì)輸入圖像采用如下3種操作.

1)保持原始輸入圖片不變;

2)水平翻轉(zhuǎn)或垂直翻轉(zhuǎn)或同時(shí)水平垂直翻轉(zhuǎn);

3)順時(shí)針或逆時(shí)針旋轉(zhuǎn)90度;

之后,采用隨機(jī)縮小[25]數(shù)據(jù)增強(qiáng)法.在512×512的全黑圖上選擇一個(gè)k×k的區(qū)域,將圖片縮小至k×k大小并填入該區(qū)域.在訓(xùn)練過(guò)程中每次迭代前從[256,512]中隨機(jī)抽選取k值.該數(shù)據(jù)增強(qiáng)可以大幅提高短線的檢測(cè)精度.

1.4.4 結(jié)構(gòu)化非極大值抑制

在測(cè)試過(guò)程中,首先在線中心分?jǐn)?shù)圖上應(yīng)用非極大值抑制(NMS)來(lái)去除重復(fù)的線檢測(cè)結(jié)果.與文獻(xiàn)[3]不同,本文利用目標(biāo)檢測(cè)中的SoftNMS[26]可以有效提高檢測(cè)性能.

(15)

其中,N(i,j)代表位置(i,j)周圍的8個(gè)單元.這種非極大值抑制可以用最大池化算子來(lái)實(shí)現(xiàn).在使用SoftNMS后,根據(jù)分類得分選取前m個(gè)線中心.使用相應(yīng)的預(yù)測(cè)長(zhǎng)度和角度值,根據(jù)公式(1)、公式(2)形成一條線.

SoftNMS只在點(diǎn)的層面上進(jìn)行NMS,沒(méi)有考慮線的長(zhǎng)度和角度的影響.因此,本文提出了一種新的結(jié)構(gòu)化非極大值抑制(StructNMS),對(duì)線段整體進(jìn)行NMS,即從分?jǐn)?shù)最高的線開(kāi)始(假設(shè)其索引為i),計(jì)算其兩個(gè)端點(diǎn)與另一條線j的端點(diǎn)之間的l2距離.

(16)

根據(jù)以上公式,利用結(jié)構(gòu)化非極大值抑制刪除所有d小于預(yù)定閾值τ的線條.

2 實(shí) 驗(yàn)

本章節(jié)對(duì)本文提出的基于幾何的線檢測(cè)算法(Line Convolutional Network,LCN)進(jìn)行實(shí)驗(yàn)分析,首先介紹基本實(shí)驗(yàn)設(shè)置以及實(shí)驗(yàn)細(xì)節(jié),同時(shí)通過(guò)消融實(shí)驗(yàn)分析LCN算法性能,最后同其它當(dāng)前最優(yōu)的線檢測(cè)算法進(jìn)行實(shí)驗(yàn)對(duì)比.

2.1 實(shí)驗(yàn)設(shè)置

數(shù)據(jù)集:本實(shí)驗(yàn)所有算法將在ShanghaiTech 數(shù)據(jù)集[2]上訓(xùn)練及測(cè)試,該數(shù)據(jù)集包含5000張訓(xùn)練圖像和462張測(cè)試圖像.同時(shí),為了評(píng)估模型的泛化性能,所有實(shí)驗(yàn)將在還將York Urban數(shù)據(jù)集[14]上單獨(dú)進(jìn)行測(cè)試,該數(shù)據(jù)集包含102張圖像.

評(píng)價(jià)指標(biāo):結(jié)構(gòu)平均精度(sAP)[3],被提出來(lái)用于評(píng)價(jià)線框檢測(cè)的準(zhǔn)確性,使用預(yù)測(cè)線段端點(diǎn)和其真實(shí)線段端點(diǎn)之間的平方誤差之和作為評(píng)價(jià)指標(biāo).當(dāng)預(yù)測(cè)的線段的平方誤差之和小于閾值,如=5、10、15時(shí),將被算作真陽(yáng)性檢測(cè).APH被用于點(diǎn)線檢測(cè)[2].本文沒(méi)有直接使用線段的矢量表示,而是將線段柵格化后產(chǎn)生的熱圖用于解析結(jié)果和基礎(chǔ)事實(shí).

對(duì)比方法:本文將 LCN與6個(gè)線檢測(cè)方法進(jìn)行比較.LSD[27],DWP[2],AFM[17],L-CNN[3],HAWP[16],和TP-LSD[21].其中后5種方法是基于有監(jiān)督的深度學(xué)習(xí)方法.它們代表了各自類別方法中的最先進(jìn)水平.本文使用每篇論文中提供的預(yù)訓(xùn)練模型以及開(kāi)源代碼進(jìn)行評(píng)估,所有算法均在ShanghaiTech數(shù)據(jù)集上進(jìn)行訓(xùn)練.

實(shí)現(xiàn)細(xì)節(jié):本文對(duì)HRNet和Hourglass兩個(gè)不同版本的基礎(chǔ) 網(wǎng)絡(luò)設(shè)置不同的初始學(xué)習(xí)率4×10-3和4×10-4.同時(shí),針對(duì)HRNet和Hourglass,令其focal loss中的β分別取4和5.此外,分別取1,0.25,3,1為公式(7)中的4個(gè)λ值.本文總訓(xùn)練輪次為300代,分別在240代和280代處進(jìn)行衰減,衰減因子為0.1.所有實(shí)驗(yàn)均在一張NVIDIA 2080Ti GPU上進(jìn)行.批量大小(batch size)為6,優(yōu)化器為ADAM,權(quán)重衰減系數(shù)為4×10-4.最后,在測(cè)試過(guò)程中取SoftNMS中的δ為0.8,StrucNMS中的τ為2.

2.2 消融實(shí)驗(yàn)

本節(jié)通過(guò)大量的實(shí)驗(yàn)來(lái)驗(yàn)證本文提出方法的有效性.所有的實(shí)驗(yàn)都是在ShanghaiTech數(shù)據(jù)集上進(jìn)行的,并給出sAP指標(biāo).

表1分析了不同訓(xùn)練設(shè)計(jì)的選擇.首先,通過(guò)比較表1中(a)和(b),表明使用focal loss可以將sAP提高約1個(gè)點(diǎn).這是因?yàn)榫€段中心只占據(jù)了圖像的一小部分,因此正負(fù)樣本之間的比例非常小.在這種情況下,focal loss對(duì)解決這個(gè)問(wèn)題是有效的.其次,驗(yàn)證本問(wèn)提出的數(shù)據(jù)增強(qiáng)的有效性.在表1中(c)和(d)中,加入旋轉(zhuǎn)和放縮增強(qiáng)之后分別為模型帶來(lái)了約1和3個(gè)點(diǎn)的性能改善.這些結(jié)果表明,通過(guò)用不同的幾何變換來(lái)增強(qiáng)數(shù)據(jù),可以得到一個(gè)更有效的線條檢測(cè)器,其泛化性能更好.

表1 消融實(shí)驗(yàn):LC表示線中心損失函數(shù),CE表示交叉墑,FL表示focal loss,數(shù)據(jù)增強(qiáng)這一列中,F翻轉(zhuǎn),R表示旋轉(zhuǎn),E表示放縮Table 1 Ablation study:LC means loss function of line center,“CE” means cross entropy,“FL” means focal loss.In the colume of data augmentation,F,R,and R mean flip,rotation,and expand respectively

表2展示了不同非極大值抑制策略的影響.(a)中使用原始的NMS實(shí)現(xiàn)了61.5 的值.接下來(lái),應(yīng)用公式(8)中的SoftNMS,結(jié)果提高了2點(diǎn),達(dá)到63.5.這是因?yàn)樵谶@個(gè)階段,只利用了點(diǎn)信息.因此,可能有一些中心位置接近的不同線條被錯(cuò)誤地刪除.設(shè)置一個(gè)較低的置信度,而不是完全刪除這些線條,可以保持恢復(fù)這種錯(cuò)誤的可能性.接下來(lái)的結(jié)果表明,使用StructNMS可以進(jìn)一步提高性能1個(gè)點(diǎn),因?yàn)檫@種機(jī)制考慮到了整個(gè)線條.結(jié)合這兩個(gè)新的NMS機(jī)制,比原來(lái)的結(jié)果提高了3個(gè)點(diǎn).

表2 不同NMS消融實(shí)驗(yàn)Table 2 Ablation study of different NMS

表3對(duì)線卷積模塊中旋轉(zhuǎn)次數(shù)T進(jìn)行了消融實(shí)驗(yàn),其中baseline表示基礎(chǔ)網(wǎng)絡(luò)為HRNet.T=2,4,8表示將HRNet中的殘差模塊替換成本文的線卷積模塊,T表示線卷積模塊中的旋轉(zhuǎn)次數(shù).圖3(b)為T=4示意圖.從表3中看出,線卷積模塊相比于殘差模塊,在sAP5指標(biāo)下,T=2比baseline高出了1.1個(gè)點(diǎn),當(dāng)進(jìn)一步將旋轉(zhuǎn)次數(shù)T提高到4,性能提高了1.6個(gè)點(diǎn).此時(shí)線卷積模塊的計(jì)算開(kāi)銷是殘差模塊的1.3倍.最后,T=8相比于T=4的提升已經(jīng)非常微弱,但是在計(jì)算開(kāi)銷上,卻增加了1倍.

表3 線卷積模塊消融實(shí)驗(yàn)Table 3 Ablation study on line convolutional block

2.3 實(shí)驗(yàn)對(duì)比

表4總結(jié)了本文提出方法與其它現(xiàn)有算法的結(jié)果對(duì)比.結(jié)果表明,本文提出的LCN算法在性能上明顯優(yōu)于其它算法.其中LCN(HR)表示基礎(chǔ)網(wǎng)絡(luò)為原始HRNet的版本,LCN(HR-L)表示基礎(chǔ)網(wǎng)絡(luò)為線卷積版的HRNet.同理,LCN(HG)和LCN(HG-L)分別表示基礎(chǔ)網(wǎng)絡(luò)為原始Hourglass和線卷積版Hourglass.從表中結(jié)果可以看出,在加入本文提出的線卷積模塊后,相比于原始基礎(chǔ)網(wǎng)絡(luò),在各sAP指標(biāo)上都可以穩(wěn)定提升1個(gè)點(diǎn).同時(shí),配合上提出的StrucNMS以及數(shù)據(jù)增強(qiáng)等技術(shù),LCN算法性能超過(guò)當(dāng)前最優(yōu)算法HAWP約3個(gè)點(diǎn),在sAP,等指標(biāo)上達(dá)到了當(dāng)前最優(yōu).此外,通過(guò)對(duì)比FPS(Frame Per Second),即每秒處理樣本數(shù)量這個(gè)指標(biāo),發(fā)現(xiàn)本文方法在效率上明顯優(yōu)于2階段方法如LCNN和HAWP,并且與單階段方法TPLSD比也略高一些.

表4 對(duì)比實(shí)驗(yàn)Table 4 Experiment comparison

表5 SceneCity數(shù)據(jù)集上量化指標(biāo)對(duì)比結(jié)果Table 5 numerical metric comparison on SceneCity

2.4 實(shí)驗(yàn)結(jié)果可視化

本文在圖5中可視化了LCN和其他兩種方法L-CNN、HAWP的輸出.L-CNN和HAWP的結(jié)果都采用文獻(xiàn)[3]附錄A.1中的方法進(jìn)行過(guò)后處理.由于LCN沒(méi)有明確輸出結(jié)點(diǎn),本文將線的端點(diǎn)視為結(jié)點(diǎn).

圖5 L-CNN,HAWP,LCN 3種方法可視化結(jié)果對(duì)比,最后一列GT為人為標(biāo)注的真實(shí)結(jié)果Fig.5 Comparison results of L-CNN,HAWP,LCN,and ground truth

L-CNN和HAWP都高度依賴結(jié)點(diǎn)檢測(cè)和線條特征采樣,這可能容易造成結(jié)點(diǎn)或紋理變化的缺失.相比之下,LCN能夠在復(fù)雜的甚至是低對(duì)比度的環(huán)境中檢測(cè)線段(見(jiàn)圖4的第3行).

2.5 三維線框重建

單張圖三維線框重建任務(wù)是近年來(lái)一個(gè)新興的方向,首次在論文[4]中被提出,該任務(wù)同時(shí)也是線檢測(cè)的下游任務(wù).即在曼哈頓假設(shè)下(即場(chǎng)景中只有3組平行線,且這3組平行線之間相互垂直),從單張圖恢復(fù)出其點(diǎn)線的三維結(jié)構(gòu).本節(jié)將根據(jù)文獻(xiàn)[4]中三維重建方法,利用本文提出的線檢測(cè)結(jié)果,來(lái)對(duì)文獻(xiàn)[4]中的數(shù)據(jù)集SceneCity[4]進(jìn)行三維線框重建.如下公式為根據(jù)線檢測(cè)結(jié)果以及交點(diǎn)信息(即兩條線的交點(diǎn)),利用曼哈頓假設(shè)下,每個(gè)消失點(diǎn)代表一組平行線的方向,來(lái)重建出每個(gè)交點(diǎn)的深度信息.由于本文中的方法無(wú)法直接提供交點(diǎn)信息.因此,本文采用啟發(fā)式算法,對(duì)檢測(cè)出來(lái)的線的端點(diǎn)進(jìn)行距離計(jì)算,當(dāng)兩條線的端點(diǎn)距離小于閾值α,則合并這兩個(gè)端點(diǎn),得到一個(gè)交點(diǎn),取α=2.

(17)

s.t.zv≥1,?v∈V

λzu+(1-λ)zv≤zw

?w∈VT,(u,v)∈E:w=λu+(1-λ)v

圖6 數(shù)據(jù)集SceneCity上的三維重建結(jié)果Fig.6 3D reconstruction results on SceneCity dataset

圖7 在圖6之上對(duì)三維結(jié)果進(jìn)行視角旋轉(zhuǎn)Fig.7 View change on the results of fig.6

3 結(jié)束語(yǔ)

本文提出一個(gè)單階段深度學(xué)習(xí)線檢測(cè)模型,直接輸出圖像中所有線段的參數(shù).通過(guò)將線段檢測(cè)表述為對(duì)每個(gè)線段的中心點(diǎn)、長(zhǎng)度和角度進(jìn)行端到端的預(yù)測(cè).同時(shí)本文提出針對(duì)線段幾何的卷積模塊,以及數(shù)據(jù)增強(qiáng)方式,結(jié)構(gòu)化非極大值抑制,使得本算法在ShanghaiTech,YorkUrban兩個(gè)數(shù)據(jù)集上達(dá)到了當(dāng)前最優(yōu),比已有算法在指標(biāo)上高出3個(gè)點(diǎn).