基于融合神經網絡的飛機蒙皮缺陷檢測的研究

張德銀 黃少晗 趙志恒 李俊佟 張裕堯

摘 要:飛機蒙皮受大氣環境侵蝕及飛鳥撞擊等影響而出現各種缺陷,將嚴重威脅飛行安全.為解決飛機蒙皮人工檢查耗時長及檢測不充分等問題,提出基于融合神經網絡的飛機蒙皮缺陷檢測方法.在YOLOv5網絡基礎上,將Xception架構融入其中,同時在Backbone中加入全局通道注意力機制,在Neck和Output中加入通道空間注意力機制,形成新的融合神經網絡.將采集到的飛機表面缺陷8 503幅圖像分為訓練集和測試集.新融合神經網絡經訓練后,用測試集驗證,鉚釘腐蝕、鉚釘脫落、蒙皮裂痕、蒙皮脫落及蒙皮撞擊5種缺陷檢測平均精確度分別為0.960、0.928、0.931、0.934、0.948.融合神經網絡準確率為0.950,召回率為0.964,平均精確度為0.957,說明新融合神經網絡對飛機蒙皮缺陷識別是有效的.

關鍵詞:飛機蒙皮缺陷;注意力機制;深度學習;融合神經網絡;目標檢測

中圖分類號:V241.07

文獻標志碼:A

0 引 言

飛行安全最重要的保障就是繞機檢查.從飛機機頭處的3個探頭到14個放電刷,從雷達罩到起落架,總共13個步驟56項內容,均需要人工進行仔細無差別檢測.檢查飛機是每次航班必做的環節,也是飛機在起飛之前和降落之后不可缺少的重要防線.如果在起飛之前和降落之后檢查出飛機蒙皮所出現的問題,就可以避免很多危險事故的發生[1-2].

飛機蒙皮表面會受到大氣環境的侵蝕、飛鳥撞擊、閃電沖擊及飛行中蒙皮相互拉扯的應力作用,會出現蒙皮裂紋、撞擊坑和蒙皮腐蝕等缺陷[3].這些飛機表面缺陷不僅影響飛機表面美觀,更會影響飛機的整體使用壽命.如果繼續飛行將會因為拉扯應力,使得缺陷裂口進一步被撕裂,從而導致飛行事故的發生[4].傳統的飛機蒙皮檢測方法是通過人工繞機檢查,需要人工細致地觀察飛機的每寸蒙皮.但是由于飛機表面太大,人工檢測存在耗時長、檢測不充分且會忽略致命蒙皮缺陷等問題[5].在智慧民航背景下,如何快速地對蒙皮進行精確檢測是研究的重點之一,而機器視覺技術則是一種十分可靠的方法[6],其利用圖像采集設備對航空器蒙皮進行采集,并建立大量飛機蒙皮數據集,再利用諸如神經網絡的目標檢測方法對蒙皮數據集進行檢測.隨著計算機視覺算法的不斷改進,基于神經網絡的視覺蒙皮檢測方法就可以進一步縮短檢測的周期,并提高智能化[7].

本研究探討關于飛機蒙皮缺陷快速巡檢的人工智能系統,適用于所有民用航空飛機蒙皮缺陷巡檢[8].本研究設計并實現基于機器視覺的神經網絡便攜式民航航空器蒙皮檢測儀,通過訓練飛機蒙皮缺陷,提高神經網絡對飛機蒙皮的檢測效果,以實現對蒙皮的安全狀況智能檢測評估.由于航空安全要求高標準無差別,傳統的神經網絡無法滿足現有需求,因此需要通過融合來提升檢測效果精度[9].該檢測儀能夠對航空器的表面蒙皮進行損傷檢測,對其損傷類型進行評估,其檢測精度與速度極大優于現有人工檢測方法,滿足日常巡檢的基本保障[10].

1 圖像數據集的建立

由于圖像數據集是人工智能最重要的因素之一,神經網絡識別的準確率和效果的差異很大程度上由數據集的質量確定[11].如何收集到大量優質數據集及如何標注識別對象的目標特征,都將直接或間接影響神經網絡對飛機蒙皮缺陷的識別效果[12].為了獲得高質量蒙皮缺陷數據集,本研究在得到許可后,在國內航空機場使用專用相機進行飛機蒙皮缺陷圖像數據集的采集[13].

為采集飛機蒙皮圖像數據集,本研究選用對焦好且焦距足夠的數碼單反相機dSLR.為了避免在拍攝過程中相機發生抖動造成缺陷數據集的情況,因此要選用具有快速快門的相機,且拍攝時間控制在0.002 s左右,從而避免因抖動造成拍攝不清晰的情況[14].此外相機過濾器也相當重要,由于采集飛機蒙皮缺陷時均在戶外可見光的情況下,因此要選用帶有偏光濾鏡的相機,以減少偏振光,達到增強顏色的效果[15].為達到以上效果,綜合經濟性、實用性及重量等因素,本研究最終選取尼康D7100中端專業單反數碼照相機.

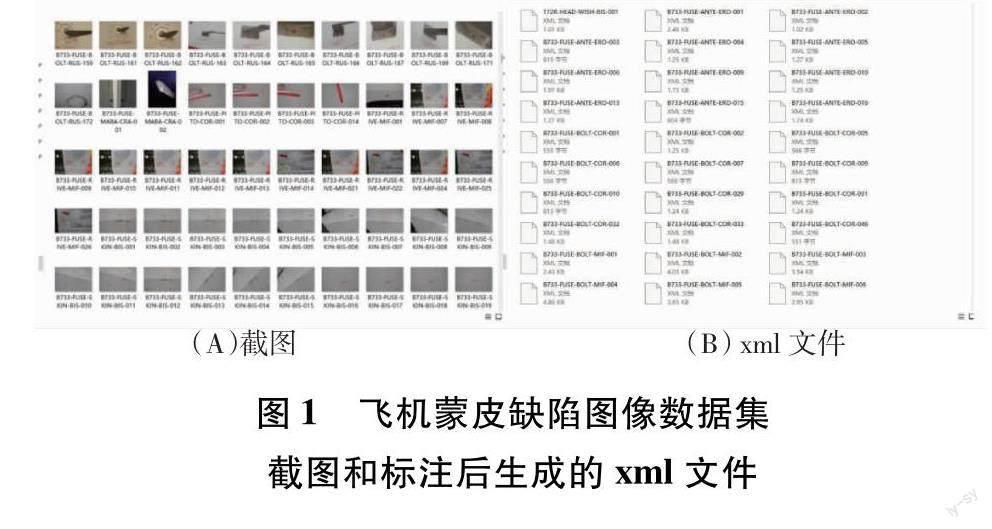

本研究在廣漢機場、新津機場、天府國際機場、雙流國際機場及平頂山飛機場等機場采集A319、A320、B733、B737、PA44、TB200、B747及B777等帶有缺陷的飛機蒙皮圖像共計8 503張,如圖1所示.圖1(A)為已采集到的飛機蒙皮缺陷圖像數據集截圖.將采集到的飛機表面缺陷分為5類,即鉚釘脫落、鉚釘腐蝕、蒙皮脫落、蒙皮裂痕及蒙皮撞擊,并使用labellmg標注軟件,對采集到的數據集進行標注,標注后生成與之相對應的xml文件,如圖1(B)所示.首先將多缺陷圖像通過pycharm剪切程序裁剪,得到10 437幅圖像數據集,接著使用添加噪聲、對比度變換及亮度調節等方法生成新圖像數據集,以截圖和標注后生成的xml文件實現對飛機蒙皮缺陷樣本的擴增,最后獲得12 440幅圖像.

2 融合神經網絡的構建

由于通道注意力模塊(channel attention module,CAM)[16]的缺點是不易提取到小目標特征,從而導致小目標易漏檢,因此,本研究采用全局池化代替CAM中最大池化操作,因為全局池化可以緩解網絡對于小目標信息的過濾,最大程度保留小目標信息,以提高神經網絡對小目標的檢測.相比于CAM,改進的全局通道注意力(global channel attention,GCA)使用4層特征共享感知機(multi-layer perceptron,MLP),可以更充分獲取小目標特征信息.改進后的CAM注意力機制命名為全局通道注意力機制GCA,其流程圖如圖2所示.

擠壓與激勵網絡( squeeze-and-excitation networks,SENet)的缺點在于忽略了空間信息,因此提出由SENet改進而來的通道空間注意力(channel space attention,CPA)機制,可以通過賦予空間信息更大的權重,顯示出目標的位置信息.為了獲取圖像寬度和高度上的注意力并對精確位置信息進行編碼,將輸入特征圖分為寬度與長度2個方向進行全局平均池化,分別獲得在寬度和長度方向的特征圖,如式(1)和式(2)所示[17-18].

將獲得的全局池化的寬度與長度方向上的特征圖進行合并,送入共享卷積核為1×1的卷積模塊,將維度降低為原來的C/r,并將經過批量處理歸一化的特征圖F1送入Sigmoid 激活函數,得到特征圖f,如式(3)所示[19].

f=βF1Dh,Dw(3)

將得到的特征圖f根據原來的長度與寬度開始卷積核為 1×1的卷積,獲得通道數目與原來相同數目的特征圖Fh和Fw,經過Sigmoid激活函數得到特征圖在長度上的注意力權重gh和在寬度上的注意力權重gw,如式(4)和式(5)所示[20-21].

gh=?Fhfh(4)

gw=?Fwfw(5)

通過式(1)~式(5)計算之后將得到輸入特征圖高度注意力權重gh和長度注意力權重gw,最后在原始特征圖上經過乘法加權計算,獲得最終在寬度和高度方向上帶有注意力權重的特征圖.改進后的CPA機制如圖3所示.

圖3 改進后的CPA機制圖

本研究采用YOLOv5神經網絡模型與Xception網絡模型融合,通過訓練結果反復調整網絡模型參數進行飛機蒙皮缺陷的檢測.YOLOv5與Xception融合的神經網絡框架圖如圖4所示.Xception網絡模型相比CBS擁有更多卷積層,可以使模型在進入Upsample前進行進一步深入卷積,使原有神經網絡具有更快的收斂效果,從而提升檢測效果的快速性和準確度.Xception網絡模型也具有輕量化且計算小的優點[22].在Backbone中加入GCA機制模塊,在Neck和Output中加入CPA機制,對飛機蒙皮缺陷小目標進行檢測精度提升.融合后的神經網絡算法進一步提高了檢測精度,能夠有效檢測到復雜飛機蒙皮背景中缺陷的具體位置[23].本研究將所提出的YOLOv5和Xception融合神經網絡對飛機蒙皮缺陷檢測方法進行了訓練和測試,與原始YOLOv5神經網絡進行了實驗對比,其中,采用Precision、Recall及mAP等評價指標[24].

損失函數CIOU_Loss是一種監督神經網絡的學習過程,通過自動調節權重的方式幫助神經網絡模型對飛機蒙皮缺陷的學習,而且通過對比標注和神經網絡學習后的預測,計算出神經網絡模型的損失,并繪制出神經網絡的損失函數曲線.損失函數CIOU_Loss可以防止神經網絡模型過大,減小了神經網絡模型參數,此種方式稱為防止過擬合,也稱為正則化[25].損失函數CIOU_Loss綜合考慮了邊框比、寬高比及中心距離等問題,極大提高了飛機蒙皮缺陷檢測的準確性[26],其計算式如下:

式(6)和式(7)中,IoU為交互比,v為衡量長寬比一致性的參數[27-28].

式(8)中,α是衡量權值的參數[29].

3 實驗過程和分析

3.1 實驗平臺的建立

實驗平臺的建立和運行是保證實驗能否成功的關鍵.本研究需要對神經網絡的實驗平臺完成搭建,并且在更換不同融合神經網絡的同時需要對moudle(模型)不斷調整,以確保神經網絡正常運行.神經網絡正常運行后,還需要對飛機蒙皮缺陷數據集進行合適分類,設置合適的參數.設置參數運行時,需要控制相關定量,即200輪、統一運行大小為16、統一輸入圖像為640×640,以確保實驗效果的準確性和真實對比性[30].實驗后,若實驗效果未達到預期效果,需要調整神經網絡中的融合框架位置或對神經網絡中的代碼與參數進行調整,以確保獲得最佳效果[31].

本研究的實驗在Pytorch深度學習框架下進行,利用YOLOv5與Xception融合神經網絡對飛機蒙皮中的鉚釘腐蝕、鉚釘脫落、蒙皮裂痕、蒙皮脫落、蒙皮撞擊5種主要缺陷進行檢測.具體配置環境參數如表1所示.

本研究最終獲得12 440幅圖像的數據集,其中鉚釘腐蝕2 637幅、鉚釘脫落2 309幅、蒙皮裂痕2 406幅、蒙皮脫落2 523幅、蒙皮撞擊2 565幅,并利用標注軟件進行標注,分別標注為rivet corrosion(鉚釘腐蝕)、rivet falling off(鉚釘脫落)、skin crack(蒙皮裂痕)、skin paint falling off(蒙皮脫落)、external impact(蒙皮撞擊).將增強后的數據集按7:3的結構劃分為訓練集8 708幅、測試集3 732幅.訓練的超參數設置如表2所示.

3.2 評價指標

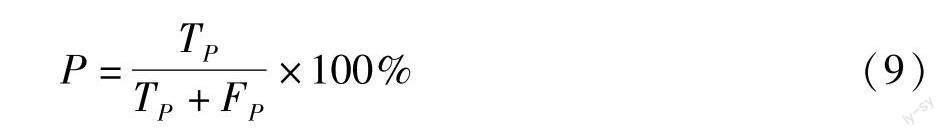

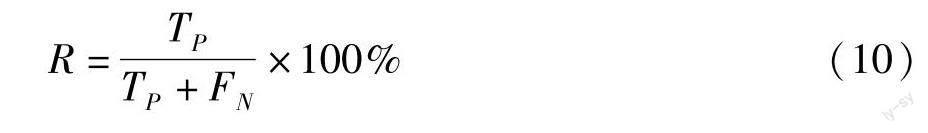

目標檢測常見的評價方式有P(準確率)、R(召回率)及mAP(平均精確度).P與R可用于評價此檢測模型的優劣,而mAP綜合考慮了P與R的相關性,更準確地反映目標檢測的能力.本研究選取P、R及mAP 3種方式來綜合評價檢測指標[34-35],從而全面評估檢測性能.

式(9)中,TP表示檢測正確的數量,FP表示檢測錯誤的數量[32].

式(10)中,FN表示將某種檢測目標當作其他目標的數量[33].

式(11)中,mAP是平均精確度[34-35].

3.3 實驗結果與分析

單獨YOLOv5神經網絡對于飛機蒙皮缺陷的檢測輸出數據效果如表3所示.YOLOv5神經網絡對于飛機蒙皮缺陷檢測中重要的5種檢測物為rivet corrosion(鉚釘腐蝕)、rivet falling off(鉚釘脫落)、skin crack(蒙皮裂痕)、skin paint falling off(蒙皮脫落)、external impact(蒙皮撞擊).單獨YOLOv5神經網絡目標檢測效果圖如圖5所示,其中,圖5(A)為鉚釘腐蝕檢測效果圖,圖5(B)為蒙皮裂痕檢測效果圖,圖5(C)為蒙皮裂痕檢測效果圖,圖5(D)為蒙皮脫落檢測效果圖,圖5(E)為蒙皮撞擊檢測效果圖,圖5(F)為鉚釘脫落檢測效果圖.

YOLOv5和Xception融合神經網絡對于飛機蒙皮缺陷檢測中重要的5種檢測物,得到相應的被檢測物數據效果,如表4所示.YOLOv5與Xception融合神經網絡目標檢測效果如圖6所示,其中,圖6(A)為鉚釘腐蝕檢測效果圖,圖6(B)為蒙皮撞擊檢測效果圖,圖6(C)為蒙皮裂痕檢測效果圖,圖6(D)為蒙皮脫落檢測效果圖,圖6(E)為蒙皮裂痕檢測效果圖,圖6(F)為鉚釘脫落檢測效果圖.

為驗證YOLOv5與Xception融合神經網絡的有效性,本研究將單獨YOLOv5神經網絡和YOLOv5與Xception融合神經網絡對驗證數據集進行對比檢測,對比效果如表5所示.由對比實驗結果可知,YOLOv5與Xception融合神經網絡算法在識別準確率與識別用時等方面都強于單獨YOLOv5算法.YOLOv5與Xception融合神經網絡的檢測準確率、召回率、平均精確度都達到了更高水平,且融合神經網絡平均檢測用時為30 ms,比單獨YOLOv5神經網絡巡檢提高了9.10%,進一步說明了YOLOv5與Xception融合神經網絡對飛機表面缺陷檢測的快速性與高效性.

4 結論與展望

本研究探討了適用于民航飛機蒙皮缺陷檢測的智能檢測系統,將Xception網絡架構融入到YOLOv5神經網絡的Backbone中,對飛機蒙皮缺陷進行檢測,同時在YOLOv5的Backbone中加入GCA機制,在YOLOv5的Neck和Output中加入CPA機制,提高檢測平均精確度.經實驗驗證,YOLOv5與Xception融合神經網絡準確率0.950、召回率0.964、平均精確度0.957,相比單獨YOLOv5神經網絡,分別提升了0.068、0.056、0.058.YOLOv5與Xception融合神經網絡平均檢測時間為30 ms,相比選擇單獨YOLOv5方式進行巡檢的檢測速度提高了3 ms.實驗結果表示,基于YOLOv5與Xception融合神經網絡對飛機蒙皮缺陷具有高效率、高精度、智能化的檢測,具有較強的實用價值.

針對本研究搭建的融合神經網絡對飛機蒙皮缺陷檢測可以進行快速有效識別,能夠在實時檢測實驗中實時傳輸檢測后的效果[36].本研究的方法可以幫助民航從業人員在對飛機蒙皮檢測時節約大量時間[37],同時通過對YOLOv5神經網絡的不斷融合和改進,增加了對飛機蒙皮缺陷檢測5種識別對象的有效性[38].

本研究在樣本集的建立過程中,由于考慮樣本集數量和質量的問題,使用了傳統圖像處理方式對樣本數據進行了擴增,但是該方法對樣本的擴增能力有限[39].若想要進一步提升樣本集的全面性,可以利用生成對抗神經網絡對飛機蒙皮缺陷樣本進行學習和重構,得到全新的飛機蒙皮缺陷樣本,實現對樣本的擴增[40].

由于神經網絡實驗平臺的軟硬件限制,越深度的網絡模型對硬件計算力的要求越高,所以下一步的研究將對硬件平臺進行升級,提供更強大的計算力,給更加深度的網絡訓練提供支持,以得到最好的飛機蒙皮識別神經網絡模型.

參考文獻:

[1]王得道,王森榮,林超,等.基于CNN-LSTM融合神經網絡的CRTSⅡ型軌道板溫度預測方法[J].鐵道學報,2023,45(2):108-115.

[2]朱淑暢,李文輝.基于卷積和Transformer融合的服裝分類算法[J].吉林大學學報(理學版),2023,61(5):1195-1201.

[3]丁華彬,丁麒文.基于語義損失的紅外與可見光圖像融合算法[J].紅外技術,2023,45(9):941-947.

[4]錢白云,呂朝陽,張維寧,等.基于多傳感器信息融合與混合感受野殘差卷積神經網絡的調相機轉子故障診斷[J].計算機測量與控制,2023,31(9):29-35.

[5]吳懷誠,劉家強,岳蕾,等.基于多特征融合的卷積神經網絡的電能質量擾動識別方法[J].電網與清潔能源,2023,39(9):19-23.

[6]周哲,歐陽勇.融合神經網絡GRU和RRT算法的機械臂路徑規劃[J].組合機床與自動化加工技術,2023,65(9):7-10.

[7]劉霞,馮文暉,連峰,等.基于物理信息神經網絡的氣動數據融合方法[J].空氣動力學學報,2023,41(8):87-96.

[8]韓永成,張聞文,何偉基,等.基于自適應截斷模擬曝光和無監督融合的低照度真彩色圖像增強算法[J].光子學報,2023,52(9):245-259.

[9]陸應越,羅昊,吳樸艷,等.融合BP神經網絡和知識圖譜的微博熱搜研究與分析[J].電腦編程技巧與維護,2023,30(9):127-130.

[10]吳軍,石改琴,盧帥員,等.采用無人機視覺的飛機蒙皮損傷智能檢測方法[J].中國測試,2021,47(11):119-126.

[11]王建兵,楊超,劉方方,等.基于圖卷積神經網絡和RoBERTa的物流訂單分類[J].計算機技術與發展,2023,33(10):195-201.

[12]張歡,程洪,葛美伶,等.機器學習輔助高熵合金相結構預測[J].成都大學學報(自然科學版),2022,41(3):280-286.

[13]閆政偉,王晨,黃秋波,等.云數據共享中一種輕量級的數據確定性刪除算法[J].成都大學學報(自然科學版),2023,42(3):255-261.

[14]冷志鵬,孫文瑞,朱立偉,等.基于YOLO-UNet算法的路面病害定量分析方法[J].物聯網技術,2023,13(8):141-143.

[15]徐仵博,劉立群.GLHMS算法的PCNN參數優化及其在圖像融合中的應用[J].軟件導刊,2023,22(8):187-195.

[16]楊燦,王重熙,章隆兵.基于層間融合的神經網絡訪存密集型層加速[J].高技術通訊,2023,33(8):823-835.

[17]李東澤,齊詠生,劉利強.基于LSTM-ATTENTION融合神經網絡的光伏功率預測[J].內蒙古工業大學學報(自然科學版),2023,42(4):350-354.

[18]閆婧,武林偉,劉偉杰,等.基于統一網絡架構的多模態航空影像質量評價研究[J].現代電子技術,2023,46(17):43-47.

[19]馬孝威.基于多源信息融合的托輥故障檢測系統[J].煤礦機械,2023,44(9):168-170.

[20]代婷婷.基于改進智能算法的機器人路徑規劃問題研究[J].成都大學學報(自然科學版),2021,40(4):379-383.

[21]杜航,張濤,陳巖,等.基于遺傳算法的BP神經網絡預測石油單井產量[J].成都大學學報(自然科學版),2021,40(1):57-61.

[22]淡文慧,毛鵬軍,蘇坤,等.基于改進YOLOv4的移動機器人障礙物檢測[J].組合機床與自動化加工技術,2023,65(10):73-76.

[23]許若波,李平,張梓楚,等.基于多源融合的人臉圖像超分辨率算法[J].電腦知識與技術,2023,19(24):107-109.

[24]王瀏洋,徐彥偉,頡潭成,等.基于優化CNN與信息融合的地鐵牽引電機軸承故障診斷[J].機械與電子,2023,41(8):39-44.

[25]閆冰,余梟,王帥,等.IMRT QA中基于后融合卷積神經網絡的MLC誤差分類預測[J].中國醫學物理學雜志,2023,40(8):925-932.

[26]曹軻,譚沖,劉洪,等.基于改進灰狼算法優化BP神經網絡的無線傳感器網絡數據融合算法[J].中國科學院大學學報,2022,39(2):232-239.

[27]祁宏宇.基于注意力U-Net網絡的紅外夜視質量增強研究[J].光學技術,2023,49(5):623-630.

[28]張亞加,邱啟蒙,劉恒,等.基于多尺度分解和改進稀疏表示的腦部圖像融合[J].陜西理工大學學報(自然科學版),2023,39(4):52-61.

[29]李揚,胡學鋼,王磊,等.基于圖神經網絡的環狀RNA生物標志物篩選預測算法[J].中國科學:信息科學,2023,53(11):2214-2229.

[30]路琨婷,費蓉蓉,張選德.融合卷積神經網絡的遙感圖像全色銳化[J].計算機應用,2023,43(9):2963-2969.

[31]裴紅蕾.基于綜合信息融合神經網絡的軸承故障診斷[J].機電工程,2022,39(4):495-500.

[32]王治學.融合實體信息的圖卷積神經網絡的短文本分類模型分析[J].信息系統工程,2023,36(9):122-125.

[33]楊佳攀,陳為,艾渤.基于深度展開神經網絡的融合感知通信場景信道估計[J].移動通信,2023,47(9):64-70.

[34]葉文超,羅水洋,李金豪,等.近紅外光譜與圖像融合的雜交水稻種子分類方法研究[J].光譜學與光譜分析,2023,43(9):2935-2941.

[35]馮江,李濤,朱哲,等.絮體性狀實時圖像檢測系統的開發與應用[J].環境污染與防治,2008,191(10):40-43.

[36]宋小飛,晁永生.基于改進YOLOv5s網絡的機械零件目標檢測[J].組合機床與自動化加工技術,2023,65(8):84-88.

[37]趙衛東,施實偉,周嬋.基于ImageNet預訓練卷積神經網絡的圖像風格遷移[J].成都大學學報(自然科學版),2021,40(4):367-373.

[38]Zhao Z,Wang P,Lu W.Multi-layer fusion neural network for deepfake detection[J].IJDCF,2021,13(4):26-39.

[39]王冠博,楊俊東,李波,等.改進YOLO v4的火焰圖像實時檢測[J].計算機工程與設計,2022,43(5):1358-1365.

[40]梁秀滿,安金銘,曹曉華,等.基于CNN-Transformer雙流網絡的燒結火焰燃燒狀態分類[J].應用光學,2023,44(5):1030-1036.

(實習編輯:黃愛明)

Investigation of Aircraft Skin Defect Detection Based on Fusion Neural Network

ZHANG Deyin,HUANG Shaohan,ZHAO Zhiheng,LI Juntong,ZHANG Yuyao

(Institute of Electronic and Electrical Engineering,Civil Aviation Flight University of China,Guanghan 618307,China)

Abstract:The aircraft skin is damaged by multiple factors,such as atmospheric environment erosion,bird strike and so on.Flight safety is threatened by those factors.A skin defect detection method based on fusion neural network is proposed to solve the problems,such as time-consuming and insufficient manual inspection in aircraft skin in this paper.The Xception architecture is integrated into the YOLOv5 network,and the global channel attention mechanism is added to Backbone,and the channel space attention mechanism is added in Neck and Output so as to form a new fusion neural network based on the YOLOv5 network.The 8 503 images of aircraft surface defects collected are divided into training sets and test sets.After training,the new fusion neural network is verified by the test set,and the average accuracy of the five kinds of defects detection,including rivet peeling,rivet corrosion,skin peeling,skin crack and skin impact,are 0.960,0.928,0.931,0.934,0.948 respectively.And the overall recognition accuracy of the whole aircraft skin defects to the new fusion neural network is 0.950,the recall rate is 0.964,and the average accuracy rate is 0.957.The experimental results show that the new fusion neural network is effective for aircraft skin defect recognition.

Key words:aircraft skin defects;attention mechanism;deep learning;fusion neural network;object detection