英偉達方法:把客戶逼成敵人

賀乾明 邱豪

英偉達CEO黃仁勛。圖/視覺中國

8月下旬,英偉達召開例行全員會。當時英偉達股價隨著銷量大漲,市值穩定地回到萬億美元以上,員工手中股票的價值已經是年初的3倍多。英偉達CEO(首席執行官)黃仁勛提醒他們,不要太早激動,公司的市值會到2萬億美元。

全球只有蘋果、微軟、谷歌的市值到過2萬億美元,各自牢牢抓住十多億用戶。它們也全部都是英偉達成為萬億公司的原因。ChatGPT火爆后,它們向英偉達下了總額數十億美元的大訂單。

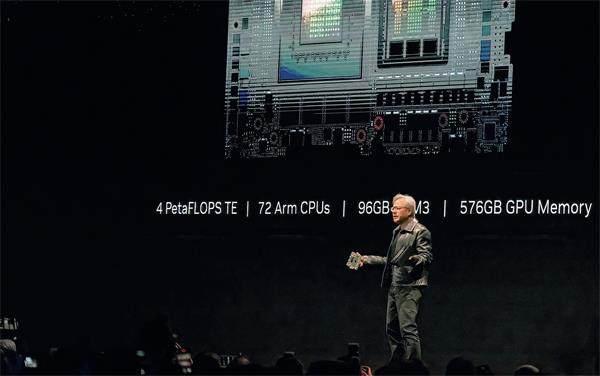

11月13日,英偉達發布了新款GPU H200,與上一代最大的差別是用了新款內存芯片,連計算能力都沒明確公布,其市值就應聲漲了700多億美元。英偉達稱已經給H200找到了買主——明年它會密集出現在亞馬遜、谷歌、微軟等公司的數據中心中。

在英偉達沖向2萬億美元的道路上,這些客戶還會繼續下大訂單,但也會和它直接競爭。11月16日微軟的Ignite大會是這種關系的直接體現,微軟一邊發布自研的AI芯片Maia100,一邊邀請黃仁勛到場宣布新的合作。

微軟之外,Meta、谷歌、亞馬遜、特斯拉等英偉達的大客戶,今年都投入更多資源研發AI芯片,甚至OpenAI都開始籌備芯片項目。

兩倍于LVMH的利潤率,大客戶們自研芯片的動力

英偉達成立至今30年,前20多年專精于游戲顯卡這一個小眾市場。加密貨幣帶來的巨大挖礦需求讓英偉達激活了顯卡銷量,英偉達的業績和市值因此躍升,不僅收入在2018年沖破百億美元、利潤率沖上30%,股價也在2016年到2018年10月間大漲800%。隨著比特幣在新冠疫情肆虐之際沖上6.8萬美元,英偉達的市值也逼近萬億美元,成為最值錢的芯片公司。

2023年3月發布的GPT-4點燃了整個人工智能行業。根據芯片研究機構SemiAnalysis獲取的信息,OpenAI用2.5萬張英偉達A100GPU訓練了三個多月,才做出GPT-4大模型。

A100是英偉達2020年發布的GPU。在GPT-4發布前幾個月,英偉達推出了H100GPU,把計算能力提升到A100的3倍,專門為Transformer架構(大模型的底層)做了優化——當時ChatGPT還沒有面世。

對于想要研發更強大模型的OpenAI和追趕OpenAI的公司,H100都是需要大量囤積的戰略資源,它立即變得供不應求。OpenAI發布GPT-4后,兩度因為GPU短缺停止付費用戶注冊。

埃隆·馬斯克(ElonMusk)說H100“比毒品都難買”。迫切需要算力的公司們,轉而訂購A100。受美國政府貿易限制,中國公司只能購買降低性能的A800和H800。這些GPU的產能也遠遠跟不上需求。

紅杉資本在今年9月稱,許多公司的增長瓶頸不是客戶需求,而是英偉達最新GPU的產能。

英偉達是設計公司,并不直接生產芯片,它需要請臺積電生產芯片,從其他公司采購高性能內存,再交給供應商組裝成一張卡。一顆H100的成本約3000美元,而英偉達賣3萬多美元,翻10倍:

英偉達向臺積電下訂單,用4納米的芯片產線制造GPU芯片,平均每顆成本155美元。

英偉達從SK海力士(未來可能有三星、美光)采購六顆HBM3(HighBandwidthMemory,高帶寬內存)芯片,成本大概2000美元。這是因為GPU處理大模型任務,還需要搭載比手機、電腦更大、數據傳輸速度更快的內存,才能保證效率。

臺積電芯片產線生產出來的GPU和英偉達采購的HBM3芯片,一起送到臺積電CoWoS封裝產線,以性能折損最小的方式加工成H100,成本大約為723美元。

H100被送到其他英偉達的供應商處,四顆或八顆組裝在一起,加上數據傳輸單元,做成服務器。

利潤豐厚的H100推動英偉達利潤率攀升到40%,超過了所有芯片同行,達到全球最大奢侈品集團LVMH的近兩倍。

英偉達高昂的利潤,就是它客戶的成本。為了借著大模型浪潮來抓住用戶、激活業務,許多大公司采購GPU后,不惜賠錢對外提供服務。GPT-4發布后,微軟將其用于必應搜索,讓用戶免費使用。

黃仁勛常說的“買得GPU越多,省得越多”成為過去式。大公司買得越多,英偉達賺的越多,它們虧損越多。一個顯而易見的選擇出現了:自研一款芯片,可能省的更多。

過去十多年,研發一款芯片的難度持續下降:臺積電、三星等代工廠存在,讓它們不用擔心芯片代工問題;芯片人才充分流動,降低了設計芯片的難度。

芯片研究機構SemiAnalysis的首席分析師迪倫·帕特爾(DylanPatel)說,自研一款類似微軟Maia100的AI芯片,每年的成本大概1億美元——對于研發費用每年上百億美元的大互聯網公司來說,并不算什么。

ChatGPT帶動了大模型熱潮,大公司不用擔心使用場景問題。咨詢機構Gartner今年8月預測,全球AI芯片市場規模隨著ChatGPT火熱快速增長,到2027年就會達到近1200億美元,是去年的2.7倍。

大公司們想在AI芯片研發能力上追上英偉達,投入五年到十年也不一定能實現。不過它們只需要花英偉達同樣的成本,做出十分之一的效果,就已經有利可圖了。

訓練更強的大模型,需要很多GPU。“訓練一個對標GPT-3.5的大模型,用2000張至3000張A100GPU就可以。但想要訓練對標GPT-4的大模型,上萬張GPU只是一個入場券。”一家中國科技公司的大模型負責人說。

訓練完成還不是結束。當用戶使用大模型的時候,這些企業得靠GPU調動大模型——即大模型推理。大模型要處理用戶輸入的問題,基本上每個字都要單獨跑一遍大模型。給出回復時,類似的情況還要再來一遍。參數上千億的大模型,每次跑一遍都要調用多張GPU。

多位大模型從業者估算,如果千億參數或更大的人工智能模型被廣泛使用,大模型的訓練成本和推理成本會達到2∶8,甚至1∶9。推理GPT-4或更強的大模型,基本上離不開英偉達高性能的GPU。

《財經》了解到,參數更大的大模型推理會產生巨大的算力需求,而且不可能在本地設備上實現(70億參數的大模型就需要14G內存,超出了幾乎所有手機的硬件配置和絕大多數電腦配置),不少英偉達員工因此相信公司市值會繼續上升。

科技公司自研AI芯片,出發點都是推理參數較小的模型,然后再進一步擴展。阿里巴巴的含光800、百度的昆侖芯片都是推理芯片,谷歌、亞馬遜、特斯拉做AI芯片,也是從推理入手,然后再做訓練芯片。

自研芯片不用向英偉達交稅,性能低一些也能節省成本。根據迪倫·帕特爾等人的測算,按照谷歌的報價,使用其最新的AI芯片TPUv5e在訓練、推理參數少于2000億的大模型時,成本低于用A100或H100。

大公司通常先在自己的業務中使用自研AI芯片,比如谷歌的TPU最先支持的是谷歌翻譯,最新的TPUv5e首先用在了GoogleBrad和一系列用大模型改造的業務中(比如Gmail)。微軟Azure芯片部門副總裁拉尼·博卡爾(RaniBorkar)11月16日在發布會上說,微軟正在必應、Office等業務中測試自研的AI芯片Maia100,預計明年初投入使用。

芯片經過內部測試后,大公司會通過云計算平臺對外提供服務,與英偉達爭搶客戶。11月8日,谷歌投資的Anthropic宣布大規模部署TPUv5e,處理其大模型Claude的推理工作,這些任務原本屬于英偉達的GPU。

英偉達2萬億美元攻防戰

“我們不需要假裝公司一直處于危險之中。事實上,我們一直處于危險之中,而且我們深有體會。”11月9日,黃仁勛在一場活動中說。

芯片行業先驅、英特爾聯合創始人安迪·格魯夫(AndyGrove)曾說“成功滋生自滿,自滿導致失敗,只有偏執狂才能生存”。英偉達也是硅谷最偏執的公司之一,從管理風格到戰略藍圖都是。

大約十年前,黃仁勛在俄勒岡州立大學向臺下的畢業生傳輸經驗:“當有人全力以赴時,他們就能做你做不到的事情。全力以赴,不留后手。”他從不對沖風險,也不會多重押注,只在自己覺得對的路線上全力押注。

從2006年開始,為了讓GPU在游戲、電影之外也有用武之地,英偉達將大筆資金投入到CUDA研發中,投資人和華爾街的分析師們不理解,為什么要給游戲顯卡不斷增加計算性能,讓它們越來越貴和難賣?

直到大約十年后,人工智能和深度學習展現了商業價值,英偉達早期投資得到認可,CUDA成了英偉達隱形的護城河。

為了顧及手機、筆記本電腦的功耗,蘋果、英特爾等競爭對手的芯片常常一年只能提升不到20%。而英偉達的AI芯片只考慮性能這一個目標。

黃仁勛不滿足“摩爾定律”每18個月性能翻一番,他提出了更快的“黃氏定律”,并要求團隊以此為目標,兩年發布一款新品,保持計算性能的絕對優勢。明年3月,英偉達將發布下一代產品GPUB100,預計性能會大幅度超過H100和加速追趕的所有競爭對手。

雖然從P100、V100到A100,功耗都在250W到400W之間,而H100的功耗直接來到了700W,是FPGA或ASIC路線下AI芯片功耗的數十倍。但更強的計算性能,讓英偉達的GPU擁有著不可替代的地位。

面對更激烈的市場競爭,英偉達加快了新品推出的速度。11月13日剛發布的H200,是英偉達第一次在兩代旗艦產品中插入一個“過渡款”。據SemiAnalysis的信息,英偉達將在2025年發布B100的下一代產品,發布周期從之前的兩年一更,加速到了一年一更,還會延續下去。

芯片市場需求和產能經常錯置,但黃仁勛從不在意周期。一旦有重要且搶手的零部件,他就會下單鎖定產能,哪怕冒著用不完的風險,也要確保自身供應,擠壓競爭對手。

目前AI芯片供應瓶頸主要是CoWoS先進封裝和HBM3,英偉達包下了臺積電約六成CoWoS產能,向HBM的三家供應商SK海力士、三星和美光下了巨額訂單。

根據英偉達財報,截至今年7月底,英偉達賬上還有價值111.5億美元的訂單、庫存和產能采購承諾,另外還有38.1億美元的供應合約預付款——同行里沒有第二家公司有這么多的庫存和預付款。

英偉達的大手筆采購,讓供應商都感到擔心。臺積電董事長劉德音在今年二季度業績會上說,看不清楚AI的火熱需求是不是短期泡沫。但英偉達的訂單就在那里,臺積電只能選擇大幅擴產跟上。

在英偉達的一再追單下,臺積電已經計劃將明年的CoWoS產能提高到3.5萬片/月、同比增長120%。

這樣極致的供應鏈掌控策略刻在英偉達的基因里。1997年,黃仁勛向臺積電下了1.27億美元的代工訂單。臺積電創始人張忠謀每隔一段時間就要回訪,重聽一遍黃仁勛的業務講解、確保他真的需要這么多晶圓——那年英偉達的全年營收只有2700萬美元。

英偉達還拿出了奢侈品行業慣用的“配貨”策略。渠道商和客戶們想要H100、A100這樣的旗艦芯片,就得先買夠一定量的L40S等適合更小模型的推理芯片,無形當中將競爭對手從夠得到的市場趕走。

地緣政治是英偉達面前最大的阻礙。上一財年,中國市場為英偉達貢獻了47%的收入。美國政府在去年和今年10月兩度收緊高性能芯片出口,英偉達是最主要的限制對象。

英偉達的反擊就是貼著紅線出新品。第一輪管制后不久,英偉達就將A100的帶寬縮水,交出既符合規定,同時不影響算力的中國特供版芯片A800,接著在半年內繼續交出旗艦芯片H100的替代版本H800。

今年11月初,美國更新芯片禁令不到一個月,英偉達又拿出了符合新要求的H20GPU。雖然H20單卡算力只有296TFLPOS,是中國公司頂級AI芯片的57%,但更高的內存、帶寬都保證了它可以串聯起來使用,買得夠多就依然有很強的競爭力。英偉達股價跟著上漲近10%。

把客戶的客戶變成自己的客戶

全球的萬億美元公司,除去沙特阿美,都是黏住幾億甚至幾十億消費者的科技公司。

英偉達是當中異類。它的品牌長期只覆蓋少數PC游戲用戶,現在50%收入來自寥寥數個大型云計算公司和互聯網巨頭:亞馬遜、微軟、Google、Meta、字節跳動、阿里巴巴等。

大公司購買英偉達的處理器有一部分是自用,但更多是將其通過云計算平臺租給其他客戶。客戶關系最終還是留在這些云計算平臺公司手上。如果有一天,它們有了性能足夠強的產品,隨時可以換掉英偉達。

英偉達靠著CUDA綁定了數百萬AI開發者,吸引著大型云計算公司采購它的GPU。如知名分析師本·湯普森(BenThompson)所說:“英偉達既不是一家硬件公司,也不是一家軟件公司:它是一家將兩者融為一體的公司。”

現在這套邏輯依然成立,在人工智能前沿探索中,CUDA仍然讓英偉達的GPU具備優勢。但現在黃仁勛還要再進一步,直接把云計算平臺的客戶變成自己的。

今年3月,GPU最稀缺的時候,英偉達推出云計算服務DXGCloud:英偉達把賣給云計算公司的GPU租回來,由英偉達員工進一步優化,再出租給需要GPU算力的客戶。

一來一回,云計算平臺承擔了數據中心的建設成本,客戶卻去了英偉達。但微軟、谷歌、甲骨文依然加入了英偉達的計劃。作為回報,它們很快就有了最稀缺的H100。全球最大的云計算供應商AWS拒絕合作,直到今年7月才上線了H100算力出租服務。

“這是我們有史以來最大、最重要的業務模式擴展。”黃仁勛說,“英偉達不僅為云計算公司提供GPU,還把自己推向市場。”

OpenAICEO山姆·阿爾特曼(SamAltman)近期接受采訪說,雖然今年GPU緊缺,但明年情況會更好。因為谷歌、微軟等公司自研的新款AI芯片將會投入市場。OpenAI已經開始測試微軟發布的AI芯片。

“這就是資本主義的魔力,現在很多公司都想成為英偉達。”阿爾特曼說。而英偉達的步步緊逼,也沒有給它們其他選擇。