姿態估計中注意圖特征增強網絡

任春賀,毛 琳,楊大偉

(大連民族大學 機電工程學院,遼寧 大連 116650)

2D人體姿態估計是指給定一張靜態的RGB圖像,準確地識別和定位出圖像中的人體關鍵點(比如頭,左手,右腳等)的位置,以便通過連接相鄰關節可以恢復人體骨骼的姿態。在監控視頻[1]場景中,常出現人體部分區域因姿態導致的關鍵點自遮擋或重疊的情況,從而導致在特征提取過程中被遮擋的部位丟失關鍵信息。由于無法準確地提取包含人體所有關鍵點的圖像信息,這對人的動作行為監測帶來了困難,可能無法及時阻止某些意外情況發生。這凸顯了特征提取在解決人體姿態遮擋問題方面的不足。

國內外大量學者在提取特征方面采用兩種方法來解決上述問題,一是添加有效的卷積器以增強特征表達,二是設計合理的注意力機制以改善特征效果。為了充分利用卷積神經網絡(Convolutional Neural Network,CNN)[2]作為姿態估計的網絡模型,可以通過添加卷積模塊的方法對網絡進行適當改進。Lin等人[3]提出了特征金字塔網絡(feature pyramid networks,FPN),該網絡雖能產生多尺度的特征表示,但因不同尺度特征之間沖突信息的存在,使得遮擋部位的關鍵點難以被檢測,姿態估計精度不高;Szegedy等人[4]提出了多尺度融合網絡,它能選擇多層特征進行融合再進行預測,但由于有些尺度的特征語義信息缺乏豐富性,很難檢測出人體遮擋部位的關鍵點;Dumoulin等人[5]提出了轉置卷積網絡。該網絡雖然只執行了常規的卷積操作,但卻能恢復特征圖的空間分辨率。然而由于該卷積矩陣的稀疏性,會產生大量的冗余特征信息,難以檢測遮擋部位的關鍵點;Newell等人[6]提出了堆疊沙漏網絡(stacked hourglass networks,SHN),利用沙漏模塊來處理和整合各個尺度的特征,但此模塊通過堆疊會使得部分特征信息丟失,導致人體遮擋部位的部分關鍵點難以被檢測;Yang等人[7]提出了一種輕量化的金字塔殘差模塊(Pyramid Residual Module,PRM)來代替沙漏模塊來學習不同尺度上的特征,但隨著層數的增加,很容易丟失原始特征信息,使得難以定位檢測出被遮擋部位的人體關鍵點;Sun等人[8]提出了一種高分辨率網絡HRNet,通過多尺度特征融合以獲得更好的語義特征。但越多地融合特征,就會產生越多的信息冗余,可能會誤導關鍵點定位和識別。另一種方法是通過在網絡中引入注意力機制的方式讓模型知道圖像中不同局部信息的重要性。Max等人[9]提出了空間變換網絡(Spatial Transformer Networks,STN),該網絡引入了一個可學習的空間維度轉換模塊,使模型具有空間不變性,但它僅考慮局部區域的空間變換;Hu等人[10]提出了通道注意力網絡SENet(Squeeze-and-Excitation Network),從通道維度上得到權重矩陣對特征進行重構,但它僅考慮通道方面的依賴性,沒有充分利用空間信息,同時也忽略了使用最大池化操作進一步細化特征;Wang等人[11]提出了殘差注意力網絡(Residual Attention Network),它是兼顧通道抽象特征和空間位置特征信息的混合注意力機制,但其參數量和計算量較大。

綜上,在人體姿態估計任務中,本文以深度殘差網絡ResNet-50作為特征提取主干網絡,提出一種結合混合注意力機制的姿態估計特征增強網絡(Pose Estimation Attention Feature Enhancement Network,PEANet)。該網絡是將混合注意力模塊插入到ResNet-50主干網絡的每個Bottleneck Block層中,在減少網絡的部分復雜度和參數的同時提高了姿態估計的精確度,以解決人體姿態關鍵點自遮擋的問題。

1 PEANet注意圖特征增強網絡

1.1 關鍵點自遮擋問題分析

關鍵點自遮擋是指因人體姿態具有多變性,如可能呈現站立、行走、半蹲、正坐等姿態,導致自身的一部分關鍵點遮擋住另一部分關鍵點。這種遮擋容易造成人體重要部位特征信息的缺失,導致人體關鍵點預測信息不完整,在姿態估計任務中出現關鍵點的漏檢,從而降低姿態估計性能。在現實生活中,若能提升因自遮擋現象而造成姿態估計不準確的網絡性能,就能較準確地識別出圖像或視頻中行人的動作,在很大程度上及時阻止意外的發生。因此,針對此問題進行深入的研究具有重大意義。

由于原主干網絡只采用卷積模塊進行特征提取操作,沒能對特定的特征進行篩選,浪費了大量的計算資源。因此,本文提出對主干網絡的每個Bottleneck Block層添加注意力,這樣既能執行特征提取操作,又能根據需求篩選出具有有效信息的特征圖。

本文選擇注意力機制來解決關鍵點的自遮擋問題。注意力機制可以對人體關鍵點的空間關系進行建模,生成的注意力圖只依賴圖像特征,可以關注不同的目標區域。通道注意力利用卷積模塊學習特征圖各中各個特征通道的重要程度,雖然不同的通道可獲取不同的特征圖,但由于自遮擋的存在,有的通道實際上生成的是具有無效信息的特征圖,此時可通過通道權重的比例調節,重新分配特征圖在通道上對遮擋的分析能力,以舍棄具有干擾信息的特征圖;在空間上有時也會存在自遮擋的現象,此時可再利用空間注意力的特點,使網絡更加關注圖像中起決定作用的區域而忽略無關緊要的區域,通過空間注意圖進而確定那些被忽略的關鍵點。

以Poseur[12]為研究對象,經過圖像處理后人體姿態關鍵點自遮擋的效果示意圖如圖1。其中,實心點代表人體部位的關鍵點,用線條將關鍵點連接起來是為了描繪出人體姿態,橢圓圈用于標識預測錯誤的位置,矩形框用于標識預測正確的位置。圖1a~1c分別為原圖、錯誤檢測圖和正確檢測圖。第一行圖片是男人在滑板上沖浪的姿態,因半蹲姿態本身造成的自遮擋,導致其左膝蓋關鍵點識別錯誤;第二行圖片是小男孩打棒球的姿態,因屈膝姿態本身造成的自遮擋,導致右肘關鍵點識別錯誤。

a)原圖 b)錯誤檢測圖 c)正確檢測圖圖1 關鍵點自遮擋現象示意圖

關鍵點自遮擋也會對其他關鍵點的預測產生負面影響,本文引入的注意力機制可使生成圖像的細節更豐富,加強網絡對人體關鍵點的關注,進而增強網絡對關鍵點自遮擋的處理能力。

1.2 注意力機制

注意力機制源于對人類視覺的研究,通常分為:通道注意力[10]和空間注意力[13]。它是通過權重參數分配來決定哪些是需要關注的重要特征信息,從而有效選擇信息。為了更好地增加人體姿態關鍵點信息的權重,注意力機制被引入到本文的網絡架構中。

通道注意力機制可以在保留每個通道平均特征的同時突出其主要特征,忽略無用特征,使得網絡更加關注人體姿態的關鍵點位置。該注意力主要是將特征圖在空間維度上進行壓縮,通過兩種池化得到不同的特征映射,最終經過元素級運算得到通道級特征。

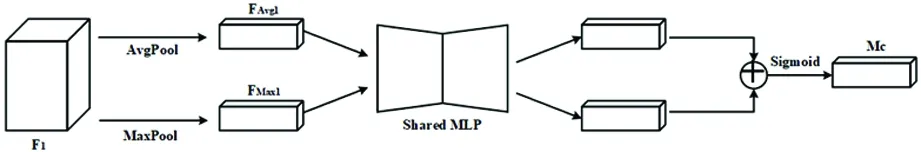

通道注意力模塊(Channel Attention Module,CAM)如圖2。通道注意力機制可以表達為

圖2 通道注意力模塊結構圖

FAvg1=AvgPool(F1) ,

(1)

FMax1=MaxPool(F1) ,

(2)

Mc=σ(MLP(FAvg1⊕FMax1)) ,

(3)

F2=Mc?F1。

(4)

其中,給定一個輸入特征F1。首先將輸入特征圖分別經過平均池化和最大池化得到特征FAvg1、FMax1;然后將兩個不同的特征圖送入MLP得到不同的輸出特征;接著將兩個不同的輸出特征進行元素級求和運算;再經過一個用σ表示的Sigmoid激活函數,得到通道注意力權重系數Mc;最后將輸入特征F1與通道注意力權重系數Mc進行元素級相乘運算,得到輸出后的通道注意力特征F2。

空間注意力機制主要關注圖像中的人類區域,同時更加關注人類姿態的可見關鍵點位置。該注意力主要是將特征圖在通道維度上進行壓縮,通過兩種池化將得到不同的特征映射先拼接再降維,最終經過元素級運算得到空間級特征。

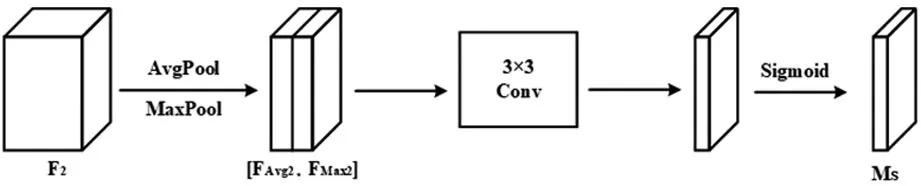

空間注意力模塊(Spatial Attention Module,SAM)如圖3。空間注意力機制可以表達為

圖3 空間注意力模塊結構圖

[FAvg2,FMax2]=AvgPool(F2)⊕MaxPool(F2),

(5)

Ms=σ(f3×3[FAvg2,FMax2]) ,

(6)

F3=Ms?F2。

(7)

其中,本模塊的輸入特征為通道注意力輸出的特征F2。首先將輸入特征圖分別經過平均池化和最大池化得到特征FAvg2、FMax2;再將兩個特征圖在通道維度上進行拼接操作;然后將其輸入到大小為3×3的卷積層f3×3中,對特征通道進行降維操作;再經過一個用σ表示的Sigmoid激活函數,得到空間注意力權重系數Ms;最后將輸入特征F2與空間注意力權重系數Ms進行元素級相乘操作,得到輸出增強后的空間注意力特征F3。

由于因人體姿態本身存在的關鍵點自遮擋現象,使得圖像丟失部分關鍵特征信息,本文采取將通道注意力和空間注意力結合的特征增強方法,集成到CNN中,以捕獲特征之間的通道和空間相關性,學習使用全局信息來選擇性地強調信息豐富的特征,并抑制無關特征,從而加強CNN生成的表示,進而提高人體姿態估計網絡處理自遮擋問題的性能。

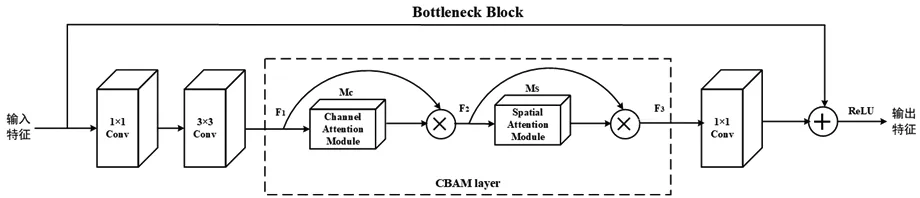

1.3 特征增強方法

為解決人體姿態自遮擋的問題,本文引入輕量級的混合注意力機制CBAM模塊[14]作為特征增強方法,以實現雙重注意力的作用,進一步增強特征提取網絡的表達能力。CBAM模塊將通道注意力模塊和空間注意力模塊以串行的方式插入到ResNet-50每個Bottleneck Block層,能夠滿足本文理論需求。構造新殘差注意力網絡如圖4。

圖4 殘差注意力網絡結構圖

將CBAM模塊放置在3×3卷積層之后,由于該卷積層擁有較少的通道,相應地該模塊引入的參數量也減少了。通過這種改進,可以自適應地提取重要特征的同時抑制或忽視不必要的特征,增強CNN的特征提取能力和對自遮擋任務的適應能力。

1.4 PEANet網絡

PEANet網絡的基本思想是將殘差注意力網絡替代原始深度殘差網絡ResNet-50的每個Bottleneck Block層,作為新的主干網絡處理輸入圖像。連接層中殘差分支采用的卷積均增加了同時關注信道和空間關系的混合注意力機制模塊,相比于SENet只關注通道注意力機制,可以取得更好的結果。采用注意圖特征增強網絡加強對深度信息的預測。輸入圖像經姿態估計主干網絡得到增強的輸出特征定義為

Y=H(X) 。

(8)

式中:X表示輸入特征量;H表示主干網絡中普通卷積和混合注意力操作;Y表示主干網絡輸出的增強特征圖。PEANet網絡結構圖如圖5。

圖5 PEANet網絡結構圖

PEANet的目的是在經過圖像處理后的單人圖像中預測人體關鍵點坐標。首先將結合通道注意力和空間注意力的混合注意力模塊與現有的主干網絡ResNet-50堆疊在一起,構成新的注意圖特征增強網絡。通過在每一層的局部感受野內融合空間和通道信息來構建信息特征,提高整個特征層次的空間編碼質量來加強CNN的表征能力,自適應地重新校準通道和空間特征響應,提取多級特征映射;然后將增強后的輸出特征送入全局平均池化(Global Average Pooling,GAP)層,可快速提取全局性的上下文信息,有利于減少大量參數,防止過擬合;再經過一個全連接(Fully-Connected,FC)層,通過主干網絡輸出獲得密集的特征映射預測粗糙的關鍵點坐標;最后送入Transformer的關鍵點編碼器和查詢解碼器網絡中,以獲得關鍵點的最終特征,每個特征被送入到線性層中,預測相應的關鍵點坐標,得到最終的姿態估計結果。

注意圖特征增強網絡輸出的特征為Transformer網絡提供更好的輸入,有助于網絡間的信息傳遞,從而解決因人體姿態產生的自遮擋問題,提高姿態估計網絡對人體關鍵點的定位能力。

2 實驗結果分析

2.1 實驗設置

本實驗的硬件配置為一張NVIDIA GeForce RTX 2070 Super顯卡,在Ubuntu16.04操作系統中,使用Python編程語言,采用Pytorch 1.7.0版本的深度學習框架對網絡模型進行訓練和驗證測試。采用COCO 2017公開數據集,其中針對人體姿態估計任務的每個人體目標標注17個關節點的信息。在仿真中使用COCO訓練集中7 392張圖片進行訓練,使用COCO驗證集中的1 250張圖片進行驗證和測試。在COCO數據集下,訓練采用AdamW[15]優化器,批尺寸設置為4,迭代次數為325次,設置初始學習率為1.25e -4,衰減權重為1.25e -5。

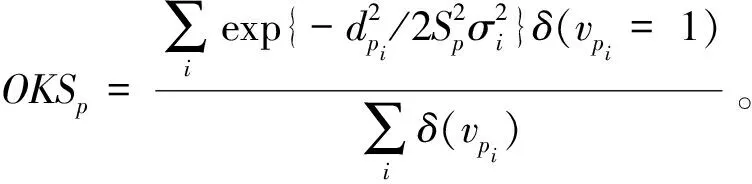

2.2 評價指標

本文使用的是COCO 2017公開數據集,以關鍵點相似性(object keypoint similarity,OKS)[16]作為人體姿態估計的評價標準,它是通過計算人體關鍵點的位置距離來檢測關鍵點的相似度。該指標定義為

(9)

式中:p為真值人的ID;i為關鍵點的ID;dpi為每個人的真實關鍵點位置與預測關鍵點位置的歐氏距離;Sp為當前真值人所占面積的平方根;σi為第i個關鍵點的歸一化因子;vpi為第p個人的第i個關鍵點是否可見;δ為克羅內克函數,滿足兩個自變量相等時取值為1,不滿足時取值為0。

采用人體關節點預測的平均精度(average precision,AP)(OKS=0.50,0.55,…,0.95時10個預測關鍵點精度的均值)作為主要評價指標,以平均召回率(average recall,AR)(OKS=0.50,0.55,…,0.95時10個預測關鍵點召回率的均值)作為輔助評價指標。AP表示每個關鍵點在測試數據集上,檢測結果的平均精度。當給定一個OKSp的閾值s時,算法精度(AP@s)可定義為

(10)

式中:p為真值人的ID;δ為克羅內克函數;s為閾值;OKSp為式(9)中所求數值,通常在[0,1]的范圍內。當OKSp大于設定閾值s時,表示預測的人體關鍵點正確,否則預測錯誤。

2.3 仿真結果與分析

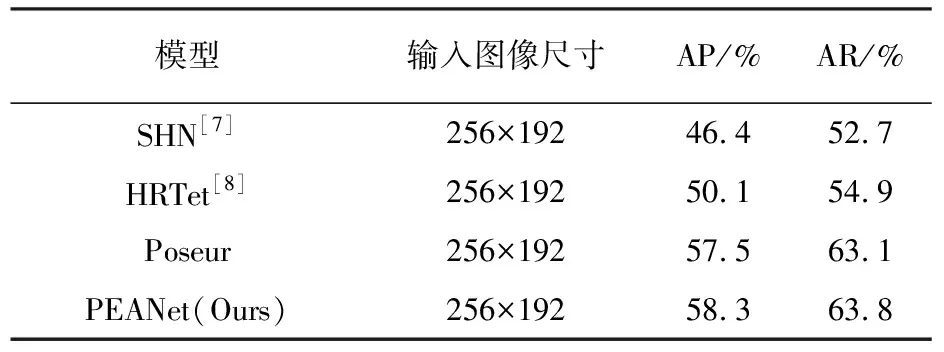

采用COCO 2017數據集進行了實驗仿真驗證,處理模型的輸入圖像尺寸均為256×192,以便于與其他方法進行對比。在相同的輸入圖像尺寸、迭代周期和學習率下,對比了PEANet與其他三種姿態估計網絡模型的實驗結果。實驗結果對比結果見表1。

表1 實驗結果對比

通過在原網絡中插入CBAM模塊,可以使PEANet更加關注與人體姿態相關的特征。其中,通道注意力模塊可以自動學習每個通道的重要性,使網絡更加關注對姿態估計有貢獻的通道,抑制對無關信息的響應;空間注意力模塊可以自適應地調整網絡對不同空間位置的關注程度,使網絡更加關注對姿態估計有貢獻的區域,提高對關鍵點的定位精度。通過表1的仿真結果表明,本文提出網絡模型PEANet在主要評估指標上相比于原網絡模型均有一定的提升,平均精度(AP)提升了0.8%,平均召回率(AR)提升了0.7%,均取得了較好的準確度。因此,可以說明本文在網絡結構設計中加入用于增強卷積神經網絡性能的混合注意力機制的有效性,效果提升顯著。本文引用的模塊能夠自適應地調整網絡對不同通道和空間位置的關注程度,使網絡更加適應不同姿態的變化和復雜背景的干擾,有利于提升關鍵點自遮擋的姿態估計精度[17]。

2.4 可視化結果

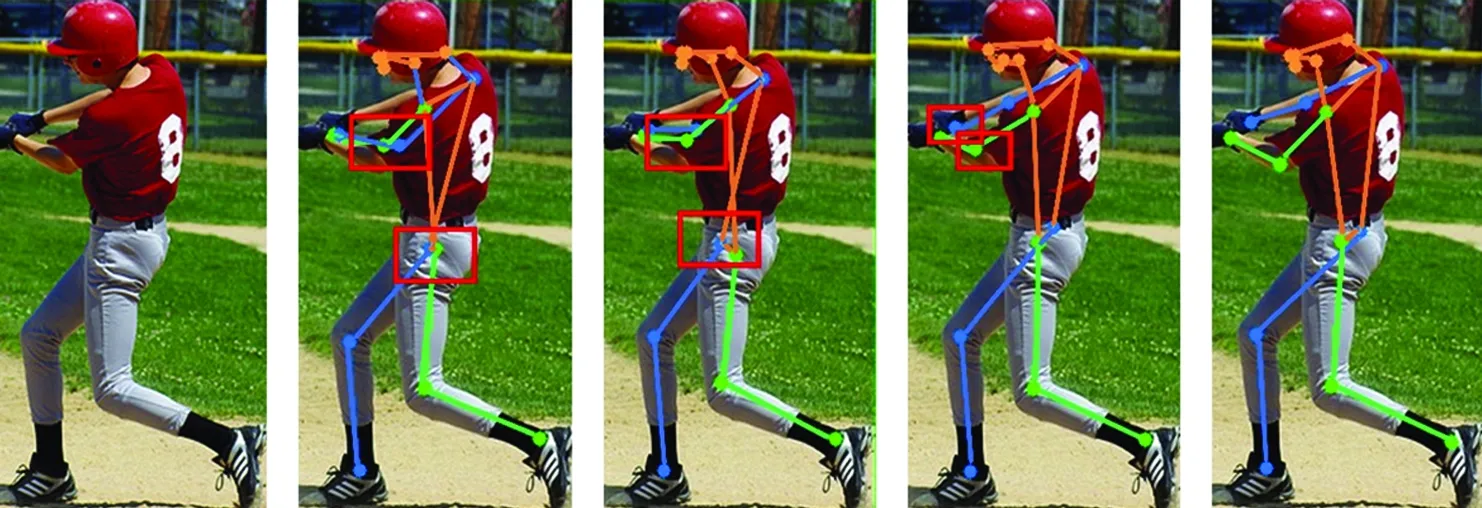

為四種網絡模型在人體姿態估計實驗中可視化的預測結果如圖6。為便于觀察姿態關鍵點的定位,本文已對輸入圖像進行適當的圖像處理。

a)原圖 b)ShuffleNetv2 c)MobileNetv2 d)Poseur e)PEANet圖6 在四種網絡模型下的可視化對比

其中圖6a為輸入原圖,圖6b~6e分別為SHN、HRTet、Poseur和PEANet模型下輸出的姿態,這四種網絡模型均為同一數據集和同一輸入圖像尺寸下的測試結果。從圖6b和圖6c中可以明顯看出,這名棒球運動員在遮擋的右臂和右腿部位均存在關鍵點誤檢的現象(用方框表示)。同樣對比圖6d和圖6e的姿態可視化結果,也可以明顯地看出本文所提方法在人體關鍵點識別的準確性上更優于原方法。因此,相較于其他三種方法,當2D人體圖像出現關鍵點自遮擋的現象時,利用本文方法能夠較為準確地檢測出關鍵點的位置,可以提高人體姿態識別的準確性。

3 結 語

針對姿態估計網絡中因人體姿態本身導致關鍵點自遮擋問題,提出注意圖特征增強網絡。在主干網絡的每個Bottleneck層添加混合注意力機制,既能通過通道注意模塊幫助網絡更好地捕捉到重要的特征通道,以增強遮擋目標的特征表達,又能通過空間注意模塊幫助網絡更好地對重要空間位置特征的關注,以助于遮擋部位的特征恢復和目標定位,進而能夠提取更加準確的深度特征圖。與原網絡模型相比,本文所提網絡提高了姿態關鍵點定位的準確性,對2D人體姿態關鍵點的檢測有顯著提升能力,能夠獲取到較好的姿態估計結果,適用于家庭監護和天眼監控等應用場景。