基于空洞全局注意力機制的近紅外圖像彩色化方法

高美玲,段 錦,趙偉強,胡 奇

〈圖像處理與仿真〉

基于空洞全局注意力機制的近紅外圖像彩色化方法

高美玲,段 錦,趙偉強,胡 奇

(長春理工大學 電子信息工程學院,吉林 長春 130012)

針對目前卷積神經網絡未能充分提取圖像的淺層特征信息導致近紅外圖像彩色化算法存在結果圖像局部區域誤著色及網絡訓練不穩定導致結果出現模糊問題,提出了一種新的生成對抗網絡方法用于彩色化任務。首先,在生成器殘差塊中引入自行設計的空洞全局注意力模塊,對近紅外圖像的每個位置理解更加充分,改善局部區域誤著色問題;其次,在判別網絡中,將批量歸一化層替換成梯度歸一化層,提升網絡判別性能,改善彩色化圖像生成過程帶來的模糊問題;最后,將本文算法在RGB_NIR數據集上進行定性和定量對比。實驗表明,本文算法與其他經典算法相比能充分提取近紅外圖像的淺層信息特征,在指標方面,結構相似性提高了0.044,峰值信噪比提高了0.835,感知相似度降低了0.021。

彩色化;近紅外圖像;生成對抗網絡;空洞全局注意力;梯度歸一化

0 引言

近紅外光是介于可見光和中紅外光之間的電磁波,其波長范圍為780~1000nm。近紅外成像技術穿透性能非常高,即使在惡劣天氣下也能獲得細節豐富的圖像。但是與符合人類視覺系統的彩色圖像相比,近紅外圖像缺少顏色信息,人類對灰度圖像的敏感度低于彩色圖像敏感度,且近紅外圖像具有可見光圖像不具備的紋理細節特征,故需要將其彩色化來增加色彩信息,使近紅外圖像能更符合人類的視覺感官。

目前針對近紅外圖像彩色化算法主要分為兩大類,一類是基于參考圖像的顏色像素匹配方法,另一類是基于深度學習的信息特征映射方法。

基于參考圖像的顏色像素匹配方法需要將近紅外圖像與參考圖像轉換到特定顏色空間,利用各像素級進行映射實現圖像彩色化。主要分為兩類,一類是局域顏色拓展著色,另一類是顏色傳遞著色。針對局域顏色拓展著色,戴康[1]利用圖像的局部馬爾可夫性質通過最小化相鄰像素間的顏色區別實現著色。Musialski[2]等人實現個性化用戶輸入偏好的物體顏色信息以實現圖像的彩色化;針對顏色傳遞著色,Welsh[3]等人利用查找匹配像素的方式實現近紅外圖像的顏色遷移。Reinhard[4]等人提出色彩遷移公式,在CIELAB(commission international eclairage LAB, CIELAB)顏色空間轉換進行著色。以上兩種方法中均需要一張特定的參考圖像作為輸入,且顏色傳遞方法需要人工操作進行上色,生成結果因素復雜且操作量較大。

基于深度學習的信息特征映射方法,通常將灰度圖像和可見光圖像兩個不同域作為網絡的輸入,兩個域的圖像不斷地通過卷積神經網絡進行特征提取,網絡不斷地進行兩個域之間的特征學習,進而實現近紅外圖像彩色化。主要分為兩類,一類是卷積神經網絡著色,另一類是生成對抗網絡著色。針對卷積神經網絡著色,馮佳男[5]等通過卷積神經網絡將低級特征與高級特征進行融合著色實現圖像彩色化,但由于近紅外圖像淺層特征與深層特征進行融合會導致淺層特征信息被覆蓋,從而邊緣漫色問題依舊存在。Cheng[6]等利用色度分量和聯合雙邊濾波結合得到彩色化結果,但生成效果不佳;針對生成對抗網絡著色,Zhu[7]等人提出雙向循環生成對抗網絡模型,引入雙向循環一致損失函數更好地實現圖像彩色化,但由于生成對抗網絡因陡峭的梯度空間導致網絡訓練不穩定,使得該方法彩色化結果出現模糊現象;Deblina[8]等人提出DUNIT網絡,借用無監督框架完成黑天到白天的轉換及目標檢測兩大視覺任務,但結果圖像紋理細節不清晰。萬園園[9]等人提出的UNIT和GAN相結合實現灰度圖像彩色化,在一定程度上提升了彩色化效果,但錯誤著色、模糊問題依舊存在。

目前已有的配對并標注好的近紅外-可見光圖像數據集稀少,這為近紅外圖像彩色化任務增添了難題。但生成對抗網絡著色采用的是無監督學習,無需成對圖像就能完成基本的著色任務,且獨特的網絡結構和訓練機制能更好地學習建立近紅外圖像與可見光圖像之間的映射關系,使得生成對抗網絡結構在大多數視覺任務中廣泛應用,如圖像超分辨率[10-11],圖像分割[12-13]及目標識別[14-15]等。

受此啟發,本文設計了一種新的近紅外圖像彩色化生成對抗網絡結構,將空洞全局注意力機制和梯度歸一化相結合完成近紅外圖像彩色化任務。第一,為解決彩色近紅外圖像中出現的局部區域誤著色問題,本文結合空洞卷積模塊和全局注意力模塊的優勢,自行構建了一個名為空洞全局注意力機制模塊,該模塊利用空洞卷積模塊不同擴張率實現不同感受野下同等特征圖的信息,解決近紅外圖像特征感受野受限制的問題,并結合全局注意力機制模塊中通道和空間兩路注意力操作來解決上下級近紅外圖像特征理解不充分、淺層特征提取不足問題。在生成器網絡中將空洞全局注意力模塊融入到殘差塊中,用來充分提取近紅外圖像特征并反卷積進行著色。第二,為解決彩色近紅外圖像出現的模糊問題,本文在判別網絡中將梯度歸一化代替批量歸一化,克服了批量歸一化模塊在訓練過程中不穩定的問題,提高了彩色近紅外圖像的生成質量。

1 空洞全局注意力機制彩色化GAN模型

1.1 生成器

本文模型生成器在ResNet網絡殘差塊基礎上引入了空洞全局注意力機制模塊(dilated global attention module, DA Block),該模塊充分結合了空洞卷積模塊和全局注意力模塊的優勢,解決了近紅外圖像淺層特征理解不充分的問題;利用空洞卷積模塊的優點解決生成對抗網絡淺層特征圖感受野受限制,不能獲取近紅外圖像全部細節信息的缺陷;利用全局注意力模塊的優點解決近紅外圖像全局上下文特征信息理解不充分、局部區域誤著色問題,通道注意力模塊引入全連接進行降維并提取近紅外圖像中更重要的細節信息,空間注意力模塊引入池化操作提取近紅外圖像不同特征并增強特征多樣性,使得近紅外圖像更能充分理解上下文信息,著色結果準確率顯著提升。生成器結構如圖2所示,空洞全局注意力機制模塊如圖3所示,網絡結構如圖4所示。

1)空洞卷積模塊

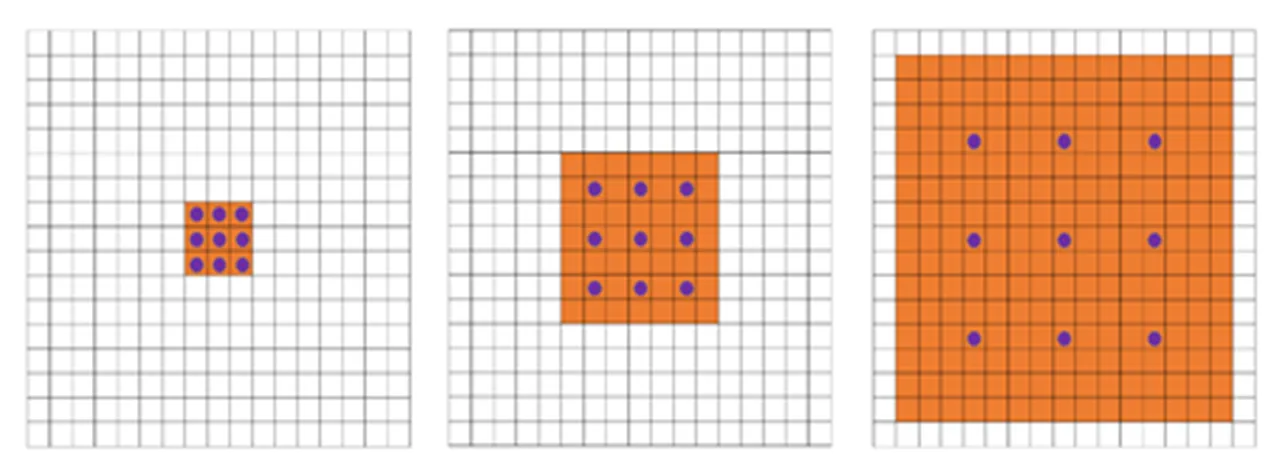

空洞卷積是指在卷積核元素之間填充0來擴大卷積核的過程。空洞卷積如圖5所示。

若為擴張率,為原卷積核大小,則加入空洞卷積后尺寸為=+(-1)(-1)。比如=1、2、4時感受野如圖6所示。

從圖6中可以看出空洞卷積可以增大輸出單元的感受野且不會增大卷積核大小,帶有多個不同空洞率的卷積進行疊加時不同的感受野可以帶來多尺度信息,獲取上下文多尺度信息。本文基于TriddentNet[17]的思想,通過空洞率分別為1、2、3的空洞卷積實現不同感受野下同等特征圖的獲取。

2)全局注意力模塊

全局注意力模塊[18]用于在減少信息彌散情況下也同時放大全局維度交互特征。給定一個中間特征圖作為輸入,卷積注意力模塊會依次沿通道和空間兩個獨立維度判斷注意力圖,然后將其乘以自適應特征進行優化得到結果。

通道注意力模塊是將中間特征圖作為輸入,分別通過全局池化和最大池化兩個操作轉成1×1×,然后經過多層感知機進行全連接逐像素加權操作,再經過Sigmoid激活操作生成通道注意力特征圖,最后將通道注意力特征圖與輸入逐像素加乘得到最終的通道注意力特征圖。該特征圖關注的是該近紅外圖像上哪些內容有重要作用,通道注意力機制可表達為公式(1)所示:

c()=[MLP(AvgPool()]+MLP(MaxPool() (1)

式中:為Sigmoid函數;MLP是多層感知機;AvgPool為平均池化;MaxPool為最大池化。

圖2 生成器結構

圖3 空洞全局注意力機制模塊

圖4 空洞全局注意力機制模塊網絡結構

圖5 空洞卷積

圖6 不同擴張率下感受野

空間注意力模塊是將最終通道注意力特征圖作為輸入,經過基于通道的全局最大池化和平均池化操作,接著將這兩個結果進行通道融合操作,再降維成1個通道的特征圖,再經過Sigmoid激活函數生成空間注意力機制圖,最后將該特征圖與輸入特征圖逐像素加乘得到最終的結果。空間注意力機制表達式如公式(2)所示:

式中:7×7代表卷積核。

1.2 判別器

本文模型判別器采用的是原始馬爾可夫模型。判別器屬于卷積神經網絡,為了提取圖像特征,最后一層輸出一維特征圖判斷圖像的真假。針對訓練不穩定帶來的彩色化結果模糊問題,本文在原始判別器批量歸一化層(batch normalization, BN)[19]替換成梯度歸一化層(gradient norm, GN),為判別函數施加了一個L1-利普希茨約束,解決了判別器因陡峭的空間造成訓練不穩定的問題,提升了判別器性能。本文判別網絡模型如圖7所示。

1)批量歸一化

批量歸一化是2015年Google研究人員提出的一種參數歸一化手段。BN層可使網絡超參數的設定更加寬泛,收斂較快。BN操作在數據輸入層,對輸入數據進行求均值、方差做歸一化,具體操作如下:

輸入:輸入:={1,…,m}

輸出:歸一化后的網絡響應{y=BN,(x)}

⑤返回學習參數和。

圖7 判別模型

2)梯度歸一化

梯度歸一化(gradient normalization, GN)是2021年Wu[20]提出的帶有L1-利普希茨約束的歸一化方式,該文主要解決的問題就是生成對抗網絡生成圖像質量較模糊問題,并且在CIFAR10、CelebA-HQ及LSUN Church Outdoor等數據集上進行測試,證明GN同時滿足模型集、非基于采樣及硬約束3個特性,且可兼容各種網絡架構,帶有約束的參數不會損失生成圖像的分辨率,不會帶有額外的超參數。具體操作如下:

輸入:生成器與判別器參數G、D,學習率G、D,批處理圖片,更新率dis,總迭代次數。

②對于=1~;

③對于dis=1~;

④對于=1~;

⑤~p,~p();

⑧潛在空間的隨機樣本{z}=12M~p();

批量歸一化雖有優點,但在實際網絡訓練中,訓練批尺寸參數通常設置為1,無法有效地處理所有批次圖像,進而導致網絡在訓練過程中出現不穩定,出現生成圖像模糊問題,而原梯度歸一化論文的思想就是為了解決生成對抗網絡結果圖像生成模糊問題,故本文模型將批量歸一化層替換成梯度歸一化層進行驗證。

1.3 損失函數設計

本文算法的損失函數基于生成對抗網絡進行設計,為了使生成圖像的細節和邊緣紋理更接近原始近紅外圖像,在對抗網絡損失函數基礎上引入SSIM(structure similarity index measure, SSIM)損失函數,SSIM損失函數在亮度、對比度和圖像結構三方面考慮了兩幅圖像之間的細節。為了實現上述目標,本文損失函數如下所示。

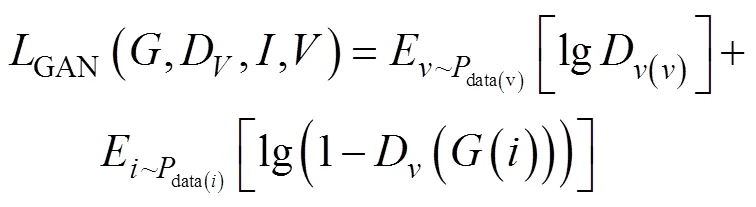

1)對抗損失。該損失目的是使生成的圖像更加真實,生成更加生動的結果,是生成對抗網絡中基礎的損失函數。

式中:是生成函數;是判別函數;為近紅外圖像域;為可見光圖像域。

2)循環一致損失。該損失用來增強整體結構信息,降低近紅外圖像域和可見光圖像域間錯誤映射的概率。

(())及(())為前向預測,差異越大,預測與原始之間差別越大。

3)識別損失。該損失旨在控制生成器隨意修改生成的色調及樣式,增強生成圖像的色調準確性等。

4)結構相似性損失。用于衡量近紅外圖像與彩色近紅外圖像之間的差異,提升生成器對輸入圖像結構的學習能力。

式中:i和v分別是近紅外圖像和生成的彩色圖像的像素平均值;i和v分別是近紅外圖像和生成的彩色圖像的方差。

5)總損失函數。聯合上述所有損失函數,本文目標是優化總損失函數。

式中:1、2,3為超參數,調整1可以調節循環一致損失函數的權重,1=10;調整2可以調節識別損失函數的權重,2=10;調節3可以調節結構相似性損失函數的權重,3=0.6。

2 實驗結果分析

2.1 實驗條件

本實驗在Windows 10操作系統下進行,深度學習框架選取PyTorch,CUDA版本為11.1,開源視覺庫為Python-Open CV4.5.1,圖像工作站配置為:Intel Core i7-6700 CPU,16GB內存,NVIDIA GeFore RTX2060S(8G)顯卡,選用RGB_NIR[21]數據集進行訓練,統一尺寸為500×500。在構建網絡時,通過隨機梯度下降更新生成器的和判別器的權重,優化器采用Adam,學習率初始設置為2×10-4,權重衰減設置為1×10-4,批處理大小設置為32,訓練周期數量為200,訓練前100周期保持學習率不變,訓練時間為9h左右。

2.2 評價指標

為了驗證本文算法的彩色化效果,本文從定性和定量兩個方面進行評估。定性分析主要是從主觀角度進行評價,定量分析主要是從客觀的評價指標作為參考進行評價。本文選用峰值信噪比(peak signal to noise ratio, PSNR)、結構相似性(image similarity)、感知相似度(learned perceptual image patch similarity, LPIPS)作為評價指標。結構相似性是用來衡量兩幅圖像在結構上的相似程度,其值越大說明兩者之間的結構未發生質變。峰值信噪比是為了衡量圖像的失真程度,數值越大說明生成圖像的失真越小。感知相似度是用來衡量兩幅圖像之間的紋理結構相似程度,數值越小說明近紅外圖像與彩色近紅外圖像紋理結構越相似,畫質越好。

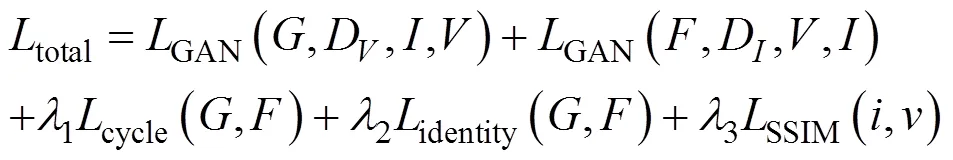

2.3 不同算法之間的對比

為了驗證本文算法的有效性,將本文算法與4種典型的基于生成對抗網絡的彩色化算法進行對比,算法分別是算法1:Deoldify[22]、算法2:Wei[23]、算法3:In2i[24]、算法4:CycleGAN算法[7]。算法結果對比如圖8所示。指標比對如表1所示。

從圖8可以看出,Deoldify算法結果只針對天空上色非常好,但是對于其他場景效果并不符合人類視覺感官。Wei及In2i結果針對草坪和樹木上色效果幾乎呈現熒綠色,存在很多不合理的細節顏色信息,飽和度較差。CycleGAN算法出現了嚴重的誤著色現象,草坪圖像中幾乎所有物體均呈現出紅色,無法區分物體顏色。本文算法相較于其他算法在牧場、大樹、雕像圖中沒有明顯的局部區域誤著色現象,且結果圖像顏色整體分布合理。從表1可以看出,本文算法除了在山峰圖中PSNR較低于CycleGAN算法,其他情況均取得了最佳的結果,在牧場圖中相較于其他算法SSIM提高了0.09,PSNR提高了1.744,LPIPS降低了0.017,在山峰圖中相較于其他算法SSIM提高了0.037,PSNR減少了0.467,LPIPS降低了0.016,在雕像圖中相較于其他算法SSIM提高了0.004,PSNR提高了1.228,LPIPS降低了0.03。

2.4 消融實驗

本實驗采取不同的網絡結構進行訓練,來驗證GAN結構和各模塊對算法性能的影響。共采取4組實驗分別進行驗證,分別是實驗一:原始GAN;實驗二:GAN+空洞卷積注意力模塊;實驗三:GAN+梯度歸一化;實驗四:GAN+空洞卷積注意力模塊+梯度歸一化,即本文算法。從測試集中隨機挑選3組實驗結果如圖9所示,指標對比如表2所示。

評價指標選取IS和FID作為衡量生成圖像清晰度和質量的考核標準。Inception分數(Inception score,IS)是對生成圖片清晰度和多樣性的衡量,IS值越大越好。特征度量距離(Fréchet inception distance,FID)是用來衡量兩組圖像的相似度,是計算真實圖像和生成圖像的特征向量之間距離的一種度量。FID分數常被用于評估由生成對抗網絡生成的圖像的質量,分數越低說明圖像的質量越高。

綜合圖9和表2指標的結果可以看出,實驗一結果會出現誤著色、上色模糊問題,實驗二在實驗一基礎上引入了空洞全局注意力機制模塊,效果上可以清晰看出錯誤著色現象明顯改善,實驗三是在實驗一基礎上引入了梯度歸一化模塊,可以明顯看出生成圖像較實驗一更為清晰,但誤著色現象依舊存在,實驗四也就是本文算法,在實驗一基礎上引入空洞全局注意力機制模塊和梯度歸一化模塊,從結果圖可以明顯看出圖像細節處顏色界限更加分明,模糊現象已明顯改善,并且從指標中也可以看出,IS平均提高了0.491,FID平均降低了1.055。為此說明本文引入的空洞全局注意力機制模塊解決了近紅外圖像局部區域誤著色問題,引入的梯度歸一化較好地改善了上色模糊現象。

圖8 各個算法對比結果:(a) 近紅外圖像;(b) Deoldify[22]結果;(c) Wei[23]結果;(d) In2i[24]結果;(e) CycleGAN算法[7]結果;(f) 本文算法結果;(g) 可見光圖像

2.5 驗證SSIM損失函數

為驗證本文引入的SSIM損失函數著色效果是否有提升,采用均方誤差(mean-square error, MSE)、峰值信噪比作為評價指標。均方誤差指的是真實圖像與彩色近紅外圖像之間的誤差,數值越大說明兩者的相差越大。峰值信噪比是為了衡量圖像的失真程度,數值越大說明生成圖像的失真越小。

共采取兩組實驗進行驗證。實驗一:本文模型+原始總損失函數。實驗二:本文模型+改進后總損失函數。將兩組實驗分別進行200周期訓練,且每25周期隨機抽取15組圖像進行MSE及PSNR測試,并取平均值繪制成最終曲線。其均方誤差趨勢曲線圖和峰值信噪比趨勢曲線圖分別如圖10、圖11所示。

圖10、11中黑色線代表實驗一結果,紅色線代表實驗二結果。從兩個曲線趨勢圖中可以明顯看出,引入SSIM損失函數后,本文算法在200周期中,實驗二中MSE較實驗一提高了3.0001,實驗二PSNR較實驗一提高了2.71dB,并且無論迭代次數處于什么階段,MSE和PSNR指標均優于實驗一,進一步證明了引入SSIM損失后確實提升了近紅外圖像彩色化效果。

圖9 消融實驗一對比算法結果:(a) 近紅外圖像;(b) 實驗一結果;(c) 實驗二結果;(d) 實驗三結果;(e) 實驗四結果;(f) 可見光圖像

表2 消融實驗一指標比對

圖10 均方誤差趨勢

圖11 峰值信噪比趨勢

3 結論

本文提出一種適用于近紅外圖像的彩色化生成對抗網絡模型,利用空洞全局注意力模塊的優勢解決了生成的結果圖像出現的局部區域誤著色問題,在判別網絡中將梯度歸一化代替原批量歸一化,提高了判別器性能的同時,也解決了生成對抗網絡因陡峭的梯度空間導致訓練不穩定問題。在生成對抗網絡損失的基礎上引入了SSIM損失函數,便于網絡的訓練。實驗結果表明,本文算法保留了近紅外圖像更多的細節信息,生成了色彩飽和度更高的彩色結果圖像。通過消融實驗證明了空洞全局注意力模塊和梯度歸一化解決了近紅外彩色化任務中出現的結果圖像局部區域誤著色及模糊問題。相比于其他彩色化算法,本文算法結果圖在圖像細節、邊緣紋理及清晰度方面有較好的優勢。

[1] 戴康. 基于超像素提取和級聯匹配的灰度圖像自動彩色化[J]. 計算機與數字工程, 2019, 47(12): 3169-3172.

DAI K. Automatic colorization of grayscale images based on superpixel extraction and cascade matching[J]., 2019, 47(12): 3169-3172.

[2] 曹麗琴, 商永星, 劉婷婷, 等. 局部自適應的灰度圖像彩色化[J]. 中國圖象圖形學報, 2019, 24(8): 1249-1257.

CAO L Q, SHANG Y X, LIU T T, et al. Locally adaptive grayscale image colorization[J]., 2019, 24(8): 1249-1257.

[3] Tomihisa Welsh, Michael Ashikhmin, Klaus Mueller. Transferring color to greyscale images[C]//, 2002, 21(3): 277-280.

[4] Reinhard E, Adhikhmin M, Gooch B, et al. Color transfer between images[J]., 2001, 21(5): 34-41.

[5] 馮佳男, 江倩, 金鑫, 等. 基于深度神經網絡的遙感圖像彩色化方法[J]. 計算機輔助設計與圖形學學報, 2021, 33(11): 1658-1667.

FENG J N, JIANG Q, JINX, et al. Colorization method of remote sensing image based on deep neural network[J]., 2021, 33(11): 1658-1667.

[6] CHENG Z, YANG Q, SHENG B. Deep colorization[C]//, 2015: 415-423.

[7] Isola P, ZHU J Y, ZHOU T, et al. Image-to-image translation with conditional adversarial networks[C]//2017, 2017: 1125-1134.

[8] Deblina Bhattacharjee, Seungryong Kim, Guillaume Vizier, et al. DUNIT: detection based unsupervised image-to-image translation[C]//2020(CVPR), 2020: 4787-4796.

[9] 萬園園, 王雨青, 張曉寧, 等. 結合全局語義優化的對抗性灰度圖像彩色化[J]. 液晶與顯示, 2021, 36(9): 1305-1313.

WAN Y Y, WANG Y Q, ZHANG X N, et al. Adversarial grayscale image colorization combined with global semantic optimization[J]., 2021, 36(9): 1305-1313.

[10] 左岑, 楊秀杰, 張捷, 等. 基于輕量級金字塔密集殘差網絡的紅外圖像超分辨增強[J]. 紅外技術, 2021, 43(3): 251-257.

ZUO Q, YANG X J, ZHANG J, et al. Super-resolution enhancement of infrared images based on lightweight pyramidal dense residual networks[J]., 2021, 43(3): 251-257.

[11] 姜玉寧, 李勁華, 趙俊莉. 基于生成式對抗網絡的圖像超分辨率重建算法[J]. 計算機工程, 2021, 47(3): 249-255.

JIANG Y N, LI J H, ZHAO J L. Image super resolution reconstruction algorithm based on generative adversarial networks[J]., 2021, 47(3): 249-255.

[12] 張振江, 張寶金, 劉偉新, 等. 基于深度卷積網絡的礦巖圖像分割算法研究[J]. 采礦技術, 2021, 21(5): 149-152, 171.

ZHANG Z J, ZHANG B J, LIU W X, et al. Research on mining rock image segmentation algorithm based on deep convolutional network[J]., 2021, 21(5): 149-152, 171.

[13] 姚永康. 基于對抗式遷移學習的皮膚病變圖像分割方法研究[D]. 西安:西京學院, 2021.

YAO Y K. Research on Skin Lesion Image Segmentation Method Based on Adversarial Transfer Learning[D]. Xi’an: Xijing University, 2021.

[14] 吳杰, 段錦, 董鎖芹, 等. DFM-GAN網絡在跨年齡模擬的人臉識別技術研究[J]. 計算機工程與應用, 2021, 57(10): 117-124.

WU J, DUAN J, TONG S Q, et al. DFM-GAN networks in cross-age simulation for face recognition[J]., 2021, 57(10): 117-124.

[15] 劉高天, 段錦, 范祺, 等. 基于改進RFBNet算法的遙感圖像目標檢測[J]. 吉林大學學報: 理學版, 2021, 59(5): 1188-1198.

LIU G T, DUAN J, FAN Q, et al. Remote sensing image target detection based on improved RFBNet algorithm[J].(Science Edition), 2021, 59(5): 1188-1198.

[16] LI C, WAN D M. Precomputed real-time texture synthesis with markovian generative adversarial networks[C]//2016, 2016: 702-716.

[17] LI Y, CHEN Y, WANG N, et al. Scale aware trident networks for object detection[C]//2019(ICCV), 2019: 6053-6062.

[18] Woo S, Park J, Lee J Y, et al. CBAM: convolutional block attention module[C]//2018, 2018: 3-19.

[19] Ioffe S, Szegedy C. Batch normalization: accelerating deep network training by reducing internal covariate shift[C]//201532, 2015: 448-456.

[20] Bhaskara V S, Aumentado-Armstrong T, Jepson A D, et al. GraN-GAN: piecewise gradient normalization for generative adversarial networks[C]//, 2022: 3821-3830.

[21] Brown M, Süsstrunk S. Multi-spectral sift for scene category recognition[C]//2011, 2011: 177-184.

[22] Jason Antic. jantic/deoldify: a deep learning based project for colorizing and restoring old images (and video!)[J/OL] [2019-10-16] https://github.com/jantic/DeOldify.

[23] LIANG W, DING D, WEI G. An improved dual GAN for near infrared image colorization[J]., 2021, 116(4): 103764-103777.

[24] Perera P, Abavisani M, Patel V M. In2i: Unsupervised multi-image-to-image translation using generative adversarial networks[C]//2018, 2018: 140-146.

Near-infrared Image Colorization Method Based on a Dilated Global Attention Mechanism

GAO Meiling,DUAN Jin,ZHAO Weiqiang,HU Qi

(,,130012,)

A new generative adversarial network method is proposed for colorization of near-infrared (NIR) images, because current convolutional neural networks fail to fully extract the shallow feature information of images. This failure leads to miscoloring of the local area of the resultant image and blurring due to unstable network training. First, a self-designed dilated global attention module was introduced into the generator residual block to identify each position of the NIR image accurately and improve the local region miscoloring problem. Second, in the discriminative network, the batch normalization layer was replaced with a gradient normalization layer to enhance the network discriminative performance and improve the blurring problem caused by the colorized image generation process. Finally, the algorithms used in this study are compared qualitatively and quantitatively using the RGB_NIR dataset. Experiments show that the proposed algorithm can fully extract the shallow information features of NIR images and improve the structural similarity by 0.044, PSNR by 0.835, and LPILS by 0.021 compared to other colorization algorithms.

colorization, near-infrared images, generative adversarial networks, dilated global attention, gradient normalization

TP391

A

1001-8891(2023)10-1096-10

2022-09-07;

2022-09-29.

高美玲(1997-),女,遼寧錦州人,博士研究生,主要研究方向:圖像處理等。

段錦(1971-),男,吉林長春人,博士,教授,博士生導師,主要研究方向:圖像處理與模式識別等。

吉林省科技發展計劃項目(20210203181SF)。