基于自適應增強與顯著性檢測的可見光與紅外圖像融合算法

陳思靜,付志濤,李梓謙,聶 韓,宋加文

基于自適應增強與顯著性檢測的可見光與紅外圖像融合算法

陳思靜,付志濤,李梓謙,聶 韓,宋加文

(昆明理工大學 國土資源工程學院,云南 昆明 650093)

為解決可見光圖像可視性差與如何精確控制可見光與紅外圖像輸入量的問題,本文提出一種結合圖像自適應增強與獨立性、聚焦度、對象性等顯著性檢測的可見光與紅外圖像融合算法。首先在可見光圖像中引入自適應增強算法提高圖像紋理細節的可見性,并對紅外圖像歸一化處理,其次將處理后的圖像利用引導濾波分解為細節層與基礎層,利用顯著性檢測生成細節層的權重圖,提高細節層中可見光圖像背景信息與紅外圖像邊緣信息的精確融合量,最終將依據權重值融合后的細節層與基礎層組合得到最終的融合圖像。為驗證本文算法的優越性,選取圖像熵、平均梯度、邊緣強度、空間頻率、視覺保真度、平均灰度等6種融合評價指標對融合圖像定量分析,并利用YOLO v5(You Only Look Once)網絡對各融合算法進行目標檢測,結果表明本文算法在融合定性評價、定量評價與目標檢測評價指標平均精度中達到最優。

圖像融合;目標檢測;引導濾波;多尺度分解;顯著性檢測

0 引言

圖像融合是將兩幅包含不同有效信息的圖像融合成為一張圖像,以提高成像質量并減少冗余信息[1]。其中可見光與紅外圖像融合是融合技術中的重要一項。可見光圖像可以提供場景中背景細節信息。但圖像質量易受一些特殊場景如夜間、樹木陰影、低照度和過度曝光等情況影響。紅外傳感器能夠捕捉人眼無法直接看到的場景中的熱信息,能夠抵抗這些不利場景的干擾[2]。但通常分辨率較低,紋理較差。可見光圖像與紅外圖像的有效融合,可以提高圖像質量,增強圖像解譯能力[3]。

在可見光與紅外圖像融合領域,主要的圖像融合方法通常可以分為幾類,即多尺度變換、稀疏表示、基于子空間、混合模型以及深度學習方法,大部分融合方法集中在多尺度變換[3]。但基于多尺度變換方法得到的融合圖像容易出現偽影和信息冗余[3]。因此,學者們提出利用濾波器對傳統多尺度分解進行優化,其中比較常用的濾波器有高斯濾波器和雙邊濾波器等[4]。但通過以上濾波器優化的方法會使圖像邊緣模糊,不利于圖像中的物體識別[4]。Li等[5]首次提出基于引導濾波(Guided Filtering, GF)多尺度分解的融合方法來解決邊緣模糊問題,既可以平滑圖像噪聲,又可以保持圖像內物體邊緣。該方法在融合過程中未對分解的基礎層與細節層進行處理,導致融合結果易出現光暈現象。為此,謝偉等[6]提出一種融合梯度信息的改進引導濾波算法來自適應強化圖像內目標邊緣結構,該方法雖然在解決光暈現象中具有一定效果,但算法的時間復雜度較高。Fan Z.等[7]提出一種快速的基于引導濾波的同源金字塔多尺度分解策略實現可見光和紅外圖像融合,但融合后圖像在邊緣上的清晰度不夠。Bavirisetti D. P.等[8]提出了一種基于圖像引導濾波器的通用、簡單、快速的融合算法。該方法通過多尺度分解、結構傳遞特性、視覺顯著性檢測和權值圖構建,將源圖像信息輸入到融合圖像中。但該方法并未解決由不利場景、對比度不明顯以及紅外可見光輸入量造成的融合圖像質量問題。葉坤濤等[9]將顯著性檢測與非下采樣剪切波變換結合生成可見光與紅外的融合圖像,利用顯著性圖控制低頻部分的融合分量,生成了對比度較高的融合圖像,但由于顯著性圖沒有對源圖像低頻部分的輸入量進行精確控制,致使該方法最終結果可見光信息占比較大,使部分紅外目標不清晰。

通過以上分析,基于引導濾波的多尺度分解方法在可見光與紅外圖像融合領域有了較快發展,但仍受可見光圖像自然場景可視性差的影響,并且需解決如何更精確控制融合中可見光與紅外圖像輸入量的問題。針對上述問題,本文提出一種基于引導濾波的高動態范圍(High Dynamic Range,HDR)自適應增強算法和基于引導濾波多尺度分解的獨立性、聚焦度與對象性(Uniqueness、Focusness and Objectness,UFO)顯著性檢測方法進行圖像融合,該顯著性檢測方法綜合獨立性()、聚焦度()、和對象性()等顯著性因素在一定程度上提高了各類不利場景中目標檢測性能[10]。為驗證本文方法的有效性,本文將在融合定性評價、定量評價以及目標檢測性能評價與目前主流的融合方法進行對比。

1 本文融合算法

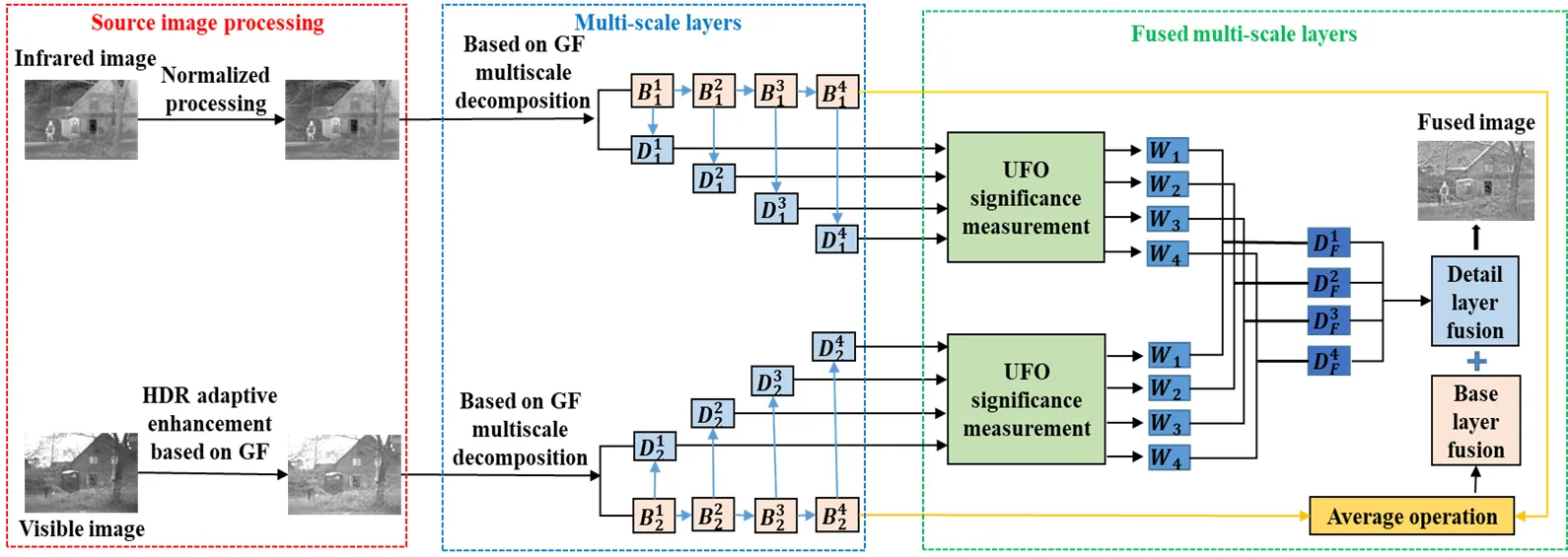

本文提出一種面向目標檢測的可見光與紅外圖像融合算法如圖1所示,融合步驟如下:

1)利用基于引導濾波的HDR圖像增強技術對可見光圖像中的黑暗陰影與低曝光等區域進行自適應增強,紅外圖像則進行歸一化處理。

2)基于引導濾波對處理后的可見光與紅外圖像進行多尺度分解,得到第一層的基礎層1,21與細節層1,21,并由第一層的基礎層生成第二層的1,22與細節層1,22,依此分解最終得到四層的基礎層與細節層。并將可見光與紅外圖像第四層的基礎層取平均得到平均基礎層。

3)通過UFO顯著性算法計算每層細節層的顯著性圖,并根據顯著性圖求取每層細節層的權重圖1、2、3、4。

圖1 本文方法流程圖

4)將可見光圖像與紅外圖像的每一層細節層通過權重圖分別融合得到F1、F2、F3、F4,然后將四層相加,得到細節層融合圖像,并與平均基礎層進行組合生成最終融合圖像。

1.1 圖像自適應增強

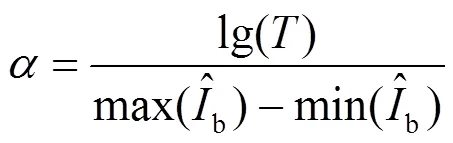

在公式中lg表示對數的運算符,并令=1以防lg的值為負。為了盡可能保留基礎層的細節信息,利用比例因子在基礎層上進行對比度壓縮,并且基于參數恢復整體度:

根據公式可知,當<1,基礎層的對比度會降低。為保證值的范圍,本文設置一個最低目標對比度,得到的計算公式:

由于比例因子對基礎層進行動態壓縮,造成了圖像整體對比度降低,因此可令>0恢復圖像整體對比度,且保持最終結果不大于基礎層的最大值,可以計算為:

最終,通過以下公式得到增強圖像:

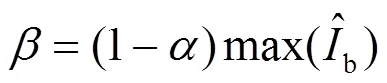

1.2 多尺度分解

利用引導濾波在多尺度圖像分解和結構傳遞方面的優勢,得到基于引導濾波分解的基礎層與細節層[12]。多尺度分解流程如圖2所示。

具體公式如下:

上述公式表示若處理可見光圖像I1,則將紅外圖像I2作為引導圖像,其中,rk,ek分別為第k層的鄰域大小和調節參數。B1k、B2k是源圖像第k級的基礎層,細節層D1k、D2k為前一級基礎層和當前基礎層之間的差異。

1.3 顯著性檢測

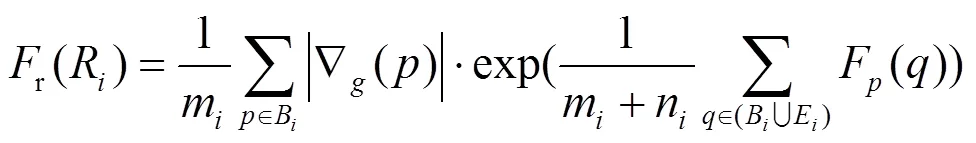

式中:B表示邊界像素m的整體聚焦度;為單一邊界像素的聚集度;E表示內部像素n聚焦度;為單一內部像素的聚集度。由于圖像邊緣處變化強度大,使用圖像邊緣銳度作為權重值,利用DOG算子計算邊緣像素的梯度值平均值,可得區域聚焦r(R),將區域聚焦度分散向各個像素,獲得整張圖的聚焦度。

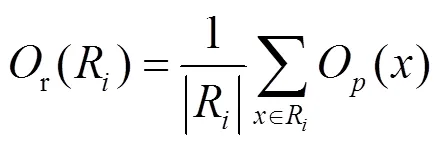

然后通過估計區域中可識別對象的概率,計算像素級的對象識別度:

繼而將每個像素的對象狀態分配給各自所在的區域R,得到區域R的對象狀態:

式中:表示包括像素的任意區域,根據區域對象狀態值得到整張圖的對象狀態。

利用區域之間的灰度距離度量(R,R)計算圖像中的區域獨立性r(R):

然后將區域獨立性分散向各個像素,獲得整張圖的獨立性。

綜合考慮聚焦度、獨立性和對象狀態定義顯著性測量值:

=exp(+)×(12)

1.4 權重圖的構建及融合

為減少計算的復雜度,并逐像素地整合互補信息,利用生成的細節層顯著性圖計算細節層權重圖:

式中將每幅圖像的細節層分為層,代表每層之間的數值范圍,利用上式計算每個數值范圍的權重,這種基于顯著性信息的互補權重圖構建過程可以自動集成每個層級的細節層信息,在此基礎上對細節層進行融合:

對基礎層融合:

融合后的圖像由最終的基礎層與細節層相結合得到:

=F+F(17)

2 實驗數據與對比試驗

2.1 實驗設置與參數分析

2.1.1 實驗設置

將本文方法與深度學習框架(Deep Learning Framework,DLF)算法[13]、具有多分類約束的生成對抗網絡(Generative Adversarial Network with Multiclassification Constraints,GANMCC)算法[14]、多層高斯曲率濾波(Multi-level Gaussian Curvature Filterin,MLGCF)算法[15]、混合多尺度分解(Hybrid Multi-Scale Decomposition,Hybrid MSD)算法[16]、非下采樣剪切波變換-脈沖耦合神經網絡(Non-subsampled Shearlet Transform-Pulse-Coupled Neural Network, NSST-PCNN)算法[17]、結合視覺顯著性圖與加權最小二乘(Visual Saliency Map and Weighted Least Square,VSMWLS)算法[18]和梯度轉移融合(Gradient Transfer Fusion,GTF)算法[19]等7種融合算法分別通過定性與定量評價進行對比。選取TNO與OSU數據集中的21組可見光與紅外圖像作為本文實驗數據[1],圖3為數據集中部分圖像對,第一行為可見光圖像,第二行為紅外圖像。

2.1.2 參數分析

在本文方法中,圖像增強中引導濾波器大小由公式=0.04max(,)決定,其中和分別表示輸入圖像的寬度和高度,根據以往經驗值,將濾波器中的邊緣保持參數設置為0.01。基于以上參數,對最低目標對比度進行對比分析,將值分別設置為2,4,6得到增強結果,由圖4可知,=2時,增強過度,存在泛白現象,而=6時目標增強不夠明顯,存在細節缺失,因此最低對比度設置為4。

針對后續GF分解層數的選取,選取可見光與紅外圖像融合數據集TNO中的7張圖像進行分析,如圖5所示。此次實驗中設置分解層數為1~5層,根據經驗設置濾波器尺寸為9,平滑參數為103,隨著的增加在=4的時候,數據值達到平穩狀態,考慮時間成本問題,分解層數選擇4層。

2.2 融合算法對比分析

2.2.1 融合圖像定性分析

將本文算法與其余7種算法對圖3數據集示例融合結果定性分析,融合結果如圖6所示。

圖3 本文實驗部分數據集

圖4 不同T值對比分析

(a) 隨分解層數K增大EN值的變化(a) The change of EN value as the number of decomposition layers K increases(b) 隨分解層數K增大AG值的變化(b) The change of AG value as the number of decomposition layers K increases (c) 隨分解層數K增大EI值的變化(c) The change of EI value as the number of decomposition layers K increases(d) 隨分解層數K增大SF值的變化(d) The change of SF value as the number of decomposition layers K increases (e) 隨分解層數K增大VIFF值的變化(e) The change of VIFF value as the number of decompositionlayers K increases(f) 隨分解層數K增大MEAN值的變化(f) The change of MEAN value as the number of decomposition layers K increases

圖6 本文算法與其它算法的融合結果比較

綜合8種融合算法定性評價結果,本文算法融合結果在圖6中均有良好展現。在(a)組圖像中,各算法均能清晰看到街道口人影與車輛,但在(a)組圖像的商店櫥窗中,本文算法較其他算法能看到櫥窗邊框與物體信息。(b)組圖像中除本文算法外,門口樹枝均存在輪廓模糊,尤其是GANMCC算法和GTF算法邊緣沒有很好的凸顯出來。(c)組圖像中僅本文算法看到地面信息,且其余7種算法除MLGCF與NSST-PCNN外圖像中樹木信息不能清晰識別,而MLGCF與NSST-PCNN算法中地板信息也不如本文算法明顯。本文算法在(d)組圖像中樹木樹枝信息可以清晰展現,但其余融合圖像中明顯丟失大量信息,造成細節模糊。(e)組圖像樹木枝丫不明顯,造成大量紋理細節丟失,本文算法在保持人影清晰的基礎上,得到較其它融合算法更為清晰的樹木。在(f)組圖像中,本文算法較其它算法更能看清打電話的人及其周邊的綠植,得到較高的圖像對比度。綜上所述,本文所提方法在物體輪廓與紋理信息之間達到了較好的平衡,獲得了清晰度更高的融合圖像。

2.2.2 融合圖像定量分析

在融合圖像定量分析中,本文綜合圖像信息與邊緣考量,選用圖像熵(Entropy, EN)、平均梯度(Average Gradient, AG)、邊緣強度(Edge Intensity, EI)、空間頻率(Spatial Frequency, SF)、視覺保真度(the Visual Information Fidelity for Fusion,VIFF)、平均灰度(Mean grayscale,MEAN)6種定量評價指標對數據集中融合結果進行質量分析,這6種指標分別表示融合圖像中信息量以及結構輪廓的變化。表1給出了本文方法與上述7種融合方法在6種指標下對融合圖像的定量評價結果,加粗值為最優值。

由表1可見,本文方法在6種指標下均取得最優值。尤其是AG、EI和SF這3項指標值相對于次優算法有明顯提升,表明在融合可見光與紅外圖像更多信息量的同時得到更為清晰的物體邊緣。其余算法如DLF、GANMCC、GTF由于圖像清晰度不夠導致在6種融合指標上都表現欠缺,而其余4種算法存在的部分細節缺失和偽影現象使指標值低于本文方法。綜合圖6與表1可知,在主觀評價與客觀評價下均取得最優結果,表明本文算法既保持了圖像紋理細節,又在邊緣保持度上獲得了顯著提升。

2.3 目標檢測結果分析

利用目標檢測算法中的YOLO v5網絡對本文方法的優越性進一步評估。即比較融合算法在目標檢測下的平均精度mAP值。由表1可知,本文方法的mAP值在這8種算法中最高,目標檢測表現最好。但相比之下,8種融合算法的mAP值并未有顯著提升。究其原因,在復雜的數據采集環境中,一些不完全或無法采集到的目標嚴重影響著融合圖像的質量,導致融合圖像中僅有紅外圖像中白色區域代表物體整體輪廓,而且融合過程中部分信息丟失也會影響目標檢測的精度。因此在復雜的環境下如何優化可見光與紅外融合算法在目標檢測的性能仍需不斷探索。

表1 本文算法與其它算法的定量融合結果比較

Note:"↑" indicates that the larger the value, the better the image quality

3 結論

本文提出了一種基于自適應圖像增強與權重圖構建的可見光與紅外圖像融合算法,該方法利用基于引導濾波的HDR圖像增強算法處理可見光圖像,并對紅外圖像歸一化處理,隨后對處理后的圖像利用GF多尺度分解得到細節層與基礎層,并加入UFO顯著性檢測算法計算細節層權重圖,調節融合輸入信息量。實驗表明,本文所提出的方法在定性評價與定量評價方面均優于DLF、GANMCC、MLGCF、Hybrid MSD、NSST-PCNN、VSMWLS與GTF算法,相比其他算法,本文算法在保留圖像紋理信息的同時,邊緣信息也更加完整和清晰,在目標檢測中結果更好。未來我們將致力于設計更有效的融合方法以提高算法的性能,并在此基礎上針對目標檢測領域對融合算法進行深入研究。

[1] ZHANG X C, YE P, XIAO G. VIFB: a visible and infrared image fusion benchmark[C]//2020(CVPRW), 2020: 14-19.

[2] 王君堯, 王志社, 武圓圓, 等. 紅外與可見光圖像多特征自適應融合方法[J].紅外技術, 2022, 44(6): 571-579.

WANG Junyao, WANG Zhishe, WU Yuanyuan, et al. Multi-feature adaptive fusion method for infrared and visible images[J]., 2022, 44(6): 571-579.

[3] MA J, MA Y, LI C. Infrared and visible image fusion methods and applications: A survey[J]., 2019, 45: 153-178.

[4] ZHOU Z, DONG M, XIE X, et al. Fusion of infrared and visible images for night-vision context enhancement[J]., 2016, 55(23): 6480.

[5] LI S, KANG X, HU J. Image fusion with guided filtering[J]., 2013, 22(7): 2864-2875.

[6] 謝偉, 周玉欽, 游敏. 融合梯度信息的改進引導濾波[J].中國圖象圖形學報, 2016, 21(9): 1119-1126. XIE W, ZHOU Y Q, YOU M. Improved guided image filtering integrated with gradient information[J]., 2016, 21(9): 1119-1126.

[7] FAN Z, YAN L, XIA Y, et al. Fusion of multi-resolution visible image and infrared images based on guided filter [C]//2018: 4449-4454.

[8] Bavirisetti D P, XIAO G, ZHAO J, et al. Multi-scale guided image and video fusion: a fast and efficient approach[J]., 2019, 38(12): 5576-5605.

[9] 葉坤濤, 李文, 舒蕾蕾, 等. 結合改進顯著性檢測與NSST的紅外與可見光圖像融合方法[J]. 紅外技術, 2021, 43(12): 1212-1221.

YE Kuntao, LI Wen, SHU Leilei, LI Sheng. Infrared and visible image fusion method based on improved saliency detection and non-subsampled shearlet transform[J]., 2021, 43(12): 1212-1221.

[10] PENG J, LING H, YU J, et al. Salient region detection by UFO: uniqueness, focusness and objectness[C]//, 2013: 1976-1983.

[11] Durand F, Dorsey J. Fast bilateral filtering for the display of high-dynamic-range images[J]., 2002, 21(3): 257-266.

[12] Bavirisetti D P, Kollu V, GANG X, et al. Fusion of MRI and CT images using guided image filter and image statistics[J]., 2017, 27(3): 227-237.

[13] HUI L, WU X , Kittler J. Infrared and visible image fusion using a deep learning framework[C]//,, 2018: 2705-2710.

[14] MA J, ZHANG H, SHAO Z, et al. GANMcC: a generative adversarial network with multiclassification constraints for infrared and visible image fusion[J]., 2021, 70: 1-14.

[15] TAN W, ZHOU H, SONG J, et al. Infrared and visible image perceptive fusion through multi-level Gaussian curvature filtering image decomposition[J]., 2019, 58(12): 3064.

[16] ZHOU Z, WANG B, LI S, et al. Perceptual fusion of infrared and visible images through a hybrid multi-scale decomposition with Gaussian and bilateral filters[J]., 2016, 30: 15-26.

[17] TAN W, Tiwari P, Pandey H M, et al. Multimodal medical image fusion algorithm in the era of big data[J/OL]., 2020: 1-21. https://doi.org/10.1007/s00521-020-05173-2.

[18] MA J, ZHOU Z, WANG B, et al. Infrared and visible image fusion based on visual saliency map and weighted least square optimization[J]., 2017, 82: 8-17.

[19] MA J, CHEN C, LI C, et al. Infrared and visible image fusion via gradient transfer and total variation minimization[J]., 2016, 31: 100-109.

A Visible and Infrared Image Fusion Algorithm Based on Adaptive Enhancement and Saliency Detection

CHEN Sijing,FU Zhitao,LI Ziqian,NIE Han,SONG Jiawen

(Faculty of Land Resources Engineering, Kunming University of Science and Technology, Kumming 650093, China)

This paper proposes a visible and infrared image fusion algorithm to solve the problem of the poor visibility of visible images and control the input volume of visible and infrared images. The proposed method combines image adaptive enhancement with uniqueness (U), focus (F), and object (O) saliency detection. First, an adaptive enhancement algorithm was applied to the visible image to improve the visibility of the textural details and normalize the infrared image. Second, the processed image was decomposed into a detail layer and base layer using guided filtering. A weight map of the detail layer was generated using saliency detection to improve the accuracy of the fusion of the background information of the visible image and the edge information of the infrared image in the detail layer. Finally, the fused image was obtained by combining the detail and base layers. To verify the performance of the proposed algorithm, five fusion evaluation indices: image entropy, average gradient, edge intensity, spatial frequency, and visual fidelity, were selected to quantitatively analyze the fused images. The YOLO v5 network was used to perform target detection for each fusion algorithm. The results show that the proposed algorithm achieved the optimal average accuracy in terms of the qualitative, quantitative, and target detection evaluation indexes of fusion.

image fusion, target detection, guide the filtering, multiscale decomposition, significance detection

TP391

A

1001-8891(2023)09-0907-08

2022-06-22;

2022-08-10.

陳思靜(1998-),女,山東濟寧人,碩士研究生,主要研究方向為遙感圖像融合及評價。E-mail:csj9804@163.com。

付志濤(1982-),男,河南開封人,博士,副教授,主要研究方向為異源圖像匹配、融合及應用等。E-mail:zhitaofu@126.com。

國家自然科學基金(41961053);昆明理工大學省級人培項目(KKSY201921019)。