結合自適應圖卷積與時態(tài)建模的骨架動作識別

甄昊宇,張 德

北京建筑大學電氣與信息工程學院& 建筑大數(shù)據(jù)智能處理方法研究北京市重點實驗室,北京100044

人體動作識別作為計算機視覺領域一項重要的研究內(nèi)容,在智能監(jiān)控、人機交互、虛擬現(xiàn)實和視頻分析等方面具有廣泛的應用前景。目前對人體動作識別的研究主要分為基于RGB視頻的人體動作識別[1]和基于3D骨架的人體動作識別[2]。基于RGB 視頻的方法需要高成本的計算資源來處理RGB 圖像和光流中的像素信息,并且在面對復雜的背景條件時,計算量更大,魯棒性較差。隨著深度成像技術的快速發(fā)展,通過Kinect深度傳感器獲取3D 人體骨架數(shù)據(jù),使用主要關節(jié)點的三維空間軌跡變化來描述動作,計算效率較高,且對背景噪聲具有較強的魯棒性。因此,基于骨架的人體動作識別受到研究人員更多的關注。

1 相關工作

早期的骨架動作識別模型主要是基于手工設計特征的方法,例如可以依據(jù)骨架數(shù)據(jù)序列中的關節(jié)坐標點位置形成時序特征向量[3],或者考慮關節(jié)點之間的相對位置,根據(jù)身體不同區(qū)域的姿態(tài)變化、偏移等信息形成特征向量[4],還可以整體考慮人體姿態(tài)的靜止特征和時序動態(tài)偏移特征形成特征向量[5-7]。基于這些特征,使用傳統(tǒng)的機器學習算法進行分類識別。這類方法的不足之處在于特征表達能力有限,當數(shù)據(jù)量增加、動作類別增多的時候,識別準確率不高。

隨著深度學習的快速發(fā)展,基于深度學習的骨架動作識別方法逐漸成為主流,并且可以分為三類,基于循環(huán)神經(jīng)網(wǎng)絡(recurrent neural network,RNN)、基于卷積神經(jīng)網(wǎng)絡(convolutional neural network,CNN)和基于圖卷積神經(jīng)網(wǎng)絡(graph convolutional network,GCN)的方法。

RNN 適合針對時序相關性強的數(shù)據(jù)進行建模,Du等[8]提出級聯(lián)RNN 建模的方式,使用多個子RNN 分別對不同身體區(qū)域的骨架數(shù)據(jù)序列進行處理,然后逐級合并子網(wǎng)絡并進行信息融合。為了構建更深層次的網(wǎng)絡,Li等[9]提出一種基于獨立神經(jīng)元的RNN模型,提升了骨架動作識別的準確率。為了更好地表達時序數(shù)據(jù)的上下文依賴關系,并解決傳統(tǒng)RNN 存在的梯度彌散問題,長短期記憶(long short-term memory,LSTM)結構得到了更多的應用,例如Liu等提出的ST-LSTM(spatiotemporal LSTM)模型[10]和GCA-LSTM(global contextaware attention LSTM)模型[11]等。盡管如此,RNN類方法仍然難以處理骨架數(shù)據(jù)在空間和時間各個維度上的同時變化特性。CNN類方法考慮通過預先設定的規(guī)則把骨架數(shù)據(jù)序列轉(zhuǎn)換為一組語義圖像,然后再使用CNN模型進行處理。例如可以直接把關節(jié)點的三維坐標對應到圖像的三通道像素值[12],或者選定幾個參考關節(jié)點,計算其他關節(jié)點到參考點的相對位置變化,還可以考慮加入視角的變化,轉(zhuǎn)換生成一系列連續(xù)圖像[13-14]。CNN 類方法識別性能有了一定提升,但是依然不能充分地利用骨架數(shù)據(jù)天然的內(nèi)在信息,人體關節(jié)之間固有的相關性無法很好地進行建模表達。

圖卷積神經(jīng)網(wǎng)絡GCN在多個領域的良好表現(xiàn)為骨架動作識別提供了新思路。由于骨架在非歐幾里德幾何空間中自然地被構造為一個圖形,Yan 等[15]構建了時空骨架圖,提出ST-GCN(spatial-temporal GCN)模型,將人體關節(jié)之間的時空關系很好地嵌入到骨架圖的鄰接矩陣中。為了進一步挖掘關節(jié)之間的自然連接關系和動作過程中關節(jié)之間不同程度的依賴關系,Li等[16]提出了基于動態(tài)連接和靜態(tài)結構連接的AS-GCN(actionalstructural GCN)模型。Zhang等[17]則利用關節(jié)所屬類型(手部關節(jié)、肩部關節(jié)等)等語義信息引導建立一個更有效的GCN 模型,充分表達全局和局部特征。但是僅依靠預設定圖拓撲結構的模型不夠靈活,無法應對變化多樣的動作數(shù)據(jù)。Shi 等[18]提出了自適應圖卷積模型,以端到端的方式學習個體數(shù)據(jù)驅(qū)動矩陣,作為圖拓撲結構鄰接矩陣的補充,增加了GCN 模型的數(shù)據(jù)適應性。Chen 等[19]設計了一種雙頭GCN 模型,把粗粒度和細粒度特征有效結合起來。馬利等[20]提出區(qū)域關聯(lián)自適應GCN 模型,捕獲非物理連接關節(jié)之間的內(nèi)在依賴聯(lián)系。近年來,GCN 類方法的應用使得骨架動作識別率得到明顯提高,已經(jīng)成為當前的主流方法。

在文獻[18]中,Shi等考慮到人體骨架是由關節(jié)點和骨骼兩種元素組成,關節(jié)點連接相鄰的骨骼,因此也提出了基于雙流數(shù)據(jù)處理的網(wǎng)絡結構,把初始骨架數(shù)據(jù)分解為關節(jié)點數(shù)據(jù)流和由骨骼表示的肢體數(shù)據(jù)流。此后,數(shù)據(jù)分流的模型構建思路得到了廣泛的應用[19-22],識別性能得到了進一步提升。

但是,大多GCN 類方法對骨架動作數(shù)據(jù)序列的時域變化動態(tài)分析還不夠深入,特別是對于非相鄰時間步長的動作單元間的關系特性由于信息稀釋而被忽略。一個動作一般由一些連續(xù)且順序固定的動作單元組成,它們之間的相鄰和非相鄰時序相關性決定了該動作的時域特征[23]。例如,跳遠動作包含“助跑”“起跳”“騰空”和“落地”四個部分,“助跑”和“騰空”,或者和“落地”之間的非相鄰時間步長距離等特性對識別跳遠動作也能夠起到重要作用。因此在時域動態(tài)建模中,還應充分考慮非相鄰時間步長動作單元之間的相關性。

基于以上分析,本文提出了結合自適應圖卷積與多尺度時態(tài)建模的雙流GCN模型。自適應圖卷積模塊以端到端的方式自適應的學習人體關節(jié)之間固有的連接關系和不同動作類別的關節(jié)變化依賴關系。多尺度時態(tài)建模模塊提取骨架序列的時間特征,增強了時間卷積,擴展了時間維度上的感受野,有效地聚合了相鄰時間步長和非相鄰時間步長的時態(tài)關系。兩個模塊相互補充,豐富了模型整體的特征表達能力,提升了識別性能。

2 模型介紹

2.1 骨架圖卷積表示

人體骨架圖可以表示為G=(V,E) ,其中V={v1,v2,…,vJ}代表J個關節(jié)點的集合,E是邊集,表示為鄰接矩陣A∈RN×N,鄰接矩陣僅包含0、1兩種數(shù)值,其中(i,j)=1 表示第i個關節(jié)點和第j個關節(jié)點之間有直接相連的邊,(i,j)=0 則反之。A是對稱的,因為G是無向圖。骨架序列可以表示為特征張量X∈RC×T×J,其中C表示坐標維度,T表示動作序列中骨架幀的數(shù)量。因此,完整的視頻骨架序列可被表示為每一幀骨架圖的堆疊G=(G1;G2;…;GT)。

圖卷積網(wǎng)絡是學習圖結構數(shù)據(jù)表示的有效框架,根據(jù)上面定義的符號,圖卷積網(wǎng)絡在骨架序列上執(zhí)行多層圖卷積以提取高層特征。每個圖卷積層通常由空間圖卷積塊和時間卷積塊組成,空間圖卷積塊提取骨架的空間特征,其具體公式為:

其中,fin表示輸入特征,表示輸出特征。A為鄰接矩陣,I為單位矩陣,Λ為度矩陣。鄰接矩陣有三個子集,分別為(1)根節(jié)點本身(root);(2)向心子集(centripetal),包含比根節(jié)點更靠近重心的相鄰節(jié)點;(3)離心子集(centrifugal),包含比根節(jié)點離重心更遠的相鄰節(jié)點。因此,A相應地分為Mk∈RJ×J作為一個可學習的矩陣,用來調(diào)整邊緣的重要性。Wk是大小為Cout×Cin×1×1 的可學習參數(shù),用于調(diào)整特征圖的通道。

時間卷積塊提取骨架序列的時間特征,對同一關鍵點在不同幀的信息進行融合,具體公式如下:

其中,Conv2d[Kt×1]是卷積核大小為Kt×1 的二維卷積運算。

2.2 模型網(wǎng)絡架構

本模型采用雙流網(wǎng)絡結構對關節(jié)點信息和肢體信息同時建模處理,主要包括三個部分,數(shù)據(jù)預處理、特征提取和動作分類,如圖1所示。

數(shù)據(jù)預處理:把骨架數(shù)據(jù)序列分解為關節(jié)點流和骨骼流(表示肢體信息)。關節(jié)點流數(shù)據(jù)由各關節(jié)點的三維坐標組成,骨骼流數(shù)據(jù)按照如下方式獲得[18]。

每個骨骼都與兩個關節(jié)點綁定,定義靠近人體骨架重心的關節(jié)點為源關節(jié)點,遠離重心的為目標關節(jié)點。這樣,每個骨骼都表示為一個從源關節(jié)點指向目標關節(jié)點的向量,該向量包含了長度信息和方向信息。骨骼向量計算公式為:

式中,vi表示目標關節(jié)點,vj表示源關節(jié)點,boneij表示關節(jié)點vi和vj間的骨骼向量。

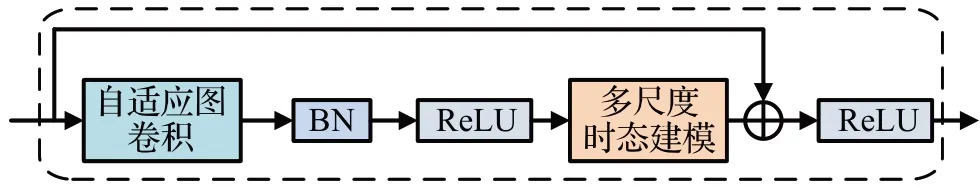

特征提取:該部分由10個基礎網(wǎng)絡層堆疊而成,每層網(wǎng)絡的輸出通道數(shù)依次是64、64、64、64、128、128、128、128、256 和256,每層網(wǎng)絡結構相同,如圖2 所示。BN 是批歸一化操作(batch normalization),ReLU 是常用的非線性激活函數(shù)。為了穩(wěn)定訓練過程,增加了一個殘差連接。這樣,經(jīng)過多個基礎網(wǎng)絡層后,特征能夠沿空間和時間維度進行集成。

圖2 網(wǎng)絡層結構單元Fig.2 Network layer structure unit

動作分類:將關節(jié)點流網(wǎng)絡和骨骼流網(wǎng)絡的輸出進行加權融合,得到融合分數(shù)并預測動作所屬的類別。

2.3 自適應圖卷積模塊

本文使用的自適應圖卷積模塊以端到端的學習方式,將圖的拓撲結構與網(wǎng)絡的其他參數(shù)一起優(yōu)化。對于不同的圖卷積層和不同類別的樣本,該拓撲結構是唯一的,增加了模型的辨識能力。自適應圖卷積模塊的結構如圖3所示。

圖3 自適應圖卷積模塊Fig.3 Adaptive graph convolutional module

為了使圖表示具備自適應的特性,將式(1)進行如下變化:

這里,骨架圖表示的鄰接矩陣分為三部分:Ak、Lk和Pk。Ak與原始的鄰接矩陣相同,表示人體的整個物理結構。Lk也是一個鄰接矩陣,它的元素值初始化為0,在訓練過程中與其他參數(shù)一起被優(yōu)化,它不僅表明兩個關節(jié)點之間存在連接,還表明了連接的強度。Lk可以學習針對待識別樣本的圖,并且對于不同層中包含的不同信息更加個性化,與式(1)中的Mk類似,執(zhí)行注意力機制的角色。然而,由于原矩陣Mk與Ak進行點乘,如果Ak中的一個元素為0,無論Mk中元素的值如何,它都將始終為0。因此,它無法生成原骨架圖表示中不存在的新連接。而Lk能夠增強非自然連接關節(jié)點對之間的特征傳遞,比Mk更加靈活。

Pk是一個數(shù)據(jù)相關圖,它為每個樣本學習一個唯一的圖。Pk應用了Non-local 注意力機制[24],通過歸一化嵌入高斯函數(shù)計算圖中任意兩個頂點之間的交互來獲得其連接強度,如式(5)所示:

其中,J是頂點的總數(shù),使用點積來計算兩個頂點的相似性。具體來說,給定輸入特征fin∈Cin×T×J,J是頂點總數(shù),zi和zj代表任意兩個頂點,θ和?是兩個嵌入函數(shù),分別為1×1的卷積操作,eθ(zi)T?(zj)是一種相似度函數(shù),計算zi和所有相關聯(lián)的zj之間的相似關系。在具體實驗中,首先將輸入特征fin∈Cin×T×J分別通過兩個嵌入函數(shù)(即1×1 卷積層)映射并分別重新排列為J×Cm×T矩陣和Cm×T×J矩陣,然后將它們相乘,得到J×J大小的相似矩陣Pk,其元素pij表示頂點zi和頂點zj的連接強度。將矩陣的各元素值歸一化,作為頂點zi和頂點zj的虛擬連接。Pk可以如式(6)所示:

Wθk和W?k分別表示嵌入函數(shù)θ和?的參數(shù)。

另外,如圖3所示,其中添加殘差連接,允許將該模塊插入到任何現(xiàn)有的模型中而不破壞其初始特征,如果輸入通道的數(shù)量不同于輸出通道的數(shù)量,則在殘差路徑中插入1×1卷積(圖3中帶虛線的紫色方框),以轉(zhuǎn)換輸入來匹配通道維度上的輸出。

2.4 多尺度時態(tài)建模模塊

為了捕獲骨架序列的動態(tài)時間模式以及建模相鄰和非相鄰時間步長之間的長距離時態(tài)關系,本文提出使用多尺度卷積建模時間序列的多尺度信息,增強了時間卷積層,豐富了模型在時間維度上的感受野。該模塊的網(wǎng)絡結構如圖4所示。

圖4 多尺度時態(tài)建模模塊Fig.4 Multi-scale temporal modeling module

模塊的輸入為特征矩陣fin∈C×Tin×J,Tin為輸入骨架序列的初始幀數(shù),采用并行的多分支結構,在不同的感受野下進行特征的提取來實現(xiàn)對多尺度時間信息的捕捉。該模塊由四個分支實現(xiàn),每個分支包含一個1×1卷積以減少通道維數(shù)。從左到右看,前兩個分支分別使用空洞率為1、2,卷積核大小都為5×1 的空洞卷積。空洞卷積可以在不引入額外參數(shù)的同時增加感受野,是卷積操作的一種。它的實現(xiàn)方式為在卷積核的每行每列中間加入零元素,將插入的空洞個數(shù)稱為空洞率(dilation rate)。空洞卷積的參數(shù)包括卷積核個數(shù)k,卷積核大小w×h,空洞率d,步長s和填充值p。這里沒有選擇更大空洞率是因為稀疏的卷積核會使無用的權重增加,產(chǎn)生一些無效信息。不同空洞率產(chǎn)生的有效感受野在時間維度上體現(xiàn)為不同的時間間隔,在具體實驗中,將上一層輸出的空間特征C×Tin×J作為輸入,按通道維數(shù)平均分成四個部分,每個分支通過1×1卷積操作來轉(zhuǎn)換通道數(shù),使每個分支的通道數(shù)為C′(即C′=C/4)。之后前兩個分支通過5×1的空洞卷積操作,將輸入特征轉(zhuǎn)換為C′×T1×J矩陣和C′×T2×J矩陣。因此前兩個分支分別捕獲了相鄰時間幀和非相鄰時間幀上的高級時間特征,也對不同持續(xù)時間的動作序列選擇了合適的尺度進行特征的提取。時域維度上時間幀數(shù)T1、T2如下計算得出:

第三個分支保留了時間幀上的原始特征,得到的特征矩陣為C′×T3×J。第四個分支采用3×1的最大池化操作得到C′×T4×J的特征矩陣,提取了時間維度中具有最突出信息的特征。時間幀數(shù)T3、T4計算如下:

將四個分支的結果連接起來得到融合特征,獲得了時間維度上的多尺度信息,其公式如下:

Tout為輸出骨架序列的時間幀數(shù),通過將四個分支串聯(lián)使通道數(shù)變?yōu)镃(即保證了輸入特征的通道數(shù)不變),最終提取到多尺度時間特征f tout∈C×Tout×J。通過聚合多尺度時間信息來更新節(jié)點的特征,如圖5所示。

圖5 時間域上的卷積Fig.5 Convolution in time domain

另外,同自適應圖卷積模塊一樣,增加殘差連接(圖4中帶虛線的綠色方框),以轉(zhuǎn)換輸入來匹配輸出通道的維數(shù)。

3 實驗及結果分析

本文的實驗在NTU RGB+D 和NTU RGB+D 120兩個大型公開數(shù)據(jù)集上完成,后一個數(shù)據(jù)集是前一個的擴展。這兩個數(shù)據(jù)集是目前骨架動作識別任務中使用最廣泛的,本文以此驗證所提出模型的有效性,并與近年來主流的方法進行了比較。

3.1 數(shù)據(jù)集介紹

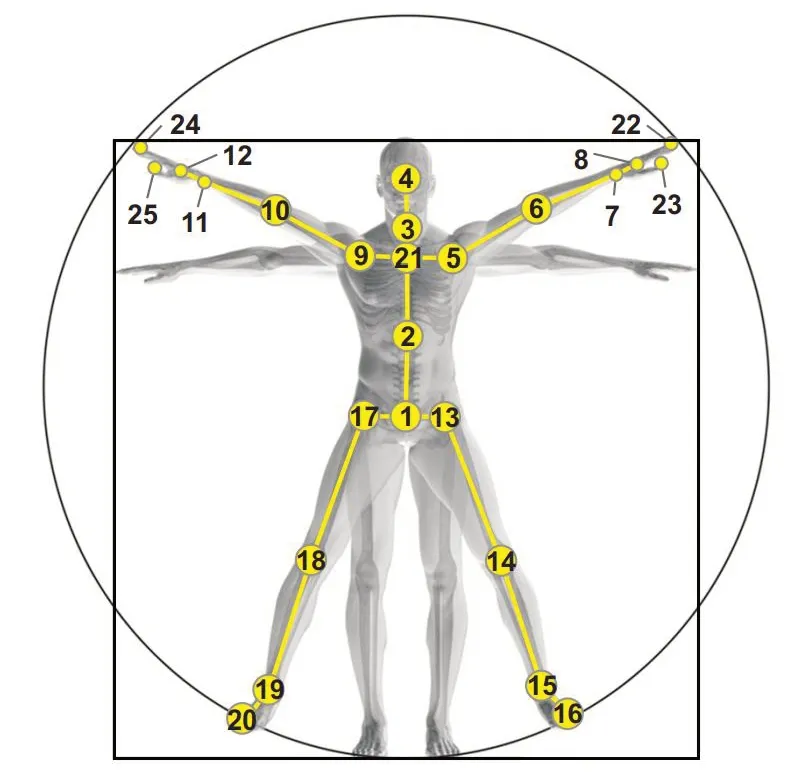

NTU RGB+D數(shù)據(jù)集[25]:該數(shù)據(jù)集包含了60個動作類別,其中40 個為日常行為動作,9 個為與健康相關的動作,還有11 個屬于雙人交互動作。這些動作由40 個年齡從10 到35 歲的志愿者完成,共56 880 個樣本序列。數(shù)據(jù)采集由位于相同高度,三個不同角度的攝像機完成,并通過Kinect深度傳感器獲得了3D骨架數(shù)據(jù),每個人體骨架包含25個關節(jié)點,如圖6所示。該數(shù)據(jù)集提供了兩種訓練和測試模式,CS(cross-subject)和CV(crossview)。CS模式下,訓練集使用20個志愿者的40 320個樣本,而其余20 個志愿者的16 560 個樣本作為測試集進行模型評估。CV模式是依據(jù)攝像機角度劃分訓練集和測試集,其中來自0°和45°視角的37 920 個樣本作為訓練集,來自-45°視角的18 960個樣本作為測試集。

圖6 NTU RGB+D數(shù)據(jù)集的關節(jié)標簽Fig.6 Joint label for NTU RGB+D dataset

NTU RBG+D 120數(shù)據(jù)集[26]:該數(shù)據(jù)集是目前最大的室內(nèi)動作識別數(shù)據(jù)集,也是NTU RBG+D數(shù)據(jù)集在志愿者和動作類別數(shù)量上的擴展。由106 名志愿者參與采集,共計包含120 個動作類別,114 480 個樣本序列。采集過程中共設置了32 個不同的場景,主要包括位置和背景的變化。該數(shù)據(jù)集也提供兩種訓練和測試模式,CSub(cross-subject)和CSet(cross-setup)。CSub 模式下把志愿者分為兩組,訓練集和測試集各包含來自53 個志愿者的樣本。而CSet 模式按照場景設置進行分組,訓練集和測試集分別包含來自16個場景設置下采集的樣本。

3.2 實驗設置

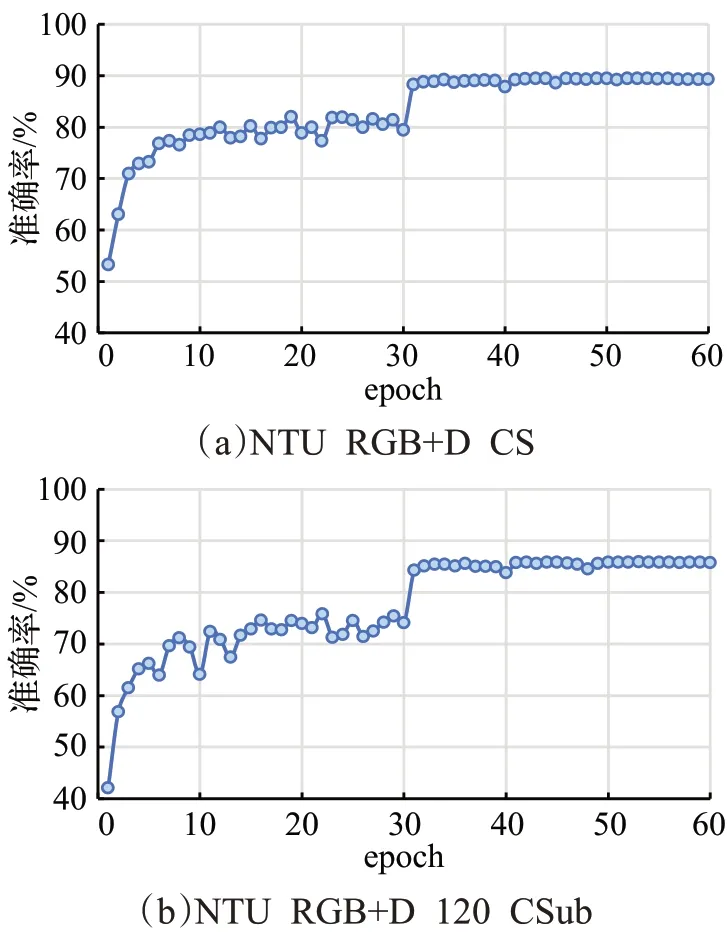

實驗均在PyTorch 深度學習框架下完成,運行環(huán)境為Win 10 操作系統(tǒng),32 GB 內(nèi)存,GPU 為1 塊RTX 2080Ti 顯卡。在模型訓練過程中,批量大小設為16,并采用帶動量的隨機梯度下降優(yōu)化算法。選用交叉熵損失函數(shù),把權重衰減初始值設為0.000 1。初始學習率設為0.1,在第30輪、40輪后減小為1/10。整個訓練過程可在第50輪迭代后結束(如圖7所示)。本文基于top-1準確率評估和比較模型的性能。

圖7 模型訓練過程中準確率的變化Fig.7 Changes of accuracy during model training

3.3 實驗結果

首先在NTU RGB+D 數(shù)據(jù)集的CS 模式和NTU RGB+D 120的CSub模式下進行了訓練和測試,觀察本文模型隨迭代次數(shù)增加而發(fā)生的性能變化,如圖7 所示。可以看出,當?shù)螖?shù)(以epoch表示)超過31之后top-1 準確率即趨向平穩(wěn)。第50 輪后,準確率呈現(xiàn)穩(wěn)定不變的趨勢。接下來,對本文模型中使用的不同模塊分別進行性能驗證和分析。

3.3.1 自適應圖卷積模塊性能分析

如2.3 節(jié)所述,自適應圖卷積模塊中有3 種類型的圖,分別是Ak、Lk和Pk。Ak表示整體骨架結構,Lk+Pk組合與數(shù)據(jù)樣本的關節(jié)點具體連接強度相關,表示自適應性。僅保留Ak或Lk+Pk組合,進行消融實驗比較分析。這里,使用關節(jié)點數(shù)據(jù)流在NTU RGB+D 120數(shù)據(jù)集的CSub 模式下完成實驗,top-1 準確率結果如表1 所示。可以看出,使用Lk+Pk組合的識別準確率高于僅使用Ak的情況。自適應圖卷積模塊在Ak、Lk和Pk都使用的情況下識別率是最高的,為了更好地說明Lk和Pk的作用,以跑步動作為例進行了可視化展示,如圖8所示。

表1 自適應圖卷積模塊有效性驗證Table 1 Validation of adaptive graph convolution module

圖8 自適應圖卷積效果可視化示例Fig.8 Visualization example of effectiveness for adaptive graph convolution module

圖8中為跑步動作序列某幀的骨架圖,紅色圓點代表關節(jié)點,其外面粉色圓圈的大小代表當前關節(jié)點和第25個關節(jié)點(圖6所示)之間的關聯(lián)強度,圓圈越大表示強度越大。自適應圖卷積模塊中通過引入Lk和Pk增強了模型的靈活性和對樣本的自適應性,從圖8中手和腿、手和腳之間有著更強的關聯(lián)度可以看出其作用,原本相距較遠的關節(jié)點由于動作樣本類別的特性也可以產(chǎn)生較強的連接。由以上分析可以表明,自適應圖卷積模塊根據(jù)不同的層和樣本學習了不同的圖拓撲結構,提取到了骨骼空間域中更高級的特征,能夠幫助提升動作識別的準確率。

3.3.2 多尺度時態(tài)建模性能分析

為驗證多尺度時態(tài)建模模塊的有效性,在NTU RGB+D和NTU RGB+D 120兩個數(shù)據(jù)集上進行消融實驗,top-1 準確率結果如表2 所示。可以看出,多尺度時態(tài)建模模塊在兩個數(shù)據(jù)集上都可以幫助提高識別準確率。在包含動作類別數(shù)量更多的NTU RGB+D 120 數(shù)據(jù)集上,可以使準確率增加3 個百分點(CSub)和2.7 個百分點(CSet)。因此,充分挖掘動作序列的時域內(nèi)在聯(lián)系,進行多尺度時態(tài)建模分析,能夠增強模型整體的識別性能,使得識別結果更加準確。

表2 多尺度時態(tài)建模有效性驗證Table 2 Validation of multi-scale temporal modeling

為進一步分析多尺度時態(tài)建模的作用,選取了2類持續(xù)時間較長的動作“刷牙”和“脫鞋”,3類持續(xù)時間較短的動作“手里東西掉落”“鼓掌”和“敲擊鍵盤”,以柱狀圖的方式展示這5 類動作的識別性能,如圖9 所示。可以看出,在多尺度時態(tài)建模加入的情況下,所選5 類動作的識別性能都有明顯提高。雖然各類動作的持續(xù)時間長短不同,但是利用多尺度卷積建模方式,有效地聚合了相鄰時間幀和非相鄰時間幀上的時態(tài)關系,減少了在局部空間中干擾時間特征聚合的與動作無關的時間信息,賦予了網(wǎng)絡在時間域上更好的特征表達能力,從而能夠更好地進行動作分類。

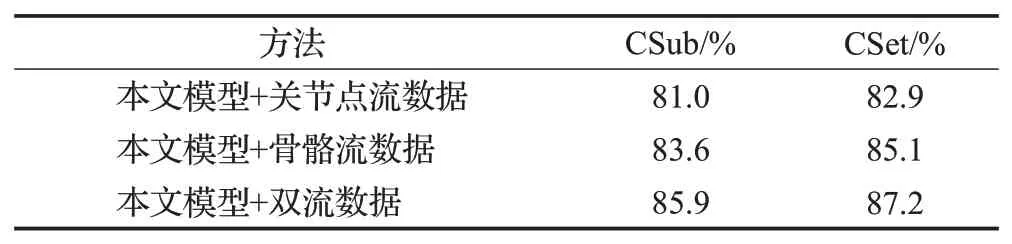

3.3.3 雙流數(shù)據(jù)網(wǎng)絡性能分析

基于人體骨架的關節(jié)點流和骨骼流數(shù)據(jù)信息構成雙流網(wǎng)絡結構,本小節(jié)使用NTU RGB+D 120數(shù)據(jù)集比較了單獨使用關節(jié)點流數(shù)據(jù)和骨骼流數(shù)據(jù)作為輸入的性能,以及將這兩種數(shù)據(jù)組合之后的性能,如表3所示。所使用的本文模型為自適應圖卷積+多尺度時態(tài)建模。可以看出,將兩流數(shù)據(jù)組合后可以進行信息的相互補充,識別性能明顯高于基于單流的情況。

表3 不同的數(shù)據(jù)流輸入下準確率比較Table 3 Comparison results with different input data-stream

3.3.4 與其他模型比較

在NTU RGB+D和NTU RGB+D 120兩個數(shù)據(jù)集上,將本文方法和近年來有代表性的模型進行了比較,比較內(nèi)容包括top-1 準確率和模型復雜度(參數(shù)量和FLOPs)方面效率的比較,如表4所示。用于比較的方法主要分為4種,包括手工設計特征的方法[6]、基于RNN的方法[8-11]、基于CNN的方法[12,14]和基于GCN的方法[15-18,21-22,27]。其中文獻[18,21]也屬于使用雙流網(wǎng)絡結構的方法。另外,還選擇了結合多個注意力機制的GCN 類方法[27]用于比較。

表4 本文模型與其他方法的結果比較Table 4 Results comparison between proposed model and other methods

從表4 可以看出,自從Yan 等[15]首次將圖卷積引入基于骨架的動作識別并提出ST-GCN 模型以來,基于GCN 的方法逐漸實現(xiàn)了顯著的性能提升,這表明了圖卷積網(wǎng)絡在處理動作識別骨架序列數(shù)據(jù)方面的有效性。與RNN類的方法和CNN類的方法相比,本文模型在兩個數(shù)據(jù)集的兩種驗證模式上的性能表現(xiàn)都有大幅提升。與同樣采用雙流結構的方法[18,21]相比,本文模型的top-1 準確率更高,有效地證明了模型的優(yōu)越性。在模型復雜度方面,與GCN類方法進行了比較。由表4可知,本文模型的參數(shù)量和FLOPs 指標相對不高,不需要過多的運算資源支持。多尺度時態(tài)建模的引入豐富了時域特征,強化了特征的多維整體表達能力,對網(wǎng)絡訓練的收斂速度起到一定的促進作用。因此,綜上而言,本文方法具有較強的競爭性,預期的應用前景良好。

4 結語

本文提出了結合自適應圖卷積模塊和多尺度時態(tài)模塊的骨架動作識別模型。自適應圖卷積通過把骨架數(shù)據(jù)的拓撲結構參數(shù)化,并嵌入圖網(wǎng)絡中,以便與模型一起學習和更新。多尺度時態(tài)模塊可以提取較復雜的時間動態(tài)特征,豐富了時間維度上的感受野,建立了時間域中的短期和長期依賴關系。兩個模塊相輔相成,使得網(wǎng)絡模型在時域和空域上具備更好的特征表達和建模分析能力。本文模型在兩個大規(guī)模的動作識別數(shù)據(jù)集NTU RGB+D 和NTU RGB+D 120 上進行了評估,識別性能均取得了較大程度的提升。在今后的工作中將考慮利用多模態(tài)數(shù)據(jù)融合的方式,進一步提高模型識別準確率,并加強模型的泛化能力。