基于人體關(guān)節(jié)點(diǎn)視覺(jué)特征的姿態(tài)識(shí)別方法研究進(jìn)展

梅健 王甜甜 黃凱 鄒青宇

摘 要 隨著深度學(xué)習(xí)和人工智能的發(fā)展,相關(guān)算法在人體姿態(tài)識(shí)別領(lǐng)域得到了廣泛應(yīng)用。基于人體關(guān)節(jié)點(diǎn)智能化算法的姿態(tài)識(shí)別得到了利用和優(yōu)化,現(xiàn)有的研究成果不同程度涉及各類(lèi)算法,亟待系統(tǒng)性總結(jié)和分類(lèi)。綜述近年來(lái)基于視覺(jué)特征的姿態(tài)識(shí)別領(lǐng)域的研究成果,將這些方法分為兩類(lèi):?jiǎn)稳俗藨B(tài)識(shí)別和多人姿態(tài)識(shí)別。分析各方法的原理和突出進(jìn)步,并介紹基于OpenPose方法的多人姿態(tài)研究,指出了未來(lái)研究的趨勢(shì)與焦點(diǎn)。

關(guān)鍵詞 人工智能 深度學(xué)習(xí) 多人姿態(tài)識(shí)別 智能化算法 OpenPose

中圖分類(lèi)號(hào) TP389.1? ?文獻(xiàn)標(biāo)識(shí)碼 A? ?文章編號(hào) 1000?3932(2023)02?0119?06

隨著科技的發(fā)展,智能化的概念和產(chǎn)品日新月異,在人工智能領(lǐng)域,人體姿態(tài)識(shí)別是計(jì)算機(jī)視覺(jué)領(lǐng)域中極具挑戰(zhàn)的研究方向,在道路姿態(tài)監(jiān)

控[1]、人體動(dòng)作分析[2,3]、運(yùn)動(dòng)培訓(xùn)[4~6]等方面都有重要的應(yīng)用前景,也是我國(guó)科研攻堅(jiān)的熱點(diǎn)。人體姿態(tài)通過(guò)智能識(shí)別檢測(cè)將提供一種全新的交互模式,如在車(chē)站或智能化娛樂(lè)場(chǎng)所,使用姿態(tài)識(shí)別的人工智能交互方式,能夠提供更準(zhǔn)確更智能的服務(wù)[7~9]。

姿態(tài)識(shí)別的重點(diǎn)是檢測(cè)人體關(guān)節(jié)點(diǎn)和肢體,并且能夠適應(yīng)各種多變的場(chǎng)景,姿態(tài)識(shí)別技術(shù)的本質(zhì)是問(wèn)題歸類(lèi)[10,11]。姿態(tài)識(shí)別以向量作為輸出,因此人體姿態(tài)識(shí)別方法需要一個(gè)從高維檢測(cè)向量到高維姿態(tài)向量的映射。在二維空間中,根據(jù)場(chǎng)景中人體個(gè)數(shù)的差異,將人體姿態(tài)識(shí)別分為單人姿態(tài)和多人姿態(tài)[12~14]。

1 單人姿態(tài)識(shí)別

隨著深度學(xué)習(xí)的發(fā)展與應(yīng)用,科研人員逐漸使用深度學(xué)習(xí)算法替代傳統(tǒng)方法進(jìn)行單人姿態(tài)識(shí)別,傳統(tǒng)的單人姿態(tài)識(shí)別是各種人體姿態(tài)分析的基礎(chǔ),對(duì)于分析圖像或視頻中的人體姿態(tài)至關(guān)重要。在深度學(xué)習(xí)的姿態(tài)識(shí)別方法中,人體姿態(tài)的骨骼節(jié)點(diǎn)具有尺度小、容易被遮擋的特性,因此算法需要更高的精度要求。

當(dāng)前,單人姿態(tài)識(shí)別方法中,坐標(biāo)回歸[14]、熱力圖檢測(cè)和使用熱力圖表示坐標(biāo)回歸是主流方法[15]。

坐標(biāo)回歸的原理是將二維坐標(biāo)的骨骼關(guān)節(jié)點(diǎn)作為有效值,訓(xùn)練網(wǎng)絡(luò)模型后實(shí)現(xiàn)關(guān)節(jié)點(diǎn)的輸出,在熱力圖檢測(cè)方法出現(xiàn)之前,這類(lèi)研究思路通常用于機(jī)器學(xué)習(xí)的單人姿態(tài)識(shí)別系統(tǒng)[14]。使用熱力圖表示坐標(biāo)回歸方法結(jié)合了坐標(biāo)和熱力圖兩者的優(yōu)點(diǎn),構(gòu)建組合方式的有效值,同時(shí)具有檢測(cè)和回歸任務(wù)[16]。

1.1 基于坐標(biāo)回歸的單人姿態(tài)識(shí)別

人體姿態(tài)識(shí)別中,坐標(biāo)回歸的數(shù)據(jù)存在大量冗余,這類(lèi)問(wèn)題的本質(zhì)是數(shù)值坐標(biāo)回歸。研究人體關(guān)節(jié)點(diǎn)回歸主要有兩種方法:

a. 全連接層直接回歸坐標(biāo)點(diǎn)。此類(lèi)方法的優(yōu)勢(shì)是輸出點(diǎn)就是坐標(biāo)點(diǎn)、縮短了訓(xùn)練時(shí)間、效率高,并且是端到端的全微分運(yùn)算。但特征圖容易丟失空間信息,直接回歸欠缺泛化性[17]。文獻(xiàn)

[18]中指出,采用全連接輸出坐標(biāo)點(diǎn)方式會(huì)極大損害空間泛化能力。全連接方式所得權(quán)重嚴(yán)重依賴(lài)訓(xùn)練數(shù)據(jù)的分布,非常容易造成過(guò)擬合。

b. 熱力圖檢測(cè)方式。通過(guò)熱力圖檢測(cè)可以收集海量數(shù)據(jù),Argmax提出峰值對(duì)應(yīng)的索引即為坐標(biāo)點(diǎn)的方法,使其精度高于坐標(biāo)回歸。但是從輸入到輸出不是一個(gè)全微分的算法,低分辨率的采樣精度低,并且內(nèi)存冗余高。

目前,全卷積網(wǎng)絡(luò)是單人姿態(tài)識(shí)別最常用的方法之一,其解決了環(huán)境和人體動(dòng)作的干擾。基于坐標(biāo)回歸的單人姿態(tài)識(shí)別主要分為兩大類(lèi):多階段直接回歸和多階段分步回歸。

文獻(xiàn)[19]針對(duì)視覺(jué)定位的局限性,提出回歸查詢(xún)像素點(diǎn)對(duì)應(yīng)的場(chǎng)景坐標(biāo)方法,此方法用于姿態(tài)識(shí)別的全卷積神經(jīng)網(wǎng)絡(luò),將彩色圖像中二維像素對(duì)應(yīng)的三維坐標(biāo)映射到場(chǎng)景圖像的RGB值中,快速建立匹配關(guān)系,無(wú)需特征檢測(cè)和特征匹配過(guò)程。

文獻(xiàn)[20]使用雙源深度卷積神經(jīng)網(wǎng)絡(luò)(Dual Source Deep Convolutional Neural Network,DS?CNN)從單一圖像設(shè)計(jì)二維人體姿態(tài)算法,提出將整個(gè)身體的外觀和多個(gè)微觀圖像結(jié)合起來(lái),可以更加準(zhǔn)確地實(shí)現(xiàn)人體姿態(tài)識(shí)別。

1.2 基于熱力圖檢測(cè)的單人姿態(tài)識(shí)別

單人姿態(tài)識(shí)別算法依據(jù)任務(wù)的定義和監(jiān)督形式可以劃分為兩類(lèi):直接坐標(biāo)回歸和熱力圖(Heatmap)檢測(cè)。各骨骼關(guān)節(jié)點(diǎn)相對(duì)原始圖片的偏移是坐標(biāo)回歸所需的數(shù)據(jù),這個(gè)過(guò)程對(duì)于非線(xiàn)性的要求非常高。所以,在基于坐標(biāo)回歸思路之后,熱力圖檢測(cè)方法成為單人姿態(tài)識(shí)別的主流方法[21]。

熱力圖檢測(cè)思想是將每個(gè)關(guān)節(jié)點(diǎn)的位置信息由一張低分辨率的熱力圖表示,熱力圖中的每一個(gè)像素值都代表該位置是否是關(guān)節(jié)點(diǎn)的概率。這種特性很容易利用高斯函數(shù)模擬。

文獻(xiàn)[22]針對(duì)人體關(guān)節(jié)點(diǎn)的熱力圖干擾姿態(tài)識(shí)別造成的姿態(tài)不一致的問(wèn)題,提出了一種基于圖模型推理的單人姿態(tài)識(shí)別網(wǎng)絡(luò),設(shè)計(jì)了人體姿態(tài)圖顯示人體結(jié)構(gòu)信息,并通過(guò)圖模型推理網(wǎng)絡(luò)實(shí)現(xiàn)關(guān)節(jié)點(diǎn)熱力圖間的信息交互。

文獻(xiàn)[23]提出一種基于深度卷積神經(jīng)網(wǎng)絡(luò)(Deep Convolutional Neural Network,DNN)的級(jí)聯(lián)姿態(tài)預(yù)測(cè)器,極大增強(qiáng)了骨骼關(guān)節(jié)點(diǎn)識(shí)別的準(zhǔn)確度。

從姿態(tài)識(shí)別開(kāi)始,不論完整圖像還是深度卷積神經(jīng)網(wǎng)絡(luò)的回歸向量,都可以使用細(xì)節(jié)聯(lián)合的方式預(yù)測(cè)數(shù)據(jù)。但是由于其固定的輸入大小,使得算法對(duì)于細(xì)節(jié)的處理存在不足。為了獲得更高的精度,訓(xùn)練多樣化成為主要待解決問(wèn)題,或者可以結(jié)合回歸和檢測(cè)兩種方式進(jìn)行姿態(tài)識(shí)別。

1.3 基于回歸與檢測(cè)混合方式的姿態(tài)識(shí)別

單人姿態(tài)識(shí)別中,坐標(biāo)回歸的優(yōu)點(diǎn)是更快的前向速度和端到端全微分訓(xùn)練,熱力圖檢測(cè)的優(yōu)點(diǎn)是精度高。結(jié)合兩者的優(yōu)點(diǎn),坐標(biāo)回歸中效果最好的方法是使用熱力圖表示坐標(biāo)回歸,直接坐標(biāo)回歸方法是從圖像到骨骼關(guān)節(jié)點(diǎn)坐標(biāo)的即時(shí)反映,弊端是網(wǎng)絡(luò)學(xué)習(xí)空間、收集數(shù)據(jù)空間不足和丟失空間信息[24]。

基于回歸和熱力圖檢測(cè)的人體姿態(tài)識(shí)別雖然性能良好,但存在后處理不可微、量化誤差大等問(wèn)題。文獻(xiàn)[25]通過(guò)積分運(yùn)算將熱力圖表示與聯(lián)合回歸結(jié)合,解決了后處理和量化誤差問(wèn)題,并且兼容任何基于熱力圖表示的方法。

諾丁漢大學(xué)計(jì)算機(jī)視覺(jué)實(shí)驗(yàn)室的ADRIAN B和GEORGIOS T提出一種檢測(cè)后回歸的由兩個(gè)相互連接深度子網(wǎng)組成的卷積神經(jīng)網(wǎng)絡(luò)級(jí)聯(lián)[21],級(jí)聯(lián)輸出的順序是先檢測(cè)熱力圖再回歸。該架構(gòu)不僅可以指導(dǎo)算法在圖像中的焦點(diǎn)位置,還可以有效應(yīng)對(duì)遮擋問(wèn)題,從而引導(dǎo)網(wǎng)絡(luò)的回歸部分來(lái)預(yù)測(cè)位置。

2 多人姿態(tài)識(shí)別

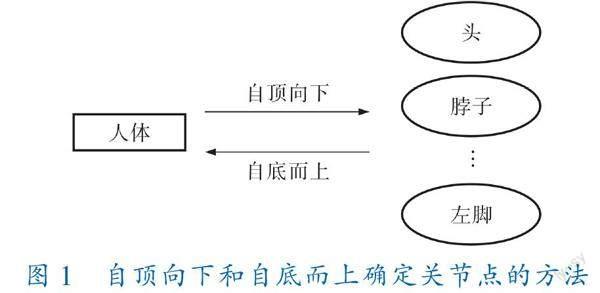

人體姿態(tài)算法從人數(shù)上區(qū)分為單人人體關(guān)節(jié)點(diǎn)檢測(cè)和多人人體關(guān)節(jié)點(diǎn)檢測(cè)兩類(lèi),自頂向下(Top?Down)和自底而上(Bottom?Up)是多人姿態(tài)識(shí)別領(lǐng)域常用的兩種處理思路。其中,自頂向下用于定位骨骼關(guān)節(jié)點(diǎn)的設(shè)計(jì),包括人體檢測(cè)和人體關(guān)節(jié)點(diǎn)檢測(cè),先從環(huán)境背景中估計(jì)每個(gè)待檢測(cè)目標(biāo),然后對(duì)單個(gè)人的關(guān)節(jié)點(diǎn)進(jìn)行檢測(cè);自底而上的邏輯與之相反,分別檢測(cè)和類(lèi)聚關(guān)節(jié)點(diǎn),即先檢測(cè)出圖像中所有的人體骨骼關(guān)節(jié)點(diǎn),然后將全部關(guān)節(jié)點(diǎn)連接成個(gè)人[14]。

自頂向下和自底而上確定關(guān)節(jié)點(diǎn)的方法如圖1所示。

2.1 自頂向下算法

自頂向下算法是先用目標(biāo)檢測(cè)算法檢測(cè)出圖像中存在的所有人體實(shí)例,然后逐個(gè)檢測(cè)不同人體的關(guān)節(jié)點(diǎn)[15,17,18]。二維多人姿態(tài)估計(jì)方法使用串聯(lián)網(wǎng)絡(luò)提取特征,然后提高特征圖的分辨率,用于關(guān)節(jié)點(diǎn)的定位[26~30]。

文獻(xiàn)[31]研究了順序卷積結(jié)構(gòu)模型,多層深度卷積網(wǎng)絡(luò)是卷積姿態(tài)結(jié)構(gòu)的基礎(chǔ),每層網(wǎng)絡(luò)都是在原始圖像和前期數(shù)據(jù)的特征圖上進(jìn)行,最終可以得到人體各關(guān)節(jié)點(diǎn)結(jié)構(gòu)圖。文獻(xiàn)[28]提出的算法使用ResNet來(lái)提取特征,用反卷積提高分辨率。最初,多人檢測(cè)網(wǎng)絡(luò)為Faster R?CNN[32],F(xiàn)aster R?CNN的出現(xiàn)縮短了檢測(cè)網(wǎng)絡(luò)的運(yùn)行時(shí)間。Mask R?CNN提高了檢測(cè)回歸的準(zhǔn)確性,并使用像素到像素的方式進(jìn)行分割預(yù)測(cè),便可以對(duì)檢測(cè)到的目標(biāo)進(jìn)行多人姿態(tài)識(shí)別[33]。

文獻(xiàn)[34]提出一種用于多人檢測(cè)和二維姿態(tài)識(shí)別的自頂向下方法。針對(duì)關(guān)節(jié)點(diǎn)類(lèi)型,提出且實(shí)現(xiàn)了完全卷積用來(lái)預(yù)測(cè)熱力圖。

文獻(xiàn)[35]采用自頂向下的二維多人姿態(tài)識(shí)別算法,使用金字塔卷積,采用一種基于多尺度融合的二維多人姿態(tài)識(shí)別模型,該模型能夠同時(shí)取得圖像中人體局部的關(guān)節(jié)信息和全局結(jié)構(gòu)信息,從而可以更準(zhǔn)確地定位難以檢測(cè)的關(guān)節(jié)點(diǎn)。

2.2 自底而上算法

自底而上算法是檢測(cè)圖像中所有人的身體關(guān)節(jié),再將其分組為個(gè)體。由于設(shè)計(jì)識(shí)別中尺度的變化,自底而上的人體姿態(tài)識(shí)別方法難以高精準(zhǔn)度估計(jì)人體姿態(tài)。文獻(xiàn)[29]使用金字塔卷積網(wǎng)絡(luò)方法提出了一種新的自底而上的更迅速的定位關(guān)節(jié)點(diǎn),并且可以解決多人姿態(tài)檢測(cè)中尺度變化的檢測(cè)方法。

為了聯(lián)合應(yīng)對(duì)檢測(cè)和姿態(tài)識(shí)別,更準(zhǔn)確地識(shí)別環(huán)境中的人數(shù),判斷遮擋的重要關(guān)節(jié)點(diǎn),并且消除相互重合的身體部分[36~39],文獻(xiàn)[40]為確定關(guān)節(jié)點(diǎn)對(duì)應(yīng)的人體部位,首先提出了DeepCut,改進(jìn)了快速區(qū)域卷積神經(jīng)網(wǎng)絡(luò)來(lái)檢測(cè)骨骼關(guān)節(jié)點(diǎn),組合成關(guān)節(jié)點(diǎn)密度圖,再標(biāo)記檢測(cè)出的關(guān)節(jié)點(diǎn)。文獻(xiàn)[41]為優(yōu)化算法的復(fù)雜度,精簡(jiǎn)了DeepCut算法,提高了檢測(cè)的精準(zhǔn)度,利用殘差網(wǎng)絡(luò)ResNet獲取人體骨骼關(guān)節(jié)點(diǎn),提高了魯棒性。

文獻(xiàn)[42]設(shè)計(jì)了OpenPose,最先使用VGG網(wǎng)絡(luò)對(duì)圖樣特征進(jìn)行粗提取,從而得到關(guān)節(jié)點(diǎn)置信圖(Part Confidence Maps,PCMs)和部位親和域(Part Affinity Fields,PAFs),使用匈牙利算法[43]最優(yōu)化匹配,連接所有骨骼關(guān)節(jié)點(diǎn)。

3 基于自底而上的OpenPose方法

OpenPose是根據(jù)卷積神經(jīng)網(wǎng)絡(luò)與監(jiān)督學(xué)習(xí),以Caffe為框架編寫(xiě)的開(kāi)放源代碼庫(kù),能夠進(jìn)行人的臉部、軀干與四肢的跟蹤,不僅適用于單人也適用于多人,同時(shí)具有較好的魯棒性[14],是用于2D、3D多人人體姿態(tài)估計(jì)的最流行的自底而上的方法之一,該成果在單人和多人人體姿態(tài)識(shí)別中取得了成功。

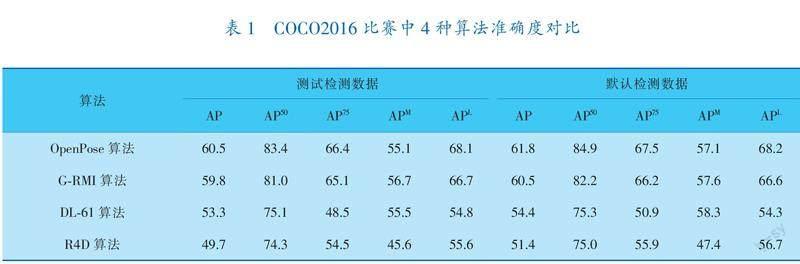

OpenPose算法、G?RMI算法、DL?61算法和R4D算法在2016年COCO比賽中的準(zhǔn)確度對(duì)比見(jiàn)表1,其中,AP表示實(shí)驗(yàn)結(jié)果中與關(guān)節(jié)點(diǎn)坐標(biāo)對(duì)比的準(zhǔn)確度,AP50與AP75表示與關(guān)節(jié)點(diǎn)相似度在50%以上及75%以上的準(zhǔn)確度,APM與APL則分別表示識(shí)別小規(guī)模人群和大規(guī)模人群的準(zhǔn)確度。

美國(guó)卡耐基梅隆大學(xué)(Carnegie Mellon University)在2016年開(kāi)源了OpenPose項(xiàng)目,該成果在單人和多人人體姿態(tài)識(shí)別中取得了巨大成功。OpenPose項(xiàng)目采用自底而上的思路,先找出圖像中人體的各個(gè)關(guān)節(jié)點(diǎn),再用這些點(diǎn)拼接成人的骨架,完成姿態(tài)識(shí)別的任務(wù)。OpenPose可以實(shí)現(xiàn)人體關(guān)節(jié)點(diǎn)的信息檢測(cè),并且適用于單人和多人環(huán)境。研究表明,OpenPose具有很高的魯棒性和精準(zhǔn)度,適用于戶(hù)外等復(fù)雜環(huán)境[44,45]。

文獻(xiàn)[42]給出了OpenPose算法模型,解決了多人肢體關(guān)節(jié)點(diǎn)連接的問(wèn)題,不過(guò)仍然存在模型較大、網(wǎng)絡(luò)參數(shù)較多等現(xiàn)實(shí)問(wèn)題需要解決。文獻(xiàn)[46]提出一種新的自底而上的多人人體姿態(tài)識(shí)別方法,構(gòu)建了一個(gè)完全卷積、單發(fā)的設(shè)計(jì),該方法利用部分強(qiáng)度場(chǎng)定位身體部位,利用關(guān)聯(lián)場(chǎng)將身體各部分結(jié)合了起來(lái)。文獻(xiàn)[47]在OpenPose的基礎(chǔ)上首先提出了Lightweight OpenPose輕量級(jí)的方法,探討了適合于實(shí)時(shí)人體姿態(tài)識(shí)別網(wǎng)絡(luò)邊緣設(shè)備上的性能。使用Mobilenet[48]提取數(shù)據(jù),最后結(jié)合空洞卷積[49]優(yōu)化OpenPose。

4 總結(jié)和展望

人體姿態(tài)識(shí)別是計(jì)算機(jī)視覺(jué)的分支,在多領(lǐng)域都具有高質(zhì)量的發(fā)展。國(guó)內(nèi)關(guān)于人體姿態(tài)識(shí)別的研究起步晚、研究投入少,但在國(guó)家安防和日常生活中,該技術(shù)具有極大的應(yīng)用市場(chǎng)和發(fā)展前景。目前,人體姿態(tài)識(shí)別的問(wèn)題和難點(diǎn)集中在兩點(diǎn),往后的工作也會(huì)從這兩方面展開(kāi):

a. 提高數(shù)據(jù)采集的魯棒性。樣本數(shù)據(jù)的噪聲和樣本種類(lèi)的相似度都會(huì)降低數(shù)據(jù)采集的質(zhì)量、影響特征選取和導(dǎo)致邊緣輪廓缺失。使用模型驅(qū)動(dòng)輸入可以保持原有特性,在識(shí)別檢測(cè)過(guò)程中會(huì)有輸入噪聲影響結(jié)果,通常采用空約束來(lái)提高輸出質(zhì)量。因此,對(duì)于基于模型驅(qū)動(dòng)的方法,探討更有效的運(yùn)動(dòng)空間時(shí)序約束十分必要。在戶(hù)外環(huán)境中捕捉圖像會(huì)受到多種因素的影響,主要有氣候環(huán)境變化、背景干擾、光照變換、人體移動(dòng)的影子、攝像機(jī)的運(yùn)動(dòng)等,這些都給實(shí)驗(yàn)數(shù)據(jù)的采集和預(yù)處理帶來(lái)了影響。對(duì)于處理的圖像序列,在目標(biāo)檢測(cè)中,雖然可以進(jìn)行多種數(shù)據(jù)預(yù)處理,但是數(shù)據(jù)依然存在冗余,非必要的數(shù)據(jù)依舊會(huì)影響整體的運(yùn)算量和速度,開(kāi)發(fā)新的高效率算法,在數(shù)據(jù)采集和判斷過(guò)程中是急需解決的問(wèn)題。

b. OpenPose算法的有效性和實(shí)時(shí)性之間的誤差。當(dāng)前,人體姿態(tài)研究都是基于相似的算法,算法的創(chuàng)新程度存在一定限制。OpenPose架構(gòu)在人體姿態(tài)識(shí)別上具有優(yōu)勢(shì),先找出環(huán)境中的人體關(guān)節(jié)點(diǎn),再逐一拼接成人體骨架,但是對(duì)于環(huán)境的判斷存在不足。基于模型的算法可以更精準(zhǔn)地判斷和描述關(guān)節(jié)點(diǎn)特征,大幅降低外部環(huán)境的影響。因此,低功耗、高精度的姿態(tài)算法是目前姿態(tài)算法重要的研究目標(biāo)。

參 考 文 獻(xiàn)

[1] 朱棟棟.基于視覺(jué)檢測(cè)與定位的快速路車(chē)輛異常行為識(shí)別[D].北京:北京郵電大學(xué),2022.

[2] 汪雯.基于深度學(xué)習(xí)的人體動(dòng)作分析與識(shí)別方法研究[D].成都:電子科技大學(xué),2022.

[3] 崔莉亞.運(yùn)動(dòng)場(chǎng)景下人體動(dòng)作分析算法研究[D].鄭州:鄭州大學(xué),2021.

[4] 李淑敏,周曙,田國(guó)輝,等.科技助力冬奧:人工智能在冰雪運(yùn)動(dòng)訓(xùn)練中的應(yīng)用與發(fā)展[C]//中國(guó)體育科學(xué)學(xué)會(huì)運(yùn)動(dòng)訓(xùn)練學(xué)分會(huì).2022年全國(guó)運(yùn)動(dòng)訓(xùn)練學(xué)術(shù)研討會(huì).2022:106.

[5] 韓曉明,喬鳳杰.人工智能助力全民健身參與的基本邏輯、現(xiàn)實(shí)困境與突破路徑[J].天津體育學(xué)院學(xué)報(bào),2022,37(5):559-565.

[6] 朱厚偉,申翠梅,鄭哲,等.基于人工智能的運(yùn)動(dòng)輔助系統(tǒng)研發(fā)進(jìn)展研究[C]//中國(guó)體育科學(xué)學(xué)會(huì)運(yùn)動(dòng)生物力學(xué)分會(huì).第二十二屆全國(guó)運(yùn)動(dòng)生物力學(xué)學(xué)術(shù)交流大會(huì).2022:391-392.

[7] 洪梁杰.基于視覺(jué)的人體軀干特征提取與姿態(tài)識(shí)別[D].吉林:東北電力大學(xué),2022.

[8] 王珊,張雙寒,高靖楠,等.基于PoseNet模型實(shí)現(xiàn)人體姿態(tài)識(shí)別[J].電腦編程技巧與維護(hù),2022(1):112-113;135.

[9] 黃國(guó)范,李亞.人體動(dòng)作姿態(tài)識(shí)別綜述[J].電腦知識(shí)與技術(shù),2013,9(1):133-135.

[10] 史偉民.基于深度學(xué)習(xí)的人體姿態(tài)估計(jì)方法研究[D].北京:北京化工大學(xué),2021.

[11] 車(chē)鑫.基于深度學(xué)習(xí)的二維人體姿態(tài)估計(jì)研究[D].武漢:華中科技大學(xué),2021.

[12] 王梓任.人體關(guān)節(jié)點(diǎn)多視角融合和人體姿態(tài)估計(jì)[D].濟(jì)南:山東大學(xué),2019.

[13] 王子沁.基于OpenPose的人體行為識(shí)別系統(tǒng)研究與實(shí)現(xiàn)[D].南京:南京郵電大學(xué),2021.

[14] 鄧益儂,羅健欣,金鳳林.基于深度學(xué)習(xí)的人體姿態(tài)估計(jì)方法綜述[J].計(jì)算機(jī)工程與應(yīng)用,2019,55(19):22-42.

[15] 張鋒,葉茂,曾凡玉.深度學(xué)習(xí)的單人姿態(tài)估計(jì)方法綜述[J].小型微型計(jì)算機(jī)系統(tǒng),2020,41(7):1502-1507.

[16] SUN K,XIAO B,LIU D,et al.Deep high?resolution representation learning for human pose estimation[C]//Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition.2019:5693-5703.

[17]? NIBALI A,HE Z,MORGAN S,et al.Numerical Coordinate Regression with Convolutional Neural Networks[J].arXiv,2018.10.48550/arXiv.1801.07372.

[18]? LIN M,CHEN Q,YAN S C.Network in Network:10.48550/arXiv.1312.4400[P].2013-12-16.

[19] ALEX K,MATTHEW G,ROBERTO C.PoseNet:A Convolutional Network for Real?Time 6?DOF Camera Relocalization[C]//IEEE International Conference on Computer Vision.Santiago,Chile,2015:2938-2946.

[20]? ?FAN X C,ZHENG K,LIN Y W,et al.Combining Local Appearance and Holistic View:Dual?Source Deep Neural Networks for Human Pose Estimation[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition.2015:1347-1355.

[21]? ?ADRIAN B,GEORGIOS T.Human pose estimation via convolutional part heatmap regression[C]//Proceedings of the European Conference on Computer Vision(ECCV).2016:717-732.

[22]? ?馬麗華.基于推理的多等級(jí)預(yù)測(cè)單人姿態(tài)估計(jì)方法[D].西安:西安電子科技大學(xué),2020.

[23]? ?TOSHEV A,SZEGEDY C.Deeppose:Human pose es?timation via deep neural networks[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern? Recognition.2014.10.1109/CVPR.2014.214.

[24]? ?LEE C Y,XIE S N,PATRICK W G,et al.Deeply?Supervised Nets[J].arXiv:Machine Learning,2014.10.48550/arXiv.1409.5185.

[25]? ?SUAN X,XIAO B,WEI F Y,et al.Integral human pose regression[C]//Proceedings of the European Conference on Computer Vision(ECCV).2018:529-545.

[26]? ?郭天曉,胡慶銳,李建偉,等.基于人體骨架特征編碼的健身動(dòng)作識(shí)別方法[J].計(jì)算機(jī)應(yīng)用,2021,41(5):1458-1464.

[27]? ?林里浪,宋思捷,劉家瑛.基于人體骨架特征學(xué)習(xí)的動(dòng)作識(shí)別[J].中國(guó)傳媒大學(xué)學(xué)報(bào)(自然科學(xué)版),2021,28(5):22-28.

[28]? ?XIAO B,WU H P,WEI Y C.Simple Baselines for Human Pose Estimation and Tracking[C]//European Conference on Computer Vision.2018:472-487.

[29] CHENG B W,XIAO B,WANG J D,et al.HigherHRNet:Scale?Aware Representation Learning for Bottom?Up Human Pose Estimation[C]//Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition.2020:5385-5395.

[30]? ?BOBICK A F,WILSON A D.A state?based approach to the representation and recognition of gesture[J].IEEE Trans PAMI,1997,19(12):1325-1337.

[31]? WEI S E,RAMAKRISHNA V.Convolutional pose machine[C]//Proceedings of 2016 IEEE Conference on Computer Vision and Pattern Recognition.2016.

[32]? ?REN S Q,HE K M,ROSS G,et al.Faster R?CNN:towards Real?time Object Detection with Region Proposal Networks[C]//Proceedings of IEEE ANIPS15.2015.

[33]? ?HE K M,GKIOXARI G,DOLLAR P,et al.Mask R?CNN[C]//Proceedings of IEEE International Confe?rence on Computer Vision.2017:2961-2970.

[34]? ?PAPANDREOU G,ZHU T,KANAZAWA N,et al.Towards accurate multi?person pose estimation in the wild[C]//2017 IEEE Conference on Computer Vision and Pattern Recognition CVPR.2017.

[35]? ?湯香渝.基于多尺度融合的二維人體姿態(tài)估計(jì)算法研究[D].北京:北方工業(yè)大學(xué),2021.

[36]? ?MUHAMMED K,SALIH K,ENRE A.MultiPoseNet:Fast multi?person pose estimation using pose residual network[C]//European Conference on Computer Vision.2018.

[37]? ?SANGHOON H,BYUNG SEOK R,KYE?HYEON K,et al.PVANet:Lightweight Deep Neural Networks for Real?time Object Detection[J].arXiv Preprint arXiv,2016.

[38]? VASILEIOS B,ANDREW Z.Recurrent human pose estimation[C]//2017 12th IEEE International Confer?ence on Automatic Face and Gesture Recognition(FG).2017.

[39]? ?HE K M,ZHANG X Y,REN S P,et al.Deep residual learning for image recognition[C]//2016 IEEE Con?ference on Computer Vision and Pattern Recognition.2016.

[40]? ?PISHCHULIN L,INSAFUTDINOV E,TANG S,et al.DeepCut:Joint subset partition and labeling for multi person pose estimation[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recogni?tion.2016:4929-4937.

[41]? ?ELDAR I,LENONID P,BJOERN A,et al.DeeperCut:A deeper,stronger,and faster multi?person pose esti?mation model[C]//Proceedings of the European Conference on Computer Vision.2016:34-50.

[42]? ?ZHE C,TOMAS S,SHIH?EN W,et al.Realtime multi?person 2D pose estimation using part affinity fields[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition.2017:7291-7299.

[43]? ?STEFANO B,CARMEN D A,MARIA F,et al.Pilot assignment in cell?free massive MIMO based on the Hungarian algorithm[J].IEEE Wireless Commun?

ications Letters,2021(1):10.

[44]? ?MARK S,ANDREW H,ZHU M L,et al.MobileNet?

V2:Inverted Residuals and Linear Bottlenecks[C]//2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition(CVPR).2018.

[45]? ?TSUNG?YI L,MICHAEL M,SERGE B,et al.Micro?soft COCO:Common objects in context[C]//European Conference on Computer Vision.2014.

[46]? ?SVEN K,LORENZO B,ALEXANDRE A,et al.Pifp?af:Composite Fields for Human Pose Estimation[C]//IEEE Computer Vision Foundation.2020:11977-11986.

[47]? ?DANIIL O.Real?time 2D Multi?Person Pose Estima?tion on CPU:Lightweight OpenPose[C]//International Conference on Pattern Recognition Applications and Methods.2019.

[48]? ?ANDREW G H,ZHU M L,CHEN B,et al.Mobile?Nets:Efficient convolutional neural networks for mobile vision applications[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition.2017.

[49]? YU F,VLADLEN K,THOMAS F.Dilated Residual Networks[C]//IEEE Computer Vision Foundation.2017.

(收稿日期:2022-08-29,修回日期:2022-11-22)

Study Progress in Posture Recognition Method?Based on Visual Features of Human Joints

MEI Jian1, WANG Tian?tian2, HUANG Kai1, ZOU Qing?yu2

(1. College of Information and Control Engineering, Jilin Institute Chemical Technology;?2. College of Electrical and Information Technology, Beihua University)

Abstract? ?With the development of deep learning and artificial intelligence, relevant algorithms have been widely applied in human postures recognition and the posture recognition based on the intelligent algorithms for human joints has been optimized. Existing research results involve all kinds of algorithms at various degrees, wait for being systematically summarized and classified. A large number of recent research achievements in the posture recognition were reviewed and divided into single?person posture recognition and multi?person posture identification, including having their principles and outstanding progress analyzed, and their future research trends and hot spots were pointed out based on describing the OpenPose?based study of the multi?person postures.

Key words? ?AI, deep learning, multi?person posture recognition, intelligent algorithm, OpenPose

基金項(xiàng)目:中央引導(dǎo)地方科技發(fā)展資金吉林省基礎(chǔ)研究專(zhuān)項(xiàng)(YDZJ202101ZYTS170);教育部產(chǎn)學(xué)合作協(xié)同育人項(xiàng)目(202102181046);2020年度吉林省高等教育教學(xué)研究課題;國(guó)家大學(xué)生創(chuàng)新創(chuàng)業(yè)訓(xùn)練計(jì)劃項(xiàng)目(202210201055);吉林省職業(yè)教育與成人教育教學(xué)改革研究課題(PX?521509);吉林市科技創(chuàng)新發(fā)展計(jì)劃項(xiàng)目(20210103098)。

作者簡(jiǎn)介:梅健(1995-),碩士研究生,從事人體姿態(tài)識(shí)別方面的研究。

通訊作者:鄒青宇(1983-),副教授,從事復(fù)雜網(wǎng)絡(luò)的研究,zouqingyu2002@126.com。

引用本文:梅健,王甜甜,黃凱,等.基于人體關(guān)節(jié)點(diǎn)視覺(jué)特征的姿態(tài)識(shí)別方法研究進(jìn)展[J].化工自動(dòng)化及儀表,2023,50(2):119-124.