基于強化學習的車輛服務遷移方法

周 率, 韓 韌

(上海理工大學光電信息與計算機工程學院, 上海 200093)

0 引 言

隨著《車聯網(智能網聯汽車)產業發展行動計劃》通知的下發,中國車聯網發展的戰略目標已基本確定,“長三角三省一市統籌智能網聯汽車產業發展規劃”的簽署進一步加快了中國車聯網的發展。 5G 網絡基礎設施的不斷完善以及國內外車聯應用的涌現,使得車輛對計算資源和服務延遲的要求日益增加,現有車輛配備的計算資源已無法滿足車聯應用的需求,這種日益迫切的要求需要將車聯應用服務遷移到具有更高計算能力的云端服務器上,但是傳統的云計算不能滿足車聯網下的低延遲要求,因此需要考慮一種稱為車載邊緣計算(Vehicular Edge Computing,VEC)的計算范式。

在VEC 中,車輛將服務遷移到靠近車輛的路側單元(Road Side Unit,RSU)上,可以享受RSU 帶來的低延遲、高帶寬和充足的計算資源[1]。 然而,盲目的遷移有時會影響服務性能,如:對于一個固定的車輛,將服務遷移到最近的RSU 在短期內可以帶來良好的服務性能,但是考慮到車輛的移動性,該種策略可能會導致頻繁遷移,進一步導致服務頻繁中斷,因此一個最佳的服務遷移策略應該考慮車輛的移動性。 服務遷移也伴隨著各種成本,包括計算成本、遷移成本和能源消耗,以全面評估遷移的效果。 考慮到車輛的移動性,專注于短期的性能提升可能會導致頻繁遷移因而帶來巨大的成本,需要考慮遷移帶來的長期累積回報,以權衡整體性能的提高。 即當車輛遠離RSU 時,如果服務性能仍然處于可接受的水平,一個最佳的遷移策略應該權衡服務遷移帶來的收益與開銷。

為了提高服務遷移的性能表現,減少服務的延遲與開銷,文獻[2]研究了最小化移動設備和邊緣服務器的總能量消耗,通過啟發式算法產生了一個接近最優的解決方案;文獻[3]提出在卸載比例和子載波分配時,必須考慮各種系統限制,包括延遲和子載波資源限制,以減少移動設備的能耗,并從混合整數規劃(Mixed Integer Programming,MIP)問題中生成多對一匹配和線性編程的子問題,以解決子載波分配問題;文獻[4]研究了下行鏈路資源分配、卸載決策和計算資源分配的聯合優化,考慮了包括數據傳輸和任務計算的總成本,并建模為混合整數線性規劃(MILP)問題;文獻[5]提出了李雅普諾夫優化的卸載決策,可以減少平均響應時間,同時降低移動設備的能耗;文獻[6]評估了計算卸載的財務成本,并建模為決策和資源聯合優化的MILP 問題;文獻[7]以合作博弈理論為基礎,通過終端設備和邊緣云的協同合作來優化系統的性能,并提出了一種基于交易的計算卸載技術;文獻[8]提出了Follow-Me Chain 算法來解決服務功能鏈的問題;文獻[9]研究了任務卸載,考慮了能耗和服務延遲的約束,并使用了二元卸載決策;文獻[10]提出了一個基于強化學習的離線無線接入網絡分片解決方案和一個低復雜度的啟發式算法,以滿足不同分片的通信資源需求,使得資源利用率最大化;文獻[10]將遷移問題建模為一維馬爾科夫決策過程(Markov Decision Process,MDP),并考慮了服務器和設備之間的歐氏距離;文獻[12]考慮了二維MDP 模型并提出了基于深度強化學習的遷移方案,使得時延與能耗最小。

盡管現有的工作在服務遷移策略方面取得了很大的進展,但仍需要進一步探索,包括遷移過程中成本的建模以及車輛的移動性。 本文將車輛的服務遷移過程建模為MDP,同時考慮了包括計算成本、遷移成本和能耗的成本,此外,本文還使用行駛速度代表示車輛的運動狀態,并提出了一種基于強化學習的遷移算法,該算法可以有效地解決傳統MDP 中維度過高的問題,并利用Actor-Critic 網絡和熵來確保收斂性和可探索性。 最后,本文基于真實數據集進行實驗并對算法進行評估。

1 系統模型建立

車輛行駛隨機分布在城市區域的道路中,道路配備了若干通信范圍相等的RSU,并且每個RSU 都具有相同的計算能力。 用E={e1,e2,…,ei} 表示所有RSU 的集合,用U={u1,u2,…,uj}表示所有車輛的合集,每個車輛u∈U都有一個計算任務且可以選擇在本地計算或者通過無線網絡遷移到RSU 上。車輛移動時可以連接到任意一個路側單元e∈E。為了保證車輛采取遷移決策時的滿意程度,本文用遷移成本,計算成本,能源消耗等相關指標來衡量服務遷移過程中產生的開支。

1.1 通信模型

本文假定車輛通過V2X 的蜂窩網絡和毫米波與RSU 進行通訊。

1.1.1 5G 蜂窩網絡

根據香農公式,在假定被高斯白噪聲干擾的信道中,理論的最大信息傳輸速率為公式(1):

其中,B是信道帶寬;S是信道內所傳輸信號的平均功率;N是信道內部的高斯噪聲功率。

因此,車輛u和路側單元e之間的數據傳輸率可以表示為式(2):

其中,Bc是信道帶寬;Hu,e是車輛u的車載通信設備與其對應的路側單元e的傳輸功率;du,e表示車輛u與路側單元e的距離;h表示瑞利衰落因子;Nc是高斯噪聲功率。

1.1.2 毫米波模式

NR-V2X 采用毫米波模式,本文假定每輛車輛都配備有定向天線陣列,并且采用了定向波束形成來增強毫米波信號的傳播。 為了最大化提高毫米波天線的指向性增益,本文假定對發射器和接收器進行光束準直,因此可以將定向天線模式近似為理想的水平面上的扇形模型[13],天線增益可以建模為式(3):

其中,η為當前天線的角度與當天線增益達到峰值時的角度之差,即天線轉向方向的可容忍對準誤差;η′是射束寬度;gm和gs分別是主瓣和旁瓣天線的定向增益。

在上述條件下,本文將毫米波信道帶寬表示為式(4):

其中,Bm是毫米波信號帶寬。

車輛天線與基站天線的信噪比為式(5)[14]:

其中,pu是車輛u配備的毫米波收發器的傳輸功率;Nm是噪聲功率譜密度;du,e表示車輛u和路側單元e間的曼哈頓距離;ρ~N0,σ2() 是以分貝為單位的陰影衰落模型;而σ為標準偏差。

1.1.3 通信模型

車輛與RSU 的數據傳輸速率可以表示為式(6):

其中,λc,λm分別為代表是否使用5G 蜂窩網絡或NR 模式進行通訊的二元變量。

當λc=1 時,假設車輛u使用5G 蜂窩網絡作為通訊方式,λm=0;反之當λc=0 時,λm=1 認為車輛u使用NR 模式作為通訊方式。

1.2 遷移成本模型

本文使用了平臺服務(PaaS) 范式,并采用Docker 技術,該技術具有增強應用程序可移植性的機制,可以讓應用程序無環境差異地部署在各個地方,因此本文將服務遷移成本建模為Docker 服務鏡像遷移成本。 假定每個車輛都包含計算任務,且任務定義為一個二元組:Tu= {pu,Su},其中pu是完成任務Tu所需的計算資源,Su代表車輛u執行的服務鏡像大小。

本文采用了部分遷移而非二元遷移,并假定車輛u卸載到遠程路側單元e的服務比例為, 表示為式(7):

其中,表示車輛u卸在本地執行的服務比例。

據服務鏡像大小,可以得出在路側單元e執行的服務的鏡像大小,式(8):

因此遷移成本如式(9):

其中,λc= {0,1},λm= {0,1},λc+λm=1

1.3 計算成本模型

1.3.1 本地車載計算

當車輛u在本地計算時,計算開銷的時間取決于其可用資源。 本文假設是車輛u的車載計算資源,則本地計算時間的計算公式(10):

1.3.2 遠程VEC 計算

當本地計算資源緊張或者計算負載過高時,可以將服務卸載到遠程路側單元上進行計算。 在許多包括道路檢測和智能制動在內的應用中,因為其鏡像的大小遠大于從路側單元傳輸回來的數據大小,所以本文假定路側單元返回的計算結果的接收時間忽略不計,則車輛u的遠程計算時間表示為公式(11):

其中,表示路側單元分配給車輛u的計算資源,pu是完成任務Tu所需的計算資源。

本文假定車輛u卸載到遠程路側單元e的服務比例為, 車輛u卸載本地執行的服務比例為,因此計算成本可以表示為式(12):

1.4 能耗模型

當本地計算資源緊張或者計算負載過高時,可以將服務卸載到路側單元上。 在這種情況下,傳輸能耗可以由公式(13)計算:

其中,?e表示車輛u在卸載時的平均傳輸功率;是服務鏡像的大小;Cu,e是車輛u可訪問的數據傳輸速率。

2 基于強化學習的車輛服務遷移

2.1 馬爾可夫決策問題

服務遷移策略應該考慮若干成本,在服務遷移過程中對于成本的優化可以采用MDP 進行解決[11]。 MDP 由四元組構成<A,S,R,P >, 其中A代表智能體的所有行動,S是智能體可以感知的環境狀態,P是在時隙t狀態下的行動將導致下一個時隙t+1 的狀態的概率,R是一個實數,代表獎勵或懲罰[15]。

2.1.1 動作空間

本文將時隙t的行動αt∈A定義為

2.1.2 獎勵函數

由于強化學習的根本目標在于提升智能體的長期累積回報,因此合理的獎勵函數能夠提升訓練速度與性能表現。 長期累積回報的定義如式(14):

其中,r(st) 是時隙t中獲得的獎勵值,γ表示折扣率,用于計算未來獎勵值的現值。

本文的獎勵函數設計如式(15) :

其中,ΔGmig(t) 、ΔGcomp(t) 和ΔP(t) 分別表示時隙t遷移成本、計算成本和能耗的下降百分比。

以ΔP(t) 為例,如式(16)定義:

2.2 算法描述

本文采用基于Soft Actor-Critic 的強化學習算法,該算法考慮了預期收益和熵之間的最大化效益,因此最優遷移策略定義為式(17):

其中,at代表智能體在時隙t采取的行動;st代表智能體在時隙t的狀態;γ表示獎勵值折扣率;溫度參數α決定了熵值的相對重要性;H(π(·∣st))代表熵。

V值表示當前環境狀態下開始,未來能獲得獎勵的期望值,用于表現當前環境狀態的好壞程度;Q值表示在選取某個行動后,未來能獲得獎勵的期望值,該值衡量的是當前選取的行動的好壞程度。V值和Q值之間的關系如圖1 所示。

圖1 Q 值與V 值關系圖Fig. 1 The relationship between Q value and V value

根據貝爾曼方程,V值和Q值可以表示為式(18) 和式(19):

2.2.1 Critic 網絡更新

傳統強化學習中,由于維度過高會引發訓練困難的問題[16],因此引入神經網絡進行近似,本文提出的算法網絡由一個Actor 網絡和兩個Critic、目標Critic 網絡構成。 Critic 網絡的損失函數可以表示為式(20):

其中,θk為Critic 網絡參數;D表示重放緩沖區, 可以通過更新;Qθk(st,at) 是時隙t的狀態行動價值;y表示目標網絡的Q值,可以表示為式(21):

根據式(20)和式(21),Critic 網絡的更新公式為式(22):

并根據式(23)更新目標Critic 網絡:

其中,θk為目標Critic 網絡的參數,λ為網絡的更新比例。

2.2.2 Actor 網絡更新Actor 網絡的損失函數通過式(24)計算:

其中,和分別為均值和方差,ε~N(ε) 是正態分布下的噪聲參數。

策略參數可以通過式(26)更新:

其中,是從策略中采樣得到的,因此可以將其微分。

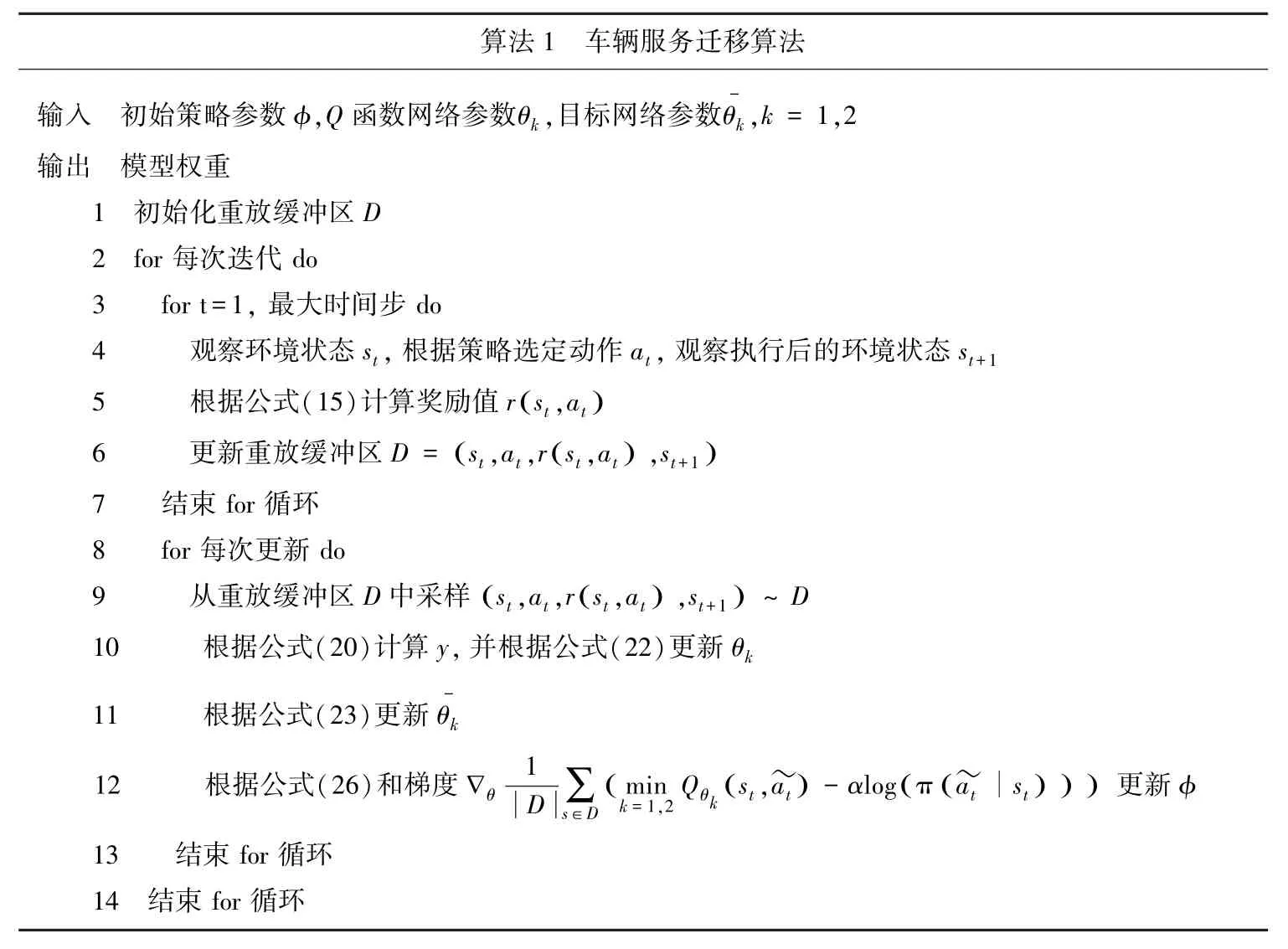

車輛服務遷移算法見表1。

表1 車輛服務遷移算法Tab. 1 Vehicular service migration algorithm

3 實驗

3.1 數據集介紹

為了評估所提出的算法在真實場景中的性能,本文采用微軟亞洲研究院在2007 年4 月至2012 年8 月期間在Geolife 項目中收集的GPS 軌跡數據集,該數據集由一連串帶有經度、緯度和高度的時間戳的點,包含的軌跡總距離為1 292 951 km,總時間為50 176 h。 同時本文使用阿里巴巴集群數據來模擬真實場景中RSU 的負載,該數據集中包含每臺機器的資源使用情況、容器的元信息和事件信息以及每個容器的資源使用情況。

3.2 實驗環境

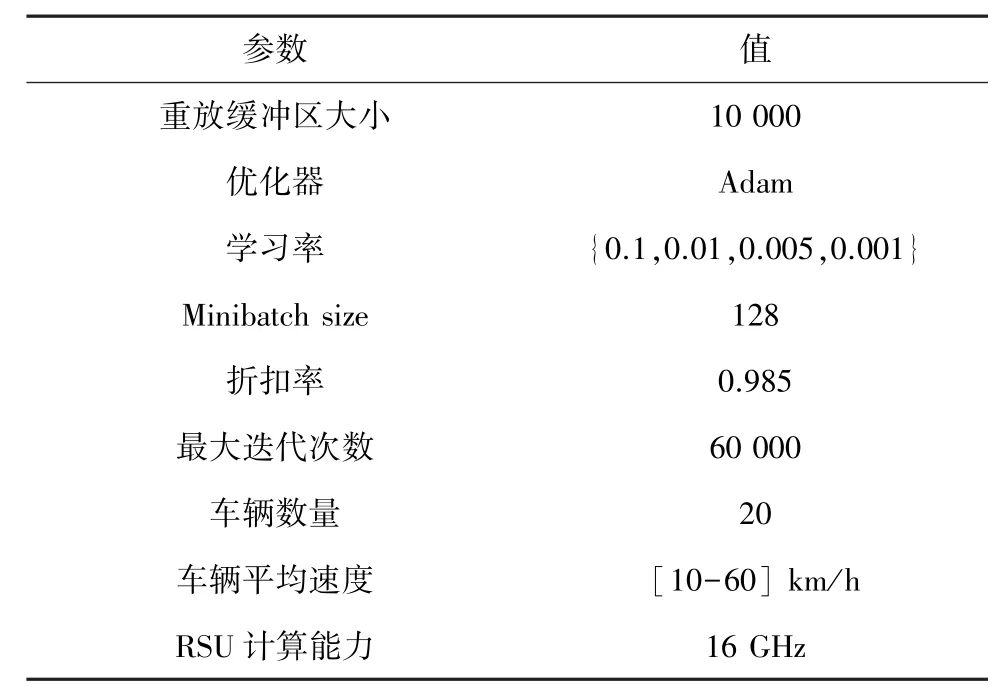

本文的仿真實驗硬件平臺配置:Intel i5-12500,32 GB DDR4 內存和NVIDIA GTX 3060;軟件平臺基于Python3.7.9,OpenAI-gym 和Manjaro。 本文將通信范圍設定為200 m,實驗參數設定見表2。

表2 實驗參數設置Tab. 2 Experiment parameters setting

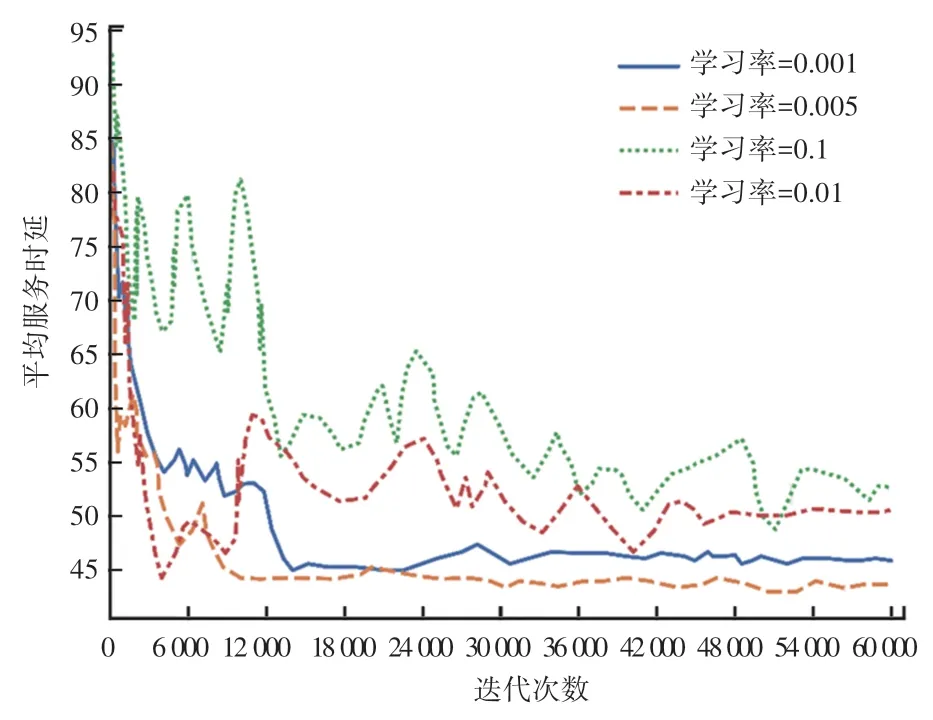

3.2.1 算法收斂性

本文首先研究學習率對提出算法的影響,將學習率設置為:0.1、0.01、0.03、0.001,采用在不同迭代次數的平均服務時延作為評價指標,平均服務時延越小,算法的表現也就越好。 學習率對算法收斂性影響的實驗結果如圖2 所示,當學習率為0.005 時,在經過9 500 次迭代后收斂到最優值并能保持穩定狀態;當學習率為0.001 時,在經過15 000 次迭代后收斂;當學習率為0.1、0.01 時,曲線變得極不穩定,而且很難收斂到穩定狀態。 因此,研究得出學習率對于算法的穩定程度具有較高影響,這是由于學習率決定了模型權重更新的速度和幅度,對模型的收斂性具有重要影響。 過高的學習率會導致模型在訓練過程中無法收斂并出現不穩定的訓練行為,使得模型的性能反而變得更差;相反,如果學習率過低,模型的權重更新會變得緩慢。

圖2 不同學習率對算法收斂性的影響Fig. 2 Effect of different learning rates on convergence

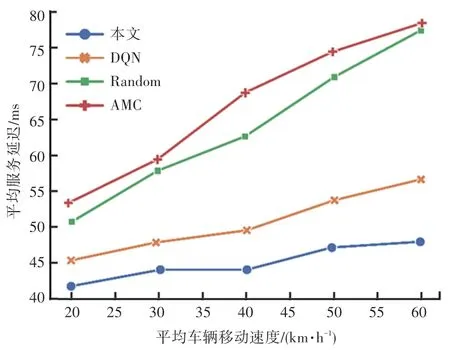

3.2.2 不同算法的服務時延對比

為了進一步驗證算法的可靠性,將本文采用的算法與就近遷移(Always Migrate Closely,AMC)、隨機遷移(Random)和深度Q 學習(Deep Q-Learning,DQN)算法進行對比,以驗證不同移動性下算法的穩定性及其表現。 算法的學習率設定為0.005,實驗結果如圖3 所示。 隨著平均車輛移動速度的增加,各算法的平均服務延遲都在上升,這是由于車輛行駛速度越快,離開RSU 通信范圍的間隔也就越小,服務遷移的觸發頻率隨之上升。 本文和DQN 算法的平均服務延遲都處于較低的水準,同時其增長速率也較為緩慢。 AMC 算法雖然每次都選擇就近的RSU,但是遷移服務時帶來的額外開支并不能彌補其服務延遲。 與DQN 算法相比,本文提出的算法在移動速度為20 km/h 時有8.6%的優勢,當移動速度達到60 km/h 時有15.3%的優勢,這是由于本文提出的算法具有較高的探索率,相比DQN 算法可以探索更多的遷移決策,從而使得平均服務時延上升速度較為緩慢。

圖3 不同車輛移動速度下的平均服務延遲Fig. 3 Average service delay for different vehicle movement speeds

3.2.3 不同算法的能耗對比

對比各算法在不同車輛移動速度下的平均能耗,實驗結果如圖4 所示,隨著平均車輛移動速度的增加,各算法的能耗同步上升,其中AMC 算法的上升速率最快,這是由于車輛移動速度的上升導致車輛更快的離開RSU 通信范圍,進而頻繁觸發遷移行動,AMC 算法的能耗因此遠遠高于其他算法。 而Random 算法在遠離RSU 后并沒有完全決定遷移,因此相比AMC 算法其能耗仍有一定優勢。 基于強化學習的DQN 和本文算法具有較大的優勢,這是因為獎勵函數中能耗帶來的獎勵值使得算法對于遷移決策較為慎重,頻繁地觸發服務遷移并不總是最優策略。 與DQN 相比,本文提出的算法在60 km/h 移動狀態下有14.4%的優勢,這是由于該算法在訓練過程中充分探索了可能的策略,因而與DQN 相比能使用更優的策略以降低能耗水平。

圖4 不同車輛移動速度下的平均能耗Fig. 4 Average energy consumption for different vehicle movement speeds

4 結束語

針對中國目前重點發展方向之一的車聯網,本文研究了基于該環境下的服務遷移問題,并對服務遷移過程中產生的計算成本、遷移成本和能耗建模,將遷移決策規劃為部分遷移而非二元遷移,同時考慮了車輛移動性帶來的問題。 本文將服務遷移建模為MDP 問題,并提出了基于深度強化學習的服務遷移算法來降低服務的平均時延和能耗。 實驗結果表明,本文提出的算法在學習率為0.005 時能夠較快達到收斂,并且與其他算法相比在20 km/h 和60 km/h 時分別有8.6%和15.3%的性能提升,同時當移動速度處于60 km/h 時,在能耗方面有14.4%的優勢。 在未來工作中,將車輛加速度引入以預測用戶駕駛車輛的移動意圖,從而進行更精確的遷移決策。