基于YOLOv5目標識別無線抓拍追蹤聲音報警系統

黃恒一 付三麗

摘? 要:文章基于YOLOv5目標檢測環境的計算機終端,通過配備無線路由器的無線攝像頭實現對行人的實時檢測,通過deepsort算法對目標行人的方向進行計數,并對其進行跟蹤。當目標計算機終端繪制的特定區域出現識別目標時,實現機器視覺語音自動報警,此外,該系統可以抓拍所識別的目標行人的照片。文章內容對研究人員入門機器視覺以及開發視覺相關應用產品具有一定的指導價值。

關鍵詞:抓拍;語音報警;計數;無線路由;deepsort算法

中圖分類號:TP391.4;TP18? 文獻標識碼:A? 文章編號:2096-4706(2023)09-0018-04

Abstract: In the computer terminal based on YOLOV5 target detection environment, this paper realizes the real-time detection of pedestrians through the wireless camera equipped with a wireless router, and the direction of the target pedestrians is counted and tracked through the deepsort algorithm. When the identified target appears in a specific region drawn by the target computer terminal, the machine vision voice automatic alarm is realized. In addition, the system can capture the photos of the identified target pedestrians. The content of this paper has a certain guiding value for researchers to learn machine vision and develop vision related application products.

Keywords: capture; voice alarm; counting; wireless routing; deepsort algorithm

0? 引? 言

當下隨著嵌入式技術、機器學習、AI等人工智能新興技術的飛速發展,目標檢測應用非常廣泛,例如生活中常見的人臉識別、車牌識別等;在自動駕駛領域,有行人識別、車道線識別;還有智能視頻監控、機器人導航、飛機航拍等多個領域的應用。目標監測最經典也是最常用的應用之一就是人臉識別。現在的智能手機、人臉支付、安檢等功能,都用到人臉檢測算法,而且速度快、準確率高。通過智能視覺識別,一群人站在一起,仍然可以清晰地檢測出每個人的臉部特征,實現人臉識別。

由于目前的一些嵌入式應用產品中融合了大量人工智能技術、當下人們生活中的嵌入式產品離不開機器視覺、人工智能等技術。機器視覺系統的特點是提高生產的柔性和自動化程度。在一些不適合人工作業的危險工作環境或人工視覺難以滿足要求的場合,常用機器視覺來替代人工視覺;同時在大批量工業生產過程中,用人工視覺檢查產品質量效率低且精度不高,用機器視覺檢測方法可以大大提高生產效率和生產的自動化程度。而且機器視覺易于實現信息集成,是實現計算機集成制造的基礎技術。人工智能是計算機科學的一個分支,它通過了解智能的實質,并生產出一種新的能以人類智能相似的方式做出反應的智能機器,該領域的研究包括機器人、語言識別、圖像識別、自然語言處理和專家系統等。人工智能可以對人的意識、思維的信息過程進行模擬,能像人那樣思考、也可能超過人的智能。論文在機器視覺、人工智能背景下設計了基于YOLOv5目標識別無線抓拍追蹤聲音報警系統[1]。

論文機器視覺系統在樹莓派YOLOv5環境下通過無線路由器配置的攝像頭實現對行人數量信息的視覺檢測并在顯現界面實時統計出監測的行人數量,此外論文視覺目標檢測系統可對視覺目標檢測區域進行設定,當目標檢測區域出現識別目標的時候,監控畫面會進行實時識別提示并且電腦端會實現語音報警,此外論文系統可根據目標特征訓練的模型,對目標行人進行圖片的抓拍,用于進一步跟蹤分析行人特征信息。

1? 目標識別原理

傳統的計算機目標識別原理是通過圖像識別器對特定目標進行識別,但是對于一副畫面中出現多種目標物體及對機器視覺圖像識別處理速度實時性要求較高的一些領域,如自動駕駛等領域,一些新的圖像目標識別技術就出現了。論文目標識別系統用到的YOLOv5目標檢測算法,該算法是一種將圖像劃分為網格系統的對象檢測算法,網格中的每個單元格負責檢測自身內部的對象[2]。

1.1? 機器視覺

機器視覺就是利用機器系統代替人的眼睛以及大腦來作出各種測量和判斷。采用成像技術(通常使用相機)獲取被測目標的圖像,再經過快速圖像處理,與圖形識別算法,從攝取圖像中獲得目標的尺寸、方位、光譜、結構、缺陷等信息,從而可以執行產品檢驗,分類與分組,裝配線上的機械手運動引導,零部件的識別與定位,生產過程中質量監控與過程控制反饋等任務[3]。

1.2? 行人監測

論文中的行人監測主要是通過行人模型識別器,通過搭建Python環境下行人識別環境,當有行人信息通過目標區域的時候,就會將目標行人框選出來,通過deepsort算法對目標行人進行跟蹤,并將通過攝像頭監測的行人數量信息實時統計出來[4]。

1.3? 目標識別語音報警

傳統的目標識別系統對目標信息進行檢測,論文機器視覺系統在目標檢測識別的基礎上增加了語音報警、區域檢測語音報警等功能。當運行目標檢測腳本文件,當目標區域目標物體識別檢測到后會聯動判斷觸發后臺語音文件,進行后臺語音文件的播報[5]。

2? 系統方案

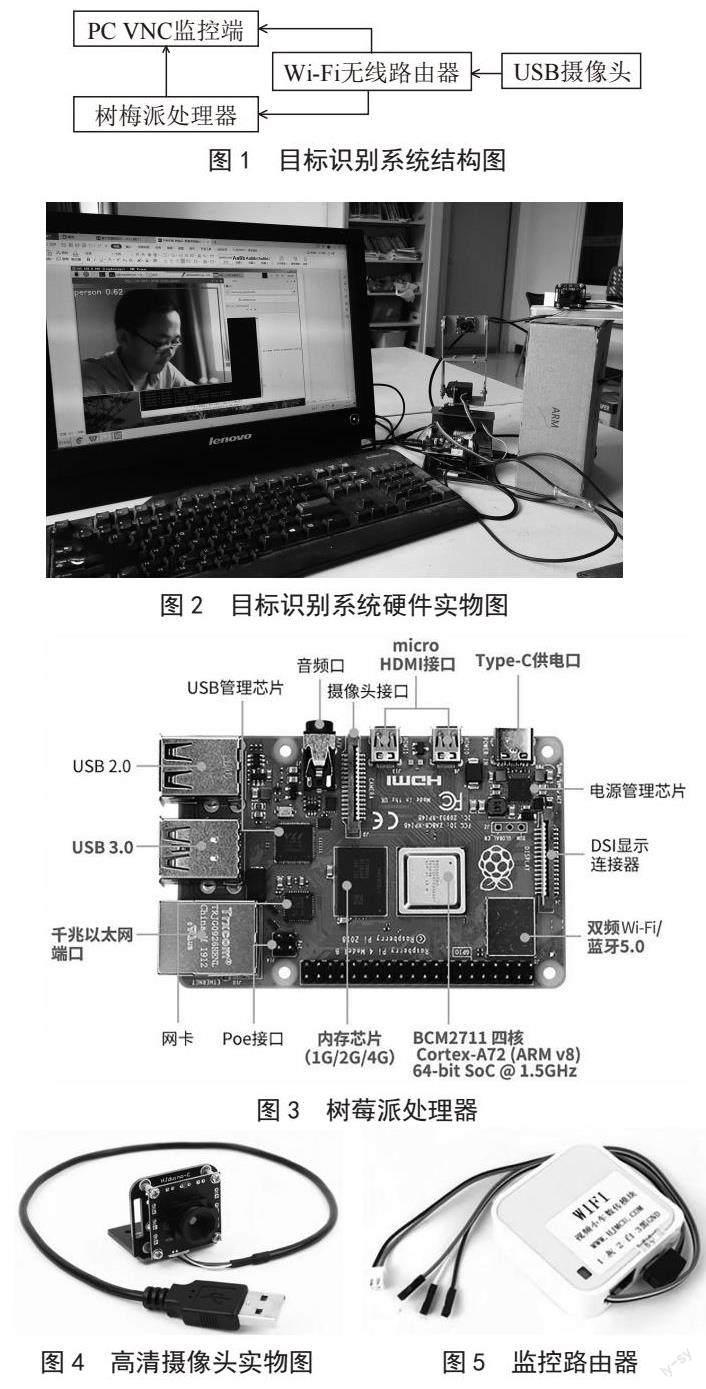

論文目標識別監控計數報警系統涉及硬件主要有樹莓派監控平臺,PC電腦端,用于配置樹莓派無線攝像頭的路由器及監控攝像頭。系統運行時,PC、樹莓派均要加入系統無線路由器搭建的局域網熱點。電腦端通過樹莓派遠程登錄軟件VNC進入樹莓派桌面端,運行行人目標計數檢測報警程序,即可彈出路由器上搭載的USB攝像頭即可在PC端接收無線路由器上攝像頭視頻流監控畫面[6]。此外論文目標模型可對攝像頭內的目標行人信息進行抓拍、語音報警。論文系統原理結構圖如圖1所示。

2.1? 系統硬件環境

系統目標識別硬件涉及電腦端、樹莓派平臺、Wi-Fi無線路由器。論文用于訓練目標識別模型電腦配置信息如下。系統制造商:LENOVO,系統型號:QiTianA7100-N000,BIOS:LENOVO BIOS,版本:F0KT39A 0.0,處理器:Intel(R)Pentium(R)CPU G2030@3.00 GHz(2個CPU)~3.0 GHz,內存:4 096 MB RAM,可用操作系統內存:3 918 MB RAM,頁面文件:使用3 406 MB,可用4 426 MB。電腦端用于訓練目標識別的模型文件及通過VNC軟件登錄樹莓派處理器進行目標行人的監控顯示,可移動監控平臺用于對目標區域行人數量信息進行實時檢測、統計人數并可實現對目標行人進行抓拍運算,Wi-Fi路由器用于搭建目標識別系統的局域網熱點。系統硬件搭配實物圖如圖2所示。

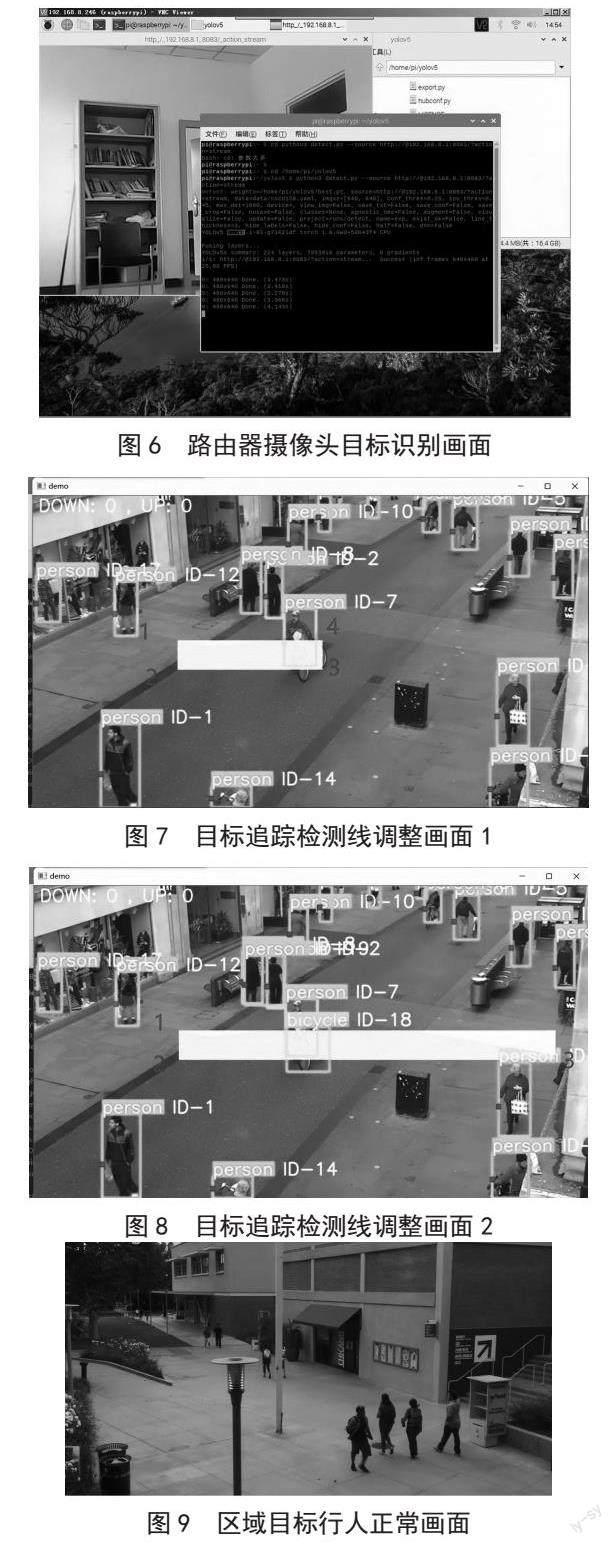

2.1.1? 樹莓派硬件

論文行人數量統計應用案例用到的樹莓派處理器如圖3所示,它是一款基于ARM的微型電腦主板,以SD/MicroSD卡為內存硬盤,卡片主板周圍有1/2/4個USB接口和一個10/100以太網接口(A型沒有網口),可連接鍵盤、鼠標和網線,同時擁有視頻模擬信號的電視輸出接口和HDMI高清視頻輸出接口,以上部件全部整合在一張僅比信用卡稍大的主板上,具備所有PC的基本功能只需接通電視機和鍵盤,就能執行如電子表格、文字處理、玩游戲、播放高清視頻等諸多功能[7]。

2.1.2? 無線監控模塊

監控模塊由Wi-Fi數傳模塊和高清攝像頭組成。具體工作過程如下,高清攝像頭拍攝實時監控畫面傳給數傳模塊,Wi-Fi數傳模塊再通過Wi-Fi將畫面傳輸手機或者平板中。Wi-Fi數傳模塊供電電壓為5 V,驅動電流為1 A,搭載64 M RAM儲存,配備一個USB接口,天線上搭載大功率板載天線,通過TTL串口進行通信。高清攝像頭模塊通過USB接口與數傳模塊相連,其供電電壓為5 V,像素為30萬,輸出幀率為30 FPS,支持手動調焦[8]。如圖4和圖5所示,分別為高清攝像頭和Wi-Fi數傳模塊實物圖。

2.2? 系統軟件環境

論文目標識別系統軟件通過PC端進行環境搭建。PC端環境搭建需要acona、Python、PyCharm進行實驗測試環境的搭建。通過PyCharm加載目標源文件、通過acona搭建目標測試的虛擬環境。行人模型的生成是通過Lambel軟件,進行行人圖片信息的標注,生成行人數據集,通過PyCharm進行行人數據集的訓練,生成best.pt行人模型文件,后續導入到樹莓派中,分別進行行人圖片、行人視頻、攝像頭行人信息的實時識別,實現抓拍、跟蹤、語音報警功能。

2.2.1? 聲音監控區域代碼

限定區域監控語音報警代碼如下,讓目標區域檢測出識別目標即實現機器端的語音聲音文件報警。

<bndbox>

<xmin>1034</xmin>

<ymin>167</ymin>

<xmax>1366</xmax>

<ymax>565</ymax>

</bndbox>

上述代碼中的數值就是聲音監控區域框面積的代碼,通過在程序中進行數值的調整,即可實現目標監控區域位置、大小的變化。

2.2.2? 目標識別代碼

目標識別系統硬件環境Wi-Fi熱點搭配完畢后,PC端通過VNC軟件登錄樹莓派處理器桌面端,通過運行監控計數代碼,即可實現對目標圖像的監控識別。樹莓派命令終端目標識別代碼如下:

python3 detect.py --source http://@192.168.8.1:8083/?action=stream

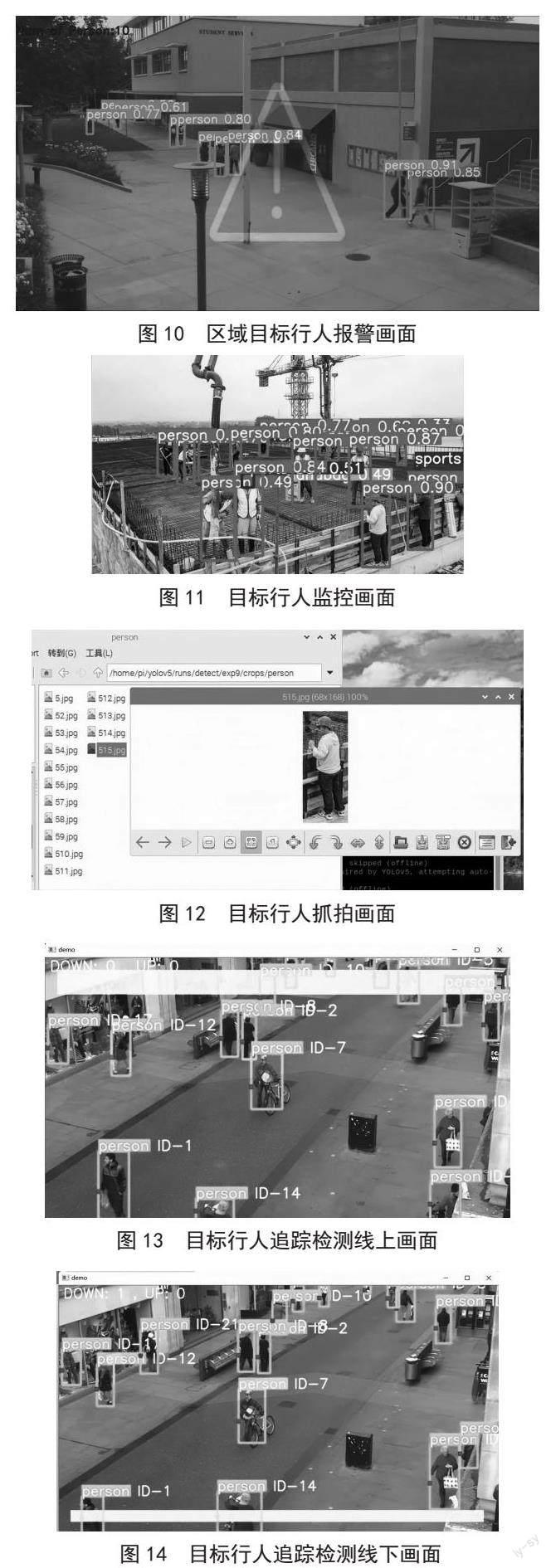

上述代碼中的http://@192.168.8.1:8083/?action=stream就是Wi-Fi路由器搭配的攝像頭視頻流[9],樹莓派終端Python程序運行完畢后,即可通過Wi-Fi路由器上的攝像頭實現目標行人的識別,目標識別畫面如圖6所示。

2.2.3? 追蹤目標檢測線代碼

目標識別追蹤系統中黃色橫線用來檢測攝像頭視野中有多少目標通過特定的檢測線,目標橫線檢測代碼如下。

mask_image_temp = np.zeros((1080, 1920), dtype=np.uint8)

list_pts_yellow = [[50, 50], [50, 150], [1850, 150], [1850, 50]]

ndarray_pts_yellow = np.array(list_pts_yellow, np.int32)

polygon_yellow_value_2 = cv2.fillPoly(mask_image_temp, [ndarray_pts_yellow], color=2)

polygon_yellow_value_2 = polygon_yellow_value_2[:, :, np.newaxis]

通過上述代碼分析,坐標點位置的判斷:

圖片格式為1 080×1 920,即圖片長寬分別為1 920和1 080,在此范圍內取值即為坐標點。

例:取任意四點,[[500,500],[500,600],[1 000,600],[1 000,500]]

目標追蹤檢測結果畫面如圖7所示。

改變3和4的坐標,使其增大800即[1 800,600],[1 800,500]結果如圖8所示。

由上述圖7和圖8可以得知,橫坐標增大向右偏移;反之向左偏移,縱坐標增大向下偏移;反之向上偏移。黃線的位置為坐標點之間依次連線圍成的封閉圖形。

2.3? 行人區域聲音報警

論文系統可以進行目標區域的繪制,目標對象進入目標區域方框界限的時候,電腦端監控區域畫面會進行識別報警提示,此外電腦端會播放警報聲音,當目標區域沒有目標對象的時候,電腦端不會發出報警聲音提示[10]。攝像頭監控畫面端目標區域行人識別正常畫面和報警畫面如圖9和圖10所示。

2.4? 行人抓拍

論文系統根據訓練的模型標注情況可以對目標行人進行自動抓拍,當路由器搭載的無線監控攝像頭中出現目標行人信息的時候,會對目標信息進行自動抓拍。攝像頭監控畫面和樹莓派端目標行人抓拍畫面如圖11和圖12所示。

2.5? 行人追蹤

論文目標識別系統除了前文敘述對目標圖像進行計數、抓拍,還可以對攝像頭目標圖像進行軌跡跟蹤,通過運行目標跟蹤,可以實現對目標圖像的精確分析。目標圖像視覺跟蹤畫面如圖13和圖14所示。

由圖13和圖14可以得知,調整圖中目標檢測線的位置即可實現對經過目標檢測線的人數的確切統計并實時顯示在畫面的上端。

3? 創新點

論文目標檢測系統增加無線監控模塊,通過配置無線路由器使得樹莓派可以通過Wi-Fi的方式連接無線攝像頭,增加了監控設備的可移動性。論文視覺目標檢測模型增加了檢測目標對象進行語音報警功能及特定區域目標對象語音報警模塊,目標對象語音報警功能提高了系統對特定對象檢測反饋的效率,此外論文目標識別系統可對目標行人進行自動抓拍并保存本地端。

4? 結? 論

當下機器視覺逐漸滲入社會生活的方方面面,在人臉識別、圖片識別、視頻監控、3C應用等各領域幾乎都能看到機器視覺的身影,對于工業領域而言,機器視覺的應用更是大大降低了高危作業的危險系數,保障了工業生產的安全性和高效性。論文基于樹莓派處理器實現的機器視覺目標行人機器視覺環境下區域聲音報警、抓拍、跟蹤功能測試效果符合預期要求,論文研究的基于YOLOv5技術的聲音報警系統可拓展至相關特定目標的識別及安防監控領域。隨著嵌入式技術、人工智能、大數據技術的發展,論文研究的內容與相關技術的融合結合應用范圍會越來越廣泛。

參考文獻:

[1] 王曼菲,李志明.基于深度學習的港口移動目標識別技術研究 [J].中國水運,2022(10):59-60.

[2] 宋波.水下目標識別技術的發展分析 [J].艦船電子工程,2014,34(4):168-173.

[3] 王亮,陳建華,李燁.一種基于深度學習的無人艇海上目標識別技術 [J].兵工學報,2022,43(S2):13-19.

[4] 曹健,王武軍,韓飛,等.基于局部特征的目標識別技術研究 [J].計算機工程,2010,36(10):203-205.

[5] 崔磊.針對多種聲特征的聲目標識別技術研究 [J].價值工程,2011,30(14):198-199.

[6] 李峰,詹邦成,辛蕾,等.基于新型聯合感知矩陣的壓縮學習目標識別技術 [J].電子學報,2021,49(11):2108-2116.

[7] 臉部描述和目標識別技術 [J].電腦與電信,2011(2):32.

[8] 唐自力,馬彩文.基于航跡和特征的目標識別技術在多目標跟蹤中的應用 [J].光子學報,2010,39(2):375-379.

[9] 薛武,趙玲,王鵬.星地協同光學遙感影像目標識別技術驗證研究 [J].航天返回與遙感,2021,42(3):128-137.

[10] 唐紹富,段蘭蘭.基于遙感圖像的船舶目標識別技術 [J].艦船科學技術,2020,42(14):85-87.

作者簡介:黃恒一(1988.03—),男,漢族,河南信陽人,講師,碩士研究生,研究方向:機器視覺、路徑規劃;付三麗(1985.10—),女,漢族,河南開封人,講師,碩士研究生,研究方向:網絡安全。