基于輕量化YOLOv5s的花椒簇檢測研究

李光明 弓皓斌 袁凱

摘要:針對現(xiàn)有花椒簇檢測算法模型參數(shù)量多、計算量大、檢測速度低、很難部署到嵌入式設備的問題,提出一種基于輕量化YOLOv5s的花椒簇檢測算法模型。首先將ShuffleNet v2主干網(wǎng)絡替代原YOLOv5s中的主干網(wǎng)絡進行重構;同時將SPPF嵌入至ShuffleNet v2骨干中;其次引入輕量級注意力機制CBAM;最后使用SIoU_Loss代替CIoU_Loss作為回歸損失函數(shù)。試驗結果表明:改進后的輕量化YOLOv5s網(wǎng)絡參數(shù)降低85.6%,計算量降低87.7%,對花椒簇的檢測精度mAP@0.5達到92.6%,較原YOLOv5s模型提高3.4%,mAP@0.5:0.95達到61.4%,檢測時間為11 ms,相比原模型16 ms縮短31.3%,可以滿足在現(xiàn)場環(huán)境下對花椒簇的檢測。

關鍵詞:花椒簇;YOLOv5s算法;輕量化;網(wǎng)絡參數(shù);檢測精度

中圖分類號:S225.93: TP391

文獻標識碼:A

文章編號:2095-5553 (2023) 04-0153-06

Abstract: In order to solve the problem that the detection algorithm model of pepper cluster has large number of parameters, large amount of computation, low detection speed and difficult deployment to embedded devices, a lightweight detection algorithm model of pepper cluster based on YOLOv5s was proposed. Firstly, ShuffleNet v2 backbone network was reconstructed instead of the original backbone network in YOLOv5s; At the same time, SPPF was embedded into the backbone of ShuffleNet v2; Secondly, lightweight attention mechanism CBAM was introduced; Finally, SIoU_Loss was used instead of CIoU_Loss as regression loss function to further improve the detection accuracy. The results showed that the network parameters of the improved lightweight YOLOv5s model were decreased by 85.6%, the computational amount was decreased by 87.7%, and the detection accuracy of mAP@0.5 for pepper clusters was 92.6%, 3.4% higher than the original YOLOv5s model, and mAP@0.5: 0.95 was 61.4%, and detection time was 11 ms, 31.3% less than the original model of 16 ms, which can meet the requirements for the detection of pepper clusters in complex field environments.

Keywords:? pepper cluster; YOLOv5s algorithm; lightweight; network parameters; detection accuracy

0 引言

中國是世界上花椒產(chǎn)量最多的國家,2021年產(chǎn)量已達到50萬噸以上。花椒產(chǎn)量的快速增長,人工采摘花椒速度過慢的問題越來越突出。所以研發(fā)全自動采摘花椒機器人具有很高的經(jīng)濟價值。花椒采摘機器人主要由花椒簇檢測系統(tǒng)和機械臂控制系統(tǒng)組成,機械臂控制系統(tǒng)接收花椒簇檢測系統(tǒng)所采集的信息對花椒進行采摘,因此對花椒簇進行快速、準確的檢測是實現(xiàn)自動采摘[1-3]的關鍵。萬芳新等[4]提出一種采用紅色和綠色圖像差異進行圖像分割,并使用優(yōu)化腐蝕濾除噪點和隔離帶法除去非目標花椒串果實來實現(xiàn)花椒果實的識別和定位。汪杰等[5]提出一種HSV顏色空間與形狀特征融合的方法對花椒圖像進行分割。但由于采摘機器人所搭載的嵌入式設備片上資源有限[6],并且對檢測速度要求很高,現(xiàn)有的復雜模型算法由于參數(shù)量過大,檢測速度低,很難部署到嵌入式設備中,所以在保證檢測精度的同時,減少模型參數(shù)量和計算量并且提高檢測速度是花椒檢測問題的難點。

近年來基于卷積神經(jīng)網(wǎng)絡(Convolutional Neural Networks, CNN)的目標檢測算法因魯棒性強、自適應性強及準確性高被廣泛應用于圖像識別等領域[7-8]。其可分為兩種類型:第一種是“兩階段檢測”算法,包括R-CNN[9],F(xiàn)ast-R-CNN[10],F(xiàn)aster-R-CNN[11]等標志性算法。另一種是一階段的檢測算法,主要包括YOLO系列[12-13],和SSD(Single Shot Multibox Detector)系列。但上述經(jīng)典網(wǎng)絡中均存在著模型過大和運算量過多等問題,很難進行嵌入式設備的移植。楊小岡等[14]提出一種在原始YOLOv5網(wǎng)絡的基礎上,使用MobileNetv3結構對模型主干網(wǎng)絡進行重構,并添加特征提取網(wǎng)絡MNtECA對網(wǎng)絡模型進行壓縮和加速的方法。張明路等[15]提出在YOLOv4算法主干網(wǎng)絡中添加1×1卷積,用3×3的深度可分離卷積替代原有卷積減少網(wǎng)絡參數(shù)量。張凡等[16]提出在YOLOv5s網(wǎng)絡模型的基礎上,結合EfficientNet網(wǎng)絡中的MBConvBlock對主干網(wǎng)絡進行重構,降低網(wǎng)絡參數(shù),并加入Stem模塊,改進卷積注意力模塊提升網(wǎng)絡性能。本文針對已有算法網(wǎng)絡參數(shù)量過大、檢測效率低下、不易部署和難以移植到移動端等問題,基于YOLOv5s目標檢測算法,提出一種輕量化花椒簇檢測算法。

1 基于YOLOv5s的輕量化花椒簇檢測算法

針對花椒簇檢測,本文結合YOLOv5s與ShuffleNet v2的基礎上提出一種輕量化的YOLOv5s網(wǎng)絡模型,主要工作有以下4個方面。

1.1 ShuffleNet v2輕量化YOLOv5s主干網(wǎng)絡

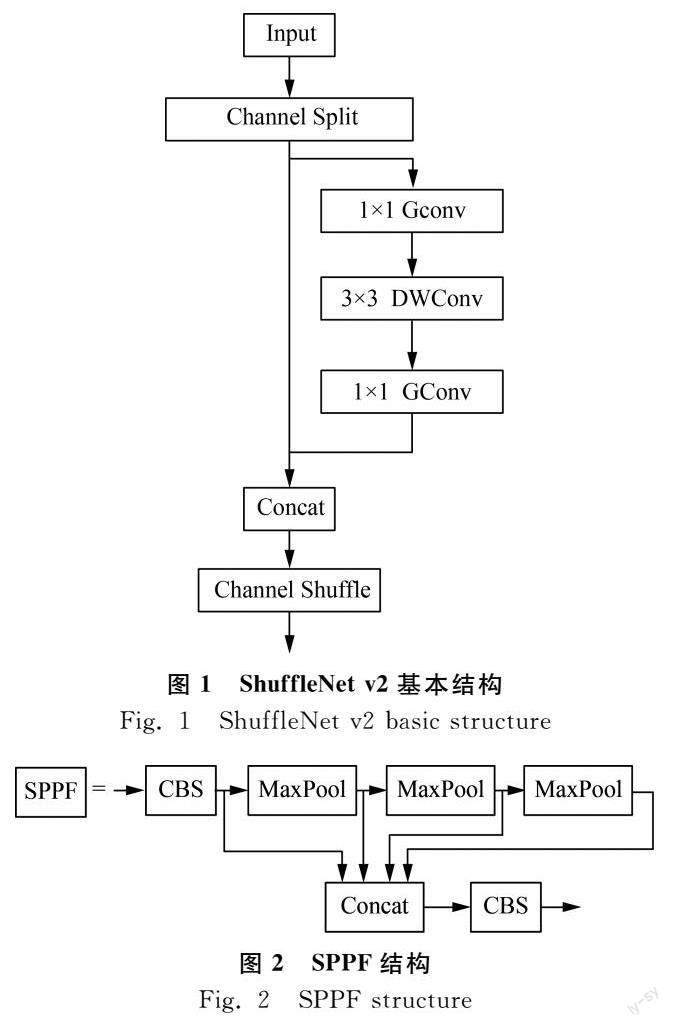

對比ShuffleNet v1[17]和MobileNet v2[18],發(fā)現(xiàn)4條輕量化網(wǎng)絡結構的指導性原則:1×1卷積進行平衡輸入和輸出的通道大小;謹慎使用組卷積,注意分組數(shù);避免網(wǎng)絡碎片化;減少元素級運算。ShuffleNet v2模型使用3×3深度可分離卷積方法,計算量較3×3標準卷積方法減少88%左右,同時精度損失較小。深度可分離卷積包括深度卷積與1×1逐點卷積,深度卷積在每一個輸入通道中都作用了一個固定尺寸卷積核,1×1卷積融合了深度卷積的輸出特征,提高了網(wǎng)絡的表達能力,同時沒有改變輸出特征圖的尺寸。本文將輕量化分類網(wǎng)絡ShuffleNet v2引進YOLOv5s目標檢測算法主干中對花椒簇進行檢測,為后續(xù)在嵌入式設備上部署提供可行方案。ShuffleNet v2模型基本結構如圖1所示。

1.2 SPPF嵌入至shuffleNet v2骨干網(wǎng)絡

快速空間金字塔池化(Spatial Pyramid Pooling-Fast,SPPF)模塊是對空間金字塔池化SPP的簡化,SPPF結構如圖2所示,僅使用池化核為5的二維最大池化代替SPP結構中池化核分別為5、9、13的二維最大池化,減少計算量;同時采用并行的殘差結構,將池化后得到的特征一部分通過Concat,一部分繼續(xù)池化,通過池化操作得到不同層次的特征,提高模型對輸入圖像的特征提取能力。使用ShuffleNet v2輕量化網(wǎng)絡后,模型的檢測精度會在一定程度上變差,因此將SPPF嵌入至ShuffleNet v2骨干中,在幾乎不增加模型大小的前提下來提高模型的檢測精度。

1.3 輕量級注意力CBAM

本文引入輕量級注意力機制CBAM,更注重大區(qū)域內(nèi)重要小目標信息。CBAM是一種輕量型模塊,包括通道注意力模塊(Channel Attention Module,CAM)與空間注意力模塊 (Spatial Attention Module,SAM)兩個子模塊,這兩個子模塊分別在通道維度關注圖片所輸入的重要信息,在空間維度關注圖片所輸入的位置信息。改進后的YOLOv5s輕量化網(wǎng)絡結構如圖3所示,圖中Shuffle-Block為ShuffleNet v2結構。

2 花椒簇數(shù)據(jù)集的制作與標注

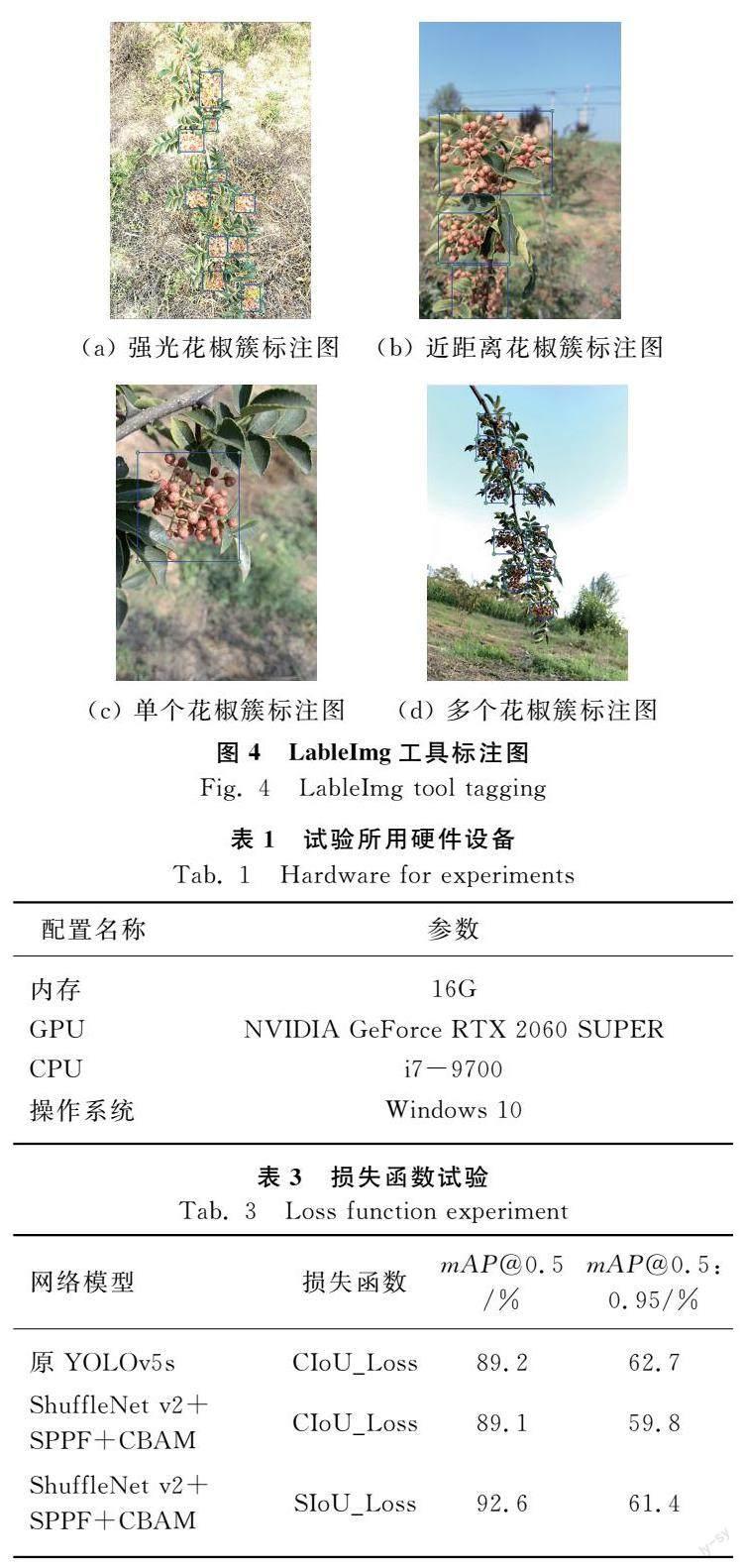

本文以成熟的花椒簇為研究對象,在手機實地拍攝收集圖像的基礎上,以網(wǎng)絡上的花椒圖像作為補充,共獲得500張照片。為提高網(wǎng)絡模型的檢測精度和泛化能力,在不同距離、不同光照、不同位置條件下對花椒進行實地拍照。拍攝時間為2022年8月,拍攝地點在陜西省白水縣某種植園。對收集到的500張圖片進行鏡像翻轉、旋轉、改變亮度、對比度以及裁剪等方式進行擴充,共得到1 400張圖片。本文使用LabelImg工具對收集到的花椒圖像進行標注,標注后得到YOLO數(shù)據(jù)格式的.txt文件。1 400張圖片按照7∶1∶2的比例劃分為訓練集、驗證集及測試集。圖片使用LableImg工具標注圖如圖4所示。

3 試驗結果與分析

3.1 試驗環(huán)境及參數(shù)設置

本文試驗所用硬件設備如表1所示。軟件環(huán)境為Python、Pytorch、CUDA、Pychram等。網(wǎng)絡訓練時批次大小(batch size)設置為32,動量因子(Momentum)設置為0.937,初始學習率(learning rate)設置為0.01,衰減系數(shù)設置為0.000 5,共訓練300輪。

3.2 試驗分析

試驗中網(wǎng)絡模型評價指標為平均精度均值mAP(mean Average-Precision)、平均每張圖片檢測時間Times、網(wǎng)絡模型的參數(shù)量Parameters和模型計算量。IoU閾值取0.5時的mAP記為mAP@0.5,閾值為0.5~0.95之中取10個值得到的平均精度記為mAP@0.5:0.95。

試驗1驗證ShuffleNet v2主干網(wǎng)絡對花椒簇檢測的影響,在其他參數(shù)不變的情況下,在自建花椒簇數(shù)據(jù)集上進行消融試驗,將主干網(wǎng)絡改為ShuffleNet v2,添加SPPF模塊,再添加不同輕量級注意力模塊CBAM、ECA、SE進行試驗,試驗結果如表2所示。

從表2可以看出,當YOLOv5s主干網(wǎng)絡改為ShuffleNet v2,添加SPPF模塊和CBAM模塊時,在模型大小與檢測精度之間達到最佳的平衡,在mAP@0.5和mAP@0.5:0.95損失不大的情況下,其網(wǎng)絡參數(shù)量為1 014 872,相比原模型7 053 910降低了85.6%;模型計算量為2.0 GFLOPs,相比原模型16.3 GFLOPs降低了87.7%;檢測時間為11 ms,相比原模型16 ms縮短了31.3%。

試驗2驗證SIoU_Loss損失函數(shù)對花椒簇檢測精度的有效性,在ShuffleNet v2、SPPF模塊和CBAM模塊應用的基礎上,使用SIoU_Loss代替CIoU_Loss作為回歸損失函數(shù)。試驗結果如表3所示。結果表明本文算法對花椒簇的檢測精度mAP@0.5達到92.6%,較原YOLOv5s模型提高3.4%,mAP@0.5:0.95達到61.4%。

試驗3為分析本文網(wǎng)絡模型的性能,與目前先進的目標檢測網(wǎng)絡EfficientDet和Faster-R-CNN在花椒簇數(shù)據(jù)集上進行比較試驗。其余模型均按本文模型訓練方式進行訓練。試驗結果如表4所示。結果表明本文花椒簇檢測模型在損失精度很小的情況下,檢測時間大大縮短,達到了預期目的。檢測效果圖如圖5所示。

4 結論

1) 針對現(xiàn)有算法網(wǎng)絡參數(shù)量過大、檢測效率低下、不易部署到嵌入式等問題,基于YOLOv5s目標檢測算法,本文提出一種改進的輕量化YOLOv5s花椒簇檢測算法,利用ShuffleNet v2作為骨干網(wǎng)絡替代原YOLOv5s算法中的骨干網(wǎng)絡,將SPPF嵌入至ShuffleNet v2骨干網(wǎng)絡最后一層,并引入輕量級注意力機制CBAM,最后將損失函數(shù)CIoU_Loss改進為SIoU_Loss,得到本文的輕量化檢測花椒簇算法。

2) 改進后的輕量化花椒檢測算法在保證原有檢測精度不變的同時,有效地降低了模型計算復雜度,并提高檢測速度。本文算法與原YOLOv5s算法相比,在自制花椒數(shù)據(jù)集上mAP@0.5提高3.4%,mAP@0.5:0.95只降低了1.3%,但參數(shù)量降低85.6%,計算量降低了87.7%,檢測時間縮短31.3%,達到了預期效果。

3) 本文將進一步研究如何減少因輕量化所造成的精度損失,提高花椒檢測精度,并研究如何在遠距離的情況下識別樹葉遮擋情況下的花椒簇,更進一步的完善花椒采摘機器人的實際應用。

參 考 文 獻

[1] Kapach K, Barnea E, Mairon R, et al. Computer vision for fruit harvesting robots-state of the art and challenges ahead [J]. International Journal of Computational Vision & Robotics, 2012, 3(1/2): 4-34.

[2] 周俊, 劉銳, 張高陽. 基于立體視覺的水果采摘機器人系統(tǒng)設計[J]. 農(nóng)業(yè)機械學報, 2010, 41(6): 158-162.

Zhou Jun, Liu Rui, Zhang Gaoyang. Design of fruit harvesting robot based on stereo vision [J]. Transactions of the Chinese Society for Agricultural Machinery, 2010, 41(6): 158-162.

[3] 阮承治, 趙德安, 陳旭, 等. 雙指型農(nóng)業(yè)機器人抓取球形果蔬的控制器設計[J]. 中國農(nóng)機化學報, 2019, 40(11): 169-175.

Ruan Chengzhi, Zhao Dean, Chen Xu, et al. Controller design for realizing double-finger agricultural robot to grasp spherical fruits and vegetables[J]. Journal of Chinese Agricultural Mechanization, 2019, 40(11): 169-175.

[4] 萬芳新, 白明昌, 賀志洋, 等. 自然場景下花椒果實的識別[J]. 中國農(nóng)機化學報, 2016, 37(10): 115-119.

Wan Fangxin, Bai Mingchang, He Zhiyang, et al. Identification of Chinese prickly ash under the natural scenes [J]. Journal of Chinese Agricultural Mechanization, 2016, 37(10): 115-119.

[5] 汪杰, 陳曼龍, 李奎, 等. 基于HSV與形狀特征融合的花椒圖像識別[J]. 中國農(nóng)機化學報, 2021, 42(10): 180-185.

Wang Jie, Chen Manlong, Li Kui, et al. Prickly ash image recognition based on HSV and shape feature fusion [J]. Journal of Chinese Agricultural Mechanization, 2021,42(10): 180-185.

[6] 王卓, 王健, 王梟雄, 等. 基于改進YOLO v4的自然環(huán)境蘋果輕量級檢測方法[J]. 農(nóng)業(yè)機械學報, 2022, 53(8): 294-302.

Wang Zhuo, Wang Jian, Wang Xiaoxiong, et al. Lightweight real-time apple detection method based on improved YOLO v4 [J]. Transactions of the Chinese Society for Agricultural Machinery, 2022, 53(8): 294-302.

[7] 景亮, 王瑞, 劉慧, 等. 基于雙目相機與改進YOLOv3算法的果園行人檢測與定位[J]. 農(nóng)業(yè)機械學報,2020, 51(9): 34-39, 25.

Jing Liang, Wang Rui, Liu Hui, et al. Orchard pedestrian detection and location based on binocular camera and improved YOLOv3 algorithm[J]. Transactions of the Chinese Society for Agricultural Machinery, 2020, 51 (9): 34-39, 25.

[8] 王丹丹, 宋懷波, 何東健. 蘋果采摘機器人視覺系統(tǒng)研究進展[J]. 農(nóng)業(yè)工程學報, 2017, 33(10): 59-69.

Wang Dandan, Song Huaibo, He Dongjian. Research advance on vision system of apple picking robot[J]. Transactions of the Chinese Society of Agricultural Engineering, 2017, 33(10): 59-69.

[9] Girshick R, Donahue J, Darrell T, et al. Rich feature hierarchies for accurate object detection and semantic segmentation [C]. Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, 2014: 580-587.

[10] Girshick R. Faster R-CNN [C]. Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, 2015: 1440-1448.

[11] Ren S Q, He K M, Girshick R, et al. Faster R-CNN: Towards real-time object detection with region proposal networks [J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2017, 39(6): 1137-1149.

[12] Redmon J, Divvala S, Girshick R, et al. You only look once: unified, real-time object detection [C]. Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, 2016: 779-788.

[13] Redmon J, Farhadi A. YOLO9000: Better, faster, stronger [C]. Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, 2017: 6517-6525.

[14] 楊小岡, 高凡, 盧瑞濤, 等. 基于改進YOLOv5的輕量化航空目標檢測方法[J]. 信息與控制, 2022, 51(3): 361-368.

Yang Xiaogang, Gao Fan, Lu Ruitao, et al. Lightweight aerial object detection method based on improved YOLOv5 [J]. Information and Control, 2022, 51(3): 361-368.

[15] 張明路, 郭策, 呂曉玲, 等. 改進的輕量化YOLOv4用于電子元器件檢測[J]. 電子測量與儀器學報, 2021, 35(10): 17-23.

Zhang Minglu, Guo Ce, Lü Xiaoling, et al. Improved lightweight YOLOv4 for electronic components detection [J]. Journal of Electronic Measurement and Instrumentation, 2021, 35(10): 17-23.

[16] 張凡, 張鵬超, 王磊, 等. 基于YOLOv5s的輕量化朱鹮檢測算法研究[J]. 西安交通大學學報, 2023(1): 1-12.

Zhang Fan, Zhang Pengchao, Wang Lei, et al. Research on lightweight Crested Ibis detection algorithm based on YOLOv5s [J]. Journal of Xian Jiaotong University, 2023(1): 1-12.

[17] Zhang X, Zhou X Y, Lin M X, et al. ShuffleNet: An extremely efficient convolutional neural network for mobile devices [C]. Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, 2018: 6848-6856.

[18] Sandler M, Howard A, Zhu M L, et al. MobileNetv2: inverted residuals and linear bottlenecks [C]. Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, 2018: 4510-4520.

[19] Rezatohighi H, Tsoi N, Gwak J Y, et al. Generalized Intersection over Union: A metric and a loss for bounding box regression [C]. Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, 2019: 658-666.

[20] Zheng Z H, Wang P, Liu W, et al. Distance-IoU loss: Faster and better learning for bounding box regression [C]. Proceedings of the AAAI Conference on Artificial Intelligence, 2020, 34(7): 12993-13000.