基于點積自注意力機制和殘差網絡的DAGAN圖像補全算法

寧浩宇 張逸彬 張莉娜 李申章 耿貞偉

關鍵詞:DAGAN;自注意力機制;殘差網絡

1引言

最初的圖像補全主要是基于數學和物理學的一種傳統圖像學技術。然而,近來年,在深度學習(DeepLearning,簡稱DL)逐漸占領視覺領域研究前沿的趨勢下,以深度學習為代表的機器學習正帶領研究者突破傳統模型發展的瓶頸。利用DL處理圖像補全的典型算法,按照網絡結構類型可以分為2類,即基于CNN(Convolutional Neural Networks,卷積神經網絡)的語境自編碼算法和基于GAN(Generative AdversarialNetwork,生成對抗網絡)的圖像補全算法。因此,本文在這兩種圖像補全的典型算法基礎上,結合其目前衍生的產物,設計了基于自注意力機制和殘差網絡的DAGAN(self-attention and residual GenerativeAdversarial Network)圖像補全算法,旨在對已有的部分算法進行整合并適當創新。

2相關工作

隨著人工智能時代的來臨,圖像補全技術算法不斷地更新換代,其在各大研究領域都起到了較大的輔助性作用。

在醫學影像領域,由于磁共振圖像的特殊成像方式,致使成像過程中產生偽影和噪聲,進而影響對病情的判斷。劉哲等[1]為了消除這些偽影和噪聲,使修復后的磁共振圖像細節更加豐富,提高其醫學應用價值,提出了一種基于深度殘差網絡編碼一反卷積網絡解碼框架的算法。針對手指靜脈由于位置特性導致成像中存在局部血管殘缺的問題,賈桂敏等[2]首次提出一種指靜脈紅外圖像血管網絡修復方法,實驗結果表明,該方法可以實現手指靜脈圖像局部血管網絡殘缺修復,得到更加完整、穩定的血管網絡結構,利用修復后的圖像可以進一步提高手指靜脈識別精度。

3圖像補全算法模型

近年來,隨著人工智能時代的到來,各大領域都在使用深度學習技術解決實際問題,如圖像分割[3]、分類[4]、對象識別[5]等.而本文著重介紹基于深度學習的圖像補全技術。

針對文本上的應用,林陽等融合自注意力機制的跨模態食譜檢索方法,這是一種利用食物圖片對食譜進行在線檢索的技術,在食譜文字編碼模塊中利用attention算法識別文本語義向量間的空間維度距離,解決了在食譜中同一原材料文本處理步驟相隔較遠的問題。王佛林等提出了基于自注意力機制的語義加強模型,由于每一個方面詞都有固定的情感修飾詞,因此該模型用自注意力機制獲取情感詞語義、句子分割點語義等多個維度的語義向量,提高了分類準確率。

3.1自注意力機制算法

3.1.1縮放點積注意力機制算法

縮放點積自注意力算法其實就是使用點積函數進行特征向量相似度的計算,其中縮放就是在進行相似度計算的基礎上縮小了為向量的維度),通過調節樣本維度使相似值不會太大,從而解決梯度消失的問題。縮放點積注意力機制的計算式為:

3.1.2多頭注意力機制

多頭注意力機制其實就是在縮放點積自注意力機制的基礎上加入了特征映射。算法思想為Query,Key,Value三個輸入維度的向量矩陣經過線性變換,然后對矩陣進行點積函數的計算,重復以上操作,并對計算矩陣進行特征拼接。在進行矩陣計算時,Query,Key,Value三個向量矩陣線性變換的權重是不同的。

3.1.3縮放點積多頭注意力機制

通過縮放點積注意力機制得到的結果將作為本文self-attention的值。具體實現過程為,將通過SEnet得到的卷積層作為self-attention的原始輸入。定義Q的特征通道,其中參數并不相同,將Q的輸出矩陣進行轉置,并和K的輸出矩陣進行計算,經過softmax得到attention權重矩陣,將這一矩陣和V(x)相乘得到基于自注意力機制的特征圖。這樣就可以很好地解決DCGAN本身處理圖像產生的邊緣模糊的問題。本文自注意力機制形式化計算式為:

3.2GAN圖像補全模型

GAN(Generative

Adversarial

Network)有2個網絡,即生成器(generator)和判別器(discriminator),在圖像補全中就是通過這兩個網絡來互相對抗以達到最好的生成效果。本文通過以下操作來擴展查詢圖。本文所提出的基于自注意力機制和殘差網絡的DAGAN圖像補全算法,對經過SEResNet和self-attention處理的模型作為GAN生成器,而沒有經過SEResNet處理的模型作為GAN判別器,使用交替訓練的方式來最小化損失函數。

在以往傳統的GANs中,它們擅長合成那些紋理特征區別明顯卻幾乎沒有結構約束的圖像類,如海洋、天空和景觀類,但對于那些受結構約束較強的圖像,就會無法捕捉某些類別中一貫出現的幾何或結構模式,如有四肢軀干的哺乳動物通常生成的圖像是具有現實的皮毛紋理,但沒有明確的獨立的腳。因此,在本文的GAN中self-attention模塊通過幫助生成器和判別器建模跨圖像區域的長期、多層次的依賴關系,而更好地體現整個圖像的結構約束特征。

4實驗

4.1實驗結果及分析

本文使用MNIST手寫體識別數據集和celebs數據集作為實驗數據,并用兩個數據集進行對比實驗。

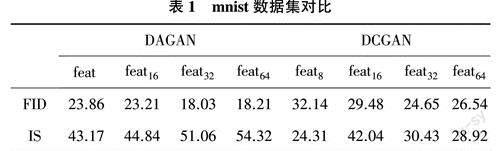

為了探討所提出的DAGAN算法在MNIST數據集的訓練效果,本文將從生成器和判別器的不同階段利用FID和IS兩種評估指標,對DAGAN算法和DCGAN算法進行對比分析。具體對比情況如表1所列。

如表1所列,在中到高級特征圖(如feat32和feat64)中DAGAN算法具有更好的性能。在DAGAN中feat8~feat32,FID指標從23.86改進到18.21,其原因是在生成器中通過self-attention獲得了更多、更具代表性的缺失圖像塊特征,并享有更多的自由來選擇更大feature map的條件,即對于大的feature map,它是卷積的補充,但是對于小的feature map,如8*8,它在建模依賴關系時,起到了與局部卷積類似的作用。

圖1為DAGAN與DCGAN準確率對比圖,在訓練了35個Epoches后,盡管DAGAN的準確率在75%左右,但在此之前DCGAN的準確率依然低于DAGAN。圖2為DAGAN與DCGAN修復視覺效果對比。

5結束語

實驗結果表明,在DCGAN基礎上增加了自注意機制和SEResNet模塊,為生成器和判別器提供了更強大的能力,可以對特征圖中的長期依賴關系進行建模,并更好地采集到圖像缺失邊緣的樣本,以此生成內容語義合理、圖像紋理足夠清晰真實的修復圖像。