基于AP-XDeepFM模型的廣告點(diǎn)擊率預(yù)測

侯 娜 邵新慧

(東北大學(xué)理學(xué)院 遼寧 沈陽 110819)

0 引 言

互聯(lián)網(wǎng)的出現(xiàn)和迅速發(fā)展使得廣告有別于傳統(tǒng)的媒體工具,借助互聯(lián)網(wǎng)這個(gè)平臺,在線廣告應(yīng)運(yùn)而生[1]。目前,很多互聯(lián)網(wǎng)公司的收益主要來源于廣告,比如微博、谷歌等。廣告的收入來源于用戶點(diǎn)擊廣告,廣告拍賣的效益取決于點(diǎn)擊率(Click-Through Rate,CTR)預(yù)測的準(zhǔn)確性。由于其廣泛的價(jià)值和巨大的市場回報(bào)率,廣告點(diǎn)擊率問題成為學(xué)術(shù)研究的熱點(diǎn)。

點(diǎn)擊率是指某條廣告點(diǎn)擊次數(shù)與展示次數(shù)之比,反映了其內(nèi)容的關(guān)注程度。高點(diǎn)擊率意味著廣告得到了精準(zhǔn)的推送,有利于廣告主產(chǎn)品的推廣,增加平臺方投放網(wǎng)站的訪問量,給用戶帶來符合自己需求的信息,產(chǎn)生良好的搜索體驗(yàn)。精準(zhǔn)的廣告點(diǎn)擊率可以實(shí)現(xiàn)廣告主、平臺方和用戶的三方利益的最大化[2]。

廣告點(diǎn)擊率預(yù)測的發(fā)展初期,常用的研究方法是概率統(tǒng)計(jì)[3],但因數(shù)據(jù)稀疏,預(yù)測效果不理想。Richardson等[4]分別采用邏輯回歸(Logistic Regression)和多元可加回歸樹(Multiple Additive Regression Trees,MART)方法進(jìn)行預(yù)測,并采用擬牛頓法訓(xùn)練,結(jié)果表明Logistic模型的預(yù)測效果優(yōu)于MART模型。Logistic模型簡單但學(xué)習(xí)能力有限,不能捕獲到非線性信息[5]。為挖掘非線性信息,Trofimov等[6]采用梯度決策樹(Gradient Boosting Regression Tree,GBDT)方法進(jìn)行廣告點(diǎn)擊率預(yù)測,GBDT能實(shí)現(xiàn)對特征的自動挖掘和組合,大量節(jié)省了人工成本。Facebook公司[7]提出將GBDT與LR模型相結(jié)合,將GBDT模型的結(jié)果作為LR模型的輸入,重新進(jìn)行訓(xùn)練,從而實(shí)現(xiàn)對廣告點(diǎn)擊率的預(yù)測。谷歌[8]提出FTRL(Follow The Regularized Leader Proximal)模型,針對LR模型設(shè)計(jì)獨(dú)特的梯度下降方法,為防止過擬合加入正則化,同時(shí)提高了廣告點(diǎn)擊率預(yù)測的準(zhǔn)確性。

為提高模型的預(yù)測性能,Rendle[9]提出了因子分解機(jī)(Factorization Machine,FM)模型,F(xiàn)M模型自動地捕獲二階交叉特征,解決了高維稀疏數(shù)據(jù)情況特征組合的困難。為解決當(dāng)不同的域進(jìn)行組合時(shí),隱向量可能會表現(xiàn)服從不同分布的問題,研究人員基于FM模型提出了FFM[10]、AFM[11]、FwFM[12]等模型。

近年來,隨著深度學(xué)習(xí)在自然語言處理、圖像處理等領(lǐng)域取得不錯(cuò)的成果,引起了CTR預(yù)測研究領(lǐng)域的關(guān)注。Google研究人員提出Wide & Deep模型[13],該模型將淺層模型LR模型和非線性模型DNN(Deep Neural Networks)巧妙地融合,開創(chuàng)了嵌入的方法在CTR研究領(lǐng)域的先河。進(jìn)一步地,Guo等[14]提出DeepFM模型,將Wide & Deep模型中的淺層模型替換為FM,并且使FM與DNN共享嵌入層的輸出值,節(jié)省了人工提取特征的時(shí)間。Lian等[15]針對DCN[16]的不足,并結(jié)合DeepFM提出XDeepFM,該模型同時(shí)以顯式和隱式的方式學(xué)習(xí)高階的特征交互,并且特征交互發(fā)生在向量級。

XDeepFM模型中采用LR模型提取一階特征,并且忽略了不同特征對于目標(biāo)向量的重要性。本文對XDeepFM模型進(jìn)行改進(jìn),提出基于AP-XDeepFM模型的廣告點(diǎn)擊率預(yù)測研究模型。在DNN的基礎(chǔ)上加入Product層,并引入注意力機(jī)制,使得模型能夠側(cè)重于影響力大的特征且能進(jìn)行更加細(xì)致的特征交互;另外,采用FM模型,提取一階特征和由一階特征兩兩組合而成的二階特征。

1 相關(guān)工作

在CTR預(yù)測中,數(shù)據(jù)類型主要是分類特征,分類特征通常進(jìn)行One-hot編碼,會得到一個(gè)高維稀疏矩陣,帶來維數(shù)災(zāi)難問題。傳統(tǒng)的機(jī)器學(xué)習(xí)算法(如LR、SVM[17]等)不能很好地處理稀疏數(shù)據(jù)且忽略了特征之間的交互關(guān)系,F(xiàn)M模型是針對以上問題提出的一種高效的解決方案。

FM模型在進(jìn)行特征組合時(shí),默認(rèn)每個(gè)交互特征發(fā)揮著同樣的作用,實(shí)際上,每個(gè)交互特征的影響是不同的,AFM模型能夠區(qū)分不同交互特征的重要性,提高模型的學(xué)習(xí)能力[11]。

借鑒圖像識別中CNN擴(kuò)大感受野的做法,在FM的基礎(chǔ)上連接若干個(gè)全連接層,從而產(chǎn)生高階的特征組合,加強(qiáng)模型對數(shù)據(jù)的學(xué)習(xí)能力,即FNN模型[5]。Qu等[18]認(rèn)為在FNN模型中,特征經(jīng)過嵌入層直接輸入到DNN進(jìn)行特征組合,也就是將特征進(jìn)行加權(quán)求和這種方法不能充分捕獲特征之間的相關(guān)性。因此,設(shè)計(jì)了Product層對特征進(jìn)行更加細(xì)致的交叉運(yùn)算。

考慮到FM模型不能捕獲高階特征之間的關(guān)系,F(xiàn)NN模型和PNN模型忽略低階特征之間的作用,華為研究人員結(jié)合兩個(gè)模型的優(yōu)點(diǎn),將FM模型和DNN結(jié)合起來聯(lián)合訓(xùn)練,提出DeepFM模型,該結(jié)構(gòu)比單一的學(xué)習(xí)模型預(yù)測性能表現(xiàn)得好。近年來,微軟公司提出了一種能夠顯式和隱式地學(xué)習(xí)特征交互的融合模型xDeepFM模型,該模型將線性模型、CIN(Compressed Interaction Network)模型和DNN結(jié)合并行訓(xùn)練,CIN和DNN共享相同的輸入向量,節(jié)省運(yùn)行時(shí)間并提升模型的泛化能力。

表1介紹幾種常見的CTR預(yù)測模型特性對比,分析發(fā)現(xiàn),在模型結(jié)構(gòu)上包括:單一淺層結(jié)構(gòu),如FM和AFM;單一深層結(jié)構(gòu),如FNN和PNN;淺層模型和(一個(gè)或多個(gè))深層模型的融合結(jié)構(gòu),如DeepFM和XDeepFM。只有AFM模型賦予交叉特征不同的重要性。FM、AFM只能學(xué)習(xí)一階特征和二階組合特征,F(xiàn)NN、PNN只能學(xué)習(xí)高階的交互特征,對于融合結(jié)構(gòu)的模型,不僅能學(xué)習(xí)低階特征也能學(xué)習(xí)高階特征,但未考慮特征的重要性。XDeepFM模型采用LR的方式學(xué)習(xí)低階特征,不能學(xué)習(xí)二階交叉特征。基于上述分析,本文借鑒XDeepFM的主要框架進(jìn)行改進(jìn),提出AP-XDeepFM模型,其特點(diǎn)是保留顯式學(xué)習(xí)高階特征的優(yōu)點(diǎn),并賦予交叉特征不同的重要性,通過引入Product層,對高階特征進(jìn)行更加細(xì)致的交互,通過采用FM模型,充分學(xué)習(xí)低階特征,提高模型的預(yù)測性能。

表1 CTR預(yù)估模型特性對比

2 模型設(shè)計(jì)

2.1 基本思想

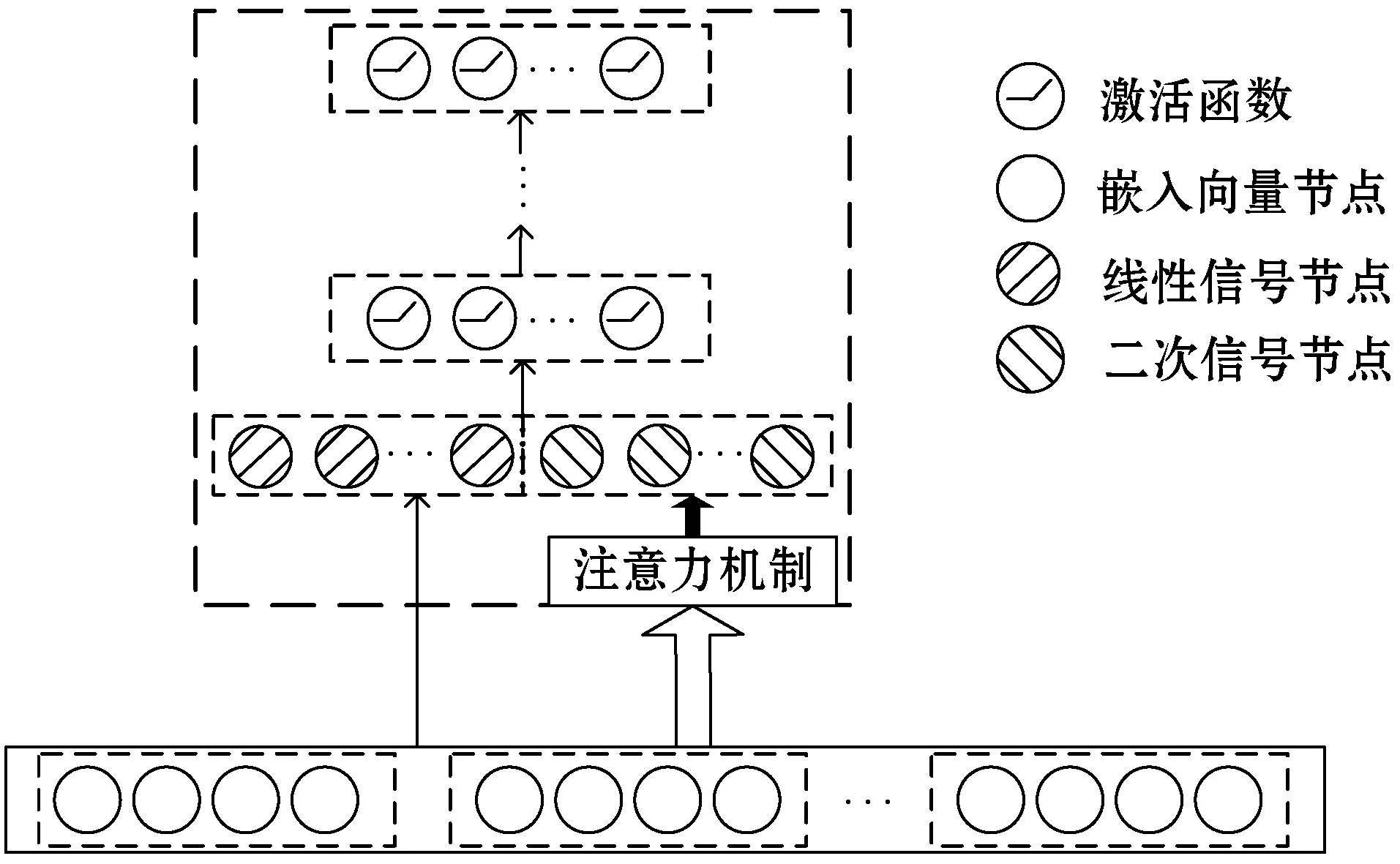

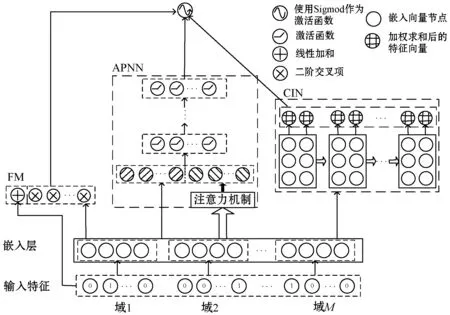

AP-XDeepFM模型主要受到XDeepFM模型的啟發(fā),采用融合結(jié)構(gòu),其框架與XDeepFM類似,AP-XDeepFM模型主要分為三層。第一層是嵌入層,原始特征經(jīng)過獨(dú)熱編碼產(chǎn)生的高維稀疏特征經(jīng)過嵌入層,將特征壓縮映射為D維的稠密向量。第二層是由三個(gè)模塊組合:FM模型、CIN模型和APNN模型。FM模型用于學(xué)習(xí)低階的交互特征,CIN模型可以顯式地學(xué)習(xí)高階交互特征,APNN模型不僅考慮到特征重要性,而且能更加細(xì)致地進(jìn)行隱式的特征提取。第三層是輸出層,將FM、CIN和APNN的輸出經(jīng)過Sigmoid函數(shù),采用Adam方法優(yōu)化模型的參數(shù),并進(jìn)行分類得到最終的預(yù)測值。

2.2 FM模型

FM模型是在線性模型的基礎(chǔ)上加入了二階交叉項(xiàng),彌補(bǔ)了線性模型忽略特征之間關(guān)系的缺憾。其模型為:

(1)

式中:n表示特征數(shù)量;xi表示第i個(gè)特征的值;vi表示第i個(gè)特征的隱向量;<·,·>表示向量內(nèi)積;w0∈R。

在線性模型的基礎(chǔ)上,加入二階交叉項(xiàng),不僅可以挖掘特征之間的關(guān)系,而且采用矩陣分解的思想來解決高維稀疏的問題,提高了模型的學(xué)習(xí)效率和預(yù)估能力。

2.3 APNN模型

目前為止,CTR預(yù)估研究問題的重心大多在于自動挖掘特征的交互信息,忽略了不同的交叉特征有著不同的重要性。比如對于用戶關(guān)于NBA這則廣告,性別為男且喜歡籃球的人群比性別男且家住上海的人群,更有可能點(diǎn)擊,也就是說對于目標(biāo)變量,前者比后者發(fā)揮的作用大。故將注意力機(jī)制引入模型中,使得不同的特征發(fā)揮著不同的重要性。

注意力機(jī)制[11]實(shí)質(zhì)上是包含一個(gè)隱藏層的多層感知機(jī),嵌入向量作為輸入向量,使用ReLU函數(shù)對交互特征打分,最后使用Softmax函數(shù)對分?jǐn)?shù)進(jìn)行規(guī)范化處理。計(jì)算式如下:

(2)

(3)

式中:W∈Rt×D、b∈Rt和h∈Rt是模型參數(shù),t是隱藏層節(jié)點(diǎn)數(shù),D是嵌入向量的維度;aij代表交互特征的重要性。

CTR預(yù)測研究的重點(diǎn)在于如何挖掘特征之間的相關(guān)性,DNN模型通過全連接的方法學(xué)習(xí)高階特征,未充分捕捉特征之間的關(guān)系。本文借鑒PNN模型的思想,在DNN第一個(gè)隱藏層前加入Product層。該層是由線性部分lz和非線性部分lp構(gòu)成,具體計(jì)算式為:

(4)

(5)

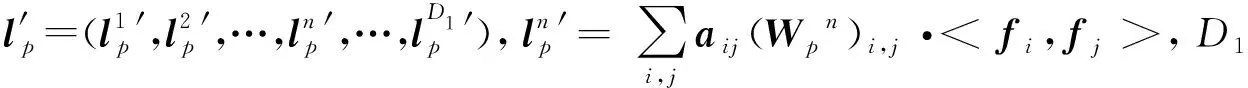

如圖1所示,APNN模型是一個(gè)包含多個(gè)隱藏層的神經(jīng)網(wǎng)絡(luò),不同于DNN,它采用單個(gè)隱藏層的神經(jīng)網(wǎng)絡(luò)搭建Attention層,并引入Product層增加模型的可解釋性。每層采用ReLU函數(shù)作為激活函數(shù),在第一層采用全連接的方式,如下:

(6)

圖1 APNN模塊的結(jié)構(gòu)

2.4 CIN模型

(7)

進(jìn)一步地,通過sum-pooling操作將輸出矩陣Xk壓縮為向量,作為最終的輸出,如:

(8)

2.5 AP-XDeepFM模型

如圖2所示,F(xiàn)M模塊和APNN模塊的結(jié)合使用可以提高模型的泛化能力,CIN模塊和APNN模塊的結(jié)合能夠充分學(xué)習(xí)交互特征,并引入注意力機(jī)制,加大重要交互特征的重要性,交互特征不僅能在元素級別上,也能在向量級別上進(jìn)行顯式和隱式的特征交互,提高模型的預(yù)測性能。

圖2 AP-XDeepFM模型的結(jié)構(gòu)

針對上述的AP-XDeepFM模型,我們設(shè)計(jì)了模型的具體訓(xùn)練步驟。

算法1基于AP-XDeepFM模型的CTR預(yù)估研究算法

輸入:原始數(shù)據(jù)集。

輸出:訓(xùn)練完的參數(shù)確定模型。

初始化參數(shù):嵌入向量的維度D,CIN模型的層數(shù),隱藏層節(jié)點(diǎn),APNN模型的層數(shù),隱藏層節(jié)點(diǎn),迭代次數(shù)T。

1.fort=1 toTdo

//遍歷每次迭代

2.獲取特征xi,I={i|xi≠0};

3.通過嵌入層,每個(gè)特征映射到D維的嵌入向量;

4.if enter in FM then:

//嵌入向量輸入到FM模型

if enter in APNN then:

//嵌入向量輸入到APNN模型

lk=ReLU(Wklk-1+bk-1);

if enter in CIN then:

//嵌入向量輸入到CIN模型

p+=[p1,p2,…,pk];

//輸出預(yù)測結(jié)果

//使用Adam優(yōu)化方法對參數(shù)進(jìn)行優(yōu)化

3 實(shí) 驗(yàn)

3.1 數(shù)據(jù)集

本文的數(shù)據(jù)集是2014年Kaggle競賽中avazu公司提供的公開數(shù)據(jù)集。該數(shù)據(jù)集共有四千多萬條,數(shù)據(jù)有23個(gè)特征和1個(gè)標(biāo)簽特征,其中正負(fù)樣本比約是1 ∶4。在原始數(shù)據(jù)中按照分層抽樣和隨機(jī)抽樣的方法抽取了100萬條數(shù)據(jù)進(jìn)行實(shí)驗(yàn),并每天按不同的采樣率進(jìn)行采樣,因此整體的正負(fù)樣本比例與原始數(shù)據(jù)基本一致,不會對實(shí)驗(yàn)結(jié)果造成影響。

3.2 評價(jià)指標(biāo)

為了檢驗(yàn)?zāi)P偷男Ч疚牟捎昧薃UC和均方根誤差這兩種評價(jià)指標(biāo)。

AUC(Area Under Curve)是刻畫ROC曲線的分類能力[19]。AUC的取值在0到1之間,AUC的值越大,分類器效果越好,那么輸出概率越合理,排序的結(jié)果越合理。所以,AUC直觀地反映了廣告的相對排序。

均方根誤差(Root Mean Square Error,RMSE)用來衡量預(yù)測值與真實(shí)值之間的偏差,由于正負(fù)樣本不平衡,精確度、準(zhǔn)確率等評價(jià)方式不能準(zhǔn)確地反映分類器的性能。由式(9)可以看出,RMSE能夠很好地觀察兩個(gè)數(shù)據(jù)分布的差異性,RMSE越大,數(shù)據(jù)分布之間的差異越大,分類模型的預(yù)測效果越差,反之,RMSE越小代表模型的精確度越高。

(9)

3.3 實(shí)驗(yàn)結(jié)果及分析

本文算法代碼是由Python 3.6軟件編寫,操作系統(tǒng)為Windows 7,內(nèi)存4 GB,CPU頻率為2.30 GHz。

本文選取前8天的數(shù)據(jù)作為訓(xùn)練數(shù)據(jù),第9天的數(shù)據(jù)作為測試數(shù)據(jù)。在相同的實(shí)驗(yàn)環(huán)境下,將通過6組實(shí)驗(yàn)對AP-XDeepFM模型的性能進(jìn)行對比,CIN中參數(shù)與xDeepFM模型中保持一致,對APNN中的重要超參數(shù)進(jìn)行實(shí)驗(yàn),討論不同的超參數(shù)對結(jié)果的影響,獲取最優(yōu)的超參數(shù)組合。在實(shí)驗(yàn)中,使用AUC和RMSE對模型結(jié)果進(jìn)行評估,實(shí)驗(yàn)分為5組。第1組實(shí)驗(yàn)討論學(xué)習(xí)率對預(yù)估結(jié)果的影響;第2組實(shí)驗(yàn)討論APNN隱藏層層數(shù)對預(yù)估結(jié)果的影響;第3組實(shí)驗(yàn)討論隱藏層節(jié)點(diǎn)數(shù)對預(yù)估結(jié)果的影響;第4組討論激活函數(shù)對預(yù)估結(jié)果的影響;第5組討論隨機(jī)失活率對預(yù)估結(jié)果的影響。第6組與典型模型進(jìn)行對比。

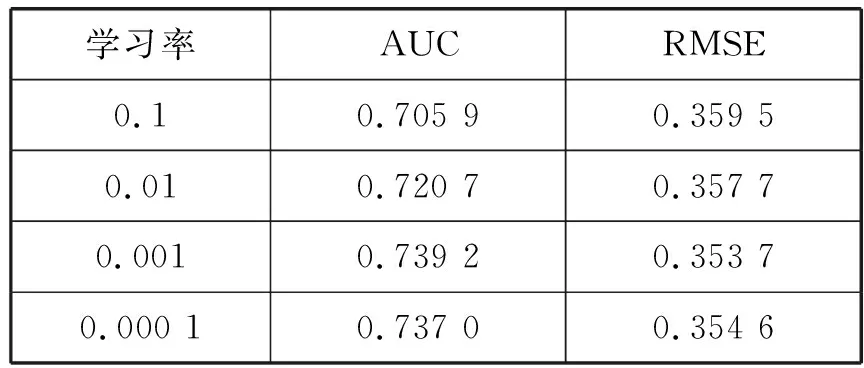

3.3.1學(xué)習(xí)率實(shí)驗(yàn)

本節(jié)分析不同的學(xué)習(xí)率對預(yù)估結(jié)果的影響。學(xué)習(xí)率是一個(gè)重要的超參數(shù),決定權(quán)重迭代的步長。在此實(shí)驗(yàn)中,采用搜索法,依次改變學(xué)習(xí)率為{0.1,0.01,0.001,0.000 1},記錄不同學(xué)習(xí)率下模型的效果。根據(jù)表2中AUC和RMSE的結(jié)果可知,當(dāng)學(xué)習(xí)率為0.001時(shí),模型的預(yù)測性能最佳。

表2 不同學(xué)習(xí)率對性能的影響

3.3.2隱藏層數(shù)目實(shí)驗(yàn)

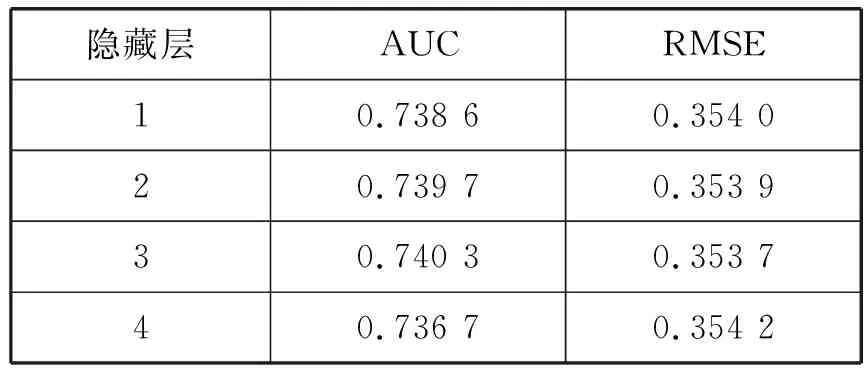

本節(jié)分析APNN網(wǎng)絡(luò)隱藏層層數(shù)對預(yù)估結(jié)果的影響。在此實(shí)驗(yàn)中,根據(jù)3.3.1節(jié)的結(jié)果設(shè)置模型的學(xué)習(xí)率為0.001,假設(shè)各隱藏層節(jié)點(diǎn)數(shù)為100,隱藏層從1層逐漸加到4層,實(shí)驗(yàn)結(jié)果如表3所示。

表3 隱藏層數(shù)目對性能的影響

隨著隱藏層數(shù)目的增多,模型的學(xué)習(xí)性能越高,CTR預(yù)估的準(zhǔn)確性明顯升高,說明模型對數(shù)據(jù)進(jìn)行充分的學(xué)習(xí),能夠提取深層次的特征。當(dāng)隱藏層數(shù)目大于3時(shí),模型的性能迅速下降,說明過多地增加隱藏層的數(shù)目會導(dǎo)致模型出現(xiàn)過擬合現(xiàn)象。根據(jù)表3中AUC和RMSE兩種評價(jià)指標(biāo)的結(jié)果,選擇隱藏層的數(shù)目為3。

3.3.3隱藏層節(jié)點(diǎn)數(shù)實(shí)驗(yàn)

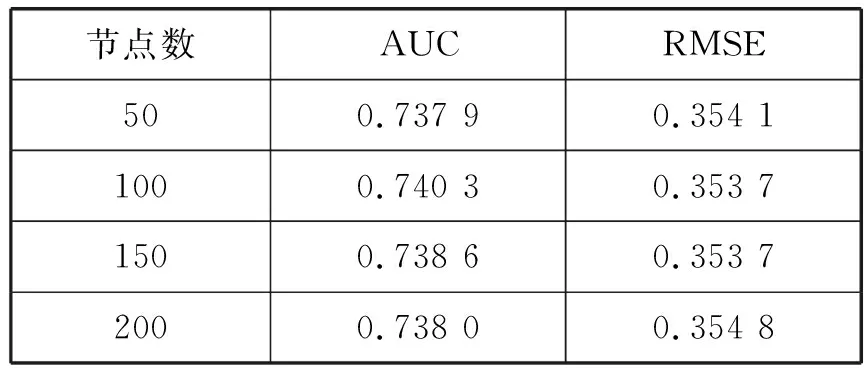

本節(jié)分析APNN網(wǎng)絡(luò)隱藏層節(jié)點(diǎn)數(shù)對預(yù)估結(jié)果的影響。考慮到每個(gè)隱藏層設(shè)置不同的節(jié)點(diǎn)數(shù),會使實(shí)驗(yàn)變得很復(fù)雜,為簡化實(shí)驗(yàn),設(shè)置每層的節(jié)點(diǎn)數(shù)相同,依次改變節(jié)點(diǎn)數(shù)為{50,100,150,200},結(jié)果如表4所示。

表4 隱藏層節(jié)點(diǎn)數(shù)對性能的影響

可以看出,隨著隱藏層節(jié)點(diǎn)數(shù)從50增至100時(shí),模型的學(xué)習(xí)性能不斷提升,CTR預(yù)估的準(zhǔn)確性明顯升高,模型得到很好的訓(xùn)練。當(dāng)節(jié)點(diǎn)數(shù)目大于100時(shí),模型的性能迅速下降,說明模型在訓(xùn)練集上學(xué)習(xí)過于充分,出現(xiàn)過擬合現(xiàn)象。根據(jù)表4中AUC和RMSE兩種評價(jià)指標(biāo)的結(jié)果,選擇隱藏層節(jié)點(diǎn)數(shù)為100。

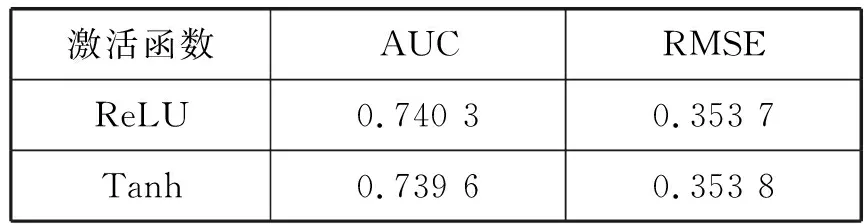

3.3.4激活函數(shù)實(shí)驗(yàn)

本節(jié)分析APNN網(wǎng)絡(luò)激活函數(shù)對預(yù)估結(jié)果的影響。根據(jù)前幾節(jié)實(shí)驗(yàn)的結(jié)果,設(shè)置學(xué)習(xí)率為0.001,隱藏層數(shù)目為3,節(jié)點(diǎn)數(shù)為100,采用ReLU和Tanh函數(shù)進(jìn)行對比,根據(jù)表5中AUC和RMSE評價(jià)指標(biāo),ReLU函數(shù)比Tanh函數(shù)的表現(xiàn)略好。

表5 激活函數(shù)對性能的影響

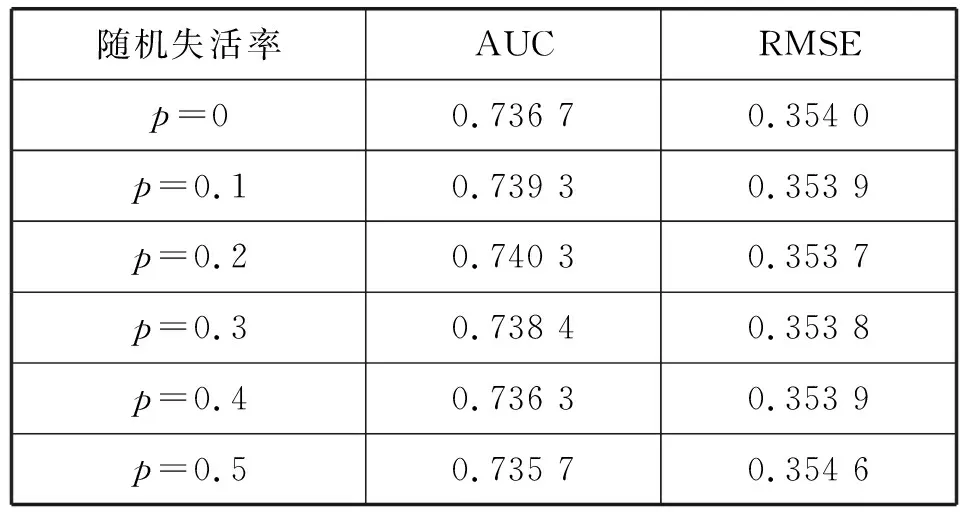

3.3.5隨機(jī)失活率的實(shí)驗(yàn)

本節(jié)分析不同的隨機(jī)失活率對預(yù)估結(jié)果的影響。為防止模型過擬合,本文采用L2正則化和隨機(jī)失活的方法。隨機(jī)失活率為0.5表示在遍歷網(wǎng)絡(luò)中每一層時(shí),會隨機(jī)丟棄50%的節(jié)點(diǎn)。隨機(jī)失活依次設(shè)置為{0.1,0.2,0.3,0.4,0.5},結(jié)果見表6。

表6 隨機(jī)失活率對性能的影響

觀察表6,使用隨機(jī)失活的方法可以提高模型的表現(xiàn),當(dāng)p小于0.2時(shí),模型的性能不斷提升,可知若不使用隨機(jī)失活,會導(dǎo)致模型過擬合,當(dāng)p大于0.2時(shí),模型的預(yù)估性能逐步下降,可能的原因是本文同時(shí)采用L2正則化和隨機(jī)失活率的方法,影響模型的學(xué)習(xí)的能力。結(jié)合AUC和RMSE的表現(xiàn),選擇隨機(jī)失活率為0.2。

通過使用網(wǎng)格搜索法,對學(xué)習(xí)率、隱藏層數(shù)目、隱藏層節(jié)點(diǎn)數(shù)、激活函數(shù)和隨機(jī)失活率重要的超參數(shù)進(jìn)行實(shí)驗(yàn),討論不同情況下模型的預(yù)估效果。通過分析AUC和RMSE兩種評價(jià)指標(biāo),確定最優(yōu)的超參數(shù)組合,即設(shè)置學(xué)習(xí)率為0.001,隱藏層數(shù)目為3,隱藏層節(jié)點(diǎn)數(shù)為100,激活函數(shù)為ReLU,隨機(jī)失活率為0.2。

3.3.6與典型的模型進(jìn)行對比實(shí)驗(yàn)

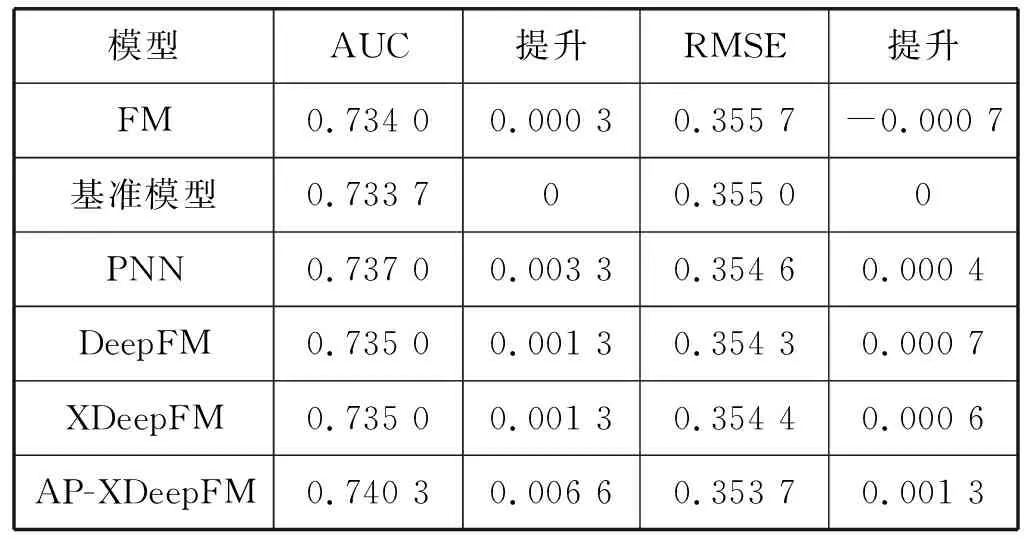

在相同的實(shí)驗(yàn)環(huán)境下,分別采用FM模型、基準(zhǔn)模型(嵌入層+MLR)、PNN、DeepFM、XDeepFM模型和AP-XDeepFM模型進(jìn)行對比實(shí)驗(yàn),其中深度學(xué)習(xí)模型在層數(shù)以及每層節(jié)點(diǎn)數(shù)保持一致,優(yōu)化方法采用Adam算法,學(xué)習(xí)率為0.001,嵌入向量的維度為10。結(jié)果如表7所示。

表7 不同模型的性能對比

實(shí)驗(yàn)結(jié)果分析:基準(zhǔn)模型的預(yù)測效果優(yōu)于FM模型,深度學(xué)習(xí)模型的預(yù)測性能優(yōu)于基準(zhǔn)模型。從AUC和RMSE指標(biāo)分析,本文提出的模型AP-XDeepFM效果優(yōu)于其他模型。相比于基準(zhǔn)模型,其AUC值提高了0.006 6,RMSE值降低了0.001 3。實(shí)驗(yàn)結(jié)果表明了AP-XDeepFM模型能通過顯式和隱式的方式,充分挖掘反映目標(biāo)變量的高階特征,還能自動學(xué)習(xí)二階交叉項(xiàng),豐富模型的特征,使用注意力機(jī)制,加大重要特征的權(quán)重,從而有效地提高了模型的學(xué)習(xí)能力和泛化能力。綜上,本文改進(jìn)的模型能夠提高CTR預(yù)測性能。

4 結(jié) 語

為提高CTR預(yù)測效果,本文在XDeepFM模型的基礎(chǔ)上進(jìn)行改進(jìn),提出一種新的融合結(jié)構(gòu)——AP-XDeepFM模型。從兩個(gè)角度作為出發(fā)點(diǎn),(1) 加大重要交互特征的權(quán)重,引入注意力機(jī)制;(2) 挖掘特征之間的關(guān)系,引入FM自動捕獲一階以及由一階生成的二階特征,在DNN的基礎(chǔ)上加入一個(gè)Product層,以便進(jìn)行更加細(xì)致的學(xué)習(xí)高階特征。通過實(shí)驗(yàn)討論模型學(xué)習(xí)率、隱藏層層數(shù)、節(jié)點(diǎn)數(shù)、激活函數(shù)和隨機(jī)失活率對模型性能的影響,并與幾種典型的CTR預(yù)估模型進(jìn)行對比。實(shí)驗(yàn)表明:該融合模型比現(xiàn)有的模型在AUC和RMSE上略有提升,可在元素級別和向量級別上顯式和隱式地學(xué)習(xí)特征交互,也能捕捉到低階交互特征,并使得重要交互特征發(fā)揮作用,有效地挖掘了高階和低階交互特征,提高了模型的預(yù)測性能。