基于語義分割引導(dǎo)的三維目標(biāo)檢測

崔振東,李宗民,,楊樹林,劉玉杰,李 華

基于語義分割引導(dǎo)的三維目標(biāo)檢測

崔振東1,李宗民1,2,楊樹林2,劉玉杰1,李 華3,4

(1. 中國石油大學(xué)(華東)計算機科學(xué)與技術(shù)學(xué)院,山東 青島 266580;2. 山東石油化工學(xué)院大數(shù)據(jù)與基礎(chǔ)科學(xué)學(xué)院,山東 東營 257061;3. 中國科學(xué)院計算技術(shù)研究所智能信息處理重點實驗室,北京 100190;4. 中國科學(xué)院大學(xué)計算機科學(xué)與技術(shù)學(xué)院,北京 100049)

三維目標(biāo)檢測是計算機視覺領(lǐng)域的熱門研究內(nèi)容之一。在自動駕駛系統(tǒng)中,三維目標(biāo)檢測技術(shù)通過捕獲周圍的點云信息與RGB圖像信息,對周圍物體進行檢測,從而為車輛規(guī)劃下一步的行進路線。因此,通過三維目標(biāo)檢測實現(xiàn)對周邊環(huán)境的精準(zhǔn)檢測與感知是十分重要的。針對三維目標(biāo)檢測技術(shù)中隨機采樣算法導(dǎo)致前景點丟失的問題,首先提出了基于語義分割的隨機采樣算法,通過預(yù)測的語義特征指導(dǎo)采樣過程,提升了前景點的采樣比重,進而提高了三維目標(biāo)檢測精度;其次,針對三維目標(biāo)檢測定位置信度與分類置信度不一致的問題,提出了CL聯(lián)合損失,使得網(wǎng)絡(luò)傾向于選擇定位置信度與分類置信度都高的3D候選框,避免了傳統(tǒng)的NMS僅考慮分類置信度所帶來的歧義問題。在KITTI三維目標(biāo)檢測數(shù)據(jù)集進行了實驗,結(jié)果表明,該方法能夠在簡單、中等、困難3個難度下均獲得精度的提升,從而驗證了其在三維目標(biāo)檢測任務(wù)中的有效性。

深度學(xué)習(xí);三維目標(biāo)檢測;點云語義分割;采樣算法;定位置信度

隨著科技的發(fā)展,自動駕駛成為了時下最熱門的行業(yè)之一。自動駕駛技術(shù)以其精確、安全、可靠的特點,減少了人類手動駕駛過程中所出現(xiàn)的安全事故。這項技術(shù)的影響不只體現(xiàn)在汽車行業(yè),且對社會發(fā)展、出行體系都帶來了巨大的變革。自動駕駛行業(yè)的興盛,離不開其關(guān)鍵技術(shù)之一——三維目標(biāo)檢測技術(shù)的發(fā)展。三維目標(biāo)檢測技術(shù)通過車輛上的雷達傳感器和圖像傳感器捕獲周邊的環(huán)境信息,幫助車輛有效地檢測并理解周邊的環(huán)境,測算出其他車輛、行人等物體的方向、距離,從而幫助自動駕駛系統(tǒng)規(guī)劃下一步車輛的行進路線。

三維目標(biāo)檢測技術(shù)通過雷達傳感器掃描獲取了三維點云數(shù)據(jù)。三維點云數(shù)據(jù)主要包含坐標(biāo)信息,,和點云的反射強度信息。三維點云與圖像的主要區(qū)別在于點云數(shù)據(jù)是無序、不規(guī)則、近密遠疏的,而且數(shù)據(jù)量龐大。但對于三維目標(biāo)檢測任務(wù)來說,點云數(shù)據(jù)能提供原始的三維位置信息,使用三維信息能夠幫助網(wǎng)絡(luò)更精確地檢測到物體的位置。因此,目前主流的三維目標(biāo)檢測方法[1-3]都是基于原始點云信息來完成的。然而,在室外大場景中,點云的數(shù)量十分龐大,約有十萬到二十萬不等。目前的硬件條件想要實時處理如此大規(guī)模的點云是十分困難的,因此,在處理點云之前必須使用采樣算法對點云進行下采樣,選取有代表性的點作為輸入,用以提取特征。目前人們大多使用隨機采樣(random sampling,RS)來實現(xiàn)下采樣的過程,隨機采樣能夠?qū)崿F(xiàn)在多個點中隨機選取出固定數(shù)量的點,該方法雖然快,卻具有很大的隨機性。在三維目標(biāo)檢測任務(wù)中,點云根據(jù)其位置和語義可以被分為前景點和背景點。前景點包括車輛、自行車、行人等物體表面上的點,其余點如公路、墻面、綠化帶等物體表面上的點均為背景點。如果能夠采樣更

多的前景點作為網(wǎng)絡(luò)的輸入,就能夠提取更多的前景信息,從而有效地提升車輛、行人等前景物體的檢測精度。然而,隨機采樣在執(zhí)行過程中,并未考慮點的位置、上下文等信息,采樣結(jié)果全憑隨機,很難選取到大量前景點作為輸入信息送入網(wǎng)絡(luò)。本文針對這一問題,提出了基于語義分割的隨機采樣算法,能夠在采樣過程中考慮點云的分割特征,有效地選擇出更多前景點作為輸入。同時,針對目標(biāo)檢測存在的分類置信度與定位置信度不一致的問題,還提出了CL聯(lián)合損失(classification-location joint loss)來幫助網(wǎng)絡(luò)選擇定位置信度與分類置信度都高的3D候選框,避免了傳統(tǒng)的NMS僅考慮分類置信度所帶來的歧義問題,有效地提升了三維目標(biāo)檢測任務(wù)的精度。

1 相關(guān)工作

1.1 基于圖像的三維目標(biāo)檢測

基于圖像的方法根據(jù)使用的二維圖像輸入數(shù)量主要分為基于單目圖像的方法和基于立體視覺的方法。三維目標(biāo)檢測任務(wù)本質(zhì)上是由二維目標(biāo)檢測任務(wù)延伸而來,基于圖像的三維目標(biāo)檢測與二維目標(biāo)檢測也是最為相似的。然而,由于缺乏深度信息,只用二維信息來進行三維目標(biāo)檢測是比較困難的。現(xiàn)有的方法主要有2種思路來緩解缺乏深度信息的問題:①利用神經(jīng)網(wǎng)絡(luò)提取高級語義表示,求得2D檢測框與3D檢測框之間的映射;②結(jié)合外部深度信息進行深度推理。CHEN等[4]提出了一個簡單的窮舉搜索算法,生成一組3D候選框,并利用卷積神經(jīng)網(wǎng)絡(luò)對候選框進行特征提取和細化。LU等[5]利用幾何先驗知識將位置預(yù)測分解為二維和三維的高度估計。ZHANG等[6]將三維目標(biāo)檢測任務(wù)分為長寬高、深度、三維中心坐標(biāo)、角度4個子任務(wù)進行,對于不同截斷程度的框均有比較高的召回率。上述方法盡管有效,但還是難以彌補缺乏深度信息的缺點,因此基于圖像的方法雖然速度較快,但精度普遍不高。

1.2 基于體素的三維目標(biāo)檢測

三維空間中的體素對應(yīng)著二維空間中的像素。當(dāng)三維空間被劃分成一個個大小相同的體素塊之后,對每個體素塊內(nèi)包含的點云的特征進行求和與取均值的操作,使用體素塊內(nèi)所有點云特征的均值作為其特征信息,如此一來,不規(guī)則的點云就被轉(zhuǎn)化為了規(guī)則的體素,以便通過三維卷積神經(jīng)網(wǎng)絡(luò)有效地提取用于三維目標(biāo)檢測的特征。然而,此種取均值操作是用一個值代表多個點云的特征,不可避免地會造成信息的損失,尤其是那些特征值與均值差距較大的點云,其特征就被嚴(yán)重地“平均”了,因此精度不是很高。如果想盡量保留原始信息,就需要讓體素格盡可能的小,但會大大增加體素的總體數(shù)量,從而導(dǎo)致計算量大幅增加。ZHOU和TUZEL[7]提出了VoxelNet,引入了VFE編碼層聚合體素特征,是基于體素的三維目標(biāo)檢測的開創(chuàng)性工作。然而,由于三維卷積網(wǎng)絡(luò)的計算量遠大于二維卷積網(wǎng)絡(luò),因此使用普通的三維卷積會引入巨大的時間開銷。后來,YAN等[8]針對VoxelNet效率低的缺點提出了稀疏嵌入卷積檢測(sparsely embedded convolutional detection,SECOND),引入了稀疏卷積[9-11]來提升網(wǎng)絡(luò)的計算速度。DENG等[12]提出了Voxel RoI池化模塊,通過聚合體素特征來生成感興趣區(qū)域(region of interest,RoI)特征,同時使用加速的PointNet[13]模塊,在保證精度的同時提升了網(wǎng)絡(luò)的計算速度。然而,由于體素化過程的局限性,基于體素的方法在精度上仍略低于點云的方法。

1.3 基于原始點云的三維目標(biāo)檢測

2017年文獻[13]提出PointNet和文獻[14]提出PointNet++之后,很多人開始使用這2種骨干網(wǎng)絡(luò)作為三維目標(biāo)檢測任務(wù)的特征提取網(wǎng)絡(luò)。因為PointNet和PointNet++可以直接從原始點云中進行特征提取,無需對點云進行體素化處理,從而最大程度地保留了物體的原始三維信息。因此,該方法相對于基于體素的方法來說,檢測精度得到了提升。文獻[1]提出了PointRCNN,將經(jīng)典的二維目標(biāo)檢測算法Faster RCNN引入了三維目標(biāo)檢測,提出了第一個兩階段的基于原始點云的三維目標(biāo)檢測算法。文獻[2]提出了三維單階段目標(biāo)檢測器(3D single stage object detector,3DSSD),在PointNet++中的特征聚合模塊(set abstraction model,SA model)中提出了一種新的融合策略,同時移除了特征傳播模塊(feature propagation model,F(xiàn)P model),提升了基于原始點云方法的計算速度。文獻[3]提出了Lidar-RCNN,為解決尺度模糊問題提出了有效的解決方案。

1.4 基于圖像和點云融合的三維目標(biāo)檢測

二維RGB圖像能夠提供色彩信息,是三維點云數(shù)據(jù)所無法提供的,因此一部分研究人員開始嘗試融合二維信息和三維信息進行三維目標(biāo)檢測任務(wù)。2016年,CHEN等[15]提出多視圖三維目標(biāo)檢測(multi-view 3D object detection,MV3D),將點云投影到鳥瞰圖,使用RoI融合策略,在第二階段融合圖像和點云的特征。KU等[16]針對MV3D檢測不到小物體的問題,提出了聚合視圖目標(biāo)檢測(aggregate view object detection,AVOD),在MV3D的基礎(chǔ)上引入了特征金字塔網(wǎng)絡(luò)(feature pyramid networks,F(xiàn)PN)[17],融合了多個尺度的特征圖,從而對小物體也有了比較高的召回率。VORA等[18]提出了PointPainting,使用圖像語義信息來增強點云信息,從而使得點云信息更加豐富。HUANG等[19]在PointRCNN[1]的基礎(chǔ)上提出了增強點特征網(wǎng)絡(luò)(enhancing point features networks,EPNet),引入了圖像分支來學(xué)習(xí)二維特征,并通過LI-Fusion模塊對圖像特征和點云特征進行融合,從而使用更豐富的特征信息來完成三維目標(biāo)檢測任務(wù)。

目前輸入數(shù)據(jù)中包含原始點云信息的方法大都需要使用隨機采樣來對大量的原始點云進行下采樣,以減少輸入網(wǎng)絡(luò)中的點云的數(shù)量,提升網(wǎng)絡(luò)的運算速度。但在室外場景下,傳感器掃描到的點大都屬于背景點,只有少部分屬于前景點。局限于RS算法本身的特性,通過RS采樣出來的點中前景點占比很小。為了解決該問題,本文提出了基于語義分割的隨機采樣算法,改善了普通RS采樣結(jié)果包含前景點較少的問題。同時,針對目標(biāo)檢測任務(wù)存在的定位置信度與分類置信度不一致的問題,提出了CL聯(lián)合損失來監(jiān)督網(wǎng)絡(luò)的訓(xùn)練過程,旨在指導(dǎo)網(wǎng)絡(luò)篩選出分類置信度與定位置信度都高的三維目標(biāo)檢測框。

2 本文方法

在點云比較稀疏的情況下,或是在霧天、雨天的場景中,僅使用點云信息進行三維目標(biāo)檢測是比較困難的。如圖1所示,在上方的RGB圖像中,可以觀察到遠處有一輛白色轎車,而在其對應(yīng)的點云場景下,相同的位置處卻難以觀察到轎車的形狀。因此,加入圖像信息來幫助檢測是十分重要的。本文算法使用了點云和圖像2種信息作為輸入,通過特征學(xué)習(xí)初步生成候選框,再對候選框進行細化,輸出三維目標(biāo)檢測的最終檢測結(jié)果。

圖1 點云稀疏時難以預(yù)測的物體

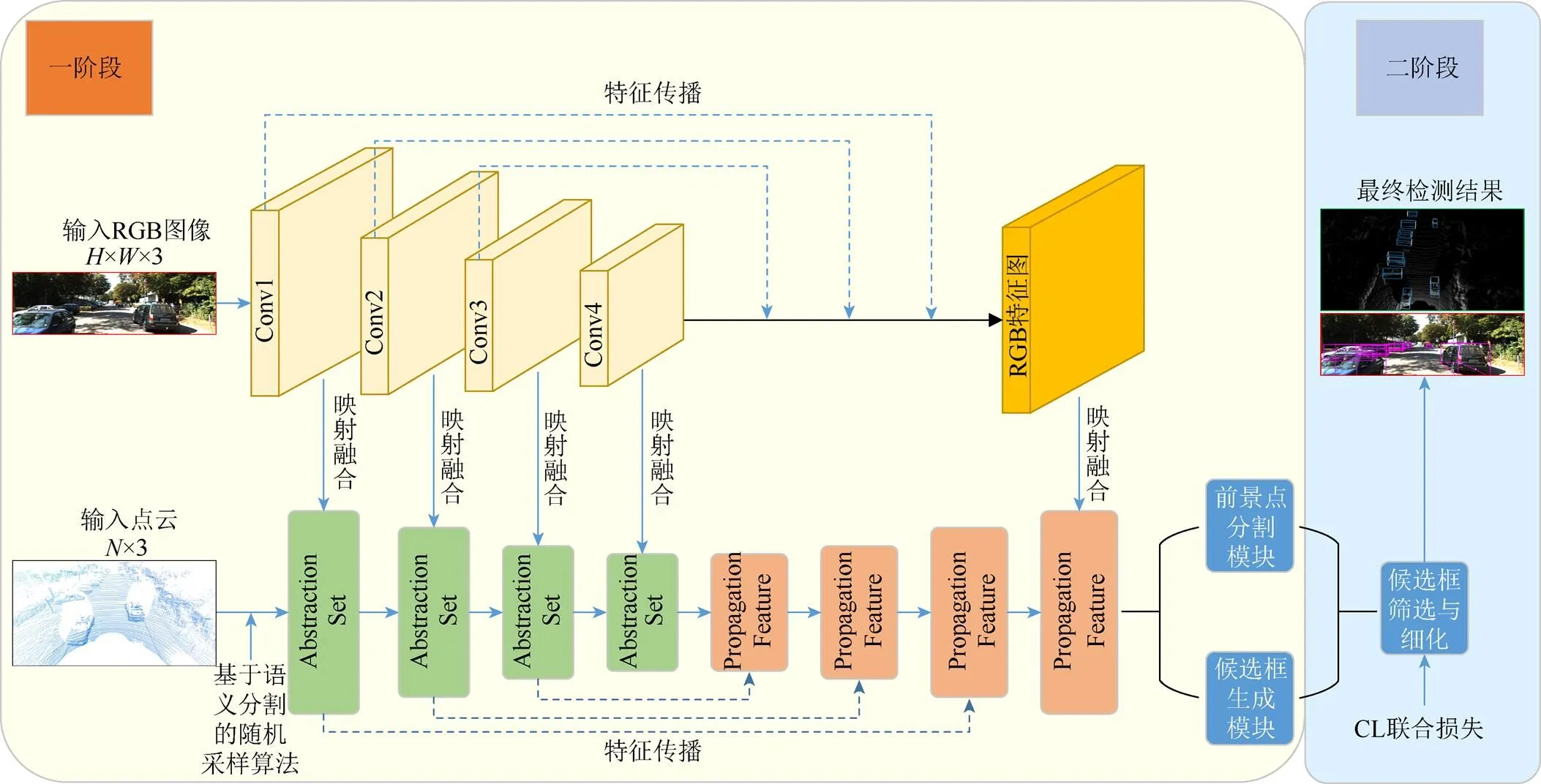

2.1 網(wǎng)絡(luò)模型

本文的網(wǎng)絡(luò)結(jié)構(gòu)(圖2)以原始點云和RGB圖像作為輸入數(shù)據(jù),輸出數(shù)據(jù)為輸入場景中車輛的三維目標(biāo)檢測框的中心點坐標(biāo)(,,)、三維目標(biāo)檢測框的長寬高(,,)以及車輛的朝向角度。

本文算法為兩階段的算法:第一階段提取和融合原始點云與圖像的特征,通過提取的特征將場景中的點分為前景點和背景點,并且為每個前景點都生成一個初始的3D候選框;第二階段對第一階段生成的若干個3D候選框進行微調(diào),刪除冗余框,最終對于每一個物體,只保留一個置信度最高的候選框作為輸出結(jié)果。

在第一階段中,本文使用PointNet++[14]作為點云信息提取的骨干網(wǎng)絡(luò),與普通的PointNet[13]網(wǎng)絡(luò)相比,PointNet++引入了MSG和MRG模塊,能夠有效地學(xué)習(xí)點云的局部多尺度特征。PointNet++中包含4個特征聚合模塊和4個特征傳播模塊,每個特征聚合模塊包含采樣層、分組層和特征提取層。對于圖像信息,本文以攝像機拍攝的RGB圖像作為輸入,輸出包含豐富語義信息的不同大小的特征圖。與PointNet++中的4個特征聚合模塊對應(yīng),本文使用4個簡單二維卷積塊提取圖像特征,每個卷積塊包含2個3×3的卷積層、1個批量歸一化(batch normalization,BN)層和1個修正線性單元(rectified linear unit,ReLU)激活層組成。并且將第2個卷積層的步長設(shè)置為2,從而擴大感受野,并且減少網(wǎng)絡(luò)模型的計算量。本文的特征映射融合方式與EPNet[19]相同。

第二階段的任務(wù)是對第一階段生成的多個3D候選框進行細化和微調(diào)。第二階段的細化網(wǎng)絡(luò)包括3個特征聚合模塊,以第一階段生成的多個3D候選框中隨機采樣512個點作為細化網(wǎng)絡(luò)的輸入(點云數(shù)量不足512的則隨機重采樣),通過特征聚合模塊后分別下采樣到128,32和1,最終輸出一個一維向量來表征物體的分類置信度和對于(,,,,,,)的微調(diào)目標(biāo)值。

圖2 本文網(wǎng)絡(luò)結(jié)構(gòu)圖

2.2 基于語義分割的隨機采樣絡(luò)模型

對于室外大型場景而言,點云的總體數(shù)量是十分龐大的。以KITTI數(shù)據(jù)集[20-21]為例,點云是環(huán)繞車輛360°采集的,一個場景內(nèi)的點云數(shù)量大都在100 000~200 000之間。RGB圖像是面向車輛正前方拍攝的,官方也僅提供了正前方部分的數(shù)據(jù)標(biāo)注。因此,在將點云輸入網(wǎng)絡(luò)之前,首先需要將車輛正前方之外的點云刪除,僅保留車輛正前方的點云。保留的點云數(shù)量大約為16 000~20 000個。然而,其中屬于前景點的點云數(shù)量大約在100~5 000之間。因此,前景點的數(shù)量相對于背景點是比較稀疏的。在以往的三維目標(biāo)檢測方法中,人們大都使用隨機采樣來選取16 384個點作為網(wǎng)絡(luò)的輸入數(shù)據(jù)。雖然隨機采樣的計算速度快,但隨機采樣在點云密度低的地方采集的點數(shù)很少。如果一個物體距離采樣位置很遠,由于點云的稀疏性,遠處物體的點云數(shù)量遠小于近處物體,此時使用隨機采樣會導(dǎo)致屬于遠處物體的點云基本不會被采樣或僅采樣數(shù)量極少的點云,從而導(dǎo)致網(wǎng)絡(luò)對遠處物體的檢測難度大大增加。

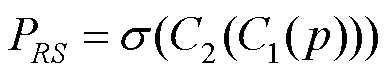

為了解決隨機采樣算法采樣結(jié)果的前背景點數(shù)量不平衡問題,本文提出了一種基于語義分割的隨機采樣方法。首先,通過點云坐標(biāo)的深度信息,即(,,)中值對點云進行分類,大于等于40的,視為遠點;小于40的,視為近點。然后,將遠點全部保留,保證原本稀疏的遠點不會因為下采樣而被剔除。對于近點,本文使用一個語義分割網(wǎng)絡(luò)對點云進行分割和打分,隨機采樣模塊中的語義分割分?jǐn)?shù)為

其中,為原始點云的三維坐標(biāo)信息(,,);為Sigmoid激活函數(shù);1為第一個卷積層,將點云的信息由3維升維到128維;2為第二個卷積層,將點云的信息由128維降維到1維,再通過Sigmoid函數(shù)的計算獲得每個點的分割分?jǐn)?shù),前景點與背景點的期望分割分?jǐn)?shù)分別為1和0。之后再對近點的分割分?jǐn)?shù)進行排序,選擇得分最高的2 048個近點,最后對剩余的近點進行隨機采樣,直至總點數(shù)達到16 384為止(若該場景沒有遠點,則直接從近點中選取分割得分最高的2 048個點云,再對剩余點云進行隨機采樣至16 384個點)。以此作為PointNet++[14]第一個特征聚合層的輸入。

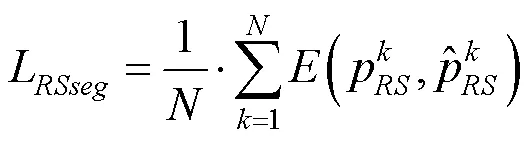

當(dāng)然,分割模塊是可以訓(xùn)練的。本文遵循PointRCNN[1]的方法,由于三維的物體在3D空間下是彼此之間自然分離的,因此,在數(shù)據(jù)集的標(biāo)注中,3D框內(nèi)部的點均可被看做是前景點,而3D框之外的點為背景點。綜上,可以通過3D真值框的標(biāo)注獲取到物體的分割真值,即框內(nèi)的點分割真值為1,框外的點為0。對于模塊的訓(xùn)練過程,本文使用交叉熵損失來進行監(jiān)督,損失函數(shù)為

通過此種方法,原本稀疏的遠處物體的點云不會因為下采樣而被剔除,保證了輸入數(shù)據(jù)中遠點的數(shù)量,進而提升了模型對于遠處困難物體的檢測能力。同時,近處的點也有更多的前景點送入網(wǎng)絡(luò)進行特征學(xué)習(xí),從而提取出豐富的前景信息,對于網(wǎng)絡(luò)對前景物體的檢測也有著很大的幫助。

2.3 CL聯(lián)合損失

非極大值抑制(non-maximum suppression,NMS)算法被廣泛應(yīng)用于目標(biāo)檢測算法中,其目的是消除冗余的目標(biāo)檢測框,為每個物體僅保留一個檢測框作為最終的檢測結(jié)果。在傳統(tǒng)的NMS算法中,檢測框的分類置信度是評價其精確度的主要標(biāo)準(zhǔn)。在獲取若干個檢測框之后,NMS根據(jù)檢測框的分類置信度從大到小進行排序,首先選擇分類置信度最高的檢測框,再計算其余檢測框與分類置信度最高的框的交并比(intersection over union,IoU),IoU大于一定閾值的檢測框會被抑制和剔除掉。

然而,在某些情況下,檢測框的分類置信度并不能很好地反映框的定位準(zhǔn)確性。如圖3所示,相對于綠色的真值框而言,黃色檢測框擁有很高的分類置信度,但其定位置信度卻比較低,藍色檢測框的定位置信度很高,但分類置信度卻低于黃色框。如果將2個框送入NMS,黃色框會被保留,且藍色框會被判定為黃色框的冗余框從而被刪除,這顯然不是我們想要的結(jié)果。

為了使得定位置信度高的檢測框能夠被保留,YU等[22]提出了IoU損失,提升了檢測框的定位置信度,從而提升了2D目標(biāo)檢測的效果。然而,UnitBox并未考慮分類置信度,而分類置信度是NMS算法所依賴的。針對此問題,本文提出了CL聯(lián)合損失以使得網(wǎng)絡(luò)傾向于選擇分類置信度與定位置信度都比較高的3D預(yù)測框。CL聯(lián)合損失為

其中,S為預(yù)測框的分類得分;為預(yù)測框的位置;為真值框的位置;為權(quán)重系數(shù)。由于S與IoU均是屬于[0,1]的數(shù),因此當(dāng)損失趨近于0時,S與IoU必須均趨近于1,即分類置信度與定位置信度越高時,損失越小。

圖3 分類與定位置信度不一致問題

Fig. 3 Classification and localization confidence inconsistency problem

通過使用CL聯(lián)合損失,使得那些原本定位置信度高而分類置信度低的3D預(yù)測框能夠在NMS的過程中得到保留,進而提升了網(wǎng)絡(luò)輸出的最終檢測框的定位精度。

3 實驗結(jié)果與分析

3.1 數(shù)據(jù)集與評價指標(biāo)

本文使用KITTI-3D數(shù)據(jù)集[20-21]來驗證和評估本文方法。對于三維目標(biāo)檢測任務(wù),KITTI公開數(shù)據(jù)集包含7 481個樣本。在之前的工作中[1,7],7 481個樣本被分為3 712個訓(xùn)練樣本和3 769個驗證樣本。因此,為了保證結(jié)果的公平性,本文按照文獻[1,7]方法進行測試。本文使用KITTI數(shù)據(jù)集官方所提出的40個召回率下的平均精度均值(mean average precision,mAP)作為評價標(biāo)準(zhǔn),同時也方便與之前的工作進行公平的比較。

3.2 實驗細節(jié)

本文的網(wǎng)絡(luò)架構(gòu)如圖2所示。以圖像和點云作為輸入數(shù)據(jù),對于點云數(shù)據(jù),從原始點云中采樣了16 384個點作為點云分支的輸入數(shù)據(jù)。對于圖像分支,將輸入圖像裁剪或補充成大小為1280 px×384 px的圖像作為輸入數(shù)據(jù)。點云分支的4個SA模塊分別將點云下采樣到4 096,1 024,256,64個點。再使用4個FP模塊恢復(fù)到16 384個點,與輸入點云數(shù)量保持一致,但每個點云的信息被豐富到了128維。在這個過程中,使用三線性插值來補充沒有信息或信息維度不足的點的特征。本文提出的CL聯(lián)合損失的權(quán)重系數(shù)在訓(xùn)練過程中設(shè)置為2。

本文使用的硬件設(shè)備為4×GeForce RTX 2080 Ti顯卡,每張顯卡的顯存為11 G。本文的2個子網(wǎng)絡(luò)采用端到端的訓(xùn)練方式,訓(xùn)練100個epoch,batch size大小為8,優(yōu)化算法為adam onecycle,初始學(xué)習(xí)率為0.002,權(quán)重衰減為0.001,momentum為0.9。本文采用了與EPNet[19]相同的數(shù)據(jù)增強方法,對輸入點云沿軸隨機旋轉(zhuǎn)[?π/18,π/18],沿軸隨機翻轉(zhuǎn),并且對真值框按照[0.95,1.05]的均勻分布進行隨機縮放。

3.3 實驗分析

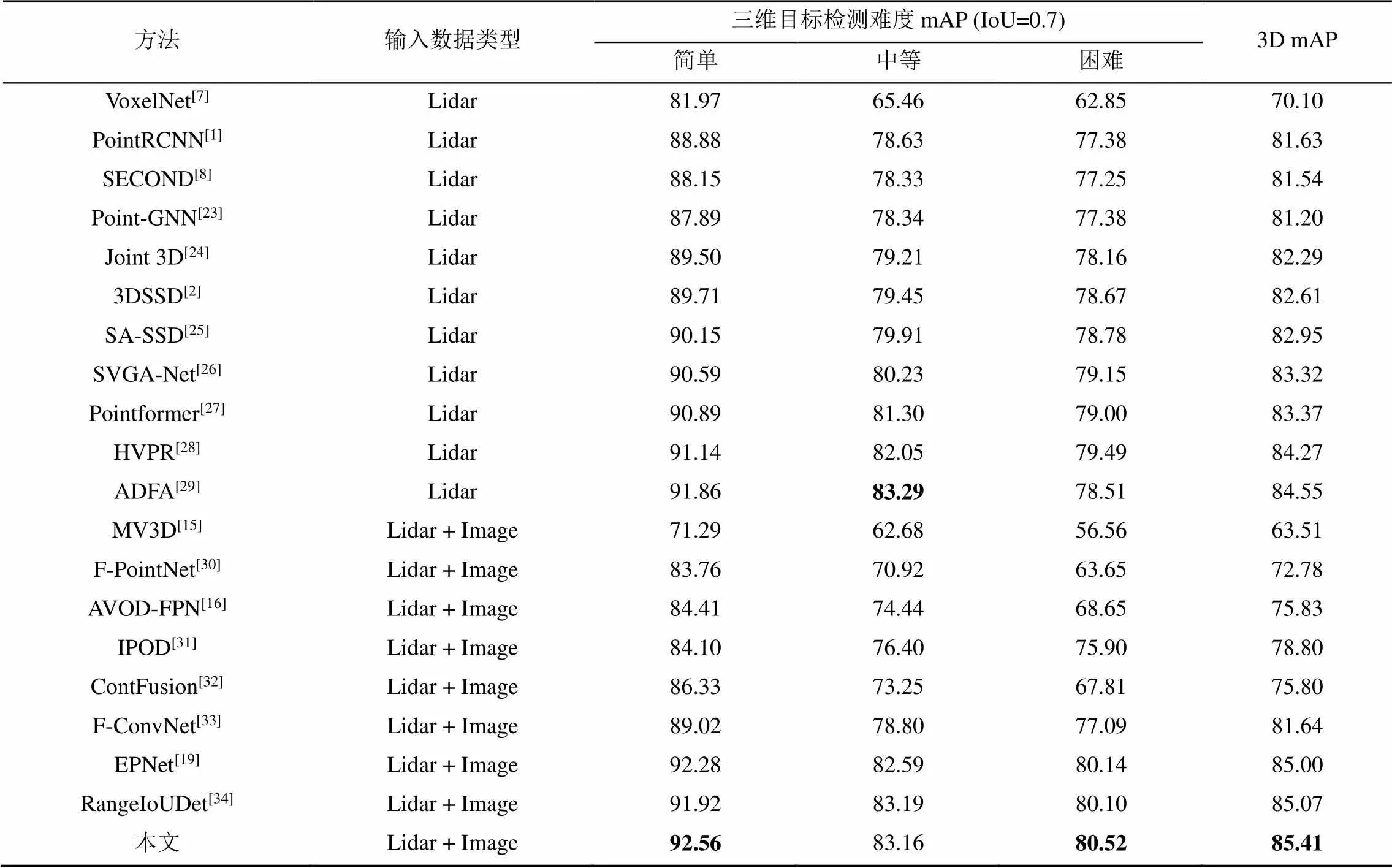

為了驗證本文方法的有效性,在KITTI val數(shù)據(jù)集[20-21]上進行了測試,與一部分主流的三維目標(biāo)檢測方法進行了比較,比較結(jié)果見表1。通過比較結(jié)果可知,本文方法的平均精度均值在簡單、中等、困難3個難度的測試上均較之前的方法有所提升,證明了本文基于語義分割的隨機采樣算法和CL聯(lián)合損失能夠有效地提升三維目標(biāo)檢測任務(wù)的mAP。

圖4為本文方法在KITTI val數(shù)據(jù)集上測試結(jié)果的3組可視化效果。其中,第一行為原始圖像,第二行為本文方法檢測結(jié)果在圖像上的可視化結(jié)果,第三行為官方標(biāo)注文件中的真實值的可視化效果,第四行為本文方法檢測結(jié)果在點云上的可視化結(jié)果。綠色3D框為真值框,紫色框和藍色框為預(yù)測框,3D場景中框的淺色面朝向表示物體的朝向,黃色圈中的物體是官方數(shù)據(jù)集中標(biāo)注為DontCare的物體,標(biāo)注為DontCare意味著該物體距離掃描設(shè)備過遠導(dǎo)致點云十分稀疏。值得注意的是,本文算法檢測出了部分被官方標(biāo)記為DontCare的物體,說明本文基于語義分割的隨機采樣算法能夠有效保留更多本身點云較為稀疏的物體的前景點。在第三列中,紅色圈中的物體是本文方法預(yù)測方向錯誤的案例,左上方車輛檢測錯誤的原因可能是該車輛車頭與車尾形狀十分相似,同時距離點云采集設(shè)備較遠,點云稀疏,并且該車輛處于陰影中,RGB信息不夠豐富;右側(cè)車輛方向預(yù)測錯誤的原因可能是該車輛被遮擋嚴(yán)重,僅憑車輛頂部的點云很難預(yù)測正確該車輛的朝向。

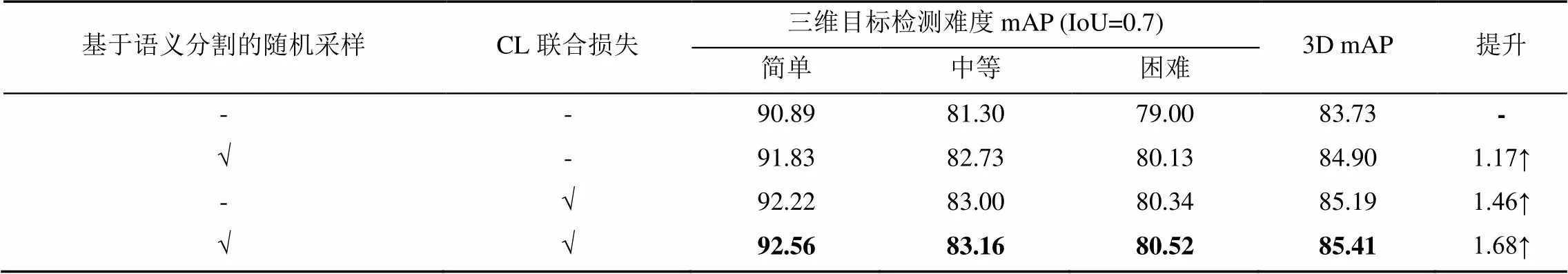

3.4 消融實驗

本文在KITTI val數(shù)據(jù)集[20-21]上進行了大量的消融實驗,以驗證本文方法的有效性。實驗結(jié)果見表2。可以看出,在使用基于語義分割的隨機采樣算法之后,3D mAP指標(biāo)相較于不使用提升了1.17%。說明基于語義分割的隨機采樣算法可以有效地選擇更多的前景點作為網(wǎng)絡(luò)的輸入,從而使得網(wǎng)絡(luò)能夠?qū)W習(xí)到更加豐富的前景特征,提升網(wǎng)絡(luò)對于前景物體的檢測性能,同時最大程度地保留了遠點,使得原本稀疏的遠點不會因為下采樣而導(dǎo)致丟失,提升了對遠處物體的檢測性能。在使用了CL聯(lián)合損失之后,3D mAP指標(biāo)得到了1.46%的提升。說明本文提出的CL聯(lián)合損失能夠幫助網(wǎng)絡(luò)選擇出定位置信度與分類置信度都比較高的3D檢測框,有效減少了部分擁有很高定位置信度的3D檢測框由于分類置信度較低而被NMS算法所抑制的情況。將兩者一起使用時,3D mAP指標(biāo)提升了1.68%,證明了本文方法的有效性。

表1 KITTI val數(shù)據(jù)集三維目標(biāo)檢測結(jié)果對比

注:加粗?jǐn)?shù)據(jù)為同等難度下的三維目標(biāo)檢測mAP最優(yōu)值

圖4 本文算法三維目標(biāo)檢測可視化結(jié)果((a)原圖;(b)圖像可視化結(jié)果;(c)真值;(d)點云可視化結(jié)果)

表2 KITTI val數(shù)據(jù)集上的消融實驗

注:加粗?jǐn)?shù)據(jù)為同等難度下的三維目標(biāo)檢測mAP最優(yōu)值

針對本文提出的CL聯(lián)合損失的權(quán)重系數(shù),本文做了對應(yīng)的消融實驗,實驗結(jié)果見表3。通過實驗結(jié)果可以看出,當(dāng)設(shè)為2時,可以取得最高的3D mAP值85.41%。因此本文在訓(xùn)練過程中將設(shè)為2。實驗結(jié)果表明,在選擇預(yù)測框時適當(dāng)考慮定位置信度是有意義的。本文方法能夠有效地選擇出定位置信度與分類置信度都比較高的檢測框,從而提升了三維目標(biāo)檢測的性能。

表3 CL聯(lián)合損失中參數(shù)l不同值的比較

注:加粗?jǐn)?shù)據(jù)為同等難度下的三維目標(biāo)檢測mAP最優(yōu)值

4 結(jié)束語

本文針對三維目標(biāo)檢測中隨機采樣具有不確定性的問題,提出了基于語義分割的隨機采樣算法,得以充分利用點云的原始信息,使輸入網(wǎng)絡(luò)的點云具有更強的代表性,同時針對目標(biāo)檢測的定位置信度與分類置信度存在歧義的問題,提出了CL聯(lián)合損失,使得網(wǎng)絡(luò)能夠選擇出那些分類置信度與定位置信度都比較高的候選框,減少了擁有很高定位置信度的3D檢測框由于分類置信度較低而被NMS算法所抑制的情況。本文在KITTI val數(shù)據(jù)集[20-21]上進行了大量三維目標(biāo)檢測的相關(guān)實驗,結(jié)果表明,本文方法的三維目標(biāo)檢測精度高于一部分主流的三維目標(biāo)檢測方法,證明了其有效性。本文存在的問題是對于圖像信息的利用還不足,下一步的工作重點是探究如何更好地使用圖像信息,以及信息融合的新方式。

[1] SHI S S, WANG X G, LI H S. PointRCNN: 3D object proposal generation and detection from point cloud[C]//2019 IEEE/CVF Conference on Computer Vision and Pattern Recognition. New York: IEEE Press, 2019: 770-779.

[2] YANG Z T, SUN Y N, LIU S, et al. 3DSSD: point-based 3D single stage object detector[C]//2020 IEEE/CVF Conference on Computer Vision and Pattern Recognition. New York: IEEE Press, 2020: 11037-11045.

[3] LI Z C, WANG F, WANG N Y. LiDAR R-CNN: an efficient and universal 3D object detector[C]//2021 IEEE/CVF Conference on Computer Vision and Pattern Recognition. New York: IEEE Press, 2021: 7542-7551.

[4] CHEN X Z, KUNDU K, ZHANG Z Y, et al. Monocular 3D object detection for autonomous driving[C]//2016 IEEE Conference on Computer Vision and Pattern Recognition. New York: IEEE Press, 2016: 2147-2156.

[5] LU Y, MA X Z, YANG L, et al. Geometry uncertainty projection network for monocular 3D object detection[C]// 2021 IEEE/CVF International Conference on Computer Vision. New York: IEEE Press, 2021: 3091-3101.

[6] ZHANG Y P, LU J W, ZHOU J. Objects are different: flexible monocular 3D object detection[C]//2021 IEEE/CVF Conference on Computer Vision and Pattern Recognition. New York: IEEE Press, 2021: 3288-3297.

[7] ZHOU Y, TUZEL O. VoxelNet: end-to-end learning for point cloud based 3D object detection[C]//2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition. New York: IEEE Press, 2018: 4490-4499.

[8] YAN Y, MAO Y X, LI B. SECOND: sparsely embedded convolutional detection[J]. Sensors: Basel, Switzerland, 2018, 18(10): 3337.

[9] GRAHAM B. Spatially-sparse convolutional neural networks[EB/OL]. (2014-02-03) [2022-05-09]. https://arxiv. org/abs/1409.6070.

[10] GRAHAM B. Sparse 3D convolutional neural networks[EB/OL]. (2015-08-13) [2022-06-10]. https://arxiv. org/abs/1505.02890.

[11] GRAHAM B, ENGELCKE M, MAATEN L V D. 3D semantic segmentation with submanifold sparse convolutional networks[C]//2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition. New York: IEEE Press, 2018: 9224-9232.

[12] DENG J J, SHI S S, LI P W, et al. Voxel R-CNN: towards high performance voxel-based 3D object detection[EB/OL]. (2020-07-15) [2022-05-11]. https://arxiv.org/abs/2012.15712.

[13] CHARLES R Q, HAO S, MO K C, et al. PointNet: deep learning on point sets for 3D classification and segmentation[C]//2017 IEEE Conference on Computer Vision and Pattern Recognition. New York: IEEE Press, 2017: 77-85.

[14] QI C R, YI L, SU H, et al. PointNet++: deep hierarchical feature learning on point sets in a metric space[C]//The 31st International Conference on Neural Information Processing Systems. New York: ACM Press, 2017: 5105-5114.

[15] CHEN X Z, MA H M, WAN J, et al. Multi-view 3D object detection network for autonomous driving[C]//2017 IEEE Conference on Computer Vision and Pattern Recognition. New York: IEEE Press, 2017: 6526-6534.

[16] KU J, MOZIFIAN M, LEE J, et al. Joint 3D proposal generation and object detection from view aggregation[C]// 2018 IEEE/RSJ International Conference on Intelligent Robots and Systems. New York: IEEE Press, 2018: 1-8.

[17] LIN T Y, DOLLáR P, GIRSHICK R, et al. Feature pyramid networks for object detection[C]//2017 IEEE Conference on Computer Vision and Pattern Recognition. New York: IEEE Press, 2017: 936-944.

[18] VORA S, LANG A H, HELOU B, et al. PointPainting: sequential fusion for 3D object detection[C]//2020 IEEE/CVF Conference on Computer Vision and Pattern Recognition. New York: IEEE Press, 2020: 4603-4611.

[19] HUANG T T, LIU Z, CHEN X W, et al. EPNet: enhancing point features with image semantics for 3D object detection[M]//Computer Vision - ECCV 2020. Cham: Springer International Publishing, 2020: 35-52.

[20] GEIGER A, LENZ P, URTASUN R. Are we ready for autonomous driving? The KITTI vision benchmark suite[C]//2012 IEEE Conference on Computer Vision and Pattern Recognition. New York: IEEE Press, 2012: 3354-3361.

[21] GEIGER A, LENZ P, STILLER C, et al. Vision meets robotics: the KITTI dataset[J]. The International Journal of Robotics Research, 2013, 32(11): 1231-1237.

[22] YU J H, JIANG Y N, WANG Z Y, et al. UnitBox: an advanced object detection network[C]//The 24th ACM International Conference on Multimedia. New York: ACM Press, 2016: 516-520.

[23] SHI W J, RAJKUMAR R. Point-GNN: graph neural network for 3D object detection in a point cloud[C]//2020 IEEE/CVF Conference on Computer Vision and Pattern Recognition. New York: IEEE Press, 2020: 1708-1716.

[24] ZHOU D F, FANG J, SONG X B, et al. Joint 3D instance segmentation and object detection for autonomous driving[C]//2020 IEEE/CVF Conference on Computer Vision and Pattern Recognition. New York: IEEE Press, 2020: 1836-1846.

[25] HE C H, ZENG H, HUANG J Q, et al. Structure aware single-stage 3D object detection from point cloud[C]//2020 IEEE/CVF Conference on Computer Vision and Pattern Recognition. New York: IEEE Press, 2020: 11870-11879.

[26] HE Q D, WANG Z N, ZENG H, et al. SVGA-net: sparse voxel-graph attention network for 3D object detection from point clouds[J]. Proceedings of the AAAI Conference on Artificial Intelligence, 2022, 36(1): 870-878.

[27] PAN X R, XIA Z F, SONG S J, et al. 3D object detection with pointformer[C]//2021 IEEE/CVF Conference on Computer Vision and Pattern Recognition. New York: IEEE Press, 2021: 7459-7468.

[28] NOH J, LEE S, HAM B. HVPR: hybrid voxel-point representation for single-stage 3D object detection[C]//2021 IEEE/CVF Conference on Computer Vision and Pattern Recognition. New York: IEEE Press, 2021: 14600-14609.

[29] LI J L, DAI H, SHAO L, et al. Anchor-free 3D single stage detector with mask-guided attention for point cloud[C]//The 29th ACM International Conference on Multimedia. New York: ACM Press, 2021: 553-562.

[30] CAO P, CHEN H, ZHANG Y, et al. Multi-view frustum pointnet for object detection in autonomous driving[C]//2019 IEEE International Conference on Image Processing. New York: IEEE Press: 3896-3899.

[31] YANG Z T, SUN Y N, LIU S, et al. IPOD: intensive point-based object detector for point cloud[EB/OL]. (2018-01-25) [2022-04-28]. https://arxiv.org/abs/1812.05276.

[32] LIANG M, YANG B, WANG S L, et al. Deep continuous fusion for multi-sensor 3D object detection[M]//Computer Vision - ECCV 2018. Cham: Springer International Publishing, 2018: 663-678.

[33] WANG Z X, JIA K. Frustum ConvNet: sliding Frustums to aggregate local point-wise features for amodal 3D object detection[C]//2019 IEEE/RSJ International Conference on Intelligent Robots and Systems. New York: IEEE Press, 2019: 1742-1749.

[34] LIANG Z D, ZHANG Z H, ZHANG M, et al. RangeIoUDet: range image based real-time 3D object detector optimized by intersection over union[C]//2021 IEEE/CVF Conference on Computer Vision and Pattern Recognition. New York: IEEE Press, 2021: 7136-7145.

3D object detection based on semantic segmentation guidance

CUI Zhen-dong1, LI Zong-min1,2, YANG Shu-lin2, LIU Yu-jie1, LI Hua3,4

(1. College of Computer Science and Technology, China University of Petroleum, Qingdao Shandong 266580, China; 2. College of Big Data and Basic Science, Shandong Institute of Petroleum and Chemical Technology, Dongying Shandong 257061, China; 3. Key Laboratory of Intelligent Information Processing, Institute of Computing Technology, Chinese Academy of Sciences, Beijing 100190, China; 4. School of Computer Science and Technology, University of Chinese Academy of Sciences, Beijing 100049, China)

3D object detection is one of the most popular research fields in computer vision. In the self-driving system, the 3D object detection technology detects the surrounding objects by capturing the surrounding point cloud information and RGB image information, thereby planning the upcoming route for the vehicle. Therefore, it is of great importance to attain the accurate detection and perception of the surrounding environment. To address the loss of foreground points incurred by random sampling in the field of 3D object detection, a random sampling algorithm based on semantic segmentation was proposed, which guided the sampling process through the predicted semantic features, so as to increase the sampling proportion of foreground points and heighten the precision of 3D object detection. Secondly, to address the inconsistency between the location confidence of 3D object detection and the classification confidence, the CL joint loss was proposed, leading the network to select the 3D bounding box with high location confidence and classification confidence, so as to prevent the ambiguity caused by the traditional NMS only considering the classification confidence. Experiments on KITTI 3D object detection datasets show that the proposed method can improve the precision at the three levels of difficulties: easy, moderate, and hard, which verifies the effectiveness of the method in 3D object detection task.

deep learning; 3D object detection; point cloud semantic segmentation; sampling algorithm; location confidence

TP 391

10.11996/JG.j.2095-302X.2022061134

A

2095-302X(2022)06-1134-09

2022-07-21;

:2022-09-30

國家重點研發(fā)計劃項目(2019YFF0301800);國家自然科學(xué)基金青年基金項目(61806199);國家自然科學(xué)基金項目(61379106);山東省自然科學(xué)基金項目(ZR2013FM036,ZR2015FM011);中國石油大學(xué)(華東)研究生創(chuàng)新基金項目(22CX04037A)

崔振東(1997-),男,碩士研究生。主要研究方向為三維目標(biāo)檢測與深度學(xué)習(xí)。E-mail:z20070047@s.upc.edu.cn

李宗民(1965-),男,教授,博士。主要研究方向為計算機圖形學(xué)、數(shù)字圖像處理與模式識別。E-mail:lizongmin@upc.edu.cn

21 July,2022;

30 September,2022

National Key Research and Development Program of China (2019YFF0301800); Youth Fund of National Natural Science Foundation of China (61806199); National Natural Science Foundation of China (61379106); Natural Science Foundation of Shandong Province (ZR2013FM036, ZR2015FM011); Innovation Fund Project for Graduate Student of China University of Petroleum (East China) (22CX04037A)

CUI Zhen-dong (1997-), master student. His main research interests cover 3D object detection and deep learning. E-mail:z20070047@s.upc.edu.cn

LI Zong-min (1965-), professor, Ph.D. His main research interests cover computer graphics, digital image processing and pattern recognition. E-mail:lizongmin@upc.edu.cn