異構(gòu)分支關(guān)聯(lián)特征融合的行人重識別

陳 璠,彭 力

物聯(lián)網(wǎng)技術(shù)應(yīng)用教育部工程研究中心(江南大學(xué) 物聯(lián)網(wǎng)工程學(xué)院),江蘇 無錫214122

行人重識別(person re-identification,Person Re-ID)是計(jì)算機(jī)視覺中的一項(xiàng)重要任務(wù),其目的是從多臺攝像機(jī)捕捉的一組行人圖像中檢索出一個(gè)特定的人。

早期的Person Re-ID 技術(shù)對整幅圖像提取全局特征進(jìn)行圖像檢索,但是由于真實(shí)場景下的行人圖像存在光照差異大、拍攝視角不統(tǒng)一、物體遮擋等問題,從圖像整體提取的全局特征易受無關(guān)因素的干擾,識別精度不高[1]。基于局部特征的方法因此被提出,通過挖掘人體部位[2-5]、行人姿態(tài)[6-9]等關(guān)鍵信息,可加強(qiáng)模型對人體關(guān)鍵區(qū)域的學(xué)習(xí),降低無關(guān)因素的干擾。

基于特征空間分割的方法在空間尺度上將特征劃分為多個(gè)局部顯著性區(qū)域,讓模型在訓(xùn)練過程中學(xué)習(xí)不同區(qū)域的差異性,并強(qiáng)制每個(gè)區(qū)域滿足獨(dú)立的ID 預(yù)測損失。Zheng 等人通過將卷積網(wǎng)絡(luò)輸出的特征圖均分為6塊,考慮了全局特征和局部特征之間的漸變關(guān)系,金字塔模型包括6 層共計(jì)21 塊不同尺度區(qū)域,再將最后一層的特征串聯(lián)起來以使模型能夠提取到具有較強(qiáng)上下文聯(lián)系的特征[4]。PAR(partaligned representations)模型將人體分割成若干個(gè)可區(qū)分的區(qū)域,再將每個(gè)區(qū)域的特征向量連接起來,得到最終的特征向量表示[5]。上述基于空間分割的方法能夠簡單直觀地細(xì)化特征,加強(qiáng)特征的魯棒性。另外,該方法考慮到圖像間行人粗糙的幾何對應(yīng)關(guān)系,將所有局部特征以特定順序進(jìn)行連接以得到行人的結(jié)構(gòu)化特征。雖然此類方法在一定程度上能夠解決幾何變化和遮擋等問題,但沒有顧及身體局部區(qū)域之間的關(guān)系,可能降低具有相似屬性的不同行人在對應(yīng)部位的區(qū)分度。

為了進(jìn)一步提升采用特征空間分割方法的模型的重識別性能,有研究者構(gòu)建具有多個(gè)分支的網(wǎng)絡(luò)模型,例如全局特征分支和局部特征分支。Yao等人提出的零件損失網(wǎng)絡(luò)(part loss networks,PL-Net)通過引入零件損失自動(dòng)檢測人體部位,并計(jì)算每個(gè)零件的分類損失,以影響全局分支的特征表達(dá)[10]。Wang等人設(shè)計(jì)了一種整合全局特征和局部特征的多粒度模型(multiple granularity network,MGN),包括一個(gè)全局分支和兩個(gè)局部分支,MGN 通過將特征圖劃分成多個(gè)條紋特征圖,并且改變不同分支的條紋數(shù)量來獲得多粒度局部特征表示[3]。對于采用多個(gè)分支的模型,全局特征增強(qiáng)了模型對背景信息的學(xué)習(xí),而局部特征可融合人體關(guān)鍵特征。但這些模型的每個(gè)分支均使用同構(gòu)特征,即這些特征均復(fù)制自全局分支的高層,使模型缺乏結(jié)構(gòu)多樣的差異特征。

針對上述問題,本文提出一種異構(gòu)分支關(guān)聯(lián)特征融合的行人重識別算法。將OSNet(omni-scale network)與注意力機(jī)制相結(jié)合作為主干共享卷積網(wǎng)絡(luò),以學(xué)習(xí)到具有更強(qiáng)顯著性和區(qū)分性的行人關(guān)鍵特征;將分支網(wǎng)絡(luò)輸出的行人特征進(jìn)行水平均等分割,再提取關(guān)聯(lián)條紋特征,從而全面利用位于條紋間的綜合信息;設(shè)計(jì)異構(gòu)特征提取模塊,以增加模型學(xué)習(xí)差異特征所需的結(jié)構(gòu)多樣性。

1 異構(gòu)分支關(guān)聯(lián)特征融合的行人重識別

1.1 網(wǎng)絡(luò)結(jié)構(gòu)

本文所提模型結(jié)構(gòu)如圖1 所示,包括3 個(gè)分支,分別為全局分支(v1)、條紋特征關(guān)聯(lián)分支(v2)和異構(gòu)特征提取分支(v3),圖中D表示特征向量的維數(shù)。骨架網(wǎng)絡(luò)選用的是OSNet[11],由5個(gè)卷積塊Convi組成,其中i=1,2,3,4,5。OSNet 是支持全尺度特征學(xué)習(xí)的輕量級網(wǎng)絡(luò),保證較高的特征提取效率,并且能夠有效地捕獲不同感受野范圍下的尺度特征。為了學(xué)習(xí)圖像中更值得關(guān)注的關(guān)鍵信息,在OSNet 的Conv2和Conv3層分別添加空間注意力模塊(spatial attention module,SAM)和通道注意力模塊(channel attention module,CAM)。全局分支由OSNet的Conv5組成,且僅使用全局最大值池化(global max pooling,GMP),GMP 可以促使網(wǎng)絡(luò)識別相對較弱的顯著特征,以保證全局分支與其他分支之間的功能多樣性。條紋特征關(guān)聯(lián)分支通過條紋特征關(guān)聯(lián)模塊將不同的條紋特征進(jìn)行關(guān)聯(lián)計(jì)算,以加強(qiáng)條紋間信息的相關(guān)性,進(jìn)而最優(yōu)地學(xué)習(xí)并整合局部特征信息。異構(gòu)特征提取分支將OSNet 的Conv5替換為網(wǎng)絡(luò)Res-Net50 的Conv2、Conv3和Conv4,以學(xué)習(xí)更具結(jié)構(gòu)多樣性的特征。共享卷積網(wǎng)絡(luò)輸出的特征圖經(jīng)過全局分支,獲得1 個(gè)512D 的特征向量g1;經(jīng)過條紋特征關(guān)聯(lián)分支和平均池化(average pooling,AP),獲得8個(gè)256D的關(guān)聯(lián)特征向量fi(i=1,2,…,8),再串聯(lián)為特征向量g2;經(jīng)過異構(gòu)特征提取分支和降維操作,獲得1個(gè)512D的特征向量g3。

訓(xùn)練階段,對3個(gè)特征向量gj(j=1,2,3)分別使用ID 預(yù)測損失函數(shù)、中心損失函數(shù)和三元組損失函數(shù)進(jìn)行監(jiān)督優(yōu)化。測試階段,將特征向量gj(j=1,2,3)串聯(lián)為特征描述符G,并使用特征描述符G進(jìn)行相似性判斷。

1.2 注意力模塊

在深度學(xué)習(xí)領(lǐng)域中,注意力機(jī)制的使用普遍且廣泛[12-15],類似于人類觀察物體時(shí)將視線聚焦于小部分重要區(qū)域,它可以幫助卷積神經(jīng)網(wǎng)絡(luò)(convolutional neural networks,CNN)將關(guān)注的重點(diǎn)放在目標(biāo)的細(xì)節(jié)信息并抑制無用信息,尋找對特征圖影響較大的區(qū)域,增強(qiáng)模型對重要局部區(qū)域的關(guān)注度[1],進(jìn)而使CNN 網(wǎng)絡(luò)對信息進(jìn)行快速篩選,從中總結(jié)出高價(jià)值信息,提高信息處理與提取的效率和準(zhǔn)確度。卷積網(wǎng)絡(luò)中低層網(wǎng)絡(luò)提取到的更多是圖像中的細(xì)節(jié)特征,如行人的邊緣輪廓特征,高層網(wǎng)絡(luò)提取的是全局的語義信息。由于低層特征圖對高層特征圖的生成至關(guān)重要,后者依賴于前者,只有低層網(wǎng)絡(luò)的卷積核提取到行人更多的邊緣特征,高層網(wǎng)絡(luò)才能將該行人進(jìn)行最佳的抽象映射。

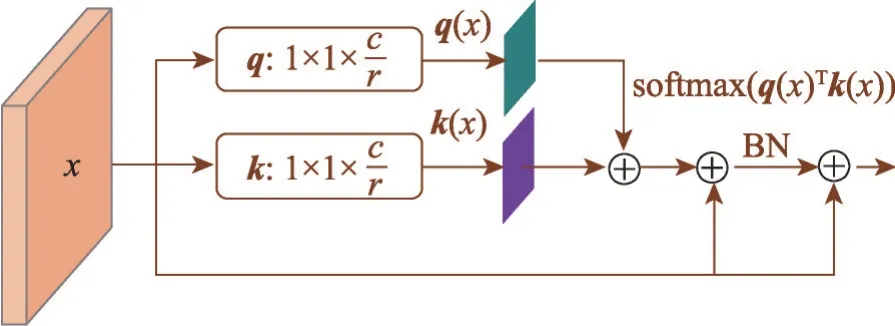

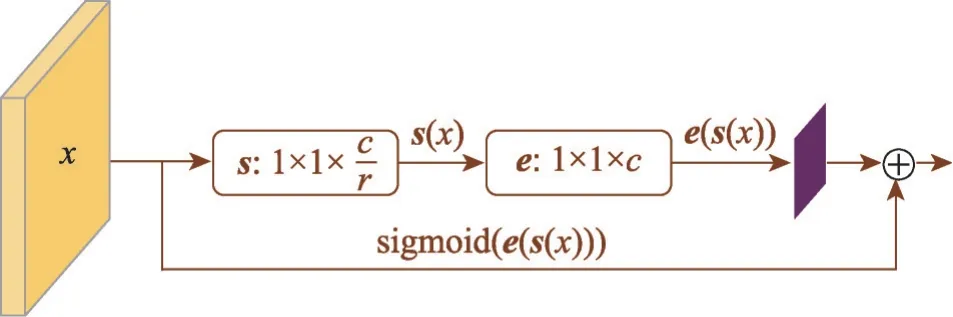

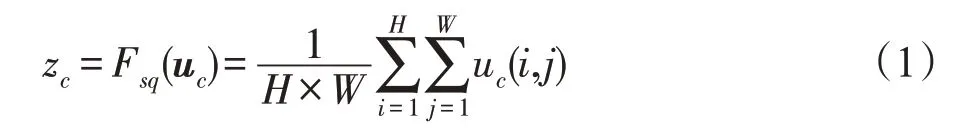

本文在骨架網(wǎng)絡(luò)OSNet中加入注意力模塊SAM和CAM。SAM 可以突出卷積網(wǎng)絡(luò)的有效部分并抑制像素級背景雜波的干擾,在空間域中捕獲并聚合語義相關(guān)的像素點(diǎn)。如圖2所示,為了降低計(jì)算復(fù)雜度,本文使用1×1 的卷積核,將輸入圖像的通道數(shù)由c減少至c/r。但單獨(dú)使用SAM 的模型會(huì)過度集中于圖像前景,而忽視低相關(guān)特征,因此加入CAM 模塊。CAM旨在將每個(gè)通道的權(quán)重壓縮到一個(gè)特征向量中[16],并將具有相同語義信息的通道進(jìn)行組合,最后與原始特征融合使模型能夠?qū)W習(xí)關(guān)鍵通道的特征,如圖3 所示。首先在式(1)中用全局平均池化對每個(gè)通道中的特征值相加后平均,以將每個(gè)通道的特征壓縮到一個(gè)1×1 的二維矩陣中,最終特征通道上所響應(yīng)的全局分布均由二維矩陣z表征。

圖2 SAM模塊Fig.2 Structure of SAM

圖3 CAM模塊Fig.3 Structure of CAM

式中,uc、zc分別表示輸入特征u和輸出特征z的第c個(gè)通道,H、W分別表示輸入特征u的高和寬。

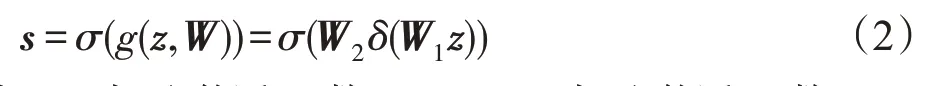

然后根據(jù)式(2),使用激活函數(shù)ReLU和Sigmoid激勵(lì)通道特征圖。特征圖先經(jīng)過兩層全連接層,之后利用激活函數(shù)強(qiáng)化通道特征的非線性響應(yīng),從而得到最終的通道注意力圖s。

式中,δ表示激活函數(shù)ReLU,σ表示激活函數(shù)Sigmoid,W1和W2分別為兩層全連接層的權(quán)重矩陣,s為輸出的特征注意力圖。

最后利用式(3)融合原始特征u與通道注意力圖s,從而重新分配原始特征圖中的各個(gè)通道的權(quán)重。

1.3 條紋特征關(guān)聯(lián)模塊

局部特征的使用降低了數(shù)據(jù)集中行人樣本復(fù)雜化的影響,且這些關(guān)鍵的局部特征更具代表性,更有助于網(wǎng)絡(luò)模型區(qū)分不同的行人。

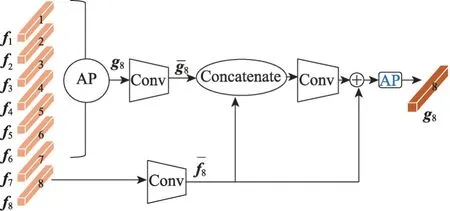

本文算法根據(jù)人體的結(jié)構(gòu)特征,將分支網(wǎng)絡(luò)v2輸出的特征圖進(jìn)行水平均等分割,由于分割后的條紋相互獨(dú)立,且每個(gè)條紋僅包含自身的信息,當(dāng)每個(gè)條紋不與其余條紋進(jìn)行通信時(shí),如果直接將這些局部特征單獨(dú)用于行人檢索,會(huì)混淆具有相似屬性的不同行人在相應(yīng)部位的區(qū)分度。因此提出條紋特征關(guān)聯(lián)模塊,該模塊解釋了行人身體各個(gè)部位與其他部位之間的關(guān)系,使每個(gè)條紋特征都包含了對應(yīng)部位本身和其他部位的綜合信息,從而更具鑒別力。如圖1所示,條紋特征關(guān)聯(lián)模塊接收來自所在網(wǎng)絡(luò)分支提取的特征圖,將最后一個(gè)卷積塊Conv5的輸出特征圖在豎直方向上水平分割為均等的8塊,通過條紋間的關(guān)聯(lián)計(jì)算依次將每個(gè)條紋與其他條紋進(jìn)行通信,從而獲得8 個(gè)關(guān)聯(lián)條紋特征向量,并將平均值池化(AP)作用在所得的關(guān)聯(lián)條紋特征上。

如圖4 所示,首先選中其中一個(gè)條紋特征向量fi(i=1,2,…,8),尺寸為1×1×C,將平均池化AP作用于其余7 個(gè)條紋特征向量fj(j≠i),以獲取包含其余條紋綜合信息的向量gl(l=j)。然后將1×1 的卷積層用于向量fi和gl,以減小通道數(shù)至c,并產(chǎn)生尺寸為1×1×c的向量。條紋特征關(guān)聯(lián)模塊連接特征,并且為每個(gè)fi輸出一個(gè)關(guān)聯(lián)特征向量qi。此時(shí)每個(gè)特征qi(i=1,2,…,8)均包含了行人的全部信息。關(guān)聯(lián)計(jì)算過程為:

圖4 條紋特征關(guān)聯(lián)模塊Fig.4 Stripe feature correlation module

其中,i=1,2,…,8 且j≠i,l≠i。Bp是一個(gè)子網(wǎng)絡(luò),包含1×1的卷積層、BN層和ReLU層;C表示特征的串聯(lián)。能夠使局部的條紋特征對遮擋與幾何變化更具辨別性和魯棒性。特征關(guān)聯(lián)模塊通過線性方式計(jì)算特征qi,計(jì)算成本低的同時(shí)保持了特征表示的緊湊性。

1.4 異構(gòu)特征提取模塊

在行人重識別任務(wù)中,結(jié)合全局特征和局部特征的多分支網(wǎng)絡(luò)可以同時(shí)關(guān)注行人的輪廓信息和細(xì)節(jié)信息,但目前很多網(wǎng)絡(luò)的不同分支使用的均是同構(gòu)特征,致使模型缺乏結(jié)構(gòu)多樣的差異特征。

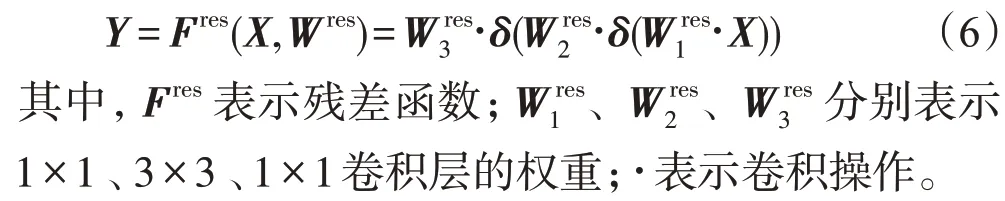

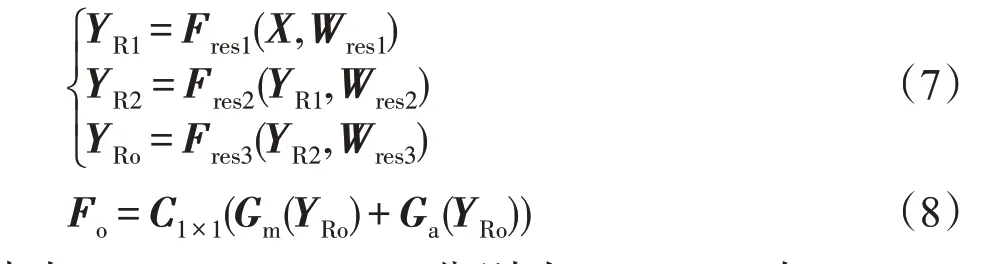

針對上述問題,本文通過增加異構(gòu)特征提取分支,增強(qiáng)網(wǎng)絡(luò)模型學(xué)習(xí)差異特征的能力,同時(shí)使其更具有判別力。具體為:異構(gòu)特征提取分支將OSNet的Conv5替換為ResNet50[17]的Conv2,3,4,如圖5(a)所示,ResNet50 的每個(gè)卷積塊Conv 均由不同數(shù)量的卷積和恒等連接的殘差塊構(gòu)成,殘差塊使用3 個(gè)卷積層(1×1,3×3,1×1)堆疊而成,其中兩個(gè)1×1 的卷積負(fù)責(zé)調(diào)整維數(shù),3×3 的卷積對圖像進(jìn)行下采樣。通過對殘差塊中卷積參數(shù)的設(shè)置,使殘差塊的輸入和輸出特征圖尺寸一致,從而進(jìn)行線性操作,保證將網(wǎng)絡(luò)深層的梯度值有效地傳遞至網(wǎng)絡(luò)淺層,以避免深度網(wǎng)絡(luò)的退化和梯度彌散問題。對于輸入張量X∈RH×W×C,經(jīng)殘差塊后對應(yīng)的輸出Y為:

圖5 異構(gòu)特征提取模塊Fig.5 Structure of heterogeneous feature extraction module

異構(gòu)特征提取分支v3的特征提取過程如圖5(b)所示,v3 分支接收來自O(shè)SNet 骨架網(wǎng)絡(luò)輸出的特征圖,并將其送入ResNet50 網(wǎng)絡(luò)的Conv2,3,4層,再經(jīng)過全局最大池化GMP 和全局平均池化(global average pooling,GAP)后得到一個(gè)2 048D的特征向量。為了提高計(jì)算效率,使用1×1 的卷積將得到的特征向量降維至512D。對于輸入張量X∈RH×W×C,經(jīng)v3 后對應(yīng)的輸出Fo為:

其中,F(xiàn)res1、Fres2、Fres3分別為ResNet50 中Conv2,3,4層的網(wǎng)絡(luò)表示;Wres1、Wres2、Wres3分別為每層網(wǎng)絡(luò)對應(yīng)的權(quán)重;YR1、YR2、YRo分別為ResNet50中Conv2,3,4層的輸出;Gm表示全局最大值池化GMP;Ga表示全局平均值池化GAP;C1×1表示1×1卷積操作。

1.5 損失函數(shù)

聯(lián)合多種損失函數(shù),可以幫助網(wǎng)絡(luò)模型學(xué)習(xí)到區(qū)分度更高、魯棒性更強(qiáng)的行人特征。在訓(xùn)練階段,組合三種不同的損失函數(shù),包括ID 預(yù)測損失(softmax loss)、中心損失(center loss)[18]以及三元組損失(triplet loss)[19]。通過最小化組合后的損失函數(shù)來優(yōu)化網(wǎng)絡(luò)模型,總損失函數(shù)為:

其中,Ls-id為單一ID損失,α、β分別是中心損失和三元組損失所占的權(quán)重。

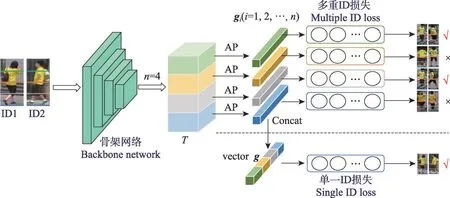

在基于特征空間分割的行人重識別研究中,大多數(shù)方法采用多重ID 損失函數(shù)對行人身份進(jìn)行預(yù)測。如圖6 所示,輸入的行人圖像通過骨架網(wǎng)絡(luò)進(jìn)行特征提取得到張量T,在特征空間中T被均勻劃分為n條水平條紋,再經(jīng)過平均值池化和降維等操作生成n個(gè)特征向量gi(i=1,2,…,n),最后使用n個(gè)分類器以產(chǎn)生n個(gè)ID 預(yù)測損失值。多重?fù)p失函數(shù)Lm-id為:

通過多重ID損失函數(shù)來監(jiān)督每個(gè)條紋特征向量gi(i=1,2,…,n),模型可以將局部區(qū)域的特征學(xué)習(xí)到最優(yōu)以區(qū)分不同的人。然而如圖6所示,許多條紋特征可能無法捕捉到不同行人的具有明顯區(qū)分性的信息,因此降低對行人整體的預(yù)測準(zhǔn)確率。

圖6 單一ID損失與多重ID損失Fig.6 Single ID loss vs multiple ID loss

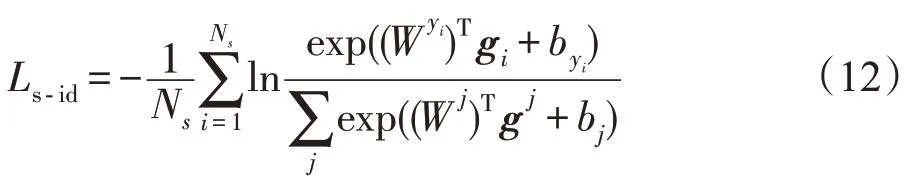

為了更高效地利用模型學(xué)習(xí)到的局部顯著性區(qū)域的判別特征,本文將n個(gè)條紋特征向量串聯(lián)成一個(gè)列向量g用于產(chǎn)生單一的ID 預(yù)測損失值。單一ID損失函數(shù)Ls-id為:

其中,W是特征向量g對應(yīng)分類器的權(quán)重矩陣,Wj和是權(quán)重矩陣W的第j列和第yi列,Ns為樣本數(shù)目。

由于向量g包含輸入圖像中行人的完整信息,使用單一ID損失函數(shù)可以驅(qū)動(dòng)g學(xué)習(xí)并整合局部顯著性區(qū)域中足夠多的判別信息。

2 實(shí)驗(yàn)結(jié)果與分析

2.1 實(shí)驗(yàn)配置與數(shù)據(jù)集

本文采用Pytorch-1.0.1 深度學(xué)習(xí)框架,Ubuntu 16.04 操作系統(tǒng),編程語言為Python3.6。硬件采用顯卡內(nèi)存為8 GB的NVIDIA GTX 1070 GPU,CUDA版本為10.1。實(shí)驗(yàn)階段,將所提算法在Market-1501[20]和DukeMTMC-reID[21]數(shù)據(jù)集上進(jìn)行實(shí)驗(yàn)驗(yàn)證,并將其與目前較新的幾種行人重識別算法進(jìn)行比較。

Market1501[20]數(shù)據(jù)集分為訓(xùn)練集和測試集兩部分。訓(xùn)練集包括12 963 張圖像對應(yīng)751 個(gè)行人。測試集包括3 368 張查詢圖像和19 732 張圖庫圖像共對應(yīng)750 個(gè)行人。DukeMTMC-reID[21]數(shù)據(jù)集同樣分為訓(xùn)練集和測試集兩部分。訓(xùn)練集包括16 522張圖像對應(yīng)702個(gè)行人。測試集包括2 228張查詢圖像和17 661張圖庫圖像共對應(yīng)702個(gè)行人。

訓(xùn)練階段,輸入圖像的分辨率大小調(diào)整為256×128,batchsize選擇為64,包括16個(gè)不同行人且每人4張圖像。通過隨機(jī)水平翻轉(zhuǎn)、隨機(jī)擦除和歸一化策略進(jìn)行數(shù)據(jù)增強(qiáng)。骨架網(wǎng)絡(luò)OSNet通過ImageNet數(shù)據(jù)集預(yù)先訓(xùn)練的模型參數(shù)進(jìn)行初始化。max_epoch(訓(xùn)練總輪數(shù))設(shè)置為150。使用Adam 優(yōu)化本文模型,基礎(chǔ)學(xué)習(xí)速率初始化為3.5E-5。使用warmup策略預(yù)熱學(xué)習(xí)率激活網(wǎng)絡(luò)[22],初始學(xué)習(xí)率為0.000 3,為了保持損失的穩(wěn)定下降,分別在epoch=60 和epoch=90 兩個(gè)階段設(shè)置學(xué)習(xí)率衰減點(diǎn)以實(shí)現(xiàn)指數(shù)衰減,衰減系數(shù)為gamma=0.1。

2.2 多分支聯(lián)合學(xué)習(xí)實(shí)驗(yàn)結(jié)果

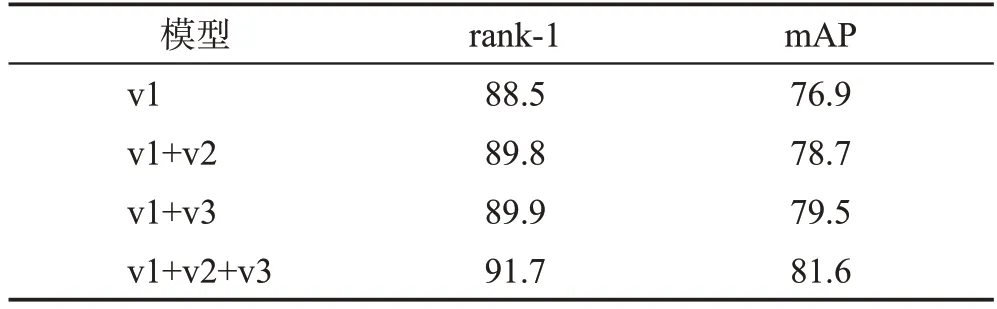

為了測試多分支聯(lián)合學(xué)習(xí)的有效性,本文分別在Market-1501 數(shù)據(jù)集和DukeMTMC-reID 數(shù)據(jù)集上進(jìn)行了實(shí)驗(yàn)驗(yàn)證,結(jié)果分別如表1和表2所示。

表1 Market-1501數(shù)據(jù)集上不同分支的實(shí)驗(yàn)結(jié)果Table 1 Experimental results with different branches on Market-1501 dataset 單位:%

表2 DukeMTMC-reID數(shù)據(jù)集上不同分支的實(shí)驗(yàn)結(jié)果Table 2 Experimental results with different branches on DukeMTMC-reID dataset 單位:%

對于Market-1501 數(shù)據(jù)集,對比兩分支聯(lián)合學(xué)習(xí)的模型,三分支聯(lián)合學(xué)習(xí)模型的rank-1精度分別提高2.3個(gè)百分點(diǎn)和1.1個(gè)百分點(diǎn),mAP分別提高了1.8個(gè)百分點(diǎn)和0.6 個(gè)百分點(diǎn)。其中,兩分支(v1+v2)聯(lián)合學(xué)習(xí)的模型在加入異構(gòu)特征提取模塊后,模型的rank-1 精度提高了2.3 個(gè)百分點(diǎn),mAP 提高了1.8 個(gè)百分點(diǎn)。本文所提三分支模型相對全局單分支模型在rank-1精度上提升了3.3個(gè)百分點(diǎn),在mAP上提升了3.6個(gè)百分點(diǎn)。

對于DukeMTMC-reID數(shù)據(jù)集,本文所提三分支模型對比兩分支聯(lián)合學(xué)習(xí)的模型,rank-1精度分別提升了1.9 個(gè)百分點(diǎn)和1.8 個(gè)百分點(diǎn),mAP 分別提升了2.9 個(gè)百分點(diǎn)和2.1 個(gè)百分點(diǎn)。其中,兩分支(v1+v2)聯(lián)合學(xué)習(xí)的模型在加入異構(gòu)特征提取模塊后,模型的rank-1 精度提高了1.9 個(gè)百分點(diǎn),mAP 提高了2.9個(gè)百分點(diǎn)。相對全局單分支在rank-1 精度上提升了3.2個(gè)百分點(diǎn),在mAP上提升了4.7個(gè)百分點(diǎn)。

結(jié)果表明,多分支聯(lián)合學(xué)習(xí)可以使模型學(xué)習(xí)到魯棒性更強(qiáng)的特征,異構(gòu)特征提取模塊對于提取更加多樣化的特征效果明顯。

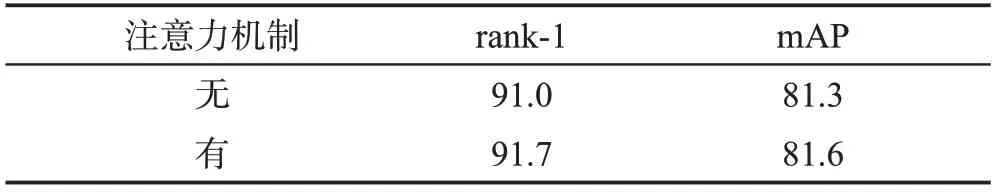

2.3 注意力機(jī)制的影響

本文將主流的注意力模塊添加到共享卷積網(wǎng)絡(luò)中,以使模型更專注于顯著性較強(qiáng)的特征,實(shí)驗(yàn)結(jié)果如表3和表4所示。從表中數(shù)據(jù)可以得出,注意力模塊對模型性能的提升做出了貢獻(xiàn),在Market-1501 數(shù)據(jù)集上rank-1精度提高了0.6個(gè)百分點(diǎn),mAP提高了0.5個(gè)百分點(diǎn);在DukeMTMC-reID數(shù)據(jù)集上rank-1精度提高了0.7個(gè)百分點(diǎn),mAP提高了0.3個(gè)百分點(diǎn)。

表3 Market-1501數(shù)據(jù)集上注意力機(jī)制的實(shí)驗(yàn)結(jié)果Table 3 Experimental results of attention modules on Market-1501 dataset 單位:%

表4 DukeMTMC-reID數(shù)據(jù)集上注意力機(jī)制的實(shí)驗(yàn)結(jié)果Table 4 Experimental results of attention modules on DukeMTMC-reID dataset 單位:%

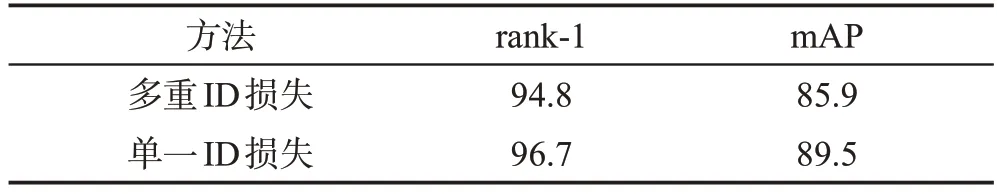

2.4 不同種類ID損失函數(shù)下的實(shí)驗(yàn)結(jié)果

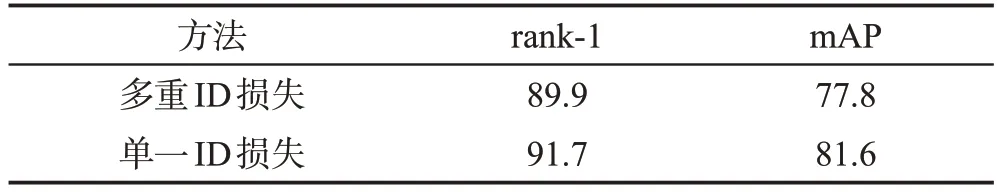

與PCB(part-based Conv baseline)[2]及其變體采用多重ID 損失不同的是,本文通過將多個(gè)關(guān)聯(lián)條紋特征向量串聯(lián)為一個(gè)新的特征向量,并用單一ID 損失函數(shù)進(jìn)行監(jiān)督優(yōu)化。多重ID損失的利用使模型中ID 損失的數(shù)量等于分割條紋的數(shù)量,好處在于可能迫使每個(gè)條紋特征向量使用帶有身份標(biāo)簽的數(shù)據(jù)集在每個(gè)指定的局部區(qū)域?qū)W習(xí)特征,但缺點(diǎn)在于某些條紋特征向量可能無法產(chǎn)生可靠的ID預(yù)測。

以Market-1501數(shù)據(jù)集上三分支聯(lián)合學(xué)習(xí)模型為例,如表5所示,單一ID損失下的模型相比多重ID損失下的模型在rank-1 精度上提升了1.9 個(gè)百分點(diǎn),在mAP 上提升了3.6 個(gè)百分點(diǎn)。同理在DukeMTMCreID數(shù)據(jù)集上,如表6所示,單一ID損失下的模型相比多重ID 損失下的模型在rank-1 精度上提升了1.8個(gè)百分點(diǎn),在mAP上提升了3.8個(gè)百分點(diǎn)。實(shí)驗(yàn)結(jié)果表明,單一ID損失函數(shù)在本文所提模型中的表現(xiàn)更好。

表5 Market-1501數(shù)據(jù)集上不同損失函數(shù)實(shí)驗(yàn)結(jié)果Table 5 Experimental results with different losses on Market-1501 dataset 單位:%

表6 DukeMTMC-reID數(shù)據(jù)集上不同損失函數(shù)實(shí)驗(yàn)結(jié)果Table 6 Experimental results with different losses on DukeMTMC-reID dataset 單位:%

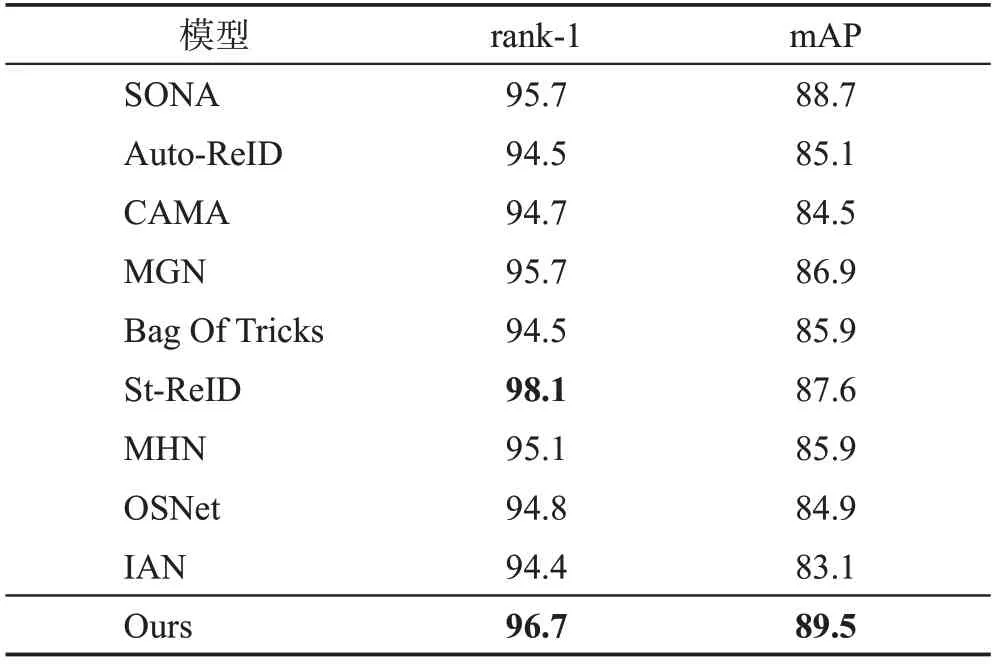

2.5 與現(xiàn)有方法的比較

表7和表8所示為本文網(wǎng)絡(luò)模型與其他一些網(wǎng)絡(luò)模型的性能比較,包括MGN[3]、OSNet[11]、SONA(secondorder non-local attention networks)[23]、Auto-ReID[24]、Bag Of Tricks[25]、St-ReID(spatial temporal ReID)[26]、MHN(mixed high-order attention network)[27]、CAMA(class activation maps augmentation network)[28]和IAN(interaction and aggregation network)[29]。所有結(jié)果中St-ReID 模型表現(xiàn)最好,但是該算法需要獲取行人圖像的時(shí)間和空間信息,而行人數(shù)據(jù)集包含的時(shí)空信息量巨大,訓(xùn)練過程占用較多的資源且花費(fèi)時(shí)間較長,使得計(jì)算效率較低。本文方法在兩個(gè)公開數(shù)據(jù)集上展示了較強(qiáng)的魯棒性和判別力。在Market-1501數(shù)據(jù)集上得到的rank-1 精度和mAP 分別為96.7%和89.5%;在DukeMTMC-reID 數(shù)據(jù)集上得到的rank-1精度和mAP分別為91.7%和81.6%,顯著優(yōu)于其他方法。結(jié)果表明,本文構(gòu)建的模型不僅繼承了OSNet的輕量級特性,而且顯著提升了重識別的精度。圖7展示了本文方法在Market-1501測試集上的部分測試結(jié)果,并與OSNet 模型的測試結(jié)果進(jìn)行了比較,實(shí)驗(yàn)結(jié)果表明本文模型具有較好的特征映射性能。

表7 在Market-1501數(shù)據(jù)集上與主流算法的比較Table 7 Comparison with mainstream algorithms on Market-1501 dataset 單位:%

表8 在DukeMTMC-reID數(shù)據(jù)集上與主流算法的比較Table 8 Comparison with mainstream algorithms on DukeMTMC-reID dataset 單位:%

3 結(jié)束語

本文提出了一種基于異構(gòu)分支關(guān)聯(lián)特征融合的行人重識別算法。使用條紋特征關(guān)聯(lián)模塊,綜合了位于條紋間的關(guān)聯(lián)信息;加入異構(gòu)特征提取分支,增加了網(wǎng)絡(luò)模型學(xué)習(xí)差異特征所需的結(jié)構(gòu)多樣性;結(jié)合注意力機(jī)制,使網(wǎng)絡(luò)模型學(xué)習(xí)顯著性和區(qū)分性更強(qiáng)的行人關(guān)鍵特征;采用單一ID 損失函數(shù)對條紋特征關(guān)聯(lián)模塊進(jìn)行監(jiān)督,避免特征的錯(cuò)誤學(xué)習(xí),并提高預(yù)測的可靠性。本文將該算法分別在Market-1501和DukeMTMC-reID 數(shù)據(jù)集上進(jìn)行有效性實(shí)驗(yàn)驗(yàn)證。實(shí)驗(yàn)結(jié)果表明,該算法能夠有效提高行人重識別的準(zhǔn)確度。

實(shí)驗(yàn)過程中,全局分支對整幅圖像提取特征時(shí)會(huì)受到復(fù)雜背景的影響以及前景遮擋的干擾。在今后的研究過程中,將考慮結(jié)合人體骨骼姿態(tài)圖以進(jìn)一步提升模型的行人重識別能力。