基于改進YOLOv5s的列車車廂客流密度檢測方法研究

張 馨,董承梁,汪曉臣,田 源

(1.中國鐵道科學研究院集團有限公司 電子計算技術研究所,北京 100081;2.北京京港地鐵有限公司 運營工程部,北京 100068)

北京、上海等城市地鐵日客流量均突破千萬人次,大規(guī)模的客流沖擊給城市軌道交通(簡稱:城軌)運營帶來諸多安全風險。實時準確地檢測車廂客流能為及時調(diào)整行車調(diào)度計劃、引導站廳內(nèi)客流等提供數(shù)據(jù)支撐。

傳統(tǒng)的列車車廂客流密度檢測多采用物理傳感器檢測方式,包括壓力傳感器、紅外檢測裝置、熱敏傳感器等[1]。其中,壓力傳感器將經(jīng)過的乘客重力轉換為電信號來統(tǒng)計客流,由于乘客重量不一,這種檢測方式準確性較差;紅外和熱敏檢測裝置分別通過紅外熱成像和熱輻射轉化原理檢測客流密度,但在客流密度較大、乘客相互重疊的情況下,兩種設備的檢測精度均受到影響。近年來,隨著各類圖像數(shù)據(jù)庫的建立和圖形處理器(GPU,Graphics Processing Unit)的快速發(fā)展,深度學習技術得到了廣泛的研究和應用,基于深度學習的方法也被應用于客流密度檢測中[2]。例如,基于城軌列車車載閉路電視監(jiān)控(CCTV,Closed-Circuit Television)系統(tǒng)實現(xiàn)對車廂的實時監(jiān)控,再通過深度學習模型對列車車廂客流進行精準檢測。

Sun等人[3]提出了一種基于YOLOv3(You Only Look Once v3)增強模型的人流密度估計方法,分別用頭部集和身體集訓練得到兩個模型,在推理時將這兩個模型的輸出結果進行融合,但該方法增加了計算成本、延長了推理時間;S.Ren等人[4]提出了Faster RCNN模型,能夠通過訓練好的模型實時檢測圖像中目標框的數(shù)量,進行人群計數(shù),但在高度遮擋場景中,該方法準確度較差;Liu等人[5]在Faster RCNN的基礎上進行改進,提出了一種檢測和回歸相結合的人群計數(shù)模型DecideNet,該方法準確度有所提升,但依然存在兩階段檢測模型計算量大、內(nèi)存需求高,難以應用于嵌入式設備的問題。

目前,在各種深度學習目標檢測模型中,YOLOv5因其模型輕量、容易部署、推理速度快而廣泛用于各類實時性要求較強的應用中[1]。其中,YOLOv5s更適用于客流密度檢測這一準確性和實時性的要求均較高的應用。針對城軌列車車廂場景中存在的人群密集、乘客間相互遮擋等問題,本文提出了一種基于改進YOLOv5s模型的列車車廂客流密度檢測方法,有效提高了檢測精度和效率。

1 基于YOLOv5s的客流密度檢測模型

1.1 YOLOv5概述

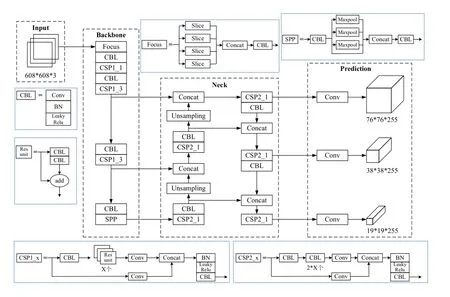

YOLOv5網(wǎng)絡結構分為輸入(Input)、主干(BackBone)、瓶頸(Neck)及輸出(Prediction)4部分:輸入端采用了Mosaic數(shù)據(jù)增強、自適應錨框及自適應圖片縮放3種方法,用于增強模型對小目標的檢測效果并提高推理速度;BackBone網(wǎng)絡中采用了Focus和跨階段局部網(wǎng)絡(CSPNet,Cross Stage Partial Network)結構;Neck網(wǎng)絡中采用了特征金字塔網(wǎng)絡(FPN,F(xiàn)eature Pyramid Network)+路徑聚合網(wǎng)絡(PAN,Path Aggregation Network)結構;在輸出部分,采用了復雜交并比(CIoU,Complete Intersection over Union)作為邊界框的(Bounding box)損失函數(shù)及非極大值抑制(NMS,Non-Maximum Suppression)方法。根據(jù)網(wǎng)絡深度和寬度的不同,YOLOv5分 為YOLOv5s、YOLOv5m、YOLOv5l、YOLOV5x 共4種,其中,YOLOv5s的網(wǎng)絡寬度和深度最小,參數(shù)量僅有7.2 M、因此速度最快,更適用于本文的客流密度檢測應用。YOLOv5s網(wǎng)絡結構,如圖1所示,輸入圖像為經(jīng)數(shù)據(jù)增強及自適應縮放等操作后得到的608×608×3的圖像,定義BackBone中Focus結構使用32個卷積核,設計了兩種CSPNet架構CSP1_X和CSP2_X,分別應用于BackBone和Neck中。

圖1 YOLOv5s網(wǎng)絡架構

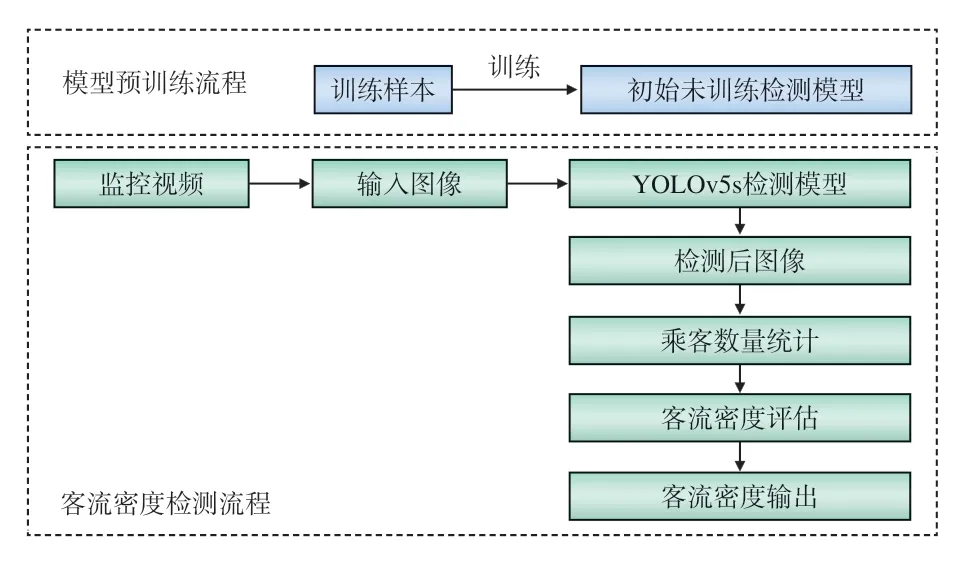

1.2 模型建立

圖2 模型建立流程

2 模型改進

2.1 特征融合網(wǎng)絡改進

在Neck網(wǎng)絡中,YOLOv5s采用的是FPN+PAN結構,如圖3所示,自頂向下傳遞深層的強語義特征,再通過自底向上的路徑增強方式,將淺層的強定位特征傳上去,縮短了信息路徑。但FPN+PAN結構中,存在只有一條輸入邊的節(jié)點未進行特征融合的情況,因此,在特征融合網(wǎng)絡中相較于其他的節(jié)點其貢獻較小。為降低計算成本且融合更多特征,文獻[6]提出了一種加權的雙向特征金字塔網(wǎng)絡(BiFPN ),去掉兩個只有一條輸入邊的節(jié)點,并添加了一條連接原始輸入節(jié)點及其同水平輸出節(jié)點的額外的邊,如圖4所示。

圖3 FPN+PAN結構示意

圖4 BiFPN結構示意

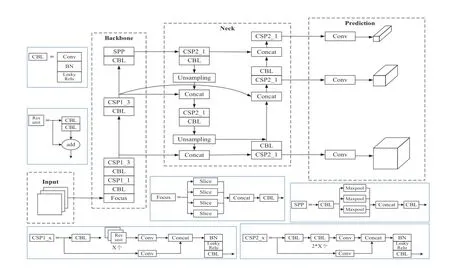

為更有效地融合不同層級的特征,提高檢測精度,本文使用BiFPN結構代替YOLOv5s原本的FPN+PAN結構實現(xiàn)特征融合功能,改進后的YOLOv5s網(wǎng)絡結構如圖5所示。

圖5 改進后的YOLOv5s網(wǎng)絡結構

2.2 損失函數(shù)改進

在計算候選框損失函數(shù)的回歸損失部分時,YOLOv5s采用了CIoU,以重疊面積、中心點距離及長寬比3項因素作為評估標準,對候選框進行全面評估。但在城軌列車車廂場景中,客流量大時人群密集大、乘客間遮擋情況嚴重,各目標間距離較近且重合度較高,僅依靠CIoU計算回歸損失可能會導致不準確的定位。

本文受文獻[7]啟發(fā),定義了一種損失函數(shù)計算方式,來解決檢測目標相互遮擋的問題,忽略預測框與其他非最佳匹配的真實框之間的關系,只期望在距離和面積兩方面預測框和對應真實框盡可能地重合,本文定義的損失函數(shù)計算公式為

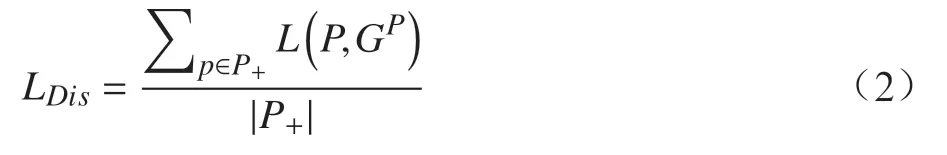

其中,LDis為預測框與其最匹配的真實框間的距離損失;LGIoU為預測框與其最匹配的真實框間的重疊面積損失。

距離損失LDis的計算公式為

“‘活力老人’是目前日間托管機構的主要群體,但對家庭、社會來說,更需要解決的可能是對失能、半失能老人的照護,但在這些業(yè)務的開展上,社區(qū)養(yǎng)老中心每走一步,都像摸著石頭過河,困難很多。”張振美說。

式中,各預測框與其最匹配的真實框間距離L的計算采用歐式距離;P為預測框;P+為所有預測框P的集合;|P+|為集合P+中預測框的數(shù)量;GP為與P最匹配的真實框,即在所有真實框的集合G+中,與P的IoU值最大的真實框,。

重疊面積損失LGIoU采用GIoU作為評估標準,其計算公式為

式中,C為預測框P與真實框GP最小的矩形封閉對象;IoU為預測框P與真實框GP的交并比值,。

2.3 NMS方法改進

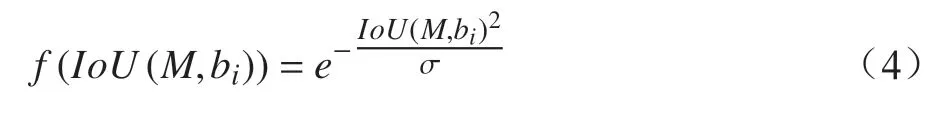

YOLOv5s在消除冗余框時,采用了NMS方法,但在車廂客流密度檢測這類密集目標檢測的應用中,正確的預測框很可能因與得分最高的預測框重疊面積較大而被錯誤地刪除,且檢測效果受閾值大小影響,不恰當?shù)拈撝翟O置可能會導致檢測效果較差。針對NMS存在的上述問題,文獻[8]提出了一種Soft-NMS方法,不直接刪除預測框,而是根據(jù)與得分最高預測框的IoU值調(diào)整原本的得分。

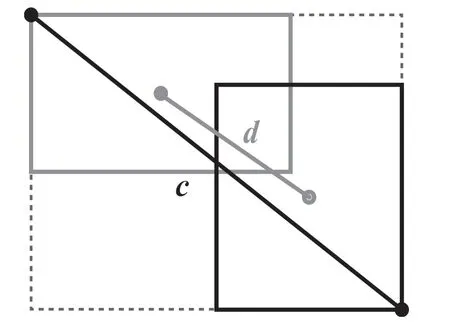

然而,當預測框與最高得分預測框相距較遠且IoU值較低時,盲目降低預測框的得分值并不合理;當相距較近且IoU值較高時,Soft-NMS不能直接令與最高得分預測框完全重疊的預測框得分降為零,可能導致重疊框剔除不完全的情況。針對上述問題,本文提出了一種結合NMS和Soft-NMS的冗余框消除方法D-NMS,根據(jù)距離,選擇其中一種方法重新計算預測框得分,具體流程如圖6所示。

圖6 D-NMS算法流程

其中,當前預測框bi與最高得分預測框M的距離dis(M,bi)=d/c,d、c的定義如圖7所示,圖7中灰色框與黑色框分別表示當前預測框與得分最高的預測框,d為兩框中心點距離,c為兩框最小外接矩形對角線長度;f(IoU(M,bi))為Soft-NMS采用的高斯懲罰函數(shù),其計算公式為

圖7 預測框間距離示意

3 實驗及結果分析

3.1 實驗數(shù)據(jù)集

本文采用CVC05-PartOcclusion行人檢測數(shù)據(jù)集與自制地鐵車廂乘客數(shù)據(jù)集進行實驗,來驗證本文改進的YOLOv5s方法的有效性。

CVC05-PartOcclusion行人檢測數(shù)據(jù)集來自CVC行人檢測數(shù)據(jù)庫,是一個部分被遮擋的行人數(shù)據(jù)集。按7∶3劃分訓練集和測試集,訓練集共包含415張圖像,測試集包含178張圖像。

自制數(shù)據(jù)集為采集的地鐵車廂圖像,對圖像中乘客頭部進行標注后得到包含不同客流密度情況的圖像,共185張。按7∶3的比例劃分訓練集和測試集,訓練集包含130張圖像,測試集包含55張圖像。

3.2 數(shù)據(jù)處理

為滿足YOLOv5s模型檢測格式,數(shù)據(jù)集中每條標注數(shù)據(jù)的內(nèi)容應依次為標注物類別數(shù)字代號、標注框中心點橫坐標、標注框中心點縱坐標、標注框?qū)挾取俗⒖蚋叨龋覙俗⒖蛑行狞c坐標值、標注框?qū)挾戎导案叨戎稻鶠榻?jīng)歸一化處理后的值。因此,需對數(shù)據(jù)集的標注數(shù)據(jù)進行歸一化處理。

CVC05-PartOcclusion行人檢測數(shù)據(jù)集的官方標注數(shù)據(jù)格式為標注物類別名稱、標注框左上角橫坐標、標注框左上角縱坐標、標注框?qū)挾取俗⒖蚋叨龋渲校瑯俗⒖蜃笊辖亲鴺酥怠挾戎导案叨戎稻韵袼貫閱挝弧P鑼俗?shù)據(jù)進行如下處理:(1)將標注物類別名稱替換為對應的數(shù)字代號;(2)根據(jù)標注框左上角坐標及標注框?qū)捀哂嬎銟俗⒖蛑行狞c的坐標值,并用中心點坐標替換左上角坐標;(3)將坐標值及寬高值進行歸一化處理。

自制數(shù)據(jù)集采用LabelImg標注工具,選擇YOLO標簽格式進行標注,得到符合YOLOv5s模型檢測格式要求的標注數(shù)據(jù)。

3.3 評價指標

本文共采用F1-Score、AP50及AP50:5:95共3個評價指標來評估算法的性能。

(1) F1-Score

F1-Score為精準率P和召回率R的調(diào)和平均,綜合考慮了這兩個指標,F(xiàn)1-Score值越大,模型質(zhì)量越高。其計算公式為。

(2) AP50

平均精度(AP,Average Precision)值通過計算PR曲線,即將召回率R設置為橫軸,精準率P設置為縱軸所構成的曲線的面積得到,AP值越大,模型越能同時保持較高的準確率和召回率。AP50為IoU閾值設置為50%時的平均檢測精度,是針對單一類別的精度。AP50值越大,模型質(zhì)量越高。

(3) AP5:5:95

AP50:5:95為IoU閾值取值從50%到95%,步長為5%時,所有AP的均值。該指標能夠綜合衡量不同IoU閾值下模型的性能,AP50:5:95值越大,模型質(zhì)量越高。

3.4 實驗結果分析

分別應用原YOLOv5s模型與改進后的YOLOv5s模型在CVC05-PartOcclusion行人檢測數(shù)據(jù)集及自制地鐵車廂乘客數(shù)據(jù)集上進行訓練。實驗運行環(huán)境為:CPU為Intel i7-1065G7,GPU為NVIDIA GeForce MX350,內(nèi)存為10 G,操作系統(tǒng)為Windows10,開發(fā)語言為Python,使用了Pytorch深度學習框架,具有支持動態(tài)修改的優(yōu)勢。

應用經(jīng)訓練得到的兩種模型對測試樣本進行測試,得到的檢測結果對比如圖8、圖9所示,其中,圖8(a)和圖9(a)為應用原YOLOv5s模型的檢測結 果;圖8(b)和 圖9(b)為 應 用 改 進 的YOLOv5s模型的檢測結果;圖8(c)和圖9(c)為檢測前圖像;圖8(d)和圖9(d)為改進后模型檢測時識別到的原模型未識別到的檢測目標。

圖8 CVC05-PartOcclusion行人檢測數(shù)據(jù)集測試結果對比

圖9 自制地鐵車廂乘客數(shù)據(jù)集測試結果對比

綜上,應用改進后的YOLOv5s模型進行檢測的結果能識別出部分原YOLOv5s模型無法識別出的被遮擋的目標,檢測結果更為準確,更適用于城軌列車車廂這類人群密集、遮擋嚴重的環(huán)境。

為驗證本文提出的改進后的YOLOv5模型與原YOLOv5模型相比性能有無提高,依據(jù)F1-Score、AP50、AP50:5:95這3項評價指標對比兩種模型的檢測性能,結果如表1和表2所示。

表1 改進模型與原模型在CVC05數(shù)據(jù)集上的檢測性能對比

表2 改進模型與原模型在自制數(shù)據(jù)集上的檢測性能對比

由表1、表2可知,在CVC05數(shù)據(jù)集上,改進后的模型較原模型F1-Score指標提高了0.5%,AP50指標提高了2.8%,AP50:5:95指標提高了4.7%;在自制數(shù)據(jù)集上,改進后的模型較原模型F1-Score指標提高了0.5%,AP50指標提高了0.9%,AP50:5:95指標提高了6.3%。因此本文提出的改進模型能有效提高檢測精度,性能更好。

4 結束語

本文提出了一種基于深度學習的車廂客流密度檢測方法,采用了改進的YOLOv5s模型對車載CCTV系統(tǒng)監(jiān)控進行實時檢測,在列車車廂人群密集、遮擋嚴重的情況下,能更準確地識別車廂中的乘客目標。本文對特征融合網(wǎng)絡結構進行優(yōu)化,以融合更多特征;重新定義了損失函數(shù),以在遮擋情景中更可靠地評估檢測結果;為避免客流密度較大時將真實目標框誤刪除,對消除冗余框的NMS方法進行了改進。最后,在CVC05數(shù)據(jù)集及自制數(shù)據(jù)集上進行了對比實驗,實驗結果表明,本文改進的YOLOv5s

模型能有效解決遮擋問題,檢測精度較改進前明顯提高,證明了本文方法的有效性,可應用于城軌列車車廂客流檢測技術領域。