基于全局和局部特征的跨模態行人再識別方法

袁瑞超,胡曉光,2,楊世欣

(1中國人民公安大學 信息網絡安全學院,北京 102600;2中國人民公安大學 偵查學院,北京 102623)

0 引 言

當前行人再識別方法主要是基于可見光圖像和視頻的行人再識別方法,著重解決可見光條件下目標人物的背景、光照、姿態等問題。然而,如果目標人物白天活動較少,夜間活動較多,僅依靠采集的可見光圖像對目標人物再識別,難以應對目前犯罪嫌疑人晝伏夜出的問題。較為發達的城市除了大范圍安裝彩色(RGB)攝像機外,同時還會安裝紅外(IR)攝像機,不僅在白天可以采集到RGB圖像,還會在夜晚采集到IR圖像。因此,基于RGB和IR圖像的跨模態行人再識別技術對于目標人物軌跡特征的捕捉非常重要。

在ILSVRC12的比賽中,Krizhevsky等人設計了識別精度較高的大型卷積神經網絡,贏得了比賽勝利。自此,以卷積神經網絡為代表的深度學習方法開始流行。應用在行人再識別領域的深度學習方法的特點是通過各種卷積神經網絡獲得豐富的行人特征,設計各種各樣的損失函數來訓練網絡。Zhang等人提出了端到端的局部特征聯合(Aligned)方法,采用難采樣三元組損失監督訓練,達到再識別目的。Park等人提出了相關關系網絡模型,將三元組損失和交叉熵損失聯合,作為最終的損失函數,多階段對網絡監督訓練。Hermans等人改進傳統的三元組損失函數,在行人類間差距大于類內距離的基礎上,使類內距離要小于某個設定閾值,來對網絡模型監督訓練,獲得了更好的識別效果。張濤等人提出了基于全局特征的三元組損失改進方法,在傳統三元組損失的基礎上引入類內距離,增大類間距離的同時,縮小類內距離,該模型達到了較好的識別效果。

近年來,基于RGB-IR圖像的跨模態行人再識別方法成為了廣泛關注點,用RGB和IR攝像機拍攝的行人圖像,對網絡進行訓練,提高同一行人RGB和IR圖像的匹配準確率。目前廣泛使用的方法有2種。一種是圖像生成方法,多采用生成對抗網絡,將混合RGB和IR的多模態圖像統一轉換為單一模態的RGB或IR圖像;另一種是神經網絡學習分類的方法,對行人的RGB和IR圖像同時進行特征提取,獲得具有鑒別力的特征,使用合理的損失函數對網絡進行監督訓練。對此擬展開闡釋分述如下。

(1)采用圖像生成的方法。Dai等人采用GAN網絡,從RGB和IR圖像數據集中學習出具有判別力的特征,用判別器進行判斷,最終提高判別器的識別能力。Wang等人提出了像級子網絡,將RGB圖像轉換為IR圖像,一定程度上擴充了數據集,在此基礎上訓練帶有特征嵌入的子網絡,從而減小模態差異,達到再識別目的。Wang等人利用GAN網絡將RGB圖像轉換為IR圖像,對真實的IR圖像和虛假的IR圖像進行判別驗證,達到再識別目的。

(2)采用神經網絡學習分類的方法。趙立昌等人提出了灰度能量差異性的紅外圖像與可見光圖像融合方法,突出了目標信息和對比度。Wu等人提出了基于深度零填充的方法,采集了RGB-IR圖像數據集SUSU-MM01,解決了再識別的研究問題。Ye等人提 出 了 雙 向 中 心 約 束 的top-ranking(eBDTR)算法,使用了一對網絡來分別提取RGB和IR圖像特征,并采用SoftMax損失和雙向約束排序損失(Bi-directional ranking loss),對網絡進行監督訓練。杜鵬等人提出自注意力模態融合的方法,利用Cycle GAN生成跨模態圖像,使用自注意力模塊區分原始圖像和生成圖像,使用模態融合模塊融合特征,使用SoftMax損失監督訓練,達到再識別目的。

本文提出了基于全局和局部特征的方法。首先,采用Cycle GAN網絡對數據集進行轉換和擴充,降低行人體態變化帶來的影響;在ResNet50網絡的基礎上,設計全局特征對比模塊和局部特征模塊,降低圖像噪聲帶來的影響和行人圖像的遮擋問題帶來的影響;最后,將交叉熵損失和改進的三元組損失以比例加和的形式作為多損失聯合函數,對網絡進行監督訓練。采用RGB圖像和IR圖像混合、RGB圖像轉換為IR圖像、IR圖像轉換為RGB圖像三種實驗思路,做了相關實驗。

1 相關理論介紹

1.1 Cycle GAN網絡原理

GAN網絡通過構造生成器和判別器,使2種不同風格的圖像相互學習,相互博弈,不斷地提高其生成能力和鑒別能力,最終將一種風格的圖像生成另外一種風格的圖像,其生成效果非常逼真。雖然GAN網絡的變體模型較多,Cycle GAN網絡采用卷積和反卷積策略,不要求以成對的方式輸入圖像,生成圖像的質量較好,故本文采用Cycle GAN網絡實現RGB圖像和IR圖像之間的轉換和擴充。

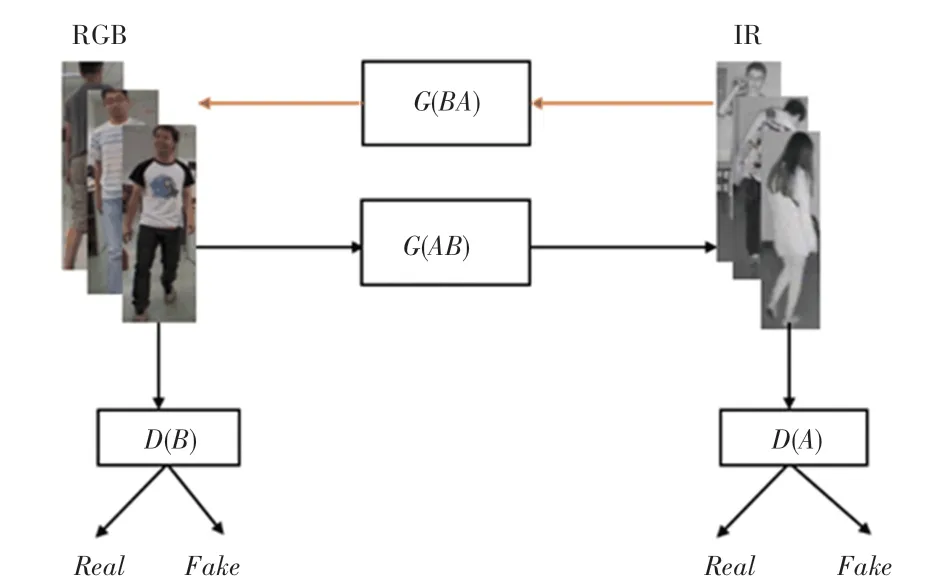

Cycle GAN網絡實現RGB圖像和IR圖像轉換和擴充的原理是:RGB圖像經過生成器(),生成IR圖像,和原有的IR圖像經過判別器(),如原有的IR圖像被判別為真(),生成的IR圖像被判別為假(),Fake-IR圖像再一次經過生成器()生成Cycle-RGB圖像,Cycle-RGB圖像和原始的RGB圖像幾乎一致;同理可知,IR圖像也會轉換為Fake-RGB圖像和Cycle-IR圖像。Fake-RGB圖像和Fake-IR圖像幾乎可以以假亂真。Cycle GAN的對RGB圖像和IR圖像的轉換和擴充示意如圖1所示。

圖1 Cycle GAN網絡對RGB圖像和IR圖像轉換和擴充的示意圖Fig.1 Schematic diagram of the conversion and augmentation of RGB images and IR images by Cycle GAN network

1.2 全局特征對比模塊和局部特征模塊

使用Cycle GAN網絡擴充數據集后,采用雙線性插值算法,將圖像分辨率統一為高384像素,寬128像素。使用擴充后的數據集訓練ResNet50網絡,得到大小為的整體特征圖,將整體特征圖輸入全局特征對比模塊,并將整體特征圖在的層面上沿著劃分出6個相等局部特征區域,獲得局部特征圖,將局部特征圖輸入局部特征模塊,如圖2所示。

圖2 圖像通過ResNet50網絡后輸入全局特征對比模塊和局部特征模塊的示意圖Fig.2 The flow chart of global feature comparison module and local feature module after the image passes through the ResNet50 network

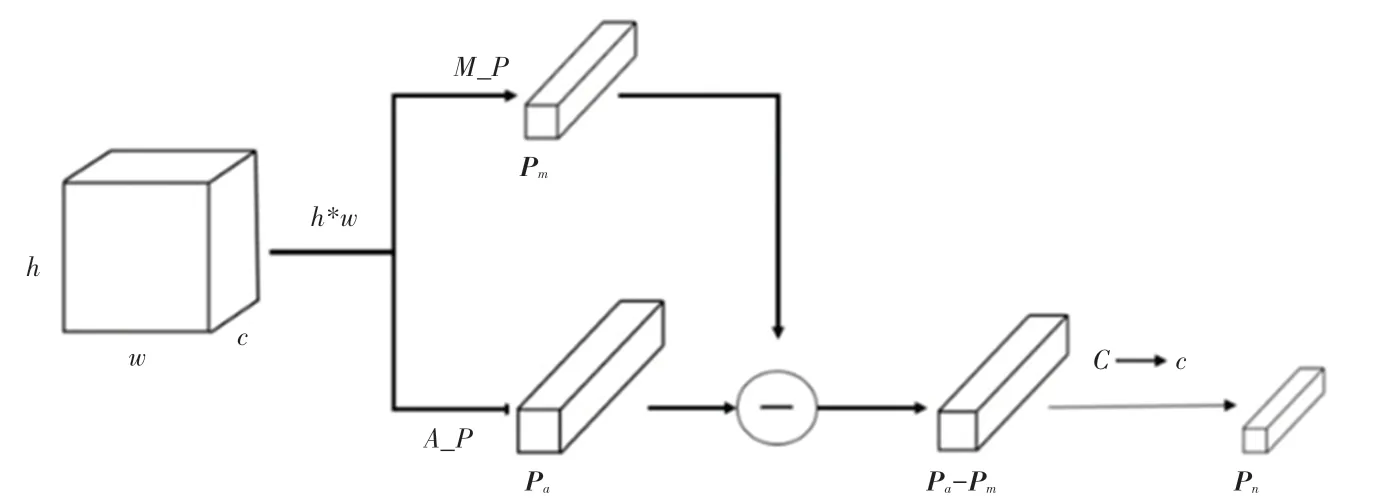

全局特征對比模塊的原理:擴充后的數據集通過ResNet50網絡后得到特征圖,將其作為整體,分別進行全局最大池化和全局平均池化,得到通道數為的特征向量P和P;采取P-P方法,使用11的卷積核進行卷積,批處理歸一化,函數激活,得到P;最終將特征圖的通道降低。全局特征對比模塊的原理示意如圖3所示。圖3中,,,分別表示特征圖的高、寬、通道數,_、_分別表示平均池化和最大池化。

圖3 全局特征對比模塊原理示意圖Fig.3 Schematic diagram of the principle of global feature comparison module

噪聲在數字圖像中體現為白點,卷積運算的原理是點乘、相加,噪聲同樣參與卷積運算,其影響同樣存在于特征圖和特征向量當中。平均池化和最大池化過程中圖像噪聲影響示意如圖4所示。研究假設圖像經過2個不同的卷積核的卷積運算形成和,假設的、有噪聲的成分,且在數值上大于、,經過最大池化(Max Pooling)所形成的特征值也包含噪聲成分;平均池化(Average Pooling)不同于最大池化,是將的所有值加和平均,含有噪聲的、參與了平均池化運算,形成的特征值也會有噪聲成分。將這2個同時含有噪聲成分的特征值和相減,在一定程度上能夠降低噪聲。因此,全局特征對比模塊中,P-P的方法在一定程度上能夠降低圖像噪聲帶來的影響。

圖4 平均池化和最大池化過程中圖像噪聲影響的示意圖Fig.4 Schematic illustration of the effect of images noise during Average Pooling and Max Pooling

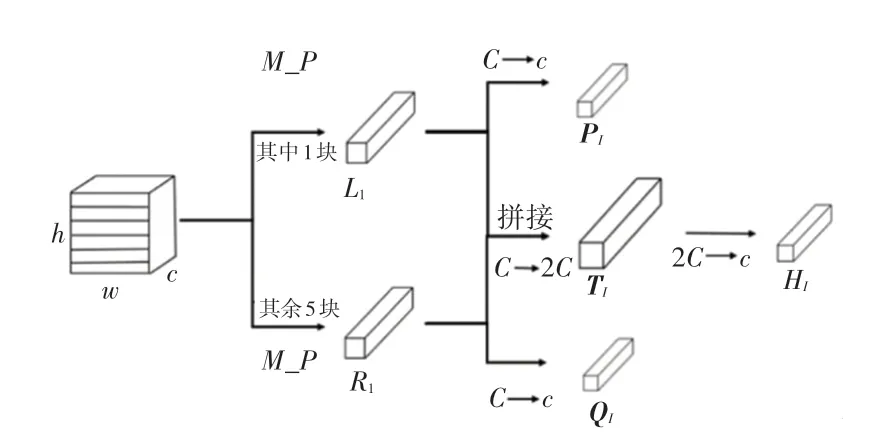

局部特征模塊如圖5所示,這里將整體特征圖在層面上沿著方向劃分為6個大小相等的區域,選擇其中一個區域全局最大池化,得到特征向量L;其余的5個區域按順序組合,形成另外一部分特征圖,將這一部分特征圖全局最大池化,得到特征向量R。一方面將L和R分別使用11的卷積核進行卷積、批處理歸一化和函數激活操作,得到P和Q;另一方面將L和R拼接,得到特征向量T,對T使用11的卷積核卷積、批處理歸一化和函數激活操作,得到H。由于將特征圖劃分為6個區域,每次選擇其中的一個區域,其余的5個區域順序組合,這樣選擇局部特征的方式共有6種,即P,Q,T分別有6種,記P={,,,,,},Q={,,,,,},T={,,,,,}。

圖5 局部特征模塊示意圖Fig.5 Schematic diagram of global feature comparison module

由于將特征圖均勻分割為6份,選取其中的一份進行運算得到P。假設行人圖像的腿腳區域被遮擋,而P是頭部區域運算得到的,這樣通過運算得到的P就降低了遮擋帶來的影響,局部特征模塊在一定程度上能夠降低遮擋對識別模型的影響。

1.3 多損失聯合

交叉熵損失經常用于行人再識別中的多分類問題。傳統的三元組損失在于尋找原始樣本、正樣本、負樣本,通過網絡不斷學習,使原始樣本和正樣本之間距離不斷地縮小,和負樣本之間的距離盡可能地增大。難采樣的三元組損失對其改進,所選擇的正樣本和原始樣本之間的距離盡可能遠,負樣本和原始樣本之間距離盡可能近。本文參考難采樣三元組損失,對三元組損失進行修改:假設所選擇的原始樣本是行人的RGB圖像,正樣本選取同一行人的IR圖像,正樣本的背景與行人的動作姿態和原始樣本的差異盡可能大;負樣本選取不同行人的RGB圖像,且和原始樣本的RGB圖像在背景和行人姿態方面盡可能相似。改進的三元組損失如圖6所示。圖6中,A表示原始樣本的RGB圖像,N表示和原始樣本的RGB圖像盡可能相似的負樣本圖像,P表示和原始樣本RGB圖像之間的距離盡可能遠的正樣本IR圖像;反之,若原始樣本選取為IR圖像,其正樣本和負樣本的選取策略相似。

圖6 改進三元組損失示意圖Fig.6 Schematic diagram of improving triple loss

將交叉熵損失和改進三元組損失以比例加和的形式作為多損失聯合函數,對此可表示為:

其中,L表示交叉熵損失;L表示改進的三元組損失;參數取正整數。

2 基于全局和局部特征的跨模態行人再識別方法的設計

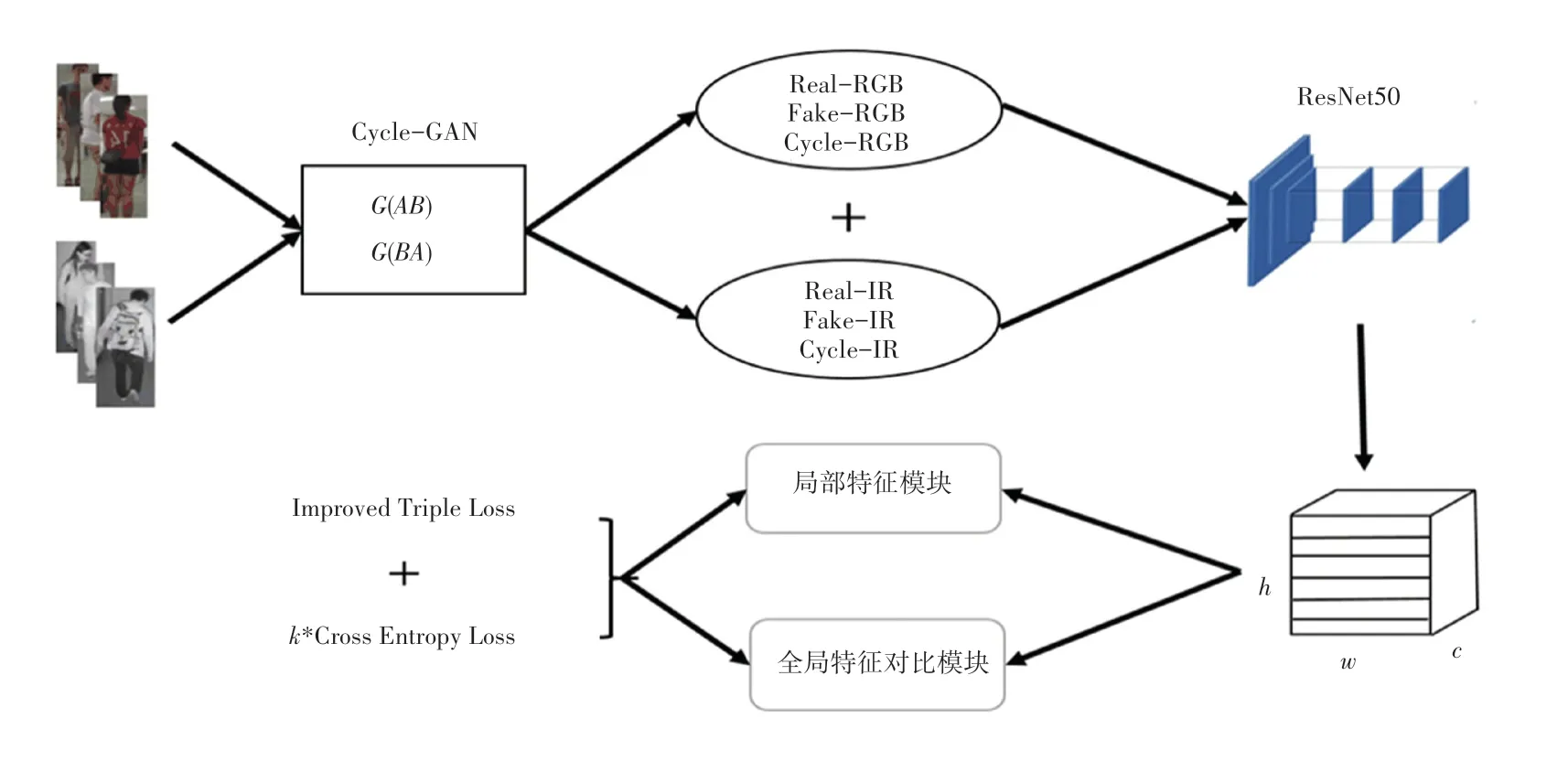

根據以上原理,本文設計了基于全局和局部特征的跨模態行人再識別的網絡結構,如圖7所示。由圖7可知,首先利用數據集訓練Cycle GAN網絡,分別將所有的RGB圖像轉換為IR圖像,所有的IR圖像轉換為RGB圖像。將同一行人生成的圖像和原始的圖像視作擁有同樣的行人身份,對圖像進行鏡像、裁剪、顏色變換操作,以進一步擴充數據集。接著使用擴充后的數據集訓練ResNet50網絡,得到整體特征圖,一方面將整體特征圖輸入全局特征對比模塊;另一方面將整體特征圖輸入局部特征模塊。最后,使用多損失聯合函數對網絡進行監督訓練。

圖7 基于全局和局部特征的跨模態行人再識別方法的網絡結構圖Fig.7 Network architecture diagram of cross-modal pedestrians re-identification method based on global and local features

Cycle GAN網絡實現RGB圖像和IR圖像之間的轉換和擴充后,將同一行人生成的圖像和原始的圖像視作擁有相同的行人身份,并進行鏡像、裁剪、顏色變換操作,以進一步擴充數據集。將所有圖像的分辨率統一調整為128×384,將生成的圖像和原始的圖像一同輸入到ResNet50網絡中進行訓練,得到通道數為2 048的整體特征圖。一方面,將整體特征圖輸入全局特征對比模塊,在得到通道數為2 048的特征向量P和P后,采取P-P方法,使用256個1×1的卷積核進行卷積,批處理歸一化,函數激活,得到P,最終將特征圖的通道降低到256;另一方面,將整體特征圖輸入局部特征模塊,在得到通道數為2048的特征向量L和R后,使用256個1×1的卷積核進行卷積、批處理歸一化和函數激活操作,得到P和Q,將特征圖的通道數降低到256;將L和R拼接,得到T,對T使用256個1×1的卷積核進行卷積、批處理歸一化和函數激活操作,得到H,將特征圖的通道數降低到256;最后,使用多損失聯合函數對網絡監督訓練,其中參數取正整數。

3 實驗仿真

本文實驗均在PyTorch框架下運行。設定為64;設定為200;初始學習率設定為0001,從第50個開始進行衰減,衰減系數為01;多損失聯合函數的參數取正整數。

評估指標選擇常見的累計匹配特性(CMC)曲線的1、10、20和平均準確率均值()。指標越高,表示模型的識別效果越好。

3.1 數據集

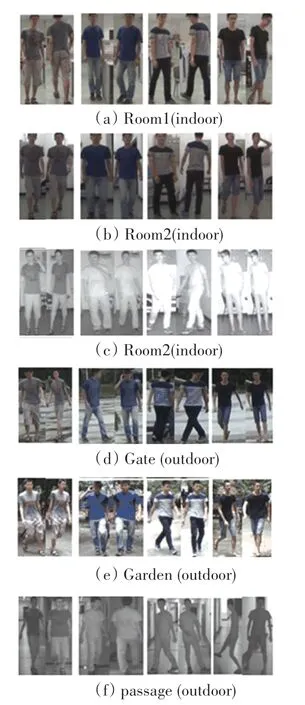

(1)數據集SYSU-MM01。分為室內模式和室外模式,共包含287 628張RGB圖像,15 792張IR圖像,共計491個行人。本文實驗選取其中的395個行人的圖像用于訓練和驗證,剩余的96個行人的圖像用于測試,并對其多次劃分,減小模型訓練結果的誤差,部分圖像示例如圖8所示。

圖8 數據集SYSU-MM01部分圖像示例圖Fig.8 Example images of part of SYSU-MM01 dataset

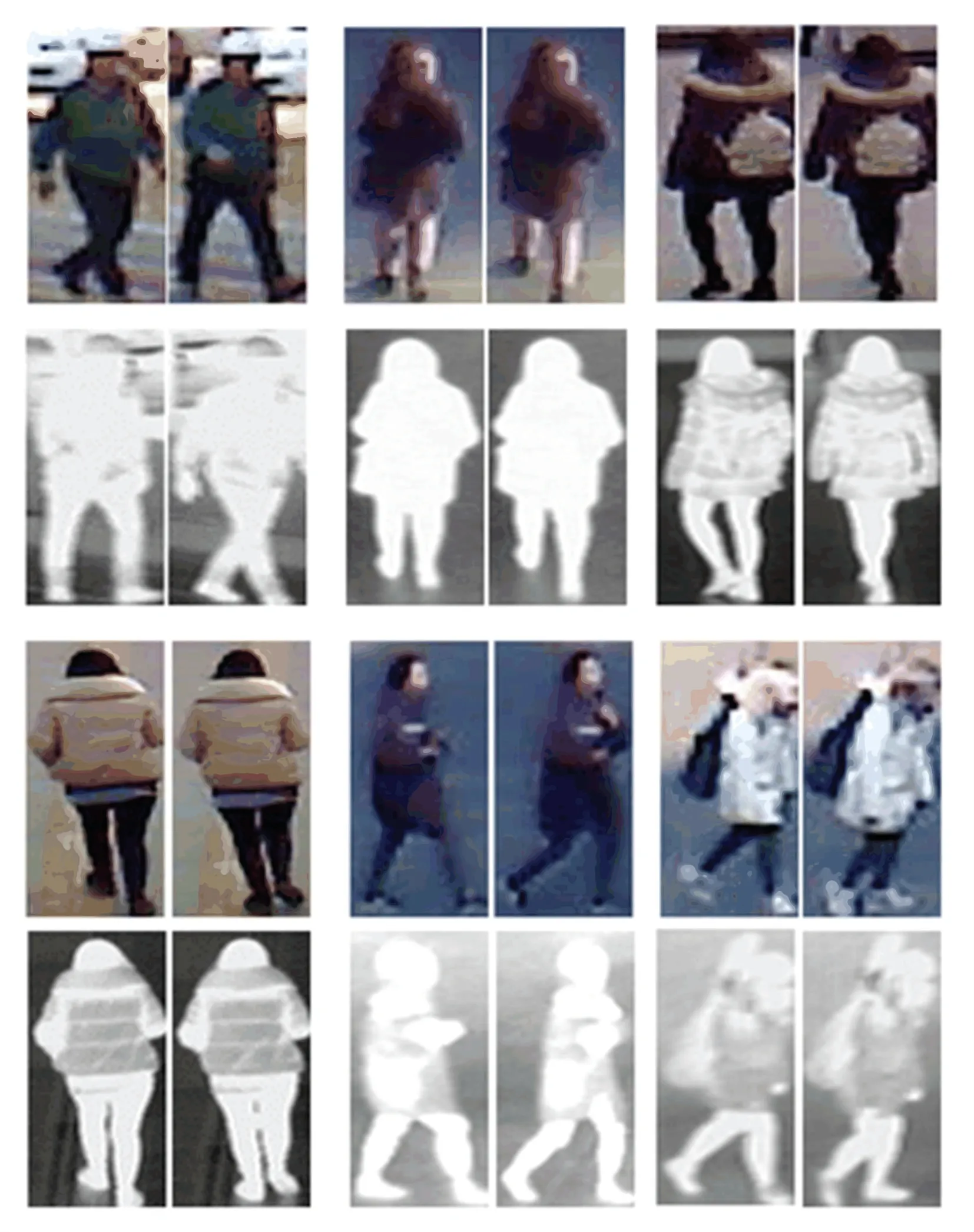

(2)數據集RegDB。包含8 240張行人圖像,412個行人,每個行人10張RGB圖像、10張IR圖像。本文實驗對數據集多次劃分,一半用于訓練和驗證,另一半用于測試,減小模型訓練結果的誤差,部分示例圖像如圖9所示。

圖9 數據集RegDB的部分圖像示例圖Fig.9 Example images of part of RegDB dataset

3.2 實驗結果與分析

3.2.1 Cycle GAN網絡對不同模態圖像的轉換結果以Cycle GAN網絡訓練RegDB數據集為例,損失曲線如圖10所示。圖10中,_的曲線表示判別器()的損失;_的曲線表示生成器()的損失;_的曲線表示圖像經過生成器()生成圖像后,由再經過生成器()生成的圖像,和原始的圖像相比較的損失;_的曲線表示判別器()的損失;_的曲線表示生成器()的損失;_的曲線表示圖像經過生成器()生成圖像,由圖像經過生成器()生成的圖像,和原始的圖像相比較的損失;_的曲線表示將圖像輸入生成器()生成的圖像和原始的圖像相比較的損失,主要用于判斷生成器()對輸入的圖像能否判斷為其自身;_的曲線表示將圖像輸入生成器()生成的圖像和原始的圖形相比較的損失,主要用于判斷生成器()對輸入的圖像能否判斷為其自身。

圖10 Cycle GAN訓練RegDB數據集損失曲線圖Fig.10 Loss curve of Cycle GAN training RegDB dataset

在選取生成器對數據集轉換之前,綜合考慮每一組模型的各個損失,使其盡可能小。本次實驗選取為75的一組模型,其中,判別器()的損失為0232;生成器()的損失為0418;圖像經過生成器()生成圖像后,由再經過生成器()生成的圖像,和原始的圖像相比較的損失為0540;圖像輸入生成器()生成的圖像和原始圖像相比較的損失為0123;判別器()的損失為0248,生成器()的損失為0256;圖像經過生成器()生成圖像,由圖像經過生成器()生成的圖像,和原始的圖像相比較的損失為0229;圖像輸入生成器()生成的圖像和原始的圖像相比較的損失為0217。

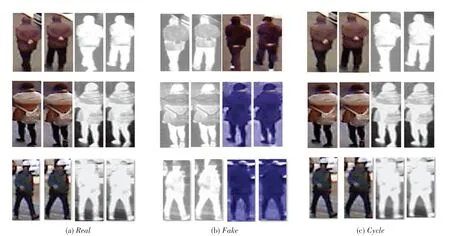

數據集RegDB經過Cycle GAN網絡轉換后的部分圖像示意如圖11所示。圖11中,第一行人物圖像的圖像相比于圖像,輪廓和動作更加清晰,圖像、圖像與原始的圖像幾乎沒有大的變化;第二行人物圖像的圖像相比圖像,衣著和背包顯得更加清晰,圖像、圖像與原始圖像幾乎一致;第三行人物圖像的圖像相比于圖像,輪廓更為清晰。圖像轉換為圖像,在圖像背景、人物衣著等有所變化,肢體動作等幾乎保持原樣,這類情況可以看作同一行人穿著不同顏色的衣服,在不同的光照條件下被攝像頭捕捉到。因此,數據集通過Cycle GAN網絡的轉換和擴充,一方面增加了圖像的數據量,另一方面增加了圖像的輪廓等細節,這有助于降低跨模態行人再識別中行人的姿態變化帶來的影響。

圖11 數據集RegDB經過Cycle GAN網絡轉換后的部分圖像示意圖Fig.11 Schematic diagram of some images of RegDB dataset transformed by the Cycle GAN

3.2.2 在SYSU-MM01數據集上的識別結果與分析

在數據集SYSU-MM01上識別測試有單擊和多擊兩種模式。其中,單擊模式選取所有的IR圖像作為,并隨機選取對應行人的一張RGB圖像組成;在多擊模式中,的選取和單擊模式一致,是每個行人選取10張對應的RGB圖像。室內場景下環境條件較為理想,圖像質量較高;室外場景下行人圖像的光照變化較大,存在遮擋現象,再識別難度較大。相比之下,單擊模式更有實際意義,本次測試不論在室內模式、還是全搜索模式均采用單擊模式。因該數據集存在部分行人缺失RGB圖像或者IR圖像的現象,因此研究中采用RGB圖像和IR圖像混合的方式進行實驗。本文方法(ALL)的識別精度和其他方法的對比見表1。

表1 在SYSU-MM01數據集上單擊模式的識別精度和其他方法對比Tab.1 Comparison of the recognition accuracy between single-click patterns and other methods on SYSU-MM01 dataset %

在全搜索場景下的單擊模式,本文方法利用Cycle GAN網絡對數據集SYSU-MM01擴充和轉換,將生成的RGB圖像、IR圖像和原始的圖像一同輸入到ResNet50網絡中進行訓練;將特征圖分別輸入到全局特征對比模塊和局部特征模塊,使用參數為2的多損失聯合函數進行監督訓練,模型效果達到最好。本文方法(ALL)和Align GAN方法相比1指標提高了1.4%,10指標提高了1.34%;和HPILN方法相比20指標提高了1.12%,值提高了2.18%。在SYSU-MM01數據集上測試時部分圖像的識別結果如圖12所示。

圖12 在SYSU-MM01數據集上測試時部分圖像的識別結果圖Fig.12 Recognition results of some images when tested on SYSUMM01 dataset

3.2.3 在RegDB數據集上的識別結果與分析

在數據集RegDB上測試時,測試集中所有的IR圖像組成,所有對應的RGB圖像組成,識別精度和其他方法的對比見表2。

由表2可知,本文方法(ALL)使用參數為3的多損失聯合函數進行監督訓練,模型精度最高。本文方法(ALL)的10指標達到了8903,比MACE方法提高了0.63%,值達到69.26%,比DFE方法提高了0.12%。

表2 在RegDB數據集上的識別精度和其他方法的對比Tab.2 Comparison of recognition accuracy with other methods on RegDB dataset %

本文方法(IR)和本文方法(RGB)是分別利用Cycle GAN網絡將數據集RegDB的RGB圖像轉換為IR圖像、IR圖像轉換為RGB圖像,將原始的圖像和轉換后的圖像一同輸入到ResNet50網絡中訓練,將特征圖分別輸入到全局特征對比模塊和局部特征模塊,并使用參數為2的多損失聯合函數監督訓練,模型識別效果較好。指標分別達到了65.28%和62.96%,1指標分別達到67.16%和66.67%,10指標分別達到了86.47%和81.67%,接近MACE、DFE方法,20指標分別達到91.06%和90.23%,與本文方法(ALL)較為接近。

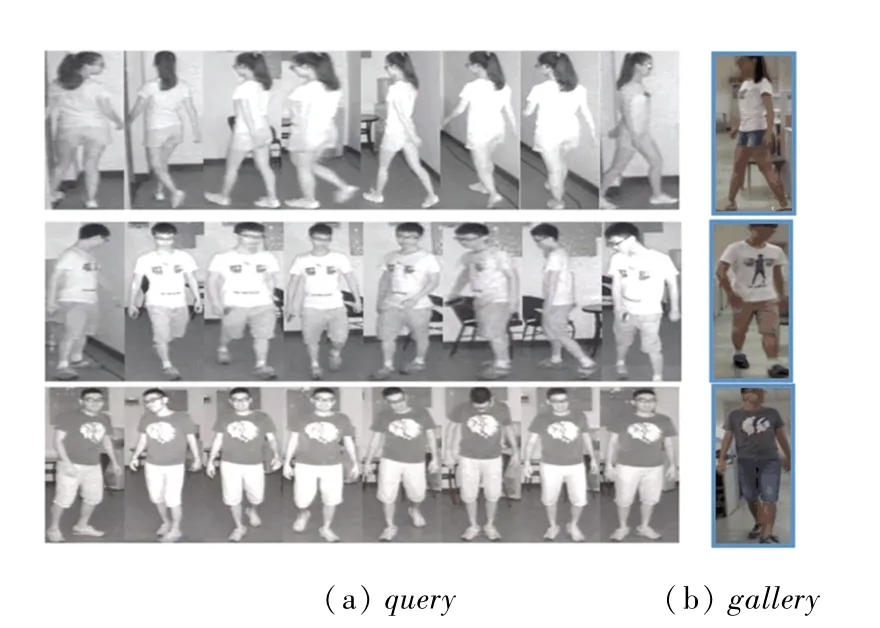

在RegDB數據集上測試時部分圖像的識別結果如圖13所示。圖13中,圖13(b)中的藍色框部分的圖像表示識別正確的圖像,紅色框部分的圖像表示識別錯誤的圖像。從識別錯誤的圖像看出,識別錯誤的RGB圖像在輪廓和姿勢等方面都比較接近IR圖像。

圖13 在RegDB數據集上測試時部分圖像的識別結果圖Fig.13 Plot of recognition results for some images when tested on RegDB dataset

3.2.4 在RegDB數據集上的消融實驗結果與分析

數據集RegDB的圖像分布比較均勻,沒有極低質量的圖像,每個行人的圖像之間較為相似,姿態變化較小。因此,在數據集RegDB進行消融實驗,識別精度和其他方法對比見表3。

表3 在RegDB數據集上消融實驗的結果Tab.3 Results of ablation experiments on RegDB dataset %

在消融實驗當中,使用原始數據集RegDB訓練ResNet50網絡得到特征圖,將特征圖輸入全局特征對比模塊和局部特征模塊,采用參數為3的多損失聯合函數進行監督訓練,與單獨使用ResNet50網絡,采用參數為3的多損失聯合函數進行監督訓練的方法相比,、1、10和20指標都有大幅度的提高,證明了全局特征對比模塊和局部特征模塊有助于提高模型的精度。

使用原始數據集RegDB訓練ResNet50網絡得到特征圖,將特征圖輸入全局特征對比模塊和局部特征模塊,采用參數為3的多損失聯合函數進行監督訓練。和使用單個的交叉熵損失或改進的三元組損失監督訓練的方法相比較,1指標分別從4732、5141提高到6453;10指標分別從6531、7552提高到8243;20指標分別從7510、8420提高到8793;值則分別從4923、5033提高到6362,證明了本文的參數為3的多損失聯合函數有助于提高模型的精度。

本文方法(IR)和本文方法(RGB)是使用Cycle GAN網絡將數據集分別轉換為IR圖像和RGB圖像,輸入到ResNet50網絡得到特征圖,將特征圖輸入全局特征對比模塊和局部特征模塊,采用參數為2的多損失聯合函數進行監督訓練,和不使用Cycle GAN網絡對數據集轉換的方法相比較,1指標從5321分別提高到6673和6723;10指標從7283分別提高到8163和8642;20指 標從8204分 別提高 到9020和9103,接近本文方法(ALL)的9262;值從5233分別提高到6292和6524,證明本文使用Cycle GAN網絡將RegDB數據集統一轉換為RGB圖像或IR圖像的方法同樣對模型的識別精度有一定程度的提高。

本文方法(ALL)和不使用Cycle GAN網絡對數據集擴充和轉換的方法相比較,1指標從6453提高到7422;10指標從8243提高到8903;20指標從8793提高到9262,指標從6362提高到6924,證明了采用Cycle GAN網絡擴充和轉換的數據集,對于網絡模型的識別精度有較大程度的提高,同時也驗證了本文方法(ALL)的有效性。

4 結束語

本文提出了基于全局和局部特征的跨模態行人重識別方法。使用Cycle GAN網絡對數據集擴充和轉換,來降低同一行人的RGB-IR圖像的姿態變化帶來的影響;全局特征對比模塊和局部特征模塊分別降低圖像噪聲和行人遮擋現象帶來的影響;將改進的三元組損失和交叉熵損失以比例加和的形式作為多損失聯合函數,進行監督訓練;探索多損失聯合函數參數取不同的值,對模型精度的影響;分別采取RGB圖像和IR圖像聯合實驗、RGB圖像轉換為IR圖像實驗、IR圖像轉為RGB圖像實驗。在當前的SYSU-MM01、RegDB數據集上與當前多數方法相比,識別準確率有一定程度的提升。通過消融實驗論證了Cycle GAN網絡不論是數據集的擴充,還是將其統一轉換為RGB圖像或IR圖像,對于網絡模型的識別精度都有一定程度的提升。但是,Cycle GAN網絡在IR圖像轉換為RGB圖像時,轉換的圖像有一定的失真,噪聲也較大;單流網絡架構對于RGB-IR圖像的跨模態行人再識別存在一定的局限性。因此,生成對抗網絡對于RGB-IR圖像數據集的擴充和轉換、圖像噪聲的抑制、更好的網絡模型及損失函數的探索可能是未來RGB-IR圖像跨模態行人再識別研究的熱點。