基于深度自編碼的醫療命名實體識別模型

侯旭東,滕飛,張藝

(西南交通大學計算機與人工智能學院,成都 611756)

0 引言

醫療信息化的蓬勃發展帶來了大量以患者為中心的醫療數據,電子病歷系統作為醫療信息化建設中的重要一環得到了廣泛普及。病歷主要包含醫療機構對門診患者和住院患者的診療記錄和工作記錄,現行衛生行業標準WS445—2014[1]對電子病歷數據及其元數據屬性進行了規范,利用電子病歷系統給病歷帶來了記錄、存儲、查閱上的便利。雖然記錄過程實現了信息化,但目前電子病歷仍由半結構化格式的記錄元信息與非結構化的醫療文本段落組成,以自然語言的形式被記錄于病歷信息系統中。隨著電子病歷管理[2]和應用[3]的逐步完善,我國開始著力推進醫療信息現代化與智能化建設。

面對自由文本形式存在的海量病歷數據,亟須利用信息抽取技術將病歷文本數據轉化為結構化病歷數據以再供利用,然而結構化病歷的構建需要具有醫療語義的短語作為支撐。統一醫學語言系統(Unified Medical Language System,UMLS)[4]對生物醫療領域的語義詞匯開展了整合工作,促進了醫療語義短語的抽取工作的發展。通常電子病歷中擁有特定醫療語義的短語被稱為醫療實體,根據醫療概念劃分出了病種診斷、藥物治療、手術治療和實驗室檢驗等語義類別,故一篇病歷的關鍵信息在一定程度上可由其包含的實體集合來表示。

醫療命名實體識別(Medical Named Entity Recognition,MNER)是利用實體識別技術對在醫療命名體上開展識別工作。在英文領域,自2004年起,I2B2(the Center for Informatics for Integrating Biology and the Beside)開始建立面向醫療領域的自然處理任務研究,在I2B2-2009[5]、I2B2-2010[6]、I2B2-2012[7]和I2B2-2014[8]的評測任務中基 于不同角度開展了各類MNER 的評測。英文領域MNER 研究開展較早,實現和方法上也逐步成熟,中文領域MNER 尚處于發展階段,楊錦鋒等[9]嘗試結合中文病歷的語言特點,為建立中文醫療命名實體數據集和標注規范提供了重要參考。中國知識圖譜與語義計算大會(China Conference on Knowledge Graph and Semantic Computing,CCKS)自2017 年起開始發布中文臨床醫療命名實體識別任務,為研究中文醫療命名實體識別提供了寶貴的實驗數據。

面向電子病歷的MNER 研究對于實現病歷結構化,助力醫療智能化十分關鍵。深度語言模型的進步為實體識別任務帶來了新的提升,但先進語言模型的參數規模達到上億,致使識別精度與算力要求間出現了不平衡、不充分的問題。知識蒸餾做到了壓縮語言模型規模與精度損失上的平衡,但其自身網絡和針對下游任務的解碼器均需要精巧設計。因此,研究基于輕量語言模型的高識別精度醫療命名實體識別模型充滿了挑戰;特別是在當前中文領域的醫療命名實體識別上公開的數據和評測較少的背景之下,對于醫療信息現代化和智能化的快速發展將會產生重大意義。

本文的主要工作如下:

1)提出了級聯思想將實體識別過程拆分的方法。該方法可以改善對序列式識別在標簽錯誤轉移錯誤和標注標簽增長控制上的不足,控制標簽隨實體類別和標注方式帶來的標簽增長為很小常數。

2)構建了級聯多任務解碼器。級聯多任務解碼器能夠顯著彌補蒸餾與非蒸餾語言模型帶來的差異,級聯多任務解碼器僅結合輕量語言模型RBT6[10],實現了高精度識別模型。

3)設計了CasSAttMNER(Cascade Self-Attention Medical Named Entity Recognition)模型與各基線模型的對比實驗。CasSAttMNER 模型可以在實體類別判斷的上下文中加入實體提及詞匯整體的信息,能表示級聯式識別中提及詞匯和其類別之間的隱信息,實驗結果表明該模型提高了醫療命名實體識別的精度。

1 相關工作

MNER 的早期工作依靠醫學領域的詞典與規則[11]。隨著對醫學概念上的編碼工作推進,國際疾病分類(International Classification of Diseases,ICD)[12]、SNOMED(Systematized Nomenclature of Human and Veterinary Medicine Reference Terminology)[13]等醫學編碼工作形成了海量醫學詞典,發展出了MedLEE[14]、MedKAT(Medical Knowledge Analysis Tool)[15]、cTAKEs(clinical Text Analysis and Knowledge Extraction system)[16]等專家系統。以專家系統形成了符號主義的醫療智能,但面對醫學領域的發展,病種、治療、藥物等方面的新發現與新治療,專家系統往往不能快速地將其包含,且其相對應的識別規則制定也十分復雜,故人們的研究目光開始轉向使用統計機器學習的方式進行。

Li 等[17]嘗試了使用條件隨機場(Conditional Random Fields,CRF)與支持向量機(Support Vector Machine,SVM)的醫療命名實體識別工作,實驗結果表明,CRF 及其采用序列標注式的識別效果好于SVM 及其短語分類方式的識別,為MNER 采用序列標注式識別作為主流方式奠定了基礎;Clark 等[18]使用規則與基于CRF 和最大熵的聯合機器學習方式,在I2B2-2010 的MNER 任務上取得了0.934 3 的評測值;Cohen 等[19]提出了使用無標數據中獲取的詞語義分布來優化CRF 中的條件概率轉移限制,這種方式為使用語料建模詞分布表示來實現實體識別奠定了基礎。

使用機器學習算法為解決MNER 問題帶來了顯著進步,但統計機器學習方式的識別模型需要依賴特征工程,特征計算的來源為特定語料庫或者任務本身的數據,這也限制了機器學習對新實體的發現能力,若預測的文本中包含著模型從未見過的詞語組成的命名實體,便無法識別,此問題在中文領域更為凸顯。故對特征工程依賴和未登錄詞限制,使得使用機器學習方式解決MNER 問題存在著明顯的上限。

而采用深度學習的預訓練語言模型能夠突破機器學習方法的限制,因此,很多工作開始轉向使用神經網絡與機器學習的方式來進一步提升MNER 的效果:Wu 等[20]使用詞嵌入和深度 神經網絡來解決MNER;Huang 等[21]提出了BiLSTM-CRF(Bi-directional Long Short-Term Memory-Conditional Random Field)神經網絡來優化標注預測;Xu等[22]基于此架構將其應用于MNER 任務中;Ji 等[23]嘗試用多個神經網絡混合的方式來增強MNER 效果。在通用領域,Baevski 等[24]在神經實體識別上引入完形填空模式驅動的網絡結構;Liu 等[25]從上下文增強的角度來嘗試提升神經實體識別模型的識別精度;Li 等[26]使用對抗神經網絡來設計神經實體識別網絡。

在面對層出不窮神經網絡所設計出的MNER 模型時,除了考慮特定領域語言特點所適用的網絡結構外,仍需考慮除識別精度外的算力要求和推理時間等成本因素。目前,使用動態語言模型來解決MNER 任務也成為獲取高精度識別的一種主流方式,但語言模型的參數量以億級別為單位,這使得基于語言模型來解決MNER 時,需要考慮算力的經濟性。深度語言模型為實現高精度的實體識別帶來了潛在機會。各項任務上評測精度越來越接近原始語言模型效果的語言模型輕量化工作也為實現算力與識別精度上的平衡帶來可能。基于這樣的背景,本文將利用輕量語言模型開展一系列研究,構建適用于醫療命名實體識別領域的模型,并嘗試平衡識別精度外的算力要求與推理時間、空間使用等成本因素,以達到實用性和精準度間的平衡。

2 模型構建

本章將使用級聯視角來審視實體識別任務,并有依據地對問題進行公式化表述,在此基礎上提出了級聯式多任務實體識別算法,構建了基于自注意力機制的級聯醫療命名實體識別模型CasSAttMNER。

2.1 級聯式識別

2.1.1 實體識別任務的級聯目標

如何控制標注標簽的增長,對解決復雜的實體識別任務十分關鍵。在此,借用數據庫中級聯操作的思想來引入一個全新的視角去審視實體識別任務。形式定義如下:假定規模為J的實體識別訓練數據集為D,用xj來表示D中的第j條文本,用ej表示文本xj中出現的實體集合。

設文本xj中共包含N個實體,1 個實體ent由包含了位置信息的實體提及t和類別信息實體類別c兩部分,此時存在實體表示為:

則給定來自訓練集合D的文本xj,其對應包含N個實體的實體集ej可表示為:

則對于實體識別訓練數據集D中的一條數據,數據d由xj和ej組成。此時d和D可表示為:

級聯式識別需要描述實體提及和其潛在的語義類別之間存在相關性的函數。式(5)對這個過程進行了描述。

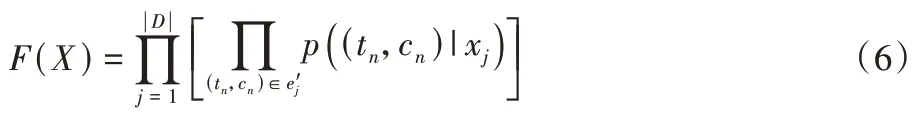

對于數據集D,需要最大化D中的所有潛在實體出現概率,式(6)描述了這種概率:

根據概率鏈式法則,式(6)可轉變為式(7):

根據上述描述,級聯式識別的求解過程可做這樣的描述。實體ent′由(tn,cn)表示,tn為實體ent′的實體提及表示,cn為ent′的實體類別表示。(tn,cn) ∈表示第j條數據中的第n個實體。cn∈|tn刻畫了在e'j中已知實體提及為tn下,實體類別為cn的對應關系,這種對應關系在真實的ej中存在1 個或0 個,預測中存在0 個、1 個或多個,目標是在求解中最大限度地接近1 個或者0 個,具體則取決于真實的ej。

式(7)揭示了級聯式識別的任務目標,便是最大化式(7)在訓練集D上的聯合概率,即目標為最大化地計算文本xj包含實體提及tn的概率與此實體提及tn對應的實體類別為cn的概率,使之解得的最大限度地接近ej。

2.1.2 級聯式識別架構

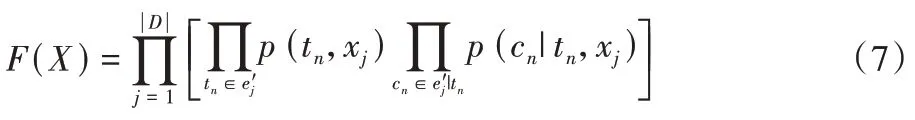

級聯式醫療命名實體識別(Cascade Medical Named Entity Recognition,CasMNER)模型標注過程為圖1 所示。

圖1 級聯式醫療命名實體識別模型的標注過程Fig.1 Labeling process of cascade medical named entity recognition model

級聯式識別借用關系型數據庫中的級聯(Cascade)思想,將文本序列作為一對多關系中的一文本序列同時映射到實體提及識別和實體類別識別兩過程中,此時句子中的每一個字詞都將對應兩個輸出預測。

設實體提及的標簽數量為N,實體類別的標簽數量為M,級聯式識別需要的標注標簽集合S的數量L為:

級聯式識別每增加一個實體提及標簽,模型預測輸出時便僅需要一個提及標簽;每增加一個類別標簽,模型預測輸出便僅需要一個類別標簽。相比序列式識別,這種方式有效控制了標注標簽的增長到常數級。

2.2 基于自注意力機制的CasMNER

2.2.1 基于自注意力機制的解碼器優化

采用級聯方式的實體識別中,實體提及得到的詞匯及其上下文信息,對于待提取的實體詞匯的類別判斷自然地存在一種上下文關系。本節對于如何在實體類別判斷的上下文中加入實體提及詞匯整體的信息,提出了使用自注意力機制來表示級聯式識別中提及詞匯和其類別之間的隱信息CasSAttMNER 對實體類別解碼器進行了重新設計。

實體提及抽取中由式(9)獲得隱解碼信息:

其中:h代表BiLSTM 網絡結構;xencode為解碼過程的輸入,由文本序列集合經分句、嵌入,再使用經過蒸餾的Transformer語言模型RBT6[10]得到。解碼過程中,首先使用BiLSTM 對xencode進行解碼,得到序列信息編碼后的第一層解碼情況,同時結合Dropout[27]方法對解碼結果進行選擇性使用,得到初步解碼。Dropout 函數可根據超參數dropoutRate來歸零BiLSTM 輸出向量上的隨機維度來控制解碼信息的稠密。

在實體類別判斷中由式(10)獲得隱解碼信息:

式中:h代表BiLSTM,這里的BiLSTM 不與實體提及抽取過程共享使用。

為完成實體提及序列標注,需完成式(11)、(12)所示的步驟計算:

其中:式(11)中的函數g是線性變化函數,目的為控制hiddent的輸出尺寸和下一步相同;式(12)中φ代表條件隨機場(CRF)[28]。CRF 條件模型通過一個觀察序列X*選擇條件概率p(Y*|X*)最大的標簽序列Y*,這類判斷式方法使得推理過程中觀察序列的依賴可以被正確地表示,而且不會生成無關推斷。CRF 的求解目標即給定觀察序列x的標簽序列為y的條件概率p(y|x)為:

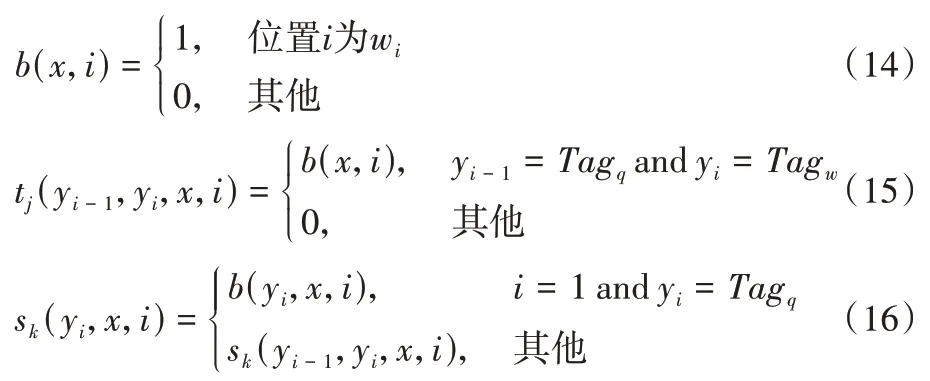

其中:tj(yi-1,yi,x,i)是整個觀察序列在位置i-1 到i的標簽從yi-1轉移到yi的轉移特征函數,sk(yi,x,i)為觀察序列位置i的標簽為yi的狀態特征函數,λj與μk為訓練過程的參數估計。

函數tj(yi-1,yi,x,i)與sk(yi,x,i)均為二分判斷函數,且所有的特征均來自觀察序列中是否為真值,則函數可被表示為:

式(14)中的wi表示某給定的位置;式(15)中的Tagq和Tagw為給定的標簽。

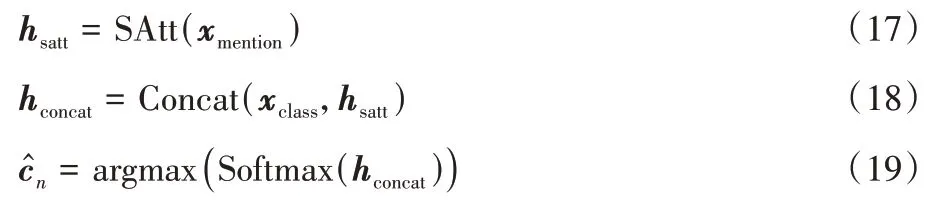

式(7)中的p(cn|tn,xj)表明了實體提及對實體類別存在聯合條件概率上的影響。在此,本節設計使用自注意力機制[29]來構建兩者間的關系信息,即:

式(17)用來計算自點積注意力。自注意力機制的輸出并不改變上一層網絡輸出的空間尺寸,因此xclass與hsatt的空間尺寸相同。式(18)使用xclass和hsatt的連接來對實體類別中增加xmention的信息,Concat 操作是在二者最后一個維度上進行連接。式(19)使用Softmax 網絡對hconcat進行非線性轉換,得到實體提及在各預設類別上的概率分布,取分布中數值最大者作為實體類別結果。此時的類別標簽的計算由式(17)~(19)描述。

2.2.2 CasSAttMNER的網絡架構

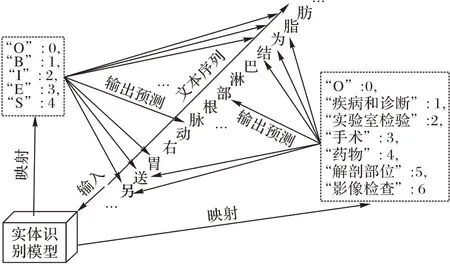

對于輸入文本序列xj,首先將經過字級別的Character-Embedding 進行嵌入表示;隨后在語言模型中得到序列的深度表示,此深度表示將共享輸出到實體提及解碼器Entity Mention Decoder 和實體類別解碼器Entity Class Decoder 中。在實體提及部分將經過兩次的解碼操作得到所需的實體提及標簽序列。在實體類別部分,利用實體提及的第一步解碼輸出的自注意力矩陣,與實體類別中的第一步解碼得到的矩陣進行連接,通過Softmax 網絡來輸出類別。兩個輸出序列的組合將成為xj的輸出結果序列yj,兩序列的長度以及內容一一對應。CasSAttMNER 的網絡結構如圖2 所示。

圖2 CasSAttMNER的神經網絡結構與推理示例Fig.2 CasSAttMNER’s neural network structure and reasoning example

3 實驗及結果分析

將CasSAttMNER模型與各基線模型在CCKS-19[30]和CCKS-20[31]數據集上進行對比實驗,評估輸入與輸出操作的效果,并進行實驗結果分析。

3.1 環境配置與評估指標

本文的實驗環境為Windows10 操作系統,CPU 為Intel Gold 6138,GPU 為Nvidia Quadro RTX 6000,CUDA版本為9.0。

描述實體識別任務的識別精準度評估采用精準率(Precision,P)、召回率(Recall,R)、F值度量(F1 score measure,F)三個指標進行判斷。數據在被預測時會出現真正(True Positive,TP)、真負(True Negative,TN)、假正(False Positive,FP)和假負(False Negative,FN)的4 種情況。針對模型會出現偏差的情況,使用P 來統計TP 在預測數據中的占比,使用R來統計TP在真實數據中的占比,F 反映了P 和R間的平衡。

精確匹配用來度量模型的預測序列結果轉換出的實體集合和人工標注的實體集合的匹配程度,是在實體集級別的匹配,在精確模式下的F 值度量為FE。在精確模式下的精準率PE、召回率RE和F 值度量FE的計算定義如下:

其中:J=ent1,ent2,…,entT為真實實體集;ent'為模型預測出的實體短語,包含模型預測的實體在文本中的位置和類別信息;K=,,…,為預測出的實體序列。

3.2 數據集

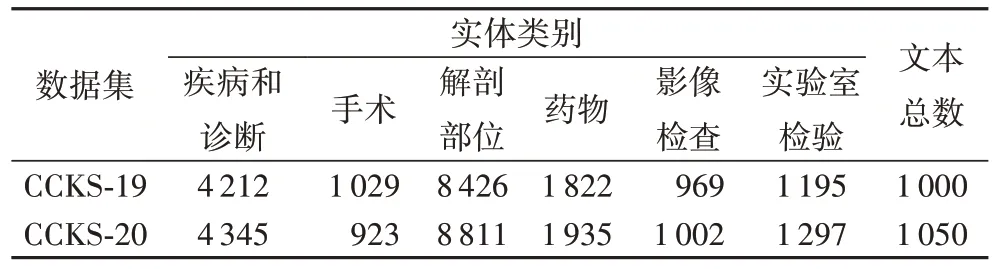

本次實驗使用CCKS 在2019 年與2020 年的中文醫療命名實體識別評測任務的兩個中文醫療實體數據集,文中分別簡稱為CCKS-19[30]和CCKS-20[31]。

CCKS-19 提供了1 000 例病歷語料作為數據集,CCKS-20提供了1 050 例病歷語料作為數據集,均含有6 種醫療實體類型。表1 提供了CCKS-19 和CCKS-20 兩數據集的相關統計信息。

表1 數據集中的實體類別與數量統計Tab.1 Entity class and quantity statistics in datasets

3.3 數據集劃分

針對模型的訓練與驗證,實驗將數據集的訓練與驗證部分劃分比例統一為90%與10%,且在對所有模型訓練和驗證中不調整數據內容。

3.4 模型超參數設置

CasSAttMNER 模型所使用的語言模型為RBT6[10],訓練方式為自動檢查點機制,若當前epoch 的結果好于當前最優記錄,將自動地將此輪epoch 學習到的參數進行轉儲,并更新最優記錄。本次訓練中模型的最優epoch 基本在30~80 的區間內。本次實驗統一訓練的優化函數為adam[32]。使用度量函數衡量模型整體的輸出準確率和損失函數評估預測與實際的偏差程度。由于確定實體類別的過程被視為多分類任務,故引入了分類精準度categorical_acc 和分類損失估計categorical_loss:分類精準度categorical_acc 用于計算預測中預測為真占所有預測情況的比值;分類損失categorical_loss為分類交叉熵,計算了在一個批量中各個實體類別的平均交叉損失熵。

為控制變量的復雜程度,本次訓練過程設置了統一的學習率1E -5 與批尺寸8。除此之外,兩個BiLSTM 網絡層的輸出尺寸均為64;Dropout Rate 均為0.35;CRF 網絡層的輸出尺寸為5;Softmax 網絡層的輸出尺寸為7。

3.5 結果與分析

級聯思想將實體邊界和實體類別標注過程分解,嘗試探索輕量語言模型的多任務開發能力。

為驗證級聯式識別存在識別精度優勢,CasSAttMNER 將在3.2 節中介紹的兩個數據集上進行評估,使用CCKS 在2019 年與2020 年的中文醫療命名實體識別評測任務中的優秀模型作為對比基線。表2 統計了各模型的F 值度量表現,CasSAttMNER 將MNER 的識別精度FE指標提升了3~8 個百分點。

表2 各模型的FE評測統計Tab.2 FE evaluation statistics of each model

表3 統計了各模型在精確匹配下各類別實體的F 值度量表現。級聯式識別進一步提升了MNER 任務的識別精準度,采用自注意力機制優化的CasSAttMNER 模型,有效地表示了實體提及與實體類別之間的隱關系。基于非蒸餾的語言模型BERT 設計的醫療命名實體識別模型[35-36]與基于蒸餾的Transformer 語言模型RBT6[10]設計的CasSAttMNER 模型進行對比實驗,在識別精度上提升了約3 個百分點,證明了多任務解碼器能夠打破蒸餾與非蒸餾的語言模型間的差異,提升蒸餾語言的模型表現。級聯多任務方式的解碼器結合輕量語言模型RBT6[10],便可實現高精度的識別任務,顯著提升了算力經濟性。

表3 各模型的實體F值度量表現統計Tab.3 Entity F value measure statistics of each model

4 結語

本文針對序列式識別在標簽錯誤轉移錯誤和標注標簽增長控制上的不足,引入級聯思想將實體識別過程拆分,提出了一種基于深度自編碼的醫療命名實體識別模型。傳統的序列式實體識別改變標注方式易帶來標簽預測空間和標簽錯誤傳播的增長過快問題,這限制了識別精度的提升。本文模型首先對級聯式實體識別進行公式化表述,隨后設計了對應的網絡結構。該模型延續編碼與解碼間深度差平衡策略,使用輕量語言模型作為編碼器減小編碼深度以及降低對訓練和應用上的算力要求,使用長短期記憶網絡與條件隨機場網絡提出了級聯式多任務雙解碼器,并添加自注意力機制進行優化得到模型CasSAttMNER。實驗結果表明,CasSAttMNER 模型的解碼器能力得到了進一步提升,在兩個中文醫療實體數據的F 值度量可達到0.943 9 和0.945 7。相關實驗證明了級聯多任務解碼器能顯著彌補蒸餾與非蒸餾語言模型帶來的差異,級聯多任務解碼器僅結合輕量語言模型,便達成實現高精度的識別模型,顯著提升了模型算力經濟性。

對于編碼器與解碼器的設計,本次使用的輕量語言模型RBT6[10]是面向通用領域,若使用面向醫學知識的輕量語言模型作為編碼器應能繼續提升醫學實體識別的精準度。本次解碼器優化設計主要基于標準的LSTM 網絡與Attention 機制結合的方式,未來可繼續探究其變種網絡或者其他類型網絡對解碼器的優化能力。