基于注意力機制的多任務漢語關鍵詞識別

何振華?胡恒博?金鑫?安達?李靜濤

摘? 要:為了提高語音關鍵詞識別的性能,在無自動語音識別的端到端關鍵詞識別模型的基礎上,使用了軟注意力機制并結合多任務訓練的方式對其進行了改進。改進后的基于注意力機制的關鍵詞識別模型由四部分構成,關鍵詞嵌入模塊和聲學模塊使用軟注意力來得到特征向量,判別器模塊和分類器模塊輸入特征向量來進行關鍵詞識別。實驗結果表明,改進后模型的準確率分別比基線模型和傳統的關鍵詞檢索方法高出37.3%和3.1%。

關鍵詞:關鍵詞識別;注意力機制;多任務訓練

中圖分類號:TP183? ? ? ? 文獻標識碼:A文章編號:2096-4706(2022)06-0082-05

Keyword Recognition of Multi-Task Chinese Based on Attention Mechanism

HE Zhenhua1, HU Hengbo1, JIN Xin2, AN Da2, LI Jingtao1

(1.Zhengzhou Xinda Institute of Advanced Technology, Zhengzhou? 450000, China; 2.China Railway Beijing Group Co., Ltd., Beijing? 100036, China)

Abstract: In order to improve the performance of speech sounds keyword recognition, this paper uses the method of soft-attention mechanism and combines multi-task training method to improve it based on the end-to-end keyword recognition model without automatic speech sounds recognition. The improved keyword recognition model based on attention mechanism consists of four parts. Keyword embedded modules and acoustic modules use soft attention to obtain the feature vectors, and the discriminator modules and classifier modules input the feature vectors for keyword recognition. Experimental results show that the accuracy of the improved model is 37.3% and 3.1% higher than the baseline model and the traditional keyword retrieval methods respectively.

Keywords: keyword recognition; attention mechanism; multi-task training

0? 引? 言

關鍵詞識別(Keywordspotting)指在從連續的音頻流中檢查出是否有預定義的關鍵詞[1]。根據是否使用了傳統的關鍵詞識別方法,可分為兩類:第一類為傳統的關鍵詞識別方法,即基于大詞匯量連續語音識別的關鍵詞檢索[2],第二類方法為基于神經網絡的關鍵詞識別方法。傳統的方法通常先將待檢測的音頻通過自動語音識別識別來生成一種特殊的詞格,然后在詞格上面進行關鍵詞搜索以檢測是否有預定義的關鍵詞。基于神經網絡的關鍵詞識別方法則是直接使用由神經網絡構成的關鍵詞識別模型進行關鍵詞識別,例如[3-6]。此外,文獻[1]中使用了卷積循環神經網絡(Convolutional Recurrent Neural Network, CRNN)模塊加上連接時序分類(Connectionist Temporal Classification, CTC)[7]訓練損失對不同組合方式的普通話輸入進行了關鍵詞識別,其中的四種CTC標簽分別為:關鍵詞標簽、非關鍵詞標簽、句子中每個字的間隔標簽、CTC的blank標簽。關鍵詞標簽中使用了字和音調的組合以獲得最好的結果,關鍵詞以外的全部字則被設為非關鍵詞標簽。模型訓練結束后,對模型輸出的結果去重后即可進行關鍵詞識別。另外,Audhkhasi等人[8]提出了一種使用較少監督進行關鍵詞識別的方法,模型中分別用聲學模型和字符級語言模型得到輸入音頻和關鍵詞的嵌入向量表示,然后送入前饋網絡中預測關鍵詞是否出現在輸入音頻中,模型中的聲學模塊和字符級語言模型模塊都采用無監督的方式進行訓練,模型的標簽也只有1/0分別表示所需檢測關鍵詞是否出現在需要檢測的句子中,整個模型的訓練用到較少的監督標簽,并沒有對音頻進行標注。本文以此模型對應的方法作為基線系統并對其進行進一步的改進。

在文獻[8]中,其聲學模塊是由聲學自動編碼器組成。聲學自動編碼器[9]中的編碼器將輸入的音頻特征進行信息壓縮得到代表整個輸入音頻的嵌入向量表示,然后再將此嵌入向量送入聲學自動編碼器中的解碼器中,以輸出重建的輸入音頻,聲學模塊使用最小均方誤差損失來進行訓練。由于在對輸入音頻特征進行信息壓縮的過程中會有信息損失,而且對于關鍵詞識別,并不需要輸入音頻中所有的信息,而只需要包含有關鍵詞信息的那部分信息。故只需要關注整個輸入中對關鍵詞識別有用的信息,而不再需要對整個輸入音頻特征進行信息壓縮。注意力機制是一種聚焦于局部信息的機制,可以被用來從眾多信息中選擇出對當前任務目標更關鍵的信息,受此啟發,可以使用注意力機制對輸入音頻進行處理以得到關鍵詞識別中所需的信息。B86FCB7B-49CA-44AB-8AD0-41E3BF54ADD1

本文改進了一種基于注意力機制的關鍵詞識別方法。使用注意力機制得到融合了關鍵詞和輸入音頻特征的嵌入向量,然后再將嵌入向量送入前饋神經網絡進行關鍵詞識別。

1? 無自動語音識別的端到端關鍵詞識別

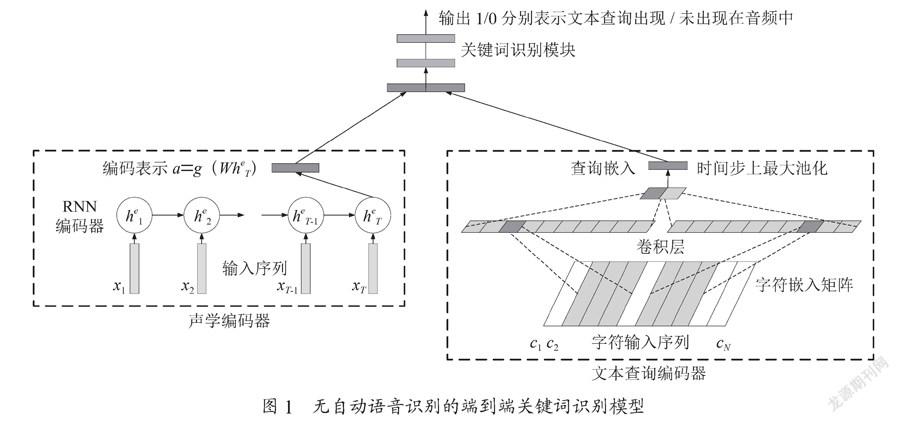

該模型的輸入為待檢測的文本格式關鍵詞和待檢測音頻的特征,輸出為1/0表示關鍵詞是否出現在音頻中。模型結構如圖1所示,該模型由三部分構成。聲學編碼器將音頻特征進行壓縮以得到代表輸入音頻的編碼表示向量,文本查詢編碼其將輸入的文本格式關鍵詞進行嵌入、卷積和池化操作得到對應的查詢嵌入,最后對這兩個向量進行拼接并送入到前饋神經網絡中輸出識別結果。

聲學編碼器是訓練過后的聲學自動編碼器的編碼器部分。聲學自動編碼器輸入音頻特征,然后輸出重建后的輸入音頻特征。其實由兩個循環神經網絡(Recurrent Neural Network, RNN)組成:一個編碼器、一個解碼器。RNN編碼器逐步輸入音頻特征(x1,x2,…,xT)并更新對應的RNN內部單元狀態,直接輸入xT更新對應的狀態后將隱含層狀態作為整個輸入特征的表示,然后對進行非線性轉換以使得聲學向量表示和文本向量表示在相同的嵌入空間中,并將此向量作為輸入特征。最后,將送入RNN解碼器的每個時間步上,并依次輸出對應時間步上的重建特征。聲學自動編碼器在使用最小均方誤差損失進行訓練之后去除解碼器之后便得到了聲學編碼器[10]。

文本查詢編碼器是由字符級語言模型[11]經過訓練后得到的。字符級語言模型輸入字符序列,然后輸出下一個預測的字符。其由三部分構成:嵌入向量矩陣,一維卷積神經網絡,RNN語言模型。給定n個字符c=(c1,c2,…,cn),每個字符經過d×N的嵌入向量矩陣的嵌入后得到n個嵌入向量d=(d1,d2,…,dn),然后使用M個d×w的卷積核對向量d進行一維卷積得到M個對應的一維卷積向量,對這M個向量進行最大池化后得到一個維度為M的嵌入向量q,最后將q送入到RNN語言模型中以輸出待預測的下一個字符。由于RNN語言模型只輸入向量q來預測下一個字符,因此可以用向量q作為文本輸入序列的表示。字符級語言模型使用交叉熵損失進行訓練,訓練完之后去除掉RNN語言模型便得到了文本查詢編碼器。

前饋神經網絡是由兩層神經網絡構成的。在得到了輸入音頻特征表示a和文本向量表示q之后,首先對這兩個向量進行拼接,然后再將拼接后的向量送入到前饋神經網絡中進行預測,結果輸出1/0分別表示關鍵詞是否出現在音頻中。

軟注意力機制是一種根據某些額外的query信息中從向量表達集合values中提取特定的向量進行加權組合的方法。軟注意力值可以分為兩步得到,先根據query信息在所有的向量表達集合values上計算注意力分布,然后根據注意力分布來計算向量表達集合values的加權平均。

具體來說,對于第一步,給定query向量q和values向量X=(x1,x2,…,xn),可以使用兩個向量之間的點積運算結果來得到注意力打分分數:s =(s1,…,si,…,sn),其中,然后使用softmax函數來得到注意力分布:a=(a1,…,ai,…,an),其中ai表示向量q和xi的相關聯程度:

(1)

對于第二步,則是將第一步得到的注意力分布a中的每個注意力得分ai分別乘上對應的xi,然后將相乘加權后的向量全部相加得到注意力值:

(2)

在無自動語音識別的端到端關鍵詞識別模型中,為了更有效地得到輸入音頻中與關鍵詞識別相關的信息,我們可以使用軟注意力機制將文本向量表示q作為query向量,將輸入音頻的特征作為values向量,經過運算操作后得到注意力值然后送入到前饋神經網絡中進行關鍵詞識別。

2? 基于注意力機制的多任務關鍵詞識別模型

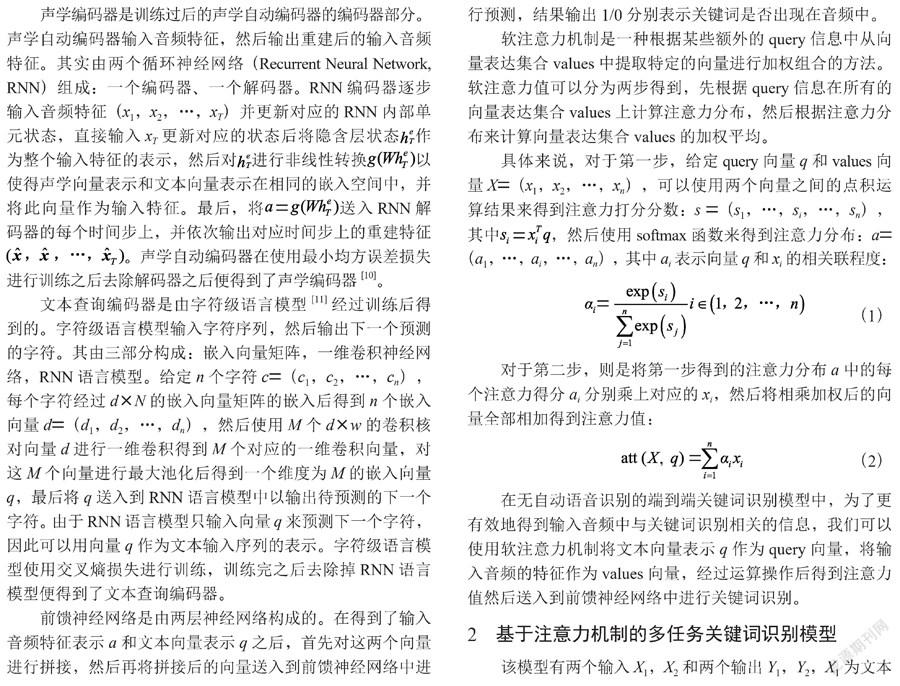

該模型有兩個輸入X1,X2和兩個輸出Y1,Y2,X1為文本格式的關鍵詞,X2為音頻話語,Y1輸出1/0表示關鍵詞輸入是否出現在輸入的音頻話語中,Y2輸出被檢測關鍵詞的分類概率。模型在推理時則只需輸出Y1來得到最終的識別結果。

模型由四部分組成:(1)關鍵詞嵌入模塊,用來得到關鍵詞嵌入向量。(2)聲學模塊,使用注意力機制融合關鍵詞嵌入向量和音頻特征序列來得到特征向量。(3)判別器模塊,輸入特征向量進行關鍵詞識別。(4)分類器模塊,輸入特征向量進行關鍵詞分類。模型結構如圖2所示。

2.1? 關鍵詞嵌入模塊

為了更有效地得到注意力機制中的關鍵詞query向量,與文本查詢編碼器不同的是,沒有訓練字符級語言模型的環節,我們直接將每個關鍵詞進行嵌入操作得到關鍵詞query向量。關鍵詞嵌入模塊中的關鍵詞輸入經過兩個步驟得到嵌入向量:首先,N個關鍵詞k1,k2,…,kN-1,kN經過嵌入矩陣E后得到對應的嵌入向量e1,e2,…,eN-1,eN,為了使關鍵詞的嵌入向量和音頻特征序列向量在同一模態空間中以更好的進行后續的注意力運算,關鍵詞嵌入模塊使用線性變化q=g(We)來得到處理后的關鍵詞嵌入向量,其中g為LeakyRelu(LeakyRectifiedLinearUnit)函數,W為線性層。

2.2? 聲學模塊

聲學模塊由CRNN模塊和注意力模塊兩部分構成。CRNN模塊從輸入音頻特征中提取出輸入音頻的高層特征,Attention模塊則使用注意力機制將關鍵詞嵌入向量和音頻輸入高層特征進行融合。

2.2.1? CRNN模塊

CRNN模塊由m個卷積神經網絡(ConvolutionalNeural Network, CNN)層和n個循環神經網絡(RecurrentNeural Network, RNN)層組成。CNN層中的CNN有權重共享和局部感受野的特點,可以用來捕獲局部相關性,且在最后一層使用了最大池化(MaxPooling)用來減少后續的計算量,使得所需提取的特征更加突出明顯。RNN層只包含用來獲得上下文相關性的雙向RNN網絡。CRNN模塊使用了批歸一化(BatchNormalization)層用來加速訓練,激活函數則使用了LeakyRelu。模塊的最后使用線性層來對雙向RNN網絡的隱含層輸出做變換,以使得CRNN模塊輸出的音頻高層特征和關鍵詞嵌入向量在同一嵌入空間中。B86FCB7B-49CA-44AB-8AD0-41E3BF54ADD1

2.2.2? 注意力模塊

注意力模塊使用注意力機制從高層聲學特征中提取與關鍵詞相關的信息。注意力模塊的計算過程如下:關鍵詞嵌入向量為qi,i∈(1,2,…,N-1,N),音頻輸入特征X=x1,x2,…,xT進入CRNN模塊后得到的高層特征為V=v1,v2,…,,用qi對V中的每一個特征向量做內積得到權重向量d=(d1,d2…),其中:

(3)

d中的每個常數表示關鍵詞嵌入向量qi與每個高層特征v的關聯性大小。d經過softmax處理得到對應的權重向量s=s1,s2…:

(4)

然后將s中的每一個權重乘上對應的高層特征v得到加權后的C其中,最后將C中每列的特征向量進行相加得到融合了關鍵詞嵌入向量和高層特征向量的向量a,即:

(5)

2.3? 判別器模塊

因向量a融合了關鍵詞嵌入向量信息和音頻特征信息,判別器模塊直接將向量a作為輸入以進行關鍵詞識別,輸出范圍為0-1的置信度得分以表示關鍵詞是否出現在音頻句子中。判別器模塊是由兩個線性層后接LeakyRelu激活函數后再加上了sigmoid激活函數組成。

2.4? 分類器模塊

為了更好地利用模型輸入的關鍵詞信息以輔助進行關鍵詞識別,我們可以將融合了關鍵詞嵌入向量信息和音頻特征信息的a送入分類器模塊中輸出關鍵詞分類結果。分類器模塊是由兩個線性層后接LeakyRelu激活函數后再加上softmax激活函數組成。基于注意力機制的多任務關鍵詞識別模型如圖2所示。

3? 實驗

3.1? 實驗設置

3.1.1? 數據準備

實驗使用了AISHELL數據集,AISHELL包含各種類型的共計178個小時的干凈普通話話語,采樣頻率為16 kHz。我們按照詞頻遞減的方法在數據集中選出了至少出現5次的共計15個關鍵詞。訓練集和評估集中的每個句子至少包含有一個關鍵詞,測試集中一半的句子不止包含有一個關鍵詞,另外一半句子完全不包含有關鍵詞。

為了使模型不會受數據標簽比例偏向性的影響,需要對判別器模塊和分類器模塊的標簽數據進行處理。對于判別器的標簽,需使數據中的正樣本和負樣本保持1:1的比例。具體來說,對于訓練集和評估集,假設句子si中含有n個關鍵詞k1,k2…kn,則句子si分別與k1,k2…kn共構成n對標簽為1的實驗數據集S1:(si,k1),(si,k2)…(si,kn),對應標簽全為1。S1作為正面樣本,表示關鍵詞k1,k2…kn出現在句子si中。未出現在句子si中的剩余(15-n)個關鍵詞被隨機地選出相同數量的n個關鍵詞,同樣的,句子si分別與共構成n對標簽為0的實驗數據集S0:,對應標簽全為0。S0作為負面樣本,表示關鍵詞未出現在句子si中。測試集中正樣本的選取方式和訓練與評估集相同,負面樣本則采取類似的方式由任意的關鍵詞與任意的完全不包含有關鍵詞的句子組成。對于分類器的標簽,當判別器的標簽為0時,分類器的標簽也為0,當判別器的標簽為1時,分類器的標簽為對應的關鍵詞分類標簽。

3.1.2? 參數設置

關鍵詞嵌入模塊中嵌入矩陣E的維度為256,線性層W含有256個單元。對于聲學模型模塊,給定音頻后先對其進行幀長為25 ms,幀移為10 ms的分幀,然后對每幀取40維梅爾濾波器組特征(filterbank,fbank)并進行一階和二階差分后得到每幀120維的fbank特征。CRNN模塊中的m/n分別為2/2,CNN層中的卷積核大小都為3×4且步長都為1,而輸出通道數依次為16和32,最大池化層的池化大小都為2×2且步長都為2,RNN層中的雙向LSTM中的隱含層大小都為256,緊跟其后的線性層含有256個單元。判別器模塊中隱含層單元個數依次為256,128,1。分類器模塊中隱含層單元個數依次為256,128,16。

模型使用了Adam優化算法,采用了多任務訓練的方式對其進行了訓練:記判別器輸出和對應標簽yk的二分類損失為,分類器輸出和對應標簽yc的交叉熵損失為,則總損失為。Batchsize為512,初始學習速率為0.000 1,實驗每5個epoch進行一次評估,當評估集損失無明顯下降時,便將學習速率下降至原來的0.9,當評估集的損失不再下降時,模型被停止訓練以防止過擬合。該模型使用Pytorch進行實現。

我們用Kaldi工具完成了傳統方法的關鍵詞識別實驗作為對比。在實驗中,我們使用了TDNN-HMM模型,共有5層DNN,每層含有850個隱含層,其含有2 984個發射狀態。

3.2? 評估準則

在本文的關鍵詞識別任務中,準確率和召回率被用來衡量關鍵詞識別任務的好壞。首先定義如下統計量:

Nfa:虛警(FalseAlarm, FA)數,即將非關鍵詞樣本檢測為關鍵詞的個數。

Nfr:拒識(FalseReject, FR)數,即將關鍵詞樣本檢測為非關鍵詞的個數。

Ntt:關鍵詞樣本被檢測為關鍵詞的個數。

Nff:非關鍵詞樣本被檢測為非關鍵詞的個數。

召回率(Recall)是指識別結果中關鍵詞樣本中被正確地檢測為關鍵詞結果所占所有關鍵詞樣本的比例,其定義為:

(6)

準確率(Accuracy)是指識別結果中被正確檢測的關鍵詞樣本占所有檢測樣本的比例,其定義為:

(7)

3.3? 實驗結果及分析

我們分別探究了α、β取不同值時其對結果的影響,實驗結果如表1所示。

表中的Attention-KWS表示本文所改進的方法,ASR-free-KWS表示本文中第2章所提到的基線系統,ASR-KWS則表示傳統的關鍵詞識別方法。從表中可以看出,當α和β分別取0.7和0.3時,準確率最高,效果最好。相比較于未使用注意力機制的ASR-free-KWS,Attention-KWS與其相比提升了37.3%,這說明了注意力機制在關鍵詞識別中提取所需信息的重要性,而且Attention-KWS相比較于傳統方法ASR-KWS也提升了3.1%。B86FCB7B-49CA-44AB-8AD0-41E3BF54ADD1

4? 結? 論

本文針對ASR-free-KWS聲學模塊中存在的信息利用問題,使用了軟注意力機制并利用多任務訓練的方式,使得關鍵詞嵌入向量高效地使用了輸入音頻特征的信息,使系統的性能得到了較大的提升。在下一步的工作中,為了能夠識別任意的漢語關鍵詞,我們將試著探究漢語中的開集關鍵詞識別。

參考文獻:

[1] YANH K,HEQ H,XIEW.Crnn-CtcBased Mandarin Keywords Spotting [C]//ICASSP2020-2020IEEEInternationalConferenceonAcoustics,SpeechandSignalProcessing(ICASSP).Barcelona:IEEE,2020:7489-7493.

[2] MANDAL A,KUMAR K R P,MITRA P. Recentdevelopmentsinspokentermdetection:asurvey [J].InternationalJournalofSpeechTechnology,2014,17:183-198.

[3] CHENGG,PARADAC,HEIGOLDG.Small-footprintkeywordspottingusingdeepneuralnetworks [C]//2014IEEEInternationalConferenceonAcoustics,SpeechandSignalProcessing(ICASSP).Florence:IEEE,2014:4087-4091.

[4] DEANDRADEDC,LEOS,VIANAMLDS,et al.Aneuralattentionmodelforspeechcommandrecognition [J/OL].arXiv:1808.08929 [eess.AS].[2021-12-24].https://arxiv.org/abs/1808.08929.

[5] SAINATHT N,PARADAC. Convolutionalneuralnetworksforsmall-footprintkeywordspotting [EB/OL].[2021-12-24].https://download.csdn.net/download/weixin_42601421/10691683?utm_source=iteye_new.

[6] ARIKS?,KLIEGL M,CHILD R,etal. ConvolutionalRecurrentNeuralNetworksforSmall-FootprintKeywordSpotting [EB/OL].[2021-12-24].https://www.isca-speech.org/archive/interspeech_2017/ark17_interspeech.html.

[7] GRAVES A,FERN?NDEZ S,GOMEZ F,etal. ConnectionistTemporalClassification:LabellingUnsegmentedSequenceDataWithRecurrentNeuralNetworks [C]//Proceedingsofthe23rdinternationalconferenceonMachinelearning. Pittsburgh:[s.n.],2006:369-376.

[8] AUDHKHASI K,ROSENBERG A,SETHY A,etal. End-to-End ASR-Free Keyword Search From Speech [J/OL].IEEEJournalofSelectedTopicsinSignalProcessing,2017,11(8):1351-1359.

[9] BALDIP. Autoencoders,unsupervisedlearning,anddeeparchitectures [C].Proceedings of the 2011 International Conference on Unsupervised and Transfer Learning workshop.Washington:JMLR.org,2011,27:37-50.

[10] CHUNGY A,WUCC,SHENC H,et al.AudioWord2Vec:UnsupervisedLearningofAudioSegmentRepresentationsusingSequence-to-sequenceAutoencoder [J/OL].arXiv:1603.00982[cs.SD].[2021-12-24].https://doi.org/10.48550/arXiv.1603.00982.

[11] KIMY,JERNITEY,SONTAGD,et al. Character-AwareNeuralLanguageModels [J/OL].arXiv:1508.06615 [cs.CL].[2021-12-24].https://arxiv.org/abs/1508.06615.

作者簡介:何振華(1983—),男,漢族,河南鄭州人,中級工程師,本科,研究方向:語音識別、機器翻譯;胡恒博(1994—),男,漢族,河南鄭州人,碩士研究生在讀,研究方向:語音識別、語音關鍵詞識別。

收稿日期:2022-02-09

課題項目:中國鐵路北京局集團有限公司科技研究開發計劃課題(2021AY02)B86FCB7B-49CA-44AB-8AD0-41E3BF54ADD1