基于人工智能算法的鋁電解工藝優(yōu)化求解

趙春紅

摘要:為提高鋁電解工藝參數(shù)優(yōu)化能力,基于近端策略?xún)?yōu)化(PPO)深度強(qiáng)化學(xué)習(xí)算法,構(gòu)建鋁電解工藝參數(shù)優(yōu)化模型,以實(shí)現(xiàn)鋁電解工藝優(yōu)化求解。對(duì)鋁電解工藝流程進(jìn)行介紹,確定其工藝中的重要技術(shù)參數(shù);然后將深度與強(qiáng)化學(xué)習(xí)相結(jié)合,建立鋁電解參數(shù)尋優(yōu)模型。在原始 PPO 算法基礎(chǔ)上加入RMSProp 算法和沖量思想得到M-RMSProp-PPO 算法,將該算法應(yīng)用到模型中進(jìn)行鋁電解工藝參數(shù)尋優(yōu)。結(jié)果表明:改進(jìn)后算法可實(shí)現(xiàn)快速收斂,累計(jì)獎(jiǎng)賞高達(dá)15%,說(shuō)明改進(jìn)后的算法性能更優(yōu)越;與決策樹(shù)算法進(jìn)行搭配后,可以得到鋁電解工藝優(yōu)化最優(yōu)組合。

關(guān)鍵詞:鋁電解;工藝優(yōu)化;深度強(qiáng)化學(xué)習(xí);M-RMSProp-PPO

中圖分類(lèi)號(hào):TP392

文獻(xiàn)標(biāo)識(shí)碼:A文章編號(hào):1001-5922(2022)06-0186-05

Optimization of aluminum electrolysis technology based on artificial intelligence algorithm

ZHAO Chunhong

(Sichuan Vocational College of Culture & Communication, Chongzhou 611200, Sichuan China

)

Abstract:In order to improve the parameter optimization ability of the aluminum electrolysis process, the aluminum electrolytic process parameter optimization model is constructed based on the proximal strategy optimization (PPO) deep reinforcement learning algorithm to realize the optimization and solution of the aluminum electrolysis process. First, the aluminum electrolysis process is introduced to determine the important technical parameters in the process; then combine depth and reinforcement learning to establish the aluminum electrolytic parameter optimization model; add RMSProp algorithm and impulse idea based on the original PPO algorithm to obtain M-RMSProp-PPO algorithm and apply it to the model to optimize the aluminum electrolytic process parameters. The experiment show that the improved algorithm can achieve rapid convergence with a cumulative reward of 15%, indicating that the improved algorithm is superior; after matching with the decision tree algorithm, the optimal combination of aluminum electrolysis process could be obtained.

Key words:aluminum electrolysis; process optimization; deep reinforcement learning; M-RMSProp-PPO

我國(guó)制造業(yè)的不斷發(fā)展,鋁電解的生產(chǎn)需求呈爆炸式增長(zhǎng),將鋁與多種金屬材料組合后可以得到新的合成金,而合成金廣泛應(yīng)用于工業(yè)領(lǐng)域、發(fā)動(dòng)機(jī)和電動(dòng)機(jī)等,其具有較好的發(fā)展前景。然而,傳統(tǒng)的鋁電解生產(chǎn)主要受工藝人員經(jīng)驗(yàn)限制,工藝優(yōu)化方法主觀性太強(qiáng),從而導(dǎo)致工藝優(yōu)化效率低、穩(wěn)定性差,

不能達(dá)到當(dāng)前工業(yè)領(lǐng)域的高效鋁電解生產(chǎn)需求。因此,提出一種新的工藝優(yōu)化方法對(duì)當(dāng)前鋁電解運(yùn)用具有重要的研究意義。有學(xué)者提出將BP-ANN-MCSA算法應(yīng)用到電弧增材工藝中,進(jìn)行參數(shù)尋優(yōu),其利用BP神經(jīng)網(wǎng)絡(luò)的深層學(xué)習(xí)特性,實(shí)現(xiàn)增材工藝參數(shù)尋優(yōu),且尋優(yōu)速率提升了10%,具有一定的可行性[1];在近端策略?xún)?yōu)化算法PPO的基礎(chǔ)上,加入RMSProp,并構(gòu)建一個(gè)基于改進(jìn)RMSProp-PPO算法的鋁電解參數(shù)尋優(yōu)模型,通過(guò)此模型實(shí)現(xiàn)率電解的優(yōu)化求解,模型性能優(yōu)越[2];集合深度強(qiáng)化學(xué)習(xí)的特性,將其應(yīng)用到電氣綜合能源系統(tǒng)優(yōu)化調(diào)度中,通過(guò)建立深度強(qiáng)化學(xué)習(xí)DRL模型和懲罰機(jī)制等完成電氣能源的優(yōu)化調(diào)度,提升了工作效率[3]。基于此,結(jié)合以上學(xué)者研究成果,利用當(dāng)前應(yīng)用廣泛的深度強(qiáng)化學(xué)習(xí)方法,進(jìn)行鋁電解工藝優(yōu)化求解,為同領(lǐng)域的優(yōu)化求解提供參數(shù)數(shù)據(jù)和研究方向,具有一定的實(shí)際意義。

1鋁電解工藝參數(shù)流程

1.1鋁電解工藝流程

鋁(Al)屬于一種金屬元素,其在空氣中組合成致密氧化鋁薄膜,具備較強(qiáng)的耐腐蝕性和延展性,在建筑、器械領(lǐng)域的應(yīng)用十分廣泛[4]。目前工業(yè)上常用的鋁電解生產(chǎn)方法為融鹽電解法,其可在950~970 ℃溫度下引入強(qiáng)電流,在槽內(nèi)產(chǎn)生化學(xué)反應(yīng),反應(yīng)公式:

Al2O3(固)→2Al3+(絡(luò)合狀)+3O2-(絡(luò)合狀 )7E892C3A-7DF4-477E-BA4F-4C2E980EB88A

Al3+(絡(luò)合狀)+3e→Al(液)

O2-(絡(luò)合狀)-2e→(原子)

2O(原子)+C(固)→CO2(氣)

工業(yè)制鋁具體工藝步驟主要分為4步。首先,將工業(yè)鋁置入電解槽中,對(duì)其進(jìn)行通電處理;然后,提升該槽內(nèi)溫度,設(shè)置在960~960 ℃。之后在槽內(nèi)加入高壓鋁液,將其與工業(yè)鋁發(fā)生化學(xué)反應(yīng),得到陽(yáng)極氣體,分別為氧氣和二氧化碳;最后,將該氣體進(jìn)行凈化處理和排放,得到氟化物,由此完成鋁電解工藝操作。

1.2鋁電解技術(shù)參數(shù)

鋁電解生產(chǎn)過(guò)程中,通過(guò)鋁電解參數(shù)指標(biāo)可看出鋁產(chǎn)量和當(dāng)前電解槽狀態(tài)。優(yōu)化工藝參數(shù)優(yōu)化,能夠提升電解槽狀態(tài),生產(chǎn)大量鋁[5]。主要方法是調(diào)節(jié)鋁水平;將電解質(zhì)、鋁液進(jìn)行設(shè)置,高度為15~19 cm。

1.3鋁電解槽生產(chǎn)MDP分析

由于鋁電解中的數(shù)據(jù)具有較強(qiáng)的時(shí)序性,其滿(mǎn)足馬爾科夫決策過(guò)程(MDP)要求,因此通過(guò)MDP對(duì)鋁電解生產(chǎn)過(guò)程進(jìn)行模擬,還原真實(shí)生產(chǎn)環(huán)境,幫助確立準(zhǔn)確的參數(shù)范圍。

MDP具體流程為:初始化狀態(tài)S0,從動(dòng)作集A中選取一個(gè)動(dòng)作A0執(zhí)行[6]。具體流程可表示為:

S0→S1→S2→S3→S4…

根據(jù)上式,將以上工藝技術(shù)參數(shù)表示電解槽狀態(tài)空間;連續(xù)天數(shù)表示為維度。

2深度強(qiáng)化學(xué)習(xí)模型構(gòu)建

2.1深度強(qiáng)化學(xué)習(xí)原理

深度學(xué)習(xí)的基本原理是對(duì)某物體進(jìn)行表征學(xué)習(xí),提取其深層特征,其學(xué)習(xí)性能優(yōu)越,在圖像識(shí)別、語(yǔ)言分類(lèi)等方面均取得較好的應(yīng)用效果[7]。強(qiáng)化學(xué)習(xí)常用于人臉識(shí)別、數(shù)據(jù)挖掘和參數(shù)優(yōu)化等領(lǐng)域;將其與深度學(xué)習(xí)結(jié)合,得深度強(qiáng)化學(xué)習(xí)(Deep Reinforcement Learning,DRL)。

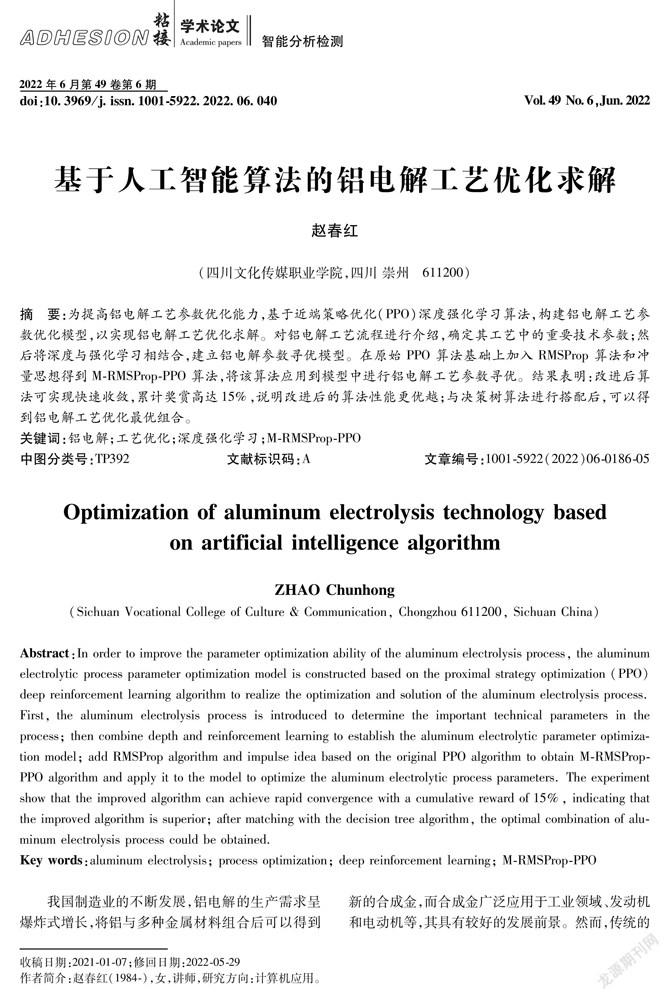

2.2深度強(qiáng)化學(xué)習(xí)模型構(gòu)建

DRL網(wǎng)絡(luò)結(jié)構(gòu)如圖1所示。該網(wǎng)絡(luò)主要分3個(gè)層級(jí):輸入層、隱含層和輸出層,常用激活函數(shù)為目前應(yīng)用較多、應(yīng)用效果較好的Relu[8]。

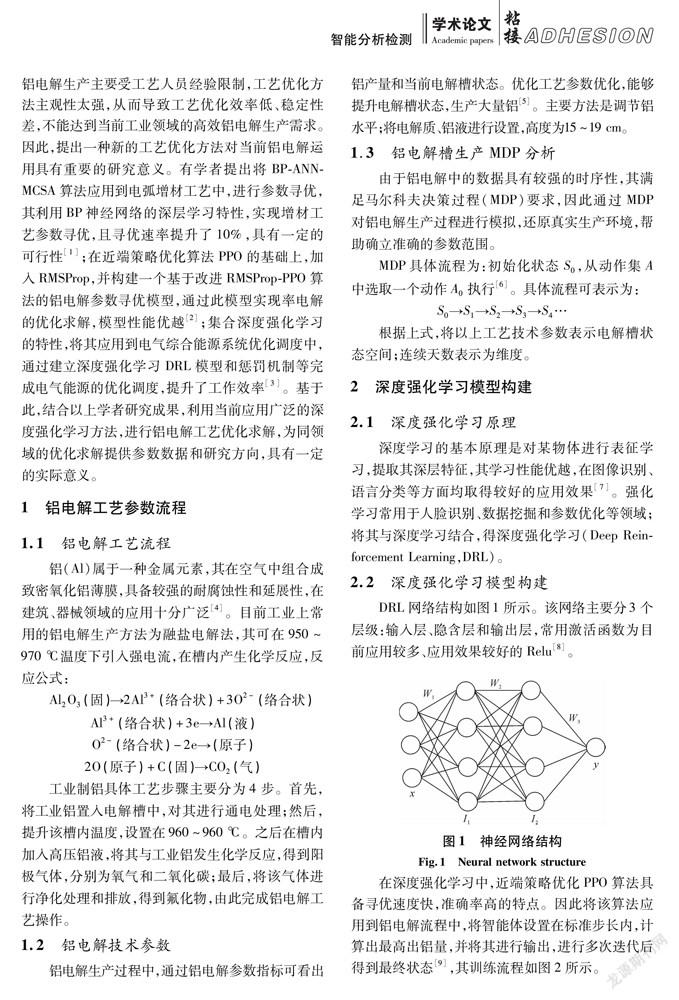

在深度強(qiáng)化學(xué)習(xí)中,近端策略?xún)?yōu)化PPO算法具備尋優(yōu)速度快,準(zhǔn)確率高的特點(diǎn)。因此將該算法應(yīng)用到鋁電解流程中,將智能體設(shè)置在標(biāo)準(zhǔn)步長(zhǎng)內(nèi),計(jì)算出最高出鋁量,并將其進(jìn)行輸出,進(jìn)行多次迭代后得到最終狀態(tài)[9],其訓(xùn)練流程如圖2所示。

從圖2可知,對(duì)網(wǎng)絡(luò)參數(shù)進(jìn)行設(shè)置,并將其與環(huán)境融合;然后將數(shù)據(jù)與獎(jiǎng)勵(lì)函數(shù)相結(jié)合輸入至全連接神經(jīng)網(wǎng)絡(luò)中進(jìn)行訓(xùn)練[10]。根據(jù)策略選擇下一步動(dòng)作并執(zhí)行,由此轉(zhuǎn)移至下一狀態(tài);循環(huán)上述流程,進(jìn)行多次更新,直至訓(xùn)練結(jié)束[11]。

2.3基于原始PPO模型的范圍尋優(yōu)算法

2.4基于改進(jìn)PPO的尋優(yōu)算法

原始PPO算法存在隨機(jī)梯度上升效率低、訓(xùn)練過(guò)早結(jié)束的問(wèn)題,收斂速度慢,尋優(yōu)結(jié)果不準(zhǔn)確。因此,基于該算法加入RMSProp 算法和沖量原理,改進(jìn)其隨機(jī)梯度上升方式,提升迭代更新速度,避免振蕩。由此得到改進(jìn)的RMSProp[13]。

3實(shí)驗(yàn)結(jié)果與分析

3.1實(shí)驗(yàn)環(huán)境和配置

為取得更好的實(shí)驗(yàn)效果,本次實(shí)驗(yàn)硬件和軟件分別選用Pychann 2019和3.6 Python,顯卡和CPU分別選用NVIDIA和E5-2620型號(hào),內(nèi)存大小為48 GB。

3.2實(shí)驗(yàn)數(shù)據(jù)

根據(jù)原始PPO尋優(yōu)策略,選擇從某鋁廠獲取2020年7月4日至2021年7月4日的鋁電解數(shù)據(jù)合計(jì)30 000條,電解槽數(shù)量為300,部分原始數(shù)據(jù)如表1所示。

本次鋁電解參數(shù)優(yōu)化過(guò)程中網(wǎng)絡(luò)結(jié)構(gòu)使用全連接神經(jīng)網(wǎng)絡(luò),隱層數(shù)為2個(gè),其對(duì)應(yīng)層數(shù)的神經(jīng)元數(shù)目為128 個(gè),神經(jīng)元激活函數(shù)選用 Relu,超參數(shù)主要包括 PPO 算法部分超參數(shù)和 M-RMSProp部分超參數(shù)。其中,PPO和M-RMSProp的學(xué)習(xí)率分別設(shè)置為0.002 5和0.003;步數(shù)最高設(shè)置為3 000。

3.3實(shí)驗(yàn)結(jié)果與分析

3.3.1基于改進(jìn)模型的訓(xùn)練結(jié)果分析

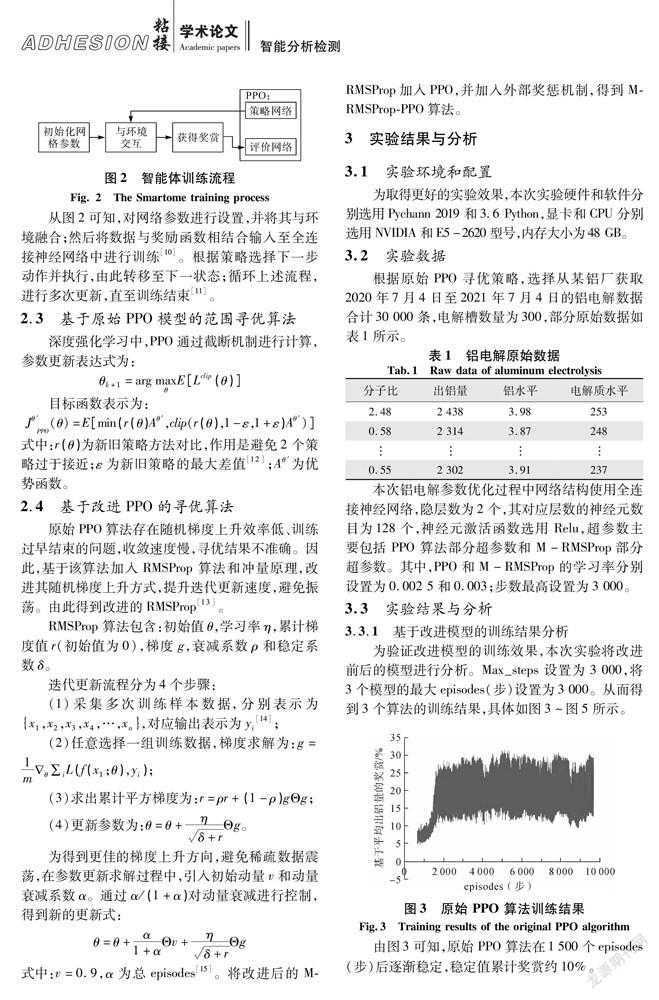

為驗(yàn)證改進(jìn)模型的訓(xùn)練效果,本次實(shí)驗(yàn)將改進(jìn)前后的模型進(jìn)行分析。Max_steps 設(shè)置為 3 000,將3個(gè)模型的最大episodes(步)設(shè)置為3 000。從而得到3個(gè)算法的訓(xùn)練結(jié)果,具體如圖3~圖5所示。

由圖3可知,原始 PPO 算法在1 500個(gè)episodes(步)后逐漸穩(wěn)定,穩(wěn)定值累計(jì)獎(jiǎng)賞約10%。

從圖4可知,RMSProp-PPO算法在1 300個(gè)episodes(步)后開(kāi)始穩(wěn)定下來(lái),累計(jì)獎(jiǎng)賞約15%,對(duì)比原始PPO算法,獎(jiǎng)賞值提升了5%,迭代速度得到提升。

從圖5可知,改進(jìn)算法在1 000個(gè)episodes(步)時(shí)逐漸穩(wěn)定,累計(jì)獎(jiǎng)賞約15%。對(duì)比改進(jìn)前算法,改進(jìn)算法的迭代速度明顯更快,得到進(jìn)一步提升。

根據(jù)以上3種算法的訓(xùn)練結(jié)果,將其進(jìn)行統(tǒng)計(jì)后進(jìn)稀疏對(duì)比,對(duì)比結(jié)果如圖6所示。

由圖6可知,改進(jìn)算法迭代至1 000次時(shí)實(shí)現(xiàn)收斂,說(shuō)明改進(jìn)算法可取得較好的應(yīng)用效果。

3.3.2參數(shù)范圍尋優(yōu)算法的結(jié)果對(duì)比和分析

實(shí)驗(yàn)將對(duì)改進(jìn)模型進(jìn)行多次訓(xùn)練,選取其中獎(jiǎng)賞值最高的 2 000組,收集訓(xùn)練結(jié)果,確定最優(yōu)參數(shù)取值范圍。訓(xùn)練結(jié)果如表2所示。

從以上訓(xùn)練結(jié)果中進(jìn)行改進(jìn)算法尋優(yōu)結(jié)果分析,將表2中的最優(yōu)參數(shù)與決策樹(shù)中的C4.5尋優(yōu)的多組最優(yōu)參數(shù)范圍做搭配選擇其交集,得到最終最優(yōu)參數(shù)范圍搭配,部分參數(shù)對(duì)比結(jié)果如圖7所示。

對(duì)以上對(duì)比結(jié)果進(jìn)行分析后,取得多種最優(yōu)參數(shù)范圍組合,組合結(jié)果如表3所示。7E892C3A-7DF4-477E-BA4F-4C2E980EB88A

4結(jié)語(yǔ)

綜上所述,構(gòu)建的基于深度強(qiáng)化學(xué)習(xí)的鋁電解工藝優(yōu)化模型可以計(jì)算出鋁電解生產(chǎn)的最優(yōu)解,為鋁電解生產(chǎn)工藝人員提供強(qiáng)有力的數(shù)據(jù)和技術(shù)支持,且通過(guò)最優(yōu)參數(shù)組合和搭配可以提升鋁電解的生產(chǎn)量,從而提升了工廠的經(jīng)濟(jì)效益。實(shí)驗(yàn)結(jié)果表明,相較于改進(jìn)前算法,改進(jìn)后的算法收斂速度更快,在訓(xùn)練1 000次后即趨于穩(wěn)定,穩(wěn)定性更強(qiáng),累計(jì)獎(jiǎng)賞為15%,比原始PPO算法更高。結(jié)果可知:改進(jìn)算法的性能十分優(yōu)越,且將其與決策樹(shù)的最優(yōu)解進(jìn)行組合和搭配后,可以得到鋁電解的最優(yōu)參數(shù)解,說(shuō)明其可在鋁電解工藝參數(shù)優(yōu)化領(lǐng)域進(jìn)行大力推廣和應(yīng)用。

【參考文獻(xiàn)】

[1]權(quán)國(guó)政,溫志航,鹿超龍,等.融合BP-ANN-MCSA算法的電弧增材工藝參數(shù)尋優(yōu)策略研究[J].塑性工程學(xué)報(bào),2021,28(1):91-97.

[2]張曉,李晉宏.基于改進(jìn)RMSProp-PPO算法的鋁電解參數(shù)尋優(yōu)模型[J].電子元器件與信息技術(shù),2021,5(3):170-174.

[3]喬驥,王新迎,張擎,等.基于柔性行動(dòng)器–評(píng)判器深度強(qiáng)化學(xué)習(xí)的電-氣綜合能源系統(tǒng)優(yōu)化調(diào)度[J].中國(guó)電機(jī)工程學(xué)報(bào),2021,41(3):819-833.

[4]于一瀟,楊佳峻,楊明,等.基于深度強(qiáng)化學(xué)習(xí)的風(fēng)電場(chǎng)儲(chǔ)能系統(tǒng)預(yù)測(cè)決策一體化調(diào)度[J].電力系統(tǒng)自動(dòng)化,2021,45(1):132-140.

[5]陳虹松,董定乾,黃兵,等.基于遺傳算法的航空葉片銑削加工工藝參數(shù)優(yōu)化[J].工具技術(shù),2021,55(9):68-73.

[6][ZK(]張永棠.一種深度強(qiáng)化學(xué)習(xí)的C-RAN動(dòng)態(tài)資源分配方法[J].小型微型計(jì)算機(jī)系統(tǒng),2021,42(1):132-136.

[7]隗寒冰,賀少川.基于深度強(qiáng)化學(xué)習(xí)的插電式柴電混合動(dòng)力汽車(chē)多目標(biāo)優(yōu)化控制策略[J].重慶交通大學(xué)學(xué)報(bào)(自然科學(xué)版),2021,40(1):44-52.

[8]趙小云,龔紅英,施為鐘,等.基于RSM與NSGA-Ⅱ的燃?xì)庠钔鈿ち慵尚钨|(zhì)量多目標(biāo)優(yōu)化[J].輕工機(jī)械,2021,39(1):86-91.

[9]劉永姜,李俊杰,曹一明,等.基于近似模型和遺傳算法的等離子噴焊工藝參數(shù)多目標(biāo)優(yōu)化[J].科學(xué)技術(shù)與工程,2021,21(11):4 403-4 408.

[10]肖鵬飛,張超勇,孟磊磊,等.基于深度強(qiáng)化學(xué)習(xí)的非置換流水車(chē)間調(diào)度問(wèn)題[J].計(jì)算機(jī)集成制造系統(tǒng),2021,27(1):192-205.

[11]祝亢,黃珍,王緒明.基于深度強(qiáng)化學(xué)習(xí)的智能船舶航跡跟蹤控制[J].中國(guó)艦船研究,2021,16(1):105-113.

[12]李聰波,余必勝,肖溱鴿,等.考慮刀具磨損的數(shù)控車(chē)削批量加工工藝參數(shù)節(jié)能優(yōu)化方法[J].機(jī)械工程學(xué)報(bào),2021,57(1):217-229.

[13]楊挺,趙黎媛,劉亞闖,等.基于深度強(qiáng)化學(xué)習(xí)的綜合能源系統(tǒng)動(dòng)態(tài)經(jīng)濟(jì)調(diào)度[J].電力系統(tǒng)自動(dòng)化,2021,45(5):39-47.

[14]董詩(shī)繪,牛彩雯,戴琨.基于深度強(qiáng)化學(xué)習(xí)的變電站巡檢機(jī)器人自動(dòng)化控制方法研究[J].高壓電器,2021,57(2):172-177.

[15][JP3]張雷,鐘言久,闞歡迎,等.熔融沉積制造高能效工藝參數(shù)優(yōu)化方法[J].機(jī)械設(shè)計(jì)與制造,2021(3):149-152.7E892C3A-7DF4-477E-BA4F-4C2E980EB88A