融合自適應感受野與多支路特征的鞋型識別算法

張家鈞,唐云祁,楊智雄

(中國人民公安大學偵查學院,北京 100032)

0 概述

通過作案人遺留在犯罪現場的嫌疑鞋印推斷嫌疑鞋型,進而在監控視頻中追蹤犯罪嫌疑人已經成為公安機關偵破案件的重要技戰法。隨著監控攝像頭的普及,該技戰法在偵查破案中具有重要作用。文獻[1]介紹2016 年某超市內發生的一起命案,現場唯一有價值的物證是數枚來自同一人的帶血鞋印。在該案件中,偵查人員通過特征標示、拼接比較、重合比較等方法確定監控視頻中一男子所穿鞋型與案發現場鞋型為同類鞋型,在監控視頻中成功鎖定犯罪嫌疑人,實現了從案發現場遺留鞋印到監控的跨模態追蹤溯源。

“鞋印+監控”技戰法雖然有較強的實戰價值,但是在監控視頻中比對嫌疑鞋型的工作全部由人工完成。我國警力尚處于不足的狀態,無法確保在規定時間內精準搜索到犯罪嫌疑人。因此,一種面向監控視頻的鞋型自動識別算法成為研究熱點。相比人臉識別問題,面向監控視頻的鞋型識別問題更復雜,其原因為受運動、光照、分辨率較低等因素的影響,在監控視頻中的鞋子區域大多是模糊不清的,導致可利用有效特征較少。因此,通過提取低分辨率鞋子影像有效特征進行鞋型自動識別是現階段亟須解決的難題。

針對上述問題,本文提出一種基于自適應感受野模塊與多支路特征融合的鞋型識別算法。通過構建自適應感受野模塊(Adaptive Receptive Field Module,ARFM),在模塊末端連接通道注意力機制,使網絡自動選擇合適大小的感受野特征,設計三支路特征融合模型,充分利用有效特征進行鞋型識別,采用Center Loss[2]和標簽平滑損失[3]聯合函數對網絡進行訓練,使樣本實現更好的聚類效果。

1 相關工作

基于內容的圖像檢索(Content-Based Image Retrieval,CBIR)是計算機視覺領域的研究熱點。在深度學習發展之前,CBIR 主要基于手工標注的特征,如尺度不變特征變換(Scale-Invariant Feature Transform,SIFT)[4],因手工特征描述受限,導致檢索效率較低。自深度學習得到迅速發展之后,特別是AlexNet[5]、VGGNet[6]、GoogLeNet[7]、ResNet[8]、DenseNet[9]等深度卷積神經網絡的出現,得益于其強大的特征提取能力,深度學習廣泛應用在圖像分類、目標檢測[10]、圖像檢索[11]等領域。

文獻[12]提出全連接層具有較強的語義特征描述能力,并且其本身是向量形式,因此在早期工作中,直接選擇全連接層作為圖像的表示向量,但是僅選擇一層全連接層會限制網絡的檢索性能。因此,文獻[13]提出融合多層全連接層特征進行圖像檢索,取得更優的檢索結果。文獻[14]對GoogLeNet的3 組inception 結構進行平均池化、1×1 卷積和全連接層操作,并將這3 組提取到的1 024 維特征進行拼接,并對得到3 072 維特征向量進行檢索,其檢索結果優于傳統的特征提取算法。文獻[15]指出,全連接層對圖像分類的貢獻突出,但是缺乏圖像細節特征和局部幾何不變特性,對圖像的尺寸、位置等變化較敏感。因此,研究人員將卷積層的輸出作為圖像特征表示向量,卷積層中神經元僅連接特征圖中的部分區域并且參數共享,具有對圖像幾何變換的有效性。將卷積層的輸出作為圖像特征表示向量需要選擇合適的卷積特征聚合方法,如SPoC[16]、CroW[17]、R-MAC[18]、SCDA[19]、PWA[20]、GEM[21]等方法。文獻[22]基于CroW 和SCDA 方法提出深度卷積特征聚合(DFW)方法,綜合考慮深度卷積特征的位置、區域和通道的重要性,并對特征進行加權聚合,以獲得更優的檢索效果。文獻[23]基于CroW 方法提出一種新的空間和通道特征加權聚合方法,生成差異性加權向量,并對權重矩陣進行濾波處理,具有較優的檢索結果。

文獻[24]提出在卷積神經網絡中每層提取的特征具有層次性,低層特征主要包含紋理、邊緣等細節特征,隨著層數的加深,網絡感受野逐漸增大,高層特征主要包含高級語義特征。基于此,文獻[25]融合低層細節特征和高層語義特征,提高網絡檢索性能。文獻[26]提出融合全局特征和局部特征的兩階段的圖像檢索方法,利用全局特征進行檢索得到top30 結果,采用局部特征進行重新檢索排序,在Google Landmarks dataset v2 數據集上達到最高的檢索精度。文獻[15]提出多層特征融合的檢索精度相比于單獨使用低層特征或者高層特征的檢索精度高。文獻[27]提出一種三支路特征層融合的模型,使網絡充分利用有效特征進行行人重識別,實驗結果表明,多層特征融合模型具有更優的檢索性能。針對傳統神經網絡在學習目標高層語義特征時存在目標邊緣、紋理等淺層特征丟失的問題,文獻[28]采用Haar-like 提取目標邊緣、紋理特征,同時利用Adaboost 進行特征降維,以提取目標的邊緣、紋理淺層特征,將目標淺層特征與神經網絡提取的深層特征相融合,能夠有效提升檢測精度。文獻[29]通過Gabor 濾波器獲取目標不同方位的特征,利用MS-CLBP 獲取目標的局部紋理、空間和輪廓信息,并將淺層特征與神經網絡學習到的高層語義特征相融合輸入到SVM 分類器中,得到優于當時最先進方法的分類精度。

針對監控視頻中行人所穿鞋型自動識別研究較少的問題,本文將深度學習運用到鞋型識別工作中,不僅取代人工盯查監控工作,大幅加快鞋型匹配速度,還可以避免人工盯查監控時受主觀因素的影響,提升公安機關偵破案件的效率。

2 本文算法

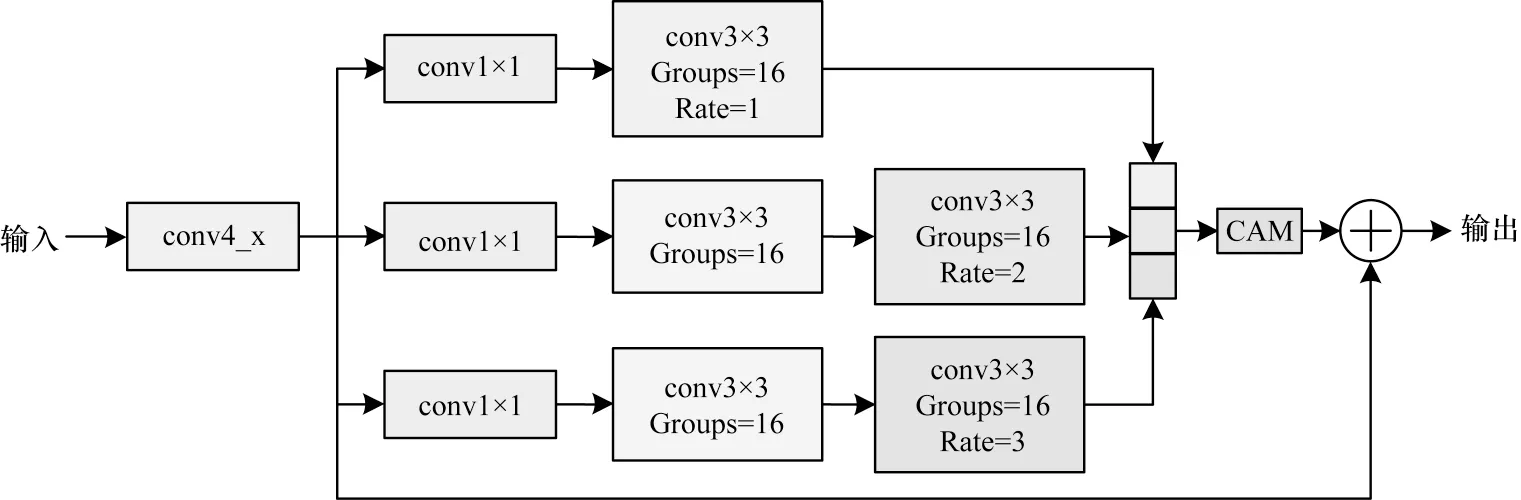

2.1 自適應感受野

感受野是指神經網絡中每層輸出特征圖的像素點在原始圖像上映射的區域大小,網絡感受野越大表示其接觸到原圖像范圍越大,所包含的特征信息更加全面。增大感受野的主要方式是增加網絡深度和采用下采樣操作,在深度學習初期,網絡層數越深,訓練得到的模型效果越好,但是通過池化層增大網絡感受野的弊端是隨著圖像分辨率的降低,圖像的細節信息也會隨之丟失。因此,本文提出一種自適應感受野模塊,其骨干網絡采用ResNet50,模塊結構如圖1 所示。

圖1 自適應感受野模塊Fig.1 Adaptive receptive field module

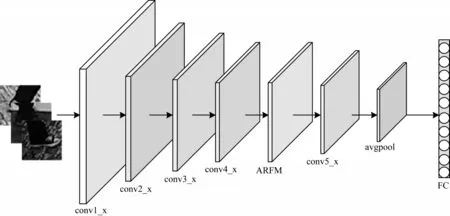

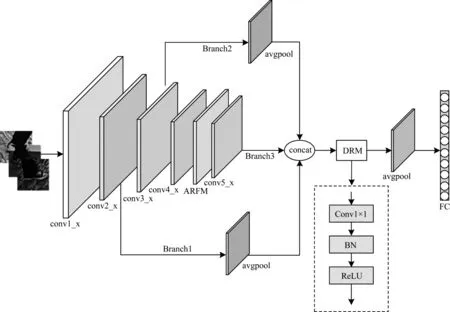

為獲得不同大小的網絡感受野,本文設計3 條卷積支路,每條支路采用不同空洞率的空洞卷積[30]。本文在3×3 卷積層中采用分組卷積[31],Groups 設置為16,減少模塊參數量,使自適應感受野模塊輕量化,在模塊末端連接通道注意力機制[32],實現自適應選擇合適大小的感受野特征[33],從而提升鞋型識別性能。圖2 為引入自適應感受野模塊之后的網絡架構。

圖2 本文網絡架構Fig.2 Architecture of the proposed network

2.1.1 空洞卷積

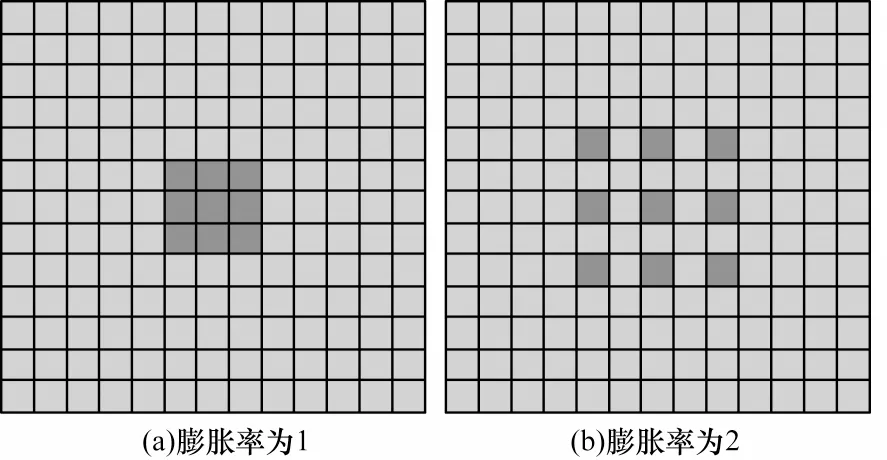

空洞卷積是指在傳統卷積的基礎上增加零填充,通過設置不同的膨脹率,在不增加額外參數的情況下擴大網絡感受野。感受野的計算如式(1)所示:

其中:rn為該層網絡感受野大小;rn-1為前層網絡感受野大小;kn為該層卷積核大小;si為i層步長。

不同膨脹率的空洞卷積示意圖如圖3 所示,圖3(a)為傳統的標準卷積操作,感受野大小為3×3。圖3(b)表示空洞卷積的膨脹率大小為2,通過增加零填充,此時感受野大小為5×5。空洞卷積在不增加額外計算量的同時僅使用不同的膨脹率獲得不同大小的感受野,以捕獲更加全面的特征信息。

圖3 不同膨脹率的空洞卷積示意圖Fig.3 Schematic diagram of cavity convolution with different dilation rates

空洞卷積卷積核的計算如式(2)所示:

其中:Kn為空洞卷積卷積核大小;kn為真實卷積核大小;d為空洞卷積使用的膨脹率參數。

2.1.2 分組卷積

本文在3×3 卷積層中采用分組卷積減少參數量,使自適應感受野模塊更加輕量化。分組卷積首先對輸入的特征圖進行分組,在每組特征圖中再進行卷積操作。假設某層輸入特征圖的通道數、寬、高、輸出通道數分別為C、W、H、K,采用傳統標準卷積方式的參數量P1如式(3)所示:

分組卷積將傳統標準卷積分為G組,其參數量P2為,如式(4)所示:

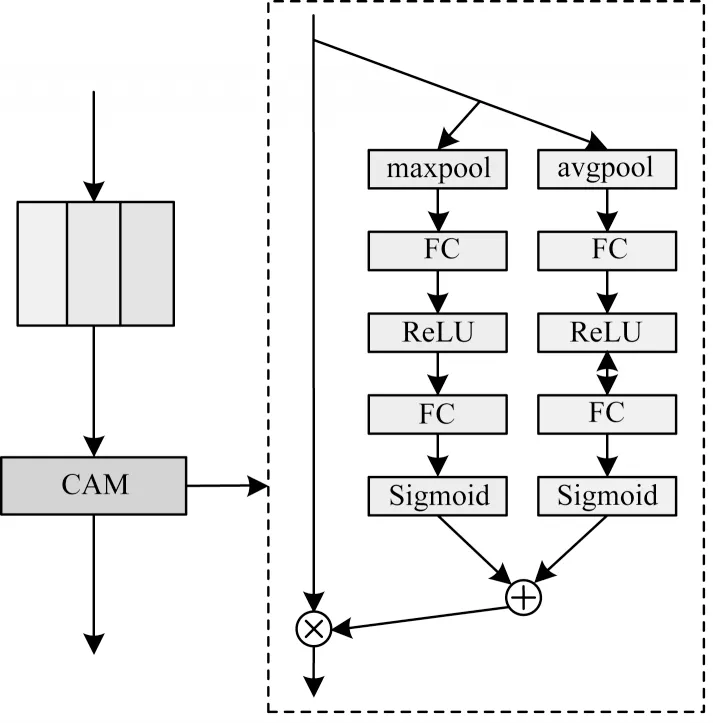

2.1.3 通道注意力機制

注意力機制使得網絡自適應選擇對當前任務更關鍵的特征信息。在本文提出的自適應感受野模塊中,3 條支路分別代表不同大小的感受野特征。本文在模塊末端連接通道注意力機制,使每條支路具有不同重要性的權重,從而實現網絡自適應選擇合適大小感受野特征的目的。通道注意力機制模型如圖4 所示。

圖4 通道注意力機制模型Fig.4 Channel attention mechanism module

首先對輸入特征進行壓縮,即通過平均池化和最大池化整合各通道的信息,之后通過兩層全連接層建模通道間的相關性,獲取每條支路的重要性權重,通過Sigmoid 激活函數獲取0~1 之間的歸一化權重,將兩條支路的歸一化權重系數相加后加權到各通道特征中,實現網絡自適應選擇合適大小的感受野特征。注意力權重系數Q如式(5)所示:

其中:X∈Rc×h×w為上層輸出特征;Q0∈、Q1∈Rc×1×1分別為經過第1 層和第2 層FC 層的特征;δ為ReLU 激活函數;σ為Sigmoid 激活函數。

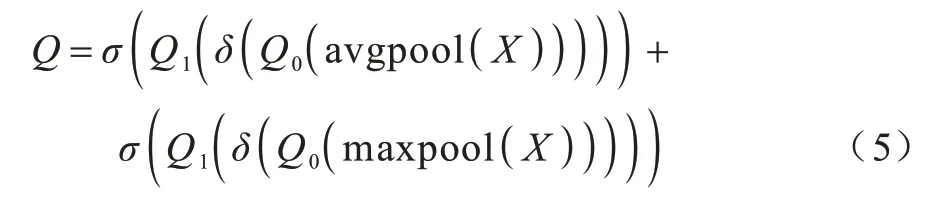

2.2 實例與批量標準化

批量標準化(Batch Normalization,BN)[34]是卷積神經網絡中數據歸一化常用的方法,BN 對輸入每批次的數據進行歸一化處理,使每層的輸出歸一化至均值為0 和方差為1 的分布,確保數據分布的一致性。實例標準化(Instance Normalization,IN)與BN相反,IN 僅作用于單張圖片,通過對單張圖片的所有像素求均值和標準差,可以降低場景遷移(如背景、光照等變化)時對識別效果產生的影響。本文使用多背景數據集,且光照、角度等條件均不同,利用IN減少外觀差異產生的影響,但是IN 在減小同類個體差異的同時也會損失一些有效特征信息。BN 保留較多區分不同個體的特征信息,但是該特征信息受外觀影響較大。因此,結合IN 和BN 兩者的優點,本文采用文獻[35]提出的IBN-Net,一半通道使用IN,剩余通道使用BN。在卷積神經網絡中,由外觀因素帶來的特征差異主要存在于低層中,高層受外觀差異產生的影響較小。本文在conv2_x 中每組卷積塊的第1 層卷積層之后使用IBN 結構,增強網絡識別能力。實例與批量標準化結構如圖5 所示。

圖5 實例與批量標準化結構Fig.5 Structure of instance and batch normalization

2.3 多支路特征融合模型

本文提出的多支路特征融合模型能夠充分利用淺層特征和深層特征,通過特征融合方式彌補神經網絡無法充分利用有效特征進行識別的不足。在卷積神經網絡中,卷積層提取的特征各不相同,淺層特征一般是紋理、邊緣等細節特征信息,深層特征通常是高級語義特征。深層特征雖然具有語義表達能力,但是如果網絡單獨使用深層特征會損失圖像細節信息,從而影響鞋型識別性能。本文選擇ResNet50 網絡中的conv2_x、conv3_x、conv5_x 這3 個模塊的輸出特征,以充分利用有效特征,以conv5_x 輸出特征為主,conv2_x、conv3_x 輸出特征為輔進行特征融合,舍棄conv4_x 模塊的原因是conv4_x 的語義特征沒有conv5_x 模塊明顯,其細節等特征信息沒有conv2_x 和conv3_x 模塊顯著。首先Branch 1 引出conv2_x 模塊的輸出,獲得與conv5_x 相同大小的輸出特征圖,經過全局平均池化得到大小為4×4×256 的特征FBranch1;同理,Branch 2 將conv3_x 模塊的輸出引出,經過全局平均池化得到大小為4×4×512 的特征FBranch2;Branch 3 直接將conv5_x 的輸出引出,得到大小為4×4×2 048 的特征FBranch3。將經過統一尺寸的特征FBranch1、FBranch2、FBranch3融合之后得到大小為4×4×2 816 的特征F。本文在特征F之后加入降維模塊(Dimensionality Reduction Module,DRM),以降低維度和增加特征F的非線性特性,從而增強網絡表達能力。多支路特征融合模型如圖6 所示。

圖6 多支路特征融合模型Fig.6 Multi-branch feature fusion model

2.4 損失函數

本文數據集中鞋類較多,且相似度較高,在訓練過程中存在類間差距不明顯、類內差距較大等問題。因此,在增大類間差距的同時縮小類內差距,提高模型的識別精度,使樣本達到更好的聚類效果。

傳統的Softmax 損失函數將整個空間按照類別個數進行劃分,在分類任務中具有較優的效果,但是Softmax 函數并沒有強調類間分離和類內緊湊。基于此,本文提出聯合Center Loss 訓練的方法。Center Loss 作為一種輔助訓練損失函數,能夠有效縮小類內差距并保持類間差異,Center Loss 函數如式(6)所示:

其中:m為批次大小;xi為全連接層之前的特征;為第yi個類別的特征中心。本文在Softmax 損失函數中加入LS(Label Smoothing),通過在輸出中引入噪聲,降低網絡訓練過擬合現象的發生及網絡對真實標簽的依賴性,以提高模型的泛化能力。本文最終采用的損失函數L如式(7)所示:

其中:LLabel為加入Label Smoothing 的Softmax 損失函數;Lc為Center Loss 函數;λ為Center Loss 函數的權重,本文λ取值0.000 1。

3 實驗與結果分析

3.1 實驗設置

本文實驗操作系統為Linux 3.10.0,是基于PyTorch 深度學習框架展開的算法研究。CPU 為Intel?Xeon?CPU E5-2650 v4 2.20 GHz,顯卡設置為NVIDIA TITAN X(Pascal),顯存12 GHz,深度學習平臺為PyTorch1.2.0,編譯環境為Python3.5.6。輸入圖像尺寸為120×120 像素,采用隨機裁剪、水平翻轉方式進行數據增強處理,采用Adam 作為優化器,初始學習率設置為0.000 1。

3.2 數據集

為驗證本文方法的有效性,本文在構建的多背景數據集上進行測試。數據集是由3 個不同視角的監控攝像頭在中國人民公安大學足跡實驗室采集的圖像,300 類鞋共35 300 張低分辨率鞋子圖像。鞋子圖像由人工手動標注完成,訓練集包含150 雙鞋30 000 張鞋子圖像。測試集包含150 雙鞋300 張鞋子圖像。鞋樣數據庫包含5 000 張混淆樣本和300 張樣本鞋子圖像。多背景數據集的部分數據樣式如圖7 所示。

圖7 多背景數據集的部分數據Fig.7 Partial data of multi-background datasets

3.3 評價指標

為評估模型性能,本文將均值平均精度(mean Average Precision,mAP)和Rank-1 作為評價指標。Rank-1 反映識別排序結果第一位的匹配正確率;mAP 反映模型的整體性能,如下:

其中:TTP為預測正確的正樣本數;FFP為預測錯誤的正樣本數;N為類別總數。

3.4 實驗結果分析

3.4.1 自適應感受野模塊對識別精度的影響

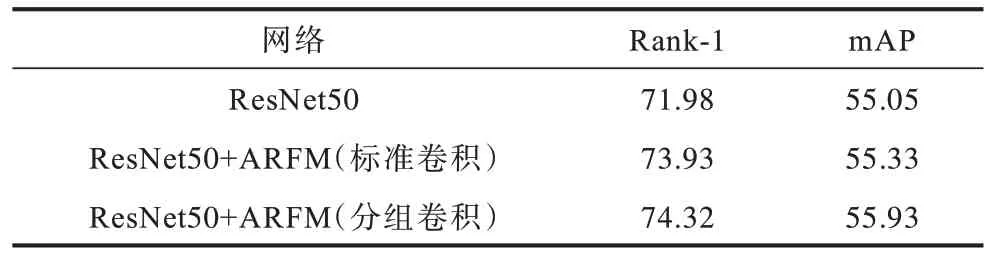

為驗證自適應感受野模塊(ARFM)對網絡識別精度的影響,在多背景鞋子數據集上,本文將對引入自適應感受野模塊的ResNet50 網絡進行測試,實驗結果如表1 所示。

表1 分組卷積和標準卷積對識別精度的影響Table 1 Influence of group convolution and standard convolution on recognition accuracy %

從表1 可以看出,自適應感受野模塊能夠有效提高網絡識別性能,本文采用標準卷積的精度相比于分組卷積的精度略微下降,在ResNet50 網絡中加入ARFM 之后,相比ResNet50,ResNet50+ARFM(分組卷積)的Rank-1 和mAP 精度分別提高2.34 和0.88 個百分點,能夠有效提高識別精度。ARFM 在不降低目標分辨率的同時,使網絡自適應選擇合適大小的感受野特征進行學習,從而提高鞋型識別精度,實驗結果充分驗證自適應感受野模塊的有效性。

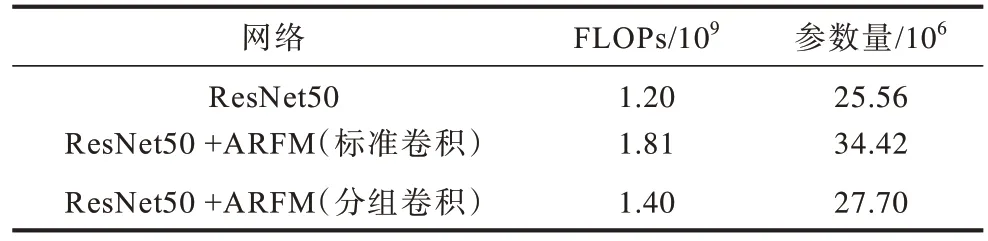

分組卷積和標準卷積對網絡復雜性的影響如表2 所示。本文將ARFM 模塊中的分組卷積替換成標準卷積。從表2 可以看出,相比ResNet50,當使用標準卷積時,自適應感受野模塊參數量增大8.66×106,且網絡浮點運算量增加了0.61×109;當使用分組卷積時,自適應感受野模塊參數量僅增大了2.14×106,浮點運算量增大0.2×109。實驗結果表明,在自適應感受野模塊中采用分組卷積能夠大幅降低參數量和運算量,從而提升網絡訓練效率。

表2 分組卷積和標準卷積對網絡復雜性的影響Table 2 Influence of group convolution and standard convolution on network complexity

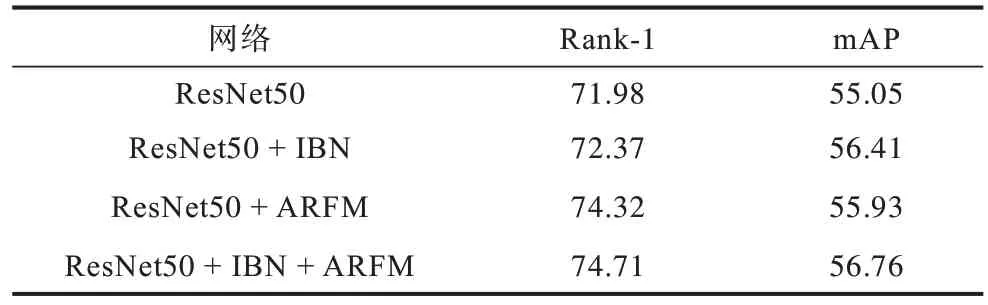

3.4.2 實例與批量標準化對識別精度的影響

在多背景鞋子數據集上,本文對加入實例與批量標準化IBN 的ResNet50 網絡進行測試,自適應感受野模塊與IBN 整體對網絡識別精度的影響如表3所示。

表3 IBN 和自適應感受野模塊對識別精度的影響Table 3 Influence of instance and batch normalization and adaptive receptive field module on recognition accuracy %

從表3 可以看出,相比ResNet50 網絡,在ResNet50 網絡中加入IBN 的Rank-1 和mAP 精度分別提高了0.39 和1.36 個百分點,在ResNet50 網絡中同時使用IBN 和ARFM,Rank-1 和mAP 精度分別提高2.73 和1.71 個百分點。因此,IBN 能夠有效縮小目標差異,在ResNet50 網絡conv2_x 中,每組卷積塊的第一層卷積層之后使用IBN 結構,能夠提高網絡的識別能力,并驗證IBN 結構的有效性。

3.4.3 多支路特征融合模型對識別精度的影響

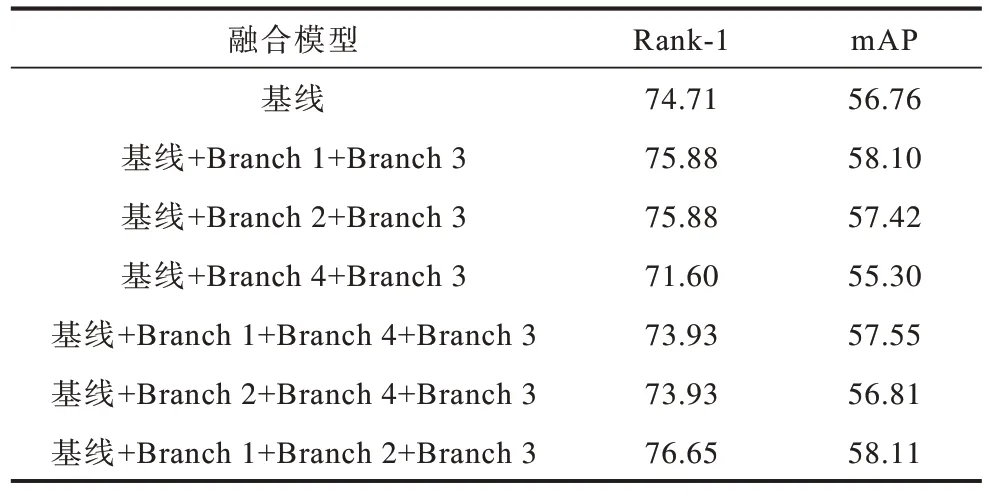

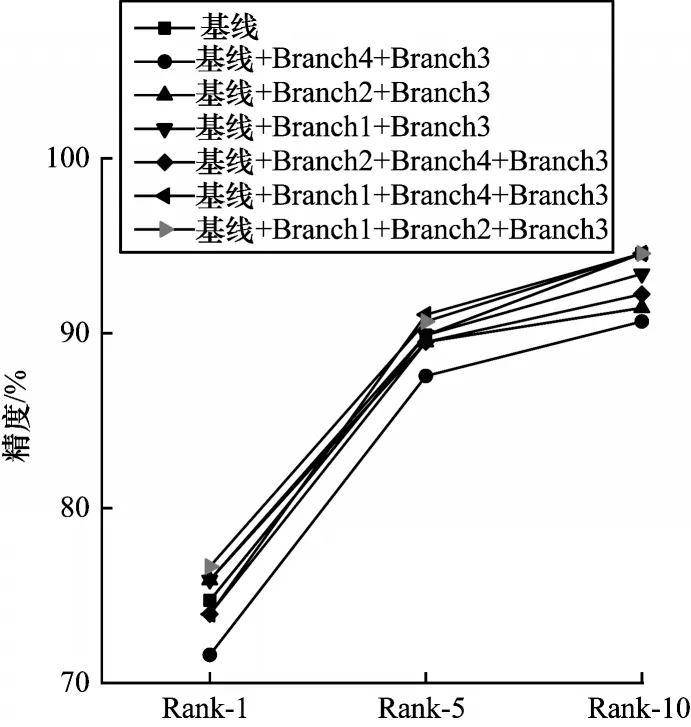

本文算法是在IBN 和ARFM 的ResNet50 網絡基線上引入Branch 1+Branch 2+Branch 3 融合特征進行識別。為驗證多支路特征融合模型的有效性,本文按照相同的融合方式測試Branch 1+Branch 3、Branch 2+Branch 3、Branch 4+Branch 3、Branch 2+Branch 4+Branch 3、Branch 1+Branch 4+Branch 3、Branch 1+Branch 2+Branch 3這6種方法的識別精度,其中Branch 4是conv4_x 引出的分支。多支路特征融合模型的精度對比如表4所示。多支路特征融合模型的Rank-1、Rank-5、Rank-10 對比如圖8 所示。

表4 多支路特征融合模型的精度對比Table 4 Accuracy comparison among multi-branch feature fusion models %

圖8 多支路特征融合模型的Rank-1、Rank-5、Rank-10 對比Fig.8 Rank-1,Rank-5,Rank-10 comparison among multi-branch feature fusion models

從表4 和圖8 可以看出,多支路特征融合模型對網絡識別性能的提升具有顯著效果,在加入IBN 和ARFM 的ResNet50 基線上,將Branch 1、Branch 2 和Branch 3 特征融合之后Rank-1 精度相比基線提高了1.94 個百分點,mAP 精度提高1.35 個百分點,識別精度具有顯著提升。在卷積神經網絡中,單獨使用深層高級語義特征會丟失圖像細節信息,從而影響鞋型識別性能,將神經網絡中淺層紋理、邊緣等細節特征與深層高級語義特征相融合,使得網絡利用魯棒性較優的鞋型特征進行鞋型識別,從而提升識別精度,進一步驗證本文特征融合模型的有效性。

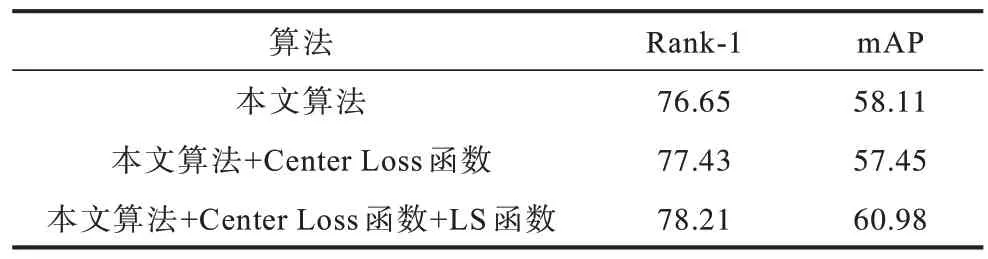

3.4.4 損失函數對識別精度的影響

在多背景鞋子數據集上,本文驗證Center Loss函數和LS(Label Smoothing)函數對識別精度的影響,實驗結果如表5 所示。本文算法加入Center Loss函數和LS 函數的Rank-1 和mAP 分別為78.21%和60.98%。在Softmax 損失函數的基礎上,本文聯合Center Loss 函數訓練網絡在增大類間距離的同時縮小類內差距,使樣本實現更優的聚類效果;在Softmax 損失函數中加入LS 函數能夠有效增強模型泛化性能,避免出現訓練過擬合現象,提高鞋型識別精度。

表5 損失函數對識別精度的影響Table 5 Influence of loss function on recognition accuracy %

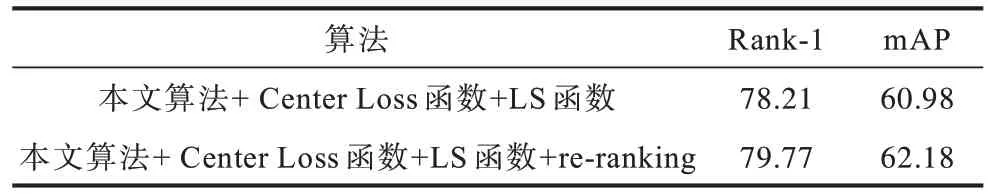

Re-ranking 是圖像檢索領域常用的測試技巧,通過對檢索結果重新排序,提升模型識別性能。本文在測試最終模型性能時加入Re-ranking,實驗結果如表6 所示。

表6 Re-ranking 測試實驗結果Table 6 Experimental results of Re-ranking test %

從表6 可以看出,本文算法具有較優的識別性能,引入Re-ranking 的Rank-1 和mAP 精度分別達到79.77%和62.18%,相比ResNet50 基礎網絡,其Rank-1和mAP 精度分別提高7.79 和7.13 個百分點。

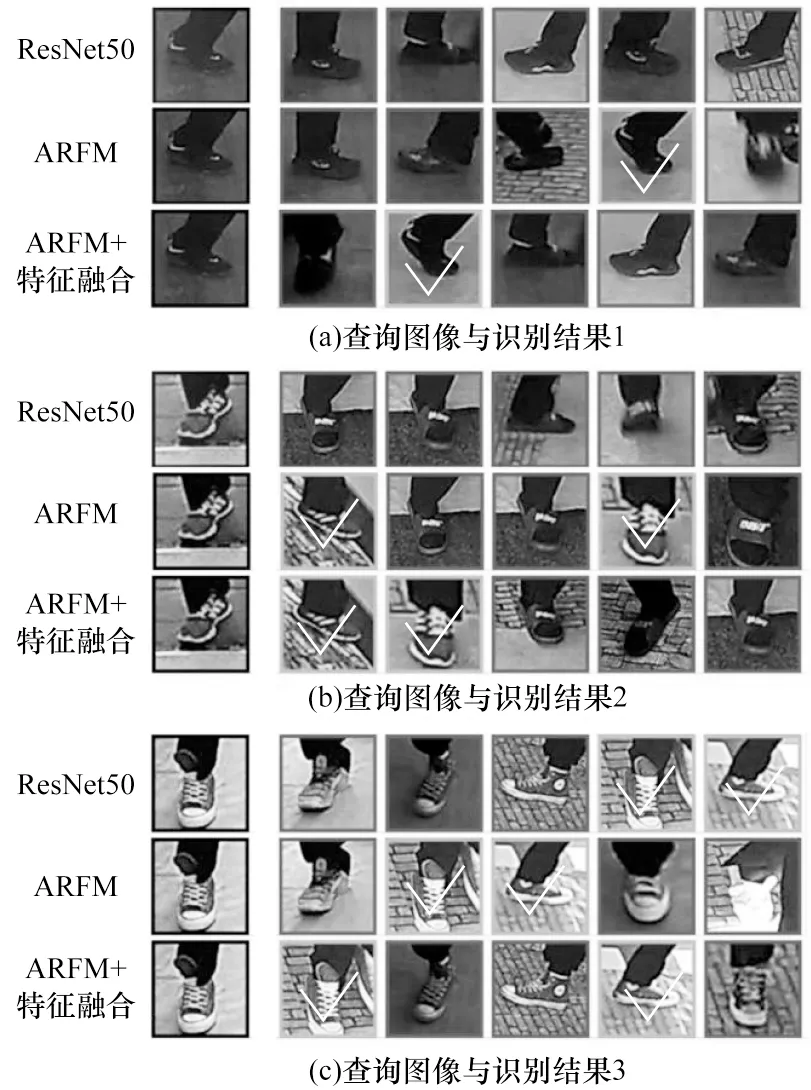

3.4.5 結果可視化

為更加直接展現ARFM、特征融合的有效性,本文在ResNet50、ARFM、特征融合模型上進行部分數據測試,并對Rank-5 結果進行可視化,左側圖像是待查詢圖像,右側5 張圖像是從庫中返回的查詢結果。其中帶有√標志的代表正確的查詢結果。不同算法的識別結果如圖9 所示。從圖9 可以看出,原始ResNet50 網絡識別效果較差,錯誤結果較多,但是在ResNet50 網絡基礎上融合ARFM 和多層特征后,其識別效果顯著提升,同時驗證了本文提出的自適應感受野模塊和多層特征融合模型的有效性。

圖9 不同算法的識別結果Fig.9 Recognition results comparison among different algorithms

4 結束語

本文提出基于自適應感受野與多支路特征融合的鞋型識別算法。設計一種輕量級自適應感受野模塊,實現自適應選擇合適大小感受野特征,提升識別精度,同時融合神經網絡淺層特征和深層特征,在Softmax 損失函數中加入Label Smoothing 并聯合Center Loss 函數對網絡進行訓練。實驗結果表明,本文算法具有較高的識別精度和較強的實用性。在公安實戰中,受監控攝像頭分辨率、天氣等因素的影響,鞋子影像存在極度模糊和色彩、亮度發生變化的情況。因此,下一步將對數據集進行研究,探究超分辨率重建、數據增強等方法對鞋型識別效果的影響,使算法適用于公安實戰工作。