BERT的圖模型文本摘要生成方法研究

摘? 要:基于圖模型的TextRank方法形成的摘要不會脫離文檔本身,但在抽取文本特征的時候,傳統的詞向量獲取方法存在一詞多義的問題,而基于BERT的詞向量獲取方式,充分挖掘了文本語義信息,緩解了一詞多義問題。對不同詞嵌入方法進行了實驗對比,驗證了BERT模型的有效性。基于詞頻統計的相似度計算方法也忽略了句子的語義信息,文中選擇了向量形式的相似度的計算方法用于文本摘要生成。最后在TTNews數據集上做實驗,效果有了明顯的提升。

關鍵詞:中文文本摘要;BERT;TextRank;相似度

中圖分類號:TP 391 ? ? 文獻標識碼:A文章編號:2096-4706(2022)02-0091-06

Abstract: The abstract formed by TextRank method based on graph model will not be separated from the document itself, but when extracting text features, the traditional word vector acquisition method has the problem of polysemy, while the word vector acquisition method based on BERT fully excavates the semantic information of the text and alleviates the problem of polysemy. The experimental comparison of different word embedding methods verifies the effectiveness of the BERT model. The similarity calculation method based on word frequency statistics also ignores the semantic information of sentences. In this paper, the similarity calculation method in vector form is selected for text abstract generation. Finally, the experiment on TTNews data set shows that the effect is obviously improved.

Keywords: abstract of Chinese text; BERT; TextRank; similarity

0? 引? 言

文本摘要作為自然語言處理領域的主要研究方向之一,它的主要任務是信息抽取。在這個互聯網快速發展的時期,每天都能從網上看到大量的文本信息,比如新聞微博等。然而并不是所有的信息都是需要的,我們都只關注自己所關心的內容,如何從大量的文本里面抽取到關鍵信息以幫助人們快速獲得自己想要的信息,是本篇論文主要討論的問題。文本摘要的主要任務就是抽取關鍵信息,進而可以解決這一問題,文本摘要旨在幫助人們從大量的文本信息中快速找到自己關注的信息。如果把含有幾千字的文章縮寫成幾百字,那么讀者就可以很輕松地了解到文章的主旨,摘要分為“人工摘要”和“自動摘要”,人工摘要由讀者自己閱讀總結得到,可能需要花費讀者大量的時間和精力,自動摘要是由機器得到的。

文本摘要可以分為抽取式摘要、生成式摘要[1]和混合式摘要。抽取式摘要可以簡單概括為從原文檔中抽取出一個或者多個句子拼接在一起構成摘要,這樣得到的摘要不會脫離文檔本身,既簡單又實用。抽取式摘要主要思想是對文檔的每句話打分,句子的重要程度就是根據分數的高低來判定的,按照分數的高低對每個句子排序,分數高的前幾個句子被抽取出來形成摘要。生成式摘要和抽取式摘要不同,它重在提取每個句子的特征,獲取文檔的主要思想后,重新組織語言生成新的句子組成摘要。混合式摘要就是將上述兩種方法結合在一起生成的摘要稱為混合式摘要。

文本摘要又可以按照文檔的其他形式劃分,比如按照文檔數量劃分,分為單文檔摘要和多文檔摘要[2],這兩者只是在文檔數量上有所不同,單文檔是指只針對一篇文檔,多文檔針對同一類型的多篇文檔處理,最后生成的摘要包含了這些文檔的主題信息。

1? 相關工作

1.1? 文本摘要研究現狀

抽取式文本摘要簡單實用,目前也出現了很多抽取式摘要生成方法,其中在工業方面應用的比較廣泛,目前主要的技術方法有基于主題模型、基于圖模型、特征評分、深度學習,等等。

1958年Luhn[3]提出了基于高頻關鍵詞給文章句子排序得到摘要的方法。Kupiec[4]等人采用了樸素貝葉斯分類器來計算一個句子是否為摘要句的概率。Aone[5]提出了TF-IDF[6]方法來計算某個句子成為摘要句子的概率。Conrog[7]等人運用馬爾可夫模型來抽取摘要句子。

上述幾種方法都是基于統計特征為基礎的摘要方法。這幾種方法得到的摘要的可讀性不是很好,為了繼續完善自動摘要提取方法,GunesErkan和Rad等人[8]提出了TextRank方法,這個算法計算每兩個句子之間的相似度,計算每個句子占全文信息的比重,選擇比重較高的前幾個句子組成摘要。隨著深度學習不斷地發展,生成式摘要也逐漸得到了廣泛的研究。2014年Google提出的序列到序列模型[9]最開始應用在翻譯任務中;2015年Facebook公司的Rush等人[10]將深度學習的端到端的方法首次應用到摘要的生成任務中,得到了很好的效果;Chopra等人[11]用卷積神經網絡編碼原文信息,采用循環神經網絡進行解碼生成了更加連貫的摘要;Nallapati[12]等在編碼階段使用雙向循環的神經網絡,還對低頻詞進行了處理;2016年谷歌[13]發布的摘要模型采用了集束搜索(Beam-Search)來生成摘要,這種方法在編碼和解碼的部分采用的是循環神經網絡,避免時間和空間的浪費;2018年谷歌發布BERT[14]模型,這個模型被多次應用在自然語言處理任務中,都取得了比較好的效果。

1.2? 主要工作

在以往的NLP任務中,詞向量的表示方法有One-Hot方法,可是One-Hot編碼方式存在維度過高的缺點,計算量非常龐大。2013年Mikolov等人提出了基于分布式的詞嵌入方式Word2Vec方法,這個方法網絡結構簡單,訓練的中文語料比較少,不能提取句子的深層語義信息。2018年由Jacob Devlin等人研發出BERT[14]模型,BERT內部主要由Transformer[15]組成,該模型網絡結構復雜,訓練的中文語料比較多,充分提取文檔的語義特征,緩解了一詞多義問題。本文選用BERT模型,是因為BERT模型使用雙向Transformer編碼器,Transformer模型能夠抽取句子的特征,得到的詞向量會隨著上下文語境的改變而動態變化,使句子的語義表達更準確,比如“蘋果公司”和“吃個蘋果”,“蘋果”在第一個句子中代表的是一個品牌的名字,在第二句話中表示的是水果的意思,BERT在對蘋果這個詞進行編碼的時候會根據其所在的上下文不同而改變編碼的詞向量,使其更符合所表達的含義。對于之前從未考慮過的詞的位置信息影響語義的表達的問題,比如像“明天你去我家”和“明天我去你家”,意思完全不一樣,BERT加入Position Embedding來保留位置信息,使相同的詞在不同的位置的時候表達的語義信息更加準確。本文將其他詞嵌入方法與BERT模型用于文本摘要做了實驗對比,BERT相比較其他模型來說能達到比較好的效果。將微調后的BERT用來預處理文本,原始的BERT輸出是針對Token的而不是句子,并且原始BERT的輸入只有兩個句子,不適合做文本摘要任務,所以,為了使它更加適合文本摘要任務,需要對BERT模型做一些修改。在每個句子句首加上[CLS]標簽,每個句子的末尾都有一個[SEP]標簽,[CLS]標簽可以區分每一個句子,BERT可以輸入多個句子,給句子進行編碼構成特征向量,用于文本摘要任務。基于圖模型的方法處理文本信息,通常以單詞或者句子作為處理文本單元,在抽取式文本摘要中,主要以句子為文本單元進行處理,將句子作為頂點,2個相似的點用邊連接起來構成圖,利用圖排序算法,比如TextRank算法對句子進行打分排序。這種方法依賴句子之間的相似度,主要進行任意句子之間的相似性計算和迭代計算,TextRank算法是基于PageRank算法改進而來。傳統的TextRank模型在計算句子的相似度時用的是基于詞頻的統計方式,這種方法沒有考慮到句子語義方面的信息,比如像“你美不”“你不美”這類的句子,沒有考慮到他們的語義層面的信息,結果存在不必要性。本文用余弦相似度的計算方法代替了傳統的詞頻統計方法,結果得到了明顯的改善。本文研究內容主要有:

(1)基于BERT的句向量表示。通過word2vec或者glove方法抽取淺層的文本特征來對基本語義單元進行向量化表示,而后依據相應算法計算句子的權重,這種方法存在一詞多義問題,抽取得到的摘要句精確度低,連貫性差。針對這一問題使用BERT對句子進行向量化表示,學習和開發深層次的語義特征,效果有明顯改善。

(2)句子的相似度度量。用TextRank方法做抽取式摘要,計算每兩個句子之間的相似度時,用的是基于詞頻的相似度度量方法,這種方法忽視了句子的上下文信息,針對這一問題本文對比了其他的相似度度量方法進行研究。

(3)關于TTNews的文本摘要生成。將本文的文本摘要生成方法用于TTNews數據集上,用其他方法和本文方法做了實驗對比,運用ROUGE評價方法評測了摘要的質量。

2? 研究方法

獲取句子的向量形式,本文使用改進的BERT方法,原始的BERT輸出是針對Token而不是句子,并且原始BERT的輸入只有兩個句子,不適合做文本摘要任務,所以,需要對BERT模型做一些修改。在每個句子句首加上[CLS]標簽,使[CLS]標簽可以區分每一個句子,同時BERT可以輸入多個句子。使用BERT來獲取句子的表示向量,借助BERT模型的強大表示能力,更好地捕捉句子的上下文信息。用TextRank算法對文本進行抽取處理,將文檔中重要的句子抽取出來組合在一起,生成新的文本摘要。

2.1? BERT的模型

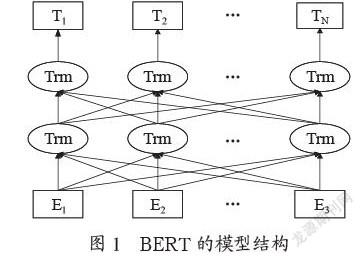

圖1為BERT的模型結構,BERT內部主要由多層Transformer構成。Transformer基本結構是Encoder-Decoder,Encoder表示編碼器,Decoder表示解碼器Transformer由這兩者組合而成。

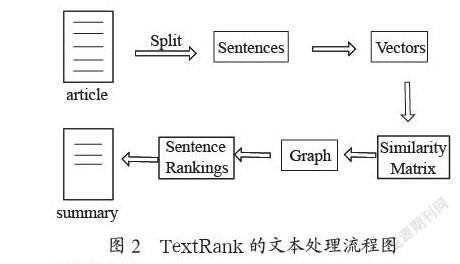

2.2? TextRank圖模型

TextRank做文本摘要,針對單個文檔首先根據標點符號進行句子分割,針對每個句子獲得句子的向量表示,構建相似度矩陣,然后以句子為頂點,相似度作為邊表示成圖的形式,最后計算每個頂點的得分,把得分最高的前幾個句子抽取出來構成文檔的摘要,其流程圖如圖2所示。

具體流程為:

(1)將文檔按照: , ? ! 。 ; “”等標點符號劃分成一系列的句子。

(2)文本預處理,去除停用詞,然后進行(jieba)分詞,得到句子中詞的詞向量,對詞向量求平均作為句子的向量表示。

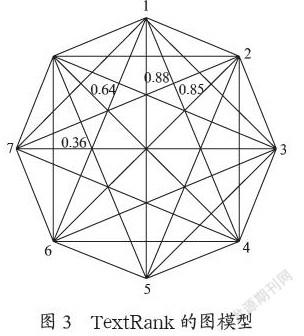

(3)計算每兩個句子之間的相似度值,然后以句子為頂點,相似度值作為邊,將兩個頂點連接構成圖如圖3所示。

(4)計算每個句子的得分值。

(5)最后按照分數高低排序,得分高的前幾個句子抽取出來構成摘要。

TextRank圖模型如圖3所示,每個頂點代表的是文本中的句子,兩個頂點連線上的數字為兩個句子之間的相似度。

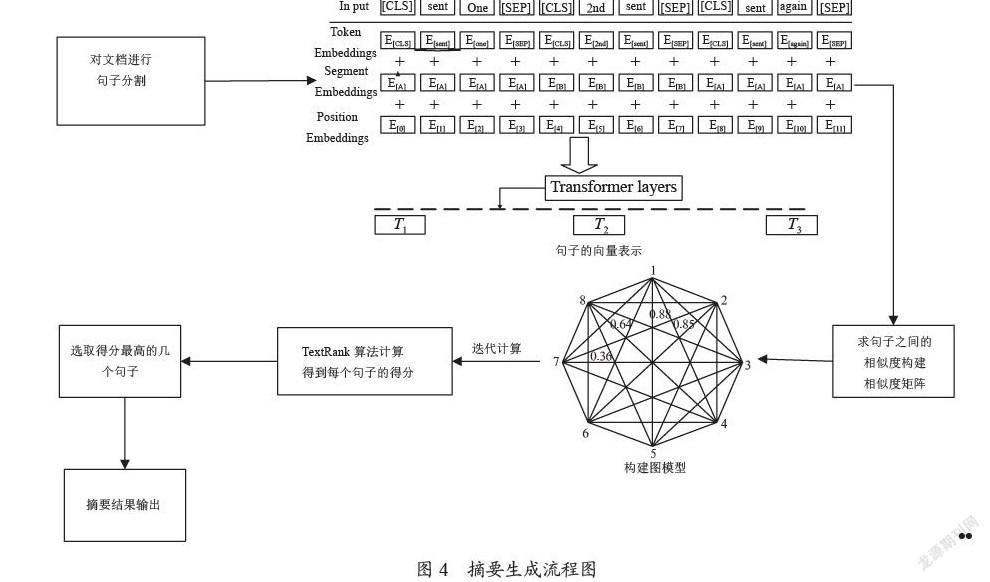

2.3? 本文方法

摘要生成的流程圖如圖4所示,首先根據標點符號對文檔進行句子分割,然后送入BERT模型,BERT模型首先對文檔每個句子進行處理,在每個句子開頭加[CLS]標簽,句子的末尾加上[SEP]標簽,句子表示成圖4(TokenEmbedding+SegmentEmbedding+PositionEmbedding)的形式,BERT模型內部有多個Transformer層,經過這些Transformer層處理后輸出每個句子的向量表示形式。然后求每兩個句子之間的相似度值,構建相似度矩陣,以每個句子為頂點,句子之間的相似度作為邊構建圖模型,最后求每個句子的得分值,選取得分高的幾個句子作為文檔的摘要。

2.3.1? 文本句向量表示

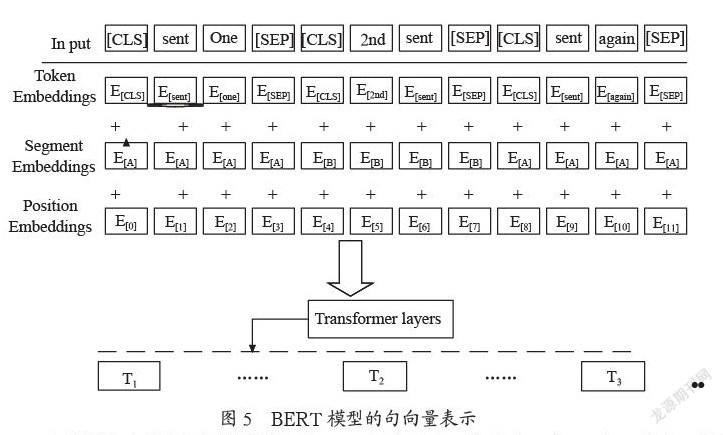

給定一篇文檔D={S1,S2,S3,…,Sn}(其中n表示文檔的第n個句子),BERT模型的句向量表示如圖5所示。

原始的BERT輸出是針對Token的而不是句子,由于原始BERT模型不適合文本摘要任務,所以,需要對模型做一些修改。在每個句子句首加上[CLS]標簽,句子的末尾都有一個[SEP]標簽,因此模型可以區分開每一個句子。

TokenEmbeddings:先得到每個詞的詞向量形式;

SegmentEmbeddings:根據i的奇偶性來決定這個句子的段嵌入為EA或者EB;

PositionEmbeddings:根據詞在文檔中的位置訓練得到;

將上面三個向量相加TokenEmbedding+SegmentEmbedding+PositionEmbedding作為BERT模型的輸入。即:

(1)將每個句子用向量表示出來保存在[CLS]中。

(2)經過BERT模型,得到每個句子的向量表示,這種向量表示包含句子的上下文信息,考慮到了句子語義層面的信息。

BERT模型與其他模型相比,可以充分挖掘詞的上下文的信息,獲得含有語義信息的向量表示形式,因此可以在一定程度上緩解多義詞問題。

2.3.2? 摘要句抽取

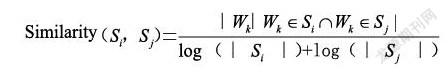

TextRank算法求句子的相似度,是基于詞頻的統計方式,忽視了句子之間的語義信息。計算公式為:

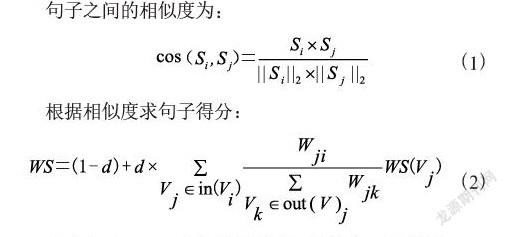

(Si,Sj表示第i個句子和第j個句子,wk表示第k個詞)這種計算方法僅僅通過統計兩個句子之間的公有詞的個數來計算句子之間的相似度,沒有考慮任何語義層面的信息。本文用BERT模型獲取的句子的向量來計算相似度,因為BERT模型使用雙向Transformer編碼器,即讓兩個Transformer特征抽取器分別從左到右和從右到左掃描輸入序列。BERT加入Position Embedding來保留位置信息,使相同的詞在不同的位置的時候表達的語義信息更加準確。本文通過用余弦相似度的計算方法計算相似度,這個方法正是計算兩個向量之間的方向關系,這樣求得的句子之間的相似度更能表達兩個句子之間的關系。

本文也考慮了用歐氏距離[16]來計算兩個句子的相似度,可因為歐氏距離主要用來計算兩個點之間的距離,和兩個點之間的坐標信息有關,而語義層次的信息并不關心數值的大小,更多的是關注兩個向量在方向上是否更加接近。基于此,余弦相似度的度量方法可以更有效地表示兩個句子之間的相似度關系。

給定文檔D,劃分句子D={S1,S2,S3,…,Sn}。以句子為頂點,構建圖G(V,E),其中V代表句子的集合,E是邊的集合,句子之間的相似度作為構成圖的邊的權值。

式(2)中,WS(Vi)表示頂點i的得分,d的值為0.85。in(Vi)代表所有指向點i的點,Wji表示點j和點i之間的邊的權值,out(Vj)表示所有從點j指向其他頂點的點,Wjk表示點j和點k的邊的權值,WS(Vj)表示頂點j的得分。

根據式(2)得到每個句子的得分值,本文選取得分比較高的前三個句子作為文檔的摘要。

3? 實驗分析

3.1? 實驗數據

文章提出的方法用在了TTNews corpus數據集上,取得分最高的前三句作為文本摘要,并與其他三個抽取式摘要方法做了對比。

3.2? 實驗環境及參數設置

實驗環境:Pytorch 1.8.1,Tensorflow 1.9.0,Torchvision 0.8,Cuda 9.2。

實驗使用的BERT-base模型共12層即12個encoder單元,隱藏層768維,12個attention,序列長度為128。

3.3? 評價指標

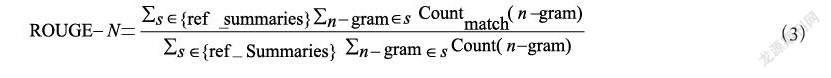

文中用ROUGE[15]作為文本自動摘要的評價指標,Rouge方法比較本文生成的摘要與數據集給出的標準摘要的重疊單元,來評價模型生成摘要的質量。本實驗用ROUGE-1、ROUGE-2、ROUGE-L這三個值作為評價指標對得出的摘要進行評價。

式(3)中n代表比較文本單元的長度,Countmatch代表的是同時出現在標準摘要和機器生成的摘要的文本的數目。

ROUGE-L表示的是標準摘要和本文生成的摘要的最長公共子序列的長度占標準摘要的比例。

3.4? 實驗結果與分析

實驗進行了2000次迭代,文中介紹的抽取式摘要方法和其他抽取式摘要方法都在TTNews數據集上做了比較。從解決一詞多義方面考慮,首先對word2vec、glove、BERT三種不同的詞嵌入方法做了實驗對比,結果如表1所示,從中可以看出相比較其他詞向量表示方法,文中采用的方法效果更好。

對于不同的相似度計算方法,對比了TextRank原始的詞頻統計方式、歐氏距離相似度算法,以及文中用的余弦相似度算法,相似度比較結果如表2所示。從中可以看出,文中選用的余弦相似度計算方法判斷兩個句子之間的相似性精確度有了明顯的提升。

最后,用文中提出的抽取式摘要方法與其他幾個抽取式摘要方法做了實驗對比,結果如表3所示。

Lead3方法:選取文章的前三個句子作為文章的摘要部分。這種方法雖然簡單方便,但是存在信息覆蓋不全,容易損失信息的缺點。

TextRank[17]方法:構建圖模型,用算法為文檔的每個句子按照得分排序。此方法經過本文方法的改進后,摘要信息的準確率得到了明顯的提升。

TF-IDF方法[6]:根據每個句子中詞語的TF-IDF值來計算句子的得分,句子的重要性根據詞的重要性之和來估計,選取重要性高的幾個句子作為摘要。這種方法句子的重要性主要通過“關鍵詞”來衡量,得到的摘要存在片面,信息涵蓋不全,不連貫等缺點。

從表3中可以看出本文提出的方法和其他幾種方法相比,ROUGE-1、ROUGE-2、ROUGE-L的值都有所提升。說明本文提出的方法生成的摘要準確性和可讀性有一定的保障。

4? 結? 論

文中主要介紹了一種對TextRank方法進行改進而得到的一個抽取式文本摘要方法,分別介紹了BERT的模型結構和TextRank處理文本的流程及原理,以及計算句子相似度的方法。因為近些年BERT模型在NLP領域處理文本的時候效果都比較好,所以選擇了BERT模型來進行處理文本。文中首先對BERT進行改進,使它適用于處理多個句子,對多個句子進行向量表示。然后基于TextRank的思想對句子進行打分處理。就是將兩種模型綜合在一起使用,然后選擇了合適的文本相似度度量方法,最后將得到的文本摘要同標準摘要進行對比分析。文中提出的方法雖然準確率得到了提升,但是得到的文本摘要還達不到非常好的效果,比如句子不夠通順、存在句子冗余等問題,文本摘要在自然語言處理領域還有待發展。

參考文獻:

[1] MIHALCEA R,TARAU P. TextRank:Bringing Order into Texts [EB/OL].[2021-11-12].https://digital.library.unt.edu/ark:/67531/metadc30962/m1/1/.

[2] 胡俠,林曄,王燦,等.自動文本摘要技術綜述 [J].情報雜志,2010,29(8):144-147.

[3] LUHNHP. The automatic creation of literature astracts [J].IBM Journal of Research and Development,1958,2(2):159-165.

[4] KUPIEC J,PEDERSEN J O,CHEN F. A trainable document summarizer [C]//18th annual international ACM SIGIR conference on Research and development in information retrieval.New York:Association for Computing Machinery,1995:68-73.

[5] AONE C,OKUROWSKI M E,GORLINSKY J,et al. A rainable summarizer with knowledge acquired from robust NLP techniques [M]//INDERJEET M,MARK M T.Advances in Automatic Text Summarization,Cambridge:The Mit Press,1999:71-80.

[6] SALTON G,BUCKLEY C.Term-weighting approaches in automatic text retrieval [J].Information Processing & Managem-ent,1988,24(5):513-523.

[7] CONROY J M,OLEARY D P. Text summarization via hidden Markov models [C]//SIGIR ‘01: Proceedings of the 24th annual international ACM SIGIR conference on Research and development in information retrieval,New Orleans:Association for Computing Machinery,2001:406-407.

[8] ERKAN G,RADEV D R. LexRank:Graph-based Lexical Centrality as Salience in TextSummarization [J/OL].arXiv1109.2128[cs.CL].[2021-11-23].https://arxiv.org/abs/1109.2128.

[9] BAHDANAU D,CHO K,BENGIO Y. Neural Machine Translation by Jointly Learning to Align and Translate [J/OL].arXiv:1409.0473 [cs.CL].(2014-09-01).https://arxiv.org/abs/1409.0473,2014.

[10] RUSH A M,CHOPRA S,WESTON J. A Neural Attention Model for Abstractive Sentence Summarization [C]//Proceddings of the 2015Conference on Empirical Methods in Natural Language Processing.Lisbon:Association for Computational Linguistics,2015:379-389.

[11] CHOPRA S,AULI M,RUSH A M. Abstractive sentence summarization with attentive recurrent neural networks [C]//Proceddings of the Annual Conference of the North American Chapter of the Association for Computional Linguistics:Human Language Technologies.San Diego:Association for Computational Linguistics,2016:93-98.

[12] NALLAPATI R,ZHOU B W,SANTOS CND,et al. Abstractive Text Summarization Using Sequence-to-sequence RNNS and Beyond [C]//Proceddings of the 20thSIGNLL Conference on Computational Natural Language Learning.Berlin:Association for Computational Linguistics,2016:280-290.

[13] ABADI M,BARHAM P,CHEN J,et al. Tensor Flow:Asystem for large-scale machine learning [C]//The Processing of the 12th USENLX Symposium on Operating Systems Design and Implementation.Savannah:USENIX Association,2016:265-283.

[14] DEVLIN J,CHANG M W,LEE K,et al. BERT:Pre-training of Deep Bidirectional Transformers for Language Understanding [J/OL].arXiv:1810.04805 [cs.CL].[2021-11-23].https://arxiv.org/abs/1810.04805v1.

[15] 王侃,曹開臣,徐暢,等.基于改進Transformer模型的文本摘要生成方法 [J].電訊技術,2019,59(10):1175-1181.

[16] Cjayz.文本相似度算法研究[EB/OL].[2021-11-23].https://www.docin.com/p-2221663292.html.

[17] MIHALCEA R,TARAU P. TextRank:Bringing Order into Texts [C]//Proceedings of the 2004 Conference on Empirical Methods in Natural Language Processing.Barcelona:Association for Computational Linguistics,2004:404-411.

作者簡介:黃菲菲(1995—),女,漢族,河南商丘人,碩士在讀,研究方向:自然語言處理。