利用改進(jìn)型VGG標(biāo)簽學(xué)習(xí)的表情識別方法

程學(xué)軍,邢蕭飛

(1.河南工業(yè)大學(xué)漯河工學(xué)院 信息工程學(xué)院,河南 漯河 462000;2.廣州大學(xué) 計算機(jī)科學(xué)與網(wǎng)絡(luò)工程學(xué)院,廣東 廣州 528225)

0 引 言

人臉表情是最直接、最明顯的情感表達(dá)方式,對其有效的識別具有重要的理論意義和實用價值[1,2]。而實際中,光照變化致使人臉表情識別面臨著各種挑戰(zhàn),研究有效適用性強(qiáng)的人臉表情識別方法顯得更為迫切[3]。

對于計算機(jī)來說,人臉表情識別技術(shù)的本質(zhì)是對采集圖像中海量數(shù)據(jù)進(jìn)行優(yōu)化處理。因其采集圖像存在多樣性和復(fù)雜性,計算機(jī)處理系統(tǒng)會面臨樣本數(shù)據(jù)非線性不確定性的問題[4]。而傳統(tǒng)處理方法如主成分分析、尺度不變特征轉(zhuǎn)換等方法,也存在模型簡單、參數(shù)設(shè)置復(fù)雜等問題。

深度神經(jīng)網(wǎng)絡(luò)則可實現(xiàn)對圖像數(shù)據(jù)的深度提取,并基于自身網(wǎng)絡(luò)的不斷學(xué)習(xí),對于網(wǎng)絡(luò)模型參數(shù)也可進(jìn)行及時調(diào)整,以滿足識別場景多樣性和表情識別準(zhǔn)確性的需求[5,6]。

借鑒于現(xiàn)行深度學(xué)習(xí)技術(shù),提出了一種利用高斯特征提取結(jié)合改進(jìn)型VGG-16網(wǎng)絡(luò)模型的人臉表情識別方法。主要創(chuàng)新點總結(jié)如下:

(1)為更好支撐VGG-16神經(jīng)網(wǎng)絡(luò)對被測圖像的表情識別,基于改進(jìn)的高斯混合模型對圖像數(shù)據(jù)及采集數(shù)據(jù)進(jìn)行圖像重建并實現(xiàn)特征的提取;

(2)針對傳統(tǒng)神經(jīng)網(wǎng)絡(luò)的圖像識別忽略表情關(guān)聯(lián)性問題,基于VGG-16神經(jīng)網(wǎng)絡(luò)模型對圖像特征采集進(jìn)行相關(guān)情感標(biāo)簽分布學(xué)習(xí)和正則化學(xué)習(xí),實現(xiàn)判別性區(qū)分,從而提高識別準(zhǔn)確度;

(3)面向在線表情實時識別的需求,采用小批量梯度下降法簡化網(wǎng)絡(luò)訓(xùn)練模型目標(biāo)函數(shù),減小運行內(nèi)存,提高模型對于表情識別的時效性。

1 相關(guān)工作

人臉表情識別研究涉及特征提取、圖像理解、數(shù)據(jù)分析和表情分類等內(nèi)容,其研究成果對于計算機(jī)視覺、認(rèn)知科學(xué)、心理學(xué)等領(lǐng)域有著重要意義。目前已有一定研究人員對人臉表情識別展開研究,其目的是對面部圖像6種基本情緒表情準(zhǔn)確分類識別,包括[7,8]:憤怒(An)、厭惡(Di)、恐懼(Fe)、快樂(Ha)、悲傷(Sa)和驚訝(Su)。

傳統(tǒng)的人臉表情識別方法主要為表觀特征法和模型法兩種方法。主成分分析法作為表觀特征法的代表方式之一,基于近似理論通過尋找最小均方值[9,10],獲取原始數(shù)據(jù)的最大可能投影方向,但其運算量較大,且不計及圖像細(xì)節(jié)機(jī)構(gòu)信息;Gabor濾波算法可有效提供測圖像數(shù)據(jù)細(xì)節(jié)信息[11],實現(xiàn)多數(shù)據(jù)多維度識別分析,但存在決策數(shù)據(jù)維數(shù)過高的問題,不滿足實時表情識別的需求;點分布模型(point distribution model,PDM)是一種模型化的圖像識別方法,其可計及圖像表情的形狀特征和紋理特征進(jìn)行綜合考慮統(tǒng)一建模,實現(xiàn)圖像特征準(zhǔn)確提取,但同樣面臨計算復(fù)雜的問題,并且存在場景自適應(yīng)能力差的缺陷[12]。

機(jī)器學(xué)習(xí)可通過網(wǎng)絡(luò)模型中多層網(wǎng)絡(luò)結(jié)構(gòu)的迭代分析決策,基于海量數(shù)據(jù)進(jìn)行自主分析決策,以強(qiáng)大的學(xué)習(xí)能力實現(xiàn)人臉表情識別的實時性和準(zhǔn)確性。針對面部表情識別問題,文獻(xiàn)[13]提出了一種基于概率融合的卷積神經(jīng)網(wǎng)絡(luò)模型,采用卷積整流線性層作為第一層并實時調(diào)整模型訓(xùn)練參數(shù)和架構(gòu)來適應(yīng)CNN的體系結(jié)構(gòu),具有較好的識別準(zhǔn)確性;文獻(xiàn)[14]采用多任務(wù)深度卷積網(wǎng)絡(luò)(multiple task deep convolution neural network,MTCNN)檢測人臉的界標(biāo)點,并通過冗余去除和降維改進(jìn)實現(xiàn)圖像微表情中光流特征的高效提取,基于對課堂教學(xué)中的實際應(yīng)用驗證方法合理性;文獻(xiàn)[15]提出一種基于深度信念網(wǎng)絡(luò)(deep belief network,DBN)使用簡化特征的半監(jiān)督情感識別算法,首先將特征提取應(yīng)用于面部圖像,然后進(jìn)行特征約簡,降低錯誤和無效的特征數(shù)據(jù)信息。

但以上方法均沒有對各種表情之間的關(guān)系進(jìn)行闡釋分析,表情是由多個面部動作模塊組合而成,其面部動作模塊的變化并不是完全相同;其次,同一面部動作模塊的運動存在于不同的表情中。根據(jù)普魯奇克的情緒之輪理論,大多數(shù)情緒都是以基本情緒的組合、混合或復(fù)合形式出現(xiàn)的。同時,人類的面部表情往往是不同情緒的融合或復(fù)合,而不是單一的基本感覺。從這個意義上說,面部表情是模糊的或相關(guān)的,即可以使用多個表情數(shù)來描述人臉的外觀。因此,以上方法存在復(fù)雜場景下可能無法描述不同情緒中的相關(guān)性或模糊性,導(dǎo)致圖像表情識別低下的問題。VGG網(wǎng)絡(luò)結(jié)構(gòu)非常簡潔,可通過不斷加深網(wǎng)絡(luò)結(jié)構(gòu)可以提升性能,以實現(xiàn)多場景多噪聲環(huán)境下圖像表情準(zhǔn)確區(qū)分與識別[16]。文獻(xiàn)[17]提出了一種改進(jìn)的VGG網(wǎng)絡(luò)的表情識別模型,該模型優(yōu)化了網(wǎng)絡(luò)結(jié)構(gòu)和網(wǎng)絡(luò)參數(shù),并通過遷移學(xué)習(xí)技術(shù)來克服圖像訓(xùn)練樣本的不足。文獻(xiàn)[18]基于VGG網(wǎng)絡(luò)模型對面部表情和人聲變化進(jìn)行識別,評估3種不同數(shù)據(jù)模式輸入中的躁動級別分類的有效性:單獨的語音觀察、單獨的視覺面部觀察以及組合的語音和面部觀察,顯著提升表情和人聲的識別率。

基于VGG深度神經(jīng)網(wǎng)絡(luò)的易擴(kuò)展、自適應(yīng)能力強(qiáng)等優(yōu)點,結(jié)合高斯特征提取方法,提出了一種近紅外人臉表情識別方法,該方法能更好地提取圖像特征,并通過面部表情的基本情緒賦值,實現(xiàn)表情的準(zhǔn)確識別。

2 紅外人臉特征提取

為了更好地支撐VGG-16神經(jīng)網(wǎng)絡(luò)對圖像特征的訓(xùn)練和學(xué)習(xí),以滿足更加精確的人臉表情識別,通過極大化數(shù)據(jù)模型對高斯混合模型進(jìn)行改進(jìn),實現(xiàn)對圖像采集數(shù)據(jù)的圖像重建和特征提取。

2.1 紅外人臉圖像的重建

由于采集的紅外人臉圖像存在圖像像素分布不均勻問題,需要對其進(jìn)行圖像重建的操作。首先通過極大化數(shù)據(jù)模型的相似度對圖像模型數(shù)據(jù)參數(shù)進(jìn)行針對性提取,并基于極大似然擬合算法計算該模型的熵值和高斯度數(shù)值,繼而可將模型轉(zhuǎn)化為高斯混合模型,以此將采集模型轉(zhuǎn)化為熱紅外人臉高斯混合模型[19]。

圖像重建操作具體操作如下:

(1)模型期望概率數(shù)值計算:對采集圖像的各像素隸屬k區(qū)域概率。C為模型概率矩陣,cik為圖像中像素xi可歸于區(qū)域k的期望數(shù)值,具體計算公式為

(1)

式中:pk為當(dāng)前估計值計算概率矩陣C中元素cik的期望概率。

(2)模型鄰域概率計算:對每個像素相鄰8個鄰域隸屬概率值進(jìn)行加權(quán)值計算。需要注意的是,在該步驟計算時需要對概率矩陣C和權(quán)重系數(shù)P′i進(jìn)行迭代更新:

首先,對采集圖像的像素xi的鄰域隸屬概率的加權(quán)平均系數(shù)Pik進(jìn)行計算;將加權(quán)平均值矩陣P設(shè)為n×K的矩陣,矩陣中元素Pik可通過下式進(jìn)行計算表示

(2)

式中:∑8(xi)為像素xi鄰域的8個附鄰區(qū)域;υij為像素xi的鄰域像素xj對其的影響量化因子;cjk為鄰域像素xj可隸屬區(qū)域的概率。

其次,對模型概率矩陣C進(jìn)行更新迭代計算,判斷xi像素是否為自由像素,若xi是,將概率cik的類歸屬于元素Pik的相同類;若xi否,則將加權(quán)平均參數(shù)Pik替換為更新后的概率矩陣。

再次,依據(jù)更新后的模型期望矩陣計算相應(yīng)像素的權(quán)重值,計算公式為

(3)

(3)混合模型參數(shù)獲取:基于極大化數(shù)據(jù)模型的似然度計算獲取混合模型的相應(yīng)參數(shù)。計算公式為

(4)

(5)

(6)

L[X|φ(pk,μk,σk)]=f[X|φ(pk,μk,σk)]=

(7)

(8)

(4)模型轉(zhuǎn)換:采用極大似然擬合將圖像模型轉(zhuǎn)換成高斯混合模型,主要可以分為3個步驟:

1)首先對模型對應(yīng)像素Rk的理論最大熵值進(jìn)行計算

(9)

2)計算模型像素Rk的真實熵值

(10)

其中,采集圖像中像素Rk鄰域所對應(yīng)的總頻率記為frj。

3)實現(xiàn)模型似然度最大化,并計算模型的高斯度G

(11)

若模型中高斯度G→0,證實采集圖像數(shù)據(jù)模型已完整轉(zhuǎn)換為高斯混合模型,完成相應(yīng)的熱紅外高斯混合人臉圖像重建。

2.2 紅外特征提取

在上文對于采集圖像高斯混合模型化的基礎(chǔ)上,選擇圖像中區(qū)域特征點標(biāo)注為圓心Os,s=1,2,…,nk。為保證不出現(xiàn)重疊圓的現(xiàn)象,對相應(yīng)區(qū)域的像素計算距離圖像邊緣的歐幾里得距離d并獲取相應(yīng)的圖像半徑rjk

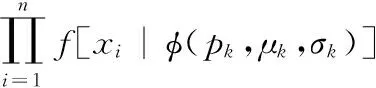

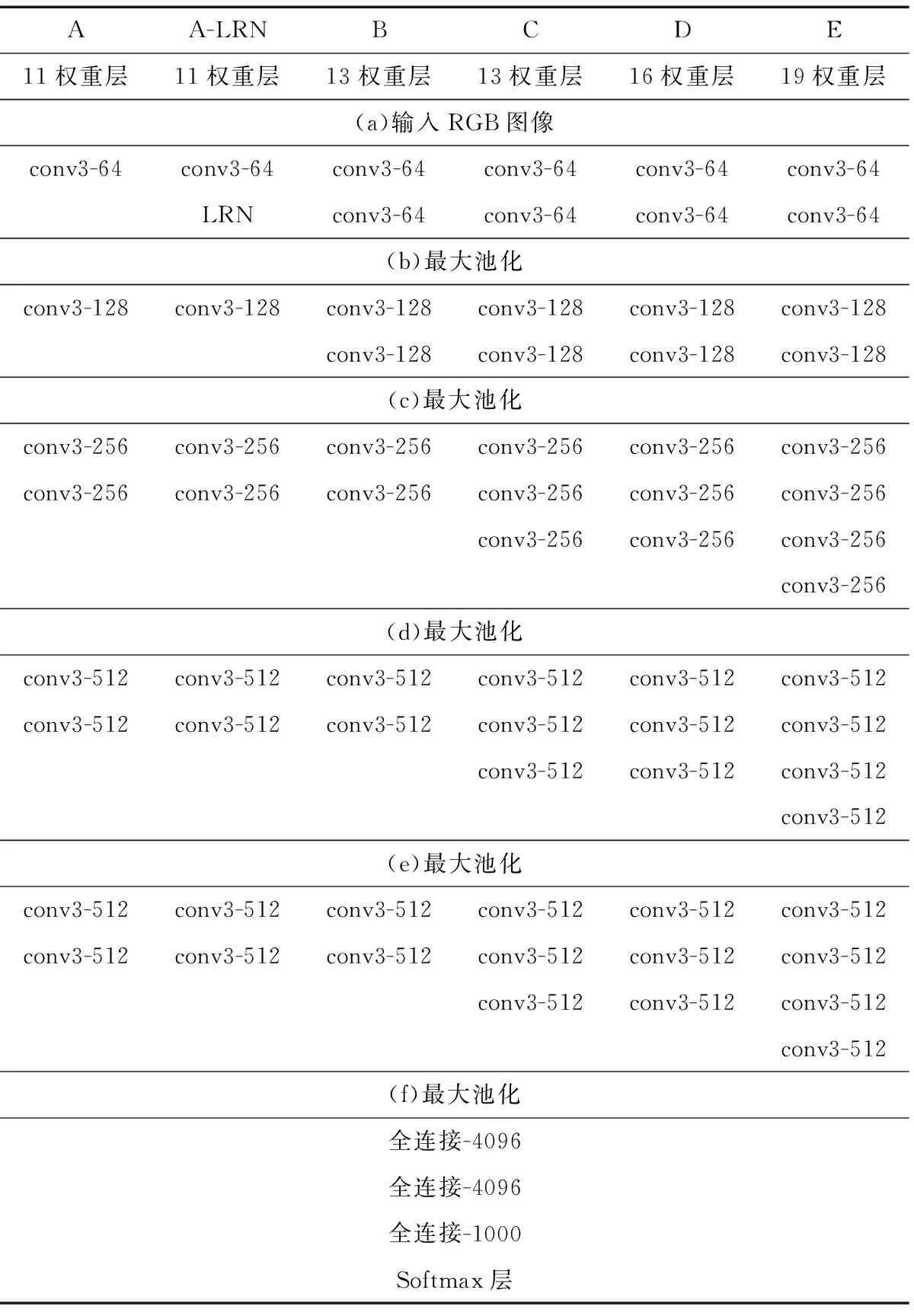

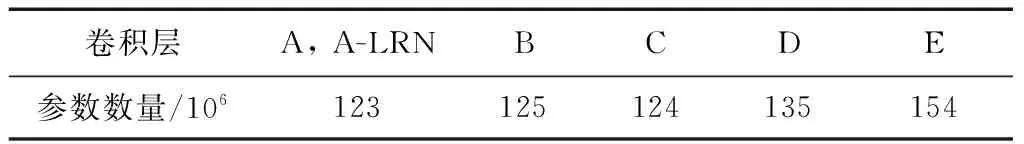

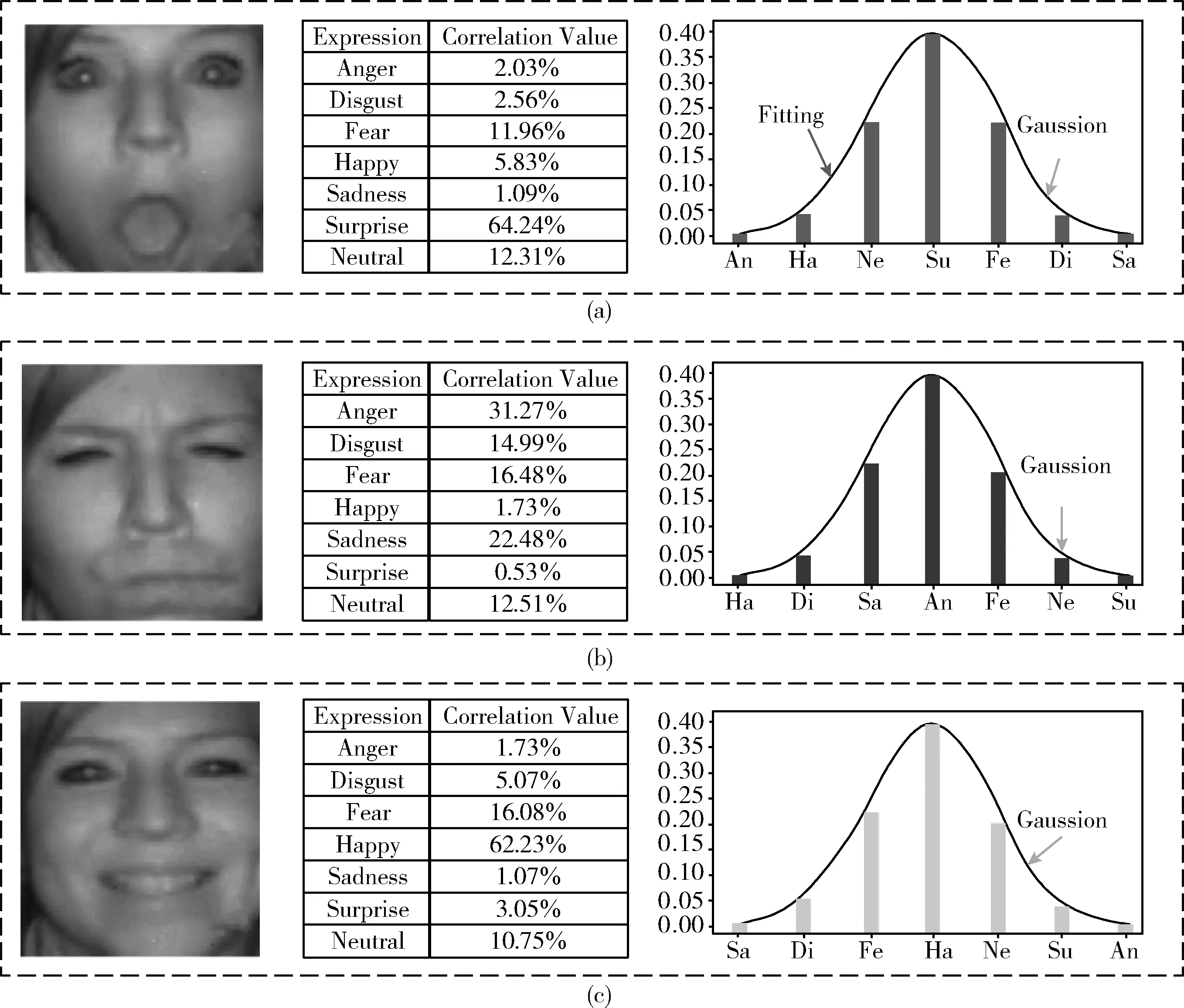

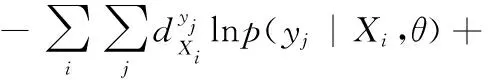

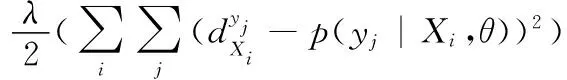

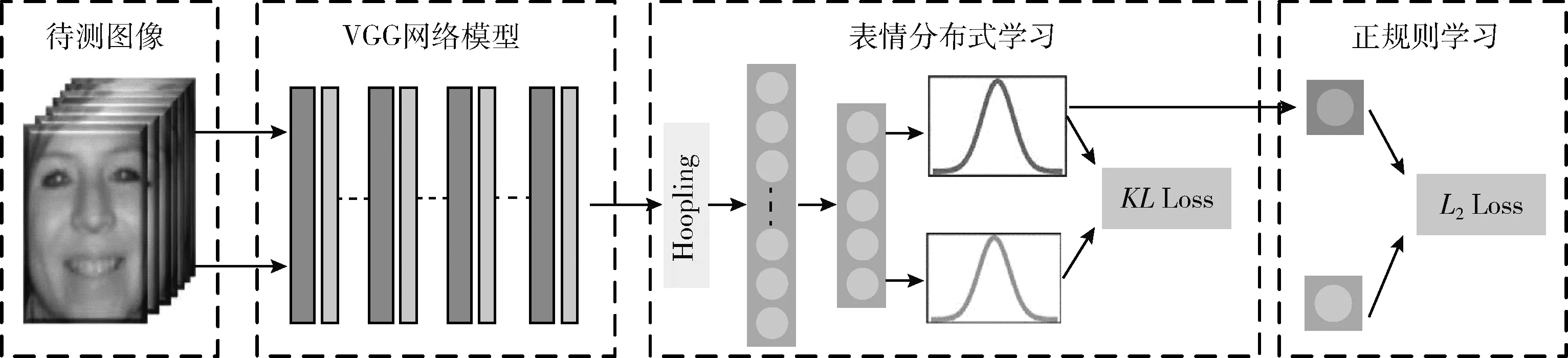

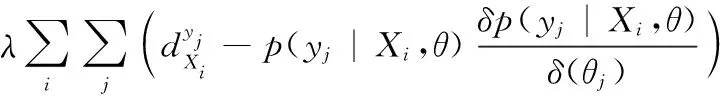

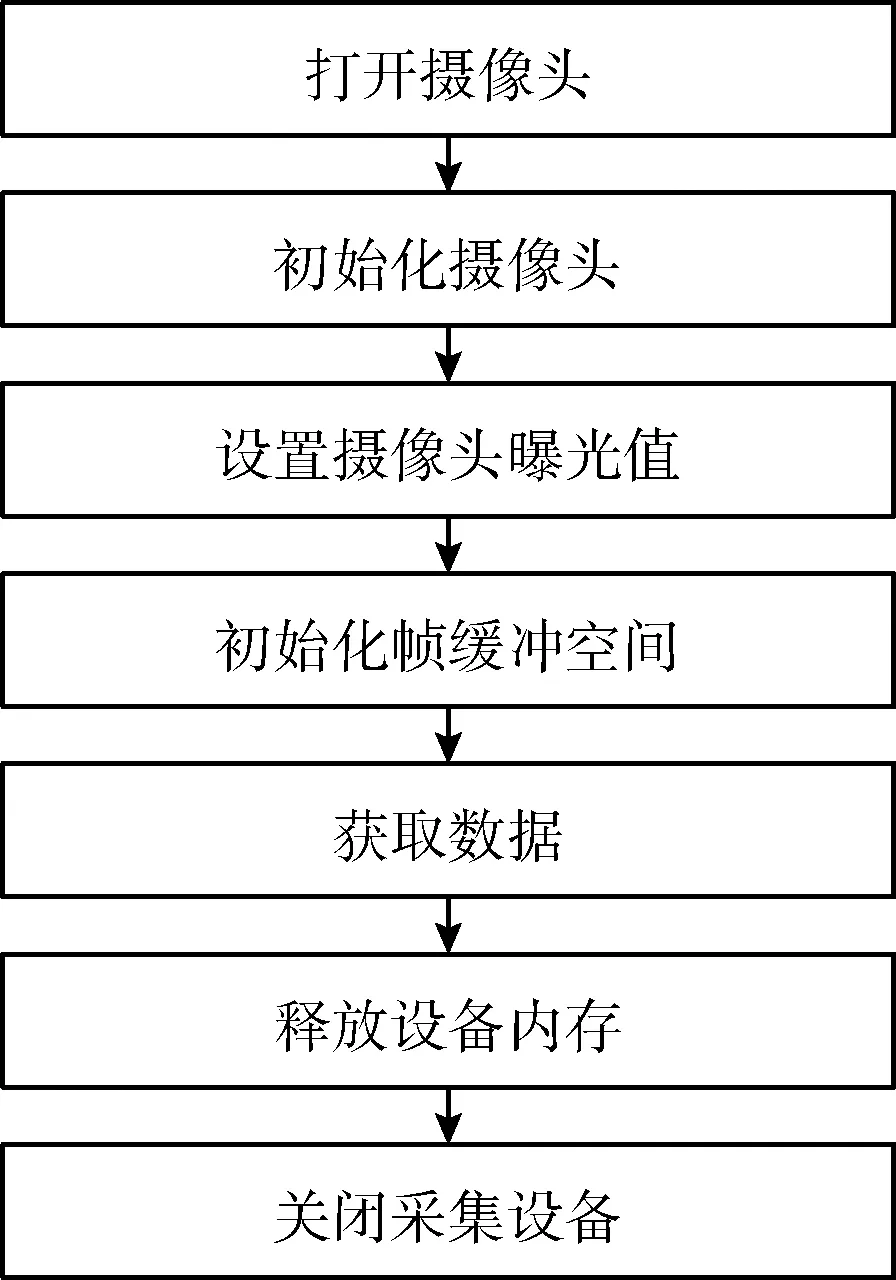

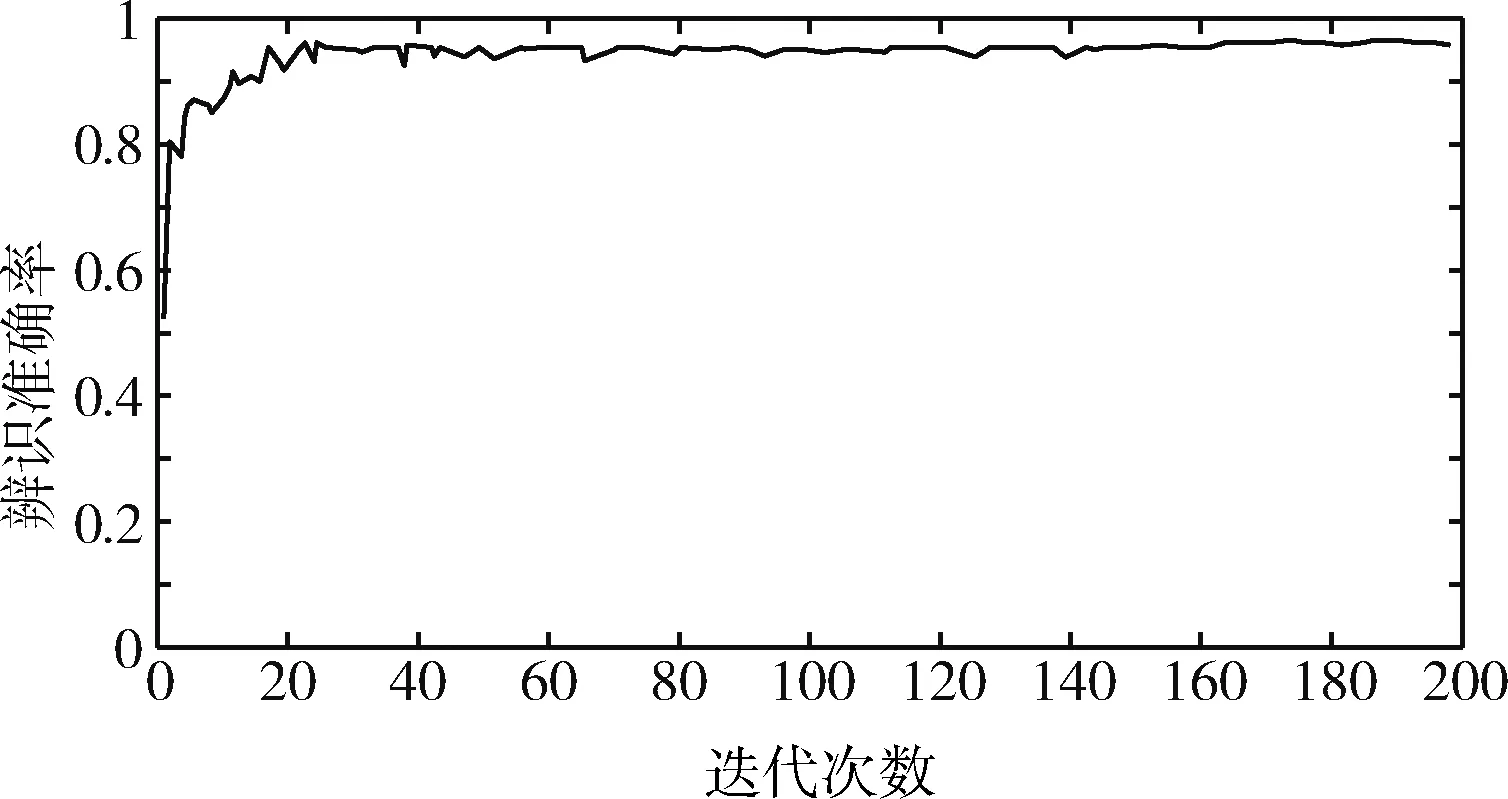

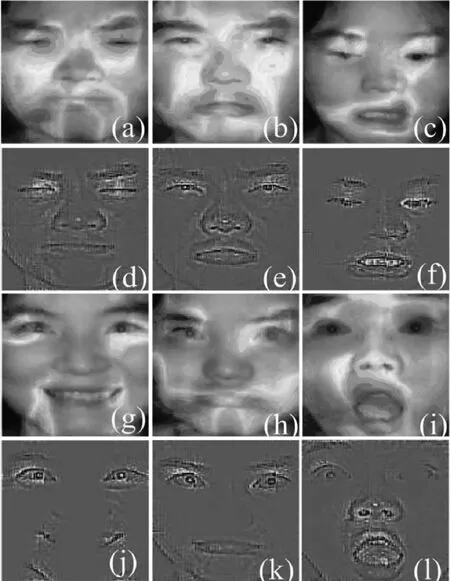

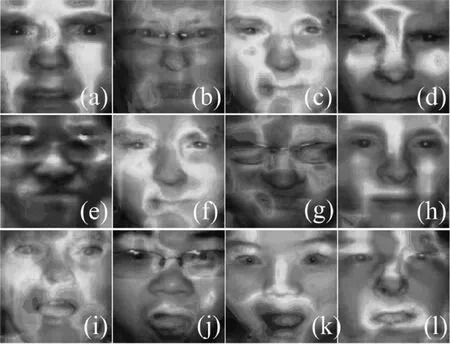

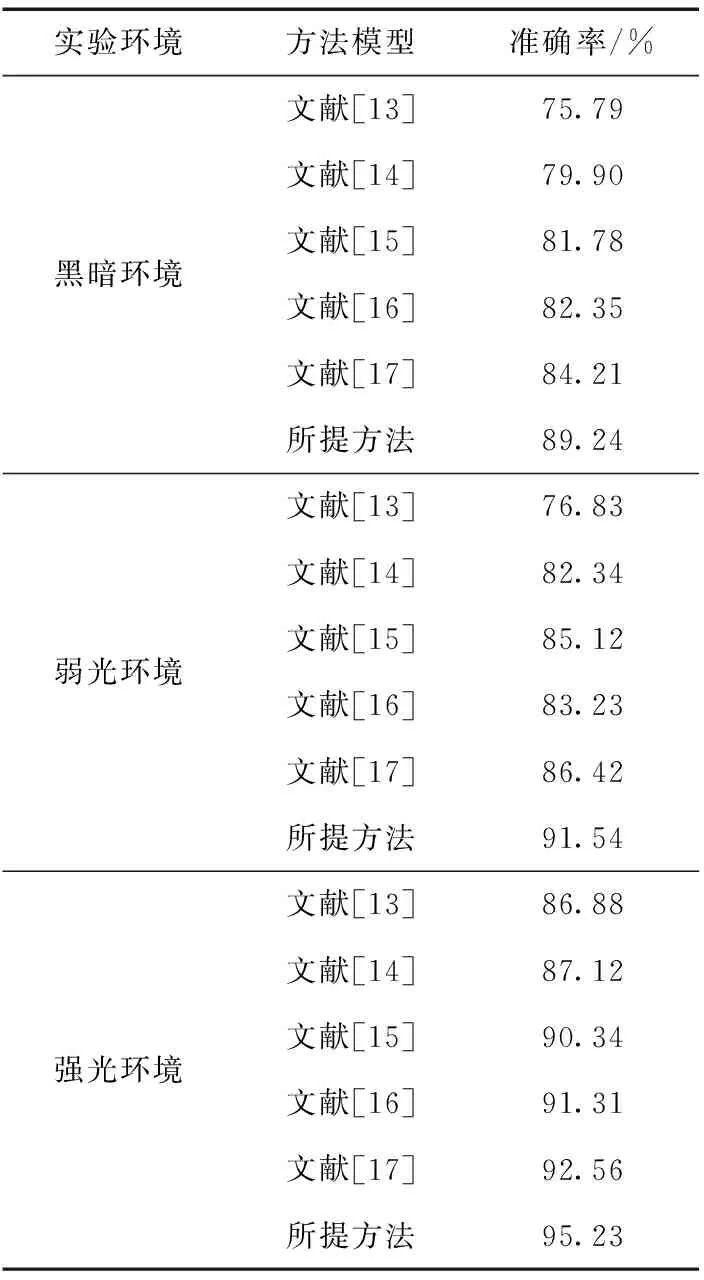

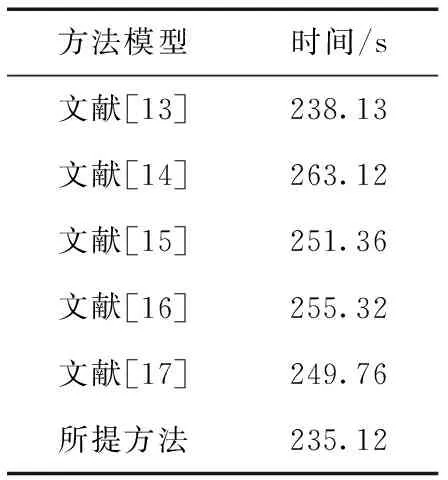

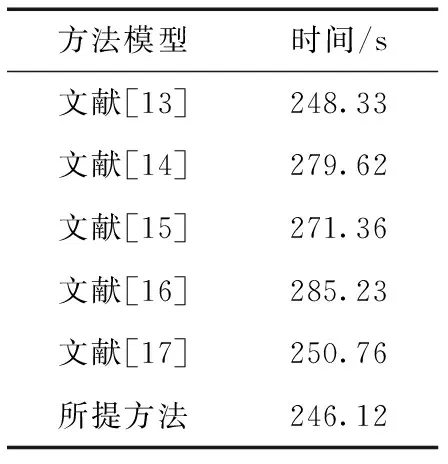

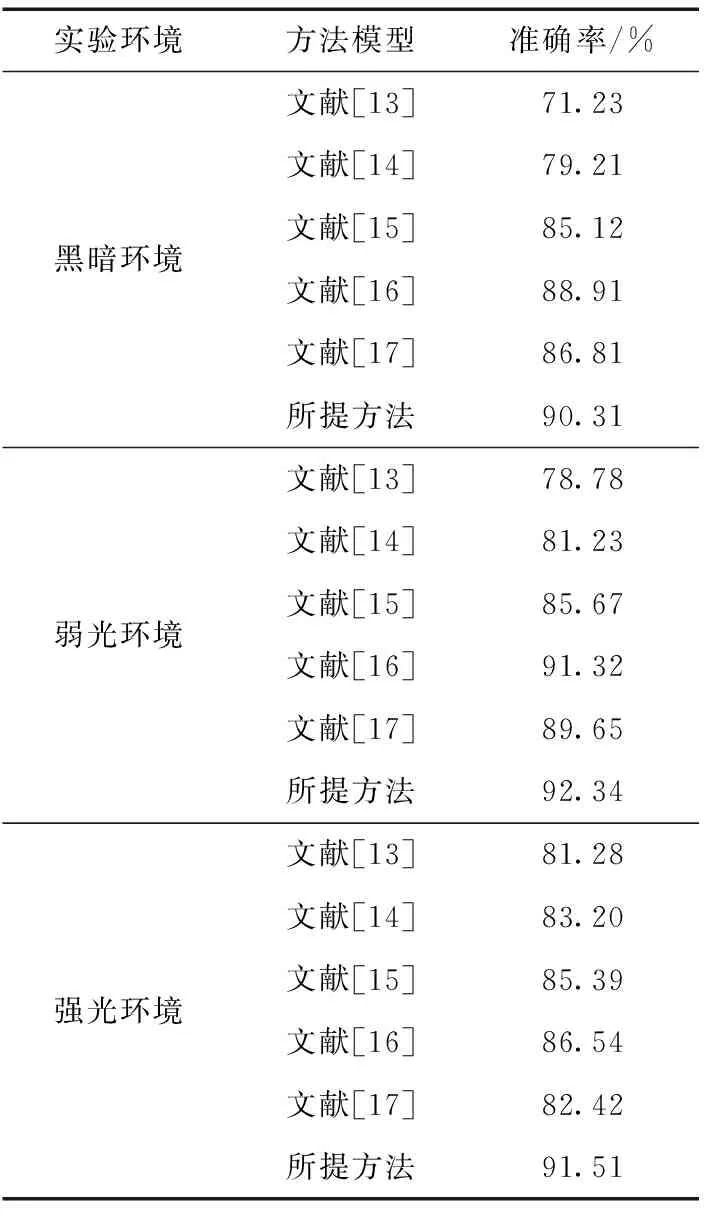

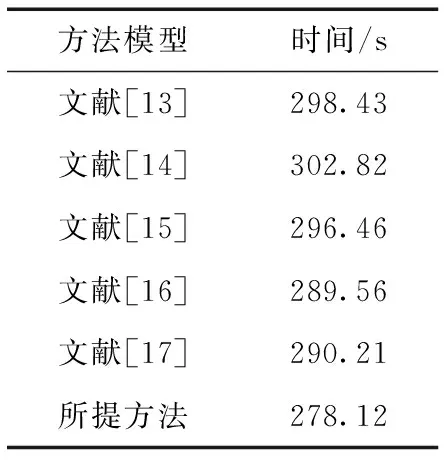

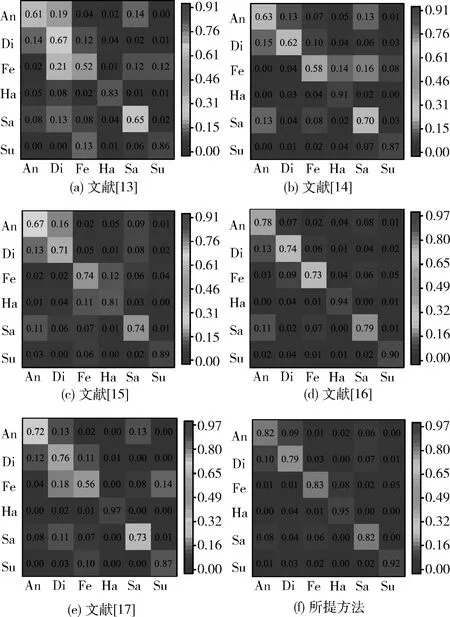

Bk(Os,rjk)={xi∈Rp|i=1,2,…,n,d(Os,Oi) (12) 式中:Oi為圓心標(biāo)注位置,依據(jù)對象像素的位置確定;Bk(Os,rjk)為采集圖像中的第s個圓;d(Os,Oi)為Oi、Os兩圓間的歐幾里得距離。則重建人臉等溫特征集Yη為 Yη={Bl}l=1 to η (13) 式中:η為圓標(biāo)標(biāo)注參數(shù);Bl為采集圖像中第一個最大半徑的第l個圓,Bl∩Bm=?,Bm∈Yη,l≠m。 經(jīng)極大化數(shù)據(jù)模型和高斯混合模型處理后,采集圖像情感特征的提取結(jié)果如圖1所示。 圖1 各種情感提取結(jié)果 在高斯混合模型對圖像特征提取的基礎(chǔ)上,基于VGG-16神經(jīng)網(wǎng)絡(luò)模型對圖像特征采集進(jìn)行相關(guān)情感標(biāo)簽分布學(xué)習(xí)和正則化學(xué)習(xí),實現(xiàn)表情識別分類;進(jìn)一步采用小批量梯度下降法簡化目標(biāo)函數(shù),減小運行內(nèi)存,提高模型對于表情識別的時效性。 VGG神經(jīng)網(wǎng)絡(luò)提出于2014年,其中VGG16模型因訓(xùn)練學(xué)習(xí)過程簡潔實用,廣泛用于圖像處理和目標(biāo)識別的研究工作中。VGG16神經(jīng)網(wǎng)絡(luò)采用3×3的卷積核,較傳統(tǒng)的較大的卷積核,可保證其在對于模型數(shù)據(jù)的訓(xùn)練學(xué)習(xí)過程中更為深入。 值得注意的是,對于VGG-16網(wǎng)絡(luò)模型的討論分析需要對于其各卷積層進(jìn)行明確,表1為各卷積層的細(xì)節(jié)描述[20]。表中,參數(shù)conv為卷積層,其數(shù)字后綴表示為感受野的尺寸和信道數(shù)量。若采樣層的初始化為0時,對于下一采樣層需要基于一定規(guī)律實現(xiàn)梯度計算,表2為各層參數(shù)設(shè)置情況。 表1 各卷積層設(shè)置 表2 參數(shù)變量設(shè)置 VGG-16網(wǎng)絡(luò)模型輸入為特征提取后的圖像: 第A,A-LRN層卷積層結(jié)構(gòu)為128個3×3卷積核; 第B層卷積層結(jié)構(gòu)為256個3×3卷積核; 第C層卷積層結(jié)構(gòu)為394個3×3卷積核; 第D層卷積層結(jié)構(gòu)為512個3×3卷積核; 第E層卷積層結(jié)構(gòu)為512個3×3卷積核; Softmax層為輸出層,將分析進(jìn)行輸出。 (14) 圖2 典型表情及其相關(guān)系數(shù)和表情分布 經(jīng)分析可知,相關(guān)情緒標(biāo)簽分布的構(gòu)建本質(zhì)是一個映射關(guān)系運算(U,V)→D,即給定一個訓(xùn)練集 E=(X1,q1),(X2,q2),…,(Xn,qn) (15) 其中,Qi={q1,q2,…,qn} 是對Xi的真實值的單一標(biāo)簽。則真實值的情緒分布為 (16) 式中:y和qi表示相同的表情;yj和Ulj表示描述Xi的相同的特定情緒。以憤怒為例 (17) 相關(guān)情緒標(biāo)簽分布學(xué)習(xí)(correlation emotion label distribution learning,CELDL)模型本質(zhì)為一個映射函數(shù)p(y|X):X→D,可測潛在相關(guān)面部表情的情緒分布[21]。本文假設(shè)p(y|X)是從S中學(xué)習(xí)的參數(shù)模型p(y|X;θ),其中θ是模型參數(shù)的向量。 (18) 在VGG-16網(wǎng)絡(luò)中,可基于正則化避免過擬合,提高模型的泛化能力,如L2正則化。作為誤差測量的L2損失公式如下 (19) 然后,最佳模型參數(shù)向量θ*由以下公式?jīng)Q定 (20) 式中:λ表示L2范數(shù)正則化系數(shù)。 此外,利用softmax函數(shù)計算樣本的概率 (21) 式中:θ表示神經(jīng)網(wǎng)絡(luò)的參數(shù);NN(X)是修改后VGG-16網(wǎng)絡(luò)的最后一個全連接層的輸出。 目標(biāo)函數(shù)為 (22) 圖3 CELDL模型框架 采用相關(guān)情緒標(biāo)簽分布結(jié)構(gòu)有兩個主要優(yōu)點:首先,它緩解了不正確的真實值情感問題,只要真實值情感基本正確,即離真實情感不遠(yuǎn),那么對真實情感的描述仍然足夠高,足以傳達(dá)積極的標(biāo)簽信息;其次,當(dāng)學(xué)習(xí)特定表情的模型時,其它表情中的面部圖像可能會有幫助,這意味著可以增強(qiáng)每個表情的訓(xùn)練樣本,而無需實際擴(kuò)展整個訓(xùn)練集。 采用小批量梯度下降法(mini-batch gradient descent, MBGD)有效地簡化目標(biāo)函數(shù)L(θ)。關(guān)于θj的更新規(guī)則表示如下 (23) 式中:α表示MBGD 中的學(xué)習(xí)率。 用鏈?zhǔn)椒▌t從第1層到第L層的參數(shù)可以計算出CELDL相對于θ的偏導(dǎo)數(shù),θ的遞推偏導(dǎo)數(shù)方程為 (24) 其中 (25) 和 (26) 則得到δL(θ)/δ(θj)后,用式(23)更新θj。算法1為所提算法的學(xué)習(xí)過程。 算法1:近紅外面部表情識別的CELDL模型 輸入:訓(xùn)練集S={X,D} 集合:批量大小b,學(xué)習(xí)率為α (1)初始化θj (2)j←0 (3)重復(fù) (4)通過式(24)計算δL(θj)/δθj (5)使用式(23)小批量更新θj (6)j←j+1 直至收斂 輸出:網(wǎng)絡(luò)層參數(shù)θ* 在本次實驗中采用的是Windows 10的操作系統(tǒng),CPU采用的型號是Intel i5-5400k 6.0 Hz,顯卡采用的型號為Radeon Graphics 8核;軟件支撐為Google旗下Tensorflow深度學(xué)習(xí)框架。對Oulu-CASIA近紅外數(shù)據(jù)集、UCHThermalFace數(shù)據(jù)集及自采集數(shù)據(jù)集分別實現(xiàn)表情識別。 Oulu-CASIA 數(shù)據(jù)集包含3種不同亮度情況和兩種成像系統(tǒng)的2880個圖像數(shù)據(jù)集,且該數(shù)據(jù)集能對憤怒、厭惡、恐懼、快樂、悲傷以及驚訝等6種情感表情進(jìn)行合理劃分。本文實驗驗證選擇可見光數(shù)據(jù)中480個圖像表情進(jìn)行所提識別方法可行性驗證。 UCHThermalFace數(shù)據(jù)集則是在不同的水平角度和垂直角度采集的熱成像人臉圖像,其也包含室內(nèi)室外兩種情況。本文選擇對俯仰角在[-15°,15°]、偏轉(zhuǎn)角在[-30°,30°]的102個熱紅外圖像進(jìn)行識別實驗驗證,包含快樂、悲傷憤怒等表情。 為驗證本文所提實驗具有工程適用性,本文亦選擇對實際采集圖像進(jìn)行識別分析。基于V4L2視頻采集驅(qū)動實現(xiàn)測試圖像采集,其大致流程如圖4所示。采用內(nèi)存映射方式,將設(shè)備采集的信息映射至應(yīng)用程序的內(nèi)存中,并基于mmap函數(shù)將數(shù)據(jù)緩沖區(qū)中的圖片信息進(jìn)行導(dǎo)出。本文為提高采集圖像導(dǎo)出速率,在對采集數(shù)據(jù)進(jìn)行處理時,同時調(diào)用兩個ioctl命令,先將采集數(shù)據(jù)緩沖出隊列,即VIDIOC_DQBUF,接著再將其入隊VIDIOC_QBUF,可有效提升其處理速度。 圖4 自采集數(shù)據(jù)集收集流程 4.2.1 Oulu-CASIA 數(shù)據(jù)集識別分析 為了評估所提出模型的學(xué)習(xí)能力,本文對所提的VGG-16 模型的準(zhǔn)確率進(jìn)行分析,如圖5所示。為了驗證學(xué)習(xí)能力優(yōu)越性,在暗光照下對Oulu_CASIA 進(jìn)行了實驗。實驗結(jié)果分析準(zhǔn)確率如圖5所示,VGG-16模型框架,隨著訓(xùn)練次數(shù)的增加,準(zhǔn)確率越來越高,在40次迭代后,所提方法的識別準(zhǔn)確率趨于穩(wěn)定。 圖5 所提模型識別準(zhǔn)確率 采用Grad-CAM來可視化重要區(qū)域,如圖6所示,同一個人的不同表情不僅展示了大多數(shù)不同的類別判別區(qū)域,而且還顯示了一小部分類別判別區(qū)域,圖6(a)為憤怒,圖6(b)為厭惡,圖6(c)為恐懼,圖6(g)為快樂,圖6(h)為悲傷,圖6(i)為驚訝,圖6(d)~圖6(f)和圖6(j)~圖6(l)表示來自訓(xùn)練網(wǎng)絡(luò)的殘差表情圖像。結(jié)果表明,該模型可以在不同的表情中發(fā)現(xiàn)更多的有區(qū)別性的信息。 圖6 同一人不同表情的類別區(qū)分區(qū)域比較 圖7分別示出了憤怒、悲傷和驚訝的類別區(qū)分區(qū)域,圖7(a)~圖7(d)為憤怒,圖7(e)~圖7(h)為悲傷,圖7(i)~圖7(l)為驚訝。不同的人對同一表情的類別區(qū)分區(qū)域大部分在相同的區(qū)域被激活,驗證本文方法的可行性。 圖7 同一表情對不同人的類別區(qū)分區(qū)域的比較 進(jìn)一步基于3種近紅外光照條件下對所提出的模型進(jìn)行了識別實驗驗證,平均識別準(zhǔn)確率比較結(jié)果見表3。在黑暗條件下,本文所提方法較文獻(xiàn)[13]、文獻(xiàn)[14]、文獻(xiàn)[15]、文獻(xiàn)[16]和文獻(xiàn)[17]的識別方法分別提高13.45%、9.34%、7.46%、6.89%和5.03%;在弱光照條件下,用文獻(xiàn)[13]計算的平均識別準(zhǔn)確率僅為76.83%,本文方法的平均識別準(zhǔn)確率可達(dá)到91.54%;在強(qiáng)光照條件下,本文方法比文獻(xiàn)[13]、文獻(xiàn)[14]、文獻(xiàn)[15]、文獻(xiàn)[16]和文獻(xiàn)[17]方法分別提高了8.35%、8.11%、4.89%、3.92%和2.67%。綜上所述,證實所提方法在不同光照條件下的可行性于優(yōu)越性,且在光照條件下的識別性能優(yōu)于黑暗條件和弱光照下的識別性能。 表3 Oulu_SACIA的表情識別平均準(zhǔn)確率 同時,表4為各方法對于Oulu_SACIA數(shù)據(jù)集處理時間對比。從圖表中可明顯看出,在處理時效性上,所提方法可有效實現(xiàn)對于表情的快速判別。 表4 各模型及方法識別時間 4.2.2 UCHThermalFace 數(shù)據(jù)集識別分析 本文選取UCHThermalFace數(shù)據(jù)集中6個數(shù)據(jù)子集進(jìn)行表情識別實驗,包含53個對象6個姿態(tài)圖像,共計318個數(shù)據(jù)圖像樣本。分別3種近紅外光照條件下基于UCHThermalFace數(shù)據(jù)集對所提出的模型進(jìn)行了穩(wěn)定性驗證,平均識別準(zhǔn)確率比較結(jié)果見表5。 如表5所示,所提方法對于UCHThermalFace數(shù)據(jù)集識別分析同樣存在強(qiáng)光環(huán)境下識別結(jié)果要優(yōu)于黑暗和弱光環(huán)境。在強(qiáng)光環(huán)境下,對于表情平均辨別準(zhǔn)確率可達(dá)到93.51%,較文獻(xiàn)[13]、文獻(xiàn)[14]、文獻(xiàn)[15]、文獻(xiàn)[16]和文獻(xiàn)[17]方法分別提升12.23%、10.31%、8.12%、2.28%和2.75%;而黑暗環(huán)境中,因存在光線不足的原因,其識別準(zhǔn)確性較強(qiáng)光實驗組有整體的下降,其準(zhǔn)確率分別為71.23%、79.21%、85.12%、87.32%、88.96%和90.31%;而弱光場景下,所提模型準(zhǔn)確率為92.34%,較文獻(xiàn)[13]提升13.56%的準(zhǔn)確性。 面向UCHThermalFace數(shù)據(jù)集各方法處理時間見表6,所提方法具有明顯時效性。 表6 各模型及方法識別時間 4.2.3 自采集數(shù)據(jù)集識別分析 為了進(jìn)一步驗證所提方法的工程實用性,采用現(xiàn)場采集的方法對200人表情特征進(jìn)行黑暗環(huán)境、弱光環(huán)境和強(qiáng)光環(huán)境下的圖像采集與特征提取。如表7所示,所提方法因經(jīng)過分布式學(xué)習(xí)和正則化學(xué)習(xí)的綜合訓(xùn)練,對于黑暗環(huán)境、弱光環(huán)境和強(qiáng)光環(huán)境的識別準(zhǔn)確率可以分別達(dá)到89.23%、90.23%和91.33%。而對比模型因訓(xùn)練網(wǎng)絡(luò)結(jié)構(gòu)簡單以及缺乏綜合訓(xùn)練學(xué)習(xí),其判斷效率和精度在各種場景下較所提方法存在一定差距。 表7 自采集圖像數(shù)據(jù)集識別平均準(zhǔn)確率 如前文所述,所提算法為簡化計算步驟,提高計算效率采用MBGD方法實現(xiàn)算法網(wǎng)絡(luò)模型的優(yōu)化,從而提高識別效率。對于自采集人臉表情識別時間見表8,所提方法可在278.12 s對被測數(shù)據(jù)集完全實現(xiàn)識別,較文獻(xiàn)[13]、文獻(xiàn)[14]、文獻(xiàn)[15]、文獻(xiàn)[16]和文獻(xiàn)[17]方法提高20.31 s、24.7 s、18.34 s、11.44 s和12.09 s。 表8 各模型及方法識別時間 為進(jìn)一步驗證所提方法的適用性,采用混淆矩陣對識別結(jié)果進(jìn)行展示說明。如圖8(f)所示,所提方法對于憤怒表情、厭惡表情、悲傷表情、開心表情、沮喪表情和驚訝表情的識別準(zhǔn)確分別為82%、79%、83%、95%、82%和92%。同時因VGG-16網(wǎng)絡(luò)訓(xùn)練結(jié)構(gòu)的復(fù)雜性和兩種學(xué)習(xí)規(guī)則的綜合,可實現(xiàn)對于各種表情之間的明顯區(qū)分。以開心表情為例,所提模型對其識別正確率可高至95%,對于厭惡和悲傷表情的識別區(qū)別錯誤率為4%和1%,并且對于其表情可實現(xiàn)完全區(qū)分;而對比模型并沒有充分考慮各表情之間的關(guān)聯(lián)關(guān)系,致使對于識別表情的區(qū)分性問題上存在缺陷,如文獻(xiàn)[13]中厭惡表情和憤怒表情識別錯誤率為19%,已將厭惡表情誤識別為憤怒。 圖8 不同方法下混淆矩陣 本文所提的卷積網(wǎng)絡(luò)模型輸出目標(biāo)主要包括兩部分,即KL損失和L2損失。KL損失和L2損失參數(shù)對卷積網(wǎng)絡(luò)模型的表情識別準(zhǔn)確度十分重要,其中參數(shù)λ在這兩個部分之間交換,參數(shù)σ控制相鄰表情的關(guān)聯(lián)度,均對識別精度有很大影響。如參數(shù)σ,若σ數(shù)值太小,單標(biāo)簽真實值與其它相鄰表情之間的相關(guān)性變得很小,該方法類似于進(jìn)行單標(biāo)簽分類任務(wù);若σ太大,則其它相鄰表情之間的相關(guān)性差別很小。 為了分析不同超參數(shù)λ和σ在CELDL 模型中的敏感度,以實現(xiàn)模型參數(shù)最優(yōu)化,在VGG-16網(wǎng)絡(luò)模型框架下對CELDL表情識別任務(wù)進(jìn)行了實驗驗證。 在自采集數(shù)據(jù)集對模型參數(shù)優(yōu)適值進(jìn)行分析,如圖9所示。在第一個實驗(a)中,根據(jù)多次實驗的設(shè)置,λ被固定為0.001,并在[0.1,0.2,0.3,0.4,0.5,0.6,0.7,0.8,0.9,1.0]中改變σ來學(xué)習(xí)不同的模型。可以觀察到,CELDL模型的準(zhǔn)確率一般都是先提高,在0.7時達(dá)到最大值,然后下降。結(jié)果表明,當(dāng)σ設(shè)為0.7時,網(wǎng)絡(luò)模型對參數(shù)選擇沒有影響,表情之間的相關(guān)性可以很好地表示出來。 圖9 模型參數(shù)靈敏度分析 實驗(b)將σ數(shù)值固定為0.7,在集合[0,0.0001,0.0005,0.001,0.005,0.01,0.05,0.1]中改變λ進(jìn)行對比實驗。結(jié)果表明,識別性能對參數(shù)λ的取值非常敏感,λ=0.001是依據(jù)KL損失和L2損失作為綜合結(jié)果判定的情況,保障了深度學(xué)習(xí)特征的優(yōu)秀識別性能。 面向多場景下多表情識別的準(zhǔn)確性和快速性需求,本文提出一種基于高斯特征提取和VGG-16神經(jīng)網(wǎng)絡(luò)的紅外人臉表情識別方法,其主要分為3部分:①基于極大似數(shù)據(jù)模型和高斯混合模型對采集圖像進(jìn)行處理,為后續(xù)深度神經(jīng)網(wǎng)絡(luò)學(xué)習(xí)訓(xùn)練提供良好的圖像訓(xùn)練數(shù)據(jù)樣本支撐;②采用相關(guān)情感標(biāo)簽分布學(xué)習(xí)和正則化學(xué)習(xí)對VGG-16神經(jīng)網(wǎng)絡(luò)進(jìn)行改進(jìn),對各表情情緒針對分析,保障多環(huán)境場景下采集圖像表情的精準(zhǔn)識別;③基于MBGD方法有效簡化網(wǎng)絡(luò)模型的目標(biāo)函數(shù),提高識別方法的識別速度,具有工程應(yīng)用實際意義。通過對3種數(shù)據(jù)集的實驗仿真分析,可以得到所提方法較CNN模型、MTCNN模型和DBN模型具有人臉表情識別準(zhǔn)確和快速的優(yōu)勢,其中對于自采集數(shù)據(jù)集的圖像識別在黑暗、弱光和強(qiáng)光環(huán)境下識別正確率可達(dá)到90.31%、92.34%和91.51%,具有一定的工程適用性。 未來研究重點將探討所提方法的平臺化,努力實現(xiàn)所提方法的商用化。

3 學(xué)習(xí)與識別

3.1 VGG網(wǎng)絡(luò)結(jié)構(gòu)

3.2 高斯標(biāo)簽的分布構(gòu)造

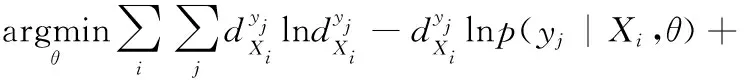

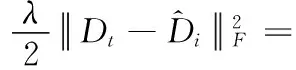

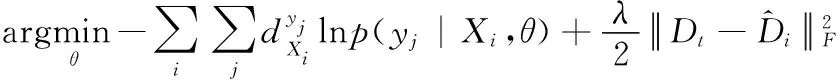

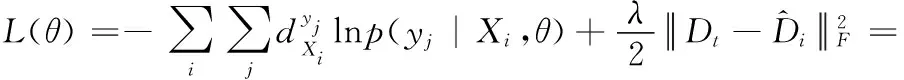

3.3 情緒標(biāo)簽的分布學(xué)習(xí)

3.4 優(yōu) 化

4 算例驗證與結(jié)果討論

4.1 實驗數(shù)據(jù)集

4.2 人臉識別實驗驗證

4.3 模型參數(shù)敏感度分析

5 結(jié)束語