基于迭代稀疏訓練的輕量化無人機目標檢測算法

侯 鑫 曲國遠 魏大洲 張佳程

1(中國科學院計算技術研究所 北京 100190)

2(中國航空無線電電子研究所 上海 200241)

3(北京郵電大學信息與通信工程學院 北京 100876)

(houxin@ict.ac.cn)

隨著無人機(unmanned aerial vehicle, UAV)技術的成熟,配備攝像頭和嵌入式系統的無人機已被廣泛應用于各個領域,包括農業、安防與監視[1]、航空攝影[2]和基礎設施檢查[3]等.這些應用要求無人機平臺能夠感知環境,理解分析場景并作出相應的反應,其中最基礎的功能就是目標自動高效檢測.基于深度網絡的目標檢測器[4-8]通過卷積神經網絡自動提取圖像特征,大大提高了目標檢測的性能.按照有沒有利用候選區域,目標檢測主要分為兩大陣營:基于候選區域檢測陣營與不基于候選區域檢測陣營(如CornerNet[9],CenterNet[10]等).基于候選區域檢測陣營根據候選框處理手段又可以分為2階段目標檢測(如R-CNN(region convolutional neural network)[11-13],R-FCN(region-based fully convolutional network)[14]等)和1階段目標檢測(如YOLO(you only look once)[15-17],SSD(single shot multibox detector)[18],RetinaNet[19]等).

檢測性能提高的同時也帶來了巨大的資源消耗和內存占用,這對計算能力受限的無人機處理平臺來說是不友好的:1)模型大小.深度卷積神經網絡強大的特征表達能力得益于數百萬個可訓練的參數,如VGG-16網絡,參數數量1.3億多,需要占用500 MB空間,這對嵌入式設備來說是很大的資源負擔.2)計算量.深度卷積神經網絡前向推理的過程需要執行大量的浮點運算,VGG-16(visual geometry group)網絡完成一次圖像識別任務需要309億次浮點運算,這對于計算資源有效的嵌入式設備來說是巨大的挑戰.3)推理時間.對于一張高分辨率的輸入圖像來說,嵌入式平臺執行深度卷積神經網絡前向推理過程是非常耗時的,可能要幾分鐘才能處理一張圖像,這對于實時應用來說是不可接受的.

因此,很多研究者通過模型壓縮方式減小模型復雜度,減少模型參數量與計算量,加快模型前向推理速度.其中比較經典的方法包括模型結構優化[20-23]、低秩分解[24-25]、模型剪枝[26-27]、模型量化[26,28]、知識蒸餾[29]等.模型壓縮方法在降低模型參數量和計算量的同時,勢必會帶來一定的精度損失.對于無人機場景目標檢測來說,如何在保持精度基本無損的情況下,進行最大限度的模型壓縮是關鍵的.

針對上述問題,本文提出了一種基于迭代稀疏訓練的模型壓縮方法,其主要貢獻有3個方面:

1) 通過迭代稀疏訓練的方式,對經典目標檢測網絡YOLOv3進行通道和層協同剪枝,可以在保持精度基本無損的情況下實現最大限度的模型壓縮;

2) 通過組合不同數據增強方式增加了數據集分布的復雜性和多樣性,結合一些優化手段(Tricks),提高了無人機場景下目標檢測網絡YOLOv3的泛化性能;

3) 實驗證明,該方法對于無人機場景下目標檢測網絡YOLOv3模型壓縮效果明顯,在保證精度基本無損的情況下可以實現最大限度的模型壓縮,而且可以極大地加速模型的前向推理過程,使得模型實時應用成為可能.

1 相關工作

1.1 目標檢測

2013年以前,目標檢測問題通過手工設計的特征算子與滑動窗口方式解決,處理速度慢、效果不魯棒,難以滿足實際工業需求.2014年,Girshick等人[11]提出R-CNN算法,使用深度卷積神經網絡完成對輸入圖像的特征提取工作,緊接著一系列基于深度卷積神經網絡的檢測算法出現,包括基于2階段的檢測算法Fast R-CNN[12],Faster R-CNN[13],Mask R-CNN[6],R-FCN[14]等,以及1階段的檢測算法YOLO[15-17],SSD[18],RetinaNet[19]等.隨著檢測算法的發展,研究者們逐漸發現基于候選區域的目標檢測存在一定的缺陷,因此出現了不基于候選區域的目標檢測器,典型的有CornerNet[9],CenterNet[10]等算法.

1.1.1 基于2階段的目標檢測器

基于2階段的目標檢測過程主要由2部分組成,首先生成包含感興趣區域的高質量候選框,然后通過進一步分類與回歸獲得檢測結果.R-CNN是2階段檢測器的基礎,首先使用深度網絡提取圖像特征,然后基于選擇搜索[30]生成候選區域,最后通過支持向量機(support vector machine, SVM)分類器對候選區特征進行分類從而得到最終的檢測結果.R-CNN不能進行端到端訓練,隨著網絡的發展,逐漸形成了較為成熟的Faster R-CNN檢測算法,后續的改進和提升基本都是基于Faster R-CNN進行的.以R-CNN算法為代表的2階段檢測器經過不斷的發展和改善,尤其是加入RPN(region proposal network)[13]結構以后,檢測精度越來越高,計算復雜度也越來較高,檢測速度較慢,難以滿足實時應用的需求.因此一般計算能力受限的嵌入式平臺不會使用2階段檢測器進行部署應用.

1.1.2 基于1階段的目標檢測器

不同于2階段檢測器,1階段檢測器不包含候選區域生成步驟,直接對預定義錨框對應的特征進行分類和回歸以得到最終的檢測結果.這種方法相比2階段檢測器來說性能有一定的下降,但速度有明顯提升.YOLO[15]首先對訓練樣本聚類得到候選框,使用這些預定義的候選框密集地覆蓋整個圖像空間位置,然后提取輸入圖像的特征并對預定義的候選框進行分類和回歸.SSD[18]通過長寬及長寬比來預定義錨框,為提升1階段檢測器的性能瓶頸,SSD從多個尺度特征層出發,同時對預定義的候選框進行類別概率學習以及坐標位置回歸,有效提升了檢測性能.后續提出的RetinaNet[19]引入focal loss函數來解決類別不平衡問題,1階段檢測器性能有了進一步的提升.

1階段檢測器中YOLO系列算法運行速度非常快,可以達到實時應用級別,但精度差強人意.后續YOLOv2[16],YOLOv3[17]的出現,將精度進行了大幅提升.特別是YOLOv3,借鑒了ResNet(residual network)[31]的殘差思想和FPN(feature pyramid network)[32]的多尺度檢測思想,在保持速度優勢的前提下,進一步提升了檢測精度,尤其加強了對小目標的識別能力.在實際部署中,由于非常好的速度/精度均衡性和高度的集成性、靈活性,YOLOv3成為工業界最受歡迎的模型之一.

1.1.3 不基于候選區域的目標檢測

2階段檢測器與1階段檢測器都基于候選框進行分類與回歸,實際應用中,很多研究者發現如果候選框設置不合適,可能影響檢測器的性能.因此,不基于候選區域的目標檢測方法被提出,這些方法將目標檢測任務轉換為關鍵點檢測與尺寸估計.CornerNet[9]將目標檢測任務轉換為左上角和右下角的關鍵點檢測任務;ExtremeNet[33]將目標檢測任務轉換為檢測目標的4個極值點;CenterNet[10]將左上角、右下角和中心點結合成為三元組進行目標框的判斷;FoveaBox[34]則借鑒了語義分割思想,對目標上每個點都預測一個分類結果,物體邊界框通過預測偏移量得到.不基于候選區域的目標檢測器的成功主要得因于FPN和focal loss結構,但與2階段檢測器和級聯方法的檢測精度仍然有差距,在靈活性和檢測速度上也沒有明顯優勢.因此,目前工業部署應用不是特別廣泛.當然,作為一種新的檢測思路,隨著方法本身的發展,相信未來將會有更多的應用.

1.2 模型壓縮

在資源有限的設備上部署深度網絡模型時,模型壓縮是非常有效的工具,常用的模型壓縮方法主要包括模型結構優化[20-23]、低秩分解[24-25]、模型剪枝[26-27]、模型量化[26,28]、知識蒸餾[29]等.模型結構優化是指通過使用輕量化的網絡結構來降低模型計算量,但這樣會導致模型表達能力下降,從而造成性能下降.低秩分解將原始網絡權值矩陣當作滿秩矩陣,用若干個低秩矩陣的組合來替換原來的滿秩矩陣,低秩矩陣又可以分解為小規模矩陣的乘積,從而實現模型壓縮和加速.模型量化主要利用32 b表示權重數據存在的冗余信息,使用更少位數表示權重參數,從而實現模型壓縮和加速.上述2種方法在壓縮率較高時,都面臨精度損失大的問題.知識蒸餾通過學生網絡對老師網絡的擬合得到一個更加緊湊的網絡結構,以再現大型網絡的輸出結果.學生網絡的選擇與設計,以及學習老師網絡的哪些信息依然是一個值得考慮的問題.模型剪枝指對一個已訓練好的高精度復雜模型,通過一種有效的評判手段來判斷參數的重要性,將不重要的連接進行裁剪以減少參數冗余,從而實現模型壓縮和加速.

Denil等人在文獻[35]中提出很多深度卷積神經網絡中存在顯著冗余,僅僅使用很少一部分(5%)權值就足以預測剩余的權值,因此模型剪枝可以實現非常可觀的壓縮率.針對無人機場景數據集,本文選擇速度/精度均衡的YOLOv3作為基礎檢測模型,通過模型剪枝來進行壓縮和加速,以獲得可在算力有限的嵌入式平臺部署應用的快速準確檢測模型.

1.3 數據增強

數據增強的目標是增加輸入圖像的可變性,以使模型對從不同環境獲得的圖像具有更高的魯棒性.常用的2種數據增強方式包括空間幾何變換與像素顏色變換[36-39],其中圖像平移、旋轉、縮放以及圖像亮度、對比度、飽和度是比較常用的.上述提到的數據增強方法都是基于像素級別的,對于無人機場景下的稠密小目標檢測任務來說提升作用有限.Kisantal等人在文獻[40]中通過剪切粘貼方式來增加小目標數量,該種方法對稠密分布的小目標效果不明顯.此外,一些研究員提出使用多張圖像一起執行數據增強的方法.Mixup[41]對任意2張訓練圖像進行像素混合從而起到正則化效果;Mosaic[42]任意混合4張訓練圖像作為一張新的圖像參與訓練.這2種方法混合了不同的上下文信息,有效提升了數據集的場景復雜性,從而提升了模型的檢測性能.本文除了使用基礎的空間幾何變換與像素顏色變換增強方式外,巧妙結合了Mixup和Mosaic兩種增強方式,進一步提升了YOLOv3在無人機場景下的檢測精度.

2 基于迭代稀疏訓練的模型剪枝

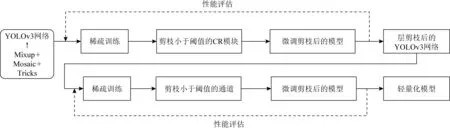

深度卷積神經網絡主要模塊包括卷積、池化、激活,這是一個標準的非線性變換模塊.網絡層數加深,意味著更好的非線性表達能力,可以學習更加復雜的變換從而擬合更加復雜的特征輸入.因此,對于同一場景數據集來說,網絡越復雜,通常意味擬合能力越強,效果越好.而復雜模型參數量大,推理速度慢,對于嵌入式平臺部署應用來說是一個很大的挑戰.文獻[35]還提出這些剩下的權值甚至可以直接不用被學習,也就是說,僅僅訓練一小部分原來的權值參數就有可能達到和原來網絡相近甚至超過原來網絡的性能.受此啟發,本文對一個特征表達能力強的復雜模型通過迭代稀疏訓練的方式,巧妙結合層剪枝和通道剪枝,在保持檢測精度的同時,實現了模型極大比例的壓縮,剪枝流程如圖1所示:

Fig. 1 The process of iterative sparse training圖1 迭代稀疏訓練流程圖

2.1 網絡結構

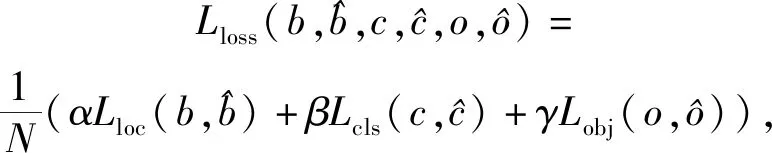

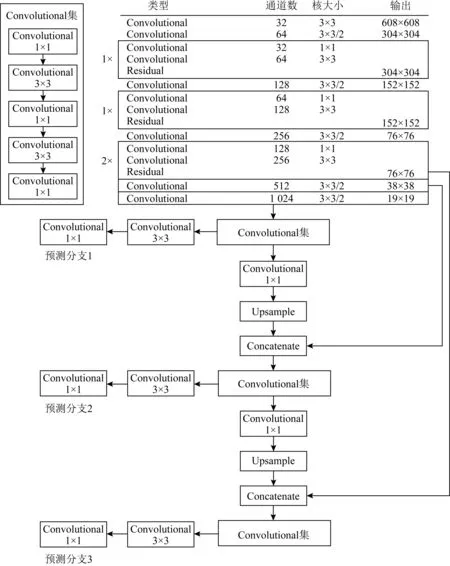

在實際部署應用中,由于非常好的速度、精度均衡和高度的集成性、靈活性,YOLO系列模型成為最受歡迎的模型之一.YOLOv3借鑒了ResNet[31]的殘差思想和FPN[32]的多尺度檢測思想,在保持速度優勢的前提下,進一步提升了檢測精度,尤其加強了對小目標的識別能力.如圖2所示為YOLOv3網絡結構,該結構由大量1×1卷積、3×3卷積與殘差結構組成,我們把每個這樣的結構作為一個單元稱為CR塊.在檢測部分,YOLOv3引入了特征金字塔的思想,采用3個不同尺度的特征圖進行檢測,以應對目標尺度變化大的問題.本文基礎模型基于YOLOv3進行,相比Zhang等人在文獻[43]中基于YOLOv3-SPP3(spatial pyramid pooling)開展的工作,同樣剪枝率下本文模型參數量更少,推理速度更快,精度更高.

Fig. 2 The network structure of YOLOv3圖2 YOLOv3網絡結構

2.2 數據增強

數據增強是目標檢測中常用的不需要增加太多訓練成本但可以有效提升模型性能的方法.Mixup[41]是一種新的數據增強策略,通過對任意2張訓練圖像進行像素混合來對神經網絡起到正則化的效果,可以提高網絡對空間擾動的泛化能力,有助于提升檢測精準率.Rosenfeld等人在文獻[44]中做過一個非常有趣的實驗,稱為“房間里的大象”,將包含大象的補丁圖像隨機放置在自然圖像上,使用現有的物體檢測模型進行檢測,發現效果并不理想.Zhang等人在文獻[45]方案中將Mixup應用于目標檢測,有效提升了模型對“房間里的大象”現象的魯棒性.如式(1)所示為YOLOv3損失函數:

(1)

增加了Mixup數據增廣策略之后YOLOv3的損失函數為:

(2)

Mosaic[42]是另一種有效的多張圖像混合的數據增強方法,通過混合4張不同圖像的上下文信息,有效提升數據集的場景復雜性,有助于提升檢測召回率.假設混合后的圖像分辨率為S×S,首先創建一個2S×2S的大圖,則混合圖像的中心點坐標xc,yc~U[S×0.5,S×1.5],隨機從訓練集中選取4張圖像,原圖像坐標換算得到混合圖像,然后中心裁剪得到最終的增強圖像.混合圖像左上、右上、左下和右下4張圖像坐標范圍為

左上角坐標:

ximg1_start,yimg1_start,ximg1_end,yimg1_end=

max(xc-wimg1,0),max(yc-himg1,0),xc,yc;

右上角坐標:

ximg2_start,yimg2_start,ximg2_end,yimg2_end=xc,

max(yc-himg2,0),min(xc+wimg2,2×S),yc;

左下角坐標:

ximg3_start,yimg3_start,ximg3_end,yimg3_end=

max(xc-wimg3,0),yc,xc,min(yc+himg3,2×S);

右下角坐標:

ximg4_start,yimg4_start,ximg4_end,yimg4_end=xc,yc,

min(xc+wimg4,2×S),min(yc+himg4,2×S).

(3)

其中,x,y,w,h分別表示圖像的橫縱坐標、寬和高.

Mixup通過任意2張圖像的像素混合可以有效提升檢測精準率,Mosaic通過任意4張圖像拼接混合可以有效提升檢測召回率,本文將Mixup和Mosaic這2種數據增強策略進行巧妙結合,獲得了檢測精準率和召回率的大幅提升.在訓練時,首先加載batchsize張訓練圖像,然后對每張圖像按照一定概率選擇數據增強策略,其中包含只進行Mixup增強、只進行Mosaic增強、同時進行Mixup和Mosaic增強與Mixup和Mosaic增強都不執行這4種方式.需要特別注意的是在選擇與其他圖像結合時,需要從batch以外的圖像中選擇.對batch中的每張圖像都執行上述操作,直至最后得到新生成的batchsize張增強圖像參與模型訓練,上述組合增強策略為

dataaug=a1mixup+a2mosaic+

a3(mixup+mosaic)+a4None.

(4)

2.3 模型剪枝

模型剪枝通過對高精度復雜模型進行冗余參數修剪,從而得到計算量和參數量有效降低的輕量化模型.除了2.2節提到的數據增強策略外,本文參考He等人在文獻[46]方案中的設置,在YOLOv3訓練過程中加入了相關優化方法,其中包括多尺度訓練、大的批處理尺寸、熱啟動、余弦學習率衰減法(cos lr decay)、標簽平滑(label smooth)等,有效提高了模型的精度.將該模型作為剪枝基準模型,依次通過迭代稀疏、層剪枝、微調與迭代稀疏、通道剪枝、微調(finetune)的過程,最終得到了不同剪枝比例的可部署模型,剪枝流程如圖1所示.

2.3.1 稀疏訓練

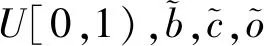

模型剪枝需要選擇可評估權重重要性的指標來剪枝不重要的結構.本文采用批歸一化層(batch normalization, BN)中的縮放因子γ的絕對值度量權重的重要程度.BN層的標準化公式為

(5)

其中,μ和σ2為統計參數,分別表示批處理中數據的均值和方差;γ和β為可訓練參數,分別對歸一化分布進行縮放與平移,從而保留原始學習到的特征.基于BN層原理,縮放系數γ主要用來保留歸一化操作前的特征,因此可以作為評估權重重要程度的指標因子.

如果權重分布不稀疏將不利于模型剪枝,需要通過外力強制稀疏化,L1正則化約束是常用的稀疏化方法.加入L1正則后YOLOv3的損失函數為:

(6)

其中,?為正則化系數,平衡2個損失項之間的關系.由于添加的L1正則項梯度不是處處存在的(在0點導數不存在),因此我們使用次梯度下降[27]作為L1正則項的優化方法.

2.3.2 層剪枝

如圖2所示為YOLOv3的標準網絡結構,特征提取部分由大量1×1卷積、3×3卷積與殘差結構構成,我們把每個這樣的結構作為一個單元稱為CR塊.實際剪枝操作過程中,為保證YOLOv3結構完整,CR塊作為一個整體參與.YOLOv3結構中一共有23個CR單元,權重重要程度統計時,我們選擇CR單元的均值作為評估剪枝與否的指標,剪掉均值較低的單元.層剪枝是一種非常粗糙的剪枝方法,按照單元裁剪的方式可能會帶來較大的精度損失,因此實際剪枝過程中我們通過觀察γ的變化趨勢設置需要剪枝的CR單元比例,通常不會一次剪掉太多,每次迭代按照50%的概率進行剪枝.通過稀疏訓練-層剪枝-微調的迭代過程,保證每次剪掉一些CR單元后,其精度損失可以通過微調補償回來.圖3為層剪枝后的YOLOv3網絡結構圖,具體剪枝參數設置見3.3節.

Fig. 3 The network structure of YOLOv3 after pruning圖3 YOLOv3剪枝后的網絡結構

2.3.3 通道剪枝

層剪枝之后我們得到了相對穩定的網絡結構,此時通過通道剪枝對其進行進一步修剪.首先需要定義全局剪枝率λ,表示需要剪枝的通道數占總通道數的比例,同時可以換算出全局剪枝率λ對應γ的閾值π1.為防止通道剪枝時某些層被全部剪掉,需要另外設置一個保護閾值β,表示每層中至少需要保留多少比例的通道,同理也可以換算出每層中對應γ的閾值π2.當且僅當γ<π1,γ<π2同時滿足時,該通道可以剪枝.直接使用較大的剪枝率會損失較多的精度,因此通道剪枝時我們通過分析稀疏訓練后γ的分布,按照30%的比例設置參數量剪枝率并迭代執行稀疏、通道剪枝、微調的過程,使得由于剪枝帶來的精度下降可以通過微調補償回來,從而得到精度損失較小的輕量化模型.

2.3.4 微 調

在執行完一次層剪枝或通道剪枝后,或多或少都會帶來精度損失,一定程度的精度損失可以通過后續的微調補償回來.本文我們是通過迭代稀疏訓練進行剪枝的,因此在每一次剪枝之后必須通過微調來補償剪枝帶來的精度損失,才能不影響下一次迭代的稀疏訓練.

3 實驗結果與分析

本文提出了一種基于迭代稀疏訓練的模型剪枝方法.實驗證明,該方法可以獲得精度和速度兼備的檢測模型.其中,模型訓練環境均基于Pytorch框架,服務器配置為Intel?Xeon?CPU E5-2640 v4@2.40 GHz,128GRAM,4塊GTX 1080 Ti.

3.1 數據集和評價指標

VisDrone-DET2019[47]是一個典型的無人機目標檢測應用數據集.該數據集包含8 599張來自無人機平臺從不同高度、不同光照條件下收集的圖像,涉及包含人、車在內的10個類別(pedestrian,person,car,van,bus,truck,motor,bicycle,awning-tricycle,tricycle),是一個非常有挑戰的數據集.其中訓練集6 471張、驗證集548張、測試集1 580張,由于測試集標注未開放下載,因此本文中模型都是基于訓練集訓練、驗證集評估的.

模型評估標準與文獻[43]中保持一致,我們主要評估輸入分辨率為608×608像素下模型的參數量、計算量(floating-point operations, FLOPS)、交并比(intersection over union, IOU)在0.5下的精度度量指標F1-score和平均精度均值(mean average precision,mAP)以及模型壓縮中涉及的參數量壓縮率、計算量壓縮率等指標.為更全面地評估輕量化模型在不同分辨率下的性能,我們選取計算量壓縮率為85%的模型與文獻[43]中模型進行對比分析,實驗證明我們的算法在達到與文獻[43]中同等壓縮率的情況下可以獲得更高的精度與更快的速度.

3.2 訓練細節

本文模型訓練環境基于Pytorch框架展開,采用動量0.9、權重衰減因子0.000 5的隨機梯度下降(stochastic gradient descent, SGD)權重更新策略;正常訓練迭代次數為300epoch,初始學習率為0.002 5,分別在240epoch和270epoch衰減10倍;稀疏訓練和微調的迭代次數為100epoch,初始學習率為0.001,分別在80epoch和90epoch衰減10倍;批處理大小為128;損失函數中α,β,γ分別設置為3.31,52.0,42.4;數據增強策略中α1,α2,α3,α4按照等概率設置為0.25;多尺度訓練設置圖像大小變化區間為[416,896];稀疏因子根據γ分布設置為0.01~0.08之間.

3.3 實驗結果

3.3.1 數據增強

數據增強是一種成本很低卻可以有效提升模型性能的方法.除了常規使用的增強方法外,本文結合了Mixup和Mosaic的優勢,有效提升了檢測精準率和召回率,增強效果如圖4所示:

Fig. 4 The effect of data enhancement圖4 數據增強效果圖

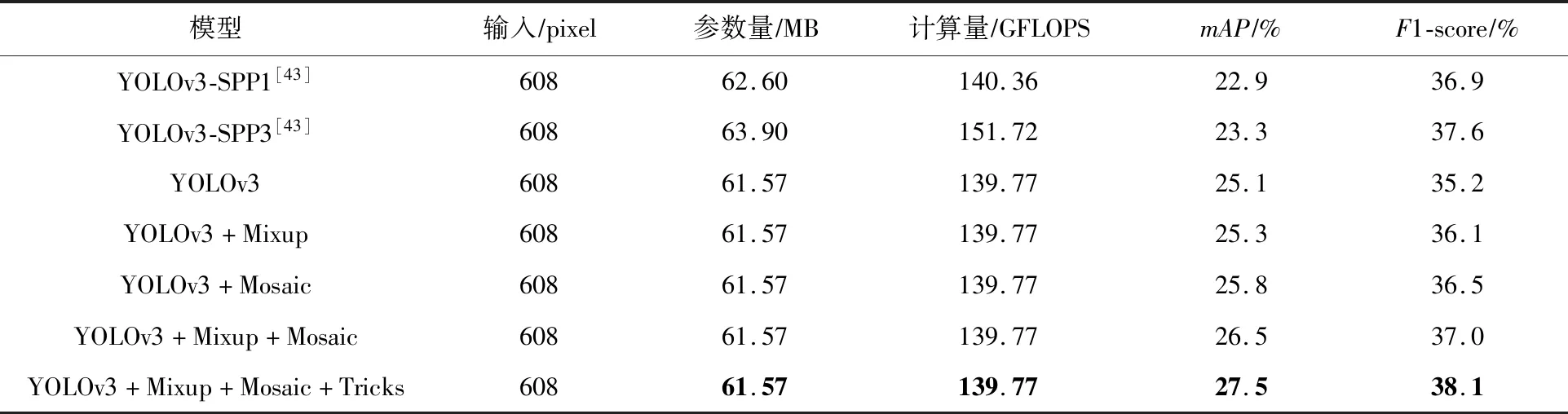

為獲得好的基準模型,我們通過數據增強策略與優化手段共同對YOLOv3標準模型進行了優化.表1中前兩行分別表示Zhang等人在文獻[43]中的測試結果,行3表示YOLOv3標準網絡測試結果,行4~6分別表示單獨加入Mixup增強策略、單獨加入Mosaic增強策略以及Mixup和Mosaic結合策略的測試結果,最后一行表示加入相關優化手段的測試結果.我們可以看到不論使用Mixup策略還是Mosaic策略都可以提升mAP指標,此外Mixup和Mosaic隨機組合的策略對mAP的提升要比單獨執行時效果更好.表1最后一行不論mAP還是F1-score都有很大的提升,雖然未加SPP[48]模塊,但通過數據增強策略與相關優化手段可以達到甚至優于YOLOv3-SPP3的結果,而且參數量和計算量更少.

Table 1 Test Results Comparison of Benchmark Model表1 基準模型測試結果比較

3.3.2 剪 枝

基準模型獲得后,我們通過迭代稀疏訓練的方式進行模型剪枝.圖5為層剪枝稀疏訓練過程中CR單元γ均值變化曲線圖,其中實線表示基準模型CR單元γ均值曲線,虛線表示稀疏訓練后模型CR單元γ均值曲線.從圖5中可以明顯發現,模型越靠前的層γ均值越大,越靠后的層γ均值越小.隨著迭代的進行,γ均值會逐漸變小,但不改變層之間的相對大小關系,而且越靠后的層越接近0,說明針對當前數據集來說,越靠后的層對模型性能貢獻越小,因此會在層剪枝過程中被剪枝.隨著剪枝過程的進行,其稀疏訓練過程也會變得越來越難,層剪枝難度增大,直至達到一定的結構平衡,如圖3所示,完成層剪枝過程.

Fig. 5 The scale factor change curve of CR module圖5 CR單元縮放因子變化曲線圖

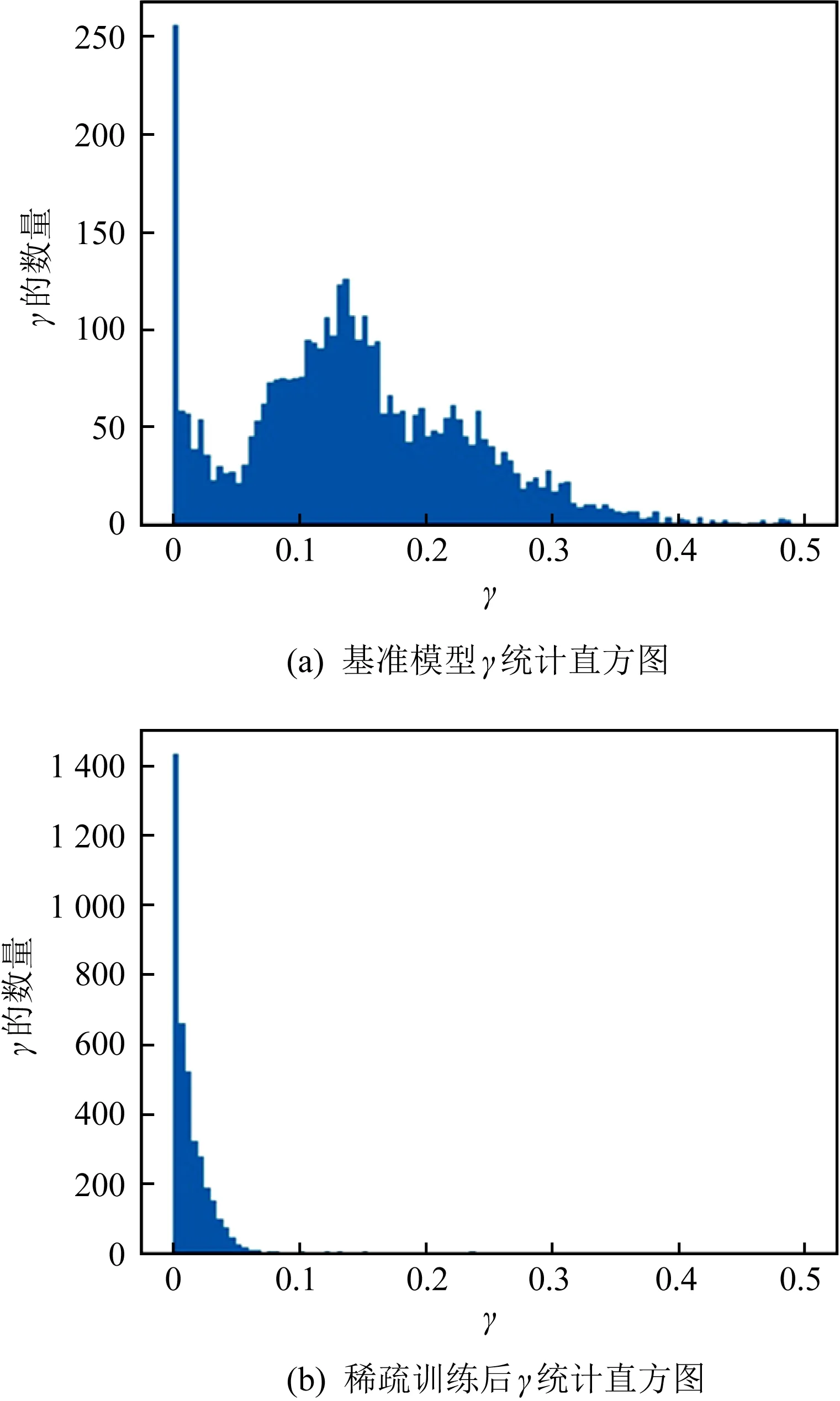

標準YOLOv3模型一共含有72個BN層,如圖6所示為通道剪枝過程中稀疏訓練前后γ統計直方圖分布.對比圖6(a)(b)的2張圖可以明顯地看到,稀疏訓練后γ數據分布直方圖變得更細更尖了,意味著接近于0的γ值變得更多了,而較大的γ值變少了,也即γ數據分布更加稀疏,有利于通道剪枝的實現.

Fig. 6 The γ statistics histogram before and after channel pruning sparse training圖6 通道剪枝稀疏訓練前后γ統計直方圖

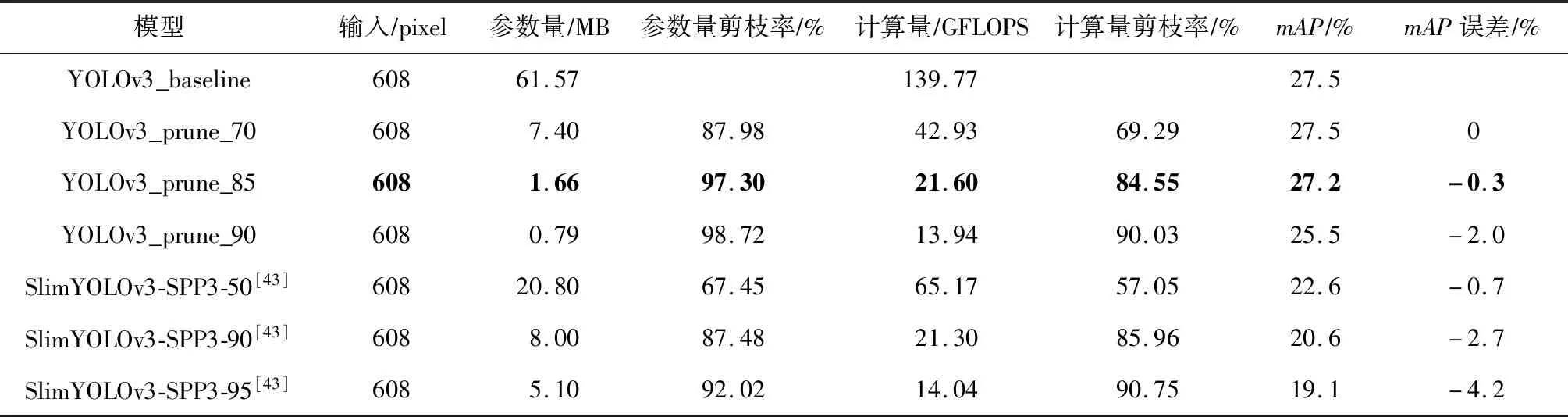

表2表示不同剪枝率下的模型壓縮性能對比,其中YOLOv3_baseline表示本文剪枝前的基準模型,YOLOv3_prune_70(85,90)分別表示計算量剪枝率為70%,85%,90%的模型,與文獻[43]工作中的SlimYOLOv3-SPP3-50(90,95)一一對應.在計算量達到同等剪枝率甚至更高剪枝率的條件下,我們的方法對參數量的壓縮率更高,而且精度誤差更低.特別是對于計算量壓縮率為85%時,參數量壓縮率達到97.3%,比文獻[43]方案中的87.48%高了將近10%.此外,mAP誤差只有0.3,相比文獻[43]方案中提升了2.4個點.

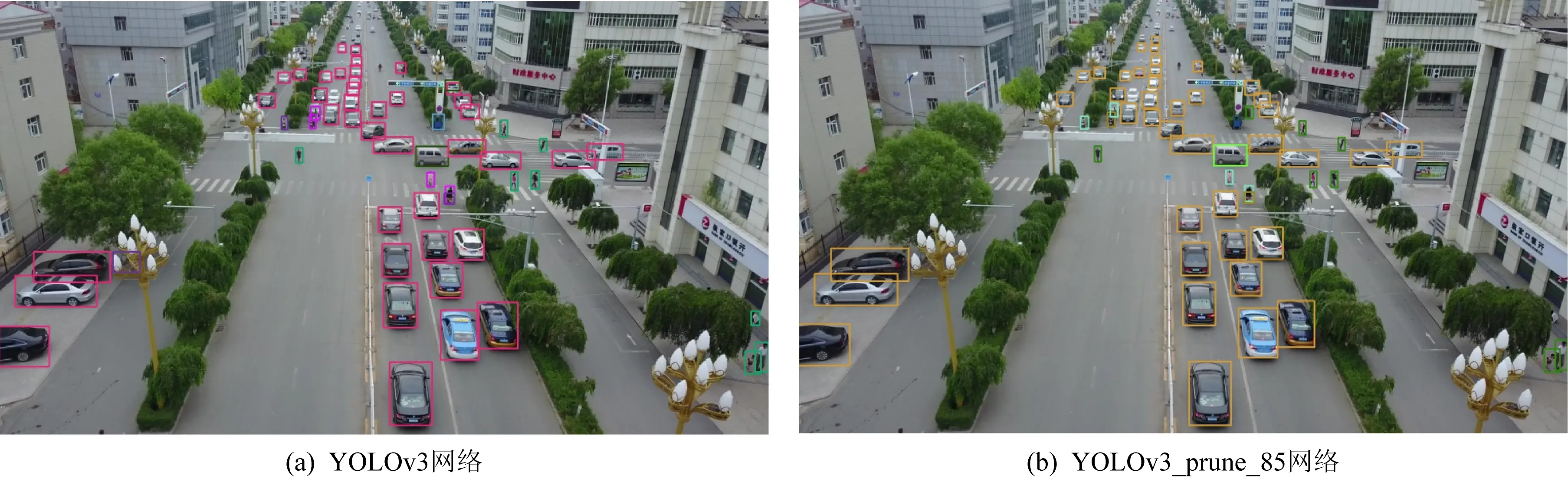

為了與文獻[43]方案中結果進行更公平全面的對比,表3針對計算量85%壓縮率水平進行了416×416,608×608,832×832這3個分辨率的性能對比,不出意料,不論mAP指標還是F1-score指標,我們的方法都取得了巨大的提升.圖7展示了608×608輸入分辨率下剪枝前后的檢測效果圖,可以看到剪枝前后都能檢測到絕大多數感興趣目標,而且剪枝前后誤差很小.

Table 2 Comparison of Model Compression Performance Under Different Pruning Rates表2 不同剪枝率下的模型壓縮性能對比

Table 3 Comparison of Model Compression Performance Under Different Resolutions

Fig. 7 Test result of model before and after pruning圖7 剪枝前后結果圖

4 結束語

本文通過數據增強策略與相關優化手段的巧妙結合,得到了一個性能較好的基準模型.通過迭代稀疏訓練的模型壓縮方法,對上述基準模型進行了極大程度的參數量壓縮與計算量壓縮.與現有典型方法[43]相比,本文提出的方法在未添加額外計算量(SPP模塊)的情況下,得到了精度更高的基準模型;同時通過迭代稀疏層剪枝與迭代稀疏通道剪枝相結合的方法,在達到同等計算量剪枝率的情況下,參數量更少,精度損失更小,適合在計算資源受限的無人機平臺部署應用.模型壓縮是生成性能較好的輕量化模型的常用方法,如何保證在一定精度損失的條件下進一步降低計算量和參數量仍然是一個值得深度研究的課題.當前方法只驗證了YOLOv3網絡在VisDrone-DET2019數據集上的壓縮性能,下一步我們將對其他典型檢測網絡與數據集做進一步驗證和推廣,以提高方法的普適性.

作者貢獻聲明:侯鑫參與代碼開發、實驗測試、數據分析、論文攥寫與修改等工作;曲國遠、魏大洲參與實驗環境搭建、代碼開發、實驗測試等工作;張佳程參與數據分析等工作.