改進YOLOX 火災場景檢測方法的研究*

張劍飛 柯 賽

(黑龍江科技大學計算機與信息工程學院 哈爾濱 150022)

1 引言

傳統的火災檢測有基于煙霧和溫度的傳感檢測,也有通過電動閥和排氣閥的數據檢測。隨著深度學習的發(fā)展,喻麗春[1]等使用改進的Mask R-CNN,通過自下向上的特征融合以及改進的損失函數實現對火焰的高精度檢測。吳凡[2]將YOLOv3[3]的主干網絡替換為Densenet121 提升網絡對火焰和煙霧的特征提取能力,并引入Focal Loss。趙民[4]等提出基于CenterNet[5]算法的復雜環(huán)境目標檢測技術。李欣健[6]等使用深度可分離卷積來改進火焰檢測模型,并使用多種數據增強技術提高檢測精度。雒朝輝[7]使用基于YOLOv4框架的無人機進行實時火焰檢測。

然而上述方法的模型相對復雜,計算量大,檢測目標單一,難于部署。為解決這些問題,本文提出了一種改進的T-YOLOX 檢測模型,對火災場景下的火焰、煙霧以及受災人員進行檢測。

該方法基于YOLOX[8]架構,結合輕量級注意力模塊對每個通道權重做調整,從而提升網絡整體的特征提取能力;添加通道混合模塊,提高各通道間交流能力,抑制過擬合;將主干網絡最后一層換為MobileViT[9]模塊,使用這個輕量級的Transformer[10]模塊來增強主干網絡對全局特征的學習能力。通過實驗,驗證了本文方法的有效性和優(yōu)越性。

2 相關工作

2.1 YOLOX

YOLOX 是YOLO 系列工作之一,綜合了YOLO系列網絡優(yōu)點,擺脫先驗框約束,使用YOLOv4[11]的特征提取網絡CSPDarknet 架構,引入YOLOv5 的Focus通道增廣技術,運用Mosaic數據增強,創(chuàng)新的加入解耦預測頭和SimOTA動態(tài)正樣本匹配方法。

2.2 Transformer

Transformer 作為近期具有開創(chuàng)性的第四代神經網絡,在CV領域產生了巨大的影響。先是ViT[12](Vision Transformer)將圖片視為文本進行處理,取得了極佳的效果。而后BoTNet[13]用Transformer 模塊替換卷積神經網絡(Convolutional Neural Networks,CNN)最后一層,強化了主干網絡對全局信息的捕捉能力。

3 改進的YOLOX算法:T-YOLOX

盡管YOLOX 已經具有了良好的檢測性能,但針對本文所要解決的問題,仍然存在以下改進方面。

1)YOLOX 的CSPLayer 層包含大的殘差邊,殘差操作在有效避免深層網絡梯度消失的同時會將夾雜的噪聲一同送入深層網絡,這會對主干網絡的訓練產生影響。

2)殘差操作會將輸入特征拼接到輸出特征上,但是單純地對特征層進行拼接操作,效果并不理想,會存在通道信息難以良好融合的問題。

3)YOLOX 使用基于CNN 的CSPDarknet 主干網絡。通過卷積核捕捉局部特征信息,但這樣會忽視全局特征信息之間的關系。

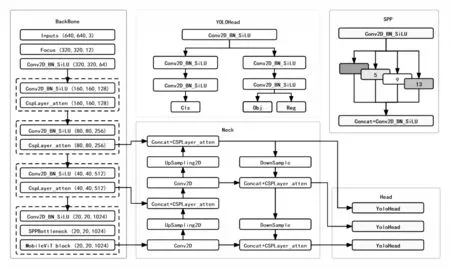

因此,針對YOLOX在火災場景檢測上的不足,本文提出T-YOLOX模型,其模型架構如圖1所示。

圖1 T-YOLOX模型架構

3.1 輕量級注意力模塊

殘差操作會將不必要的噪聲帶入下一層網絡,對網絡訓練產生影響。本文在CSPLayer 上添加輕量級注意力模塊,通過對殘差邊施加注意力,進而對每個通道權重做調整,以此來削弱噪聲對網絡訓練的影響。

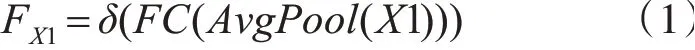

其原理是通過特征融合和殘差變換在強化通道信息的同時弱化噪聲影響。模塊主要包含三個分支,X1 首先借助全局均值池化(AvgPool)操作壓縮高維特征,隨后通過全連接層(fully connected layers,FC)以及δ(ReLU)激活函數對特征做FX1壓縮操作,如式(1):

隨著我國政府積極推廣PPP模式,降低了電力設計企業(yè)進入非電行業(yè)的門檻,除了參與PPP項目的設計和咨詢業(yè)務,還能與其他企業(yè)組建聯合體作為投資方參與PPP項目的建設和運營,獲得穩(wěn)定的投資收益和工程收益,實現多元化發(fā)展。

完成后再通過全連接層(FC)以及σ(Sigmoid)激活函數做擴展得到FX2,并將最終抽取的注意力權重FX2施加到X2上,過程如式(2)、(3)所示:

另外Input 會在堆疊的殘差塊上的進行特征提取操作得到X3,最后X2 與X3 通過拼接(⊕)操作匯聚在一起。輕量級注意力施加流程如圖2 所示。

圖2 輕量級注意力施加流程

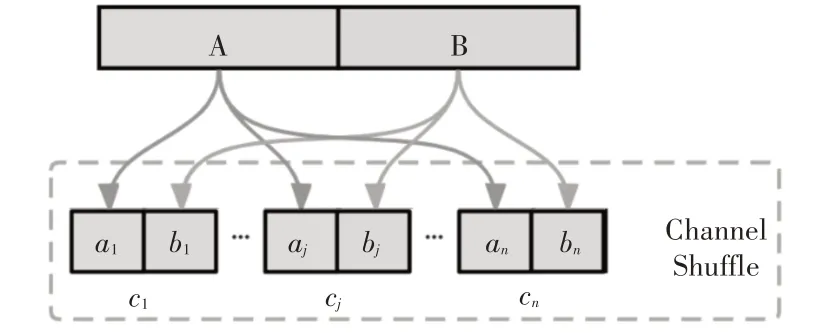

3.2 Channel Shuffle通道混合技術

引入Channel Shuffle[14](CS)模塊,對完成拼接操作的特征層做通道混合操作,以此來提升通道間交流。特征層拼接操作如式(4)所示:

該方法在相同的計算資源下,能強化通道間交流能力,避免過擬合,具體演示流程如圖3所示。

圖3 Channel Shuffle演示流程

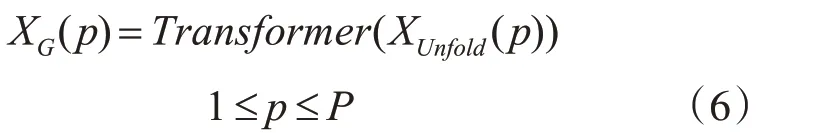

3.3 輕量級Transformer:MobileViT

將主干網絡最后一層替換為MobileViT Block,以此來提升網絡對全局以及局部信息的感知能力,強化主干的特征提取能力。MobileViT Block 對給定輸入特征X∈RH×W×C(其中C、H、W分別表示張量的通道、高度和寬度)先后使用n×n卷積(n=3)編碼局部空間信息以及1×1 卷積將張量投影到高維空間(d 維,其中d>C),進而調整得到XL∈RH×W×d,接著對特征做通道展平(Unfold)操作得到XUnfold∈RP×N×d其中P=w·h,P代表寬(w)高(h)的patch像素數(w≤n,h≤n),N=HW÷P,N代表patch 的總份數,隨后通過Transformer 模塊對patch 間信息進行編碼,得到XG∈RP×N×d,操作如式(6)所示:

為避免丟失patch 之間的位置信息以及每個patch 內部的像素信息,隨后將XG∈RP×N×d重新堆疊(Fold)還原得到XFold∈RH×W×d。然后將XFold送入1×1 卷積網絡,將其投影到低維空間(C 維)得到X?∈RH×W×C,通過將X? 與X拼接(Concat)得到X?∈RH×W×2C,最后利用n×n卷積(n=3)融合局部特征X?與全局特征X獲得輸出Y∈RH×W×C。MobileViT Block的結構如圖4所示。

圖4 MobileViT Block整體結構

4 實驗

4.1 數據集

針對早期火焰數據集圖像分辨率不高,信息反饋能力偏弱的問題。本文自制了火災數據集,檢測內容包含火焰、煙霧以及受災人員三類。從網絡上搜取火災相關的數據,將采集到的數據進行篩選后整理出5000 張照片。使用LabelImg 工具構建火災數據集,數據集包含Fire、Smoke、Person 三類,圖像的標注信息會保存在xml文件中。

關于本次實驗使用的火災數據集,共有火焰標注7000 個左右,煙霧以及人員的標注2000 個左右。借助可視化數據圖5(a)可以看出目標框中心位置分布均勻,圖5(b)顯示目標框相對圖片的占比程度。不難發(fā)現,標注數據的分布和占比均勻且多樣。

圖5 數據可視化

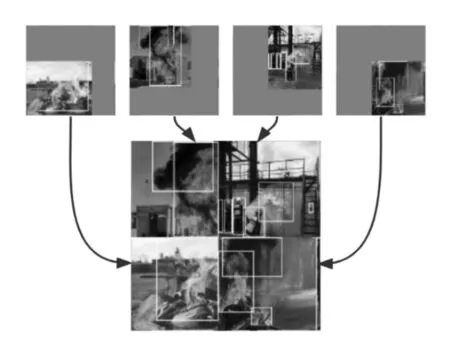

4.2 數據增強

圖6 Mosaic數據增強

4.3 實驗環(huán)境

本次實驗在Python3.8,CUDA11.1,PyTorch 1.9.1 環(huán)境上進行。 所有模型均在NVIDIA RTX3060 GPU上進行訓練和測試。

在網絡訓練前,對模型使用了Kaiming 初始化[15]。訓練時,數據集按照8∶2 劃分為訓練集和測試集,并從訓練集中抽取10%作為驗證集,輸入的圖片張量為(640,640,3),使用Adam優(yōu)化器以及余弦退火學習率進行訓練,訓練批次為4,初始化學習率為0.0001,訓練總共進行300次迭代。

4.4 評估指標

本文采用目標檢測模型常用評估指標mAP(Mean Average Precision)以及FPS(Frames Per Second)進行模型評估。AP 指PR(Precision-Recall)曲線下面積、mAP 指每個類別AP 的均值,AP 以及mAP 值越大越好。Precision 和Recall 的計算公式如式(7)~(8)所示:

TP(True Positives)表示被分為正樣本,且分對的;FP(False Positives)表示被分為正樣本,但分錯的;FN(False Negatives)表示被分為負樣本,但分錯的。

4.5 實驗設計與結果分析

關于實驗,T-YOLOX 模型的訓練損失如圖7所示。通過該圖可以發(fā)現,隨著訓練輪數的不斷增加,Loss 曲線逐漸趨于平穩(wěn)。當Epoch 達到200 左右后,模型逐漸收斂,訓練過程未出現過擬合現象。

圖7 Loss曲線

本文共設計了一組消融實驗和一組對比實驗,為符合模型部署要求,本次實驗選取“-s”輕量級規(guī)格。通過消融實驗檢驗本文不同改進部分對網絡性能的影響,隨后再通過T-YOLOX 與主流網絡(CenterNet、YOLOv3)的對比實驗,綜合分析模型性能。

4.5.1 消融實驗

為分析本文改進部分對模型性能的影響,共設計三組實驗對不同的改進進行分析,每組實驗均在相同訓練參數,不同模型內容上進行測試。模型性能檢測結果如表1 所示,其中“√”代表在改進模型中使用的策略,“×”代表在改進模型中未使用的策略。對表1 進行分析可見:改進1 添加Channel Shuffle 模塊提高了通道間交流能力,避免了過擬合,mAP 有所提升。改進2 在此基礎上添加輕量級注意力模塊,引入注意力加強邊后,提升了通道對空間信息的注意力,同時弱化噪聲對深層網絡的影響,mAP 提升了1.05%。改進3 加入MobileViT 模塊,將CNN 與Transformer 進行融合,以此實現主干網絡對局部以及全局信息的學習能力,mAP提升了1.02%。

表1 不同改進方法的實驗結果

4.5.2 模型對比

為了驗證T-YOLOX 改進模型的檢測性能,將其與主流目標檢測模型YOLOv3、CenterNet、YOLOX 做對比實驗,對比實驗結果如表2 所示。由表2分析可知,T-YOLOX算法的mAP 達到了69.54%,較原始YOLOX 算法提高了2.24%,結合表中Fire、Somke、Person 三類的平均AP 值進行分析可得,本文方法檢測火焰、煙霧以及受災人員的AP 值比原始YOLOX 算法均有不同程度的提高,相比其他主流目標檢測模型(CenterNet、YOLOv3)具有更好的檢測性能。同時在檢測受災人員方面T-YOLOX有明顯的優(yōu)勢,在保證高精度檢測的同時,模型的FPS 并未出現大幅度下降,檢測速度與主流模型相比仍然具有一定優(yōu)勢。

表2 主流目標檢測模型性能對比

5 結語

本文針對現有目標檢測模型難以在復雜火災場景下對火災場景進行及時高效的反饋問題,提出了一種改進YOLOX 的火災場景檢測模型T-YOLOX。該方法在YOLOX 模型基礎上,引入了強化通道交流能力的Channel Shuffle 模塊,施加通道注意力權重的CSPLayer_attention 模塊,以及將CNN與Transformer相融合的MobileViT模塊。檢測效果如圖8 所示。實驗表明,本文所提出的檢測方法,針對復雜火災場景有良好的性能表現。

圖8 T-YOLOX檢測效果展示